近年来,随着信息技术的快速发展,获取大规模数据集的成本逐渐降低,因此,从大规模数据集中自动获取问题相关知识并解决复杂问题的机器学习技术,已经成为众多领域中解决复杂任务的有效技术手段。人工神经网络是机器学习的重要分支,随着深度网络等具有优秀学习能力的新型人工神经网络的涌现,人工神经网络技术又重新受到机器学习领域研究者的重视。然而,现有人工神经网络的构造方法主要以模拟生物神经网络的拓扑结构和突触可塑性为主,而对生物神经细胞所具有的高级功能的描述和抽象的关注较少。

神经生物学和认知神经学的研究表明:神经细胞所具有的学习能力是生物神经系统完成学习和记忆任务的重要基础[1]。经典的M-P(McCulloch-Pitts)神经元及其类似神经元模型是现有使用最广泛的神经元模型,该类神经元模型将神经细胞的信息处理功能抽象为输入与输出之间的简单函数变换,缺乏对生物神经细胞学习机制的模拟。生物神经细胞的学习机制不仅会改变细胞胞体功能还将改变神经突触工作方式[2],因此,融合生物神经细胞学习机制的人工神经元模型具有更坚实的生物学基础。习惯化和去习惯化是生物神经细胞具有的典型非联合型学习机制[3],结合上述非联合型学习机制的人工神经元模型改变了经典神经元的结构和信息处理过程,具有更加坚实的生物学基础和学习能力。人工神经网络是对生物神经网络的抽象和模拟,人工神经元作为人工神经网络的基础,基于生物学机制的人工神经元和人工神经网络的模拟和模型构造方法受到众多学者关注。近年来国内外学者从神经细胞的不同生物学机制出发,设计了多种神经元模型。

许少华等[4]将突触信号的时间整合机制引入人工神经元模型,基于突触信号交换过程是时间过程的原理,扩展了M-P神经元结构,将神经元的输入方式从几何点式的瞬时输入,扩展为一组依赖时间的连续函数输入。过程神经元网络在连续信号处理方面具有良好的应用效果[5],并发展出多种过程神经元模型[6-7]。在解决多值逻辑和多区域非线性划分等复杂模式识别问题时,以二值或实值函数作为激活函数的神经网络存在结构较为庞大、学习和收敛速度较慢、容易陷入局部极小等问题。多值神经元具有良好的鲁棒性和快速的收敛性[8]。多值神经元的多阈值激活函数部分地模拟了生物神经元的功能可塑机制,使得神经元获得了多种激活状态,从而提高神经元的学习能力。量子神经元的加权、聚合、活化和激励等相关操作可用于模拟神经细胞对输入刺激的时空整合、兴奋、抑制、疲劳和不应期等相关过程[9],其将生物神经元看为黑盒模型,从量子自身具有的特征映射到神经元的特征,从而构造了量子神经元。随着对神经元工作机制认识地逐渐深入,一类基于神经元生物学机制的人工神经元模型被相继提出。班晓娟等[10]基于神经胶质细胞对生物神经元网络的生长提供能量支持的生物学原理,将神经胶质细胞对神经元能量供给机制引入神经元模型,提出了能量人工神经元模型。该模型具有良好的自组织、自生长能力。钱夔等[11]基于多巴胺和5-羟色胺这两种神经递质对学习过程的调节作用,设计了模拟神经递质调节的神经网络发育算法,实现了非结构环境的记忆与识别。上述研究工作表明,相关学者从生物神经元的突触信息传递机制、信息整合机制、神经元的内外部工作机制等不同角度设计了神经元模型,但对生物神经元自身所具有的非联合型学习机制的借鉴和模拟却未见讨论和涉及。

本文在借鉴和模拟生物神经元自身所具有的非联合型学习机制的基础上,结合经典的M-P神经元模型,提出并实现了具有典型非联合型学习机制的学习神经元,建立了学习神经元的数学模型。经实验验证,该神经元具有良好的习惯化和去习惯化学习能力。

1 神经元习惯化、去习惯化机制简化模型现有神经元模型主要以神经突触可塑性理论为基础,将神经细胞功能描述为信息时空整合过程,缺乏对生物神经细胞非联合型学习机制的借鉴和模拟。

本文对生物神经元具有的信息时空整合、习惯化、去习惯化特性进行简化,并将简化后的神经元功能整合到M-P神经元模型中,建立学习神经元模型。其中具有习惯化学习机制结构的学习神经元称为习惯化神经元,具有去习惯化学习机制结构的学习神经元称为去习惯化神经元。

处于习惯化模式的神经元对相似输入的响应逐渐降低,呈静默状态,从而系统不响应重复的无害输入,降低系统能量消耗;去习惯化机制可唤醒已静默的神经元,使其工作模式从习惯化模式切换到正常模式,从而使系统保持对环境输入的敏感性。

基于生物神经细胞的习惯化和去习惯化学习机制,可获得习惯化机制和去习惯化机制的简化模型如下:

1) 生物神经元某通路受到重复的相似刺激且刺激程度较小时,神经元对该刺激的响应逐渐降低从而对该刺激形成习惯化,可获得如下简化模型:学习神经元对输入模式的响应强度与模式出现的频率成反比。

2) 生物神经元对某个刺激形成习惯化后,如果在其他输入通路接收到强刺激,则神经细胞对已习惯化的刺激产生强烈的响应从而形成去习惯化,可获得如下简化模型:能量较高的输入模式可以加强神经元对已习惯化模式的响应。

2 学习神经元的数学模型本文在M-P神经元基础上,分别结合习惯化学习机制和去习惯化学习机制设计了习惯化神经元模型和去习惯化神经元模型。

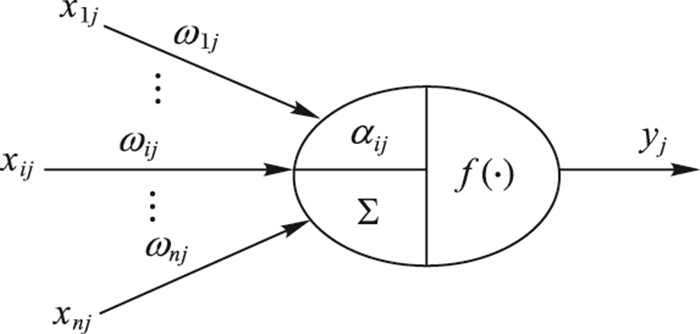

2.1 习惯化神经元模型在经典神经元模型基础上,增加了习惯化参数,构建了习惯化神经元模型,习惯化神经元的结构如图 1所示。

|

图 1 习惯化神经元结构 Figure 1 Habituation neuron structure |

图 1中:xij为学习神经元输入;ωij是神经元输入通路权值;f(·)为学习神经元激活函数,习惯化神经元输出表达式为

| $ {n_{ij}}(t + 1){\rm{ = }}\left\{ \begin{array}{l} {n_{ij}}(t) + 1, \begin{array}{*{20}{c}} {} & {{d_{ij}} < {d_{\rm{T}}}} \end{array}\\ 0, \begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {} & {} & {} \end{array}} & {{d_{ij}} \ge {d_{\rm{T}}}} \end{array} \end{array} \right. $ | (1) |

其中:dij是刺激的相似度,dT为相似度阈值,相似度可表达为dij=‖xij-xij*‖/D,其中D为归一化系数。在习惯化参数学习过程中,记忆的习惯化刺激的模式更新过程可描述为xij*(t+1)=(1-dij)xij*(t)+dijxij(t),其中xij*(t)为习惯化的模式。

与经典M-P神经元比较,习惯化神经元增加了习惯化参数。综上所述,习惯化神经元模型可由下述公式描述:

| $ {y_j} = f(\mathop \Sigma \limits_{i = 1}^n {\mathit{\alpha }_{ij}}{\mathit{\omega }_{ij}}{\mathit{x}_{ij}}) = f(\mathop \Sigma \limits_{i = 1}^n \frac{1}{{1 + {{\rm{e}}^{{n_{ij}}}}}}{\mathit{\omega }_{ij}}{x_{ij}}) $ | (2) |

| $ {d_{ij}} = \left\| {{x_{ij}} - x_{ij}^*} \right\|/D $ | (3) |

| $ x_{ij}^*(t + 1) = (1 - {d_{ij}})x_{ij}^*(t) + {d_{ij}}{x_{ij}}(t) $ | (4) |

| $ {n_{ij}}(t + 1) = \left\{ \begin{array}{l} {n_{ij}}(t) + 1, \begin{array}{*{20}{c}} {} & {{d_{ij}} < {d_{\rm{T}}}} \end{array}\\ 0, \begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {} & {} & {} \end{array}} & {{d_{ij}} \ge {d_{\rm{T}}}} \end{array} \end{array} \right. $ | (5) |

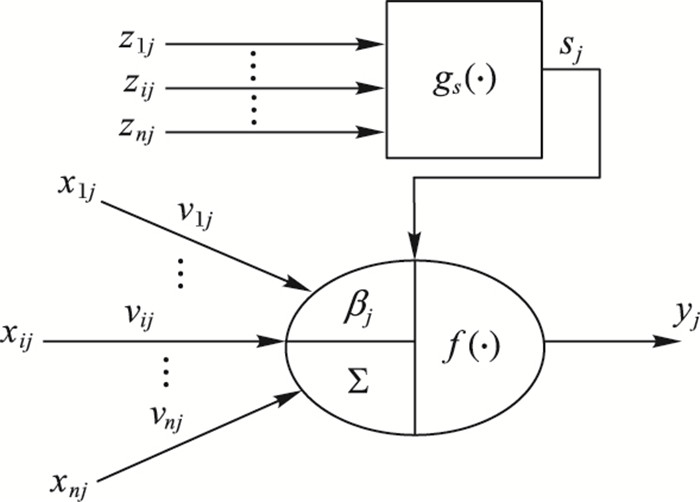

在经典神经元模型基础上,增加了去习惯化参数构建的去习惯化神经元结构如图 2所示。

|

图 2 去习惯化神经元结构 Figure 2 Dishabituation neuron structure |

图 2中:zij为输入刺激;xij为学习神经元的输入;vij是神经元输入通路的权值;f(·)为学习神经元的激活函数,去习惯化神经元输出的表达式为

去习惯化过程将提高神经元的输出信号强度,因此当强烈刺激出现时神经系统将对已习惯化的输入刺激产生强烈反应。增强参数βj描述了神经元反应增强过程,βj的变化过程用于模拟神经节中的S神经元,增强过程开始后,神经元输出在较短时间产生强烈响应,增强参数βj快速增大;但随时间增加βj逐渐下降,并最终将趋近为1。因此,增强参数可表达为βj=(1+sjλe-λnj)(nj≥0)。其中:λ为去习惯化系数;nj为刺激习惯化系数,用非强烈刺激出现次数表示;sj=g(Ij)为增强化系数;g(Ij)为增强化系数变换函数,且有

| $ g({I_j}) = \left\{ \begin{array}{l} 1, \\ 1/\mathit{\lambda }, \end{array} \right.\begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {} & {{I_j} \ge {I_{\rm{T}}}} \end{array}}\\ {\begin{array}{*{20}{c}} {} & {{I_j} < {I_{\rm{T}}}} \end{array}} \end{array} $ | (6) |

其中IT为刺激强烈程度的阈值。若神经元输入的刺激强度小于阈值IT,则nj逐渐增大使βj逐渐趋近于1,去习惯化过程消失;若神经元输入的刺激强度大于阈值IT,则nj为0使βj上升为(1+λ),去习惯化过程开始。nj可由下式描述:

| $ {n_j}(t + 1) = \left\{ \begin{array}{l} {n_j}(t) + 1, \begin{array}{*{20}{c}} {} & {{I_j} < {I_{\rm{T}}}} \end{array}\\ 0, \begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {} & {} \end{array}} & {} \end{array}} & {{I_j} \ge {I_{\rm{T}}}} \end{array} \end{array} \right. $ | (7) |

去习惯化学习过程的前提是神经细胞接收到强烈刺激,之后,神经细胞对已习惯化的输入刺激产生强烈反应[12]。神经生物学研究表明,输入刺激的强烈程度与其包含的信息量和能量有关[13]。信息熵可描述信息输入的信息量,能量均值可描述刺激的能量,因此刺激的强烈程度可表示为:

| $ {I_j} = {a_j}{H_j} + (1 - {a_j}){E_j} $ | (8) |

其中:Hj为输入刺激的熵;Ej为输入刺激的能量,

在经典的M-P神经元基础之上,去习惯化神经元增加了增强参数。去习惯化神经元的模型可描述为:

| $ {y_{\rm{j}}} = f\left( {{\mathit{\beta }_j}\mathop \sum \limits_{i = 1}^n {\mathit{\upsilon }_{ij}}{x_{ij}}} \right) = f\left( {(1 + g({I_j})\mathit{\lambda }{{\rm{e}}^{ - \lambda {n_j}(t)}})\mathop \sum \limits_{i = 1}^n {\mathit{\upsilon }_{ij}}{x_{ij}}} \right) $ | (9) |

| $ {I_j} = {a_j}{H_j} + (1 - {a_j}){E_j} $ | (10) |

| $ {E_j} = \frac{1}{\mathit{n}}\sum\limits_{i = 1}^n {{z_{ij}}} $ | (11) |

| $ g({I_j}) = \left\{ \begin{array}{l} 1, \\ \frac{1}{\lambda }, \end{array} \right.\begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {} & {{I_j} \ge {I_{\rm{T}}}} \end{array}}\\ {\begin{array}{*{20}{c}} {} & {{I_j} < {I_{\rm{T}}}} \end{array}} \end{array} $ | (12) |

| $ {n_j}(t + 1) = \left\{ \begin{array}{l} {n_j}(t) + 1, \begin{array}{*{20}{c}} {} & {{I_j} \ge {I_{\rm{T}}}} \end{array}\\ 0, \begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {\begin{array}{*{20}{c}} {} & {} \end{array}} & {} \end{array}} & {{I_j} < {I_{\rm{T}}}} \end{array} \end{array} \right. $ | (13) |

为验证本文提出的学习神经元模型的有效性,构造两组样本序列,分别检验习惯化神经元和去习惯化神经元的有效性:

1) 样本序列一:具有随机输入和相似输入,分别模拟随机刺激和相似刺激。验证在随机输入情况下,神经元输出与经典M-P神经元输出相同;在相似输入情况下,神经元输出逐渐减小,最终趋近于零。

2) 样本序列二:输入刺激分为刺激强度小于阈值IT的弱刺激和刺激强度大于阈值IT的强刺激两类,神经元输入为相似输入。验证在输入刺激为弱刺激的情况下,神经元输出逐渐减小,趋近于零;在输入刺激为强刺激的情况下,神经元输出迅速增大。

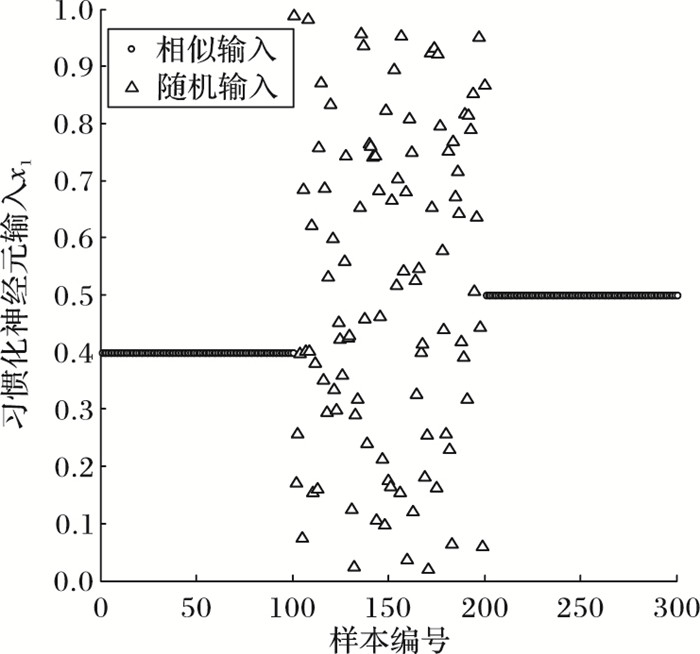

为模拟相似输入、随机输入,神经元输入为常数代表相似输入,神经元输入为[0, 1]区间随机均匀分布的随机数代表随机输入。习惯化神经元(样本序列一)和去习惯化神经元(样本序列2) 参数分别如表 1、2所示。

| 表 1 习惯化神经元参数 Table 1 Habituation neuron parameters |

| 表 2 去习惯化神经元参数 Table 2 Dishabituation neuron parameters |

由表 1可知,习惯化神经元样本1~100及201~300为常数,模拟相似刺激;样本101~200为服从[0, 1]区间随机均匀分布的随机数,模拟各类随机刺激,各样本的归一化系数D=1,相似度阈值dT=0.01,神经元输入通路权值ω1=ω2=ω3=2,激活函数为单极性Sigmoid函数,通过两类不同输入样本,观察神经元输出区别。

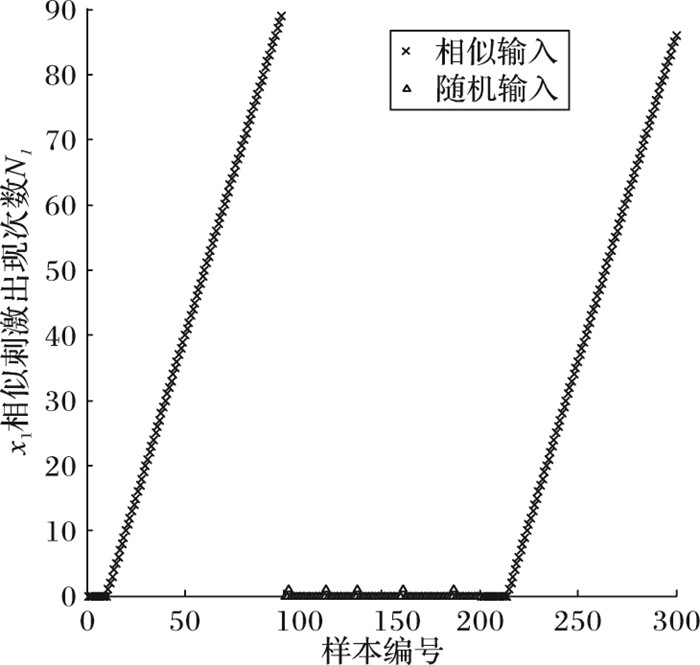

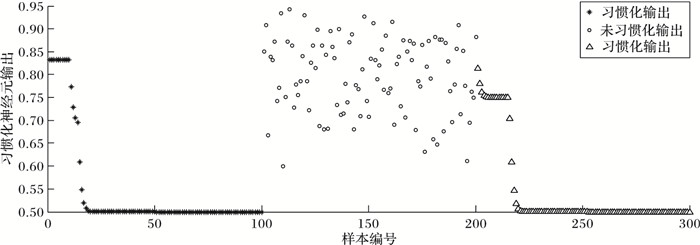

以神经元输入通路x1为例,由图 3和图 4可以看出:在输入为常数即相似刺激时,相似刺激计数N1增加;输入为随机刺激时,相似刺激计数基本为0,符合习惯化学习过程。

|

图 3 习惯化神经元输入 Figure 3 Habituation neuron input |

|

图 4 相似刺激出现次数 Figure 4 Number of occurrences of similar stimuli |

由图 5可以可知,在输入为相似刺激时,神经元输出逐渐减小,最终趋近于零,对应于图 4中相似刺激增加过程,模拟生物神经细胞的习惯化过程;在输入为随机刺激时,神经元输出为没有习惯化过程,对应于图 3中相似刺激基本为0的过程,输出与经典M-P神经元输出相同。由图 3~5可知习惯化神经元具有典型的习惯化特性。

|

图 5 习惯化神经元输出 Figure 5 Habituation neuron output |

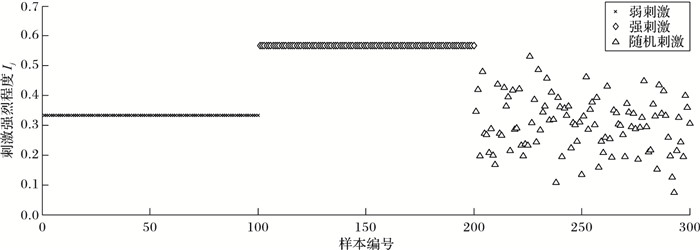

表 2给出了去习惯神经元的参数,z1、z2、z3为输入刺激,样本1~100为弱刺激,样本101~200为强刺激,样本201~300为服从[0, 1]区间随机均匀分布的随机数。一个系统越有序,信息熵就越低;反之,一个系统越乱,信息熵越高。样本的信息熵根据熵在统计热力学中的公式H=klnW得出,其中k为玻尔兹曼常数,W为微观状态数。在本实验中,样本1~200信息均为定值,因此求得信息熵H为0.1;样本201~300信息包含随机序列,故信息熵H为0.7。能量均值取输入刺激的平均值,即E=(z1+z2+z3)/3,a=0.3,IT=0.5,λ=2。神经元输入设为常数,方便观察习惯化和去习惯化过程。

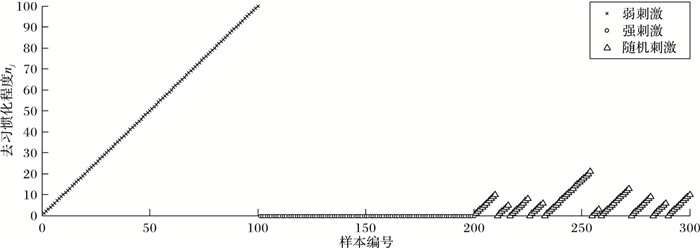

由图 6、图 7可知,样本1~100为弱刺激,nj逐渐增加,βj逐渐趋近于1,不具有去习惯化特性;样本101~200为强刺激,nj为0,βj上升为(1+λ),具有去习惯化特性;样本201~300, 为随机刺激,既有弱刺激也有强刺激,所以nj也是随机地既有逐渐增加的过程,也有为零的过程。

|

图 6 输入刺激强烈程度 Figure 6 Degree of input stimulus intensity |

|

图 7 去习惯化程度 Figure 7 Degree of dishabituation |

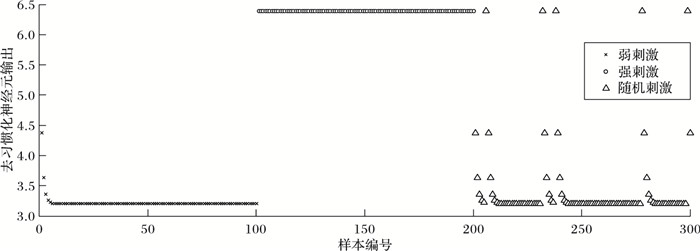

图 8为去习惯化神经元输出,可以看出,样本1~100在弱刺激情况下的神经元输出逐渐减小,呈现习惯化过程;样本101~200在强刺激情况下的神经元输出得到增强,对已习惯化的模式重新产生强烈的响应,从而形成去习惯化过程;样本201~300在随机刺激情况下的神经元输出既有减弱,也有增强。

|

图 8 去习惯化神经元输出 Figure 8 Dishabituation neuron output |

本文通过深入分析生物神经细胞的非联合型学习机制,获得该机制的简化描述,并在M-P神经元模型基础上进行扩展,获得具有习惯化、去习惯化学习能力的学习神经元模型。经实验验证,本文所提的学习神经元模型具有典型的非联合型学习功能。融合生物神经细胞非联合学习机制的学习神经元具有更坚实的生物学基础,其改变了经典神经元的结构和信息处理过程,提高了神经元的学习能力,扩展了人工神经元的功能结构,也为构建具有更强的学习能力和解决复杂问题能力的新型神经网络提供了良好的基础

在后续的研究工作中,将会研究生物神经元另一非联合学习特性--敏感化,并将具有非联合学习机制的学习神经元应用到人工神经网络,解决背景建模与运动物体提取问题,而后模拟中枢神经系统的结构和机制,设计中枢模式发生器,应用于机器人步态控制领域。

| [1] | SWEATJ D. Mechanisms of Memory[M]. 2版. 北京: 科学出版社, 2012: 237-289. (SWEAT J D. Mechanisms of Memory[M]. 2nd ed. Beijing: Science Press, 2012: 237-289.) |

| [2] | NICHOLLSJ G. From Neurons to Brain[M]. 5版. 北京: 科学出版社, 2014: 428-436. (NICHOLLS J G. From Neurons to Brain[M]. 5th ed. Beijing: Science Press, 2014: 428-436.) |

| [3] | GAZZANIGAM S, LVRYR B, MANGUNG R. Cognitive Neuroscience:the Biology of the Mind[M]. 3版. 北京: 中国轻工业出版社, 2011: 349-356. (GAZZANIGA M S, LVRY R B, MANGUN G R. Cognitive Neuroscience:the Biology of the Mind[M]. 3rd ed. Beijing: Beijing Light Industry Press, 2011: 349-356.) |

| [4] | 许少华, 何新贵. 基于函数正交基展开的过程神经网络学习算法[J]. 计算机学报, 2004, 27(5): 645-650. (XU S H, HE X G. Learning algorithm of process neural network based on orthogonal function basis expansion[J]. Chinese Journal of Computers, 2004, 27(5): 645-650.) |

| [5] | 李大刚, 王小艺, 刘载文, 等. 过程神经网络水华预测方法研究[J]. 计算机与应用化学, 2011, 28(2): 173-176. (LI D G, WANG X Y, LIU Z W, et al. Research water-bloom prediction based on process neural network[J]. Computer and Applied Chemistry, 2011, 28(2): 173-176.) |

| [6] | 王兵, 李盼池, 杨冬黎, 等. 云过程神经网络模型及算法研究[J]. 电子与信息学报, 2015, 37(1): 110-115. (WANG B, LI P C, YANG D L, et al. Research on cloud process neural network model and algorithm[J]. Journal of Electronics and Information, 2015, 37(1): 110-115. DOI:10.11999/JEIT140329) |

| [7] | 王兵, 许少华, 孟耀华, 等. 结构自适应的半监督自组织过程神经网络[J]. 控制与决策, 2015, 30(3): 507-512. (WANG B, XU S H, MENG Y H, et al. Semi-supervised self-organizing process neural network with self-adaptive structure[J]. Control and Decision, 2015, 30(3): 507-512.) |

| [8] | AIZENBERG I. Periodic activation function and a modified learning algorithm for the multivalued neuron[J]. IEEE Transactions on Neuron Networks, 2010, 21(12): 1939-1949. DOI:10.1109/TNN.2010.2082561 |

| [9] | LIU C-Y, CHEN C, CHANG C-T, et al. Single-hidden-layer feed-forward quantum neural network based on Grover learning[J]. Neural Networks, 2013, 45: 144-150. DOI:10.1016/j.neunet.2013.02.012 |

| [10] | 班晓娟, 刘浩, 刘卓然. 一种基于能量人工神经元模型的自生长、自组织神经网络[J]. 自动化学报, 2011, 37(5): 615-622. (BAN X J, LIU H, LIU Z R. An energy artificial neuron model based self-growing and self-organizing neural network[J]. Acta Automatica Sinica, 2011, 37(5): 615-622.) |

| [11] | 钱夔, 宋爱国, 章华涛, 等. 基于单胺类神经递质调节发育算法的机器人视觉定位[J]. 机器人, 2014, 36(3): 362-368. (QIAN K, SONG A G, ZHANG H T, et al. Robot vision location based on developmental algorithm of monoamine neurotransmitters modulation[J]. Robot, 2014, 36(3): 362-368.) |

| [12] | MULLER K J, NICHOLLS J G, STENT G S. In Neurobiology of the Leech[M]. New York: Cold Spring Harbor Laboratory, 1981: 27-34. |

| [13] | 张爱华, 顾建文, 郑崇勋. 中枢兴奋性传递的突触后电位小波熵分析研究[J]. 西安交通大学学报, 2004, 38(4): 428-431. (ZHANG A H, GU J W, ZHENG C X. Study on neural excitatory transmission by wavelet entropy analysis of presynaptic potentials[J]. Journal of Xi'an Jiaotong University, 2004, 38(4): 428-431.) |