2. 上海交通大学 计算机模式识别实验室, 上海 200240

2. Computer Pattern Recognition Laboratory, Shanghai Jiao Tong University, Shanghai 200240, China

目标检测识别是利用计算机技术对图像进行解译,并检测识别出不同种类的目标和对象,是计算机视觉领域的一个主要研究方向,在以图像为主体的智能化数据采集与处理中具有十分重要的作用和影响。它能够有效地处理特定目标物体的检测和识别、图像的分类标注以及主观图像质量评估等问题。目前图像检测识别技术在图像搜索、商品推荐、用户行为分析以及人脸识别等互联网应用产品中具有巨大的商业市场和良好的应用前景,同时在智能机器人、自动驾驶和无人机等高新科技产业以及生物学、医学和地质学等众多学科领域具有广阔的应用前景[1]。而特定目标的检测这种对于人来说是再简单不过的任务,计算机却很难直接得到图像中的高层语义概念,也不清楚目标出现在图像中哪个区域。图像中的目标可能出现在任何位置,目标的形态可能存在各种各样的变化,背景千差万别,再加上遮挡问题、光照变化等众多难点的存在,导致特定目标检测并不是一个容易解决的任务,一直以来都是模式识别与计算机视觉研究领域中极为活跃的问题。

在传统模式识别方法的系统框架中,通常需要相当专业的知识来设计一个特征提取模块,把原始数据转换成一个适当的特征表示或特征向量,之后则是利用合适的分类器,对输入的样本进行检测或分类。因此传统的模式识别方法会在特征选择和分类器选择上耗费研究人员绝大部分的精力。纵观近十年关于目标检测问题的研究,经典算法DPM (Deformable Parts Model)在方向梯度直方图(Histogram of Oriented Gradient, HOG)特征[2]的设计思路上进行改进,连续获得了三年PASCAL-VOC (Pattern Analysis, Statistical modelling and ComputAtional Learning Visual Object Classes)比赛的目标检测冠军[3];2009年Gall等[4]提出了一种霍夫森林(Hough Forest)算法,在隐式形状模型(Implicit Shape Model, ISM)[5]的基础上作了改进,训练特定类目标的Hough Forest投票模型并根据各个部分对目标中心的投票结果,完成目标检测任务。传统的模式识别方法实现的目标检测算法通常需要的训练数据规模不大,时间成本较低,然而普遍具有对噪声敏感、实时性低、模型泛化能力差等缺点。

深度学习作为机器学习的一个分支,属于特征学习方法,计算机能够自发地把原始数据通过一些简单的非线性映射关系组合转变成为更高层次、更加抽象的表达。并且通过足够多的转换组合,能学习到极为复杂的模型。与此同时,更深层的表达能够强化输入数据的判别性,并削弱不相关因素的影响[6]。2006年, Hinton等[7]第一次提出了深度学习的思想,主要提出了两个观点:1) 多隐层的神经网络具有强大的特征学习能力,通过训练模型所提取的特征对原始输入数据生成更抽象、更体现本质的表述,从而有利于解决特征可视化或分类问题;2) 通过无监督学习算法实现一种称作“逐层初始化”的方法,针对梯度在传播过程中消失的问题,有效地降低深度神经网络的训练难度。随后,深度学习的研究在学术界和工业界持续升温,并且在语音识别、图像识别和自然语言处理等领域获得了突破性的进展。仅仅一年之后,基于卷积神经网络(Convolutional Neural Network, CNN)的深度学习模型在大规模图像分类任务上大幅提高了分类精度,掀起了深度学习研究的热潮[1]。同时,基于卷积神经网络解决目标检测识别问题的研究热度也呈现出爆发态势的增长。在目标检测领域,Ross Girshick于2014年发表的R-CNN算法[8],开创性地结合了Region-Proposal和CNN,将目标检测任务转化为图像分类任务,在PASCAL VOC 2007数据集上的mAP (mean Average Precision)达到了58%。之后在此基础上,改进版R-CNN——Fast R-CNN[9]和Faster-RCNN[10]被陆续提出,为该领域的发展作出了巨大贡献。深度卷积神经网络实现的目标检测算法充分利用了图形处理器(Graphics Processing Unit, GPU)等现代硬件优势,实时性相对更高,同时得益于百万甚至千万级别的训练样本规模,模型的泛化能力和鲁棒性也得到了显著增强。

1 相关工作 1.1 Hough Forest目标检测通过训练特定目标类别的Hough Forest,由各个尺度不变特征转换(Scale-Invariant Feature Transform, SIFT)特征patch对物体的中心位置投票,选取局部极值作为物体的中心。Hough Forest具有如下特点:1) 叶子节点保存具有判别性的码本,包含一个patch是来自物体还是来自背景,物体中心距离当前patch中心的位置的信息;2) 建立Hough Forest可以优化投票性能,叶子节点投票时的不确定度将降低。

Hough Forest实现目标检测算法流程如下:

1) 训练部分。利用有监督的方式训练Hough Forest:训练数据特征提取;叶子节点存储总的类别构成和偏移量以形成码本;每个节点得到很多patch,如果达到成为叶子节点的标准,该节点作为叶子节点;否则进行二值测试,将节点上的patch拆分给子节点。

二值测试的过程:给定一些patch,其集合设为A,且A={pi=(Ii, ci, di)},其中,Ii表示第i个patch, ci为其类标,di为离中心的偏移量;均匀采样得到一系列测试像素,然后随机选择最小化类别不确定性或者偏移量不确定性。类别不确定性表达式为:

| ${U_1}(A) = \left| A \right| \cdot Entropy({\text{\{ }}{{\text{c}}_i}{\text{\} }})$ | (1) |

式中:Entropy ({ci})定义为E ({ci})=-c·log c-(1-c)·log(1-c),式(1) 用来衡量类别不纯度。

偏移量不纯度表达式为:

| ${U_2}(A) = \sum\limits_{i:{c_i} = 1}^{} {{{({d_i} - {d_A})}^2}} $ | (2) |

均匀抽样后产生一系列测试像素{tk},对其不确定性求和:

| $\mathop {\arg \min }\limits_k (U(\{ {p_i}|{t^k}({I_i}) = 0\} ) + U\{ {p_i}|{t^k}({I_i}) = 1\} )$ | (3) |

其中随机选取可以保证叶子节点的类别不确定性和偏移量不确定性都比较低[11]。

2) 检测部分。将测试图像按尺度缩放,建立图像金字塔,目的是提取不同尺度下的特征。

3) 将每一个特征patch输入Hough Forest各个尺度内进行投票。在Hough空间内搜索局部极值作为目标中心候选点。最后用非极大值抑制去除冗余目标中心,输出目标。

本文选择尺度不变性特征(SIFT)[12]实现针对航空器目标的Hough Forest算法来作对比实验。该算法相对其他的传统目标检测算法有一定速度上的优势,但仍然有很多明显的缺陷,比如对于大尺寸检测图像来说,建立多层图像金字塔的空间和时间成本并不低;投票仅能实现对目标中心的预测,预设了同尺度下bounding-box的大小不变的前提。

1.2 YOLO实时目标检测YOLO算法将目标检测和识别作为回归问题来解决,提出了一种端到端的算法同时完成这两个任务[13]。

YOLO目标检测算法流程如下:

1) 给定输入图像,将图像划分成7×7网格。

2) 对于每个网格,通过卷积神经网络预测2个bounding-box。

3) 调整阈值去除置信度过低的目标,用非极大值抑制去除冗余bounding-box。

YOLO算法将目标检测任务转换成一个回归问题,大幅提高了检测的速度,达到了45 frame/s。在网络结构上,YOLO采用了24层卷积层加2层全连接层的结构,因此最终的分类器能够很好地整合图像的全局信息,在充分的上下文关系帮助下,使得虚警出现的比例大幅降低。然而YOLO也存在一个关键问题:使用了7×7的网格回归,导致目标定位误差大,检测精度受到限制,同时也无法检测到过小的目标。

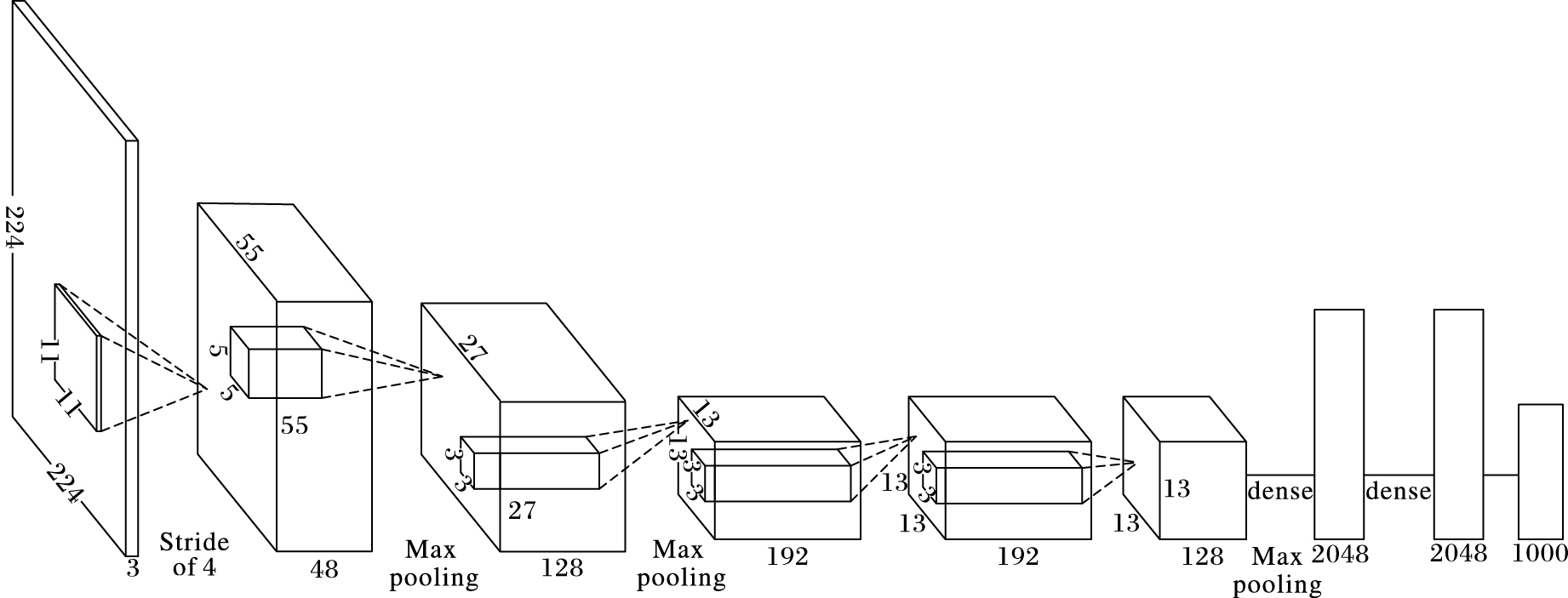

1.3 AlexNet图像分类网络AlexNet获得了ILSVRC2012图像分类第一名,是近几年卷积神经网络在图像方面应用的里程碑式模型[14]。AlexNet采用了5层卷积层加3层全连接层的结构,相对卷积神经网络的经典模型LeNet来说复杂了许多。AlexNet的网络架构如图 1所示。AlexNet在细节处理方面结合了文献[14]的改进方法,使用了ReLU作为激活函数,并使用了Dropout的方式防止过拟合现象。AlexNet中一层完整的卷积层包括了卷积、ReLU、Max-pooling以及Normalization四个部分。最后对训练数据作了增量处理,再次降低了过拟合的风险。

|

图 1 AlexNet网络结构 Figure 1 Network architecture of AlexNet |

卷积神经网络是可以用作处理多维数组类型的数据的算法,三通道的RGB图像就是一个典型的例子,它的四个关键部分分别是:局部连接、权值共享、池化以及多层卷积。

一个典型的卷积神经网络结构由这样一系列步骤组成:第一个阶段包含卷积层和池化层,卷积层单元(卷积核)位于特征图(Feature Map)中,每一个卷积核通过一组权值和上一层的特征图的某个局部块作卷积,即局部连接;然后将这个加权和传递给一个非线性激活函数,例如Sigmoid函数或者ReLU。同一个特征图中所有单元共享权值,不同层的特征图则使用不同的权值,即权值共享。显而易见,权值共享大大减少权重参数的数量。使用局部连接和权值共享能够起作用主要是因为:通常一个特征点附近的值是高度相关的,可以形成比较容易被探测到的有区分性的局部特征;其次,不同位置局部统计特征不太相关,也就是说在一个地方出现的某个特征可能会出现在别的地方,所以不同位置的单元可以共享权值。卷积层的作用是感知上一层特征的局部连接,然而池化层的作用则是在语义上把相似的特征合并起来,因为形成同一个主题的特征的相对位置通常会不太一样。池化单元一般会计算特征图中某一个局部块的最大值,相邻的池化单元通过移动一行或者一列来从块上读取数据。多个卷积层、非线性变换以及池化层串联起来,最后再加上全连接层,就构成了一组卷积神经网络的主体。在实际应用中,往往使用多层卷积的方式,因为层数越多,越能学习到更高语义的特征。

神经网络所利用的很多自然信号是具有明显层级特征的属性,其中高级的特征是通过对低级特征的组合来实现的。在图像中,边缘的组合形成基本图案,这些图案形成物体的局部,然后再构成物体。这种层级结构也存在于语音数据以及文本数据中,如:电话中的声音和音节、文档中的单词和句子。当输入数据在前一层中的位置有变化的时候,池化操作使得这些特征表示对这些变化具有鲁棒性。卷积神经网络中的卷积和池化层灵感直接来源于视觉神经科学中的简单细胞和复杂细胞[15],它们以LNG-V1-V2-V4-IT层级结构形成视觉回路[16]。卷积神经网络与神经认知的架构有点相似[17],不过在神经认知中并没有类似反向传播算法这种端到端的监督学习算法。

2.2 航空器检测识别本文所设计框架的应用场景是:针对对地卫星拍摄的包含军用机场的大尺寸光学图像,需要分别输出航空器目标的定位框和航空器类型识别结果。受限于应用场景的规定,本框架需要分别完成bounding-box检测和类型识别两个模块,并各自配有可视化输出。由于项目对目标检测的要求较高,提高检测率的同时还要保证实时性。与此同时,通过观察数据集,发现各类的训练数据不均衡,因此直接采用检测-识别同时完成的框架,会导致检测率和识别率大幅降低。综合考虑各个因素,本文提出了融合两个网络来完成航空器目标检测识别任务。

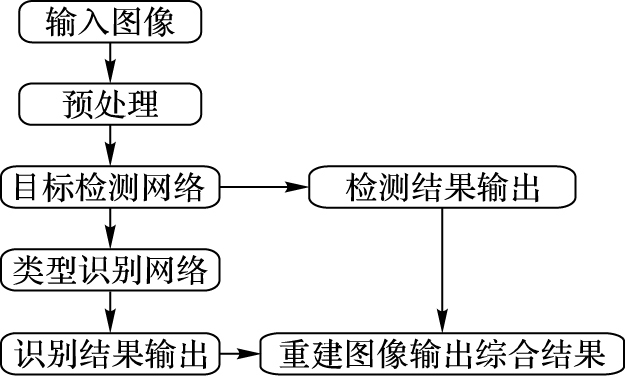

如图 2所示,本文算法流程大致可分为预处理输入图像、目标检测、类型识别、以及输出综合结果四个阶段。

|

图 2 本文算法流程 Figure 2 Flow chart of the proposed algorithm |

检测部分, 本文在YOLO算法的基础上作了改进,YOLO关键问题是采用网格分割图像导致的检测精度下降以及检测过小目标的问题。

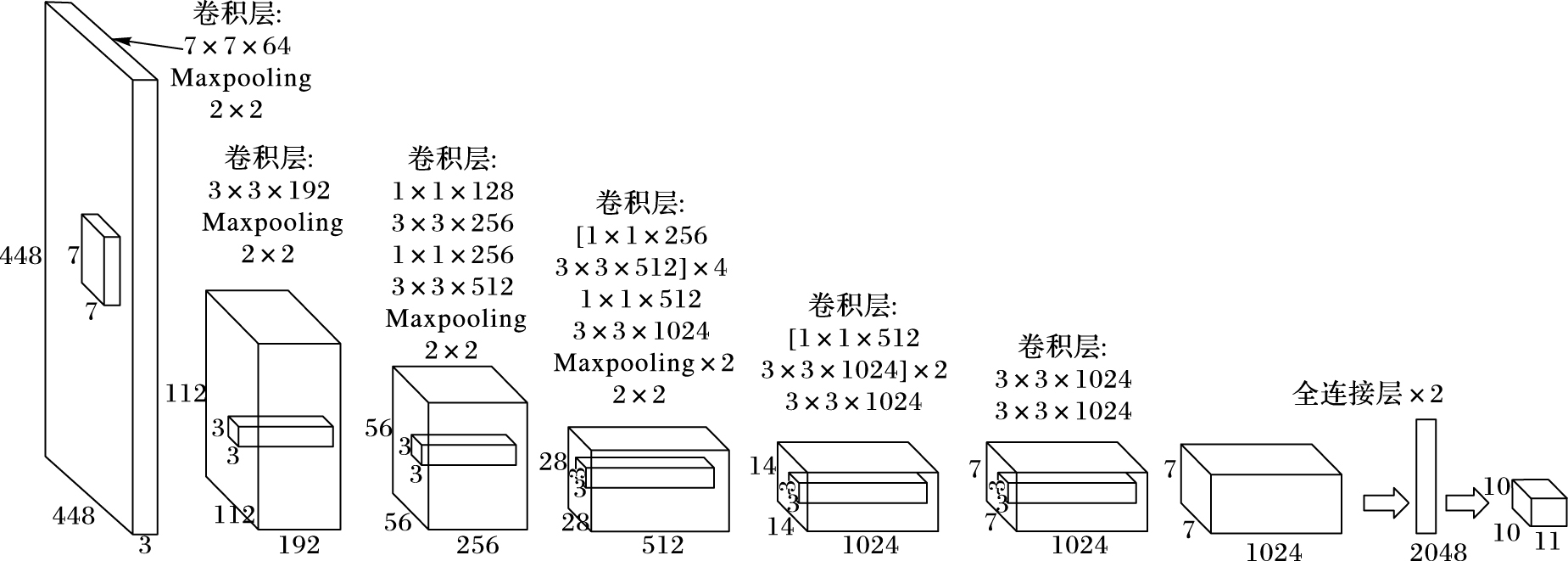

图 3给出了目标检测部分的网络架构,由24个级联的卷积层以及2个全连接层构成。

|

图 3 目标检测网络结构 Figure 3 Network architecture of target detection |

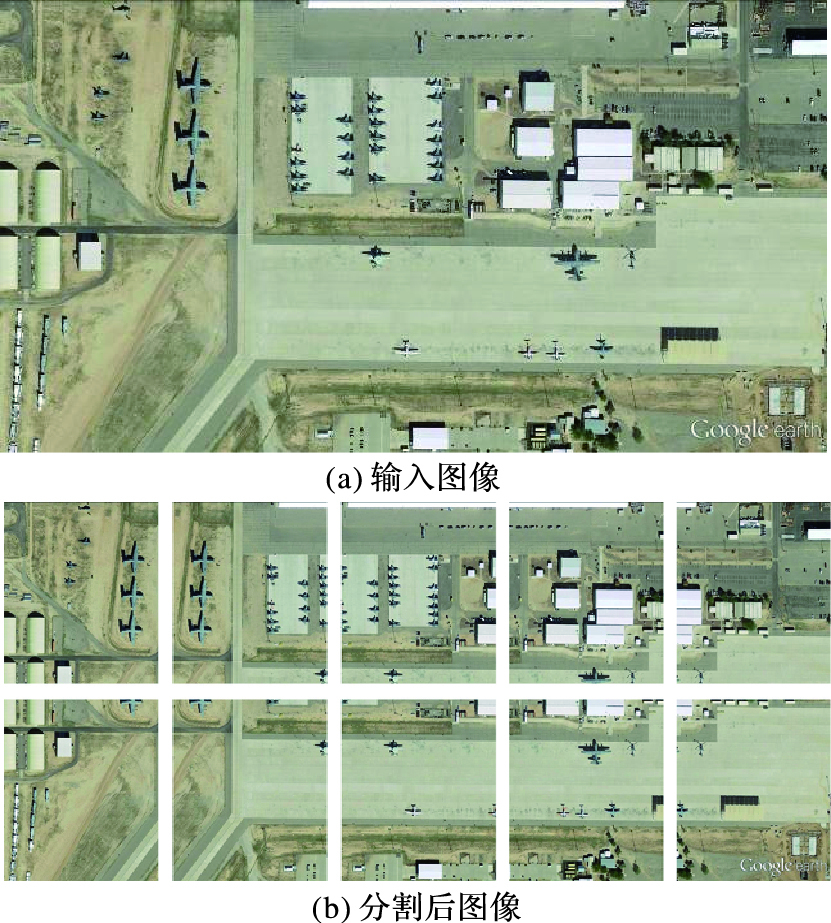

针对实际应用场景,本文主要有两点改进:1) 简化Prediction-Tensor,同时增加网格数量,在保证参数基本不增加的情况下完成更为精确的bounding-box预测。2) 在预处理部分对图像作参数自适应的带重叠区域分割,使分割后的图像保持与网络输入层的目标尺寸接近,这样做能有效防止在缩放过程中出现过小目标因而无法检测。同时,带重叠区域的分割策略能避免目标被错分割,从而影响检测结果。图 4给出了预处理过程中分割步骤的例图,本例中对原图进行了2×5的分割策略。

|

图 4 分割预处理示意图 Figure 4 Schematic diagram of segmentation preprocessing |

对于预处理后的输入图像,将其分成10×10个网格,每个目标中心对应到所处网格内。每个网格最终会预测出2个bounding-box以及对应的置信度,每个bounding-box包含5个分量:目标中心位置坐标(x, y)、bounding-box的长宽(w, h)、以及对应的置信度c。其中置信度c定义为c=Pr(Object)*IOUpredictiongroundtruth, 若不存在目标,c的值为0;否则等于预测值和真值之间的IOU (Intersection Over Union)。

Prediction-Tensor维度的计算公式为:

| $P = S \times S \times (B \times 5 + C)$ | (4) |

其中:S×S为网格数;B为每个网格所预测的bounding-box数;C则是网络监测目标的类别数。由于简化了检测网络中的类别数C=1,降低了该向量Prediction-Tensor的维数,最终其维数为1 100。

在激活函数的选择上, 本文参考了PReLU (Parametric ReLU)[18],使用了如下形式的函数:

| $f({y_i}) = \left\{ \begin{gathered} {y_i}, & {y_i} > 0 \hfill \\ {a_i}{y_i}, & {y_i} \leqslant 0 \hfill \\ \end{gathered} \right.$ | (5) |

其中:yi是非线性函数f (yi)的输入;ai协同作用在函数非正区域的效率上,是各个通道下网络在训练过程中学习到的参数。虽然使用ReLU一定程度上增加了参数的个数,这与整个网络所需要学习的参数个数相比是可以忽略的,因此由ai增加的过拟合风险可以忽略。

训练过程中对ai的更新加入了动量μ,如式(6) :

| $\Delta {a_i}: = \mu \Delta {a_i} + \epsilon \delta \varepsilon /\left( {\delta {a_i}} \right)$ | (6) |

其中:

损失函数(loss function)的作用是估计模型的预测值与真值的差别,它是经验风险函数的核心部分,也是结构风险函数重要组成部分,通常被设计为一个非负实值函数,损失函数越小,模型的性能就越好。模型的学习过程可以认为是一个最优化目标损失函数的过程。在损失函数的设计上,本文采用的是较易优化的误差平方和,来对模型进行训练。简单的误差平方和应用在本文的Prediction-Tensor上有较大的缺陷——会对存在与不存在目标的两种网格的得分同等对待,由于实际应用中大部分网格不存在目标,这就导致了存在目标的网格作用被放大,大部分网格的得分趋向于0,训练过程过早发散,无法收敛。因此在loss函数中加入了权重因数λc和λn来调整两类网络的误差平方和,其中λc:λn=10:1。

损失函数表达式floss如下:

| $\begin{align} & {{f}_\rm{loss}}={{\lambda }_{c}}\sum\limits_{i=0}^{{{S}^{2}}}{\sum\limits_{j=0}^{B}{[1_{ij}^{obj}{{({{x}_{i}}-\overset{\wedge }{\mathop{{{x}_{i}}}}\, )}^{2}}+{{({{y}_{i}}-\overset{\wedge }{\mathop{{{y}_{i}}}}\, )}^{2}}]}}+ \\ & \quad {{\lambda }_{c}}\sum\limits_{i=0}^{{{S}^{2}}}{\sum\limits_{j=0}^{B}{[1_{ij}^{obj}{{({{\sqrt{\omega }}_{i}}-{{\sqrt{\overset{\wedge }{\mathop{\omega }}\, }}_{i}})}^{2}}+{{({{\sqrt{h}}_{i}}-{{\sqrt{\overset{\wedge }{\mathop{h}}\, }}_{i}})}^{2}}]}}+ \\ & \quad \sum\limits_{i=0}^{{{S}^{2}}}{\sum\limits_{j=0}^{B}{1_{ij}^{obj}{{({{C}_{i}}-\overset{\wedge }{\mathop{{{C}_{i}}}}\, )}^{2}}}}+{{\lambda }_{n}}\sum\limits_{i=0}^{{{S}^{2}}}{\sum\limits_{j=0}^{B}{1_{ij}^{noobj}{{({{C}_{i}}-\overset{\wedge }{\mathop{{{C}_{i}}}}\, )}^{2}}+}} \\ & \quad \sum\limits_{i=0}^{{{S}^{2}}}{1_{ij}^{obj}\sum\limits_{c\in classes}^{{}}{{{({{p}_{i}}(c)-{{\overset{\wedge }{\mathop{p}}\, }_{i}}(c))}^{2}}}} \\ \end{align}$ | (7) |

其中:1iobj表示第i个网格中是否存在目标,而1ijobj则表示了第i个网格中的目标是否由第j个bounding-box预测得到;λc和λn分别为针对包含目标与不包含目标网格所设置的权重系数;S2为网格数;B为每个网格预测的bounding-box数,其余变量分别表示bounding-box包含的5个分量——目标中心位置坐标(x, y)、bounding-box的长宽(w, h),以及对应的置信度c。

2.2.2 分类网络在目标分类任务中可以使用多种典型图像分类网络,包括:AlexNet、CaffeNet、GoogleNet[19]、VGGNet、ResNet等。针对应用场景本文参考了AlexNet和ResNet-50两种网络结构来实现分类任务。

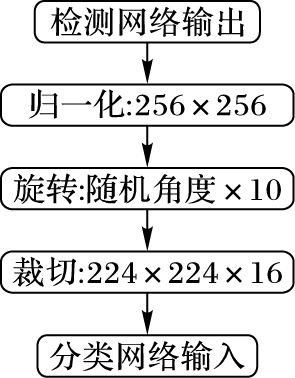

为了尽量防止过拟合问题发生,本文同样采用了数据扩充的策略。每一张来自上一级目标检测网络输出的图像都经过了固定倍数的数据扩充,同时这也能改善自采数据集数据规模过小带来的问题。图 5简要表述了数据扩充部分中的3个处理阶段。

|

图 5 数据扩充流程图 Figure 5 Flow chart of data augmentation |

训练过程中同样加入了Dropout,目的是在模型训练时随机让网络某些隐含层节点的权重不工作。不工作的那些节点可以暂时认为不是网络结构的一部分,但是下次样本输入时它可能会重新工作,所以它的权重依然会被保留下来。这种策略一定程度上减少了每次迭代训练中参数的个数,可以有效防止过拟合现象的发生。

本文的激活函数使用PReLU函数,和上一级网络保持一致。在卷积神经网络中,Pooling层总结了同一核映射中邻近神经元组的输出。通过邻接Pooling单元总结的邻近关系不重叠,也就是说一个Pooling层可以被认为是由间隔S像素的Pooling单元网格组成,每个网格输出一个Z×Z大小的邻近关系,均位于Pooling单元的中心位置。本文参考AlexNet的设计,在Pooling层中设定了S<Z,这种重叠Pooling的策略能有效改善分类结果,同时一定程度上降低了过拟合的风险。

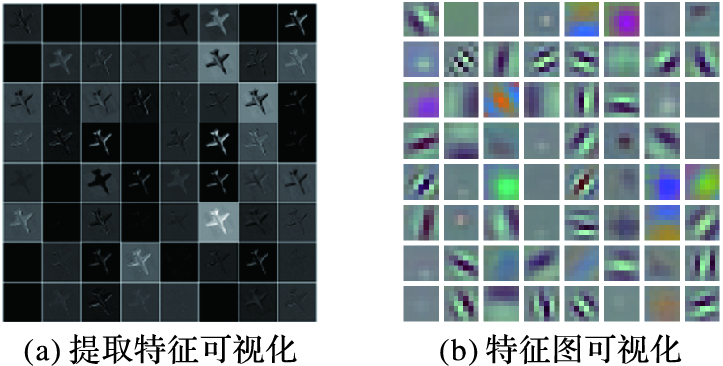

图 6给出了分类网络中的第一个卷积层所提取的图像特征的可视化结果,可以看到较浅的卷积层提取的特征信息基本上是边缘等底特征,具象且容易理解。

|

图 6 第一卷积层可视化 Figure 6 Visualization of layer-1 convolution |

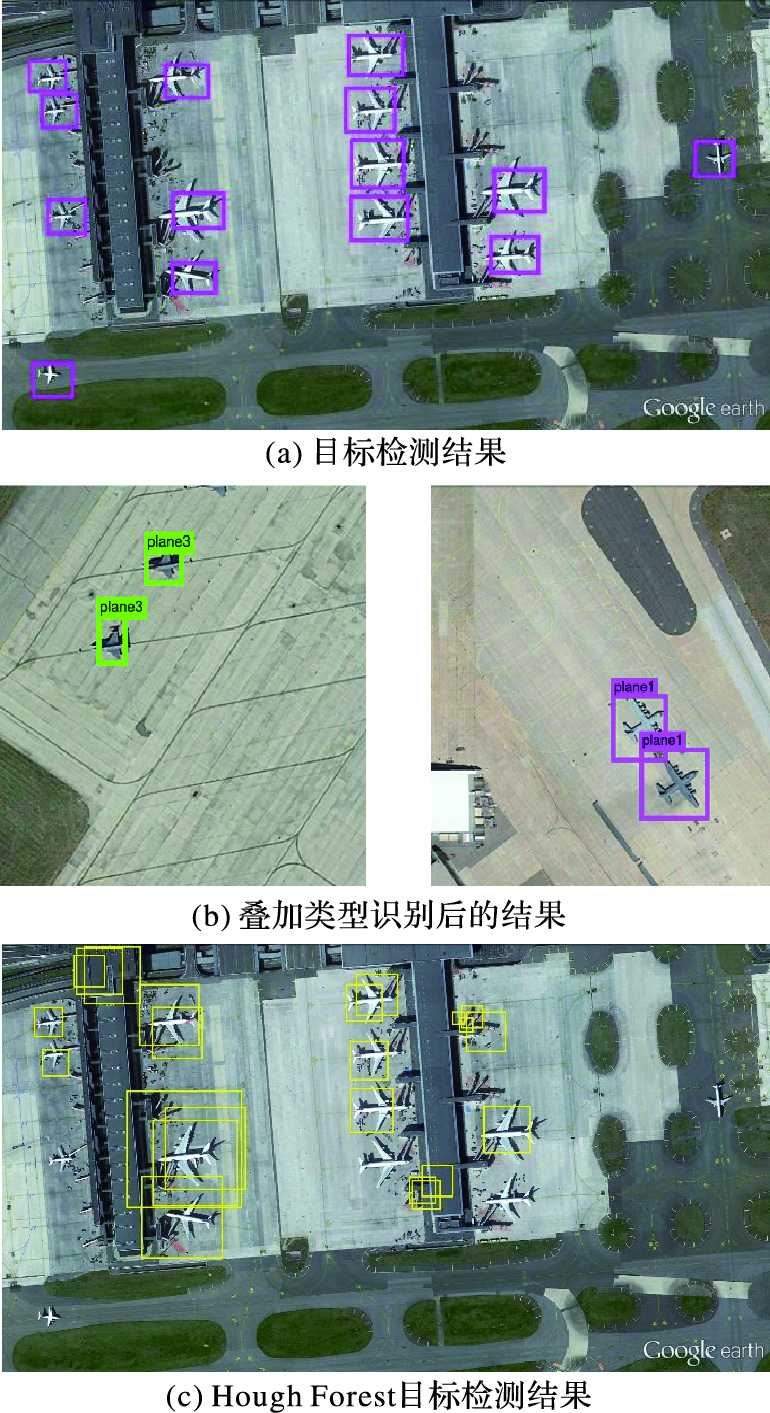

针对本文的应用场景,测试该框架所使用的数据集为自采数据集,经过增量处理后,包含19 600张带标注数据的统一尺寸机场图像,共计35 110个标注目标。10 846张独立航空器切片,分类目标为运输机、轰炸机、战斗机、预警机、直升机以及民用客机。数据集中训练和测试数据比例为8.5:1.5。图 7(a)、(b)显示了该框架中两个模块的输出结果,图 7(c)显示了检测实验中所采用对比方法Hough Forest的检测效图。

|

图 7 目标检测和类型识别输出结果 Figure 7 Output of target detection and classification recognition |

实验平台硬件及操作系统信息如表 1所示。

| 表 1 实验平台信息 Table 1 Experiment platform information |

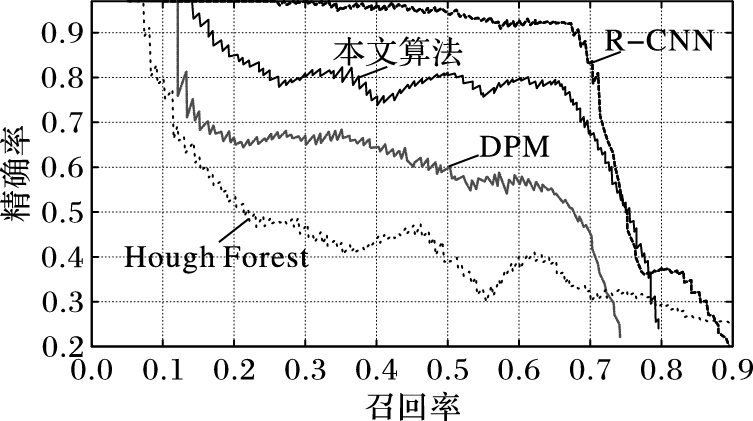

目标检测阶段在该数据集上的对比测试结果如图 8和表 2所示。

| 表 2 目标检测实验结果 Table 2 Experimental results of target detection |

|

图 8 目标检测精确率-召回率曲线 Figure 8 Precision-recall curve of target detection |

考虑到应用场景限制,航空器目标检测部分实验忽略了Bounding-box的IOU,仅考察了目标的召回率(recall)和精确率(precision)。检测时间计算为检测整幅图像所耗的时间,对比算法均使用C++实现,其中R-CNN和本文检测算法基于caffe架构实现。

从图 8以及表 2可以看出,由于充分利用了GPU并行计算的性能优势,本文算法的实时性能相对仅仅基于CPU计算的传统目标检测算法DPM和Hough Forest有很大的提升。同时,区别于同为卷积神经网络实现的R-CNN算法,本文算法直接将网格化后的原图像进行bounding-box的回归预测,端到端的算法流程在实时性能上也有了显著提升。

类型识别部分实验中,由于总类数仅有6类,所以仅考察了两种网络下的Top-1分类错误率(Top-1分类错误率指的是模型预测出最高置信度的类别不正确的比例),反映了该分类模型的精确率;并且比较了平均每张切片的分类时间,两种网络均基于caffe架构实现。表 3给出了类型识别阶段在该数据集上的实验结果,可以看出,对于此类规模的数据集,卷积神经网络在图像分类问题上达到了较高的正确率,其性能相对于传统的模式识别方法有显著优势;网络的深度增加也在一定程度上提升了模型的泛化能力,同时带来的还有计算资源开销的大幅上升,因此在具体应用问题中需要权衡这两点来设计合适的网络模型。

| 表 3 类型识别实验结果 Table 3 Classification recognition experimental results |

本文提出了一套针对具体应用场景的目标检测识别系统框架,满足了应用场景中同时需要目标位置和目标内容两组输出的要求,并应用到自采数据集上开展了实验。系统主要由一个检测网络和一个识别网络级联而成,需要根据要求的精确率和实时性来权衡选择具体的网络模型,比如在识别网络中AlexNet的精度较ResNet低了接近15%,但是在实时性上则提高了超过50%。本文的检测网络与部分检测算法进行了对比,精度处在一个可接受范围内,而实时性则有大幅度提升。实验验证,对于实时性要求较高并且样本是大尺寸图片的应用问题来说,本文提出了一种可行的解决思路。

由于目前还无法从公开途径获取到聚焦于军用机场上多类型航空器检测任务的公开数据集,本文仅在自采数据集上进行了实验,因此其结果还存在一定的局限性,无法反映算法在更大规模数据集上的泛化性能。其次,本文基于深度神经网络实现的算法其效率很大程度上依赖于计算硬件的水平,因此在不同等级的计算硬件上表现差异巨大,如何优化算法,降低对硬件计算能力的要求是下一步的研究方向。

| [1] | 卢宏涛, 张秦川. 深度卷积神经网络在计算机视觉中的应用研究综述[J]. 数据采集与处理, 2016, 31(1): 1-17. ( LU H T, ZHANG Q C. Applications of deep convolutional neural network in computer vision[J]. Journal of Data Acquisition and Processing, 2016, 31(1): 1-17. ) |

| [2] | DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//CVPR'05:Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2005:886-893. |

| [3] | FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D. Cascade object detection with deformable part models[C]//Proceedings of the 2010 IEEE conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2010:2241-2248. |

| [4] | GALL J, LEMPITSKY V. Class-specific hough forests for object detection[M]. London: Springer, 2013 : 143 -157. |

| [5] | LEIBE B, LEONARDIS A, SCHIELE B. Combined object categorization and segmentation with an implicit shape model[EB/OL].[2016-09-10]. http://vision.stanford.edu/cs598_spring07/papers/LeibeSchiele2004.pdf. |

| [6] | LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444. doi: 10.1038/nature14539 |

| [7] | HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507. doi: 10.1126/science.1127647 |

| [8] | GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2014:580-587. |

| [9] | GIRSHICK R. Fast R-CNN[C]//ICCV'15:Proceedings of the 2015 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2015:1440-1448. |

| [10] | REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN:towards real-time object detection with region proposal networks[C]//Proceedings of the 2015 International Conference on Neural Information Processing Systems. Cambridge, MA:MIT Press, 2015:91-99. |

| [11] | 尤玮, 戴声奎. 基于多特征与改进霍夫森林的行人检测方法[J]. 计算机工程与设计, 2014, 35(10): 3538-3544. ( YOU W, DAI S K. Pedestrian detection algorithm using multiple features and improved Houghforest[J]. Computer Engineering and Design, 2014, 35(10): 3538-3544. doi: 10.3969/j.issn.1000-7024.2014.10.035 ) |

| [12] | LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110. doi: 10.1023/B:VISI.0000029664.99615.94 |

| [13] | REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once:unified, real-time object detection[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2016:779-788. |

| [14] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//NIPS'12:Proceedings of the 2012 25th International Conference on Neural Information Processing Systems. Cambridge, MA:MIT Press, 2012:1097-1105. |

| [15] | HUBEL D H, WIESEL T N. Receptive fields, binocular interaction and functional architecture in the cat's visual cortex[J]. Journal of Physiology, 1962, 160(1): 106-154. doi: 10.1113/jphysiol.1962.sp006837 |

| [16] | FELLEMAN D J, VAN ESSEN D C. Distributed hierarchical processing in the primate cerebral cortex[J]. Cerebral Cortex, 1991, 1(1): 1-47. |

| [17] | FUKUSHIMA K, MIYAKE S. Neocognitron:a new algorithm for pattern recognition tolerant of deformations and shifts in position[J]. Pattern Recognition, 1982, 15(6): 455-469. doi: 10.1016/0031-3203(82)90024-3 |

| [18] | HE K M, ZHANG X Y, REN S Q, et al. Delving deep into rectifiers:surpassing human-level performance on imagenet classification[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2015:1026-1034. |

| [19] | SZEGEDY C, LIU W, JIA Y Q, et al. Going deeper with convolutions[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:1-9. |