视觉目标跟踪是指对视频序列中的运动目标进行检测与跟踪,是当今计算机视觉最活跃、最具挑战性的研究领域之一,并在人机交互、安防监控、增强现实等方面发挥着重要作用。由于实际场景复杂多变,视频中目标的形变、旋转、快速移动、运动模糊及光照变化等因素都会影响跟踪的准确性,设计一个快速、鲁棒的跟踪算法仍然非常困难,为解决这些问题,各种跟踪方法被相继提出[1]。目标跟踪算法通常分为两类:判别式 (discriminative models) 和生成式 (generative models)。判别式跟踪是通过学习一个分类器来区分目标和背景,而生成式跟踪是在视频帧中寻找与目标最相似的窗口。

近年来,判别式跟踪方法中基于相关滤波理论的跟踪方法发展迅速,由于它的高速和高效,得到了广泛的关注和应用。相关滤波理论在信号处理领域中用来比较两个信号的相似性,Bolme等[2]基于此理论提出了最小误差输出平方和 (Minimum Output Sum of Squared Error,MOSSE) 的跟踪算法,把相关滤波首次引入跟踪。借助于快速离散傅里叶变换,相关滤波是把时域上的卷积转换为频域上的点积,极大减少了计算开销,显著提高了目标跟踪速度,达到了惊人的669帧每秒,完全满足实时性要求。由于该算法在实时目标跟踪上的优秀表现,此后基于此算法框架的改进算法被相继提出,其中最有影响力的为Henriques等[3-4]提出的循环结构跟踪算法 (Circulant Structure of tracking-by-detection with Kernels, CSK),它通过对单幅图像的密集采样得到具有周期性循环结构的样本,利用循环矩阵在傅氏变换中的特殊性质实现高效采样训练,最终实现快速跟踪,然后用方向梯度直方图 (Histogram of Oriented Gradient, HOG)[5]特征代替原算法中像素灰度值特征,提出了核相关滤波跟踪算法 (Kernelized Correlation Filter, KCF),极大提高了跟踪准确性。除HOG特征,CN (Color-Naming) 颜色特征[6]也加入到基于相关滤波器的跟踪算法中,并取得了不错的效果[7]。文献[8-9]在相关滤波器中引入尺度金字塔,很好地解决了跟踪过程中目标的尺度变化问题,但依旧无法在跟踪失败时恢复跟踪。由于相关滤波跟踪器没有再检测机制,当目标被遮挡或消失时跟踪器会失效,因此,为实现目标跟踪丢失后再次获得目标,Ma等[10]训练了一个随机蕨分类器的,当相关滤波器跟踪失败后,该分类器以滑动窗口的形式在视频帧上重新获得目标,以实现长时目标跟踪。基于相关滤波理论的跟踪算法还有文献[11-16],文献[17]对主流相关滤波跟踪算法进行了比较和总结。

针对基于相关滤波理论的跟踪算法在跟踪快速运动目标时目标丢失问题,本文在核相关滤波算法 (KCF)[4]的基础上引入基于光流法的目标再检测机制,提出了长时核相关滤波器 (Long-term Kernelized Correlation Filter, LKCF)。跟踪模块使用HOG和CN颜色特征,目标再检测模块基于光流法[18],并加入高斯分布权值,整个算法采用新的在线更新策略,所提算法能在目标跟踪丢失后再次恢复跟踪。

1 跟踪器本文所提跟踪器由跟踪模块和目标再检测模块组成,其中跟踪模块使用引入CN颜色特征的核相关滤波器 (KCF),检测模块使用光流法实现运动目标检测及位置预测。

1.1 核相关滤波器KCF的原始模型是线性回归,即f(t)=wTt,参数w需要通过训练得到,t为样本的特征向量。令i为样本序号,yi为ti对应的目标回归值,训练的目的是求最小化平方误差下的w,即:

| $\mathit{\boldsymbol{w}} = \mathop {{\rm{arg}}\,{\rm{min}}}\limits_\mathit{\boldsymbol{w}} \sum\limits_i {{{(f({\mathit{\boldsymbol{t}}_i}) - {y_i})}^2} + \mathit{\boldsymbol{\lambda }}{{\left\| \mathit{\boldsymbol{w}} \right\|}^2}} $ | (1) |

其中:λ为正则化参数。

现实中很多问题的解都是非线性的,非线性问题往往不好求解,所以希望能用解线性分类的方法求解,所采用的方法是进行非线性变换,将非线性问题变换为线性问题,通过解变换后的线性问题的方法求解原来的非线性问题[19],这种方法称为核方法,核相关滤波器 (KCF) 就是通过它求解滤波器参数w。

为获得KCF的滤波器参数w,首先需要对目标进行采样训练,传统的采样方法是在目标周围选取若干图像块,而KCF只需采集一幅图片x∈M×N,并将x分别以m、n个像素为单位进行水平和垂直方向循环偏移,从而得到不同样本xm, n,其中m∈{0, 1, …, M-1},n∈{0, 1, …, N-1},每个样本对应的回归值ym, n服从二维高斯分布。训练的目的是找到最优化权值的参数w,即:

| $\mathit{\boldsymbol{w}} = \mathop {{\rm{arg}}\,{\rm{min}}}\limits_\mathit{\boldsymbol{w}} \sum\limits_{m,n} {{{\left| {\phi ({\mathit{\boldsymbol{x}}_{m,n}})\cdot\mathit{\boldsymbol{w}} - {y_{m,n}}} \right|}^2} + \mathit{\boldsymbol{\lambda }}{{\left| \mathit{\boldsymbol{w}} \right|}^2}} $ | (2) |

其中:

根据快速傅里叶变换和岭回归法[20],解式 (2) 得:

| $\mathit{\boldsymbol{\alpha }} = {F^{ - 1}}\left( {\frac{{F\left( \mathit{\boldsymbol{y}} \right)}}{{F\left( {\phi \left( \mathit{\boldsymbol{x}} \right)\cdot\phi \left( \mathit{\boldsymbol{x}} \right)} \right) + \mathit{\boldsymbol{\lambda }}}}} \right)$ | (3) |

其中:F、F-1分别为傅里叶变换及其逆变换;y为M×N的矩阵,相应元素是ym, n。

训练上一帧目标图像块x得到参数α,再在当前帧中,于前一帧目标位置处采集相同尺寸的图像块z, 根据式 (3) ~式 (4) 获得目标在当前帧中的位置,即f(z) 最大元素所在位置。

| $f\left( z \right) = {F^{ - 1}}\left( {F\left( \mathit{\boldsymbol{\alpha }} \right) \odot F\left( {\phi \left( \mathit{\boldsymbol{x}} \right)\cdot\phi \left( z \right)} \right)} \right)$ | (4) |

其中⊙表示对应元素点乘。

1.2 特征选择KCF使用的是大小为M×N×31方向梯度直方图 (HOG) 特征值,本文所提跟踪器在其基础上引入11通道的CN颜色特征,该特征比RGB灰度特征有更好的表现能力,它根据语言学把颜色分为11种,和人眼感知到的颜色非常相似,已广泛应用于目标检测、识别及行为识别[21-23],因此,本文把RGB空间三通道特征转化为11通道的CN颜色特征使用。本文跟踪器所用的两种特征,HOG能更好地表现目标的空间梯度信息,CN颜色特征能更好地表现颜色信息,两者级联在一起共42个通道。

1.3 目标再检测相关滤波器跟踪目标的原理是把当前帧中与滤波模板作用后响应最大的地方作为目标位置,而每次进行滤波的位置是上一帧目标所在位置,当目标快速运动时,目标在当前帧中实际位置超出滤波模板滤波范围,这就造成跟踪失败。除此之外,当目标遇到遮挡、形变等情况也会造成跟踪失败,为了能重新找到目标以持续跟踪,引入目标再检测机制非常必要。不同于文献[24]在每一帧中都重新检测,本文所提再检测机制只有当目标的峰值响应强度 (Peak-to-Sidelobe Ratio,PSR)[2]小于阈值T时才开始作用。PSR的定义为式 (5):

| $PSR = ({g_{{\rm{max}}}} - \mu )/\sigma $ | (5) |

其中:gmax为滤响应峰值,μ为响应平均值,σ为响应值标准差,滤波响应值即为式中的f(z) 所得矩阵元素值。

本文再检测机制使用LK (Lucas-Kanade)[18]光流法检测运动目标,因为视频目标和背景会有相对运动,通过检测相对运动就可以重新检测到目标,以下将简要介绍光流法。

假设相邻两帧目标对应位置像素点亮度不变,即:

| $I\left( {x,y,t} \right) = I\left( {x + dx,y + dy,t + dt} \right)$ | (6) |

其中:x,y为横纵坐标;I(x, y, t) 为前一帧某一位置像素点亮度;I(x+dx, y+dy, t+dt) 为当前帧对应位置处像素点亮度。对式 (6) 右边进行泰勒展开,得式 (7):

| $\begin{array}{l} I\left( {x + dx,y + dy,t + dt} \right) = \\ \quad I\left( {x,y,t} \right) + \frac{{\partial I}}{{\partial x}}dx + \frac{{\partial I}}{{\partial y}}dy + \frac{{\partial I}}{{\partial t}}dt + o({\partial ^2}) \end{array}$ | (7) |

由式 (6) ~(7) 得式 (8) ~(9):

| $\frac{{\partial I}}{{\partial x}}{\rm{d}}x + \frac{{\partial I}}{{\partial y}}dy + \frac{{\partial I}}{{\partial t}}dt = 0$ | (8) |

| ${I_x}u + {I_y}v = - {I_t}$ | (9) |

其中:

式 (9) 可表示为矩阵相乘,如式 (10):

| $\left[ {\begin{array}{*{20}{c}} {{I_x}}&{{I_y}} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} u\\ v \end{array}} \right] = - {I_t}$ | (10) |

一个方程求两个未知数显然不可解,假设目标局部区域具有运动一致性,即可联立方程式 (11):

| $\mathit{\boldsymbol{Ad}} = \mathit{\boldsymbol{b}}$ | (11) |

由最小二乘法得式 (12):

| $\mathit{\boldsymbol{d}} = {({\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{A}})^{ - 1}}{\mathit{\boldsymbol{A}}^{\rm{T}}}\mathit{\boldsymbol{b}}$ | (12) |

其中:

在实际计算中,角点可以得到相对稳定的光流[25],所以本文使用角点作为特征点计算光流,找出上一帧目标上的角点,假设共k个角点,记为 (x1, y1),(x2, y2),…,(xk, yk)。由于光流法是基于相邻帧物体微小运动的,当物体运动较大时,传统光流法效果并不好,为此本文使用金字塔光流法[26]计算角点的光流,记为 (u1, v1),(u2, v2),…,(uk, vk)。

1.4 跟踪流程本文算法是在KCF的基础上引入再检测机制来实现长时目标跟踪的,因此跟踪时首先利用KCF跟踪目标,计算跟踪每一帧目标的PSR,当值小于经验阈值T时,再检测机制生效。

再检测机制的作用是通过计算前一帧目标区域的光流场,预测出目标在当前帧中的位置,由于视频中非目标物也会运动产生光流,给判断目标位置带来干扰,为减轻干扰,将特征点的光流乘以一个权值,距离上一帧目标中心越近的特征点光流越重要,其权值越大。本文使用高斯分布表示权重ω(x, y),则第k个角点的权值为式 (13):

| $\mathit{\boldsymbol{\omega }}_{(x,y)}^k = {\rm{exp}}\left( { - \frac{{{{\left( {{x_k} - {x_0}} \right)}^2} + {{\left( {{y_k} - {y_0}} \right)}^2}}}{{2{\sigma ^2}}}} \right)$ | (13) |

其中:x0,y0为上一帧目标中心横纵坐标;

将1.3节中所有角点的光流加权平均即得目标光流:

| $\begin{array}{*{20}{l}} {U = \sum\limits_i^k {\omega _{(x,y)}^i{u_i}} /\sum\limits_i^k {\omega _{(x,y)}^i} }\\ {V = \sum\limits_i^k {\omega _{(x,y)}^i{v_i}} /\sum\limits_i^k {\omega _{(x,y)}^i} } \end{array}$ |

利用光流法,通过以上计算预测目标在当前帧中的位置为 (x, y),其中x=x0+U,y=y0+V,此位置为目标的粗略位置,为获得更精确位置需在 (x, y) 处再次运用核相关滤波器。

2 实验结果分析为了评估本文所提算法在跟踪快速运动目标时的性能,实验使用文献[27]中标记为快速运动的视频作为视频测试,并使用距离精确度 (Distance Precision, DP) 和成功率 (Success Rate, SR) 作为评估标准。精确度是指跟踪目标的中心坐标与人工标定的准确值间的欧氏距离小于某个阈值的帧数占全部视频帧数的百分比,阈值越低时精确度越高,跟踪效果越好。成功率是指包围跟踪目标的边框区域与人工标定的准确值间的重叠率大于某个阈值的帧数占全部视频帧数的百分比,阈值越高时成功率越高,跟踪效果越好。

实验除了验证所提算法再检测模块的有效性,还与当前主流跟踪算法比较,以此证明它的整体优越性。

实验平台 Matlab 2015b,intel-i7-6700,3.4 GHz,8 GB内存。

实验参数 再检测模块中,经验阈值T为6,高斯分布

为说明CN颜色特征和再检测机制对提高KCF跟踪效果的作用,本文进行了对比实验。现定义在KCF上只引入CN颜色特征的算法记为cKCF,只引入再检测机制的算法记为rKCF,两者都引入则为本文长时核相关滤波器 (LKCF)。

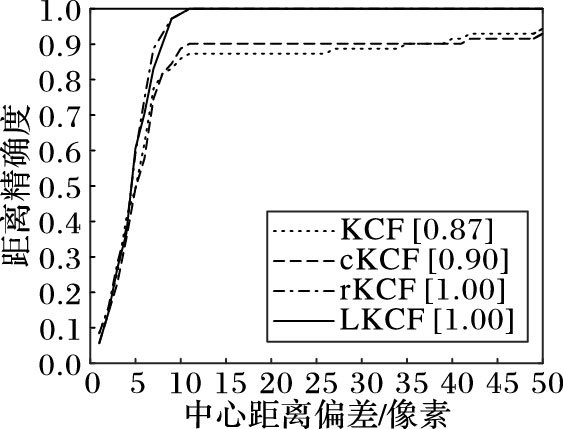

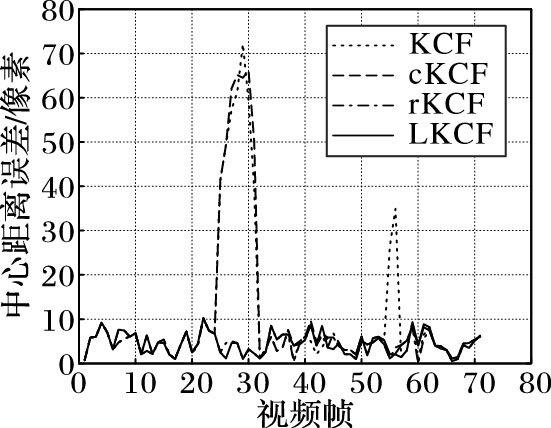

实验使用OTB-50数据集[27]中的Deer视频比较KCF、cKCF、rKCF及LKCF性能差异。首先绘制精确度图,如图 1所示,并使用20个像素点时的精确度作为评价标准。其次,为直观地呈现个算法的差异,还绘制了中心距离误差图,如图 2所示。

|

图 1 中心距离精确度 Figure 1 Center distance precision |

|

图 2 中心距离误差 Figure 2 Center distance error |

从图 1可以看出rKCF和LKCF的精度达到了100%,即在所有帧中,跟踪目标的中心坐标与真实标定值之间的欧氏距离都小于20个像素值。KCF的距离精度达到了87%,cKCF为90%,只比KCF多3个百分点,相比而言,在KCF基础上引入再检测机制的rKCF则增加了13个百分点,可看出再检测机制可以显著提高跟踪效果。

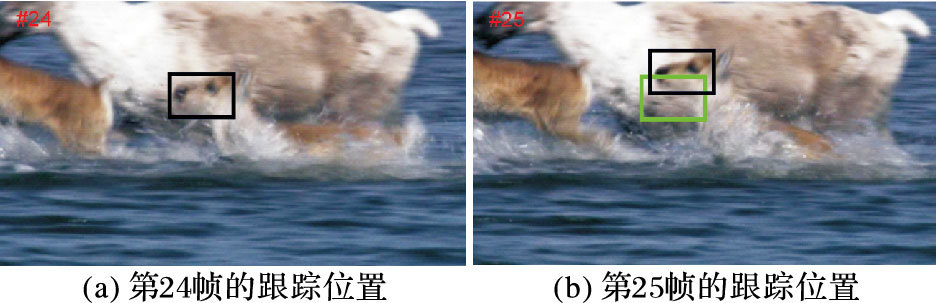

从图 2可以观察到,KCF和cKCF在25帧附近中心距离产生了巨大偏差,而rKCF和LKCF此时表现出色,具体从图 3可看出在24帧所有跟踪器都能较准确跟踪,在25帧KCF和cKCF跟踪失败,引入再检测机制的rKCF和LKCF此时却跟踪成功,证明再检测机制对提高跟踪鲁棒性的作用 (注:图 3中目标框线型对应图 1中各跟踪器线型,图 3(a)中4个跟踪框重合)。在图 2中55帧附近KCF产生较大偏差,而cKCF此刻却没有产生较大偏差,说明CN颜色特征也可以提高跟踪的鲁棒性。

|

图 3 4个跟踪器在第24、25帧的跟踪位置 Figure 3 Tracking position of 4 trackers in the 24th~25th frames |

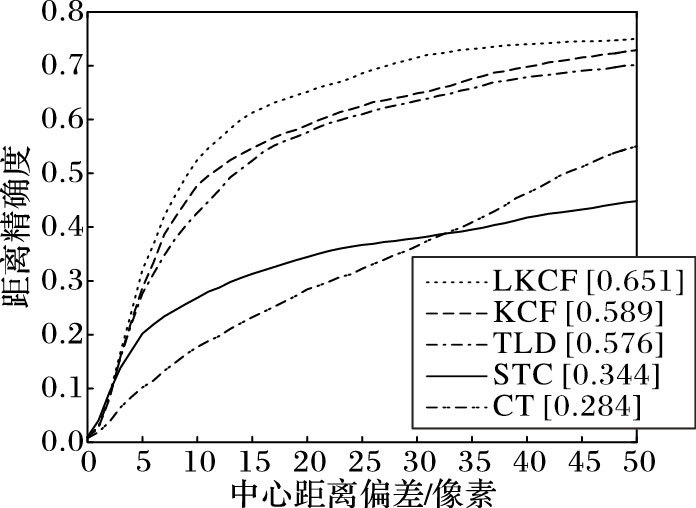

实验选取OTB-50数据集[27]中标记为快速运动的15组视频序列作为测试视频,将本文所提长时核相关滤波跟踪算法 (LKCF) 与核相关滤波跟踪算法 (KCF)[4]、跟踪-学习-检测 (Teach-Learn-Detection,TLD)[24]、压缩跟踪 (Compressive Tracking,CT)[28]、时空上下文 (Spatio-Temporal Context,STC)[29]进行对比实验。实验选用阈值为20个像素点时的距离精确度 (DP) 和阈值为0.5的成功率 (SR) 作为评测标准,结果如表 1所示。

| 表 1 5种跟踪算法在视频序列上的性能比较 Table 1 Performance comparison of 5 tracking algorithms over the video sequences |

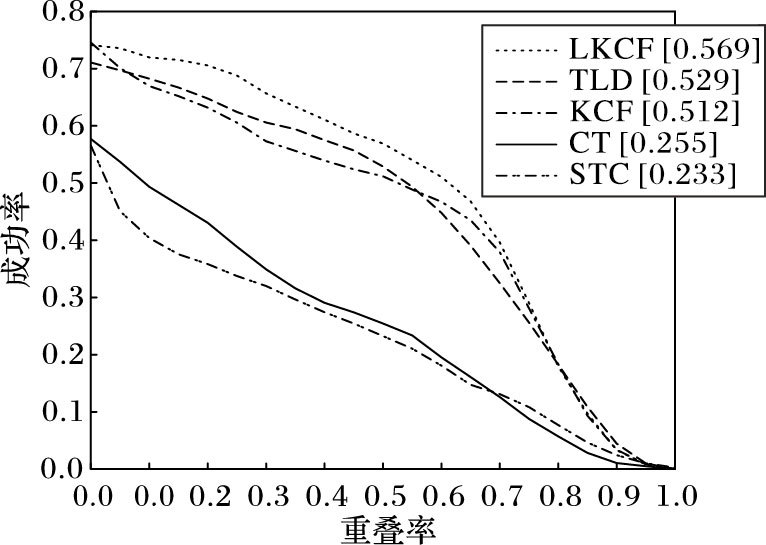

从表 1中可看出,本文算法的距离精确度均值为0.651,成功率均值为0.569,是5种跟踪算法中综合表现最好的,且分别比KCF高6.2个百分点和5.1个百分点。为更形象地表现测试结果,图 4、图 5分别给出了5种跟踪算法在15组测试视频中,在不同阈值下的距离精确度和成功率。

|

图 4 5种跟踪算法在不同阈值下的距离精度 Figure 4 DP of 5 tracking algorithms at different thresholds |

|

图 5 5种跟踪算法在不同阈值下的成功率 Figure 5 SR of 5 tracking algorithms at different thresholds |

表 2为5种跟踪算法在测试视频序列上的运行速度对比结果,从结果可看出,本文提出的LKCF算法运行速度排名第4,与最快的789.5帧每秒尚有差距,但仍能满足实时跟踪要求。

| 表 2 5种跟踪算法运行速度对比 Table 2 Running speed comparison of 5 tracking algorithms |

为解决基于相关滤波理论的跟踪器在跟踪快速运动目标时目标丢失问题,本文在核相关滤波 (KCF) 跟踪算法的基础上引入CN颜色特征及基于光流法的再检测机制,提出了一种长时核相关滤波 (LKCF) 跟踪算法,该算法可在目标跟踪丢失时重新获得目标并继续跟踪。实验表明,本文算法在距离精确度均值和准确度均值分别比KCF跟踪算法高6.2、5.7个百分点,与近年来4个优秀算法比较,在跟踪快速运动目标时鲁棒性最好,能满足实时跟踪要求,有实际应用价值。不足的是本文算法运行速度较慢,造成速度慢的原因是基于光流法的运动物体检测算法计算复杂度较高,因此,后续将对优化再检测机制作进一步研究。

| [1] | SMEULDERS A W M, CHU D M, CUCCHIARA R, et al. Visual tracking:an experimental survey[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 36(7): 1442-1468. |

| [2] | BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]//Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2010:2544-2550. |

| [3] | HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//Proceedings of the 2012 European Conference on Computer Vision. Berlin:Springer, 2012:702-715. |

| [4] | HENRIQUES J F, RUI C, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(3): 583-596. |

| [5] | FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2010, 32(9): 1627-1645. |

| [6] | Van De WEIJER J, SCHMID C, VERBEEK J, et al. Learning color names for real-world applications[J]. IEEE Transactions on Image Processing, 2009, 18(7): 1512-1523. doi: 10.1109/TIP.2009.2019809 |

| [7] | DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2014:1090-1097. |

| [8] | DANELLJAN M, HÄGER G, KHAN F, et al. Accurate scale estimation for robust visual tracking[EB/OL].[2016-05-20]. http://www.bmva.org/bmvc/2014/files/abstract038.pdf. |

| [9] | LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[C]//Proceedings of the 2014 European Conference on Computer Vision. Berlin:Springer, 2014:254-265. |

| [10] | MA C, YANG X, ZHANG C, et al. Long-term correlation tracking[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:5388-5396. |

| [11] | HONG Z, CHEN Z, WANG C, et al. Multi-Store Tracker (MUSTer):a cognitive psychology inspired approach to object tracking[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:749-758. |

| [12] | LIU T, WANG G, YANG Q. Real-time part-based visual tracking via adaptive correlation filters[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:4902-4912. |

| [13] | LI Y, ZHU J, HOI S C H. Reliable patch trackers:robust visual tracking by exploiting reliable patches[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:353-361. |

| [14] | GALOOGAHI H K, SIM T, LUCEY S. Correlation filters with limited boundaries[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2014:4630-4638. |

| [15] | DANELLJAN M, HAGER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2015:4310-4318. |

| [16] | LANG J, LAGANI R. Scalable kernel correlation filter with sparse feature integration[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision Workshop. Piscataway, NJ:IEEE, 2015:587-594. |

| [17] | CHEN Z, HONG Z, TAO D. An experimental survey on correlation filter-based tracking[J]. Computer Science, 2015, 53(6025): 68-83. |

| [18] | LUCAS B D, KANADE T. An iterative image registration technique with an application to stereo vision[C]//Proceedings of the 7th International Joint Conference on Artificial Intelligence. San Francisco, CA:Morgan Kaufmann, 1981:285-289. |

| [19] | 李航. 统计学习方法[M]. 北京: 清华大学出版社, 2012 : 116 . ( LI H. Statistical Learning Method[M]. Beijing: Tsinghua University Press, 2012 : 116 . ) |

| [20] | RIFKIN R, YEO G, POGGIO T. Regularized least-squares classification[J]. Acta Electronica Sinica, 2003, 190(1): 131-154. |

| [21] | KHAN F S, VAN DE WEIJER J, VANRELL M. Modulating shape features by color attention for object recognition[J]. International Journal of Computer Vision, 2012, 98(1): 49-64. doi: 10.1007/s11263-011-0495-2 |

| [22] | KHAN F S, ANWER R M, VAN DE WEIJER J, et al. Color attributes for object detection[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:3306-3313. |

| [23] | KHAN F S, ANWER R M, VAN DE WEIJER J, et al. Coloring action recognition in still images[J]. International Journal of Computer Vision, 2013, 105(3): 205-221. doi: 10.1007/s11263-013-0633-0 |

| [24] | KALAL Z, MIKOLAJCZYK K, MATAS J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2012, 34(7): 1409-1422. |

| [25] | SHI J, TOMASI C. Good features to track[C]//Proceedings of the 1994 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 1994:593-600. |

| [26] | BOUGUET J Y. Pyramidal Implementation of the Lucas Kanade feature tracker description of the algorithm[J]. OpenCV Documents, 2000, 22(2): 363-381. |

| [27] | WU Y, LIM J, YANG M H. Online object tracking:a benchmark[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:2411-2418. |

| [28] | ZHANG K, ZHANG L, YANG M H. Real-time compressive tracking[C]//Proceedings of the 2012 European Conference on Computer Vision. Berlin:Springer, 2012:864-877. |

| [29] | ZHANG K, ZHANG L, LIU Q, et al. Fast visual tracking via dense spatio-temporal context learning[C]//Proceedings of the 2014 European Conference on Computer Vision. Berlin:Springer, 2014:127-141. ZHU Mingmin, born in 1990, M. S. candidate. His research interests include gesture recognition, object detection, object tracking. HU Maohai, born in 1967, Ph. D., associate professor. His research interests include image processing, optical pattern recognition, biomicroscopic imaging. |