2. 电子科技大学 计算机科学与工程学院, 成都 610054

2. School of Computer Science and Engineering, University of Electronic Science and Technology of China, Chengdu Sichuan 610054, China

在移动互联网、大数据的时代背景下, 智能终端的普及与社交网络的发展, 使得互联网多媒体数据 (图片、视频) 呈现爆发式增长, 计算机视觉已成为一个热点研究领域, 以往完全依赖人工对多媒体数据进行标注和描述已成为一项不可能的任务。本文重点关注视频语义的自然语言自动描述研究, 该方向的研究具有较高的应用价值和现实意义, 可广泛应用于智能安防、视频检索、人机交互、虚拟现实以及帮助盲人理解电影视频等。用自然语言对视频进行描述这一项任务对于正常的人来说非常简单, 但是对于计算机来说却是一项很难的任务, 它要求提出的方法能够跨越低层的像素特征到高层语义的语义鸿沟, 语义鸿沟的存在导致了计算机自动描述视频准确率低的问题。针对这一现状问题, 在阅读大量文献与实验验证的基础下, 本文提出一种端到端的、基于长短期记忆 (Long-Short Term Memory, LSTM) 的自然语言描述的方法。方法首先提取视频帧序列的各类特征, 包括:通过预训练的深度卷积神经网络 (Convolutional Neural Network, CNN) 模型 (如:VGG16(Visual Geometry Group)[1]、AlexNet[2]、GoogleNet[3]、ResNet[4]等) 提取视频中帧序列图片的特征, 并提取运动特征如光流 (Optical Flow, OP), 以及视频特征如密集跟踪轨迹 (Dense Trajectory, DT) 等; 采用前期融合的方法融合提取到的多种特征, 使用这些特征及融合后的特征的组合与视频的自然语言描述文本训练基于LSTM的视频自然语言描述模型; 在生成视频自然语言描述时使用不同特征训练的模型进行后期融合, 获得最终的自然语言描述, 实现低层特征与自然语言的直接映射。此过程即输入视频, 直接生成包含高层语义对象、符合自然语言语义规则的自然语言描述。本文使用深度学习框架Caffe[5]来完成文中描述的所有视频帧序列的CNN特征提取和LSTM视频自然语言描述模型的训练, 为了提高特征的提取与模型的训练速度, 采用了图形处理器 (Graphics Processing Unit, GPU) 进行并行计算, 以提升运算速度。在微软视频描述 (Microsoft Video Description, MSVD)[6]数据集上的实验结果表明本文方法在主流自然语言评测标准中取得了较好的评测结果 (详见第3章), 表明了本文方法在提升视频自然语言描述准确性上的有效性。

1 相关研究近年来, 对于图片和视频进行自然语言描述受到了广泛的关注, 尤其是2015年ImageNet大规模视觉识别的挑战 (ImageNet Large Scale Visual Recognition Competition, ILSVRC) 和COCO (Common Object in COntext) 说明大赛, 2015年大规模电影描述挑战赛 (Large Scale Movie Description Challenge, LSMDC), 吸引了许多研究人员对该领域的关注, 并在图像和视频文本描述方面发表了一系列的研究成果。

1.1 图片文本描述由图片直接生成文本描述的方法主要分为两类。一类为管道方法, 首先通过建立模型学习到图片中视觉对象对应的单词; 再通过基于一个递归神经网络 (Recurrent Neural Network, RNN) 或LSTM的自然语言模型, 将视觉对象对应的单词组合成一个句子来描述图片; 最后通过相关性模型对句子进行打分排名, 这种方法的两个部分可以单独进行调试, 比较灵活。另一类为端对端的方法, 即通过一个模型直接将图片转换到文本的描述。Google基于CNN和RNN开发了一个图像标题生成器[7]。这个工作主要受到了基于RNN机器翻译[8-9]的启发。在机器翻译中, 分为编码阶段与解码阶段, 编码阶段RNN读取源语言的句子, 将其变换到一个固定长度的向量表示;然后解码阶段RNN将向量表示作为隐层初始值, 产生目标语言的句子。Li-Feifei团队在文献[10]也提到一种图片生成文本描述的方法, 与Google的做法类似, 用图片的CNN特征作为RNN的输入, 使用这种方法的图片自然语言描述方法都取得了比较好的结果。

1.2 视频文本描述视频生成自然语言的描述的方法, 也大致分为两类:

一类为包含两个阶段的管道方法[11-12]。第一阶段先从视频中定位出语义内容 (如:主语、动词、对象、场景), 第二阶段基于固定的模板 (如:SVO (Subject、Verb、Object)、SOV (Subject、Object、Verb)、VSO (Verb、Subject、Object) 等, 不同语言类型, 语法结构不同, 因此语义内容的顺序也不同) 生成文本描述, 这种基于模板的文本描述生成方法具有一定的局限性, 它仅能对视频进行简单的陈述, 而无法描述视频中的其他丰富信息。

另一类为端到端的方法[13-16]。该方法将视频内容与视频自然语言描述的原始语料结合在一起作为模型的输入, 而不是像第一种方式那样分开, 该方法通过两个步骤来生成视频的自然语言描述:第一步以提取的视频的CNN或视频特征和人为提供的自然语言描述文本作为模型的输入数据来训练模型; 第二步该模型用一个固定长度的向量来表示视频, 并将该向量和前一个单词作为输入, 解码得到下一个单词, 最终得到视频向量的一组单词表示, 将这些单词按序输出为一个句子即得到视频的自然语言描述。

本文提出一种基于多特征融合的深度视频自然语言描述方法, 基于主流的前期融合与后期融合方法, 进行多种特征的融合方法研究, 提取训练视频数据集的各类特征, 进行前期特征融合得到融合特征向量, 并将训练样本的自然语言描述转为向量方式与融合的特征作为模型的输入, 基于不同的特征训练多个视频自然语言描述模型, 在进行自然语言描述时再通过权值向量对不同特征训练的模型进行后期融合, 以获取最好的结果。最后通过实验评价本文方法的效果, 并分析特征融合对于视频的自然语言描述结果评价的影响。

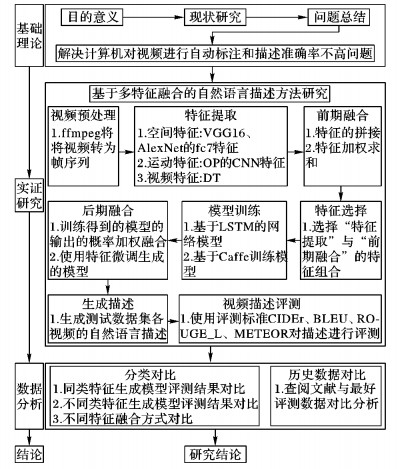

2 研究思路本文研究的技术路线如图 1所示, 主要分为四个研究阶段:基础理论、实证研究、数据分析、结论。各个阶段的研究内容根据箭头的方向先后进行, 各阶段具体研究内容与技术途径详见图 1中各步骤详解。

|

图 1 本文研究技术路线 Figure 1 Technical route of this paper |

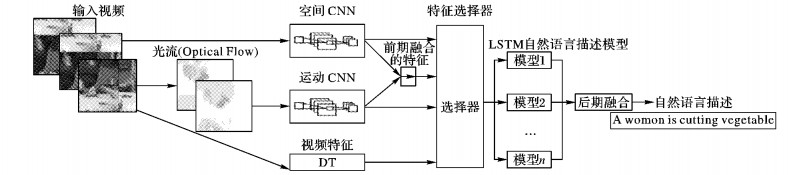

本文提出的生成自然语言描述的模型结构如图 2, 输入视频帧序列 (x1, x2, …, xn), 最终得到的输出自然语言的单词序列 (y1, y2, …, ym), 正常情况下输入帧的数量与输出的单词序列的单词数都是可变的。在本文的模型中, 给出一个输入 (x1, x2, …, xn), 估计自然语言输出序列 (y1, y2, …, ym) 的条件概率, 可用式 (1) 表示:

| $p({{y}_{1}}, {{y}_{2}}, ..., {{y}_{m}}|{{x}_{1}}, {{x}_{2}}, ..., {{x}_{n}})$ | (1) |

|

图 2 LSTM自然语言描述模型结构示意图 Figure 2 Schematic diagram of natural language description model based on LSTM |

本文方法首先通过输入的视频帧序列提取视频的3类特征, 包括空间特征 (基于VGG16、AlexNet的fc7层特征)、运动特征 (提取视频的光流并生成可视化光流图并提取光流图CNN特征)、视频特征 (DT特征); 然后对于可进行融合的特征进行前期融合; 再通过一个特征选择器, 该特征选择器的作用为选择提取到的及前期融合后得到的特征的组合作为LSTM描述模型的输入; 训练一个基于LSTM的视频自然语言描述模型; 使用训练得到的LSTM描述模型进行生成视频自然语言描述实验; 最后如果实验需要进行后期融合, 在得到最终的视频自然语言描述前, 先使用2.3节中描述的方法确定后期融合时使用的各模型的权值, 再依据权值得到概率最大的输出结果。

2.2 特征提取本文使用的特征均通过预训练的模型或公开的方法的实现来提取。使用预训练好的被公认比较优秀的模型提取的特征可以很好地表达视频或者视频帧。本文主要提取了如下几类特征:

空间特征:本文使用预训练的模型提取视频帧序列图像的空间特征, 因为近年来CNN在图像分类、目标检测、图像语义分割等领域取得了一系列突破性的研究成果[17], 通过CNN提取的特征能够很好地表达图像。因此本文选择在ImageNet分类任务数据集中取得很好数据的CNN模型VGG16[1]和AlexNet[2], 提取预处理好的视频帧序列中所有图片的fc7层的特征, 并计算帧序列特征的均值, 最终得到一个4 096维特征向量来表示整个视频。

运动特征:视频的一个特点是其由许多连续的视频帧组成, 帧与帧之间存在运动的变化, 因此在进行视频分析时极有必要分析视频的运动特征。本文使用文献[18]中描述的方法提取相邻帧的光流, 并将提取到的光流数据归一化到0~255, 存储为图片文件, 视频帧数量为N时, 光流图像的数量为N-1。使用预训练的模型[19]提取光流图像的fc7层特征作为运动特征, 并计算光流序列特征的均值, 最终得到一个4 096维特征向量表示整个视频的运动特征。

视频特征:与单独的图片描述问题不同的是,视频帧之间具有时间上的关联性, 因此在对视频进行分析和研究时很有必要进行视频的时间上的特征提取。本文使用文献[20]方法提取DT特征, 在提取DT特征时采用不重叠的长方形块覆盖图像上的区域, 最后拼接获取到的各区域的DT特征作为整个视频的特征。

2.3 特征融合分别设使用不同模型提取的视频帧序列特征为Fi=(F1Mi, F2Mi, …, FnMi), 其中Mi表示第i种模型, 它们将被用来验证本文提出的特征融合方式。

前期融合:需要在进行模型训练前融合特征, 以融合后的特征作为模型的输入。本文验证了两种前期融合方式:

1) 特征拼接。在特征提取阶段, 为了拼接多种模型提取的特征, 各个模型均使用一个向量Fi表达整个视频, 其中i表示第i种特征。选取这些特征的组合直接拼接得Ffusion, 自然语言描述模型的视频特征输入, 可用式 (2) 表示:

| ${{\boldsymbol{F}}_{\text{fusion}}}=({{\boldsymbol{F}}_{1}}, {{\boldsymbol{F}}_{2}}, \cdots, {{\boldsymbol{F}}_{m}})$ | (2) |

其中:m表示融合的特征数量。

2) 加权求和。将不同模型提取到的特征进行长度对齐, 设置权值向量W =(w1, w2, …, wm), 对特征进行加权求和, 融合后的特征作为视频自然语言描述生成模型的视频特征输入, 可用式 (3) 表示:

| ${{\boldsymbol{F}}_{\text{fusion}}}=W{{\boldsymbol{F}}^{\text{T}}}=({{w}_{1}}{{\boldsymbol{F}}_{1}}+{{w}_{2}}{{\boldsymbol{F}}_{2}}+\cdots +{{w}_{m}}{{\boldsymbol{F}}_{\text{m}}})$ | (3) |

其中:Ffusion为最终得到融合后的特征, m表示特征的数量, 并且满足

后期融合:在自然语言描述模型生成后进行融合, 本文验证了两种后期融合的方式。

1) 微调模式。用一种特征作为输入训练视频自然语言描述模型M1, 完成训练后再使用另外一种特征作为输入, 以先前训练的模型作为权重初始值, 使用相同的视频文本生成模型网络进行微调, 最后得到可用于生成视频自然语言描述模型M2。

2) 加权求和。在估计输出时, 使用一种模型M1与前一个词作为输入, 估计下一个词的可能输出, 获得当前输入条件下概率最高的10个备选词, 这些词的概率分别为p1= p1k(y′) (k=1, 2, …, 10), 使用其他模型Mi, 分别计算这些备选词的概率, 通过权值向量重新计算输出的概率, 如式 (4) 所示:

| $p(y')=\boldsymbol{W{{P}}^{\text{T}}}=({{w}_{1}}{{p}_{1}}+{{w}_{2}}{{p}_{2}}+\cdots +{{w}_{n}}{{p}_{n}})$ | (4) |

并且满足

本文的自然语言描述模型受文献[7]的启发, 采用两层LSTM网络模型:一层用于编码, 将输入的视频特征转为向量表示;一层用于解码, 将视频特征向量转为单词序列。选择LSTM模型的原因在于其满足本研究内容的三个基本条件:模型需要能够处理不同长度的视频, 并能够生成不同长度的自然语言描述; 同时模型要能够学习到视频前后帧在时间上的依赖关系; 在训练过程中使用梯度下降法, 误差信号和梯度需要能够长时间范围内向底层回传。

1) 在训练阶段, 此网络底层输入数据包含直接提取的特征F或融合后的视频特征向量Ffusion, 以及自然语言描述视频的句子转为与特征向量相同长度并通过嵌入层转化为向量。将视频特征向量与视频自然语言描述的向量进行链接, 形成视频特征与自然语言描述的嵌入特征。

2) 在1) 中的视频特征与自然语言描述的嵌入特征通过两层LSTM网络训练整个网络。

3) 在验证阶段, 第一层将视频进行编码得到特征向量Ffusion, 第二层用于解码, 接收隐含层表示 (ht), 并将其解码为单词序列, 在解码阶段,模型采用最大化对数似然函数来估计ht及前一个单词能够预测的下一个单词。设θ为参数, 输出单词序列为Y=(y1, y2, …, ym), 模型可由式 (5) 表示:

| ${{\theta }^{*}}=\underset{\theta }{\mathop{\text{argmax}}}\, \underset{t=1}{\overset{m}{\mathop \sum }}\, \log p({{y}_{t}}|{{h}_{n+t-1, {{y}_{t-1}}}};\theta )$ | (5) |

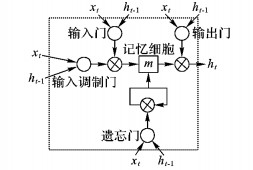

图 3描述的是本文LSTM模型中的一个LSTM单元, 一个LSTM单元包含一个记忆细胞m, 该记忆细胞的输出值受当前时间t、输入x、前一个输出y和前一个记忆细胞mt-1的影响。一个LSTM单元有4个门:输入门 (i)、输入调制门 (g) 和忘记门 (f) 控制m更新, 输出门 (o) 控制输出。忘记门允许LSTM单元忘掉前一个记忆细胞mt-1, 输出门决定多少记忆传入隐含层 (mt), 这一过程的公式如式 (6)~(11) 所示:

| ${{i}_{t}}=\sigma \left( {{W}_{xi}}{{x}_{t}}+{{W}_{hi}}{{h}_{t-1}} \right)$ | (6) |

| ${{f}_{t}}=\sigma \left( {{W}_{xf}}{{x}_{t}}+{{W}_{hf}}{{h}_{t-1}} \right)$ | (7) |

| ${{o}_{t}}=\sigma \left( {{W}_{xo}}{{x}_{t}}+{{W}_{ho}}{{h}_{t-1}} \right)$ | (8) |

| ${{g}_{t}}=\phi \left( {{W}_{xm}}{{x}_{t}}+{{W}_{hm}}{{h}_{t-1}} \right)$ | (9) |

| ${{m}_{t}}={{f}_{t}}\odot {{m}_{t-1}}+{{i}_{t}}\odot {{g}_{t}}~$ | (10) |

| ${{h}_{t}}={{o}_{t}}\odot \phi \left( {{m}_{t}} \right)$ | (11) |

|

图 3 LSTM细胞单元 Figure 3 LSTM cell unit |

4) 测试阶段, 使用训练好的模型进行预测时, 采用后期融合中的加权求和方法时, 需要确定权值向量W的具体值, 本文通过在验证子集上进行微调得到。微调的过程为依次固定一个权值wi, 然后将1-wi分配到n-1个权值, 权值的最小值设定为0.01, 每次变化的幅度为0.01, 满足式 (12) 所示的条件下依次计算每一组权值下, 验证子集生成的自然语言描述的评估分数, 并选择取得最大值时的W。

| $\sum\limits_{i=1}^{n}{{{w}_{i}}}=1$ | (12) |

其中:n为模型数量, 当n取1时即测试一个单独的模型。

3 实验与分析 3.1 数据集MSVD[6]数据集是一个专门用于视频描述实验的标准数据集, 该数据集总共包含2 089个视频, 但由于部分链接失效, 最终保存下来的可用视频共有1 970个, 通过土耳其机器人获取多种语言的描述, 本文使用其英文描述, 该数据集总共包含80 827条可用英文描述, 总共包含567 874个字符, 不相同的单词和符号数量12 594个, 每个视频平均长度10.2 s, 且每个视频平均拥有41条英文文本描述。按照文献[13]方案进行数据集划分, 将数据集中划分为3个子集, 其中训练集包含1 200个视频, 验证集包含100个视频, 测试集包含670个视频。

3.2 评价指标本文采用LSMDC指定的四种标准评价指标CIDEr (Consensus-based Image Description Evaluation)[21]、BLEU (BiLingual Evaluation Understudy)[22]、ROUGE_L (Recall-Oriented Understudy for Gisting Evaluation, Longest common subsequence)[23]和METEOR[24]。这四种指标计算出的值为百分比, 值越高表示描述越接近给定的原始描述。在本文中用来衡量使用特征融合方法生成的自然语言描述与人工描述的相似程度, 以此来评价本文提出的视频自然语言描述方法的优劣。

3.3 实验步骤本文方法的实验基本流程如下:

1) 视频预处理:通过ffmpeg提取视频中每一帧的图片, 并将提取到的视频帧图片尺寸缩放为固定大小256×256, 按先后顺序将视频帧从1开始编号命名。

2) 特征提取:基于视频和帧序列提取包含2.2节描述的空间特征、运动特征、视频特征。

3) 前期特征融合:通过2.3节描述的特征融合方法, 选择不同的空间特征、运动特征、视频特征进行融合。

4) 选择第3) 步描述的前期特征融合后得到新特征, 并结合训练数据集的自然语言描述作为模型的输入数据, 训练多个基于LSTM的自然语言描述模型。该过程基于深度学习框架Caffe实现, 其中训练此自然语言模型的部分参数如表 1所示。

| 表 1 LSTM自然语言描述模型部分参数 Table 1 Part parameters of natural language description model based on LSTM |

5) 在生成视频的自然语言描述时, 选择多个已训练的模型进行后期融合, 按照2.3节特征融合中所描述的后期融合方法中的加权法得到权值向量W。

6) 使用选择的已训练的模型及上一步得到的权值向量W, 生成测试集的自然语言描述。

7) 使用CocoCaption[25]工具, 结合本文方法生成的自然语言描述与测试集中给出的人工对视频的描述, 评估相似度分值。

3.4 实验结果与分析表 2中列举了本文描述的自然语言描述方法在测试集上生成自然语言描述的评估分数。其中:Spa表示空间特征, Mot表示运动特征, DT代表视频特征, [EC]表示前期融合的特征拼接, [EW]表示前期融合的特征加权和, [LT]表示后期融合微调方式, [LW]表示后期融合加权方式。第1~4行的数据为不进行特征融合使用单一特征进行实验的评估分数; 第5~8行的数据为仅进行前期特征融合得到的评估分数; 第9~12行的数据为前期融合与后期融合相结合得到的评估分数。通过表 2中的测评结果可看出:在METEOR评测指标方面,本文提出的3种特征融合组合的结果评分超过了文献[12]的最佳值0.298;但是CIDEr和BLEU指标方面,本文的特征融合组合的结果评分均低于文献[16]中的最佳值0.516 7和0.419 2。通过数据的对比分析可以得出如下的结论:1) 融合不同类型的特征方法能够获得评测分值的提升,如表 2中的第6、8、11、12行都比融合前的单特征模型获得了更高的评测分值。2) 相同类型的特征融合的结果不会高于单特征的分值, 如表 2中第5和7行结果比其中某一个单独的特征生成的模型评测分值都低。3) 使用不同特征对现有模型进行微调的方法效果较差, 如表 2中的第9、10行, 分值比融合前单特征模型的评测分值都要低很多。

| 表 2 自然语言描述方法评估结果 Table 2 Evaluation results of natural language description method |

图 4中的三个子图为视频1中的部分帧, 数据集中给出的该视频的部分参考文本描述为:1) a person is riding a motorcycle on the beach;2) a man rides a motorcycle through the ocean。本文方法生成的描述为A person is riding a motorcycle on the snow。图 5中的三个子图为视频2中的部分帧, 数据集中给出的该视频的部分参考文本描述为:1) a man is playing a guitar; 2) a man is playing the guitar while sitting on a park bench。本文方法生成的描述为A man is playing a guitar。图 6中三个子图为视频3中的部分帧, 数据集中给出的该视频的部分参考文本描述为:1) a person is cutting a fish with knife; 2) a man is slicing open a fish and cuts off its head。本文方法生成的描述为A woman is cutting a cooked fish on a cutting board。通过这些示例可以看出本文方法能够比较准确地生成部分视频的自然语言描述。

|

图 4 视频1中部分帧 Figure 4 Part frames of video 1 |

|

图 5 视频2中部分帧 Figure 5 Part frames of video 2 |

|

图 6 视频3中部分帧 Figure 6 Part frames of video 3 |

本文提出一种多特征的视频自然语言描述的框架方法, 此方法在两个阶段进行特征的融合, 以提升生成自然语言描述的准确性。本文使用的特征包括空间特征 (如VGG16、AlexNet提取的视频帧序列特征)、运动特征 (光流图像的CNN特征)、视频特征 (DT特征) 等。在MSVD数据集上进行了多种特征的融合组合实验, 通过实验验证了本文方法的可行性与有效性, 并得出结论:使用多特征融合能够提升视频自然语言描述的准确性, 相同类型的特征融合无法提升准确率, 不同类型的特征之间的融合对于准确性的提升幅度更大。基于本文提出的特征融合方法框架, 选择适当的不同类型特征, 还可以进一步提升视频自然语言描述的准确性。

| [1] | SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL].[2016-09-14]. https://arxiv.org/pdf/1409.1556v6.pdf. |

| [2] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[EB/OL].[2016-09-14]. https://papers.nips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf. |

| [3] | SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015:1-9. |

| [4] | HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[EB/OL].[2016-09-14]. https://www.researchgate.net/publication/286512696_Deep_Residual_Learning_for_Image_Recognition. |

| [5] | JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[EB/OL].[2016-03-10]. https://arxiv.org/pdf/1408.5093v1.pdf. |

| [6] | CHEN D L, DOLAN W B. Collecting highly parallel data for paraphrase evaluation[C]//HLT 2011: Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA, USA: Association for Computational Linguistics, 2011, 1:190-200. |

| [7] | VINYALS O, TOSHEV A, BENGIO S, et al. Show and tell: a neural image caption generator[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015:3156-3164. |

| [8] | SUTSKEVER I, VINYALS O, LE Q V. Sequence to sequence learning with neural networks[C]//NIPS 2014: Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014. |

| [9] | CHO K, MERRIENBOER B V, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation[EB/OL].[2016-09-10]. https://arxiv.org/pdf/1406.1078v3.pdf. |

| [10] | KARPATHY A, LI F F. Deep visual-semantic alignments for generating image descriptions[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015:3128-3137. |

| [11] | KRISHNAMOORTHY N, MALKARNENKAR G, MOONEY R J, et al. Generating natural-language video descriptions using text-mined knowledge[C]//AAAI 2013: Proceedings of the Twenty-Seventh AAAI Conference on Artificial Intelligence. Menlo Park, CA: AAAI Press, 2013:541-547. |

| [12] | THOMASON J, VENUGOPALAN S, GUADARRAMA S, et al. Integrating language and vision to generate natural language descriptions of videos in the wild[EB/OL].[2016-03-10]. http://www.cs.utexas.edu/users/ml/papers/thomason.coling14.pdf. |

| [13] | VENUGOPALAN S, ROHRBACH M, DONAHUE J, et al. Sequence to sequence-video to text[EB/OL].[2016-03-10]. https://arxiv.org/pdf/1505.00487v3.pdf. |

| [14] | VENUGOPALAN S, XU H, DONAHUE J, et al. Translating videos to natural language using deep recurrent neural networks[EB/OL].[2016-03-10]. https://arxiv.org/pdf/1412.4729v3.pdf. |

| [15] | SHETTY R, LAAKSONEN J. Video captioning with recurrent networks based on frame-and video-level features and visual content classification[EB/OL].[2016-03-10]. https://arxiv.org/pdf/1512.02949v1.pdf. |

| [16] | YAO L, TORABI A, CHO K, et al. Describing videos by exploiting temporal structure[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 4507-4515. |

| [17] | 李彦冬, 郝宗波, 雷航. 卷积神经网络研究综述[J]. 计算机应用, 2016, 36 (9) : 2508-2515. ( LI Y D, HAO Z B, LEI H. Survey of convolutional neural network[J]. Journal of Computer Applications, 2016, 36 (9) : 2508-2515. ) |

| [18] | FARNEBACK G. Two-frame motion estimation based on polynomial expansion[C]//SCIA 2003: Proceedings of the 13th Scandinavian Conference on Image Analysis, LNCS 2749. Berlin: Springer, 2003:363-370. |

| [19] | GKIOXARI G, MALIK J. Finding action tubes[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015:759-768. |

| [20] | WANG H, KLASER A, SCHMID C, et al. Action recognition by dense trajectories[C]//CVPR 2011: Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2011:3169-3176. |

| [21] | VEDANTAM R, ZITNICK C L, PARIKH D. CIDEr: consensus-based image description evaluation[EB/OL].[2016-03-10]. https://arxiv.org/pdf/1411.5726v2.pdf. |

| [22] | PAPINENI K. BLEU: a method for automatic evaluation of machine translation[J]. Wireless Networks, 2015, 4 (4) : 307-318. |

| [23] | FLICK C. ROUGE: a package for automatic evaluation of summaries[EB/OL].[2016-03-10]. http://anthology.aclweb.org/W/W04/W04-1013.pdf. |

| [24] | DENKOWSKI M, LAVIE A. Meteor universal: language specific translation evaluation for any target language[EB/OL].[2016-03-10]. https://www.cs.cmu.edu/~alavie/METEOR/pdf/meteor-1.5.pdf. |

| [25] | CHEN X, FANG H, LIN T, et al. Microsoft COCO captions: data collection and evaluation server[EB/OL].[2016-09-14]. https://arxiv.org/pdf/1504.00325v2.pdf. |