管理科学与工程领域围绕着如何提高劳动生产效率、增强经济效益等目标, 对生产实际问题进行建模与优化。其中, 大量的研究与实践活动均可归结为组合优化问题[1]。这类问题的主要特征是规模大、变量多, 不一定能给出解析式, 也不一定必须求得最优解[2]。因传统运筹方法能力有限, 故多采用启发式或元启发式算法加以解决。过去多年来, 先后涌现出了遗传[3]、模拟退火[4]、蚁群[5]、粒子群[6]、细菌觅食[7]、人工鱼群[8]、混合蛙跳[9]、人工蜂群[10]、萤火虫[11]、布谷鸟搜索[12]、蝙蝠[13]、虾群觅食[14]、狼群[15]、狮群[16]等多种基于群集智能优化的元启发式算法。这些算法具有广泛的适用性和较高的搜索效率。但目前来看这类算法的内在运行机理仍不明朗, 突出表现为应用效果明显波动, 对不同问题的自适应能力较差。为此, 人们提出了各种改进措施:或者依赖特定的启发式策略, 或者引入各种拓扑结构或模因 (memetic) 模型, 或者选择不同的参数、尝试各种混合策略, 因而导致各种变形算法的“泛滥”。

依据没有免费的午餐 (No Free Lunch, NFL) 定理[17]:不存在一个与具体应用无关的, 普遍适用的“通用算法”能够一劳永逸地解决所有优化问题。其深层的含意在于:在问题域的内在属性特征与算法相对性能测度之间有可能存在某种内在关联, 关联程度的高低决定着算法的应用效果。鉴于现实问题的复杂性和多样性:一方面, 人们针对所要解决的问题域的内在特征缺乏足够的认知, 算法的选择具有主观随意性和盲目性; 另一方面, 人们对各种算法的适用范围也缺乏足够的经验, 直接拿来应用难免“取短舍长”。“算法过剩”与“算法滥用”困扰着领域知识的进一步发展。为此, 亟须寻求一种“超启发式算法”, 依据问题的属性特征从“在线”的各种算法中自发地选择最适用的算法或算法的组合, 从而解决问题-算法之间低效率的盲目匹配这一明显的“鸿沟”。

算法自动选择 (匹配) 问题也是许多研究领域需要解决的NP难题[18]。在诸如人工智能、运筹学、管理科学与工程以及生物信息等学科领域, 都有一大批复杂难解的问题处于开放 (open) 状态, 也都有一批类型和能力不同的算法可以在不同程度上解决这些问题, 但又都令人难以满意。所谓算法的自动选择主要解决这样一个问题:针对所要解决的问题, 对于已知的可用算法, 到底哪一个执行的效果最好?显然, 依次执行所有可供选择的算法会过于消耗时间和资源; 而通过专家经验来选择, 则因缺乏可扩展性难以推广,故有必要寻求更高效、更方便的算法选择方法。

在机器学习领域, 人们基于元学习思想研究如何从大量的数据中寻找规律, 进行分类并作出新的行为预测或判断。可以设想, 若以已有的大量问题数据集为依托, 通过提取它们的关键特征, 并利用元学习方法建立关键特征与不同优化算法性能测度之间的映射模型, 则有可能预测出适用于此类问题的优化算法, 从而达到问题-算法最佳匹配的目的。

本文以在人工智能领域著名的NFL定理[17]和丑小鸭 (Ugly Duckling, UD) 定理[19]为理论依据, 首先提出并证明了组合优化问题算法选择定理, 明确肯定了:若给定条件满足, 在多个优化算法中必定有一个最适用于给定问题的算法,其意义在于为进一步开展问题-算法匹配的研究奠定理论基础。然后结合元启发式优化算法的特点, 以Rice抽象概念图[20]为基础, 以元学习算法为工具, 提出了一种优化算法自动选择框架。最后以多模式资源受限项目调度问题 (Multi-mode Resource Constrained Scheduling Problem, MRCPSP)[21]作为验证数据集, 选取了三种元启发式算法 (遗传、粒子群和模拟退火) 对所设计的算法自选择框架进行实证分析。结果表明, 算法的自动选择过程是成功的, 结果是可接受的。取三种算法两两比较, 能够以达到95%的准确率预测出最佳算法, 交叉验证的平均准确率也达到了85%;若三种算法同时作出比较, 平均预测准确率也达到了80%。

1 算法选择问题 1.1 研究现状算法选择问题在不同研究领域有不同的表述和侧重点[18],如超启发式算法[22]、算法自动选择[23]、算法自适应匹配、算法推荐[24]等。20世纪80年代末, 有学者意识到算法选择过程实际上可看成是一种学习过程[25]。于是, 算法选择问题在机器学习领域成为一个研究热点, 并逐渐发展形成了元学习思想[26-28]。一般的学习是指通过学习建立有关对象的知识, 而元学习是对学习过程的学习, 通过探查学习过程的机理, 不断地完善自我学习过程。其主要过程是通过对学习算法的属性或所学问题特征的分析, 建立灵活的自我学习机器[29-30]。元建模则通过建立反映输入与输出之间关系的数学模型来拟合或代理样本数据。常见的元建模方法包括多项式回归、高斯过程回归、支持向量回归、径向基函数、多元适应性回归样条和人工神经网络等。这些方法大多依赖于统计样本数据来构建模型, 故又称为无分布统计方法。

20世纪90年代初, 欧洲开展了大型分类算法比较项目[31], 其主要目标是比较机器学习、神经网络和统计学方法等在不同问题上的性能, 并通过研究数据集特征与算法性能表现之间的联系获取关于算法选择的知识。为了简化问题的处理, Pfahringer等[32]提出了地标策略。在大型分类算法比较项目研究基础上, 欧洲一些国家继续资助了一些基于该研究成果的算法选择研究项目。Rice[20]在其具有开创性的文献中给出了算法选择问题的概念图。Rendell等[33]提出了一种描述分类问题特征的方法, 并利用问题规模和分类的集中特征验证了对算法行为产生的影响。Aha[34]把这一思路拓展到基于规则的学习算法, 即如果给定的数据集具备C1, C2, …, Cn的特征, 则选用算法A而不是算法B。Smith-Miles[35]曾提出基于元学习思想不同学科领域实现算法选择的统一框架。Misir[36]证实了机器学习用于算法选择的效果。Messelis等[37]研究了基于实证难度模型的多模式资源受限项目调度问题的自动算法推荐。Vilalta等[38]曾利用元学习方法解决了一种随时间改变的动态数据的算法推荐问题。Miranda等[39]提出了基于元学习框架的支持向量机改进模型。Smith-Miles等[40]量化了组合优化问题一般特征和部分组合优化问题的特定特征。Leyva等[41]提出了一种基于知识的算例选择系统, 该系统使用元学习思想从多种可用算法中, 为每一个专用数据库选择最适用的算例选择算法。Bhatt等[42]对当前基于数据集特征的元学习方法所面临的挑战进行了综述。Lemke等[43]对于元学习及其未来发展趋势进行了文献述评。

综上所见, 算法选择问题一直是相关领域关注的焦点, 研究的重点在于如何实现最适用算法的自动选择。

1.2 相关理论基于元学习思想的算法选择通过改善学习算法的学习行为来处理算法的选择问题,本质上是从大量的问题实例所具有的潜在结构特征中, 获得有价值的信息用于对新实例的行为作出预测判断。构成元知识的元特征和元目标分别来自于数据集以及对算法性能指标的估值或排序。需要探究的是问题的元特征与算法的性能表现之间存在着怎样的关系, 如何利用学习过程逐渐积累的知识建立起完善的元模型, 并用于对未来新问题的算法选择。

为了拥有充分的理论依据, 本文基于两个著名的定理针对组合优化问题提出了一个关于优化算法选择定理。

引理1 若一个组合优化问题具有可行解, 则该问题至少有一个最优解。

证明 因该组合问题具有可行解, 故在满足给定约束条件下, 经有穷次搜索之后, 可找到全部可行解, 最优解必包含在其中。

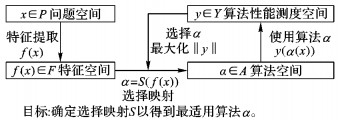

Rice抽象概念图定义[20]:问题的特征属性和算法性能测度之间存在着关联,因而算法选择过程可以归纳为一个形式化的抽象模型, 如图 1所示。对于给定问题实例x∈P, 若其特征为f(x)∈F, 则找到选择映射α=S(f(x))→A, 可使得所选算法α∈A最大化性能y(α(x))∈Y。在本文论域内, 四元组〈P, A, F, Y〉被视为元数据。

|

图 1 Rice算法选择抽象概念图 Figure 1 Schematic diagram of Rice's algorithm selection problem model |

定理1 NFL定理[17]。在有限搜索空间内, 由于对所有可能函数的相互补偿, 最优化算法的性能是等价的, 即没有其他任何算法能够比搜索空间的线性列举或者纯随机搜索算法更优。NFL定理的意义在于:当明确表明一个算法比另一个算法“更好”时, 只是针对具有特定特征的问题或者特定的先验信息、数据分布、训练样本的数目、代价或奖励函数等。

定理2 UD定理[22]。“丑小鸭与白天鹅之间的区别和两只白天鹅之间的区别一样大”。该定理引申的含义表明:世界上不存在分类的客观标准, 一切分类的标准都是主观的。分类的结果取决于选择哪些特征作为分类标准, 而特征的选择又依存于分类的目的。

推论1 由定理1, 任何优化算法都有局限性, 即:局限于某个问题, 或者局限于某个领域, 或者局限于某种特性。

推论2 算法优劣的比较只能在明确界定的特定范围内才有意义。

组合优化问题算法选择定理:若一个组合优化问题具有可行解, 且该问题特征属性的选择偏好明确可析, 则针对该问题至少存在一个优化算法能够取得最佳匹配。换句话说, 在多个优化算法中必定有一个最适用于求解该问题的算法。

证明 由引理1, 该问题至少有一个最优解。因该问题的特征属性的选择偏好明确可析, 故由定理1, 不管采用何种算法, 则至少存在一个目标函数, 能够使得其中一个算法效果最佳; 由定理2, 当把优化算法的选择看作是对算法作出的分类, 则针对该问题的最佳算法取决于特征属性的选择偏好以及对目标函数的指定。再由Rice抽象概念图定义, 为了选择适合给定问题的最佳算法, 不但需要获取问题的特征属性, 还要考虑对于特定问题域, 哪些特征属性与算法的性能相关。

组合优化问题算法选择定理表明, 当明确定义了问题域的特征属性并且建立起与算法相对性能测度之间的关系模型时, 就能够针对所要解决的问题选择出最佳算法。

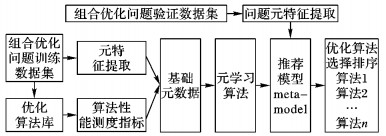

2 组合优化问题算法自动选择框架依照Rice概念图和元学习方法, 本文提出了组合优化问题算法自动选择框架, 如图 2所示。按照该框架, 算法的选择过程如下:首先提取问题数据集的元特征, 形成反映问题特征的元数据; 然后把各候选算法应用到问题数据集, 依据算法性能测度指标评估各算法的相对性能, 形成关于算法优劣的基础元数据; 接着采用适当的元学习方法对基础元数据进行元学习, 以获取问题元特征与算法相对性能测度间对应的元模型, 用于对未见数据集作算法匹配预测, 按照匹配程度的高低从中选择最适用的算法。

|

图 2 组合优化问题算法自动选择框架 Figure 2 Framework of automatic algorithm selection for combinatorial optimization problems |

图 2表明, 基于元学习推荐的算法自动选择过程需要实现以下几个步骤:1) 收集并整理问题数据集; 2) 定义并提取问题数据集特征; 3) 确定参与自动选择的优化算法及其性能评价指标; 4) 选择元学习算法训练问题数据集, 得到元模型; 5) 把元模型用于新数据集的预测, 验证准确率并作出评价。

3 算法选择实证分析 3.1 问题数据集的选取MRCPSP是在资源约束的项目调度问题 (Recourse-Constrained Project Scheduling Problem, RCPSP) 基础上增加活动多模式以及若干种不可更新资源而形成的一类资源约束项目调度问题。经多年研究已经产生了许多求解方法和典型的标杆算例库[21, 44], 为不同方法的优劣比较提供参考标准。

本文从算例库中选出活动规模分别为0、12、14、16、18、20和30, 每一活动有3种执行模式的标杆算例库中随机选取了378个算例作为实证分析的基本数据集。

3.2 数据集元特征的提取元特征提取的基本要求是尽量与元启发式算法的性能相关, 尽量降低提取过程的计算复杂度。具有代表性的数据集特征大致可以分为3类[18]:1) 基于统计和信息论的元特征; 2) 基于基准算法的元特征; 3) 基于模型的元特征。

对于MRCPSP来说, 网络复杂度系数、资源系数、资源强度、次序强度等是其基本的固有特征。但是因所选取问题的结构性质相近, 特征值差别很小, 故不能充分反映此类问题的性能特征, 也不能保证与优化算法的性能测度强相关。为此, 本文结合特征分类方法进一步选取了一系列其他相关特征。表 1列出了所选中3组共38个特征。其中, 固有特征20个, 统计特征5个, 目标函数值特征13个。

| 表 1 MRCPSP可选特征列表 Table 1 Optional features of MRCPSP |

遗传算法、粒子群算法和模拟退火算法三种算法性能相近且都具有鲁棒性和并行搜索等优点,如果能够在性能相近的算法中区分出优劣, 则更能说明所设计的自动算法选择方法的有效性。三种算法中针对MRCPSP的调度排序均采用双维编码[45], 第一维代表活动模式, 第二维代表活动的优先权值。下面给出了一个具有10个活动, 每一活动有三种模式的项目调度问题编码实例:

第一维 (活动模式): 1 3 1 2 3 2 1 2 3 1 2 1

第二维 (优先级): 1 3 5 2 11 4 8 6 7 10 9 12

1) 遗传算法的设计。

首先随机产生种群规模为30的一组双维染色体编码, 然后开始300轮迭代。每一轮迭代过程都分别对双维编码作随机单点交叉和变异。交叉概率0.7, 变异概率0.01, 采用归一化几何轮盘赌策略, 从新生染色体中选择下一代。

2) 粒子群算法的设计。

首先随机产生规模为30的一组双维粒子群编码, 接着开始300轮迭代。每一轮迭代依据标准粒子群算法计算公式更新粒子的速度和位置。学习因子c1、c2分别是0.8和0.7, 惯性权重w=0.93-0.3×Iter/MaxIter(其中:Iter为当前迭代次数,MaxIter为最大迭代次数) 随迭代次数不断下降[45]。

3) 模拟退火算法的设计。

首先随机产生30组双维编码调度, 从中选择一个最好的解作为初始解。给定最大邻域解数量60, 对初始解作随机2-opt交换, 产生60个邻域解。每次都以最佳邻域解作为当前最优解, 若未产生更好的解则按照转移概率接受劣解, 通过内外循环迭代, 逐渐降温。算法参数设定如下:初始温度设定为Tk=500;内循环最大迭代次数ILk=300;外循环最大迭代次数OLk=300;降温系数λ=0.99;转移概率遵从Metropolis准则。

3.4 优化算法的性能测度指标优化算法性能测度指标既能够充分测度出算法的性能表现同时又不会消耗过多的时间。本文设计的指标包括运行效率 (时间) 以及目标值与最优值之间的偏差。由于仅需比较算法的相对性能优劣, 故把各算法的运行时间限定为60 s, 记录算法在运行结束时的结果, 包括偏差和结束时间。每一算法运行5次取平均值。

算法优劣的比较原则如下:先比较偏差, 偏差小的算法较优; 若偏差相等再比较运行时间, 时间短的算法较优。最终得到的是三种元启发式算法的相对优劣排序, 以1、2、3作出标号。

综合上述过程, 得到378行×39列的算例数据集特征矩阵。其中:378行代表 378个算例, 前38列对应38个特征值, 第39列对应1、2、3数值标号, 标出最适于该算例的算法。

3.5 元学习训练过程问题可测特征与算法性能测度之间的映射关系, 体现在二者之间通过大量数据的训练而获得的训练模型。本文采用基于模型的元学习方法——前馈型神经网络 (Feed forward Neural Network, FNN) 算法对元数据进行训练学习。FNN算法假定在问题元特征与算法性能排序之间存在一个可经样本数据进行训练的潜在模型。按照误差逆传播算法训练多层前馈网络, 由信息的正向传播和误差的反向传播两个过程组成。首先将数据输入计算出一个输出, 然后与实际输出比较, 完成一次学习的正向传播处理过程; 当实际输出与期望输出不符时误差反传, 通过不断调整权值和阈值, 使误差平方和最小。本文直接采用了Matlab 2016b人工神经网络工具箱提供的FNN函数来运行算例数据。输入层共有38个神经元, 代表38个问题特征; 隐含层选择10、15、20, 激活函数采用radbas、logsig、tansig三者之一自动优选。不同神经元数量、隐含层个数、使用的激活函数对训练结果有不同影响。为了遴选出最佳隐含层和激活函数, 把隐含侧和激活函数二者交叉形成9种组合, 每种组合单独获取训练模型, 比较筛选出具有最小均方根差的训练模型作为最佳模型。基于前馈神经网络元学习算法的优化算法选择流程如下:

START:给定训练算例x∈P, 测试算例xnew∈P; 元学习算法t∈T; 元启发式算法集合α∈A; 算法性能测度集y∈Y。

Step1 执行所有算例问题特征的提取f(x);

Step2 对x∈P, 执行∀α∈A, 找到各算法依据性能测度集y∈Y的排序, 使得y(αk-1(x))≥y(αk(x));

Step3 执行元学习算法t∈T, 使得训练数据的预测结果的均方根差最小, 获得元模型 (Meta model);

Step4 利用元模型对xnew作出预测, 推荐αbest=Model(xnew)。

3.6 实证结果分析通过提取MRCPSP数据集特征和3个算法的性能测度值, 得到了378行×39列的原始特征与预测目标值对应的矩阵, 然后利用前馈人工神经网络算法对该目标进行预测计算。378个算例按照测试算例个数/训练算例个数的既定比例, 随机拆分为训练组和测试组, 训练组用于训练获得元模型, 测试组用于验证模型的预测准确率。预测准确率定义为:元模型预测值减去性能测度数值标号 (第39列) 出现0的个数与测试算例的总个数之比, 即被准确预测的算法占总测试算例数量的百分比。

平均准确率是指作10次随机交叉验证后得到的准确率或称命中率 (Hit rate) 的平均值。表 2列出了GA、PSO和SA三种算法两两之间进行比较的结果。从结果看,两选一的算法预测准确率最高可超过95%,交叉验证准确率平均达到85%。随着测试算例/训练算例比值的上升, 准确率略有下降, 这说明减少训练算例的占比会影响到预测准确率。若三种算法同时参与比较, 预测准确率最高可达92%, 交叉验证准确率平均为80%。可见, 增加参与比较的优化算法数量也会降低预测准确率。

| 表 2 算法二选一的选择结果 Table 2 Pairwise comparison of three meta-heuristics |

经验表明, 在求解Benchmark问题过程中经常出现的情况是:一个算法用于其中多数算例会得到很好的结果, 但是其中总是有一小部分算例的结果不能令人满意; 而当换用另外一个算法时, 会有另一小部分算例的结果表现不好。本文方法能够针对当前算例自动地推荐一个较好的算法, 从而避免了盲目的算法使用, 可以显著地改变计算效率, 提高解决问题的总体表现。

4 结语元学习概念最早源于人工智能领域的机器学习理论, 用于探究学习过程和学习机制, 以便于改进或调整学习效果, 其目标是把问题的元特征与元模型关联起来, 构建自适应的自动学习机制。本文把这一理念引入到元启发式算法的自动选择过程中, 为解决现实中“问题-算法”之间盲目或者低效率匹配这一矛盾尝试了一条新的思路。

本文以资源约束项目调度问题为验证数据集, 依照设计的算法自动选择框架对三种优化算法的选择进行了实证分析, 取得了初步成果。从预测准确率来看, 基于元学习推荐的算法自动选择这一设想仍值得进一步的深入研究。下一步的工作包括:进一步提升数据集元特征提取的精准度, 寻找那些更能够反映数据集本质特征的数据; 进一步探索算法的性能测度表现与问题元特征之间的关联关系。除了关注问题特征之外, 对于算法性能的评测标准目前主要集中在时间和准确率上, 下一步将尝试从多维角度对算法性能进行评测, 例如, 对评测指标分配不同的权重。现实中有许多具有NP难特性的组合优化问题, 本文所尝试的这一研究路线完全适用于任何类似问题的算法自动选择过程。

| [1] | HILLIER F S, LIEBERMAN G J. Introduction to Operations Research[M]. New York: McGraw-Hill, 2014 : 12 -17. |

| [2] | 汪定伟, 王俊伟, 王洪峰, 等. 智能优化方法[M]. 北京: 高等教育出版社, 2007 : 1 -9. ( WANG D W, WANG J W, WANG H F, et al. Intelligent Optimization Method[M]. Beijing: Higher Education Press, 2007 : 1 -9. ) |

| [3] | HOLLAND J H. Adaptation in Natural and Artificial Systems[M]. Ann Arbor: University of Michigan Press, 1975 : 22 -30. |

| [4] | KIRKPATRICK S, GELATT J R, VECCHI M P. Optimization by simulated annealing[J]. Science, 1983, 220 (4598) : 671-680. doi: 10.1126/science.220.4598.671 |

| [5] | COLORNI A, DORIGO M, MANIEZZO A. Distributed optimization by ant colonies[EB/OL].[2016-03-01]. http://faculty.washington.edu/paymana/swarm/colorni92-ecal.pdf. |

| [6] | KENNEDY J, EBERHART R. Particle swarm optimization[C]//Proceedings of the 1995 IEEE International Conference on Neural Networks. Piscataway, NJ: IEEE, 1995: 1942-1948. |

| [7] | PASSINO K M. Biomimicry of bacterial foraging for distributed optimization and control[J]. IEEE Control Systems Magazine, 2002, 22 (3) : 52-67. doi: 10.1109/MCS.2002.1004010 |

| [8] | 李晓磊, 邵之江, 钱积新. 一种基于动物自治体的寻优模式:鱼群算法[J]. 系统工程理论与实践, 2002, 22 (11) : 32-38. ( LI X L, SHAO Z J, QIAN J X. An optimizing method based on autonomous animats: fish-swarm algorithm[J]. System Engineering & Theory Practice, 2002, 22 (11) : 32-38. ) |

| [9] | EUSUFF M, LANSEY K. Optimization of water distribution network design using the shuffled frog leaping algorithm[J]. Journal of Water Resources Planning and Management, 2003, 129 (3) : 210-215. doi: 10.1061/(ASCE)0733-9496(2003)129:3(210) |

| [10] | KARABOGA D. An idea based on honey bee swarm for numerical optimization[R]. Kayseri, Turkiye: Erciyes University, 2005. |

| [11] | XINSHE Y. Nature-inspired metaheuristic algorithms[M]. London: Luniver Press, 2008 : 38 -50. |

| [12] | XINSHE Y. Cuckoo search via levy flights[C]//NaBIC 2009: Proceedings of the 2009 World Congress on Nature & Biologically Inspired Computing. Piscataway, NJ: IEEE, 2009: 210-214. |

| [13] | XINSHE Y, GANDOMI A H. Bat algorithm: a novel approach for global engineering optimization[J]. Engineering Computations, 2012, 29 (5) : 464-483. doi: 10.1108/02644401211235834 |

| [14] | GANDOMI A H, ALAVI A H. Krill herd: a new bio-inspired optimization algorithm[J]. Communications in Nonlinear Science and Numerical Simulation, 2012, 17 (12) : 4831-4845. doi: 10.1016/j.cnsns.2012.05.010 |

| [15] | TANG R, FONG S, YANG X, et al. Wolf search algorithm with ephemeral memory[C]//Proceedings of the Seventh International Conference on IEEE Digital Information Management. Piscataway, NJ: IEEE, 2012: 165-172. |

| [16] | YAZDANI M, JOLAI F. Lion Optimization Algorithm (LOA): a nature-inspired metaheuristic algorithm[J]. Journal of Computational Design and Engineering, 2016, 3 (1) : 24-36. doi: 10.1016/j.jcde.2015.06.003 |

| [17] | WOLPERT D H, MACREADY W G. No free lunch theorems for optimization[J]. IEEE Transactions on Evolutionary Computation, 1997, 1 (1) : 67-82. doi: 10.1109/4235.585893 |

| [18] | 曾子林, 张宏军, 张睿. 基于元学习思想的算法选择问题综述[J]. 控制与决策, 2014, 29 (6) : 961-968. ( ZENG Z L, ZHANG H J, ZHANG R. Summary of algorithm selection based on meta-learning[J]. Control and Decision, 2014, 29 (6) : 961-968. ) |

| [19] | CRUZ-REYES L, GÓMEZ-SANTILLÁN C, PÉREZ-ORTEGA J. Algorithm selection: from meta-learning to hyper-heuristics[EB/OL].[2016-03-01]. http://cdn.intechweb.org/pdfs/30653.pdf. |

| [20] | RICE J R. The algorithm selection problem[J]. Advances in Computation, 1976, 15 : 65-118. |

| [21] | JOSÉC, MARIO V. Multi-mode resource-constrained project scheduling using RCPSP and SAT solvers[J]. European Journal of Operational Research, 2011, 213 (1) : 73-82. doi: 10.1016/j.ejor.2011.03.019 |

| [22] | WATANABE S. Knowing and Guessing: A Quantitative Study of Inference and Information[M]. New York: Wiley, 1969 : 376 -377. |

| [23] | SONG Q B, WANG G T, WANG C. Automatic recommendation of classification algorithms based on data set characteristics[J]. Pattern Recognition, 2012, 45 (7) : 2672-2689. doi: 10.1016/j.patcog.2011.12.025 |

| [24] | CAN C, MENGQI H, JEFFERY D W, et al. A recommendation system for meta-modeling: a meta-learning based approach[J]. Expert Systems with Applications, 2016, 46 : 33-44. doi: 10.1016/j.eswa.2015.10.021 |

| [25] | BRODLEY C E. Recursive automatic bias selection for classifier construction[J]. Machine Learning, 1995, 20 (1) : 63-94. |

| [26] | DE SOUZA B F, CARVALHO D, SOARES C. Metalearning for gene expression data classification[C]//HIS 2008: Proceedings of 2008 Eighth International Conference on Hybrid Intelligent Systems. Piscataway, NJ: IEEE, 2008: 441-446. |

| [27] | LAN Z, GU J, ZHENG Z. A study of dynamic meta-learning for failure prediction in large-scale systems[J]. Journal of Parallel and Distributed Computing, 2010, 70 (6) : 630-643. doi: 10.1016/j.jpdc.2010.03.003 |

| [28] | ZHOU S, LAI K K, YEN J. A dynamic meta-learning rate-based model for gold market forecasting[J]. Expert Systems with Applications, 2012, 39 (6) : 6168-6173. doi: 10.1016/j.eswa.2011.11.115 |

| [29] | GIRAUD-CARRIER C. Metalearning-a tutorial[EB/OL].[2016-03-10]. https://pdfs.semanticscholar.org/5794/1a4891f673cadf06fba02419372aad85c3bb.pdf. |

| [30] | ROSSI AL D, CARVALHO A, SOARES C, et al. Meta-stream: a meta-learning based method for periodic algorithm selection in time-changing data[J]. Neurocomputing, 2014, 127 : 52-64. doi: 10.1016/j.neucom.2013.05.048 |

| [31] | KING R D, FENG C, SUTHERLAND A. STATLOG: comparison of classification algorithms on large real-world problems[J]. Applied Artificial Intelligence, 1995, 9 (3) : 289-333. doi: 10.1080/08839519508945477 |

| [32] | PFAHRINGER B, BENSUSAN H, GARRIER C G. Meta-learning by landmarking various learning algorithms[C]//ICML 2000: Proceedings of the Seventeenth International Conference on Machine Learning. San Francisco: Morgan Kaufmann Publishers, 2000: 743-750. |

| [33] | RENDELL L, CHO H. Empirical learning as a function of concept character[J]. Machine Learning, 1990, 5 (3) : 267-298. |

| [34] | AHA D. Generalizing from case studies: a case study[C]//ICML 1992: Proceedings of the 9th International Conference on Machine Learning. San Francisco: Morgan Kaufmann Publishers, 1992: 1-10. |

| [35] | SMITH-MILES K A. Cross-disciplinary perspectives on meta-learning for algorithm selection[J]. ACM Computing Surveys, 2008, 41 (1) : 1-25. |

| [36] | MISIR M. Intelligent hyper-heuristics: a tool for solving generic optimization problems[D]. Flanders, Belgium: Katholieke Universiteit Leuven, 2012. |

| [37] | MESSELIS T, CAUSMAECKER P D. An automatic algorithm selection approach for the multi-mode resource-constrained project scheduling problem[J]. European Journal of Operational Research, 2014, 233 (3) : 511-528. doi: 10.1016/j.ejor.2013.08.021 |

| [38] | VILALTA R, DRISSI Y. A perspective view and survey of meta-learning[J]. Artificial Intelligence Review, 2002, 18 (2) : 77-95. doi: 10.1023/A:1019956318069 |

| [39] | MIRANDA P B C, PRUDENCIO R B C, CARVALHO A, et al. A hybrid meta-learning architecture for multi-objective optimization of SVM parameters[J]. Neurocomputing, 2014, 143 : 27-43. doi: 10.1016/j.neucom.2014.06.026 |

| [40] | SMITH-MILES K, LOPES L. Measuring instance difficulty for combinatorial optimization problems[J]. Computers & Operations Research, 2012, 39 (5) : 875-889. |

| [41] | LEYVA E, CAISES Y, GONZÁLEZ A, et al. On the use of meta-learning for instance selection: an architecture and an experimental study[J]. Information Sciences, 2014, 266 : 16-30. doi: 10.1016/j.ins.2014.01.007 |

| [42] | BHATT N, THAKKAR A, GANATRA A. A survey & current research challenges in meta-learning approaches based on dataset characteristics[J]. International Journal of Soft Computing and Engineering, 2012, 2 (1) : 239-247. |

| [43] | LEMKE C, BUDKA M, GABRYS B. Meta-learning: a survey of trends and technologies[J]. Artificial Intelligence Review, 2015, 44 (1) : 117-130. doi: 10.1007/s10462-013-9406-y |

| [44] | KOLISCH R, SPRECHER A. PSPLIB-a project scheduling problem library[J]. European Journal of Operational Research, 1996, 96 (1) : 205-216. |

| [45] | 陈龙, 韩兆兰, 崔建双. 求解多模式资源约束的项目调度问题的离散粒子群算法[J]. 计算机应用, 2015, 35 (Suppl 2) : 101-105. ( CHEN L, HAN Z L, CUI J S. Discrete particle swarm optimization for solving multi-mode resource-constrained project scheduling problem[J]. Journal of Computer Applications, 2015, 35 (Suppl 2) : 101-105. ) |