2. 昆明理工大学 教育技术与网络中心, 昆明 650500;

3. 云南省计算机技术应用重点实验室 (昆明理工大学), 昆明 650500

2. Educational Technology and Network Center, Kunming University of Science and Technology, Kunming Yunnan 650500, China;

3. Yunnan Provincial Key Laboratory of Computer Technology Applications (Kunming University of Science and Technology), Kunming Yunnan 650500, China

随着网络数据的飞速增长, 如何使人们更方便更快捷地准确获取到需要的信息也变得更加重要。由于网络上的信息大部分属于非结构化和半结构化的信息, 信息抽取就是从这些异构数据源中获取结构化知识的技术, 这项技术被用在了构建知识图谱[1]、自动问答系统、语义精准搜索等多个领域。关系抽取属于信息抽取的一个子任务, 当实体抽取完成后, 得到了一系列离散的命名实体, 如何将这些实体关联起来, 找出实体之间的语义关系就是关系抽取所要解决的问题。

现有的关系抽取的方法可以分为基于模式匹配[2]的方法、基于词典驱动的方法[3]和基于机器学习的方法[4-5]等, 其中基于机器学习的方法是目前主流的关系抽取方法。基于机器学习的方法又可以分为有监督的方法、无监督的方法和弱监督的方法。有监督的方法需要人工标记大量的训练语料, 费事费力且移植性差;而现阶段无监督的方法在准确率和召回率都比较低。在这种情况下, 人们提出了基于弱监督的关系抽取方法[6], 弱监督的关系抽取方法在少量人工标记语料的基础上通过自举 (boostrapping) 的学习方法, 不断自动扩充训练语料, 有效减少了人工参与, 并且获得了不错的性能。

利用机器学习的方法进行关系抽取时, 又可分为基于特征向量的方法[7-8]和基于核函数的方法[9]。核函数的方法在学习和训练的速度上都相对较慢[10], 而基于特征向量的方法在各方面表现比较优秀。基于特征向量的方法中特征项的选择十分重要, 首先特征项不仅需要能够体现较多的语义信息, 而且要能够准确区分不同的语义关系。特征项的好坏直接影响着关系抽取的性能高低。一般特征的选择有词法特征和语法特征。词法特征为句子中的词序列, 单纯基于词法特征会导致数据的稀疏性, 限制分类性能。语法特征从句子的依存关系路径中获取, Miller等[11]研究表明, 语法特征可以较好地体现句子中的语义关系, 将语法特征作为关系抽取的特征向量, 对实体关系抽取的性能有很大帮助。陈立玮等[12]指出中文由于结构复杂, 特别是在对中长句子的句法分析上, 现有句法分析工具性能明显下降。然而英文的句法分析工具经过较长时间发展, 已经比较成熟, 基本可以完成英语句子的句法分析。本文使用了协同训练的方法[13], 在中文视图的特征选择上面, n-gram特征相对来说是一个较好的选择, 它不依赖句法分析工具, 且不存在词法特征的稀疏性问题,同时还体现了相邻词语之间的序列关系, 但它在英文上与句法特征相比处于劣势[12]。

通过利用一种语言的优势去提升另一种语言的关系抽取性能是一个可行的办法, Kim等[14]将英语丰富的语料作为源训练数据用来提升语料资源贫乏的韩语关系抽取性能上面。如今大量的弱监督关系抽取主要集中在以英语为主的文本上面, 现有的句法分析工具在中文长句的分析效果上可能会出现较大波动, 对关系抽取模型的分类性能产生较大的影响。

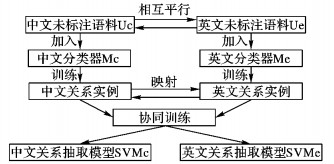

本文提出一种基于平行语料库的双语协同训练方法, 在中英平行语料库中, 利用英文的句法分析工具对英文进行句法分析, 对英文和中文语料使用适合各自语言的不同特征, 同时训练中文分类器和英文分类器, 采用自举的学习方法, 在中文分类器和英文分类器中提取出可靠度较高的关系实例, 将一种语言中可靠度较高的关系实例通过标注映射的平行语料库, 找到平行语料库中对应的关系实例, 加入到另一种语言的训练语料中, 通过不断的迭代, 提升了训练语料的质量, 从而得到性能更佳的中文关系抽取分类模型。实验结果表明, 基于平行语料的双语协同训练可以提升中文的关系抽取性能。

1 弱监督关系抽取框架 1.1 自举的弱监督关系抽取方法弱监督关系抽取的方法最早出现在对文献中蛋白质和基因的关系抽取中, 后来人们对其进行了大量的改进和优化[15]。基于自举方式的弱监督关系抽取以少量的种子集合为基础, 种子集合为已标注的实例集, 将种子集作为训练语料, 利用种子集合训练出一个分类器, 然后对未标注的大量可靠文本语料通过分类器进行分类, 将可信度较高的候选实例结果加入到种子集合中再进行训练。这样一方面解决了初始训练语料不足的问题, 对训练语料进行了优化; 另一方面减少了人工手工标注的工作量。一般关系抽取使用的分类模型有最大熵模型和支持向量机 (Support Vector Machine, SVM)。研究表明[16], 支持向量机略优于最大熵,所以本文使用支持向量机SVM作为分类器。SVM可以输出某一关系实例在各个关系类别上的概率值, 通过计算概率分布的熵值来判断候选实例的可信度, 熵值越小的候选实例其可信度越高。熵值的计算公式如下:

| $ H =-\sum\limits_{i = 1}^K {{P_i}\lg \;{P_i}} $ | (1) |

其中:K表示一共的关系类别个数;Pi表示关系实例属于第i种关系类别的概率值。

1.2 弱监督关系抽取的特征选取一个好的特征对于分类器的效果影响十分重要, 常用的特征有词法特征、句法特征还有n-gram特征。词法特征由词序列和词性序列构成, 单独使用词法特征会导致数据稀疏性的问题, 所以一般将词法特征与其他特征相结合一起使用。句法特征一般从句子的句法依存路径中获取, 基于英语的依存句法分析工具已比较成熟, 可以准确地得到句子的句法依存关系结果, 而中文的依存句法分析工具在中长句上效果较差。n-gram特征利用设定窗口大小去获取文本中连续的词组序列, 一定程度上体现了语法关系, 它的优点是不需要依赖具体的现存在的工具, 并且不存在数据稀疏的问题, 可用在中文句子语料上面。文献[12]提出的一种新的n-gram特征, 它是基于词语和它的词性标注的n-gram特征。本文在英语训练语料上选择可靠度较高分析工具的词法特征加语法特征, 中文训练语料上选择比较适合中文句子的n-gram特征。词法特征、句法特征和本文所用的基于词语和词性标注的n-gram特征分别举例如下:

词法特征举例:〈PER〉比尔盖茨, 出生于西雅图〈ORG〉, PER NR PU VV P ORG NS。

句法特征举例:〈PER〉->出生/VV < -于/P < -〈ORG〉。

n-gram特征举例 (词语和词性标注组合):〈PER〉出生/VV于/P 〈ORG〉。

2 基于平行语料库的双语协同训练 2.1 双语协同训练协同训练是一种基于半监督的学习框架, 它也是一种基于boostrapping思想的半监督学习框架。它使用两种不同的独立的特征下的视图去训练两个分类器, 两个分类器各自对自己的数据进行分类, 将各自分类结果中置信度最高的前n个数据加入到对方的训练语料中去。

本文使用中英双语平行语料库, 利用小规模的标注的双语语料分别选择词法特征加句法特征和n-gram特征, 分别对其中的具有语义关系的英语语料和中文语料进行训练, 得到两个不同的分类器, 记为Me (英文分类器) 和Mc (中文分类器)。再对未标注的中英双语平行语料进行分类, 得到新的英文和中文的带标签的实例, 通过标注映射, 找到平行语料库中对应的实例, 分别加入到中文和英文分类器的训练语料中, 然后再继续进行训练, 不断迭代进行, 直到所有实例迭代完成为止, 最后得到了两个协同训练后的中文分类器SVMc和英文分类器SVMe。具体算法过程如下:

输入:有标注的英文训练数据集Le和中文训练数据集Lc, 无标注的英文数据集Ue和无标注的中文数据集Uc。

输出:训练后的中文关系抽取模型SMVc和英文关系抽取模型SVMe。

Step1 使用Le训练一个英文数据分类器Me, 使用Lc训练一个中文分类器Mc。

Step2 迭代循环t次:

Step2.1 从Ue中取出部分数据集记为Ue′, 使用Me对Ue′中的数据进行分类。

Step2.2 将置信度较高的前n个实例记为Ee, 在已经标注映射好的平行语料库中找到它们对应的实例记为Eec。

Step2.3 将Ee和Eec分别加入到Le和Lc中。

Step2.4 从Uc中取出部分数据集记为Uc′, 使用Mc对Uc′中的数据进行分类。

Step2.5 将置信度较高的前n个实例记为Ec, 在已经标注映射好的平行语料库中找到它们对应的实例记为Ece。

Step2.6 将Ec和Ece分别加入到Lc和Le中。

Step2.7 从Ue′和Uc′中删除已经添加到训练集中的数据, 并且从Ue和Uc中再取出部分数据集加入到Ue′和Uc′中。

整个流程框架如图 1所示。

|

图 1 协同训练框架图 Figure 1 Collaborative training framework |

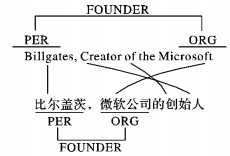

当获得中英文两个分类器中得出的可信度较高的关系实例后, 在加入到彼此的训练语料中之前, 首先需要通过对平行语料库对其进行标注映射处理, 以找到英文句子中的关系实例与中文句子中的关系实例的对应关系。标注映射的第一步就是标注。首先通过命名实体识别技术在平行双语文本的英文句子中找出存在的一系列实体, 每两个实体组成一个实体对, 一般称为实例。然后对实例进行标注。接下来在每两个实体之间探测它们存在的语义上的关系, 然后对实体之间存在的语义关系进行标注。以上工作主要利用现有的工具帮助检测并标注出在平行双语文本中英语句子中的实例和实例之间的关系。标注的结果如图 2所示, 图 2中为中英双语平行语料库中的一对句子的标注映射结果, 微软公司和比尔盖茨两个实体构成了一个实例, 表现了人名和组织机构名之间的创建关系。

|

图 2 中英平行语句标注映射图 Figure 2 Annotation mapping between Chinese and English parallel sentences |

在完成中英平行语料库中英文句子的标注任务后, 需要将标注的内容映射到相对应的另一种语言 (中文) 中, 本文是从英文到中文进行映射。本文使用单词对齐的方法完成从英文到中文的标注映射的任务, 单词对齐就是在双语文本中找到词汇级的对译关系, 这样就可以找到英文句子中实例和实例间关系在中文句子中对应的词。单词对齐的算法有很多, 比如Brown等[17]提出的IBM模型, 这些算法已经被成功地运用在机器翻译等自然语言处理任务方面。本文使用的单词对齐工具为GIZA++, 该工具在中英文上都可以使用,并已广泛应用于机器翻译等领域,其单词对齐效果可以满足大多数情况下的需求。经过单词对齐之后, 识别出中英双语文本中具有平移关系的每个词, 由此形成了一个二分图, 图中的无向边将英文句子中代表实体和关系的词和中文中对应的词连接起来。本文首先完成实体之间的映射, 再完成实体之间关系的映射。经过上面的步骤, 使可以将实体和实体关系从英文句子中映射到汉语句子中。如图 2所示,“billgates”和“Microsoft”映射到了它们在中文句子中对应的实例比尔盖茨和微软公司。

基于单词对齐的实体和关系映射可能由于工具的原因产生一些错误的映射, 进一步将影响实验的训练语料的质量, 因此需要制定一些启发式的规则去提高实体映射的准确度, 尽量减少由错误映射得到的关系实例加入到训练语料中去。本文定制的启发式规则如下:

1) 英文中每个实体指称只对应中文中一个实体指称。

2) 对于英文中连续多个词构成的实体指称在中文中也必须是连续多个词构成, 中间不能有间隔。

3) 对齐实体的词性必须相同。

除以上的启发式的方法外, 本文还提出了一种基于翻译工具的实体映射检查策略。该策略如下:将在平行双语语料中的英文句子中的实例通过翻译工具进行翻译, 得到多个近似的对应的中文词汇, 然后在平行双语语料中对应的中文句子中匹配最大长度相似的词汇, 如果找到相同的词汇且只有一处, 那么将英文句子中的实例映射到中文中找到的相同或相似的那个实例。

通过以上两种方法, 过滤了一些不合格的关系实例映射, 使得标注映射的准确率得到了一定程度的提高。

3 实验与分析 3.1 实验设置本文所使用的中英平行语料库为哈尔滨工业大学信息检索研究室的英汉双语语料库, 它包括10万对句子对齐的双语句子对。本文选取其中的5万对平行句子对作为正式语料。首先对其中的英文句子进行命名实体识别、依存关系分析等预处理操作, 完成对英文句子的标注任务;然后通过文中上述方法对语料库进行标注映射,最终有24127个对齐的实例。在其中选取含有语义关系与不含语义关系的5600个实例作为最后的实验语料集合。本实验选取其中1/6作为测试集, 在剩余的实例中选取1/20作为已经标注的数据集, 剩下的作为未标注的数据集。由于基础的SVM分类器为2类分类器, 所以本文选取改进的SVMLIB作为本实验的分类器。实验最后结果取平均值。实验结果的评价包括准确率、召回率和F1指数。

中文的句法分析工具使用Mate Parser[18], 英文句子的预处理工具使用斯坦福大学的自然语言处理工具[19-20]。

3.2 实验结果和分析1) 首先用不同的方法对中文测试语料进行测试分析, 选取的方法有未采取协同训练的弱监督自举SVM中文关系抽取, 记为LLS;单语 (中文) 协同训练方法, 记为LLCB;双语 (中英文) 协同训练方法, 记为DLCB。其中单语和双语协同训练算法中每次选取实例数n为20, 也就是SVMc和SVMe每次各加入20个实例。取最高性能为其实验结果值。

从表 1可以看出双语协同训练要比未采取协同训练的关系抽取方法在性能上得到了提升, 而双语协同训练又在单语协同训练的基础上进一步提升了性能。

| 表 1 不同算法性能比较 % Table 1 Performance comparison of different algorithms % |

2) 双语协同训练时英文的分类特征为从依存语法中获得的语法特征, 中文使用的是基于词语与词性的n-gram特征。下面将比较双语协同训练时中英文特征的选择对关系抽取结果的影响。中英文的特征选取分别为词法加语法特征 (lex+syn)、词法加n-gram特征 (lex+ng),结果如表 2所示。

| 表 2 双语协同训练不同特征选取性能比较 % Table 2 Performance comparison of different feature selection in bilingual cooperative training % |

从表 2可以看出, 中英双语协同训练时的特征选取对抽取结果产生了影响, 其中英文选取词法加句法特征, 中文选取词法加n-gram特征取得了最好的效果, 在英文上选取n-gram特征没有取得更好的效果, 反而有略微下降,主要还是因为在中文长难句的语法分析效果上没有英文的好,而英文的语法分析工具已经比较成熟。n-gram特征对中文的关系抽取提供了很好的补充, 优于传统的语法特征。总体来看协同训练提高了关系抽取的性能, 以英文的句法特征为特征向量的分类器得到的实例很好地补充了中文关系抽取分类器的训练语料集。

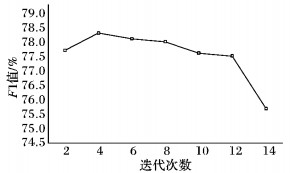

3) 协同训练时, 不同的迭代次数会对最终分类模型的性能造成不同的影响, 接下来对不同迭代次数下协同训练的性能进行比较。这次取n的值为100进行迭代。如图 3所示。

|

图 3 DLCB算法迭代次数对F1值的影响 Figure 3 Influence of iteration number of DLCB algorithm on F1 value |

由图 3可以看出, 随着迭代次数的上升, 一开始模型性能呈现出上升的趋势, 但是随着迭代次数的继续增加, 其性能出现了下滑, 据此可知, 迭代次数在中间的一个合适值时, 模型的性能达到了最优的状态。其原因还是因为随着迭代次数的增加, 由于标注映射错误等产生的一些低质量训练语料被加入训练语料的概率增加, 降低了关系抽取模型的性能。

3.3 算法性能分析双语协同训练时, 影响其性能的方面主要有训练语料的影响和协同训练策略的影响。除此之外, 本文还计算了SVM分类算法用于此关系抽取方法的时间复杂度。

由于本文采取的是简单的词对齐的方法对中英文语料库进行映射, 虽然采取了启发式的方法和基于翻译工具的实体映射检查策略, 但不能避免地会存在错误映射的实例对, 在协同训练中, 一旦错误的映射被加入到可信的训练语料中去, 这个错误将被继续学习和加强, 最终对关系抽取分类器的性能造成极大的影响。在应用级的大规模的语料中, 很难人工检查修正未正确映射的关系实体, 因此需要对对齐率进行评估, 在侧面将反映出协同训练最终得到中文关系抽取模型的好坏。本文随机抽取1000对经过单词对齐后的中英文, 手动计算关系实例对齐率。一共进行5次计算, 最后计算平均值, 作为整体的对其率。经过人工对比, 发现对其率达到了78.4%, 在一定程度上适用于双语协同训练。

除了训练语料的影响, 协同训练本身参数的设置也会对本文的关系抽取模型性能造成影响, 本文在这里重点研究的参数为协同训练时特征的选取和迭代次数对其的影响。结果已经在上面的实验中进行了测试。

本文计算分析了利用SVM进行自举训练时的算法时间复杂度, 其时间复杂度如下:O(n2*M2*d)。其中:M代表未标注语料的大小;d为所取特征的维度, 取所有词中tf-idf最高的前10000个词作为分类特征, 这里选取词法特征作为实验;n为所分种类数。M和n取不同值时算法执行的时间如表 3所示。

| 表 3 算法执行时间分析 Table 3 Algorithm execution time analysis |

通过对算法各个方面进行的分析来看, 由映射错误和SVM效率等问题, 使得算法的性能遭受了一定的影响。

4 结语本文提出了一种基于平行语料库的双语协同训练方法用于提升中文关系抽取的性能, 针对中文关系抽取时依然句法分析工具, 而长难句句法分析准确性会大幅下降的问题, 使用适合各自语言的特征在平行语料库中的中英文同时进行训练, 将彼此可信度高的且标注好的实例映射到彼此的训练语料中, 提升了训练语料的质量。实验结果表明, 选取英文的句法特征和中文的n-gram通过协同训练得到的中文分类器很好地改善了中文的关系抽取性能, 优于基于弱监督的纯中文自举训练的方法, 这种方法适用于多语言的关系抽取, 具有较强的鲁棒性。

后续工作中:一方面将继续对平行语料库的标注映射工作进行优化, 使其更加准确; 另一方面, 在现实应用中, 可以使用的双语语料库毕竟有限, 且质量不一定能满足关系抽取的需求, 因而寻找更加适合中文关系抽取的特征是今后深入研究的方向。

| [1] | 刘峤, 李杨, 段宏. 知识图谱构建技术综述[J]. 计算机研究与发展, 2016, 53 (3) : 582-600. ( LIU Q, LI Y, DUAN H. Knowledge graph construction techniques[J]. Journal of Computer Research and Development, 2016, 53 (3) : 582-600. ) |

| [2] | APPELT D E, HOBBS J R, BEAR J, et al. SRI international FASTUS system: MUC-6 test results and analysis[C]//MUC61995: Proceedings of the 6th Conference on Message Understanding. Stroudsburg, PA, USA: Association for Computational Linguistics, 1995:237-248. |

| [3] | AONE C, RAMOS-SANTA M. REES: a large-scale relation and event extraction system[C]//ANLC 2000: Proceedings of the Sixth Conference on Applied Natural Language Processing. Stroudsburg, PA, USA: Association for Computational Linguistics, 2000:76-83. |

| [4] | ZHANG Y, ZHOU J F.A trainable method for extracting Chinese entity names and their relations[C]//CLPW 2000: Proceedings of the Second Workshop on Chinese Language Processing: Held in Conjunction with the 38th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA, USA: Association for Computational Linguistics, 2000, 12: 66-72. |

| [5] | ZHANG Z. Weakly-supervised relation classification for information extraction[C]//CIKM 2004: Proceedings of the Thirteenth ACM International Conference on Information and Knowledge Management. New York: ACM, 2004:581-588. |

| [6] | CRAVEN M, KUMLIEN J. Constructing biological knowledge bases by extracting information from text sources[C]//Proceedings of the Seventh International Conference on Intelligent Systems for Molecular Biology. Menlo Park, CA: AAAI Press, 1999:77-86. |

| [7] | ZHAO S, GRISHMAN R. Extracting relations with integrated information using kernel methods[C]//ACL 2005: Proceedings of the 43rd Annual Meeting on Association for Computational Linguistics. Stroudsburg, PA, USA: Association for Computational Linguistics, 2005: 419-426. |

| [8] | ZHOU G, SU J, ZHANG J, et al. Exploring various knowledge in relation extraction[C]//ACL 2005: Proceedings of the 43rd Annual Meeting on Association for Computational Linguistics. Stroudsburg, PA, USA: Association for Computational Linguistics, 2005:427-434. |

| [9] | ZELENCO D, AONE C, RICHARDELLA A. Kernel methods for relation extraction[J]. Journal of Machine Learning Research, 2003, 3 (6) : 1083-1106. |

| [10] | SHAWE-TAYLOR J, CRISTIANINI N. Kernel methods for pattern analysis[M]. New York: Cambridge University Press, 2004 : 25 -45. |

| [11] | MILLER S, FOX H, RAMSHAW L, et al. A novel use of statistical parsing to extract information from text[C]//NAACL 2000: Proceedings of the 1st North American Chapter of the Association for Computational Linguistics Conference. Stroudsburg, PA, USA: Association for Computational Linguistics, 2000:226-233. |

| [12] | 陈立玮, 冯岩松, 赵东岩. 基于弱监督学习的海量网络数据关系抽取[J]. 计算机研究与发展, 2013, 50 (9) : 1825-1835. ( CHEN L W, FENG Y S, ZHAO D Y. Extracting relations from the Web via weakly supervised learning[J]. Journal of Computer Research and Development, 2013, 50 (9) : 1825-1835. ) |

| [13] | BLUM A, MITCHELL T. Combining labeled and unlabeled data with co-training[C]//COLT 1998: Proceedings of the Eleventh Annual Conference on Computational Learning Theory. New York: ACM, 1998:92-100. |

| [14] | KIM S, JEONG M, LEE J, et al. A cross-lingual annotation projection approach for relation detection[C]//COLING 2010: Proceedings of the 23rd International Conference on Computational Linguistics. Stroudsburg, PA, USA: Association for Computational Linguistics, 2010:564-571. |

| [15] | RIEDEL S, YAO L, MCCALLUM A. Modeling relations and their mentions without labeled text[C]//ECML PKDD 2010: Proceedings of the 2010 European Conference on Machine Learning and Knowledge Discovery in Databases, Part Ⅲ, LNCS 6323. Berlin: Springer, 2010:148-163. |

| [16] | WANG T, LI Y, BONTOHEVA K, et al. Automatic extraction of hierarchical relations from text[C]//ESWC 2006: Proceedings of the 3rd European Conference on the Semantic Web: Research and Applications. Berlin: Springer, 2006: 215-229. |

| [17] | BROWN P F, PIETRA V J D, PIETRA S A D, et al. The mathematics of statistical machine translation: parameter estimation[J]. Computational Linguistics, 1993, 19 (2) : 263-311. |

| [18] | BOHNET B.Top accuracy and fast dependency parsing is not a contradiction[C]//COLING 2010: Proceedings of the 23rd International Conference on Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2010:89-97. |

| [19] | MAMEFFE M, MACCARTNEY B, MANNING C. Generating typed dependency parses from phrase structure parses[EB/OL].[2016-03-10]. http://www.lrec-conf.org/proceedings/lrec2006/pdf/440_pdf.pdf. |

| [20] | FINKEL J R, GRENAGER T, MANNING C. Incorporating non-local information into information extraction systems by Gibbs sampling[C]//ACL 2005 Proceedings of the 43rd Annual Meeting on Association for Computational Linguistics. Stroudsburg, PA, USA: Association for Computational Linguistics, 2005:363-370. |