微博是中国最热门的社交平台之一,是网络新词的主要来源。微博新词作为未登录词的大量出现,给微博文本分析带来很大困难。其中,微博文本的分词精度低下是必须解决的首要问题。既有研究结果显示,60%的分词错误都由未登录词导致[1]。如何有效地提高微博新词的识别精度,具有重要的研究意义和实用价值。目前,微博新词识别主要研究方法包括:基于规则、基于统计、规则与统计相融合等三种方法。

基于规则的方法是从语言学的角度对新词的构词规则进行归纳总结并构建正则表达式规则库。邹纲等[2]针对网页上的中文新词识别问题,提出一种从网页中自动检测新词语的方法,并根据构词规则对自动检测的结果进行过滤,最终抽取新词语。该方法对高频新词有很好的识别效果。Ma等[3]针对网络新闻中的未登录词,提出一种自下而上的归并算法,同时引入一些基本语法规则,避免了过多的高频垃圾串的抽取。Sasano等[4]针对日语中的未登录词,利用衍生规则和象声词模式,通过在句子的格框架中添加新节点的方式发现最优路径,以此实现对未登录词的识别,该方法对某些特定类别的未登录词有很好的识别效果。基于规则的方法针对特定领域可以得到很高的准确率,但是人工制定规则需要大量人工成本,存在规则领域性适应能力低下等问题。

基于统计的方法通常使用大规模语料库,通过计算统计信息量来发现新词。Wang等[5]将新词识别问题与分词问题结合,在对文本分词标注和新词标注的基础上,利用统计量特征对改进的条件随机场 (Conditional Random Field, CRF) 模型进行训练,同时提高了分词和新词识别的效果。Sun等[6]融合词法特征和边界特征,提出一种快速的线上CRF训练方法,将识别到的新词加入到词典列表不断进行模型训练,最后分词结果和新词识别结果都得到了提升。Huang等[7]设定少量种子新词,并依据词性构建三元组模型循环扩充新词候选集,通过一系列统计量特征将新词识别结果量化。该方法不需要复杂的语言规则,只在词性标注的基础上就可以得到很好的新词识别效果。邢恩军等[8]提出一种基于上下文词频词汇量的统计指标,该指标通过将信息熵公式中的邻接字符串在语料集中出现的次数改成邻接字符串集合的大小,克服了左右信息熵在识别新词时特征不够明显的缺点。该方法与领域无关,且对新词的长度没有限制,仅采用一个统计指标就能取得较好的效果。统计方法有很强的领域适应能力和可扩展性,但具有需要大规模语料库和数据稀疏问题严重等问题。

规则和统计相融合的方法是目前研究的主流方法。Nuo等[9]提出一种将统计度量值和上下文规则结合的新词识别方法,先利用互信息等统计量将结合度高的单字组合形成候选新词,并利用基于上下文的扩展机制,确定新词的左右边界。通过该方法构建的新词词典有效地提高了分词效果,但只局限于识别被切分成单字碎片的新词。杜丽萍等[10]提出一种非监督的新词识别方法,利用点互信息 (Pointwise Mutual Information, PMI) 的改进算法--PMIk算法与少量基本的过滤规则相结合,从大规模百度贴吧语料中自动识别出网络新词,实验结果显示该方法比改进前的算法取得了更好的新词识别效果。Li等[11]使用基于支持向量机 (Support Vector Machine, SVM) 和词特征的方法进行新词识别,并在程序中引入了少量的规则过滤,有效地提高了新词识别的效果。Attia等[12]通过使用有限状态的词法猜测工具和基于机器学习的预标注工具体系来进行未登录词的抽取,实验证实方法的有效性并已将抽取的未登录词集合作为公开的开放资源。规则和统计相融合的方法可以相互取长补短,在一定程度上缓解单独使用统计方法造成的数据稀疏问题,同时解决单独使用规则方法造成的领域适应能力差等问题。

综上所述,针对传统方法所存在的问题,本文提出了一种基于规则与统计相融合的方法。该方法针对微博新词的构词规则极其复杂和自由度大的特点,构建人工启发式规则库,引入新的统计量特征改进传统的C/NC-value方法,并将抽取得到的新词集作为训练数据,利用条件随机场模型对训练语料进行新词的标注、建模和识别,最终有效地提高了新词边界的识别准确率和低频新词的识别精度。最后,将抽取的微博新词集合加入微博分词的用户字典,分词实验结果显示可有效提高微博文本的分词和词性标注精度。本文方法具有不需要大规模语料库作为学习数据进行训练、计算量小、精准度高等优点。

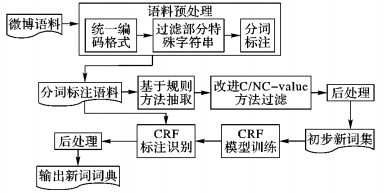

1 流程描述本文方法流程如图 1所示,主要包括数据预处理、规则方法抽取、改进C/NC-value方法过滤、后处理和CRF模型训练与识别新词等5个部分。

|

图 1 系统流程 Figure 1 System flow |

第1步 数据预处理。主要包括:

1) 将文本字符统一转换为UTF-8编码。

2) 过滤微博文本中某些固定格式的特殊字符串。主要包括三类:一是网页地址URL,如“http://t.cn/zOixljh”“http://t.cn/RPKM61K”等;二是邮箱地址,如“cszyzxj@163.com”“mcq0544@qq.com”等;三是微博文本特有的一种字符串格式,由符号“@”后面紧跟一个用户名称和一个空格符号组成,表示提及该用户,如“@且听风吟_5734”和“@李开复”等。

3) 通过实验室独自研发的基于感知机的微博文本分词工具对微博语料进行分词和词性标注处理。如:“石家庄/ns火车站/n成功/a地/u接受/v了/u冰/n桶/q挑战/v,/wd接/v下来/v,/wd他/rr有/v权/n挑战/v三/m个/q火车站/n。/wj”。

第2步 使用新词的构词规则库对已经经过预处理的微博语料进行新词抽取,得到新词候选串。

第3步 利用统计量信息重构NC-value目标函数,对新词候选串进行筛选。

第4步 有针对性地制定规则对一些明显错误的识别结果进行过滤,得到初步新词集。部分规则实例如下:

1) 数字加量词的组合构成的常规字符串,如:“2015年”“12岁”“3个”等;

2) 符号组合形成的非表情字符串,如“!!!”“???”“ < < < ”等;

3) 非语气词与语气词组合形成的字符串,如“是吗”“在呢”“行啊”等。

第5步 将抽取的新词集作为训练数据,利用条件随机场模型对训练语料进行新词的标注、建模和识别,最后经后处理得到最终的新词集。

2 微博新词构词特点及规则归纳 2.1 微博新词构词特点微博新词具有涉及领域广、构词模式相对自由等特点,因此,从多种角度对新词进行分析和归纳,总结新词产生的途径和构词规律可有效提高新词的抽取精度。

2.2 微博新词构词规则如表 1所示,微博新词的构词方式复杂多样,有谐音词、方言词、旧词新用、缩略词、英语音译词、符号新词和新造词等。从词性构成的角度分析,新词的组成集中在名词、动词、形容词和区别词之间,同时介词与副词也具备了一定的构词能力,能够与其他词语组合形成新词。从音节的角度分析,新词构成的总趋势是向多音节发展,以双音节、三音节和四音节为主; 同时,微博新词还充分运用了英语、汉语、数字、符号等互相组合的方式,结构新颖自由。本文主要从三个角度进行总结:

| 表 1 微博新词构词特点 Table 1 Micro-blog new word formation characteristics |

1) 词性构成,包括动词、名词、形容词、区别词相互组合的常规规则以及介词、副词与名词、动词组合的特殊规则。规则实例见表 2的词性。

| 表 2 新词规则 Table 2 Rules of new words |

2) 成词字符类别,主要针对英文、数字和汉字的组合。规则实例见表 2的字符类别。

3) 符号表意规则,微博文本中存在大量的表情符号,本文将其总结为两类:一是静态表情符号,是由一些基本的符号组合形成的,形式上类似于日语中的颜文字;二是动态表情符号,有固定的构成格式:“[字符串]”。规则实例见表 2的符号。

3 新词发现 3.1 C/NC-value算法该算法由Frantzi等[13]提出,是一种领域独立的复合词抽取算法。主要包括两部分:

一是基于统计量信息计算C-value值,统计信息包括候选词的词频和词长以及包含当前候选词的更长候选词的词频和词数,如式 (1) 所示:

| $ \begin{array}{l} C-value(w) = \left\{ \begin{array}{l} {\rm{lb}}\;\left| w \right|f(w), \\ \;\;\;\;\;\;\;\;w未被嵌套在其他候选词中\\ {\rm{lb}}\;\left| w \right|\left( {f(w)-\frac{1}{{p({T_w})}}\sum\limits_{a \in {T_w}} {f(a)} } \right)\\ \;\;\;\;\;\;\;\;\;其他 \end{array} \right.\\ \end{array} $ | (1) |

其中:w=w1w2…wn是候选词;|w|表示w的长度;f(w) 表示w的词频;Tw表示包含w的候选词集;a表示Tw中任意的包含w的候选词;f(a) 表示a的词频;p(Tw) 表示包含w的候选词总数。

二是结合上下文信息计算NC-value值,上下文信息是指出现在候选词前后的上下文相关词的统计信息,包括上下文相关词出现在候选词前后的次数和权重,权重通过与上下文相关词同时出现的候选词的数量除以总的候选词的数量计算得到,如式 (2) 所示:

| $ \begin{array}{l} NC = value(w) = \alpha * C-value(w) + \beta * \sum\limits_{b \in {C_w}} {{f_w}(b)} * \frac{{t(b)}}{n};\\ \alpha + \beta = 1 \end{array} $ | (2) |

其中:Cw表示出现在候选词w前后的上下文相关词集合,b表示Cw中任意的出现在候选词w前后的上下文相关词,fw(b) 表示b在候选词w的上下文中出现的次数,t(b) 表示与b同时出现的候选词数量,n表示候选词的总个数。α和β为取值0~1的参数。

3.2 改进的C/NC-value算法既有C/NC-value方法抽取微博新词的缺点主要包括:1) 部分识别结果存在词语粘连现象,新词的边界识别不正确;2) 低频新词无法正确识别。

针对上述问题,本文引入邻接熵和互信息两种统计量,重构NC-value目标函数,以提高新词边界的识别准确率和低频新词的识别精度。使用邻接熵改善分词精度的方法由Huang等[14]提出,能有效解决未登录词的左右边界问题。该方法利用信息熵来衡量候选新词的左邻字符和右邻字符的不确定性,候选新词的邻接熵越大,说明邻接字符的不确定性越大,成为新词边界的可能性就越大。具体定义如式 (3)~(5) 所示:

| $ HL(w)=-\sum\limits_{x}{p(x\left| w \right.)\ \text{lb}\ p(x\left| w \right.)} $ | (3) |

| $ HR(w)=-\sum\limits_{y}{p(y\left| w \right.)}\ \text{lb}\ p(y\left| w \right.) $ | (4) |

| $ BE(w) = \min \{ HL(w), HR(w)\} $ | (5) |

互信息是一个用来衡量候选词子串之间的结合程度的统计量。本文将互信息加入到目标函数中,通过计算候选低频新词及其子串间的结合程度来提高微博低频新词的识别精度。根据文献[15]对互信息的定义,本文改进如式 (6) 所示:

| $ MI(w)=\underset{1\le i\le n}{\mathop{\text{min}}}\,\text{lb}\frac{p(w)}{p({{w}_{1}}\ldots {{w}_{i}})p({{w}_{i+1}}\ldots {{w}_{n}})} $ | (6) |

其中:p(w) 表示w出现的频率;p(w1w2…wi) 表示w的子串w1w2…wi出现的频率;p(wi+1wi+2…wn) 表示w的子串wi+1wi+2…wn出现的频率。改进后的NC-value值计算如式 (7) 所示:

| $ \begin{array}{l} NC-value(w) = \alpha *C-value(w) + \beta * BE(w) + \\ \gamma * MI(w);\alpha + \beta + \gamma = {\rm{1}} \end{array} $ | (7) |

其中:C-value(w) 是根据式 (1) 得到的C-value值;BE(w) 是根据式 (3)、(4)、(5) 得到的邻接熵值;MI(w) 是根据式 (6) 得到的互信息值;α、β和γ为参数,取值范围为[0, 1]。

3.3 条件随机场 (CRF)CRF模型由Lafferty等[16]提出,是一种典型的判别式模型。它在观测序列的基础上对目标序列进行建模,重点解决序列化标注的问题。条件随机场的定义如式 (8) 所示:

| $ \begin{array}{l} P(y{\rm{|x}}) = \frac{1}{{Z(X)}}\exp (\sum\limits_i {\sum\limits_k {{\lambda _k}{t_k}({y_{i-1}}, {y_i}, x, i)} + } \\ \;\;\;\;\;\;\;\;\sum\limits_i {\sum\limits_k {{u_k}{s_k}({y_i}, x, i)} } ) \end{array} $ | (8) |

其中:tk(yi-1, yi, x, i) 为转移函数,表示观察序列和标记序列在i-1和i时刻的特征;sk(yi, x, i) 为状态函数,表示观察序列和标记序列在i时刻的特征;Z(X) 为归一化因子;λ和u为训练所得参数。

CRF模型将新词发现看作一个序列标注过程,利用单字在新词中的位置信息来标记新词。本文采用四词位标注集,如表 3所示。

| 表 3 四词位标注集 Table 3 Four word mark set |

特征模板的设置主要利用上下文的信息,从训练语料中获得字特征,采用当前字和其前后两个字及其词性信息作为特征。特征模板具体描述如表 4所示。

| 表 4 特征模板 Table 4 Feature template |

将得到的初步新词的特征量化,作为训练特征,利用CRF模型训练出新词抽取模板,利用该模型对预处理的微博语料进行标注抽取,并对抽取结果进行后处理修正,识别出更多的新词。最后,将CRF模型识别出的新词与初步得到的新词集合并整理,即为最终识别出的新词集。

4 实验与分析 4.1 实验语料由于目前尚无公开的微博新词标准数据集,新词发现实验使用的语料数据来源于爬萌 (http://www.cnpameng.com/),从2014年6月1日的新浪微博数据 (约10万条) 中随机抽取出2万条,通过实验室独自研发的基于感知机的微博文本分词工具进行分词和词性标注处理,并对预处理后的语料进行新词的规则方法抽取和C/NC-value的改进算法识别,得到初步的新词集。

从语料中抽取新词并进行人工校对,共抽取新词800个,作为标准新词集。通常来讲,新词是指未被收录到词典中的词语[17]。在本研究任务中,新词满足以下条件:1) 符合本文提出的构词规则;2) 不在用户字典中;3) 分词工具切分出现错误;4) 在网络上被广泛使用。

4.2 评价方法通过准确率P、召回率R和F值对新词发现实验的结果进行评价。计算公式如下所示:

| $ P = \frac{识别到的正确的新词数}{识别到的词语总数} \times 100\% $ | (9) |

| $ R = \frac{识别到的正确的新词数}{语料中正确的新词总数} \times 100\% $ | (10) |

| $ F = \frac{{2 \times P \times R}}{{P + R}} \times 100\% $ | (11) |

在计算NC-value值获取初步新词集的过程中,需要对候选新词w的C-value值、邻接熵和互信息的权重,即参数α、β和γ进行设定。先对三种统计量单独使用时的情况进行实验,结果见表 5的三种统计量单独使用部分。实验结果显示,单独使用三种统计量得到的准确率P、召回率R和F值均较低,新词识别效果较差。

| 表 5 三种统计量单独使用时和调参的实验结果 Table 5 Experimental results of three kinds of statistics when used alone and in parameter tuning |

接下来,对三个参数的取值进行调整。依据贪心算法的思想,在满足α+β+γ=1的基础上,先将α置于0~1取值,β则在0~1-α取值,相应的γ值为1-α-β,以0.1为步长对三个参数动态调整,结果显示当α=0.4时得到了最大的F值;再将α的取值范围设为0.35~0.45,β的取值范围仍为0~1-α,γ值仍为1-α-β,以0.01为步长再次对三个参数动态调整,记录下得到最大的F值时的参数取值。再按照相同的方法,依次对β和γ做同样的实验。三种情况下得到的最大的F值及相应的参数取值如表 5的调参实验结果部分所示。结果显示,当α=0.34,β=0.35,γ=0.31时得到了最大的F值,即达到了最好的新词识别效果。

对候选新词的NC-value值设定阈值,如果阈值设定过高,会过滤掉很多有意义的新词;反之,如果阈值设定过低,又会使新词结果中出现很多垃圾串。多次实验结果显示,阈值设定为0.42时效果最佳。本文中,当NC-value值大于0.42时,判定该候选词为初步的新词。

4.4 新词发现实验结果及分析将本文方法与传统的新词发现方法进行对比,选取文献[10-12]分别提出的方法作为三个基线系统,同时将三个基线系统方法、单独使用规则的方法、单独使用改进的C/NC-value方法、规则与传统的C/NC-value结合的方法、规则与改进的C/NC-value结合的方法、结合支持向量机 (SVM) 分类器 (http://www.csie.ntu.edu.tw/~cjlin/libsvm/) 的方法与本文提出的结合条件随机场 (CRF) 模型 (https://sourceforge.net/projects/crfpp/) 的方法进行新词识别的对比实验,实验结果见表 6。

| 表 6 新词发现结果 Table 6 New word finding results |

实验结果分析:

1) 基线方法1[10]提出了PMI的改进算法,并使用部分过滤规则;基线方法2[11]使用基于SVM和词特征的方法进行新词识别,并在程序中引入了少量的规则过滤;基线方法3[12]通过使用有限状态的词法猜测工具和基于机器学习的预标注工具体系来进行未登录词的抽取。三个基线系统都得到较高的召回率,但新词识别的准确率较低。一些新词与其他词语被错误地划分成一个字串,如在新词识别结果中出现“太给力”“惊呆了”“的恶搞”等词。而本文方法更关注微博新词的语言学特点,进行归纳总结和制定规则,识别结果中均是符合构词规则的词语。如在预处理后的语料中存在“太/d给/p力/n”“惊/v呆/v了/y”“的/u恶/a搞/v”的切分,通过使用规则“介词+名词”可以将“给力”正确抽取,使用规则“动词+动词”可以将“惊呆”正确抽取, 使用规则“形容词+动词”可以将“恶搞”正确抽取,因此,构词规则的引入可以很好地提升新词识别的准确率。

2) 通过对实验4和实验5的结果分析可以发现:单独使用规则的方法,由于缺少对候选串的过滤机制,识别结果中存在大量的非新词词语,如“拼尽”(拼/v尽/v)、“学英语”(学/v英语/n)、“媒体人”(媒体/n人/n) 等;单独使用改进的C/NC-value统计方法,由于缺少规则方法抽取候选串的过程,使新词识别结果中出现大量的垃圾串,如“真好看”“太稀饭”“小心啊”等,因此,两种方法得到的准确率和召回率均相对较低。本文将规则与统计的方法进行融合,减少了垃圾串的产生,同时又能过滤掉大部分的非新词词语,使新词识别的准确率和召回率都得到很大的提升。

3) 实验6是在规则抽取的基础上利用传统的NC-value目标函数过滤得到新词。规则的引入使其得到相对较高的准确率,不符合本文构词规则的词语不会出现在候选新词列表中;但是新词识别的召回率较低,说明目标函数考虑的统计信息对新词的识别效果不佳。实验7提出的改进的C/NC-value方法,通过引入邻接熵和互信息有效提高了新词发现精度。邻接熵的引入可以很好地解决新词边界问题,如通过规则方法抽取后,“欢迎点赞”(欢迎/v点/v赞/v)、“点赞”(点/v赞/v)、“点赞支持”(点/v赞/v支持/v) 都出现在候选新词列表中,通过改进的NC-value方法可以准确地确定新词的左右边界,将“点赞”保留,其余两种情况被过滤掉,因此进一步提高了新词识别的准确率; 同时,互信息反映了候选词子串之间的结合程度,当低频新词的子串出现的频率也较低,子串之间的结合程度紧密时,其互信息值仍然较高,从而达到精确识别该类新词的效果。

4) 实验8和实验9是在得到的初步新词集的基础上分别结合SVM分类器和CRF模型进行新词识别。实验依据初步新词集对分词后的语料进行标注得到训练集,经分词工具粗切分的语料作为测试集。其中,在实验8中,通过选取词频、邻接熵和互信息三个特征组成特征向量,相关参数设定参照文献[11]。在实验9中,通过将得到的初步新词的特征量化作为训练特征,并利用CRF模型构建新词抽取模板,对测试语料进行新词的标注识别。实验结果显示两种方法均能进一步提高对低频新词的识别效果。其中,基于序列标注的CRF模型更有效地利用了新词的上下文信息,对新词的识别效果达到最佳。通过本文方法识别到的低频新词包括“细思恐极”“喜大普奔”“累觉不爱”“hold住”等。

4.5 微博分词测试为了验证本文方法的有效性,将采用不同新词识别方法得到的新词集合作为用户词典加入到实验室独自研发的微博文本分词工具中,进行分词和词性标注实验,实验结果如表 7所示。本实验使用2016年NLPCC (http://tcci.ccf.org.cn/conference/2016/pages/page05_evadata.html) 微博分词评测任务提供的2万条训练集作为训练语料,8000条测试集作为测试语料, 同时参照基于宾州大学汉语树库的分词标准[18]对测试语料进行分词和人工校对,参照中国科学院计算技术研究所汉语词性标记集 (http://ictclas.nlpir.org/nlpir/html/readme.htm) 进行手工词性标注。

| 表 7 分词和词性标注结果 Table 7 Results of word segmentation and part of speech tagging |

实验评价方法仍然使用准确率P、召回率R和F值,其中准确率P和召回率R定义如下:

| $ P = \frac{正确分词(标注)的数量}{总的切分(标注)数量} \times 100\% $ | (12) |

| $ R = \frac{正确分词(标注)的数量}{总的切分(标注)数量} \times 100\% $ | (13) |

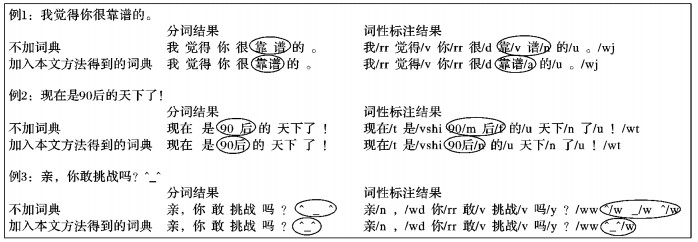

实验结果如表 7所示。从实验结果可看出:1) 通过与不加用户词典得到的结果对比,加入不同的新词识别方法得到的新词词典,分词和词性标注结果的F值都得到了提升,说明新词词典的加入可以提高分词系统的分词标注精度。2) 使用新词用户词典,可以纠正不同类型新词出现的分词和词性标注错误,尤其对符合本文提出的构词规则的新词效果显著。如不同词性组合构成的新词、数字与汉字结合构成的新词和表情符号等。三种不同类别的新词被切分的情况如图 2所示。3) 相比其他方法,使用本文方法构建的新词词典在分词标注结果中得到了最大的F值,说明了本文方法的有效性。

|

图 2 分词和词性标注实例 Figure 2 Examples of word segmentation and part of speech tagging |

本文结合微博新词的构词规则极其复杂和自由度大的特点,针对传统的C/NC-value方法抽取的结果词语粘连现象严重,新词边界的识别准确率不高,以及部分微博新词由于出现频率低而无法正确识别的问题,提出了一种融合规则和统计的微博新词发现方法。通过对微博文本新词的构词规则进行归纳总结,建立新词构词规则库;通过改进传统的C/NC-value方法,重构NC-value目标函数,并结合条件随机场模型 (CRF) 训练和识别新词,提高了新词边界的识别准确率和低频新词的识别精度。最后,将新词识别结果加入用户字典,分词实验结果显示提高了微博文本分词和词性标注的精度。

本研究主要特点如下:

1) 通过对大量微博文本新词的归纳分析,对微博新词的构词规则作了系统的分类和总结,在人工启发式构词规则中融合了词性、构词字符类别和符号表意等特征。

2) 针对微博新词发现,改进了C/NC-value算法。导入词频、邻接熵和互信息,重构NC-value的目标函数,有效地解决了该算法抽取结果所包含的词语粘连现象相对严重、新词边界识别准确率不高以及低频新词无法正确识别的问题。

3) 使用条件随机场模型 (CRF) 进一步提高了对低频新词的识别精度,使识别效果得到了很大的提升。

4) 规则与统计方法相融合,相互取长补短,该方法具有不需要大规模语料库、计算量小、精准度高等特点。

未来工作中,将进一步分析新词识别结果的错误类型,面向大规模开放微博语料,总结和归纳微博新词的构词规则,以及改进统计算法提高新词识别精度。

| [1] | SPROAT R, EMERSON T. The first international Chinese word segmentation bakeoff[C]//Proceedings of the 2nd SIGHAN Workshop on Chinese Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2003, 17: 133-143. |

| [2] | 邹纲, 刘洋, 刘群, 等. 面向Internet的中文新词语检测[J]. 中文信息学报, 2004, 18 (6) : 1-9. ( ZOU G, LIU Y, LIU Q, et al. Internet-oriented Chinese new words detection[J]. Journal of Chinese Information Processing, 2004, 18 (6) : 1-9. ) |

| [3] | MA W Y, CHEN K J. A bottom-up merging algorithm for Chinese unknown word extraction[C]//Proceedings of the 2nd SIGHAN Workshop on Chinese Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2003, 17: 31-38. |

| [4] | SASANO R, KUROHASHI S, OKUMURA M. A simple approach to unknown word processing in Japanese morphological analysis[J]. Nuclear Physics A, 2014, 21 (6) : 1183-1205. |

| [5] | WANG A, KAN M Y. Mining informal language from Chinese microtext: joint word recognition and segmentation[EB/OL].[2016-01-06]. http://www.aclweb.org/old_anthology/P/P13/P13-1072.pdf. |

| [6] | SUN X, WANG H, LI W. Fast online training with frequency-adaptive learning rates for Chinese word segmentation and new word detection[C]//Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics: Long Papers. Stroudsburg, PA: Association for Computational Linguistics, 2012, 1: 253-262. |

| [7] | HUANG M, YE B, WANG Y, et al. New word detection for sentiment analysis[EB/OL].[2016-01-03]. http://mirror.aclweb.org/acl2014/P14-1/pdf/P14-1050.pdf. |

| [8] | 邢恩军, 赵富强. 基于上下文词频词汇量指标的新词发现方法[J]. 计算机应用与软件, 2016, 33 (6) : 64-67. ( XING E J, ZHAO F Q. A novel approach for Chinese new word identification based on contextual word frequency-contextual word count[J]. Computer Applications and Software, 2016, 33 (6) : 64-67. ) |

| [9] | NUO M, LIU H, LONG C, et al. Tibetan unknown word identification from news corpora for supporting lexicon-based Tibetan word segmentation[EB/OL].[2016-01-03]. http://rsr.csdb.cn/serverfiles/csdb/paper/upload/20151021/201510210132497839.pdf. |

| [10] | 杜丽萍, 李晓戈, 于根, 等. 基于互信息改进算法的新词发现对中文分词系统改进[J]. 北京大学学报 (自然科学版), 2016, 52 (1) : 35-40. ( DU L P, LI X G, YU G, et al. New word detection based on an improved PMI algorithm for enhancing segmentation system[J]. Acta Scientiarum Naturalium Universitatis Pekinensis, 2016, 52 (1) : 35-40. ) |

| [11] | LI C, XU Y. Based on support vector and word features new word discovery research[M]. Berlin: Springer, 2013 : 287 -294. |

| [12] | ATTIA M, SAMIH Y, SHAALAN K, et al. The floating Arabic dictionary: an automatic method for updating a lexical database through the detection and lemmatization of unknown words[EB/OL].[2016-01-03]. http://www.aclweb.org/anthology/C12-1006. |

| [13] | FRANTZI K, ANANIADOU S, MIMA H. Automatic recognition of multi-word terms: the C-value/NC-value method[J]. International Journal on Digital Libraries, 2000, 3 (2) : 115-130. doi: 10.1007/s007999900023 |

| [14] | HUANG J H, POWERS D. Chinese word segmentation based on contextual entropy[EB/OL].[2016-01-06]. http://www.aclweb.org/website/old_anthology/Y/Y03/Y03-1017.pdf. |

| [15] | YE Y, WU Q, LI Y, et al. Unknown Chinese word extraction based on variety of overlapping strings[J]. Information Processing and Management, 2013, 49 (2) : 497-512. doi: 10.1016/j.ipm.2012.09.004 |

| [16] | LAFFERTY J D, MCCALLUM A, PEREIRA F C N. Conditional random fields: probabilistic models for segmenting and labeling sequence data[C]//Proceedings of the 18th International Conference on Machine Learning. San Francisco, CA: Morgan Kaufmann, 2001: 282-289. |

| [17] | LI H, HUANG C, GAO J, et al. The use of SVM for Chinese new word identification[C]//Proceedings of the 1st International Joint Conference on Natural Language Processing. Berlin: Springer, 2004: 723-732. |

| [18] | XIA F. The segmentation guidelines for the PENN Chinese treebank (3.0)[EB/OL].[2016-01-07]. http://repository.upenn.edu/cgi/viewcontent.cgi?article=1038&context=ircs_reports. |