电信客户流失预测所对应的数据集是典型的不均衡数据集, 因为在所有的电信客户中有流失发生的客户毕竟是少数, 大多数客户还是稳定存在的, 而流失客户才是企业关注的焦点。传统的机器学习算法以整体预测精度为训练目标, 这样就导致多数类预测精度高, 而少数类预测精度相对较低[1]。因此, 数据的不均衡性成为影响客户流失预测精度的主要障碍, 研究如何解决客户流失预测中面临的数据不均衡问题就变得越来越重要。

针对客户流失预测中的数据不均衡问题, 国内外学者主要进行了以下两方面的研究:

1) 修正偏斜的数据分布, 采用重采样或者构建新样本的方法实现数据均衡化处理。针对重采样过程中有用样本信息丢失的问题, 文献[2]提出了两种欠采样的改进算法EasyEnsemble和BalanceCascade, 结果表明改进的欠采样方法能够有效地均衡数据分布, 同时提高少数类样本的分类准确率; 文献[3]采用基于聚类的欠采样方法来提取多数类的聚类边界, 并结合支持向量机 (Support Vector Machine, SVM) 分类算法构建流失预测模型, 结果表明该方法能够保留有用的多数类样本信息, 均衡数据分布并扩大决策边界, 进而提高SVM算法对少数类样本的识别能力; 针对样本合成过程中所带来的数据噪声干扰以及模型过拟合问题, 文献[4]提出一种基于错分的混合采样算法, 有效地解决了合成少数类过采样技术 (Synthetic Minority Over-sampling Technique, SMOTE) 中存在的数据噪声干扰问题, 同时克服了盲目采样和不合理采样所带来的样本空间重叠问题; 文献[5]提出一种基于单边选择链和样本分布密度融合的不均衡数据处理方法, 有效地解决了SMOTE采样算法所带来的过拟合问题, 同时提升了分类模型对少数类样本的分类性能。

2) 改进分类算法, 采用组合分类方法或代价敏感分析。文献[6]将基于粒子群优化的欠采样方法与组合分类技术相结合来构建流失预测模型, 结果表明该组合预测模型对流失客户的识别能力明显优于单一的预测技术; 文献[7]采用了基于分割聚类分层抽样逻辑回归预测模型, 该模型从失衡数据集的重采样和预测算法的改进两个方面同时入手, 改善了数据失衡对预测所造成的影响; 文献[8]将客户生命价值作为随机森林中节点划分的准则, 不仅消除了不均衡数据对预测结果的影响, 而且提高了对有流失倾向的高价值客户预测的准确率; 文献[9]将代价敏感学习理论与随机森林分类算法相融合, 采用加权随机森林分类算法来解决电信客户流失预测中的不均衡数据分类问题; 针对客户流失数据集的非均衡问题和错分代价的差异性问题, 文献[10]将代价敏感学习应用于加权支持向量机, 结果表明该方法在精确度、命中率、覆盖率和提升度方面均有所改善。

虽然上述研究对客户流失预测具有一定的贡献, 但是研究的焦点一直围绕如何消除不均衡数据分布对分类预测结果的影响, 而文献[11-12]表明偏斜的数据分布并不是影响传统分类算法对稀有类识别的唯一因素, 特征和类标签之间的关联性同样对不均衡数据的分类结果有重要影响, 然而许多研究往往忽略了特征对类标签的识别能力。文献[13]表明传统的特征选择仅仅实现了特征降维, 并不能提高特征对类标签的识别能力。文献[14-16]采用了一种差异度表示方法来处理不均衡数据的分类问题, 该方法利用样本之间的差异性来捕获数据集的结构特性和统计特性, 并借助样本间的差异度来构建新的特征空间, 即差异度空间, 结果表明在新的特征空间内, 样本的类标签更容易得到识别。故差异度表示方法为电信客户流失预测中的不均衡数据分类问题提供了一种新的解决思路。

不受类别分布的影响是差异度表示方法的一大优势, 可弥补已有不均衡数据分类方法的不足, 然而, 若直接将该方法应用于实际的电信客户流失预测, 将会出现以下两大弊端:1) 电信客户数据集中存在大量冗余或无关的特征属性, 可能会对原型选择形成干扰, 进而影响差异度转化的有效性; 2) 基于随机选择的原型选择方法并不能确保所选择的原型集是最优的。

为解决上述问题, 本文提出一种基于差异度的改进型不均衡数据分类 (Improved Dissimilarity-Based imbalanced data Classification, IDBC) 方法来预测电信客户的流失趋势。针对冗余属性对差异度表示方法的影响, 本文在构建分类模型之前, 采用基于关联的特征选择 (Correlation-based Feature Selection, CFS) 算法对原始数据集进行特征选择; 针对随机选择方法在原型选择过程中所带来的不确定性和复杂度高的弊端, 本文采用改进型的样本子集优化 (Improved Sample Subset Optimization, ISSO) 技术来选择原型集。

1 差异度表示方法 1.1 差异度表示传统的分类技术是根据特征与类标签之间的关联性来决定对象的类别归属。在原始特征空间内, 不同对象在同一特征空间内可能会有相同的类标签, 同样, 当特征空间的结构发生变化时, 隶属不同类别的对象可能会由相同的特征向量所表示。因此, 仅利用特征与类标签之间的关联性来判断对象的类别归属是远远不够的。在差异度表示方法中, 假定归属同一类别的对象之间具有很强的相似性; 反之, 具有极大的差异性, 以能够显著刻画类标签的代表性对象实例为参考目标, 利用其余对象与代表性对象之间的差异度来构建新的特征空间, 即差异度空间。差异度表示方法借助对象之间的差异性来确定对象的类标签, 以差异度代替特征属性, 从而克服了类重叠的弊端。

差异度表示的基本思想:

假设训练集T中包含n个对象实例, 即T={x1, x2, …, xn}, 从训练集中选取r个对象实例构成原型集R, 即R={ p1, p2, …, pr}, 要求该r个对象实例能够显著刻画所有类标签的特征。利用映射关系D(T, R) 将训练集数据映射到差异度空间,形成差异度训练集

| $ \begin{array}{l} \boldsymbol{\hat x} = D(\boldsymbol{x}, R) = \\ \;\;\;\;\;\;\;{[dis(\boldsymbol{x}, {\boldsymbol{p}_1}), dis(\boldsymbol{x}, {\boldsymbol{p}_2}), ..., dis(\boldsymbol{x}, {\boldsymbol{p}_r})]^\rm{T}} \end{array} $ | (1) |

其中:x∈T;dis(·) 表示距离函数; [·]T表示矩阵的转置。

进而利用训练集中的任意对象和原型集中所有对象之间的差异性, 确定该对象的类别归属, 证明如下:

同理, 利用映射关系D(., R) 将训练集中所有的对象实例都映射到差异度空间内, 得到差异度训练集

该差异度表示方法仅借助对象实例之间的差异性来确定对象的类别归属, 不需要考虑特征属性对类标签的影响, 而且忽略了类别分布对分类结果的影响, 从而避免了传统分类器在不均衡数据分类过程中失效。

1.2 基于样本子集优化的原型选择在差异度表示方法中, 原型集代表了一类对类标签具有显著识别能力的有用样本子集, 作为差异度转化过程中的参考数据集。随机选择是一种最简单的原型选择方法, 即从训练集中随机选取部分样本实例作为原型集; 但是随机选择方法所存在的不确定性可能会导致所获取的原型集缺乏参考价值, 从而影响差异度转化的有效性[13]2。文献[17]曾采用样本子集优化 (Sample Subset Optimization, SSO) 方法从多数类样本集中选择有用的样本实例, 所选取的样本实例代表了整个多数类样本集的统计特性。本文利用该优化思想, 以整个训练集 (既包含多数类样本, 也包含少数类样本) 为研究对象, 采用改进型的样本子集优化技术进行原型选择。

改进型的样本子集优化 (ISSO) 技术通过最小化训练数据集交叉验证过程中的期望误差来选择一个有效的训练样本子集。k折交叉验证的期望误差定义如式 (2) 所示:

| $ erro{r_{\rm{cvk}}} = \frac{1}{n}\sum\limits_{i = 1}^k {\sum\limits_{j = 1}^n {\left| {y_j^{(i)}-p(t_j^{(i)}\left| {{\theta ^{(i)}}, \boldsymbol{x}_j^{(i)}} \right.)} \right|} } $ | (2) |

其中: yj(i)表示第i次迭代后第j个样本实例的实际类标签;

在样本子集优化过程中, 采用粒子群优化 (Particle Swarm Optimization, PSO) 算法[18]选取最优的训练子集。假定训练集中含有n个样本实例, 即T={x1, x2, …, xn}, 粒子群中含有L个粒子, 即Z={m1, m2, …, mL}, 采用一个指示函数集M={Ix1, Ix2, …, Ixn}编码对应粒子。在每一维中, 若第j个样本实例xj被选中, 则指示函数Ixj=1;否则Ixj=0。在优化过程中, 由于指示函数采用二进制离散编码的方式进行表示, 但是粒子群算法通常是对连续值进行优化, 故使用sigmoid(·) 函数对式 (3) 中所求得的连续速度值进行离散化处理。粒子的速度和位置更新如式 (3)~(5) 所示:

| $ \begin{array}{*{20}{l}} {{v_{i,j}}(t + 1) = w{v_{i,j}}(t) + {c_1}{f_1}(pbes{t_{i,j}} - po{s_{i,j}}(t)) + }\\ {\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{c_2}{f_2}(gbes{t_{i,j}} - po{s_{i,j}}(t))} \end{array} $ | (3) |

| $ v{{\rm{'}}_{i,j}}(t + 1) = {\rm{sigmoid}}({v_{i,j}}(t + 1)) = \frac{1}{{1 + {{\rm{e}}^{ - {v_{i,j}}(t + 1)}}}} $ | (4) |

| $ po{s_{i, j}}(t + 1) = \left\{ {\begin{array}{*{20}{c}} {0, \;\;random() \ge v{'_{i, j}}(t + 1)}\\ {1, \;random() < v{'_{i, j}}(t + 1)\;} \end{array}} \right. $ | (5) |

其中:w、c1、c2、f1、f2分别表示不同的参数常量; pbesti, j表示局部最优解; gbesti, j表示全局最优解; random() 表示伪随机序列生成器, 用于生成所需的随机数, 并且random() 服从[0, 1]内的均匀分布; vi, j(t)、vi, j(t+1) 分别表示第t次和第t+1次迭代后第i个粒子中第j个样本实例的速度, 而v′i, j(t+1) 表示第t+1次迭代后第i个粒子中第j个样本实例速度的离散值, 即粒子的当前速度; posi, j(t+1) 表示第t+1次迭代后第i个粒子中第j个样本实例所处的位置, 与第t+1次迭代后该样本实例的离散速度有关。

每一次迭代完成后会获取一个优化的训练样本子集sg(i), 优化过程结束后得到k个优化样本子集, 即sg(1), sg(2), …, sg(k), 然后统计样本集合中每个实例在所有样本子集中出现的频率, 并对频率值进行排序, 选取排名靠前的样本构成最优的原型数据集, 用于后续训练集和原型集之间的差异度转化, 一般情况下, 原型集中样本数目设定为lb n,其中n为训练集中样本的总数目。

1.3 差异度转化利用训练集和原型集样本之间的差异性, 将训练数据集映射到差异度空间, 形成差异度训练集。假设训练集T={x1, x2, …, xn}中包含n个样本实例, 每个样本实例xi=(ai1, ai2, …, aiq, ci) 中包含q+1个属性 (q个特征属性和1个类标签); 原型集R={ p1, p2, …, pr}中包含r个有代表性的样本实例, 同样每个样本实例pi=(a′i1, a′i2, …, a′iq, c′i) 也包含q+1个属性。利用映射关系D(., R), 将训练集中的样本实例依次映射到差异度空间内得到差异度训练集, 即

1) 差异度训练集

| $ {\boldsymbol{\hat x}_i} = \{ {\hat a_{i1}}, {\hat a_{i2}}, ..., {\hat a_{iq}}, {c_i}\} $ |

2) 对于差异度训练集中的任意样本实例

| $ {\hat a_{ij}} = dis({\boldsymbol{x}_i}, {\boldsymbol{p}_j}) = {\rm{ }}{\left( {\sum\limits_{k = 1}^q {{{\left| {{a_{ik}} - a{{\rm{'}}_{jk}}} \right|}^2}} } \right)^{\frac{1}{2}}} $ | (6) |

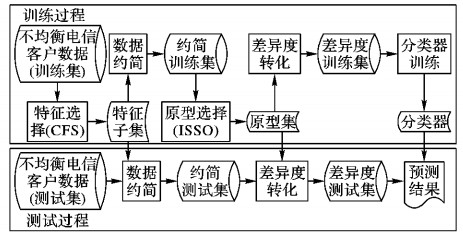

基于差异度的电信客户流失预测模型的具体方案设计如图 1所示。

|

图 1 基于差异度的电信客户流失预测模型框图 Figure 1 Block diagram of telecom customer churn prediction model based on dissimilarity |

模型构建主要包括两个阶段:训练阶段和测试阶段。在模型训练阶段, 主要进行特征选择、原型选择、差异度转化和分类器训练; 在模型测试阶段, 主要利用测试样本对训练所得的分类器的有效性进行检验。具体过程如下:

1) 模型训练。

a) 特征选择。利用基于关联的特征选择 (CFS) 算法对电信客户数据集中的特征空间进行降维, 剔除冗余或无关的特征属性, 保证原型选择的有效进行。

b) 原型选择。采用改进型的样本子集优化技术 (ISSO) 从训练数据集中选取有代表性的样本子集, 作为差异度转化中的参考集。

c) 差异度转化。计算训练数据集与原型集之间的差异度, 并利用训练样本实例与原型集之间的差异度来重新定义训练样本实例的描述方式, 取代已有的基于特征属性的样本实例描述方法。

d) 分类器训练。由于差异度表示方法与类别分布无关, 故在类别分布不均衡的数据分类问题中失效的分类算法仍可运用于电信客户流失预测的分类建模。本文采用的分类算法有朴素贝叶斯 (Native Bayes, NB)、逻辑回归 (Logistic Regression, LR)、k近邻 (k-Nearnest Neighbors, kNN)、决策树 (J48) 和随机森林 (Random Forest, RF)。

2) 模型测试。

a) 数据约简。利用模型训练过程中所得的特征子集, 对测试数据集进行属性约简。

b) 差异度转化。利用模型训练过程中所得的原型集, 将约简后的测试数据集映射到差异度空间, 形成差异度测试集。

c) 分类器评估与应用。利用差异度测试集对训练所得的分类器进行测试, 获取分类评价指标, 预测流失结果。

2.2 模型评价标准受试者工作特征曲线下的面积 (Area Under ROC Curve, AUC) 表示受试者工作特征曲线 (Receiver Operating Characteristic Curve, ROC) 与坐标轴所围的面积, 该曲线的横坐标代表假正率 (False Positive Rate, FPR), 纵坐标代表真正率 (True Positive Rate, TPR)。通常情况下, AUC是一种用来评估不均衡数据分类预测性能的重要指标。理想情况下, 要求真正率尽可能高, 假正率尽可能低。因此, AUC值越大, 代表分类模型的分类性能越优。TPR、FPR的定义如式 (7)、(8) 所示:

| $ TPR{\rm{ = }}\frac{预测正确的流失客户的数目}{实际流失客户的数目} $ | (7) |

| $ FPR{\rm{ = }}\frac{预测错误的非流失客户的数目}{实际非流失客户的总数目} $ | (8) |

本文选取UCI机器学习数据库中的电信客户流失数据集 (Churn_data) 和另外6个普通的不均衡数据集 (abalone9-18、ecoliIM、ecoliIMU、ecoliOM、yeastCYT-POX、glassNM) 对所提出的基于差异度的改进型不均衡数据分类算法的有效性进行验证。Churn_data数据集的详细信息如表 1~2所示, 另外6个类别分布不均衡的UCI数据集的数据描述如表 3所示。

| 表 1 UCI电信客户数据集 (Churn_data) 的客户属性描述 Table 1 Description of customer properties for UCI telecom customer dataset (Churn_data) |

| 表 2 Churn_data电信客户数据集的数据描述 Table 2 Data description of Churn_data telecom customer dataset |

| 表 3 UCI中其他六个不均衡数据集的数据描述 Table 3 Data description of other six imbalanced datasets from UCI |

为评估本文算法在解决不均衡数据分类问题时的有效性, 在Eclipse开发环境下, 利用数据挖掘工具Weka进行了相应的实验, 并对实验结果进行了详细的分析。实验分为两个部分。

实验1 基于UCI电信客户数据集, 借助朴素贝叶斯 (NB)、逻辑回归 (LR)、k近邻 (kNN)、决策树 (J48) 和随机森林 (RF) 五种分类算法, 分别运用已有的不均衡数据处理方法, 例如随机过采样 (Random Over-Sampling, ROS)、随机欠采样 (Random Under-Sampling, RUS)、合成少数类的过采样 (SMOTE)、提升 (Boosting)、装袋 (Bagging)、代价敏感分析算法 (MetaCost) 和原差异度分类 (Dissimilarity-Based Classification, DBC) 方法、改进型的差异度分类 (IDBC) 方法,以及在特征选择基础上实现的改进型差异度分类 (Improved Classification based on Feature Selection and Dissimilarity, FS-IDBC) 方法对该数据集进行训练和测试, 比较分类评价指标AUC, 实验结果如表 4所示。

| 表 4 基于Churn_data数据集的不均衡数据处理方法的分类评价指标 (AUC) Table 4 Classification evaluation (AUC) of imbalanced data processing methods on Churn_data dataset |

通过分析表 4的实验数据, 可以分析得出以下结论:

1) 在不同的分类算法下, 基于差异度的不均衡数据处理 (DBC) 方法的分类评价指标AUC值均高于已有的不均衡数据处理方法的AUC值。说明差异度表示是一种有效的不均衡数据处理方法, 能够避免传统分类算法在不均衡数据分类过程中失效。

2) 通过分析不同的两种原型选择方法的实验结果, 并在同一分类算法下以已有不平衡处理方法中最优方法所获取的分类评估指标AUC值为参考对象,依次计算IDBC方法、DBC方法相对于最优方法在识别率方面的提升度,同时进一步综合上述五种分类算法下识别率的提升度,以识别率的平均提升度为衡量标准,计算结果表明:当采用基于随机选择的原型选择 (Prototype Selection based on Random Selection, RS-PS) 方法进行原型选择时, DBC方法对流失客户的识别率要比已有的不平衡处理方法中最优算法的识别率平均提高了大约8.3%;然而, 当采用基于改进型的样本子集优化的原型选择 (Prototype Selection based on Improved Sample Subset Optimization, ISSO-PS) 方法进行原型选择时, IDBC方法对流失客户的识别率平均提高了大约11.3%。比较结果表明基于改进型的样本子集优化的原型选择方法能够通过分析样本在分类过程中的作用, 进而选出与类标签紧密相关的核心样本子集。因此, 基于改进型样本子集优化的原型选择方法对分类结果更有利。

3) 通过比较特征选择前后IDBC算法的分类结果, 分析可得:虽然基于改进型样本子集优化的差异度分类方法是一种高效的不均衡数据分类方法, 但是电信客户数据集中所存在的冗余、无关的客户属性不仅会增加模型构建过程中的复杂度, 而且会对原型选择造成干扰, 致使所选择的原型集缺乏参考价值。因此, 在特征选择的基础上, 采用IDBC方法将有助于提高传统分类算法对不均衡电信客户数据分类预测的准确率。

实验2 基于6个普通的UCI不均衡数据集 (abalone9-18、ecoliIM、ecoliIMU、ecoliOM、yeastCYT-POX、glassNM), 借助朴素贝叶斯 (NB)、逻辑回归 (LR)、k近邻 (kNN)、决策树 (J48) 和随机森林 (RF) 五种分类算法, 分别运用已有的不均衡数据处理方法ROS、RUS、SMOTE、Boosting、Bagging、MeataCost和改进型的差异度分类方法 (IDBC) 在上述6个不均衡数据集上训练分类模型,并对训练所得模型的有效性进行检验, 比较分类评价指标AUC, 如表 5所示。

| 表 5 基于UCI其他六个数据集的不均衡数据处理方法的分类评价指标 (AUC) Table 5 Classification evaluation (AUC) of imbalanced data processing methods on UCI other six datasets |

通过分析表 5中的实验结果, 可以得出结论:差异度表示方法不仅可以解决电信客户流失预测中的不均衡数据分类问题, 而且适用于其他不同领域的不均衡数据分类研究。同时通过比较所有的不均衡数据处理方法, 发现组合分类技术和代价敏感学习的分类效果优于一般的重采样方法, 而逊色于改进型的差异度分类方法。

4 结语本文针对电信客户流失预测中存在的不均衡数据分类问题以及差异度分类方法在不均衡数据分类中的局限性, 提出将特征选择、样本子集优化以及差异度分类方法相结合来解决电信客户流失预测问题。通过对基于差异度的改进型不均衡数据分类 (IDBC) 算法进行实证分析, 可以得出以下几点结论:1) 差异度分类方法能够消除类别分布对预测结果的影响, 对流失客户的预测性能优于已有的流失预测方法; 2) 相对于随机选择的结果, 样本子集优化所选择的原型集更具有参考价值, 对流失客户的识别更有利; 3) 在构建分类模型之前, 对原始电信客户数据集进行特征选择, 不仅能够消除冗余, 降低计算复杂度, 而且确保了原型选择的有效性; 4) 差异度表示方法适用于解决不均衡数据的分类问题。但是, 本文提出的改进型差异度分类算法目前仅仅适用于解决不均衡数据的二分类问题, 并不适用于解决多类别的数据分类问题。因此, 探索差异度分类方法在多类别数据分类问题中的应用将成为下一阶段的研究目标。

| [1] | 曹鹏, 李博, 栗伟, 等. 基于粒子群优化的不均衡数据学习[J]. 计算机应用, 2013, 33 (3) : 789-792. ( CAO P, LI B, LI W, et al. Imbalanced data learning based on particle swarm optimization[J]. Journal of Computer Applications, 2013, 33 (3) : 789-792. doi: 10.3724/SP.J.1087.2013.00789 ) |

| [2] | LIU X, WU J, ZHOU Z. Exploratory under-sampling for class-imbalance learning[J]. IEEE Transactions on Systems, Man, and Cybernetics, Part B, 2009, 39 (2) : 539-550. doi: 10.1109/TSMCB.2008.2007853 |

| [3] | LI P, YU X, SUN B, et al. Telecom customer churn prediction based on imbalanced data re-sampling method[C]//Proceedings of the 2013 International Conference on Measurement, Information and Control. Piscataway, NJ: IEEE, 2013: 229-233. |

| [4] | 古平, 欧阳源遊. 基于混合采样的非平衡数据集分类研究[J]. 计算机应用研究, 2015, 32 (2) : 379-381. ( GU P, OUYANG Y Y. Classification research for unbalanced data based on mixed-sampling[J]. Application Research of Computers, 2015, 32 (2) : 379-381. ) |

| [5] | 翟云, 王树鹏, 马楠, 等. 基于单边选择链和样本分布密度融合机制的非平衡数据挖掘方法[J]. 电子学报, 2014, 42 (7) : 1311-1319. ( ZHAI Y, WANG S P, MA N, et al. A data mining method for imbalanced datasets based on one-sided link and distribution density of instances[J]. Acta Electronica Sinica, 2014, 42 (7) : 1311-1319. ) |

| [6] | IDRIS A, KHAN A. Churn prediction system for telecom using filter-wrapper and ensemble classification[J/OL]. The Computer Journal, 2016[2016-06-01]. http://comjnl.oxfordjournals.org/content/early/2016/05/27/comjnl.bxv123.abstract. |

| [7] | LI P, LI S B, BI T T, et al. Telecom customer churn prediction method based on cluster stratified sampling logistic regression[C]//Proceedings of the 2014 International Conference on Software Intelligence Technologies and Applications & International Conference on Frontiers of Internet of Things. London, UK: IET, 2014: 282-287. |

| [8] | 丁君美, 刘贵全, 李慧. 改进随机森林算法在电信业客户流失预测中的应用[J]. 模式识别与人工智能, 2015, 28 (11) : 1041-1049. ( DING J M, LIU G Q, LI H. The application of improved random forest in the telecom customer churn prediction[J]. Pattern Recognition and Artificial Intelligence, 2015, 28 (11) : 1041-1049. ) |

| [9] | EFFENDY V, BAIZAL Z K A. Handling imbalanced data in customer churn prediction using combined sampling and weighted random forest[C]//Proceedings of the 20142nd International Conference on Information and Communication Technology. Piscataway, NJ: IEEE, 2014: 325-330. |

| [10] | 蒋国瑞, 司学峰. 基于代价敏感SVM的电信客户流失预测研究[J]. 计算机应用研究, 2009, 26 (2) : 521-523. ( JIANG G R, SI X F. Study of telecom customer churn prediction based on cost sensitive SVM[J]. Application Research of Computers, 2009, 26 (2) : 521-523. ) |

| [11] | JAPKOWICZ N, STEPHEN S. The class imbalance problem: a systematic study[J]. Intelligent Data Analysis, 2002, 6 (5) : 429-449. |

| [12] | ELLOUMI M, ZOMAYA A Y, YANG P, et al. Stability of feature selection algorithms and ensemble feature selection methods in bioinformatics[EB/OL].[2016-03-10]. http://onlinelibrary.wiley.com/doi/10.1002/9781118617151.ch14/summary. |

| [13] | ZHANG X, SONG Q, WANG G, et al. A dissimilarity-based imbalance data classification algorithm[J]. Applied Intelligence, 2015, 42 (3) : 544-565. doi: 10.1007/s10489-014-0610-5 |

| [14] | PEKALSKA E, DUIN R P W. Dissimilarity representations allow for building good classifiers[J]. Pattern Recognition Letters, 2002, 23 (8) : 943-956. doi: 10.1016/S0167-8655(02)00024-7 |

| [15] | PEKALSKA E, DUIN R P W, PACLIK P. Prototype selection for dissimilarity-based classifiers[J]. Pattern Recognition, 2006, 39 (2) : 189-208. doi: 10.1016/j.patcog.2005.06.012 |

| [16] | DUIN R P W, PEKALSKA E. The dissimilarity representation for pattern recognition: a tutorial[EB/OL].[2016-03-10]. http://homepage.tudelft.nl/a9p19/presentations/DisRep_Tutorial_doc.pdf. |

| [17] | YANG P Y, YOO P D, FERNANDO J, et al. Sample subset optimization techniques for imbalanced and ensemble learning problems in bioinformatics applications[J]. IEEE Transactions on Cybernetics, 2014, 44 (3) : 445-455. doi: 10.1109/TCYB.2013.2257480 |

| [18] | KENNEDY J, EBERHART R. Particle swarm optimization[C]//Proceedings of the 1995 IEEE International Conference on Neural Networks. Piscataway, NJ: IEEE, 1995: 1942-1948. |