由于原始数据集中常常存在大量无关或冗余特征,因此在特征选择时,获取鲁棒性较强的结果变得很困难。针对这一难题,蔡哲元等[1]提出的基于核空间距离测度的特征选择方法、成卫青等[2]提出的基于改进互信息和信息熵的文本特征选择方法、Liu等[3]提出的特征选择的全局和局部结构保存方法等,从不同角度有效地实现了特征选择,但针对多重共线性问题,这些方法还需进一步改进。偏最小二乘回归(Partial Least Squares Regression, PLSR) 在自变量间存在较高相关性时,提供了一种多因变量对多自变量的回归建模方法,可以有效地解决多重共线性难题。基于这种优势,许多学者提出了一系列数据降维模型,如李建更等[4]提出的基于逐步提取偏最小二乘主成分的特征选择方法、李胜等[5]提出基于改进的量子遗传偏最小二乘的特征选择方法、Nagaraja 等[6]利用偏最小二乘回归和优化实验设计特征选择算法,实现了对多维特征的降维。同时由于PLSR运行速度快,且可应用于分类,因此也有很多学者利用PLSR建立分类模型,如马宗杰等[7]提出基于奇异值分解和偏最小二乘回归的分类模型,Eroglu等[8]将PLSR分类模型应用于睡眠脑电信号分类。简彩仁等[9]提出了基于稀疏表示和偏最小二乘回归的分类方法,Li等[10]将偏最小二乘回归应用于肿瘤分类;但是文献[9-10]只是将PLSR应用于数据降维,并没有用偏最小二乘回归作进一步的分类,而是采用传统的支持向量机(Support Vector Machine, SVM)方法和最近邻子空间准则。

在建立PLSR特征选择和分类模型时,模型输入矩阵直接来源于样本数据,而输出矩阵的构建对模型的性能至关重要。文献[4]和[11]的模型输出都是类别标签,操作简单,但结果的分类准确性不好;文献[5]根据量子遗传问题,以适用度函数的适应度值作为模型输出,提高了准确率,缩短了运行时间,但分类的鲁棒性有待提高;文献[9]以最近邻子空间的度量余量作为模型输出,虽克服了传统分类方法存在的过拟合问题,但分类模型并没有考虑鲁棒性需求。另外在模型建立过程中,噪声样本对优选特征子集的选择有一定的影响,但很多文献并没有考虑到这一点。文献[6]、[10]、[12-13]在用PLSR进行特征选择时,都没有把噪声样本的干扰考虑进去,在一定程度上存在鲁棒性不强的缺点;而文献[9]用稀疏表示的方法去除了噪声样本的干扰,但是却没有进行特征选择,所以运算代价较大。

针对上述文献提出的方法中存在的问题,本文旨在提出一种在PLSR模型下同时实现鲁棒性特征选择和分类的模型,既能剔除噪声样本的干扰,解决特征选择中特征之间的冗余和多重共线性问题,得到鲁棒性较强的优选特征子集,又能实现基于偏最小二乘回归的快速准确分类。

1 偏最小二乘回归算法原理 1.1 偏最小二乘回归设有p个自变量{x1, x2, …, xp}和q个因变量{y1, y2, …, yq}。偏最小二乘回归分别在输入矩阵X与输出矩阵Y中提取出成分t1和u1(t1是x1, x2, …, xp的线形组合,u1是y1, y2, …, yq的线形组合)。在提取这两个成分时,为了回归分析的需要,有下列两个要求:

1) t1和u1应尽可能多地携带它们各自数据表中的变异信息;

2) t1和u1的相关程度能够达到最大。

在第一个成分t1和u1被提取后,偏最小二乘回归分别实施X对t1的回归以及Y对u1的回归。如果回归方程已经达到满意的精度,则算法终止;否则,将利用X被t1解释后的残余信息以及Y被u1解释后的残余信息进行第二轮的成分提取。如此往复,直到能达到一个较满意的精度为止。若最终对X共提取了m个成分t1, t2, …, tm,偏最小二乘回归将通过实施yr对t1, t2, …, tm的回归,然后再表达成yr关于原变量x1, x2, …, xm的回归方程[14],其中r=1, 2, …, q。

目前的研究者多将研究视角针对基于偏最小二乘回归的数据降维,也有涉及到偏最小二乘回归直接用于分类的研究,但是还没有一种能在PLSR模型下同时实现特征选择和分类,且具有较好鲁棒性的系统模型,因此这一思路是对相关研究领域的补充,在获得合理有效的模型这一层面上也是很有意义的。

1.2 类一致性系数在建立偏最小二乘回归模型时,一般均是将类别标签直接作为模型输出,这种处理方式是较不稳定的,因此为改善模型性能,提高算法的鲁棒性,本文根据Logistic回归(Logistic Regression, LR)的模型特点,同时结合k近邻(k Nearest Neighbor, kNN)思想,定义了一个类一致性系数C作为模型的输出变量。首先定义了一个类一致性概率P,其表达式为:

| $P=a/k$ | (1) |

类一致性系数的表达式为:

| $C=\ln (P/(1-P))=\ln (a/(k-a))$ | (2) |

其中:k为所取的邻域大小,a为该邻域内同类样本的个数。原理如图 1所示。某1类样本(图中实心圆形)的3邻域中所有样本均与它是同一类,那么其类一致性系数可表示为C=ln(3/(3-3) )=ln(3/0) ;同理,某2类样本(图中实心菱形)的7邻域里只有1个与它不同类,则其类一致性系数为C=ln(6/(7-6) )=ln(6) 。

|

图 1 类一致性系数的原理 Figure 1 Principle of class consistency coefficient |

本文在进行参数k值的选取时,为了准确估计每个样本的局部类分布概率密度,在不同的邻域范围内构建模型。经过对数值实验的结果分析,当k≤2时,由于尺度过小的原因使得概率估计局限在非常微小的区间中,易受到噪声样本点影响,造成估计的结果不理想,准确率偏低;当k取10以上的值时,由于邻域范围内包含的样本数量过多而失去了局部类分布概率密度估计的意义,造成细节信息的丢失并引起平滑噪声,降低了模型的可靠性,尤其是在靠近分类边界的区域会造成估计结果较差。常规的k近邻算法常采用奇数作为备选k值进行分类以便于投票决定类别,因此本文借鉴了k近邻的思想选取k=3, 5, 7作为本次实验的邻域范围取值。对于任意一个样本,本文以3个类一致性系数C1, C2, C3作为模型的输出矩阵。

2 基于PLSR的鲁棒性特征选择与分类算法为了实现在PLSR模型下同时进行特征选择和分类,提高分类精度和运行效率,并在特征选择之前剔除噪声样本的影响,提高特征选择的鲁棒性,本文提出了基于偏最小二乘回归的鲁棒性特征选择与分类算法(Robust Feature Selection and Classification algorithm based on Partial Least Squares Regression, RFSC-PLSR)。

2.1 基于偏最小二乘回归的特征选择由于原始数据集中可能存在的大量相关或冗余特征[15],因此在模式识别中,特征选择显得特别重要;同时原始数据集中还可能存在一些噪声样本[16],它们会直接影响特征选择的效果,造成结果的鲁棒性不强,因此本文算法在特征选择时首先考虑根据类一致性概率进行保守样本筛选,剔除噪声样本,以避免噪声样本对特征选择的不利影响。这里,定义3邻域时所有近邻样本都为同一类的样本为保守样本,即类一致性概率P=1时,判定该样本为保守样本。

以得到的保守样本作为模型输入,保守样本在邻域范围k=3, 5, 7时的类一致性系数作为模型输出建立偏最小二乘回归模型,得到回归系数矩阵。回归系数对应每维特征的权重,故回归系数越大,说明其对模型的贡献越大。这里,定义一个累计贡献率为:

| $sp=\sum\limits_{i=1}^{m}{{{\alpha }_{i}}}/\sum\limits_{j=1}^{n}{{{\alpha }_{j}};m=1,2,\cdots ,n}$ | (3) |

其中:n为特征总数,m为入选特征数,回归系数α从大到小排列。为确定合适的阈值进行了多次数值实验,结果表明当sp达到95%时,特征选择的效果最好,此时前m个回归系数α对应的特征进入优选特征子集。

2.2 基于偏最小二乘回归的分类将上述得到的优选特征子集应用于训练数据集中的所有样本训练偏最小二乘分类模型,此时的模型输入是所有训练样本的优选特征子集,输出是所有训练样本在邻域范围k=3, 5, 7时的类一致性系数。将测试样本集输入训练好的偏最小二乘回归分类模型得到3个不同邻域下的类一致性系数预测值,并结合该测试样本在训练集中的k(k=3, 5, 7) 个近邻样本类别标签来确定测试样本的类别标签。这样既可以保证用到样本数据的局部结构信息,又兼顾了其全局结构信息。

3个类一致性系数表征了在由小到大变化的3个邻域里,与该测试样本具有相同类别标签的训练样本的概率分布,保证了在全局结构上对样本分布的综合考察;而在局部结构角度上,选择测试样本在训练集中的k个近邻中多数样本的类别标签对其类别标签进行合理估计。首先将预测值类一致性系数C转换为类一致性概率P,转换公式为:

| $P=\frac{\exp (C)}{1+\exp (C)}$ | (4) |

之后将得到的P作为k近邻方法预测结果的置信度,定义:

| $\theta =\left\{ \begin{array}{*{35}{l}} 1, & P\ge 0.5 \\ -1, & P<0.5 \\ \end{array} \right.$ | (5) |

其中:θ=1表示接受k近邻方法估计出的类别标签;反之,θ=-1表示拒绝k近邻方法估计出的类别标签。这样在3个邻域范围取值下得到3个类别标签预测值,最终根据多数原则确定测试样本的类别标签。

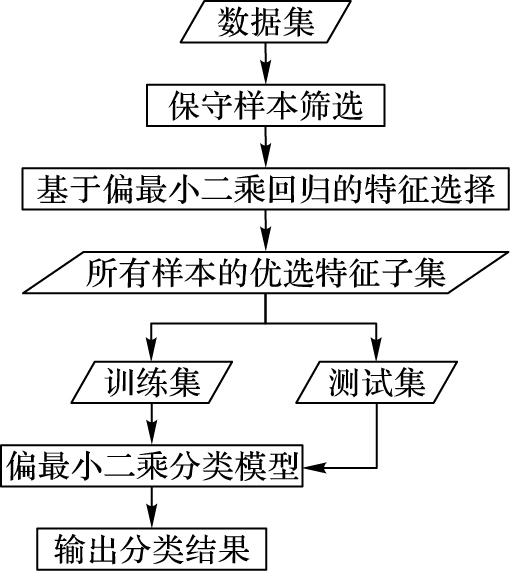

2.3 RFSC-PLSR方法的步骤RFSC-PLSR算法流程如图 2所示。

|

图 2 RFSC-PLSR算法流程 Figure 2 RFSC-PLSR algorithm flow |

具体算法步骤描述如下:

1) 对于给定样本集X0={xr, r=1, 2, …, n},设X1={xi, i=1, 2, …, n}为训练样本,X2={xj, j=1, 2, …, n-i}为测试样本。

2) 根据式(1) 计算3邻域时X0的类一致性概率P。如果P=1,那么xr为保守样本;否则xr为噪声样本。

3) 以保守样本为输入,3、5、7三种邻域下的类一致性系数为输出建立PLSR方程,得到保守样本的回归系数矩阵rc,并模归一化rc。

4) 根据式(3) 计算出回归系数矩阵rc的累计贡献率sp。

如果sp≥0.95,则选择前m个回归系数α对应的特征进入优选特征子集。

5) 用X1和优选特征子集作输入,3、5、7三种邻域下的类一致性系数为输出建立并训练PLSR分类模型。

6) 把X2输入到训练出的分类模型,得到3种不同邻域下的类一致性系数预测值C1, C2, C3,根据式(4) 转换为类一致性概率P1, P2, P3。

7) 通过k近邻方法得出测试样本在训练集中的3、5、7个近邻样本的类别标签Y1, Y2, Y3。

8) 根据6) 的结果,如果P1≥0.5,那么接受Y1;否则拒绝Y1,即类别标签为另一类别标签。同理,应用于Y2, Y3。

9) 根据7) 的结果,由多数原则确定测试样本空间X2的预测类别标签Y0。

3 数值实验及结果分析本文以二分类问题为例,在偏最小二乘回归的基础上进行建模。通过多组数值实验来验证本文提出的RFSC-PLSR算法的有效性,并与支持向量机(SVM)[17]、朴素贝叶斯(Naive Bayes, NB)[18]、BP神经网络(BP Neural Network, BPNN)[19]和Logistic回归(Logistic Regression, LR)[20]等四种常用的典型分类器进行对比、分析和讨论。

3.1 数据集考虑在特征维度多样化的条件下对比实验结果,本文从UCI Machine Learning Repository(http://archive.ics.uci.edu/ml/index.html)中选择5个不同维度的数据分别进行数值实验,数据集详情及特征选择结果如表 1所示。

| 表 1 数据集详情及特征选择结果 Table 1 Data set details and feature selection results |

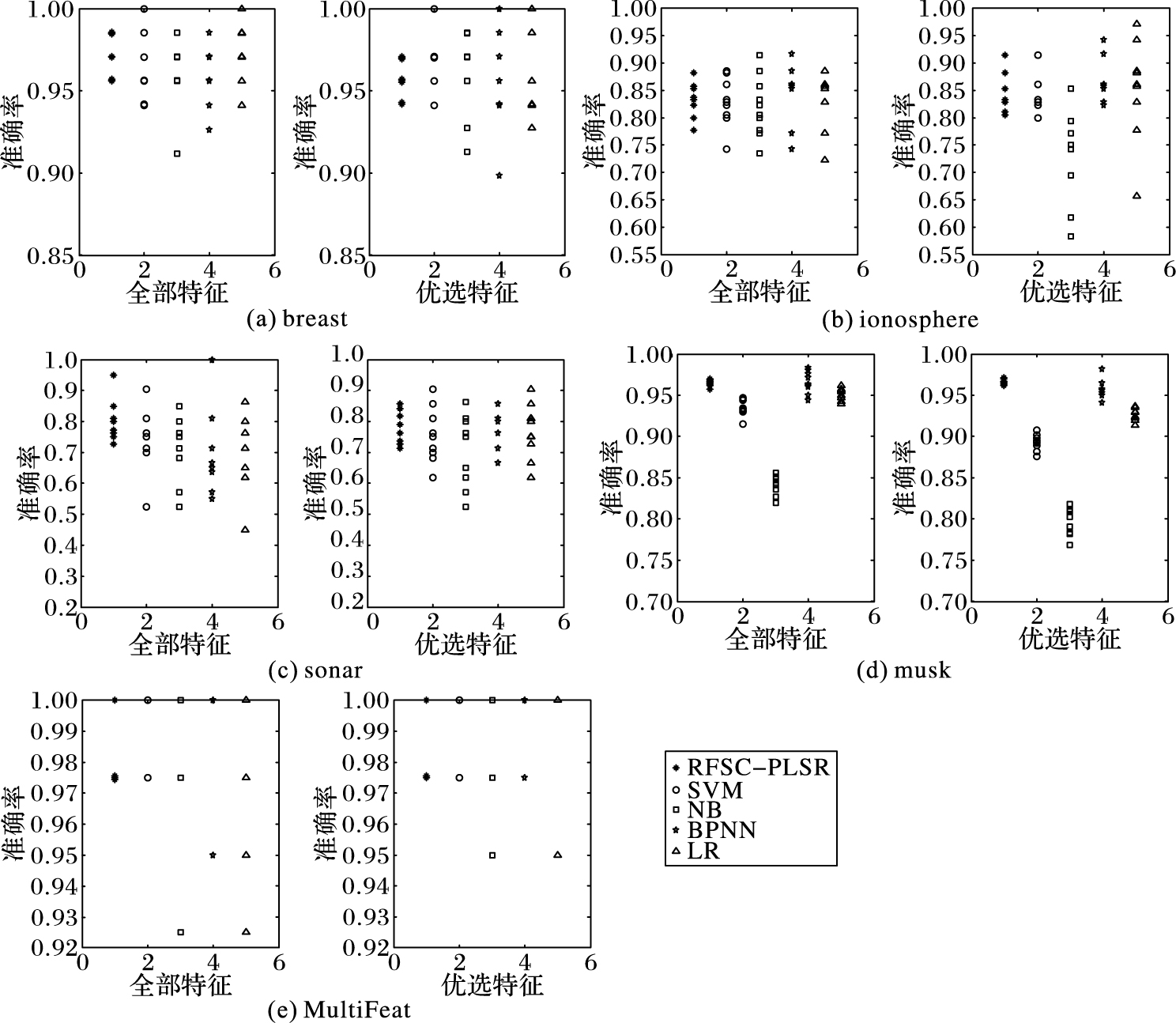

对上述数据集采用十折交叉验证法,以10次的平均结果作为不同方法的最终结果并加以比较,分类精度和运行时间分别如表 2所示,鲁棒性效果对比如图 3所示。

| 表 2 RFSC-PLSR与典型的四种分类器的分类精度和运行时间比较 Table 2 Classification accuracy and running time comparison between RFSC-PLSR and four typical classifiers |

|

图 3 不同数据集在全部特征和优选特征时的鲁棒性效果对比 Figure 3 Comparison of robustness of different data sets on all features and preferred features |

观察表 2分类精度发现,全部特征时RFSC-PLSR和四种典型的分类器相比较,准确率没有明显低于其他四种,且方差较小。如在ionosphere数据中,RFSC-PLSR的准确率虽比BPNN低,但其方差明显比BPNN小,且分类精度相对其他三种方法较好,在sonar数据中,RFSC-PLSR的分类精度明显比其他四种方法好;在优选特征下,RFSC-PLSR的分类精度相对较高,表中加下划线的分类精度分别是5种分类器中表现最好的和次好的,可以看出,RFSC-PLSR的分类精度都表现较好。如在ionosphere、sonar和musk3个数据中,RFSC-PLSR的分类精度都相对其他四种方法较好,在breast和MultiFeat数据中,RFSC-PLSR的准确率虽不如BPNN和SVM好,但方差都比它们小。可以看出,本文算法不管在全部特征下,还是优选特征下,都有较好的分类精度。

比较五种分类器在全部特征和优选特征下的精度变化情况,发现五种分类器精度没有发生显著性的变化,且RFSC-PLSR在进行特征选择之后分类精度的波动情况明显比其他四种分类器上较小。这一则说明本文的特征选择方法较好地去除了冗余无关特征,选出的特征子集能较完整保留数据的信息;一则说明本文结合特征选择与分类的PLSR模型的鲁棒性强。

从表 2运行时间可以看出,在5个数据集中,与SVM和BPNN相比,RFSC-PLSR在全部特征和优选特征时能保证较好的运行效率,虽然NB以及LR处理多维数据时的运行效率优势非常明显,但是在分类精度上的表现不尽如人意。如在sonar和musk数据下,NB的运行速度很快,但是其分类精度明显比RFSC-PLSR低很多;在ionosphere 和sonar数据下,LR的运行速度也很快,但是其分类精度也明显比RFSC-PLSR低。

图 3给出了5个数据在全部特征和优选特征时的5种分类器的鲁棒性效果对比,从图 3中可以看出,在全部特征和优选特征时RFSC-PLSR在前四个数据中准确率都较集中,鲁棒性明显好于其他四种分类器。在MultiFeat数据中,在全部特征时,虽其鲁棒性效果和SVM差不多,但明显好于其他三种方法;在优选特征时,RFSC-PLSR的鲁棒性和SVM、BPNN差不多,但也明显好于其他两种分类器。说明RFSC-PLSR的鲁棒性较好。

综合以上三点,表明本文算法处理不同维度的数据集时,在分类精度、运行效率和鲁棒性三个方面均有良好的表现,能在保证算法精度和运行效率的前提下增强鲁棒性,具有一定的优越性。

4 结语本文利用偏最小二乘回归分析的优势,结合k近邻算法,提出一种基于偏最小二乘回归的鲁棒性特征选择与分类算法。通过在多种维度数据集上的应用得到如下结论:

1) RFSC-PLSR算法,两次结合PLSR模型,有效解决了特征之间的多重共线性问题,同时排除了噪声样本的影响,提高了系统的鲁棒性。

2) 定义的类一致性系数从全局信息考虑,并结合k近邻兼顾局部信息,敏感地感知出类别的变化,更好地体现数据集的真实结构。

3) RFSC-PLSR算法选用PLS回归模型,有效去除了冗余和无关特征,提高了运行效率,具有较好的推广性。

本文中RFSC-PLSR算法处理的问题相对简单,当遇到复杂的非线性问题时,若扩展到核空间上可能会有更好的表现;如何根据数据集的结构自适应地确定特征选择阈值sp很有意义;分类模型中P的阈值选择,本文也没有作细致的讨论。故上述问题将成为作者下阶段的重点研究方向。

| [1] | 蔡哲元, 余建国, 李先鹏, 等. 基于核空间距离测度的特征选择[J]. 模式识别与人工智能, 2010, 23 (2) : 235-240. ( CAI Z Y, YU J G, LI X P, et al. Feature selection algorithm based on kernel distance measure[J]. Pattern Recognition and Artificial Intelligence, 2010, 23 (2) : 235-240. ) |

| [2] | 成卫青, 唐旋. 一种基于改进互信息和信息熵的文本特征选择方法[J]. 南京邮电大学学报(自然科学版), 2013, 33 (5) : 63-68. ( CHENG W Q, TANG X. A text feature selection method using the improved mutual information and information entropy[J]. Journal of Nanjing University of Posts and Telecommunications (Natural Science Edition), 2013, 33 (5) : 63-68. ) |

| [3] | LIU X, WANG L, ZHANG J. Global and local structure preservation for feature selection[J]. IEEE Transactions on Neural Networks and Learning Systems, 2013, 25 (6) : 1083-1095. |

| [4] | 李建更, 耿涛, 阮晓钢. 基于逐步提取偏最小二乘主成分的特征选择方法[J]. 生物学杂志, 2010, 27 (4) : 85-87. ( LI J G, GENG T, RUAN X G. Feature selection based on step-wise extraction of partial least square principal components[J]. Journal of Biology, 2010, 27 (4) : 85-87. ) |

| [5] | 李胜,张培林,李兵,等.改进的量子遗传偏最小二乘特征选择方法应用[EB/OL].[2015-09-09].http://xueshu.baidu.com/s?wd=paperuri%3A%2860c46a5aa2660e17695da55a04fd240c%29&filter=sc_long_sign&tn=SE_xueshusource_2kduw22v&sc_vurl=http%3A%2F%2Fd.wanfangdata.com.cn%2FPeriodical_pre_c9928afb-7542-4d5f-930a-e367c2695add.aspx&ie=utf-8&sc_us=6354191550128628502. ( LI S, ZHANG P L, LI B, et al. Application for feature selection method of improved quantum genetic algorithm-partial least square[EB/OL].[2015-09-09]. http://xueshu.baidu.com/s?wd=paperuri%3A%2860c46a5aa2660e17695da55a04fd240c%29&filter=sc_long_sign&tn=SE_xueshusource_2kduw22v&sc_vurl=http%3A%2F%2Fd.wanfangdata.com.cn%2FPeriodical_pre_c9928afb-7542-4d5f-930a-e367c2695add.aspx&ie=utf-8&sc_us=6354191550128628502.) ) |

| [6] | NAGARAJA V K, ABD-ALMAGEED W. Feature selection using partial least squares regression and optimal experiment design[C]//Proceedings of the 2015 International Joint Conference on Neural Networks. Piscataway, NJ:IEEE, 2015:1-8. |

| [7] | 马宗杰, 刘华文. 基于奇异值分解-偏最小二乘回归的多标签分类算法[J]. 计算机应用, 2014, 34 (7) : 2058-2060. ( MA Z J, LIU H W. Multi-label classification based on singular value decomposition-partial least squares regression[J]. Journal of Computer Applications, 2014, 34 (7) : 2058-2060. ) |

| [8] | EROGLU K, MALEKI M, KAYIKCIOGLU T. Fast and high accuracy classification of sleep EEG using PLSR method[C]//Proceedings of the 201321st Signal Processing and Communications Applications Conference. Piscataway, NJ:IEEE, 2013:1-4. |

| [9] | 简彩仁, 陈晓云. 基于稀疏表示和最小二乘回归的基因表达数据分类方法[J]. 福州大学学报(自然科学版), 2015, 43 (6) : 738-741. ( JIAN C R, CHEN X Y. Gene expression data classification model based on sparse representation and least square regression[J]. Journal of Fuzhou University (Natural Science Edition), 2015, 43 (6) : 738-741. ) |

| [10] | LI J G, GENG T. Tumor classification based on partial least square regression[C]//Proceedings of the 2010 International Conference on Biomedical Engineering and Computer Science. Piscataway, NJ:IEEE, 2010:1-6. |

| [11] | 金志超, 陆健, 吴骋, 等. 两种基于偏最小二乘法的分类模型对肿瘤基因表达数据行多分类的比较研究[J]. 中国卫生统计, 2009, 29 (5) : 450-454. ( JIN Z C, LU J, WU C, et al. Two multiple classification methods based on partial least squares using tumor microarray gene expression data on a comparative study[J]. Chinese Journal of Health Statistics, 2009, 29 (5) : 450-454. ) |

| [12] | ZENG X Q, LI G Z. Dimension reduction for p53 protein recognition by using incremental partial least squares[J]. IEEE Transactions on NanoBioscience, 2014, 13 (2) : 73-79. doi: 10.1109/TNB.2014.2319234 |

| [13] | 曾雪强, 李国正. 基于偏最小二乘降维的分类模型比较[J]. 山东大学学报(工学版), 2010, 40 (5) : 41-47. ( ZENG X Q, LI G Z. An examination of a classification model with partial least square based dimension reduction[J]. Journal of Shandong University (Engineering Science), 2010, 40 (5) : 41-47. ) |

| [14] | ABDI H. Partial least squares regression and projection on latent structure regression (PLS regression)[J]. Wiley Interdisciplinary Reviews:Computational Statistics, 2010, 2 (1) : 97-106. doi: 10.1002/wics.51 |

| [15] | 周城, 葛斌, 唐九阳, 等. 基于相关性和冗余度的联合特征选择方法[J]. 计算机科学, 2012, 39 (4) : 181-184. ( ZHOU C, GE B, TANG J Y, et al. Joint feature selection method based on relevance and redundancy[J]. Computer Science, 2012, 39 (4) : 181-184. ) |

| [16] | 车凯, 郭茂祖, 刘晓燕, 等. 植物抗性基因识别中样本选择的一种新方法[J]. 智能计算机与应用, 2012, 2 (4) : 31-34. ( CHE K, GUO M Z, LIU X Y, et al. A novel sample selection method for plant resistance gene recognition[J]. Intelligent Computer and Applications, 2012, 2 (4) : 31-34. ) |

| [17] | CHERKASSKY V, MA Y. Practical selection of SVM parameters and noise estimation for SVM regression[J]. Neural Networks, 2004, 17 (1) : 113-126. doi: 10.1016/S0893-6080(03)00169-2 |

| [18] | 李文进, 熊小峰, 毛伊敏. 基于改进朴素贝叶斯的区间不确定性数据分类方法[J]. 计算机应用, 2014, 34 (11) : 3268-3272. ( LI W J, XIONG X F, MAO Y M. Classification method for interval uncertain data based on improved naive Bayes[J]. Journal of Computer Applications, 2014, 34 (11) : 3268-3272. ) |

| [19] | YU L L, TAN B X, MENG T X. The automatic classification of ECG based on BP neural network[J]. Advanced Materials Research, 2010, 121/122 : 111-116. doi: 10.4028/www.scientific.net/AMR.121-122 |

| [20] | CHENG Q, VARSHNEY P K, ARORA M K. Logistic regression for feature selection and soft classification of remote sensing data[J]. IEEE Geoscience and Remote Sensing Letters, 2006, 3 (4) : 491-494. doi: 10.1109/LGRS.2006.877949 |