2. 上海理工大学 光电信息与计算机工程学院, 上海 200093

2. School of Optical-Electrical and Computer Engineering, University of Shanghai for Science and Technology, Shanghai 200093, China

随着计算机技术的快速发展,视觉显著性算法也在不断更新。自从Itti等[1]提出计算视觉显著性模型开始,越来越多的学者开始致力于该领域的研究。近年来,视觉显著性在计算机视觉和模式识别领域变得越来越热门,被广泛地应用于图像处理技术中,如物体检测、视觉追踪、图像分割与图像增强等。

视觉显著性算法的目的是找出图像中最明显、最能吸引注意的物体或区域。从人类视觉的角度来讲,图像中的显著性通常与局部对比度有关,这是因为显著物体与周围区域存在多方面的差异,如颜色、亮度、形状、纹理等特征的差异。

目前,研究者们提出的显著目标检测算法,大致可以分为两类:由任务或知识驱动的自顶向下(top-down) 方法[2-5],由数据或刺激驱动的自底向上(bottom-up) 方法[6-14]。

自顶向下方法通常与标定真实值的监督学习有关。为了更好地将显著性区域从背景中抽取出来,自顶向下方法中往往会用到高层次的信息或图像特征来提高显著性图的准确性。例如,Wang等[15]将字典学习与条件随机域组合,产生具有区分度的特征来描述显著性物体; Yang[16]用深度神经网络将局部估计与全局搜索相结合来找出图像中最显著的区域。

自底向上方法通常采用低层次信息比如颜色,像素差,空间距离以及边缘来构建显著性图,这些方法与图像内容、先验知识无关。例如,Perazzi等[17]提出了一种基于对比度的视觉显著性估计; Frintrop 等[18]则通过在语义和生物学激发的模型中加入特征融合、均值漂移等步骤,提升了传统模型的效果。

多种低层次信息与显著性传播算法[19-23]相结合,是目前很多非机器学习方法的思路。为了模拟显著性传播过程,图像被分割成若干区域,每个区域用一个节点表示。不同节点用带权边连接。已标记节点的显著性会用具体数值量化,并通过特定算法,沿着带权边,迭代地向周围未标记的邻接节点传递[12]。

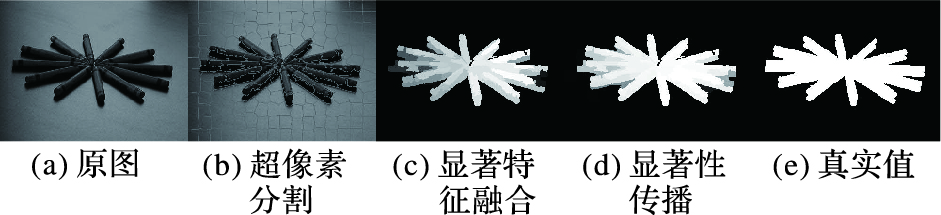

大多数基于图的算法按照以下步骤工作。首先,输入图像(图 1(a))被分割成超像素块(图 1(b)),依据超像素块来构建适当的无向图。通过加法、乘法或者其他函数组合低层次信息后,找出最可能是显著区域的超像素块,将这些超像素块标记,并根据算法赋予它们相应的显著性值(图 1(c))。接着,特定的显著性传播算法能够计算出已标记节点与未标记节点之间的相似度。然后,显著性值通过带权边,由已标记节点向未标记节点散射。最终,每个超像素块都被标记且有显著性值,由此得到整体显著性图(图 1(d))。

|

图 1 基于图构建的显著性检测步骤 Figure 1 Saliency detection steps based on graph construction |

近年来,研究者们提出了多种基于图像分割与图构建的显著性计算方法,例如,利用基于流形排序的散射算法[24],利用随机游走的方式在图上建立显著性传播过程[25],以及通过优化上述方法而衍生出的细胞自动机算法[26]等。这些方法都以图像边界作为背景先验,采用不同的传播算法构建显著性图。预处理方面,这几种方法都用到了简单线性迭代聚类(Simple Linear Iterative Clustering,SLIC)超像素块分割[27]。这样做的好处是将原本像素级别的运算转变为超像素级别的运算,减少了时间开销。超像素块分割能保持图像的局部结构特征及部分语义特征,与像素级的特征相比,更利于显著性的呈现;同时,边界先验的引入简化了特征选取过程,将分析范围缩小为图像的特定区域,既简化了运算,又提升了准确性。微软亚洲研究院图像显著性测试集(Microsoft Reasearch Asia,MSRA),扩展复杂场景图像显著性数据集(Extended Complex Scene Saliency Dataset,ECSSD)等多个公开数据集测试结果表明,无论是速度还是效果,这几种基于图的方法明显优于基于像素、先验无关的方法。其中,基于流形排序的方法[23]是目前效果较好的算法之一。

然而,基于图的方法存在两个缺陷。第一,选择前景或背景先验区域的算法存在问题。如果不能找出典型的、有代表性的先验,最终得到的显著性图可能不准确,甚至和真实值相反。第二,已提出的算法中,一些不必要的步骤开销过大,导致算法效率较低。本文会在后面讨论这些问题。

一些自顶向下的方法,如文献[6, 15-16]通过提取图像的不同特征,利用机器学习方法,根据这些特征训练出能够检测图像中显著物体的模型。这类方法在特定训练集下容易获得很好的效果,在公开数据集上能够超过自顶向上方法,尤其是判别性区域显著特征融合(Discriminative Regional Feature Integration,DRFI)[28]在MSRA、ECSSD等数据集上的准确度领先于其他算法。

但是,这类方法的缺点同样突出。一是机器学习普遍对训练集有较高要求,如果没有足够的训练样本,则容易因为训练不足而达不到预期效果,产生欠拟合;如果过度训练,则会造成过拟合,同样无法得到很好的效果。二是模型的适应性不足,单一模型可能在特定数据集上的结果较好,而在其他的数据集上效果不佳。三是效率问题,如果提取的特征过于复杂(尤其是高维特征),则模型训练会消耗大量时间,

图像通过模型进行检测的时间也会较长,因此,尽管DRFI的效果非常好,但是在效率方面仍有不足,本文在实验部分会比较各算法的效率。针对上述方法的优点及存在的问题,本文提出了一种新的基于流形排序的显著目标检测算法,首先改变了超像素块分割的策略,其次设计了以显著期望、全局对比度,以及局部对比度为指标的显著置信度估计,找出最具有代表性的背景先验,并用新的带权相加的方式将其融合,获得比普通乘法更好的前景估计,最终得到准确的显著性图,在效果上超过先前基于图的方法,在效率上超过多种机器学习方法。

2 算法步骤 2.1 超像素块分割本文首先对输入图像进行超像素块划分。 假设一张图片包含N个像素,将它划分成n个超像素块,则每个超像素块包含N/n个像素,因此,相邻超像素块中心之间的初始距离为

| $\begin{array}{c} {D_s} = {d_{lab}} + \frac{m}{s}{d_{xy}}\\ {d_{lab}} = \sqrt {{{({l_k} - {l_i})}^2} + {{({a_k} - {a_i})}^2} + {{({b_k} - {b_i})}^2}} \\ {d_{xy}} = \sqrt {{{({x_k} - {x_i})}^2} + {{({y_k} - {y_i})}^2}} \end{array}$ | (1) |

其中:SLIC算法[20]建议m取10。根据式(1) ,找出每个像素最近的聚类中心,把该像素归到对应聚类中,通过计算可得到这些新聚类的中心坐标。重复这一过程,直到每个聚类的中心坐标变化量小于一定阈值,这样就得到一幅图像的n个超像素块。但是通过实验,一般图像在5次迭代后,聚类中心坐标变化量非常小,几乎可以忽略不计,因此在本文算法中,划分超像素块的终止条件由阈值改为5次迭代。这样节省了预处理时间开销,也让算法更简单。先前的基于超像素块算法,一般将图片划分为200个超像素块。本文通过实验,综合衡量了效率与精准度,认为采用300个超像素块划分,能够取得更精准的结果,并且在时间开销上与划分为200个超像素块所需时间相差较小。

2.2 闭环无向图构建与流形排序超像素块分割完毕后,在这些分割好的超像素块上构建闭环无向图,并进行流形排序。流形排序的一般步骤是:给定数据集X={x1,x2,…,xk,xk+1,…,xn}∈Rm×n,其中n代表总元素个数,k表示已经标记的元素,剩余的元素需要根据与前k个元素的相关度进行排序。元素类型保存在指示向量y=[y1,y2,…,yn]T中,如果是标记元素,则yi=1,否则yi=0。接着,定义无向图G=(V,E),其中点集V对应数据集X,而边集E的权值由相似度矩阵W=[wij]n×n表示。定义度数矩阵D=diag{d11,d22,…,dnn},其中

| $\begin{array}{*{20}{l}} {{f^*} = \mathop {\arg \min }\limits_f \frac{1}{2}\left( {\sum\limits_{i,j = 1}^n {{w_{ij}}{{\left\| {\frac{{{f_i}}}{{\sqrt {{d_i}} }} - \frac{{{f_j}}}{{\sqrt {{d_j}} }}} \right\|}^2} + } } \right.}\\ {\left. {\mu {{\sum\limits_{i = 1}^n {\left\| {{f_i} - {y_i}} \right\|} }^2}} \right)} \end{array}$ | (2) |

其中:参数μ控制准确性与平滑性之间的平衡。将上述函数求一阶导数,令导数为0,得到结果:

| ${\mathit{\boldsymbol{f}}^*} = {(\mathit{\boldsymbol{D}} - \alpha \mathit{\boldsymbol{W}})^{ - 1}}\mathit{\boldsymbol{y}}$ | (3) |

其中:α=1/(1+μ)。输入图像被分割成超像素块后,构建闭环无向图G=(V,E),其中V是分割后的超像素块组成的点集,而边集E由以下准则定义:1) 相邻的超像素块相互连接;2) 每个超像素块与它相邻的超像素块的邻居也相互连接;3) 所有在图像边缘的超像素块相互连接。于是,输入图像转化为无向图。得到边集后,构造相似度矩阵W,定义如下:

| ${w_{ij}} = \left\{ {\begin{array}{*{20}{l}} {{{\rm{e}}^{ - \left\| {c{}_i - {c_j}/{\sigma ^2}} \right\|,}}} & {{\rm{节点}}\mathit{i}{\rm{与}}\mathit{j}{\rm{相连}}}\\ {0,} & {\rm{其他}} \end{array}} \right.$ | (4) |

其中:ci和cj分别是超像素块i与j在CIELab颜色空间上的色彩均值;σ2是控制连通权值强度的因子。很明显,由式(4) 得到的相似度矩阵W是稀疏的。根据W很容易算出D。文献[23]中,α的值被设置为0.99,σ2的值被设置为0.1。本文中,由于超像素块的分割方式发生变化,算法不再采用上述的参数值。分割的超像素块越精细,相邻的超像素块之间的联系越紧密,所以控制连通权值强度的因子σ2应当适当变大,以补偿超像素块变多带来的权值衰减。本文通过实验,将σ2设为0.5。然后根据σ2的值,找到最佳的α值为0.9。

2.3 背景显著估计如文献[1, 18]所述,显著性的计算源于人类视觉注意机制,人类感知习惯在决定一张图像中的显著物体时起到了重要作用。已有的背景估计方法中,研究者将图像边界作为背景候选区。这与人类视觉习惯一致:一方面,人们在观察图像时,中心区域通常最先引起人的注意;另一方面,在照片或图像中,人们不太可能将重要物体放在边缘,因此,本文算法采用类似的方法来选取背景先验。

一张图像有4个边界,以上边界为例,首先标记与上边界有公共边的超像素块。相对地,其他超像素块视为未标记,这样就得到指示向量y。然后将所有超像素块按照式(3) 进行排序,得到n维向量f*。 f*中的每一个值代表对应超像素块与上边界的相似度,值越高则相似度越高。根据人类视觉习惯,与边界相似的超像素块,极有可能是背景或非显著区域,因此,可以将f*看作关于上边界的背景先验估计。 将f*归一化后可得到关于上边界的背景显著估计:

| ${S_{{\rm{top}}}}(i) = 1 - \overline {{\mathit{\boldsymbol{f}}^*}} (i)$ | (5) |

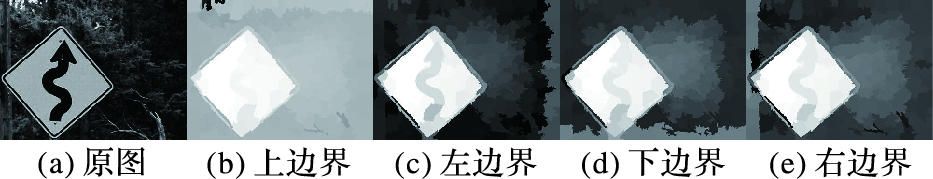

其中:i代表图中相应超像素块的索引,f*是归一化后的f*。类似地,分别计算出关于左边界,下边界以及右边界的背景显著估计,根据式(5) 得到Sleft、Sbottom、Sright。图 2展示了一幅图像关于4条边界的背景显著估计效果。

|

图 2 基于不同边界的显著估计结果 Figure 2 Saliency estimation results based on different boundaries |

原始的流形排序算法[23]直接将4张背景显著估计相乘得到背景显著图:

| ${S_{{\rm{bg}}}} = {S_{{\rm{top}}}} \times {S_{{\rm{left}}}} \times {S_{{\rm{bottom}}}} \times {S_{{\rm{right}}}}$ |

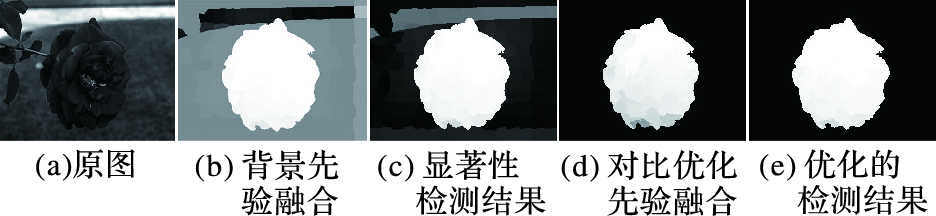

然而,这种方法存在明显的问题,如果显著性物体恰好与其中某个边界颜色相似,或者某个边界区域与其他边界相差很大,则背景显著估计就会不准确,甚至错误。如图 3(a),中心区域是一朵花,周围是草和绿叶,顶部是被虚化的河流。 那么此情况下红花会被看作显著物体,而其他区域是非显著的,但是,上边界出现的河流与其他边界相差较大,导致绿色区域相对显著。根据之前的算法,得到正确的Sleft、Sbottom、Sright以及错误的Stop。由于乘法的性质,Stop的错误可能被放大,因此在融合后会出现如图 3(b)的不准确估计,最终导致图 3(c)中的不准确结果。图 3展示了背景显著估计的准确程度对最终显著性检测结果的影响。

|

图 3 背景估计对结果的影响 Figure 3 Effect of background estimation on results |

在基于随机游走的方法[25]中,研究者计算出4张背景估计,根据颜色差异计算4张图的相似性,然后舍去与其他3张差异最大的图。这比文献[23]中的算法有了一定改进,但仍可能出现问题。如遇到显著性物体与多个边界相似的情况,这种算法就会失效;而且计算相似性的算法涉及到多次全图遍历,会造成不必要的时间开销。 综上所述,通过简单乘法融合背景显著估计缺乏合理性,本文将不采用乘法的方式来融合显著估计。

2.4 对比度优化与背景先验融合在基于细胞自动机的算法[26]中,研究者提出了改进方法。利用CIELab色彩特征将边界区域聚成3类,构建出3张不同的全局颜色区别(Global Color Distinction,GCD)矩阵。接着,用全局空间距离(Global Spatial Distance,GSD)矩阵来平衡这些不同的GCD图,背景显著估计变为:

| ${S_{{\rm{bg}}}} = \sum\limits_{k = 1}^3 {GC{D_k} \times GS{D_k}} $ |

这种方法在聚类、计算GCD和GSD的时候会有比较大的开销,但是将显著估计的融合方式由简单的乘法变成了带权加法,能有效修正不合理的背景显著估计。

本文利用相似的思路,设计了相应的显著融合算法,以带权加法的方式,通过权值修正显著估计,改进之前的算法。根据显著性物体在图像中的分布情况,合理的背景显著估计需要具备三个条件: 1) 显著区域在图像中占的比例相对较少;2) 显著区域相对集中,同类区域显著值接近;3) 显著区域与非显著区域对比明显。

根据以上条件,本文设计了三个指标来判断显著估计的置信度。首先定义背景显著估计的显著期望:

| $E = \frac{1}{n}\sum\limits_{i = 1}^n {S(i)} $ | (6) |

其中n为超像素块的个数。根据条件1) ,显著区在图像中占的比例偏少,因此,一个合理的显著先验,显著值的期望E应当偏低。如果E过高,说明在显著先验中,显著区域在图像中的比例过大,或者区域内的显著值过高。接着,定义局部显著对比度:

| ${C_{{\rm{local}}}} = \frac{1}{n}\sum\limits_{i = 1}^n {\frac{1}{{\left| {{k_i}} \right|}}\sum\limits_{t \in {k_i}} {{{\left| {S(i) - S(t)} \right|}^2}} } $ | (7) |

其中:i为超像素块标号,ki是与第i个超像素块相邻的所有超像素块集合。局部对比度反映超像素块与相邻区域的差异。作为显著先验,根据条件2) ,除了图像边界与图像中物体的边界区域,其余超像素块与邻接超像素块的差异应当较小,因此Clocal较小。Clocal太大说明显著区域不集中,或显著区域内部的显著值相差过大。最后,定义全局显著对比度:

| ${C_{{\rm{global}}}} = \sum\limits_\delta {\delta {{(i,j)}^2}} {P_\delta }(i,j)$ | (8) |

其中:i,j代表相邻超像素块,δ(i,j)代表相邻超像素块间的灰度差,Pδ(i,j)代表灰度差为δ的超像素块分布率。根据条件3) ,合理的显著先验,显著区域与非显著区域应当对比明显,因此Cglobal应当较大。如果Cglobal太小则说明显著区域与非显著区域区分不明显,不是合理的显著先验。

根据上述定义与分析,显著性期望E应当较小,局部对比度Clocal应该较小,而全局对比度Cglobal应该较大,因此定义估计置信度:

| $p = {C_{{\rm{global}}}}/\left( {{C_{{\rm{local}}}} \times E} \right)$ | (9) |

置信度p越大,说明该显著先验越合理,反之则越不合 理。分别算出4张背景显著估计的置信度ptop、pleft、pbottom、pright,并将背景显著估计通过带权加法融合:

| ${S_{{\rm{bg}}}} = \sum\limits_i {{p_i}{S_i}} $ | (10) |

其中i∈{top,left,bottom,right}。与之前算法相比,带权相加的方式能在相同准确率情况下获得更高的召回率。

2.5 前景显著估计Sbg是从边界先验的角度得到的初步的显著性图。根据前文所述,前景区域在图中有较高的显著值。由于经过对比度优化,前景区域的显著性会提高,因此,本文不再使用平均灰度值作为选取前景的依据,而是根据实验结果,设计了新的阈值:

其中:mean(Sbg)代表Sbg的均值,max(Sbg)代表Sbg中的最大值。该阈值使得相同召回率情况下,准确率更高。根据阈值得到新的指示变量y,显著度大于阈值的超像素块标记为前景,yi=1; 小于阈值的标记为背景,yi=0。按照式(3) 对整张图进行流形排序,得到像素块最终的显著性值::

| ${S_{f{\rm{g}}}}(i) = \overline {{\mathit{\boldsymbol{f}}^*}} (i)$ | (12) |

其中 f*表示归一化后的f*。通过归一化,每个超像素块得到最终的显著性值。此时再将每个超像素块的显著性值赋给相应超像素块中的每个像素点,即得到最终的视觉显著性图。

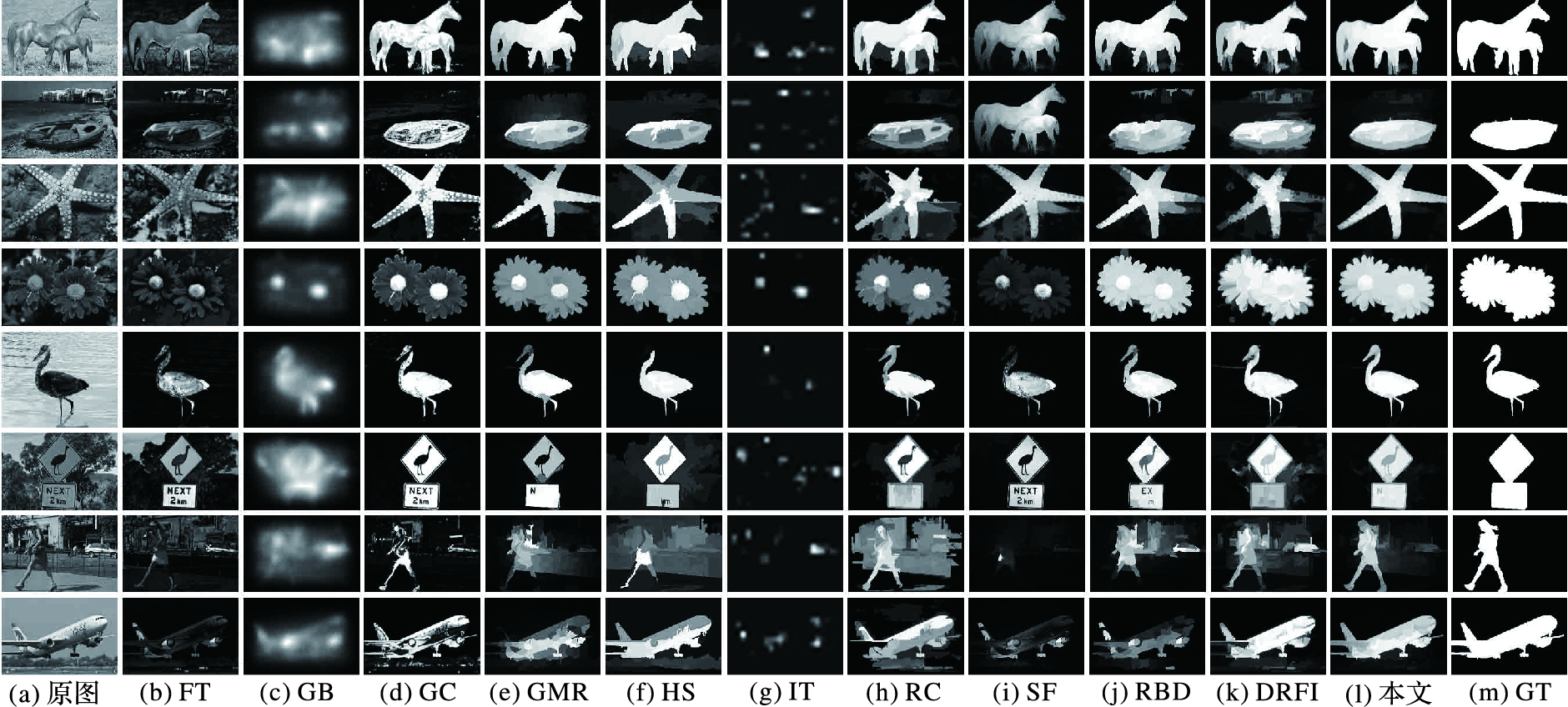

3 实验结果及分析本文将提出的算法在MSRA、ECSSD,大连理工-欧姆龙显著性数据集(DUT-OMRON)[23]以及帕斯卡显著性数据集(PASCAL-S)[29]四个公开数据集上测试,并与近年来的12种算法相比较。这12种算法分别是显著性快速分析模型(Saliency-Based Visual Attention for Rapid Scene Analysis,IT)[1]、基于引导学习的显著性检测算法(Bootstrap Learning,BL)[6]、基于全局对比度的显著区域检测(Global contrast based salient region detection,RC)[7]、基于鲁棒背景检测的显著性优化(Robust Background Detection,RBD)[8]、层次显著性检测(Hierarchical Saliency detection,HS)、基于对比度的显著区域过滤算法(Saliency Filter,SF)[17]、基于图的流形排序(Graph based Manifold Ranking,GMR)[23]、基于细胞自动机的显著性检测算法(Saliency Detection via Celluar Automata,BSCA)[26]、显著区域特征融合算法(Discriminative Regional Feature Integration,DRFI)[28]、频域协调显著检测(Frequency-Tuned,FT)[30]、基于图的显著性检测(Graph-Based,GB)[31]和软图像抽取(Soft Image Abstraction,GC)[32]。通过图 4可以看出本文算法得出的显著区域与真实值(Ground Truth,GT)接近,噪声明显少于其他算法,显著区域灰度值更均匀。

|

图 4 部分算法显著性检测结果对比 Figure 4 Comparison of saliency detection results of some algorithms |

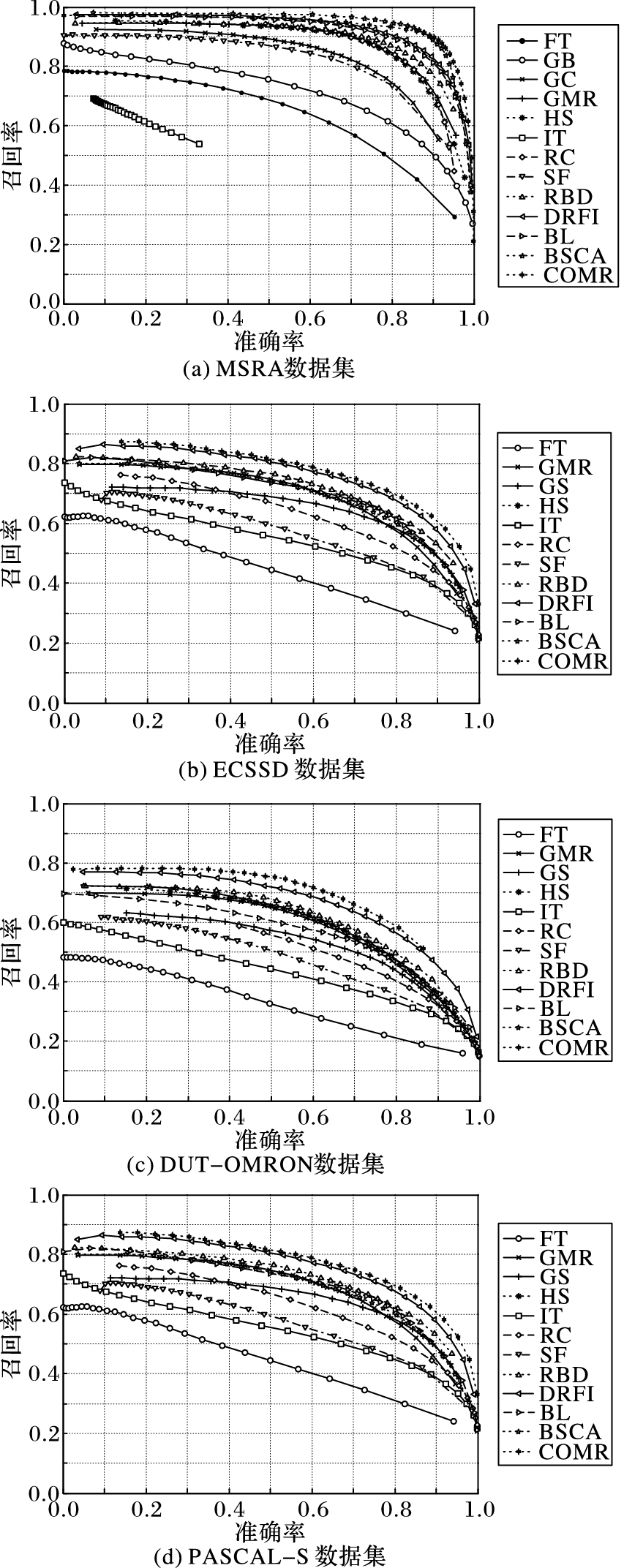

准确率-召回率(Precision-Recall,PR)曲线是评价算法效果最常用的手段。通过固定阈值,得到256张二值图,将结果与真实值(Ground-Truth,GT)比较就能得到相应的PR曲线(图 5)。

|

图 5 准确率-召回率曲线 Figure 5 Precision-Recall curve |

从图 5所示的PR曲线可以看出,本文算法COMR在MSRA上领先其他算法,与DRFI以及BSCA基本持平,在高准确率要求的情况下,本文算法的召回率比DRFI与BSCA高。 在ECSSD数据集上,本文算法仅次于DRFI,但该算法与改进前的GMR相比,有显著提升,同时优于效果较好的非机器学习算法RBD,以及基于细胞自动机的显著性检测算法BSCA。在DUT-OMRON及PASCAL-S数据集上,该算法的表现超过了包括DRFI、BL等机器学习算法在内的其他所有方法。

3.2 F-值分析通常,准确率和召回率不能单独用来评价显著性图的质量,因此,本文用F-measure值对准确率和召回率进行加权调和平均,以此来判断算法质量:

| ${F_\beta } = \frac{{(1 + {\beta ^2})Precision \times Recall}}{{{\beta ^2}Precision + Recall}}$ |

其中β2=0.3,Fβ越高说明算法效果越好。从表 1可以看出,本文算法在ECSSD上的F-measure值仅次于DRFI,比其他所有算法的F-measure值高。在MSRA上,本文算法的F-measure值高于其他算法。结合多个数据集的准确率-召回率曲线,说明本文算法在效果及适应性方面,优于已有的多种算法。

| 表 1 不同数据集测试数据比较 Table 1 Comparison of test data of different data sets |

除了PR曲线,本文利用固定阈值的方法算出假阳性(FP)率和真阳性(TP)率,得到受试者工作特征(Receiver Operating Characteristics,ROC)曲线。计算ROC曲线与坐标轴围成的面积AUC(Area Under Curve)。MAE是显著图与真实值之间的均方误差。这两个指标是衡量显著性算法效果和稳定性的重要指标。分别比较这些算法的AUC与MAE,通过比较发现本文算法的AUC仅次于DRFI,高于同类型算法GMR、BRD、BSCA等。在MSRA上,本文算法的MAE已经比DRFI小,也小于同类型算法GMR、BRD、BSCA。这说明本文的算法在多个数据库的不同指标上领先于多种现有的算法。

3.4 算法效率比较在Intel Xeon E5645 2.4GHz CPU,8 GB RAM,SSD硬盘的运行环境下,测试了12种算法对每张图的平均处理时间。

从表 2可以看出,本文算法的运行时间适中,比大多数算法消耗的时间少,尤其是对于效果较好的DFRI算法以及较新的BSCA算法,本文算法速度几乎是它们的3倍。对于速度较快的算法,例如FT,本文算法效果遥遥领先。同类型算法GMR、RBD的时间开销与本文算法接近,但从图 4以及各项效果指标可以看出,本文算法优于这两种算法。

| 表 2 算法效率比较 Table 2 Algorithm efficiency comparison |

本文针对目前基于先验的显著性算法中先验选取不合理或不准确的情况,提出利用局部对比度与全局对比度的关系优化先验融合过程的显著性物体检测算法:

1) 在预处理阶段改进了超像素块分割策略,使预处理时间缩短,增加超像素块分割个数,使算法精确度提升。

2) 设计了显著期望、全局对比度以及局部对比度三个指标,判断显著估计的置信度,帮助找出合理的显著先验。

3) 改进了显著估计的融合方式,利用显著置信度及带权加法替代之前的简单乘法,使得到的显著性估计的召回率提升。

4) 在前景显著估计中设计了新的阈值选取策略,使得到的最终结果具有更高的准确率。

5) 通过一系列在公开数据集上的测试,验证了该算法的正确性,效果及性能。效果方面超过了原算法GMR,数据指标超过多种算法,并在性能方面领先于深度学习DRFI算法以及新算法BL、BSCA等。

实验结果表明,在准确找到前景区域的前提下,基于先验的显著物体检测算法能够达到更好的效果。通过对比度优化与改进显著融合方式,本文算法能得到恰当的前景区域,最终获得清晰、完整、准确的显著性图。

当然,由于本文算法依赖于超像素块分割以及边界先验,因此对于显著物体过于靠近图像边界,图像中显著性物体多、分布零散,以及显著性物体占据图像绝大多数区域的情况,仍存在不足。我们会在后续研究中,逐步改善这些问题,进一步提高算法效果。

| [1] | ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20 (11) : 1254-1259. doi: 10.1109/34.730558 |

| [2] | BORJI A, SIHITE D N, ITTI L. Probabilistic learning of task-specific visual attention[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:470-477. |

| [3] | FRINTROP S, BACKER G, ROME E. Goal-directed search with a top-down modulated computational attention system[M]//Pattern Recognition, LNCS 3663. Berlin:Springer, 2005:117-124. |

| [4] | GAO D, VASCONCELOS N. Discriminant saliency for visual recognition from cluttered scenes[J]. Advances in Neural Information Processing Systems, 2004, 17 : 481-488. |

| [5] | TONG N, LU H, XIANG R, et al. Salient object detection via bootstrap learning[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:1884-1892. |

| [6] | ACHANTA R, ESTRADA F, WILS P, et al. Salient region detection and segmentation[M]//Computer Vision Systems, LNCS 5008. Berlin:Springer, 2008:66-75. |

| [7] | CHENG M M, ZHANG G X, MITRA N J, et al. Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37 (3) : 569-582. doi: 10.1109/TPAMI.2014.2345401 |

| [8] | ZHANG W, WANG Z, YAN C, et al. Saliency optimization from robust background detection[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2014:2814-2821. |

| [9] | 蒋娇, 陆平, 朱恒亮, 等. 融合对比度与背景先验的显著目标检测算法[J]. 计算机辅助设计与图形学学报, 2016, 28 (1) : 82-89. ( JIANG J, LU P, ZHU H L, et al. Salient object detection using contrast and background priors[J]. Journal of Computer-Aided Design and Computer Graphics, 2016, 28 (1) : 82-89. ) |

| [10] | 王晨, 樊养余, 李波, 等. 基于滤波合成的关键显著性目标检测方法[J]. 计算机应用, 2014, 34 (12) : 3531-3535. ( WANG C, FAN Y Y, LI B, et al. Key salient object detection based on filtering integration method[J]. Journal of Computer Applications, 2014, 34 (12) : 3531-3535. ) |

| [11] | 葛涛, 冯松鹤. 基于层次和动态阈值的图像显著区域检测方法[J]. 计算机应用, 2006, 26 (11) : 2721-2723. ( GE T. FENG S H. A method for image salient regions detection based on layer and dynamic threshold[J]. Journal of Computer Applications, 2006, 26 (11) : 2721-2723. ) |

| [12] | 赵三元, 李凤霞, 沈建冰, 等. 基于红黑小波的图像显著性检测[J]. 计算机辅助设计与图形学学报, 2014, 26 (10) : 1789-1793. ( ZHAO S Y, LI F X, SHEN J B, et al. Image saliency detection using red-black wavelet[J]. Journal of Computer-Aided Design and Computer Graphics, 2014, 26 (10) : 1789-1793. ) |

| [13] | 柳欣, 钟必能, 张茂胜, 等. 基于张量低秩恢复和块稀疏表示的运动显著性目标提取[J]. 计算机辅助设计与图形学学报, 2014, 26 (10) : 1753-1763. ( LIU X, ZHONG B N, ZHANG M S, et al. Motion saliency extraction via tensor based low-rank recovery and block-sparse representation[J]. Journal of Computer-Aided Design and Computer Graphics, 2014, 26 (10) : 1753-1763. ) |

| [14] | 胡正平, 孟鹏权. 全局孤立性和局部同质性图表示的随机游走显著目标检测算法[J]. 自动化学报, 2011, 37 (10) : 1279-1284. ( HU Z P, MENG P Q. Graph presentation random walk salient object detection algorithm based on global isolation and local homogeneity[J]. Acta Automatica Sinica, 2011, 37 (10) : 1279-1284. ) |

| [15] | WANG L, LU H, RUAN X, et al. Deep networks for saliency detection via local estimation and global search[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:3183-3192. |

| [16] | YANG J. Top-down visual saliency via joint CRF and dictionary learning[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:2296-2303. |

| [17] | PERAZZI F, KRÄHENBÜHL P, PRITCH Y, et al. Saliency filters:contrast based filtering for salient region detection[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:733-740. |

| [18] | FRINTROP S, WERNER T, GARCIA G M. Traditional saliency reloaded:a good old model in new shape[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:82-90. |

| [19] | GONG C, TAO D, LIU W, et al. Saliency propagation from simple to difficult[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:2531-2539. |

| [20] | GOPALAKRISHNAN V, HU Y, RAJAN D. Random walks on graphs to model saliency in images[C]//Proceeding of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2009:1698-1705. |

| [21] | JIANG B, ZHANG L, LU H, et al. Saliency detection via absorbing Markov chain[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2013:1665-1672. |

| [22] | REN Z, HU Y, CHIA L T, et al. Improved saliency detection based on superpixel clustering and saliency propagation[C]//Proceedings of the 18th ACM International Conference on Multimedia. New York:ACM, 2010:1099-1102. |

| [23] | YANG C, ZHANG L, LU H, et al. Saliency detection via graph-based manifold ranking[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:3166-3173. |

| [24] | ZHOU D, WESTON J, GRETTON A, et al. Ranking on data manifolds[J]. Advances in Neural Information Processing Systems, 2004, 16 : 169-176. |

| [25] | LI C, YUAN Y, CAI W, et al. Robust saliency detection via regularized random walks ranking[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:2710-2717. |

| [26] | QIN Y, LU H, XU Y, et al. Saliency detection via cellular automata[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:110-119. |

| [27] | ACHANTA R, SHAJI A, SMITH K, et al. Slic superpixels[EB/OL].[2016-01-07]. https://infoscience.epfl.ch/record/149300/files/SLIC_Superpixels_TR_2.pdf?version=2. |

| [28] | JIANG H, WANG J, YUAN Z, et al. Salient object detection:a discriminative regional feature integration approach[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:2083-2090. |

| [29] | LI Y, HOU X, KOCH C, et al. The secrets of salient object segmentation[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2014:280-287. |

| [30] | ACHANTA R, HEMAMI S, ESTRADA F, et al. Frequency-tuned salient region detection[C]//Proceeding of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2009:1597-1604. |

| [31] | HAREL J, KOCH C, PERONA P. Graph-based visual saliency[C]//Advances in Neural Information Processing Systems. Cambridge, MA:MIT Press, 2006:545-552. |

| [32] | CHENG M M, WARRELL J, LIN W Y, et al. Efficient salient region detection with soft image abstraction[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2013:1529-1536. |