铝电解生产是一系列复杂的电化学反应过程,且具有高温、强辐射、强腐蚀等特点,因此过程参数的在线测量一直是铝电解生产中的一个重要问题[1]。为了解决这一时滞问题,一种方法是采用软测量技术。软测量是通过在可测参数与不可测参数间构建非线性数学模型,以可测数据为基础实现对不可测参数的估计。随着铝电解生产与检测装备的自动化与信息化水平的不断提升,铝电解厂中累积了大量的生产数据,这为软测量建模提供了数据基础,因此,软测量方法[2]中基于数据驱动的建模方法在铝电解中取得了巨大成功,其中应用较为广泛的是反向传播网络(Back-Propagation Network,BP Network)[3-4]和支持向量机(Support Vector Machine,SVM)[5-6]。极限学习机(Extreme Learning Machine,ELM)是近年来由Huang等[7]提出的一种针对单隐层前馈神经网络的新算法。由于ELM只需要设定隐层节点的个数,无需调整输入权值和隐含层偏置,从而大幅度缩短了网络的训练时间[8]。Han等[9]通过大量实验表明ELM比BP神经网络和SVM具有更快的训练速度和更好的泛化能力,因此,极限学习机近年来在软测量领域开始得到大量的应用[10-12]。

虽然ELM是一种非常简单且快速的神经网络算法,但若直接将ELM应用于铝电解工艺参数建模中,仍存在一些问题:首先,采集的铝电解数据具有高维、非线性和冗余信息多等特点[13],因此需要较多的隐层节点,不利于ELM的H矩阵满足列满秩,从而降低ELM的建模精度;其次,由于铝电解生产中电解槽的状态不断变化,可能导致各种过程参数大幅度地波动,使得ELM网络的泛化能力和稳定性降低。

由此,本文提出一种基于改进极限学习机(Improved Extreme Learning Machine,IELM)的软测量建模方法。为了解决ELM在处理高维数据存在的问题,利用粗糙集属性约简理论删除输入变量中的冗余属性和不相关的属性,得到对分子比重要的辅助变量,从而降低ELM网络的输入复杂性;同时,为了提高ELM网络的泛化能力,利用偏相关系数对ELM网络的输入部分进行分块处理,将对输出作用相同的数据放在一起重新建立ELM网络结构,提高ELM网络的学习性能。最后利用改进的ELM方法对铝电解中的分子比建立了软测量模型。实验表明,本文提出的建模方法具有较高的预测精度和泛化能力。为了验证本文方法的有效性和鲁棒性,本文在4个UCI标准数据集上进行了测试。

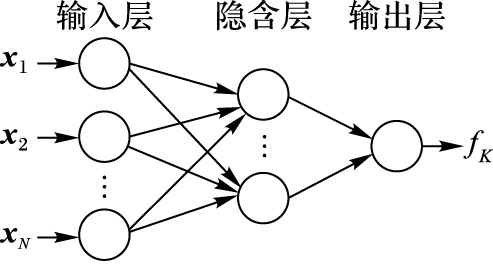

1 改进的极限学习机方法 1.1 传统ELM算法对于N个不同的样本(xi,ti)∈[Rm×Rn],具有K个隐含层节点的ELM输出可以表示为:

| ${{f}_{K}}\left( \mathit{\boldsymbol{x}} \right)=\sum\limits_{j=1}^{K}{{{\mathit{\boldsymbol{ }}\!\!\beta\!\!\rm{ }}_{j}}}{{g}_{j}}\left( {{\mathit{\boldsymbol{x}}}_{i}} \right)=\sum\limits_{j=1}^{K}{{{\mathit{\boldsymbol{ }}\!\!\beta\!\!\rm{ }}_{j}}}g\left( {{\mathit{\boldsymbol{a}}}_{j}}\cdot {{\mathit{\boldsymbol{x}}}_{i}}+{{b}_{j}} \right)$ | (1) |

xi=[xi1,xi2,…,xim]T∈Rm(i=1,2,…,N),ti=[ti1,ti2,…,tin]T∈Rn,aj=(aj1,aj2,…,ajm)T是输入节点与第j个隐含层节点的连接权值,bj是第j个隐含层节点的阈值,βj=(βj1,βj2,…,βjm)T是第j个隐含层节点与输出层节点的连接权值,g(·)是隐含层的激活函数。

对于给定的K个隐含层节点和激活函数,若存在βj,aj和bj使得该单隐层神经网络能以接近0的误差逼近样本的期望值tn,由式(1) 可得一个线性的方程组:

| $\mathit{\boldsymbol{H}}\mathit{\boldsymbol{\beta }} = \mathit{\boldsymbol{T}}$ | (2) |

其中:

| $\mathit{\boldsymbol{H}}={{\left[ \begin{array}{*{35}{l}} g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{K}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{K}} \right) \\ g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{K}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{K}} \right) \\ \vdots & \vdots & {} & \vdots \\ g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{K}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{K}} \right) \\ \end{array} \right]}_{N\times K}}$ |

H叫作网络的隐含层输出矩阵,输出权值β则可以由式(3) 得到:

| $\mathit{\boldsymbol{\hat \beta }} = {\mathit{\boldsymbol{H}}^ + }\mathit{\boldsymbol{T}}$ | (3) |

其中H+表示H的Moore-Penrose广义逆[14]。

因此,传统ELM算法的步骤可以概括为:

1) 随机设定输入层的连接权值aj和bj,其中j=1,2,…,K;

2) 计算网络隐含层的输出矩阵H;

3) 根据式(3) 计算网络输出层的权值。

|

图 1 原始ELM网络结构 Figure 1 Original ELM network architecture |

传统的ELM算法没有对输入数据与输出数据之间的关系进行分析,输入数据之间是杂乱无章的,这样不利于网络的训练。文献[15]提出利用简单相关系数将输入变量与输出变量之间的关系分为正关系和负关系,根据正、负关系将输入数据分为两部分,并分别对这两部分输入建立局部的输入单元,以此建立的ELM网络的性能得到了一定的提高。然而,当输入变量是多个的时候,简单相关系数会受其他变量的影响,这时它反映的仅是两个变量之间表面的非本质的联系。此时根据简单相关系数会对ELM网络的输入数据进行错误的划分,因此,本文提出利用偏相关系数来表征输入数据与输出数据之间的关系。

偏相关系数是在控制其他变量影响的情况下计算多个变量中某两个变量之间线性相关的程度,它反映了两个变量之间的本质线性关系[16]。利用偏相关系数可以对ELM网络的输入、输出变量之间的正负关系进行精准的判断,从而对输入数据进行正确地划分。偏相关系数的定义[17]如下:

对于给定的变量组{X1,X2,…,Xp},它们之间的相关系数矩阵表示为:

| ${{\mathit{\boldsymbol{R}}}_{e}}=\left[ \begin{array}{*{35}{l}} {{r}_{11}} & {{r}_{12}} & \cdots & {{r}_{1p}} \\ {{r}_{21}} & {{r}_{22}} & \cdots & {{r}_{2p}} \\ \vdots & \vdots & {} & \vdots \\ {{r}_{p1}} & {{r}_{p2}} & \cdots & {{r}_{pp}} \\ \end{array} \right]$ | (4) |

其中rij表示变量Xi与Xj的简单相关系数,则对于任意i和j(i,j=1,2,…,p),变量Xi与Xj在控制其他变量的条件下的偏相关系数表示为:

| $\begin{align} & \rho \left( {{X}_{i}},{{X}_{j}}|{{X}_{1}},{{X}_{2}},\cdots {{X}_{i-1}},{{X}_{i+1}},{{X}_{j-1}},{{X}_{j+1}},\cdots ,{{X}_{p}} \right)= \\ & \frac{-{{\Delta }^{ij}}}{\sqrt{{{\Delta }^{ii}}}\sqrt{{{\Delta }^{jj}}}} \\ \end{align}$ | (5) |

其中:Δij、Δii、Δjj分别为|Re|中元素rij、rii、rjj的代数余子式。

利用式(5) 可以分别计算软测量模型中各个输入属性与输出属性之间的偏相关系数。若ρ>0,则表示输入属性与输出属性之间呈现正相关,称为正输入属性,说明输入属性对输出属性的作用是正向的:如果输入属性的值增大,则输出属性的值也会相应地增大。若ρ<0,则表示输入属性与输出属性之间呈现负相关,称为负输入属性,说明输入属性对输出属性的作用是反向的:如果输入属性的值增大,则输出属性的值会相应地减小;如果输入属性的值减小,则输出属性的值会相应地增大。以此可以将输入数据分为正输入和负输入两部分。

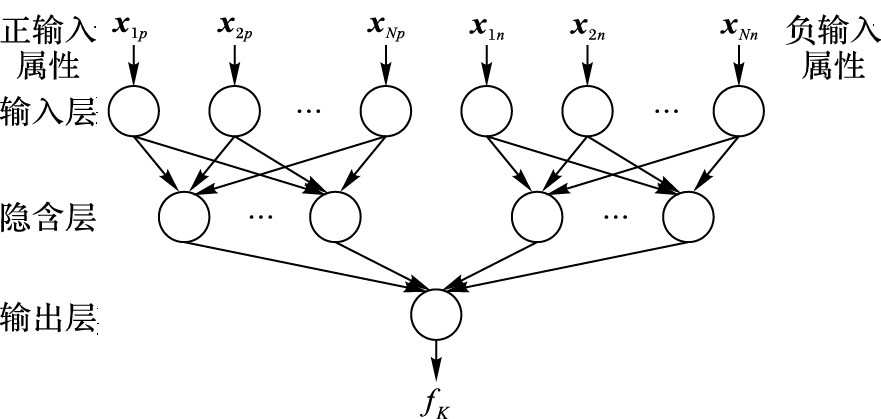

通过对输入数据进行分块处理,将对输出变量作用相同的数据放在一起,分别对各自的输入模块设置隐含层节点,可以有效减少ELM网络输入权值的连接个数,从而解决传统ELM因隐含层节点过多而不能保证ELM的H矩阵列满秩的问题。此外,分开对正、负输入模块进行训练,可以进一步提高网络的学习性能。改进后的ELM网络结构如图 2所示。

|

图 2 改进ELM网络结构 Figure 2 Improved ELM network architecture |

由于采集的铝电解数据具有高维、非线性和冗余信息多等特点,为了降低输入数据的维数和剔除不重要的变量,本文利用粗糙集属性约简算法对输入数据进行预处理。

粗糙集理论是1982年由波兰科学家Pawlak等[18]提出的,它是处理不精确或不完全信息分类问题的一种重要方法。它的突出优点是具有很强的定性分析能力,即通过依赖于集合的上下近似的概念来发现数据集合中数据之间的依赖关系。目前粗糙集在基于数据的决策与分析、机器学习、模式识别等计算机领域取得了大量的成功,而利用粗糙集模型进行各项应用研究也已正成为粗糙集的一个研究热点[19]。

属性约简是粗糙集理论中的一个重要研究内容,它定义为在保持决策表决策属性和条件属性之间的依赖关系不发生变化的前提下消除冗余的关系。属性约简的意义在于将信息系统中与知识分类不相关或不重要的属性删除掉,从而降低信息系统的复杂性。经过属性约简后,得到的则是与决策属性依赖性高的条件属性。

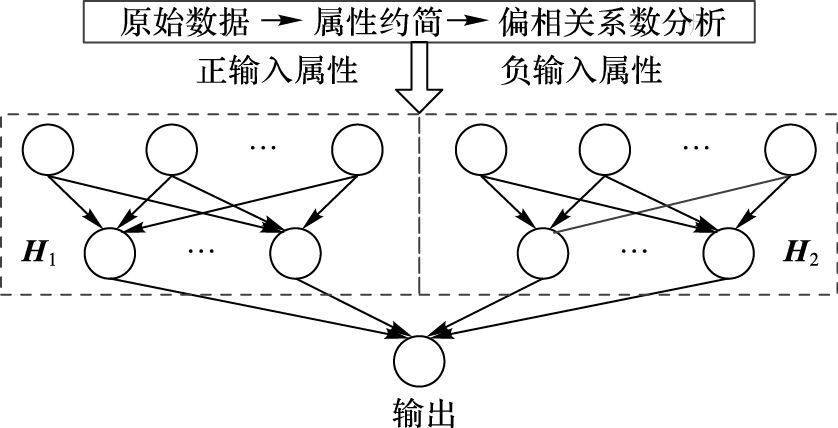

因此,在构建ELM网络之前,本文采用粗糙集的一般属性约简算法[20]对输入数据进行处理,其目的是为了得到合理的输入变量并且降低ELM网络的输入复杂性。由此,本文建立软测量模型的整体过程如图 3所示。

|

图 3 建模过程 Figure 3 Modeling process |

由图 3可知,建模过程可分为以下几个步骤:

1) 输入样本数据集预处理。按照具体的需求,对样本数据的属性进行处理将之转换成粗糙集的数据格式,如归一化或连续值离散化处理等。

2) 利用粗糙集属性约简算法对样本数据集进行属性约简处理,得到软测量模型的辅助变量。

3) 利用式(5) 对输入变量与输出变量进行偏相关性分析,从而确定正相关输入变量和负相关输入变量,分别记为: xp∈RN×m1和xo∈RN×m2。m1表示正输入变量的个数,m2表示负输入变量的个数,则m1+m2=m。

4) 将得到的正相关输入变量放到ELM网络的正输入部分,同样地将负相关输入变量放到ELM网络的负输入部分。

5) 对正输入模块和负输入模块设置隐含层节点个数, 分别记为k1和k2,则正输入模块的网络连接权值可以表示为aj1p=(aj11,aj12,…,aj1m1)T(j1=1,2,…,k1),而隐含层节点的阈值表示为βj1p=(βj11,βj12,…,βj1m1)T(j1=1,2,…,k1)。同样地,负输入模块的网络连接权值可以表示为aj2o=(aj21,aj22,…,aj2m2)T(j2=1,2,…,k2),隐含层节点阈值表示为βj2o=(βj21,βj22,…,βj2m2)T(j2=1,2,…,k2)。

6) 计算正输入模块隐含层的输出矩阵H1和负输入模块隐含层的输出矩阵H2,其中:

| $\begin{align} & {{\mathit{\boldsymbol{H}}}_{1}}={{\left[ \begin{array}{*{35}{l}} g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{{{k}_{1}}}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{{{k}_{1}}}} \right) \\ g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{{{k}_{1}}}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{{{k}_{1}}}} \right) \\ \vdots & \vdots & {} & \vdots \\ g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{{{k}_{1}}}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{{{k}_{1}}}} \right) \\ \end{array} \right]}_{N\times {{k}_{1}}}} \\ & {{\mathit{\boldsymbol{H}}}_{2}}={{\left[ \begin{array}{*{35}{l}} g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{{{k}_{2}}}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{{{k}_{2}}}} \right) \\ g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{2}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{{{k}_{2}}}}\cdot {{\mathit{\boldsymbol{x}}}_{1}}+{{b}_{{{k}_{2}}}} \right) \\ \vdots & \vdots & {} & \vdots \\ g\left( {{\mathit{\boldsymbol{a}}}_{1}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{1}} \right) & g\left( {{\mathit{\boldsymbol{a}}}_{2}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{2}} \right) & \cdots & g\left( {{\mathit{\boldsymbol{a}}}_{{{k}_{2}}}}\cdot {{\mathit{\boldsymbol{x}}}_{N}}+{{b}_{{{k}_{2}}}} \right) \\ \end{array} \right]}_{N\times {{k}_{2}}}} \\ \end{align}$ |

最后将它们合并为一个矩阵,即为网络隐含层最终的输出矩阵H=[H1H2]。

7) 根据式(3) 计算得到隐含层与输出层的权值。

8) 计算得到软测量模型的输出结果。

3 实验仿真为了验证本文方法的有效性和合理性,本文对铝电解分子比建立了软测量模型,同时选取UCI数据库中的4个数据集进行了测试。

为了定量对所建模型的训练效果和预测精度进行评价,本文采用均方根误差(Root Mean Square Error,RMSE)作为性能指标。计算公式如下:

| $RMSE=\sqrt{\frac{1}{n}\sum\limits_{i=1}^{n}{{{\left( {{y}_{i}}-{{{\hat{y}}}_{i}} \right)}^{2}}}}$ | (6) |

其中:n为测试样本的个数,yi为第i个样本的真实值,

在铝电解生产过程中,电解质的组成对铝电解生产的经济指标具有重要影响,降低电解质分子比是提高铝电解电流效率的有效途径[21]。目前,在铝厂中分子比的测定主要还是采用人工取样分析,取样周期一般是3 d,因此,分子比的测量具有滞后性。在电解槽运行过程中,工人通常是凭自己的经验来对分子比的高低情况进行判断,显然容易出现误差,因此,对分子比建立软测量模型具有重要的现实意义。本文选取某铝厂某电解槽165 d的历史数据,其中135组作为训练数据,30组作为测试数据。由于铝电解数据具有多变量、非线性的特点,因此影响分子比的变量具有不确定性,因此本文将采集数据中的变量都作为候选辅助变量,包括工作电压、电压差、下料量、氟盐量、电解质水平、铝水平、出铝量、硅含量、槽温等18个变量,输出变量则是分子比。

首先利用粗糙集一般属性约简算法进行处理,得到分子比软测量模型最终的辅助变量,包括电压差、下料量、氟盐量、电解质水平、出铝量、硅含量、钒含量、氟化钾和锂盐,并对它们进行标号为1,2,…,9。这里利用粗糙集约简理论不仅对辅助变量中冗余信息进行了剔除,而且还对影响分子比的变量进行了选取。然后利用偏相关系数对这9个输入属性与分子比的正负关系进行分析,得到2个正输入属性,它们的标号为:1和8,剩余的7个即为负输入属性。而利用文献[15]提出的划分方式则得到3个正输入属性,它们的标号为:4,5,8,剩余的6个为负输入属性。由此可以看出利用偏相关系数和简单相关系数对输入属性的划分结果不相同。最后,分别与BP神经网络、SVM、传统ELM和文献[15]提出的方法(C-ELM)进行对比,实验结果如表 1和表 2所示。

| 表 1 分子比仿真结果对比1 Table 1 Simulation result 1 of molecular ratio |

| 表 2 分子比仿真结果对比2 Table 2 Simulation result 2 of molecular ratio |

本文方法与BP神经网络、SVM和ELM的对比结果如表 1所示。从表 1可以看出:BP神经网络不仅训练时间最长,而且还出现了严重的过拟合问题;而SVM虽然泛化能力较好,但是训练时间也较长;ELM的训练速度快、泛化误差小,说明ELM是一种有效的软测量建模方法;而改进后的ELM相比传统的ELM,在相似的建模精度下能够有效地减少了隐层节点数。

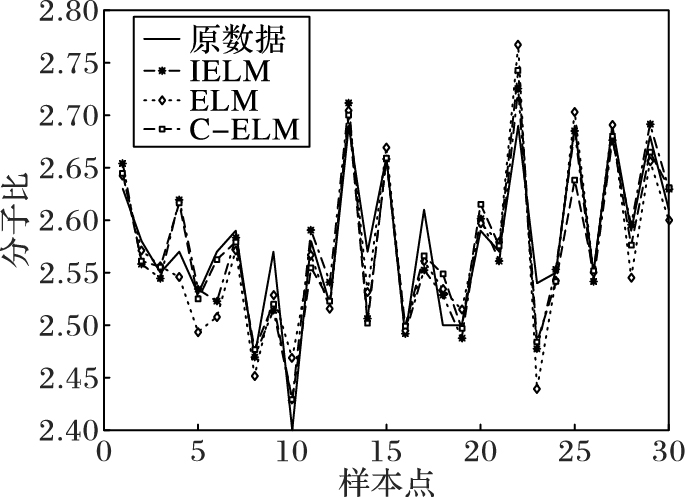

本文方法与文献[15]方法和传统ELM在相同隐层节点数下的对比结果如表 2和图 4所示。从表 2可以看出,本文方法和文献[15]方法通过对ELM的输入模块进行划分重新构建ELM网络均提高了ELM的泛化能力。相比于文献[15]方法,本文方法具有更小的泛化误差。由此验证了在多个输入变量的情况下,利用偏相关系数来表征两个变量之间的正负关系更合理。实验总体结果表明了本文方法的有效性和合理性。

|

图 4 分子比测试结果对比 Figure 4 Comparison of molecular ratio test results |

为了进一步验证本文建模方法的有效性和鲁棒性,本文从UCI公共数据集中选取了4组数据集进行了测试。对每个数据集随机选取其中的2/3作为训练集,剩余1/3作为测试集,数据描述如表 3所示,实验仿真结果如表 4所示。

| 表 3 数据描述 Table 3 Data description |

| 表 4 UCI数据仿真结果 Table 4 UCI data simulation results |

从表 4可以看出,在处理公共数据集时,本文提出的方法较之文献[15]提出的方法和传统的ELM方法也具有更小的泛化误差,而文献[15]方法则出现了降低原始ELM泛化能力的问题,由此验证了本文方法的有效性和鲁棒性。

从上面两组对比实验可以看出,本文利用粗糙集属性约简算法对输入变量中的冗余属性进行剔除,降低了ELM网络的输入复杂性;同时,利用偏相关系数对输入属性与输出属性的正负关系进行正确的判断,克服了文献[15]利用简单相关系数对输入数据进行错误划分而导致ELM泛化能力下降的问题。在处理铝电解数据和UCI公共数据集上,本文方法均取得了较好的效果。

4 结语针对ELM在铝电解工艺参数软测量建模中存在的问题,本文提出了一种改进的极限学习机的软测量建模新方法。首先将粗糙集运用到ELM中,通过对输入变量进行属性约简,降低了ELM的输入量。再者,利用偏相关系数对ELM的输入模块进行了划分,将对输出作用相同的数据放在一起,提高了ELM的学习性能。通过与BP神经网络、SVM、传统ELM和文献[15]方法的对比,实验仿真证明本文提出的方法具有更好的泛化能力和稳定性,证实了该方法的有效性。这为铝电解过程参数的软测量提供了一种有效、可靠的新方法。在此基础上,未来的研究方向是建立针对不同槽况的软测量模型以及完善铝电解数据降维的相关工作。

| [1] | 刘业翔, 李劼. 现代铝电解[M]. 北京: 冶金工业出版社, 2008 : 192 -214. ( LIU Y X, LI J. Modern Aluminum Electrolysis[M]. Beijing: Metallurgical Industry Press, 2008 : 192 -214. ) |

| [2] | SLISKOVIC D, GRBIC R, HOCENSKI Z. Methods for plant data-based process modeling in soft-sensor development[J]. Automatika, 2012, 52 (4) : 306-318. |

| [3] | ZHANG H, KUANG Y, WANG G, et al. Soft sensor model for coal slurry ash content based on image gray characteristics[J]. International Journal of Coal Preparation and Utilization, 2014, 34 (1) : 24-37. doi: 10.1080/19392699.2013.841677 |

| [4] | YAN X, YANG W, MA H, et al. Soft sensor for ammonia concentration at the ammonia converter outlet based on an improved group search optimization and BP neural network[J]. Chinese Journal of Chemical Engineering, 2012, 20 (6) : 1184-1190. doi: 10.1016/S1004-9541(12)60606-5 |

| [5] | KANEKO H, FUNATSU K. Application of online support vector regression for soft sensors[J]. AICHE Journal, 2014, 60 (2) : 600-612. doi: 10.1002/aic.14299 |

| [6] | YU J. A Bayesian inference based two-stage support vector regression framework for soft sensor development in batch bioprocesses[J]. Computers and Chemical Engineering, 2012, 41 (12) : 134-144. |

| [7] | HUANG G B, ZHU Q Y, SIEW C K. Extreme learning machine:theory and applications[J]. Neurocomputing, 2006, 70 (1/2/3) : 489-501. |

| [8] | DING S, ZHAO H, ZHANG Y, et al. Extreme learning machine:algorithm, theory and applications[J]. Artificial Intelligence Review, 2015, 44 (1) : 103-115. doi: 10.1007/s10462-013-9405-z |

| [9] | HAN F, HUANG D S. Improved extreme learning machine for function approximation by encoding apriori information[J]. Neurocomputing, 2006, 69 (16/17/18) : 2369-2373. |

| [10] | ZHANG H, YIN Y, ZHANG S. An improved ELM algorithm for the measurement of hot metal temperature in blast furnace[J]. Neurocomputing, 2016, 174 : 232-237. doi: 10.1016/j.neucom.2015.04.106 |

| [11] | YANG Y, ZHANG S, YIN Y. A modified ELM algorithm for the prediction of silicon content in hot metal[J]. Neural Computing and Applications, 2016, 27 (1) : 241-247. doi: 10.1007/s00521-014-1775-x |

| [12] | 常玉清, 李玉朝, 王福利, 等. 基于极限学习机的生化过程软测量建模[J]. 系统仿真学报, 2007, 19 (23) : 5587-5590. ( CHANG Y Q, LI Y C, WANG F L, et al. Soft sensing modeling based on extreme learning machine for biochemical processes[J]. Journal of System Simulation, 2007, 19 (23) : 5587-5590. ) |

| [13] | 张旖芮, 阳春华, 朱红求. 基于数据的铝电解槽况分类[J]. 计算机工程与应用, 2015, 51 (11) : 233-237. ( ZHANG Y R, YANG C H, ZHU H Q. Classification of cell states for aluminum electrolysis based on data[J]. Computer Engineering and Applications, 2015, 51 (11) : 233-237. ) |

| [14] | SERRE D. Matrices[M]. New York: Springer, 2002 : 35 . |

| [15] | 贺彦林, 王晓, 朱群雄. 基于主成分分析-改进的极限学习机方法的精对苯二甲酸醋酸含量软测量[J]. 控制理论与应用, 2015, 32 (1) : 80-85. ( HE Y L, WANG X, ZHU Q X. Modeling of acetic acid content in purified terephthalic acid solvent column using principal component analysis based improved extreme learning machine[J]. Control Theory and Applications, 2015, 32 (1) : 80-85. ) |

| [16] | 王海燕, 杨方廷, 刘鲁. 标准化系数与偏相关系数的比较与应用[J]. 数量经济技术经济研究, 2006, 23 (9) : 50-155. ( WANG H Y, YANG F T, LIU L. Comparison and application of standardized regressive coefficient and partial correlation coefficient[J]. The Journal of Quantitative and Technical Economics, 2006, 23 (9) : 50-155. ) |

| [17] | 郝黎仁, 樊元, 郝哲欧. SPSS实用统计分析[M]. 北京: 中国水利水电出版社, 2007 : 184 . ( HAO N R, FAN Y, HAO Z O. Practical Statistical Analysis of SPSS[M]. Beijing: China Water and Power Press, 2007 : 184 . ) |

| [18] | PAWLAK Z, SKOWRON A. Rudiments of rough sets[J]. Information Sciences, 2007, 177 (1) : 3-27. doi: 10.1016/j.ins.2006.06.003 |

| [19] | 王国胤, 姚一豫, 于洪. 粗糙集理论与应用研究综述[J]. 计算机学报, 2009, 32 (7) : 1229-1246. ( WANG G Y, YAO Y Y, YU H. A survey on rough set theory and applications[J]. Chinese Journal of Computers, 2009, 32 (7) : 1229-1246. doi: 10.3724/SP.J.1016.2009.01229 ) |

| [20] | 王国胤. Rough集理论与知识获取[M]. 西安: 西安交通大学出版社, 2001 : 133 -134. ( WANG G Y. Rough Set Theory and Knowledge Acquisition[M]. Xi'an: Xi'an Jiaotong University Press, 2001 : 133 -134. ) |

| [21] | 刘咏, 任凤莲. BP神经网络在铝电解质分子比预报中的应用[J]. 冶金分析, 2006, 26 (4) : 28-31. ( LIU Y, REN F L. Application of BP neural network in prediction of molecular ratio of aluminum electrolyte[J]. Metallurgical Analysis, 2006, 26 (4) : 28-31. ) |