近年来,深度学习引起许多研究者的关注,主要原因在于深度学习拥有从未知目标上自动学习特征的能力,而且其分类性能比传统的分类器更好。深度学习的这种优点被用来处理高维数据以及复杂的音频数据,因此,深度学习在声音识别[1-4]、音频信息检索[5-6]和多媒体分类[7-8]等研究领域具有重要意义。

目前,基于深度学习的方法在声音事件识别方面已有一定的研究。其中,Yu等[9]利用深度神经网络(Deep Neural Network,DNN)提取声音信号的判决内部表示用于声音的分类;Dahl等[10]使用DNN建立了一个上下文相关的模型用于大量词汇的语音识别;McLoughlin等[11]提出基于声谱图的前端特征并结合支持向量机(Support Vector Machine,SVM)和DNN分类声音事件。

但是,训练含有许多隐层的DNN时会产生向更深层传播训练错误的问题。为了解决这个问题,Hinton等[12]提出采用一种无监督学习的贪心逐层训练方式训练神经网络,即深度置信网络(Deep Belief Network,DBN)。该网络训练层采用受限玻尔兹曼机(Restricted Boltzmann Machine,RBM)[13-16]进行无监督学习,然后在网络的顶层采用有监督的反向传播(Back Propagation,BP)网络进行网络参数的微调,更有利于处理高维数据以及复杂的音频数据的识别。关于DBN的研究有:Farahat等[17]提出利用DBN提取语音帧的判决信息,并且采用非线性变换增强特征的抗噪性能;Mohamed等[18]提出利用DBN建立一个声音模型用于语音识别;Guo等[19]提出使用DBN捕获声音事件的时域信息用于音频分类。

然而,真实环境中存在着复杂多变的噪声,尤其是低信噪比(Signal-to-Noise Ratio,SNR),对声音事件识别产生较大的干扰。常用的降低噪声影响的方法有卡尔曼滤波[20]、小波增强[21]、多频带谱减法[22]等。这些方法需要先验地获得待检测信号或噪声信号的统计特性。基于匹配追踪(Matching Pursuit,MP)的方法利用信号的稀疏性,将信号稀疏分解重构进行自适应表示,不需要先验地获得待检测信号和噪声信号的统计特性,适合于各种环境下声音事件的识别。

关于MP的研究主要有:Chu等[23]将MP特征结合Mel频率倒谱系数(Mel Frequency Cepstrum Coefficient,MFCC)特征,用k-最近邻(k-Nearest Neighbor, kNN)和高斯混合模型(Gaussian Mixture Model,GMM)分类器对声音事件进行分类识别;Wang等[24]利用主成分分析(Principal Component Analysis,PCA)和线性判别分析(Linear Discriminant Analysis,LDA)对MP稀疏分解的原子进行降维处理作为声音事件的特征,并用SVM分类器对声音事件进行分类识别;Mallat等[25]提出利用过完备原子字典将原信号进行稀疏分解,通过稀疏逼近重构信号。由于MP在稀疏分解时需要迭代次数较多,收敛较慢,文献[26]在MP的基础上提出正交匹配追踪(Orthogonal Matching Pursuit,OMP)算法,该算法可以在较少的迭代中完成信号的收敛。

OMP稀疏分解在搜索最优原子时存在计算复杂度高的问题。为了实现OMP快速稀疏分解,本文提出基于优化的OMP和DBN声音事件识别方法。首先,从声音事件样本库中选择声音事件,将其分为训练样本集和测试样本集;然后,在保证收敛精度的前提下,采用粒子群优化(Particle Swarm Optimization,PSO)算法对选择的样本进行OMP稀疏分解;接着,对重构信号提取优化的正交匹配追踪(Optimized Orthogonal Matching Pursuit,OOMP)复合特征;最后,使用DBN对OOMP特征进行分类识别。

1 OMP信号稀疏分解OMP算法在MP算法的基础上利用Gram-Schmidt方法将选择的最优原子与已选择原子集合进行正交化处理,以保证在相同精度的前提下,收敛速度更快。

假设待分解信号f,长度为N,在进行OMP稀疏分解前,首先要构造一个过完备字典D=(gγ)γ ∈Г,Г为γ的集合。本文选择的Gabor字典[25]由一个调制的高斯窗函数g(t)=e-πt2构成,

| ${{g}_{\gamma }}\left( t \right)=\frac{1}{\sqrt{s}}g\left( \frac{t-\mu }{s} \right)\text{cos}\left( \upsilon t+\omega \right)$ | (1) |

其中:平移因子μ是原子的中心位置;伸缩因子s、频率因子v和相位因子ω定义原子gγ的波形。实际应用中需要对时-频参数γ=(s,μ,v,ω)进行离散化[25]:

| $\gamma =\left( s,\mu ,\upsilon ,\omega \right)=\left( {{a}^{j}},d{{\text{a}}^{j}}\Delta \mu ,{{k}_{1}}{{\text{a}}^{-j}}\Delta \upsilon ,i\Delta \omega \right)$ | (2) |

其中:0 <j ≤lb(N),0≤d≤2-j+1N,0≤k1 <2j+1,0≤i ≤12,a=2,Δ μ=1/2,Δv=π,Δω=π/6。对于长度N为256的声音信号,过完备字典中包含Num=52(N lb(N)+N-1) =119 756个原子。

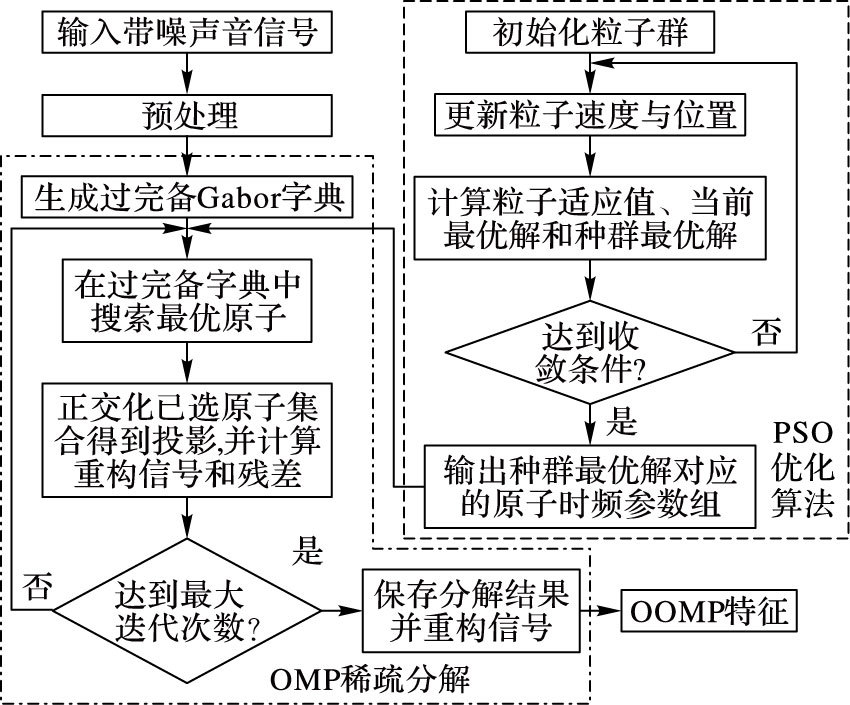

OMP稀疏分解如图 1点划线框部分所示,过程如下:

|

图 1 PSO优化的OMP最优原子搜索过程 Figure 1 OMP optimal atomic search process optimized by PSO |

1) 初始化信号残差R0=f,迭代次数k=1,最大迭代次数kmax,已选原子集合p1=gγ1,归一化后得到u1。

2) 从过完备原子字典D中选出第k次迭代与信号残差最为相关的原子gγk,即内积|〈Rk-1,gγ〉|最大:

| $\left| \left\langle {{\mathit{\boldsymbol{R}}}_{k-1}},{{\mathit{\boldsymbol{g}}}_{{{\gamma }_{k}}}} \right\rangle \right|\ge \alpha \underset{\gamma \in \mathit{\Gamma }}{\mathop{\rm{max}}}\,\left| \left\langle {{\mathit{\boldsymbol{R}}}_{k-1}},{{\mathit{\boldsymbol{g}}}_{\gamma }} \right\rangle \right|$ | (3) |

其中0<α ≤1,表示最优因子。

3) 利用Gram-Schmidt方法将gγk关于已选原子集{gγi}(0 < i ≤k)正交化得到投影pk:

| ${{\mathit{\boldsymbol{p}}}_{k}}={{\mathit{\boldsymbol{g}}}_{{{\gamma }_{k}}}}-\sum\limits_{n=1}^{k-1}{\left\langle {{\mathit{\boldsymbol{g}}}_{{{\gamma }_{k}}}},{{\mathit{\boldsymbol{u}}}_{n}} \right\rangle }{{\mathit{\boldsymbol{u}}}_{n}}$ | (4) |

4) 将残差投影到uk上得到新的残差Rk+1:

| ${{\mathit{\boldsymbol{R}}}_{k+1}}={{\mathit{\boldsymbol{R}}}_{k}}-\left\langle {{\mathit{\boldsymbol{R}}}_{k}},{{\mathit{\boldsymbol{u}}}_{k}} \right\rangle {{\mathit{\boldsymbol{u}}}_{k}}$ | (5) |

5) 若未达到最大迭代次数kmax,设置k=k+1,返回2) ,否则转至6)。

6) 经过逐次迭代稀疏分解得到一系列原子,输出第kmax次的近似原子展开式:

| $\mathit{\boldsymbol{f}}\approx \sum\limits_{k=1}^{{{k}_{\text{max}}}}{\left\langle {{\mathit{\boldsymbol{R}}}_{k}},{{\mathit{\boldsymbol{u}}}_{k}} \right\rangle {{\mathit{\boldsymbol{u}}}_{k}}}$ | (6) |

即对声音信号进行OMP稀疏分解重构。

2 优化的OMP声音事件识别架构 2.1 PSO最优原子搜索策略PSO的基本思想是利用粒子之间的协作与竞争,实现对复杂空间最优解的搜索[27-28]。在每一次的搜索中,粒子通过跟踪两个“极值”来更新自己的信息,一个是当前粒子的极值点;另一个是当前整个粒子种群找到的最优解,即全局极值点。

对OMP稀疏分解,瓶颈主要集中在式(3) 的最优原子搜索过程。为此,利用PSO对最优原子搜索过程进行优化,其流程如图 1虚线框部分所示。

在该优化算法中,将时-频参数组γk=(s,μ,v,ω)作为待优化的参数,对应第k次分解时粒子i在字典空间中所处的位置:

| ${{\mathit{\boldsymbol{x}}}_{i}}\left( k \right)=\left[ {{s}_{i}}\left( k \right),{{\mu }_{i}}\left( k \right),{{\upsilon }_{i}}\left( k \right),{{\omega }_{i}}\left( k \right) \right]$ | (7) |

将时-频原子与第k次分解时信号的残差的内积|〈Rk,gγk〉|作为适应值函数f[xi(k)],用来衡量粒子所处位置的质量。根据粒子群的移动和聚集,得到一个具有最大适应值的位置,即最优原子参数。

PSO优化搜索详细过程如下:

1) 初始化PSO种群规模m,迭代次数k=1,最大迭代次数kmax,搜索范围[xmin,xmax],速度范围[vmin,vmax],随机生成每个粒子i的初始速度和位置,计算初始适应值f[xi(k)],并设置为粒子i的当前个体最优解pbest(i),将最大的pbest(i)设置为种群最优解gbest。

2) 更新每个粒子的速度与位置。判断粒子的速度是否超出界限,如果出界则更新;判断粒子的位置是否在过完备原子字典中,如果不在,则取边界值代替粒子的位置:

| $\begin{array}{l} {\mathit{\boldsymbol{v}}_i}{\rm{(}}k + 1{\rm{)}} = {\alpha _1}\left\{ {w{\mathit{\boldsymbol{v}}_i}} \right.{\rm{(}}k{\rm{)}} + {c_1}r\left[ {{\mathit{\boldsymbol{p}}_{{\rm{best}}}}\left( i \right) - {{\mathit{\boldsymbol{x}}}_i}{\rm{(}}k{\rm{)}}} \right] + \\ {c_2}r\left. {\left[ {{\mathit{\boldsymbol{g}}_{{\rm{best}}}} - {{\mathit{\boldsymbol{x}}}_i}{\rm{(}}k{\rm{)}}} \right]} \right\} \end{array}$ | (8) |

| ${{\mathbf{x}}_{i}}\text{(}k+1\text{)}={{\mathbf{x}}_{i}}\text{(}k\text{)}+{{\mathit{\boldsymbol{v}}}_{i}}\text{(}k+1\text{)}$ | (9) |

其中:α1为收敛因子,α1越大收敛速度越快;c1和c2为学习因子;r为(0,1) 内均匀分布的随机数;w为惯性权重因子,w较大则具有较强的全局搜索能力,较小则倾向于局部搜索。

但是,若w取值太大,可能导致粒子速度过大从而跳过最优解;若w取值太小则可能导致粒子搜索前期收敛速度太慢。本文采用线性惯性权重递减策略,w值随迭代次数线性递减:

| $w={{w}_{\text{max}}}-k\times \left( {{w}_{\text{max}}}-{{w}_{\text{min}}} \right)/{{k}_{\text{max}}}$ | (10) |

3) 为了避免出现局部最优现象,设置变异概率P,对粒子进行位置变异。

4) 计算粒子的适应值f[xi(k+1) ],如果该值优于当前的个体极值点pbest(i),则用当前粒子所处位置更新pbest(i);如果所有粒子中有pbest(i)优于当前的种群最优解gbest,则更新gbest。

5) 如果k>kmax,则终止迭代,输出gbest对应的时-频参数组,即最优原子;否则,令k=k+1,转至2) ,并更新信号或者信号残差。

| ${{\mathit{\boldsymbol{R}}}_{k+1}}={{\mathit{\boldsymbol{R}}}_{k}}-\left\langle {{\mathit{\boldsymbol{R}}}_{k}},{{\mathit{\boldsymbol{u}}}_{k}} \right\rangle {{\mathit{\boldsymbol{u}}}_{k}}$ | (11) |

重复多次上述过程,实现优化的OMP信号稀疏分解,保存分解结果并重构信号。

以重构信号和原始信号的均方误差(Mean Squared Error,MSE)作为衡量重构信号的质量的标准。

| $MSE = \frac{1}{N}\sum\limits_{y = 0}^{N - 1} {{{\left[ {f'{\rm{(}}y{\rm{)}} - f{\rm{(}}y{\rm{)}}} \right]}^2}} $ | (12) |

其中:N为信号长度;y为采样点索引值; f′(y)为重构后的信号; f (y)为原始信号。MSE值越大,重构质量越差;MSE值越小,重构质量越好。

对于长度为256的声音信号,表 1给出了采用原始OMP和优化OMP在稀疏度为20时的稀疏分解计算量。表 1中,原OMP方法的参数设置见文献[25];优化OMP方法中的粒子种群大小为30,最大迭代次数为15。从表 1中可以看出,两种方法之间的MSE相差不大,但是优化OMP在搜索次数和内积计算次数上分别减少了119 306次和2 386 120次,时间上优化OMP仅为原始OMP的1.58%,说明采用PSO优化OMP的方法在保证声音信号重构质量的同时,实现了OMP的快速稀疏分解。

| 表 1 稀疏分解计算比较 Table 1 Comparison of sparse decomposition |

OMP稀疏分解采用的Gabor原子由调制的高斯窗函数构成,而高斯型函数在时域和频域都是局部化的,其局部特性保证了原子时-频参数能够较好地刻画信号的非平稳时变特性。OMP稀疏分解将待提取的有用信息作为稀疏成分,将噪声作为残差成分,对噪声进行低维投影后,噪声不具有稀疏性[29]。在重构信号时,残差部分的噪声很难恢复,从而达到消除噪声成分、增强声音事件信号的目的。

通过优化OMP稀疏分解声音信号,获得表示该信号的时-频参数组γk=(s,μ,v,ω)中伸缩因子s和频率因子v的均值和标准差,构成OMP特征。

| $OMP{\rm{(}}\lambda {\rm{)}} = \left[ {{\rm{mean}}\left( {s,\upsilon } \right),{\rm{std(}}s,\upsilon {\rm{)}}} \right]$ | (13) |

其中λ表示每帧声音信号对应的帧索引。

对于声音信号,重构精度随着稀疏度的增加而不断提升。但是,稀疏度过高,在重构声音信号主体时,噪声信号的重构比例也会相应地提升。所以,在保证重构精度的前提下,笔者经过实验确定OMP稀疏分解在稀疏度为20时重构效果最好。

由于OMP特征维数较少,单独使用OMP特征的识别效果不理想;而MFCC将线性频谱映射到基于听觉感知的Mel非线性频谱中再转换到倒谱上,能够较好地刻画声音特征,但是在噪声环境下,MFCC的性能大幅下降;此外,真实环境中不同声音存在不同的基音频率(Pitch)范围,而Pitch作为特征描述声音具有很好的区分性。针对这些问题,本文除了提取OMP特征外,还提取重构声音信号的MFCC特征和Pitch特征,来补充OMP特征,组成一个OOMP复合特征。

2.3 DBNDBN是由多层受限玻尔兹曼机(RBM)[13-16]组成的概率生成模型,采用贪心逐层无监督学习算法,自底向上地对输入的数据进行提取和抽象,并通过对网络权重值的调整和深层结构的优化实现训练的整体最优,可以有效地表示和训练非线性数据。

2.3.1 受限玻尔兹曼机RBM是由可视层和隐层组成的无向图模型,可视层表示输入数据,隐层是学习可视层输入数据的内在特征的二值表示,可视层和隐层之间通过权值进行连接,而层内是无连接的。根据输入数据类型不同,RBM的能量函数E为:

| $E\left( {v,h|\theta } \right) = - \sum\limits_{i = 1}^{{N_{\rm{V}}}} {\sum\limits_{j = 1}^{{N_{\rm{H}}}} {{w_{ij}}{v_i}{h_j} - \sum\limits_{i = 1}^{{N_{\rm{V}}}} {{b_i}{v_i}} } } - \sum\limits_{j = 1}^{{N_{\rm{H}}}} {{a_j}{h_j}} $ | (14) |

| $E\left( {v,h|\theta } \right) = - \sum\limits_{i = 1}^{{N_{\rm{V}}}} {\sum\limits_{j = 1}^{{N_{\rm{H}}}} {{w_{ij}}{v_i}{h_j} + \frac{1}{2}\sum\limits_{i = 1}^{{N_{\rm{V}}}} {{{{\rm{(}}{v_i} - {b_i}{\rm{)}}}^2}} } } - \sum\limits_{j = 1}^{{N_{\rm{H}}}} {{a_j}{h_j}} $ | (15) |

式(14) 和式(15) 分别表示可视层输入数据类型为二值型和连续型。其中:θ={w,ɑ,b}表示RBM模型的参数;wij表示可视单元i和隐层单元j之间的权重;bi和aj是其偏置项;NV和NH分别是可视单元和隐层单元的数目。

根据能量函数E可以得到可视单元和隐层单元状态的联合概率:

| $p\left( {v,h|\theta } \right) = \frac{1}{{Z\left( \theta \right)}}{\rm{exp}}\left( { - E\left( {v,h|\theta } \right)} \right)$ | (16) |

其中,

| $p\left( {{h_j} = 1|v,\theta } \right) = \sigma \left( {\sum\limits_{i = 1}^{{N_{\rm{V}}}} {{w_{ij}}{v_i} + {a_j}} } \right)$ | (17) |

| $p\left( {{v_i} = 1|v,\theta } \right) = \sigma \left( {\sum\limits_{j = 1}^{{N_{\rm{H}}}} {{w_{ij}}{h_j} + {b_i}} } \right)$ | (18) |

其中σ(x)=1/(1+exp(-x))。

当输入数据类型为连续型时,式 (18) 更新为:

| $p\left( {{v_i} = 1|v,\theta } \right) = N\left( {\sum\limits_{j = 1}^{{N_{\rm{H}}}} {{w_{ij}}{h_j} + {b_i},1} } \right)$ | (19) |

其中N(·)是均值为0、方差为1的高斯分布。

RBM按照梯度下降法[12]进行极大似然学习,即最大化输入的重构概率。为了提高训练速度和减少训练时间,本文采用单步对比散度CD1(Contrastive Divergence)算法[12-13, 17]来逼近梯度。因此,RBM参数按照如下公式进行更新:

| $\Delta {w_{ij}} = \varepsilon \left( {{E_{\rm{d}}}\left( {{v_i}{h_j}} \right) - {E_r}\left( {{v_i}{h_j}} \right)} \right)$ | (20) |

| $\Delta {b_i} = \varepsilon \left( {{E_{\rm{d}}}\left( {{v_i}} \right) - {E_r}\left( {{v_i}} \right)} \right)$ | (21) |

| $\Delta {a_j} = \varepsilon \left( {{E_{\rm{d}}}\left( {{h_j}} \right) - {E_r}\left( {{h_j}} \right)} \right)$ | (22) |

其中:ε表示学习率;Ed(vihj)表示训练数据集的期望;Er(vihj)表示采用CD1算法计算出的样本分布的期望。

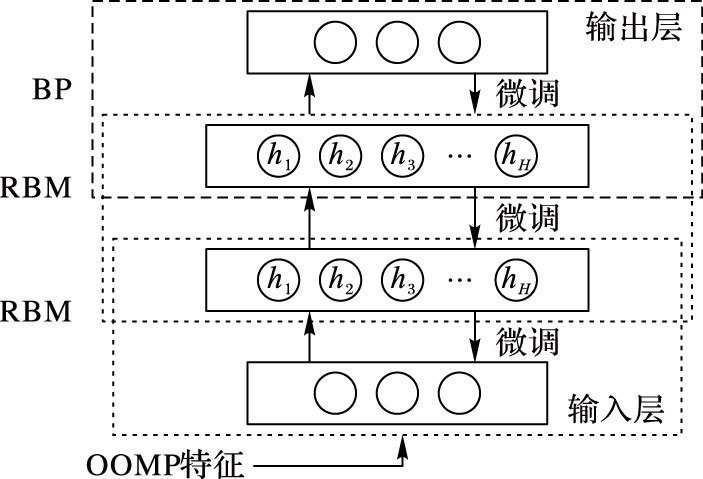

2.3.2 DBN构建通过对多层RBM的学习,前一层RBM隐层的输出作为下一层RBM可视层的输入,并在最后一层采用BP网络进行微调,微调的目的是调整DBN模型参数,从而优化模型的分类性能。因此,本文构建一个经过RBM无监督学习和BP有监督微调的DBN模型架构,具体如图 2所示。

|

图 2 DBN模型 Figure 2 DBN model |

DBN训练过程主要有两个步骤:

1) 根据输入的OOMP特征自底向上地训练RBM;

2) 根据1) 的训练结果,采用BP算法对整个DBN结构进行参数的微调,使其更有利于分类。

由于声音特征的声学特性,采用二值型RBM进行特征学习将会丢失特征的属性。因此,本文DBN中第一层RBM的可视层采用服从高斯分布的RBM,其余仍为二值RBM。

3 实验与分析 3.1 声音样本实验采用的40类声音均来自Freesound[30]声音数据库,分为哺乳动物叫声、鸟叫声和昆虫叫声3大类,每类声音有30个样本,具体如表 2所示。

| 表 2 声音事件样本集 Table 2 Sample set of sound events |

每个样本是单声道“.wav”格式、采样率为44.1 kHz、声音长度为2 s、量化精度为16位的声音片段。为了保持实验数据的相对独立性,训练声音样本和测试声音样本没有重复数据。从每一类样本中随机选取20个纯净声音样本作为训练样本,剩余的10个样本混合不同的环境噪声组成多组测试样本,共有1 200个样本,其中训练样本集800个,测试样本集400个。实验用到的3种噪声为SONY ICD-UX512F录音棒以44.1 kHz的采样频率录取的真实环境噪声,分别为风声、雷雨声和雨天湖边声,按信噪比0、10、20、30 dB混入纯净声音用于测试。

3.2 参数设定1) 提取MFCC特征中,采用24阶Mel三角带通滤波器组,提取12维离散余弦变换系数,加上对数能量作为第13维特征;采用循环平均幅度差函数(Circle Average Magnitude Difference Function,CAMDF)提取每帧声音信号的1维Pitch特征。此外,本文对声音信号以帧为单位提取特征,根据上面训练和测试集样本大小,OOMP训练特征大小为132 800×18,测试特征大小为66 400×18。对于抗噪幂归一化倒谱系数(Anti-noise Power Normalized Cepstral Cofficient,APNCC)特征,采用32阶的Gammatone滤波器,提取12维离散余弦变换系数。

2) PSO算法中的参数根据文献[27-28]以及多次实验作如下设定:种群大小为20,最大迭代次数为20,粒子搜索最大值为声音长度,速度最大值为2π,收敛因子为0.729,学习因子为2,权重最大值为0.95,最小值为0.4,变异概率为0.2。

3) DBN中的相关参数根据文献[12-13]以及多次实验作如下设定:第一层服从高斯分布的RBM的学习率为0.001,迭代次数为200,其余的二值型RBM的学习率为0.025,迭代次数为100,动量为0.5。

4) 本文实验中用到SVM和随机森林(Random Forests,RF)分类器。其中:SVM是直接利用LIBSVM[31]工具箱进行SVM的训练和测试建模,核函数为径向基核函数,惩罚因子c=2,核参数g=2.8;而RF分类器中的决策树的个数和分类属性个数,则综合考虑本文实验样本数量和特征维度以及文献[32]建议,分别设置为500和5。

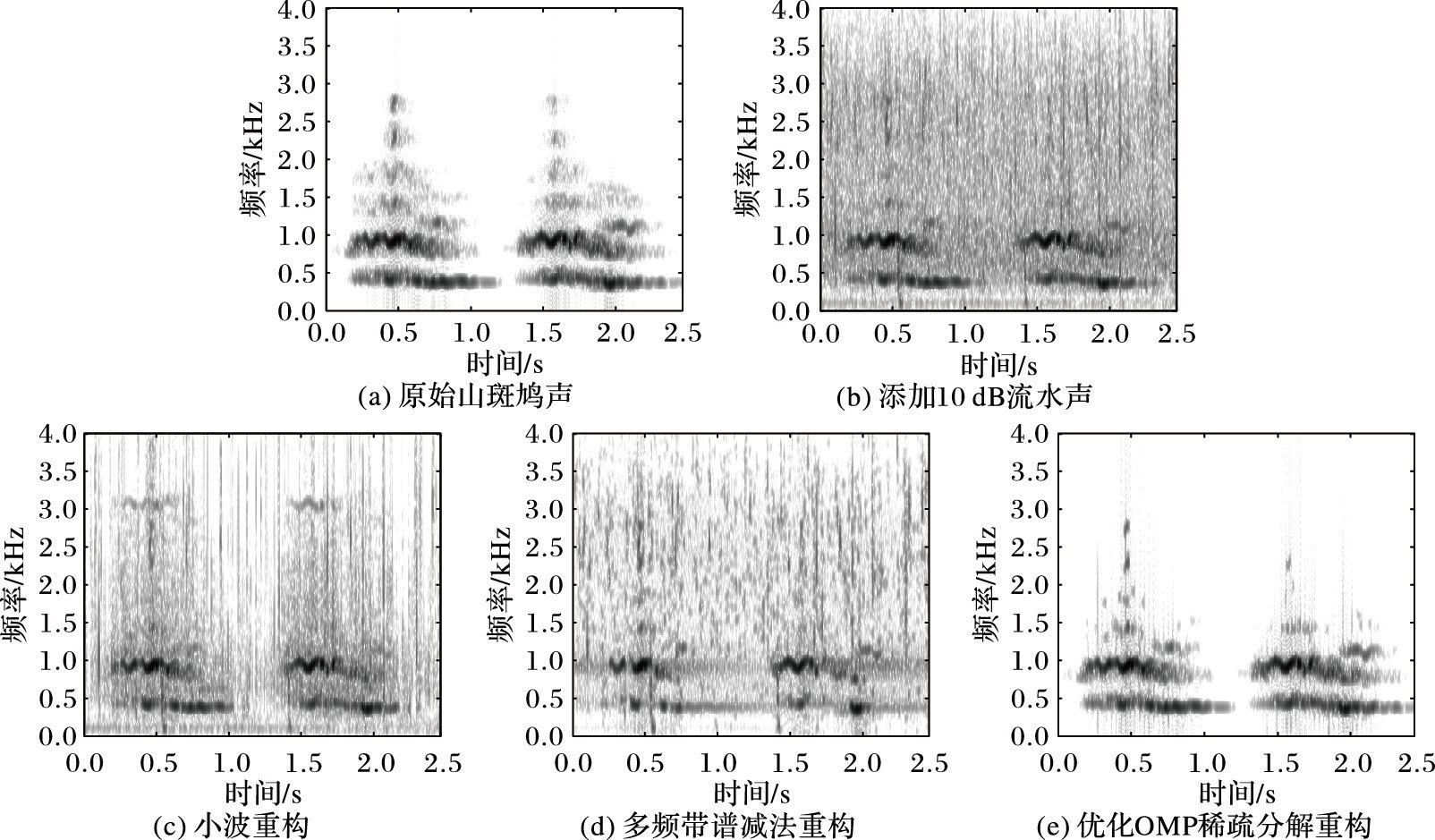

3.3 实验结果与分析 3.3.1 OOMP稀疏分解对声音信号的增强图 3中:图(a)是一段包含2个有效音节的山斑鸠声音信号的声谱图;图(b)是对该声音信号添加10 dB的流水噪声的声谱图;图(c)是采用小波增强法对图(b)进行重构后的声谱;图(d)是采用多频带谱减法对图(b)进行重构后的声谱图;而图(e)是经过OOMP稀疏分解后对图(b)进行重构的声谱图。

|

图 3 山斑鸠声音信号的声谱 Figure 3 Sound spectrum of mountain turtledove |

从图 3中可以看出,采用小波增强和多频带谱减法对带噪声音信号增强后,噪声残留成分较多。经过OOMP稀疏分解重构后,声音信号的主体部分得到保留,而与信号相关度低的噪声信号被去除,声音增强效果较好。图 3(e)初步说明,OOMP稀疏分解在声音增强性能上优于小波增强和多频带谱减法。

3.3.2 不同深度结构的DBN识别性能由于DBN的深度不同,其识别效果也不同。为了选取出较好的DBN结构,分别构建不同隐层数和不同隐层单元数[17]的DBN,对重构声音信号提取MFCC特征,将该特征放入DBN中进行训练识别。表 3表示不同深度结构的DBN识别性能。从表 3中可以看出,随着DBN隐层数的增加,识别性能越来越好,最好的训练正确率和测试正确率分别达到98.21%和96.41%,但是当隐层数增加到第5层和第7层时,识别性能反而开始逐渐减少。在层数相同时,DBN的识别性能随着隐层单元数的增加而增加,直至隐层单元个数为512。当隐层单元个数大于512,其识别性能逐渐开始下降,这是因为随着DBN结构越来越复杂,可能出现过拟合现象,从而导致识别性能降低。因此,综合考虑隐层数和隐层单元数的识别性能,本文采用包含隐层数为4、隐层单元数为512的DBN。

| 表 3 不同深度结构的DBN识别性能 Table 3 Recognition performance of DBN with different depth structures |

选取OMP特征、MFCC特征、OMP+MFCC特征和OOMP特征,放入3.3.2节选定的DBN中训练,在无噪声条件下进行识别率对比实验,结果如表 4所示。由表 4可知,在无噪声条件下,除了OMP特征外,其他三个特征对声音事件的识别率都较高。单独使用OMP特征,由于特征维数过低,识别效果不理想;而采用OMP特征和MFCC特征结合后,识别效果得到大幅提升;再用Pitch特征补充后,OOMP特征识别效果达到最佳。

| 表 4 无噪声条件下不同特征的识别率比较 Table 4 Recognition rate comparison of different features under noiseless conditions |

对测试样本分别添加信噪比为0、10、20和30 dB的三种环境声,测试四种特征在三种噪声环境下不同信噪比的识别性能,结果如表 5所示。

| 表 5 四种特征在三种噪声环境下不同信噪比的识别率 % Table 5 Recognition rates of four features in three kinds of noise environment with different SNR % |

从表 5可以看出,不同的噪声环境对识别性能的影响不一样。其中,MFCC特征在三种噪声不同信噪比下的识别率均最低,说明MFCC特征不适合噪声环境下的声音事件识别;OMP特征的识别率稍好于MFCC特征,但效果也不理想;而OOMP特征的识别率比OMP特征和OMP+MFCC特征均要好,说明经过OMP特征、MFCC特征和Pitch特征的结合形成的OOMP特征能有效地提高识别性能,具有较好的抑制环境声音的特性。表 5还显示出,雨天湖边噪声环境对识别率的影响最大,风声和雷雨声噪声对识别率的影响相对较小。OOMP特征识别率远高于单独的OMP特征和MFCC特征,也优于OMP+MFCC特征,从而说明OOMP特征是一个较好的特征,适合用于各种环境下的声音事件识别。

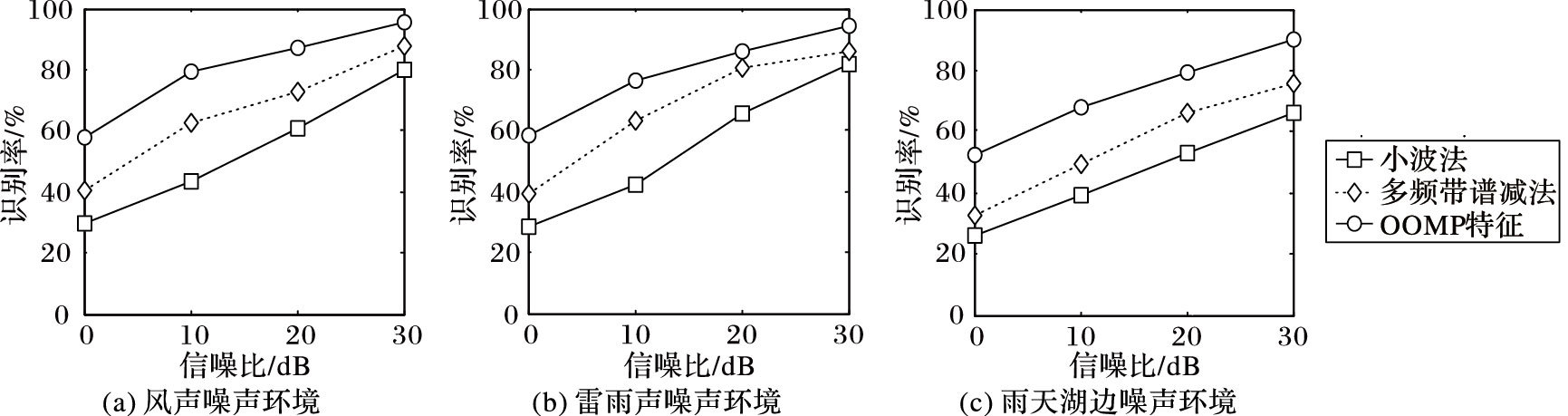

3.3.4 不同声音增强方法在不同环境和信噪比下比较利用风声、雷雨声和雨天湖边声来模拟真实的环境声音,分别对测试样本添加信噪比为0、10、20和30 dB的三种环境声,提取它们的OOMP特征,以及经小波和多频带谱减法增强后的两组MFCC特征,并采用DBN分别对三组特征进行识别,结果如图 4。从图 4可以看出,三种声音增强方法中,在各种环境及各种信噪比下,小波增强的性能相对来说较差,多频带谱减法性能稍微优于小波增强,而OOMP特征的识别性能最好,从而说明了在各种环境及各种信噪比下,OOMP特征仍然能保持最好的识别效果。

|

图 4 三种声音增强方法在不同环境及信噪比下的识别率比较 Figure 4 Recognition rate comparison of three kinds of sound enhancement methods in different environments and SNR |

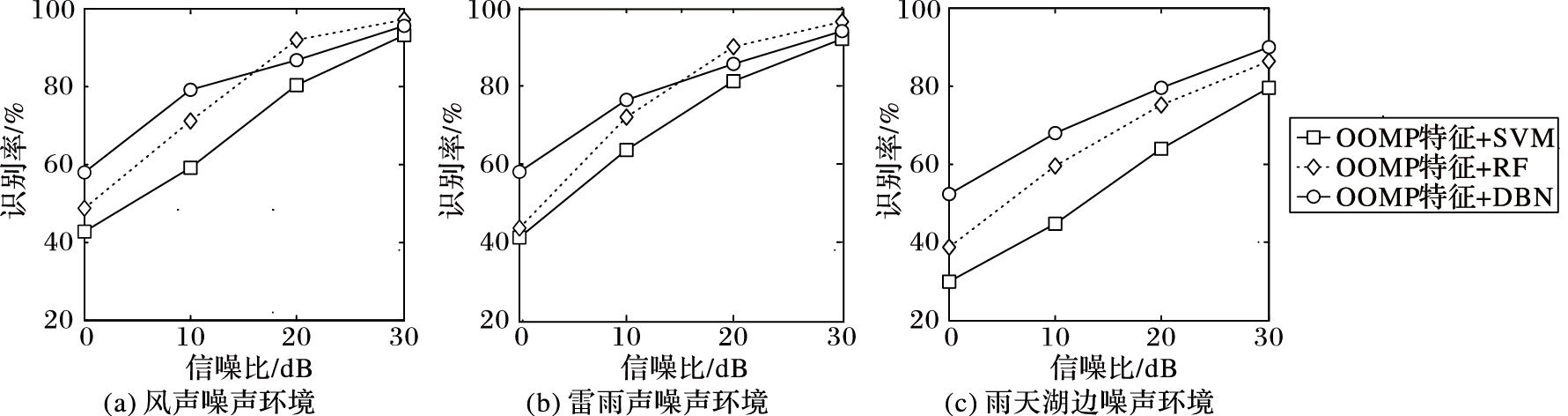

将OOMP复合特征分别放入SVM、RF和DBN分类器训练,对其识别性能进行比较,结果如图 5所示。从图 5中可以看出,在三种噪声环境下,信噪比为0 dB和10 dB时,OOMP特征结合DBN的平均识别率比OOMP特征结合SVM或RF的平均识别率要高;在风声和雷雨声的情况下,OOMP特征结合RF的识别性能在20 dB和30 dB时稍微优于DBN分类器;在雨天湖边噪声的所有信噪比下,OOMP特征的识别性能都是最好的。在三种噪声环境下,尤其是低信噪比时,本文方法识别率都高于OOMP特征结合SVM和RF的方法,从而也说明了DBN分类器的分类性能优于传统的分类器。

|

图 5 OOMP特征结合不同分类器在不同环境及信噪比下的识别率比较 Figure 5 Recognition rate comparison of OOMP feature combined with different classifiers in different environments and SNR |

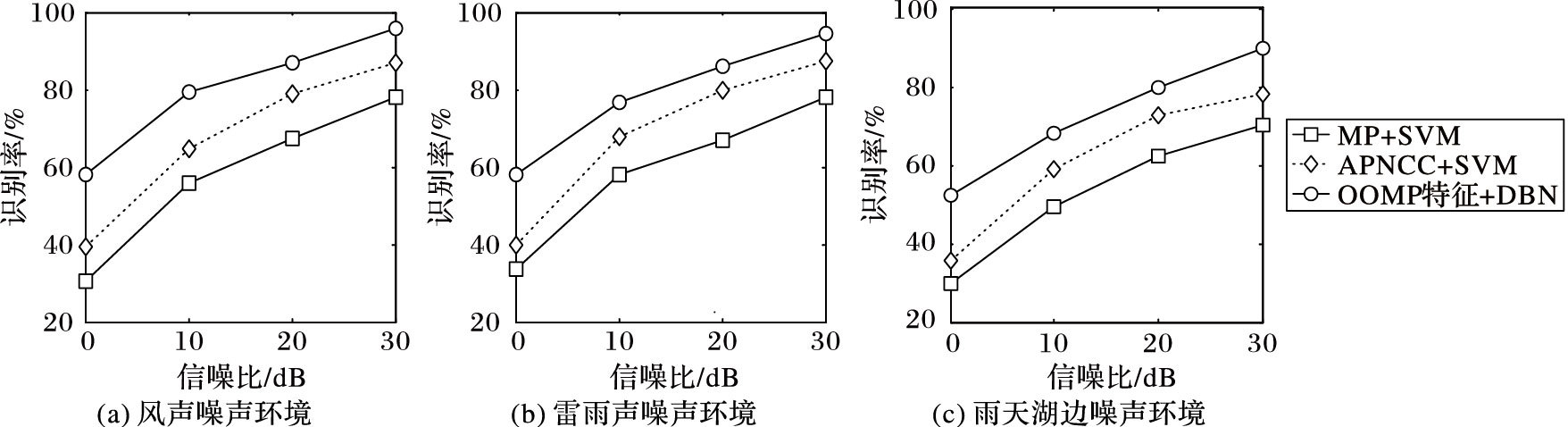

把OOMP特征结合DBN的方法与APNCC结合SVM的方法[33]和MP结合SVM的方法[24]分别进行比较,在同上所述的三种噪声环境下的识别率对比如图 6所示。可以看出,MP结合SVM的方法的平均识别率最低,而APNCC结合SVM的方法的平均识别率优于MP结合SVM的方法;本文提出的OOMP特征结合DBN的方法的平均识别率最高。即在三种噪声环境下,无论是高信噪比还是低信噪比,本文方法的识别率都高于APNCC结合SVM和MP结合SVM的方法。

|

图 6 本文方法与对比方法在不同环境及信噪比下的识别率比较 Figure 6 Recognition rate comparison of contrast algorithms in different environments and SNR |

针对各种环境声音对声音事件识别的影响,本文提出一种基于优化OMP结合DBN的声音事件识别方法。该方法采用PSO对OMP进行优化,对其提取OOMP特征放入DBN中进行分类识别。通过与传统的声音增强方法以及现有的APNCC结合SVM的方法和MP结合SVM方法进行比较,可以得出本文的方法除了具有较好的抑制噪声的效果外,还能有效地提高各种环境下不同信噪比的声音事件识别。但是在声音信号更为微弱、环境更为恶劣的情况下,本文方法仍有改进的空间,下一阶段将结合声谱图等方法,研究分析声音信号更为微弱、环境更为复杂和信噪比更低的声音事件识别。

| [1] | DENG L, LI J Y, HUANG J T, et al. Recent advances in deep learning for speech research at Microsoft[C]//ICASSP'13:Proceedings of the 2013 IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway, NJ:IEEE, 2013:8604-8608. |

| [2] | LEE H, PHAM P, LARGMAN Y, et al. Unsupervised feature learning for audio classification using convolutional deep belief networks[C]//NIPS'09:Proceedings of the 2009 Conference Advances in Neural Information Processing Systems 22. Cambridge, CA:MIT Press, 2009:1096-1104. |

| [3] | HINTON G, DENG L, YU D, et al. Deep neural networks for acoustic modeling in speech recognition:the shared views of four research groups[J]. IEEE Signal Processing Magazine, 2012, 29 (6) : 82-97. doi: 10.1109/MSP.2012.2205597 |

| [4] | SAINATH T N, MOHAMED A, KINGSBURY B, et al. Deep convolutional neural networks for LVCSR[C]//ICASSP'13:Proceedings of the 2013 IEEE International Conference on Acoustics, Speech and Signal Processing. Piscataway, NJ:IEEE, 2013:8614-8618. |

| [5] | HAMEL P, ECK D. Learning features from music audio with deep belief networks[C]//ISMIR'10:Proceedings of the 201011th International Society for Music Information Retrieval Conference. Piscataway, NJ:IEEE, 2010:339-344. |

| [6] | KAGAYA H, AIZAWA K, OGAWA M. Food detection and recognition using convolutional neural network[C]//MM'14:Proceedings of the 201422nd ACM International Conference on Multimedia. New York:ACM, 2014:1085-1088. |

| [7] | RAVANELLI M, ELIZALDE B, NI K, et al. Audio concept classification with hierarchical deep neural networks[C]//EUSIPCO'14:Proceedings of the 201422nd European Signal Processing Conference. Piscataway, NJ:IEEE, 2014:606-610. |

| [8] | SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//CVPR'15:Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:1-9. |

| [9] | YU D, SELTZER M L, LI J Y, et al. Feature learning in deep neural networks-studies on speech recognition tasks[EB/OL].[2016-03-26]. Computer Science, 2013, 5(1):1301.3605. https://arxiv.org/pdf/1301.3605v3.pdf. |

| [10] | DAHL G E, YU D, DENG L, et al. Context-dependent pre-trained deep neural networks for large-vocabulary speech recognition[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20 (1) : 30-42. doi: 10.1109/TASL.2011.2134090 |

| [11] | MCLOUGHLIN I, ZHANG H M, XIE Z P, et al. Robust sound event classification using deep neural networks[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2015, 23 (3) : 540-552. doi: 10.1109/TASLP.2015.2389618 |

| [12] | HINTON G E, OSINDERO S, TEH Y-W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18 (7) : 1527-1554. doi: 10.1162/neco.2006.18.7.1527 |

| [13] | HINTON G E. A practical guide to training restricted Boltzmann machines[M]//Neural Networks:Tricks of the Trade, LNCS 7700. 2nd ed. Berlin:Springer, 2012:599-619. |

| [14] | ACKLEY D H, HINTON G E, SEJNOWSKI T J. A learning algorithm for Boltzmann machines[J]. Cognitive Science, 1985, 9 (1) : 147-169. doi: 10.1207/s15516709cog0901_7 |

| [15] | LAROCHELLE H, MANDEL M, PASCANU R, et al. Learning algorithms for the classification restricted Boltzmann machine[J]. Journal of Machine Learning Research, 2012, 13 (1) : 643-669. |

| [16] | LE ROUX N, BENGIO Y. Representational power of restricted Boltzmann machines and deep belief networks[J]. Neural Computation, 2008, 20 (6) : 1631-1649. doi: 10.1162/neco.2008.04-07-510 |

| [17] | FARAHAT M, HALAVATI R. Noise robust speech recognition using deep belief networks[J]. International Journal of Computational Intelligence and Applications, 2016, 15 (1) : 1650005. doi: 10.1142/S146902681650005X |

| [18] | MOHAMED A, DAHL G E, HINTON G. Acoustic modeling using deep belief networks[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2012, 20 (1) : 14-22. doi: 10.1109/TASL.2011.2109382 |

| [19] | GUO F, YANG D S, CHEN X O. Using deep belief network to capture temporal information for audio event classification[C]//IIH-MSP'15:Proceedings of the 2015 International Conference on Intelligent Information Hiding and Multimedia Signal Processing. Piscataway, NJ:IEEE, 2015:421-424. |

| [20] | LEE Y K, JUNG G W, KWON O W. Speech enhancement by Kalman filtering with a particle filter-based preprocessor[C]//ICCE'13:Proceedings of the 2013 IEEE International Conference on Consumer Electronics, Piscataway, NJ:IEEE, 2013:340-341. |

| [21] | VERMA N, VERMA A K. Real time adaptive denoising of musical signals in wavelet domain[C]//NUiCONE'12:Proceedings of the 2012 Nirma University International Conference on Engineering, Piscataway, NJ:IEEE, 2012:1-5. |

| [22] | 周晓敏, 李应. 基于Radon和平移不变性小波变换的鸟类声音识别[J]. 计算机应用, 2014, 34 (5) : 1391-1396,1417. ( ZHOU X M, LI Y. Bird sounds recognition based on Radon and translation invariant discrete wavelet transform[J]. Journal of Computer Applications, 2014, 34 (5) : 1391-1396,1417. ) |

| [23] | CHU S, NARAYANAN S, KUO C C J. Environmental sound recognition with time-frequency audio features[J]. IEEE Transactions on Audio, Speech, and Language Processing, 2009, 17 (6) : 1142-1158. doi: 10.1109/TASL.2009.2017438 |

| [24] | WANG J C, LIN C H, CHEN B W, et al. Gabor-based nonuniform scale-frequency map for environmental sound classification in home automation[J]. IEEE Transactions on Automation Science and Engineering, 2014, 11 (2) : 607-613. doi: 10.1109/TASE.2013.2285131 |

| [25] | MALLAT S G, ZHANG Z F. Matching pursuits with time-frequency dictionaries[J]. IEEE Transactions on Signal Processing, 1993, 41 (12) : 3397-3415. doi: 10.1109/78.258082 |

| [26] | SOUSSEN C, GRIBONVAL R, IDIER J, et al. Joint k-step analysis of orthogonal matching pursuit and orthogonal least squares[J]. IEEE Transactions on Information Theory, 2013, 59 (5) : 3158-3174. doi: 10.1109/TIT.2013.2238606 |

| [27] | KENNEDY J, EBERHART R. Particle swarm optimization[C]//ICNN'95:Proceedings of the1995 IEEE International Conference on Neural Networks. Piscataway, NJ:IEEE, 1995:1942-1948. |

| [28] | 马超, 邓超, 熊尧, 等. 一种基于混合遗传和粒子群的智能优化算法[J]. 计算机研究与发展, 2013, 50 (11) : 2278-2286. ( MA C, DENG C, XIONG Y, et al. An intelligent optimization algorithm based on hybrid of GA and PSO[J]. Journal of Computer Research and Development, 2013, 50 (11) : 2278-2286. ) |

| [29] | LI S T, FANG L Y. Signal denoising with random refined orthogonal matching pursuit[J]. IEEE Transactions on Instrumentation and Measurement, 2012, 61 (1) : 26-34. doi: 10.1109/TIM.2011.2157547 |

| [30] | Universitat Pompeu Fabra. Repository of sound under the creative commons license[DB/OL].[2016-03-14]. http://www.freesound.org. |

| [31] | CHANG C C, LIN C J. LIBSVM:a library for support vector machines[J]. ACM Transactions on Intelligent Systems and Technology, 2011, 2 (3) : Article No.27. |

| [32] | BREIMAN L. Random forests[J]. Machine Learning, 2001, 45 (1) : 5-32. doi: 10.1023/A:1010933404324 |

| [33] | 颜鑫, 李应. 利用抗噪幂归一化倒谱系数的鸟类声音识别[J]. 电子学报, 2013, 41 (2) : 295-300. ( YAN X, LI Y. Anti-noise power normalized cepstral coefficients in bird sounds recognition[J]. Acta Electronic Sinica, 2013, 41 (2) : 295-300. ) |