随着网络文本数量增加,呈现大数据特征,如何对海量文本进行快速分析,例如根据新闻标题进行类别识别,根据网络评论进行情感分析等,在自动问答[1]、信息检索[2]、网络舆情发现等领域应用广泛。新闻标题字符数少,属于短文本,在文本结构化时存在数据稀疏问题[3],难以根据词的共现信息挖掘其语义,使基于特征抽取的机器学习分类算法,如朴素贝叶斯、支持向量机等,和基于自动特征学习的卷积神经网络等深度学习模型,在直接应用于短文本分类时,仍存在不足。针对这种短文本数据稀疏对分类性能的影响,学者从扩展短文本特征、优化文本特征表示方法及改进分类模型方面,展开了广泛研究。

从文本特征扩展方法看,Phan等[4]用隐狄克雷分布(Latent Dirichlet Allocation, LDA)发现潜在语义,对短文本进行扩展;马成龙等[5]通过训练无标注数据得到词矢量,再用词矢量相似度扩展文本的集外词;郑诚等[6]提出了融合主题模型(Biterm Topic Model, BTM)特征和改进特征权重计算的方法,用于扩充短文本特征;张海涛等[7]用背景补偿与边缘相关方法,根据文本关联性建立小样本簇背景特征集,并结合边缘相关性分析确定文本特征;高元等[8]提出了一种融合随机森林与贝叶斯多项式的标题分类算法,用图书馆书目数据验证了其性能。上述文本扩展方法在不同数据集上均取得了性能提升,但其对文本特征的表示方法仍需人工定义,且对文本特征扩展时可能引入的噪声未作进一步讨论。近年来,神经网络(Neural Network, NN)方法由于能从大规模数据中进行自动特征学习,在自然语言处理中被大量使用。Le等[9]用无监督方法学习段落向量,得到句子、段落等变长文本的固定大小的特征表示;Kalchbrenner等[10]用动态卷积神经网络对句子建模,用动态k-max pooling消除输入语句长度的影响;Kim [11]用预训练的词向量结合卷积NN(Convolutional NN, CNN)进行句子分类,在情感分类、主客观句分类和问句分类等数据集上验证了模型性能;Wang等[12]提出了一种结合密度峰聚类及Word Embedding的短文本扩展方法,是与本文最相关的工作。在文本语义表示方面,Mitchell等[13]对短语、句子的分布式表示模型构建及评价方法进行了研究;Mikolov等[14-15]提出用Skip-gram模型学习大规模文本数据的向量表示,并对如何提高训练质量及速度[16]进行了研究。文献[11, 13-16]为本文针对扩展文本提出的CNN分类模型结构,以及本文的文本短语语义扩展方法,提供了主要理论依据。

综上可知,现有研究主要着眼于扩展短文本特征,并借助深度学习模型的大规模参数表述能力,根据高阶n-gram及词序信息[12]学习语义特征,改进特征描述方法。但由于扩展文本从一定程度改变了原文语法结构,有必要针对扩展文本设计分类模型,使其适于对扩展文本进行特征学习。另外,特征扩展容易引入噪声,使短文本发生主题偏移而影响分类性能。因此,本文对短文本扩展及分类模型构建方法展开了研究。通过适度控制扩展文本长度,针对扩展文本结构建立分类模型以改善分类性能。对汉语新闻标题,首先基于Word Embedding将其扩展为标题三元组,再构造卷积神经网络,对标题三元组进行分类。实验在2017自然语言处理与中文计算评测(Natural Language Processing & Chinese Computing in 2017, NLP & CC2017)的新闻标题分类数据集上进行,验证了本文方法的有效性。

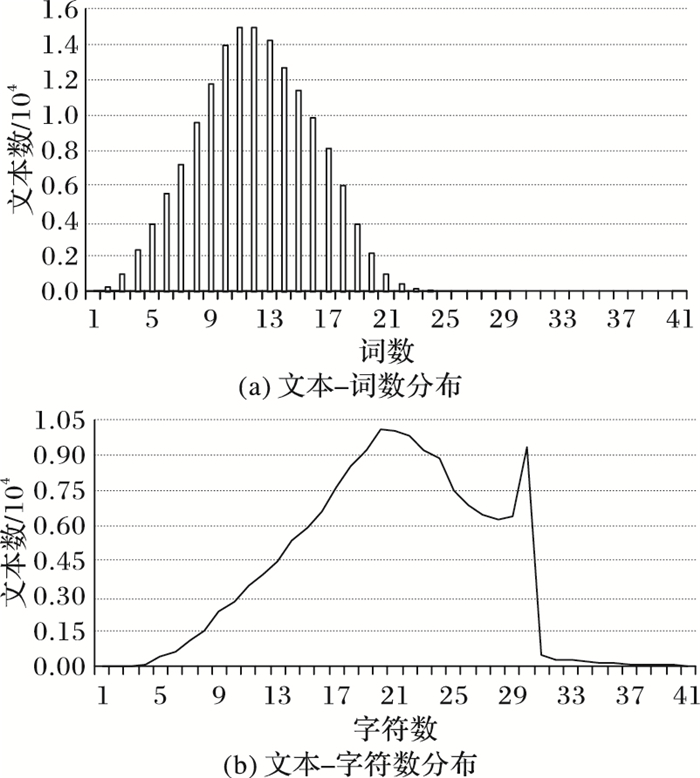

1 短文本及扩展依据 1.1 短文本描述短文本的研究多针对特定域文本,如微博、网络评论、搜索引擎查询串等,但没有对短文本的明确定义。本文以中文新闻标题为研究目标。分析15万条新闻标题文本,其词数及字符数如图 1所示。从图 1折线可知,标题字符数介于1~40,图 1柱形表示的中文分词(结巴分词)词数介于1~28,如“南京长江大桥”分词结果为一个词“南京长江大桥”。结合新闻门户网站(如新浪新闻)、新闻出版物对新闻标题字数的约束,本文所研究短文本的字符数介于1~40。

|

图 1 新闻标题字符数、词数分布 Figure 1 Distribution of terms and words of news titles |

阅读文本时,通常读者会根据自身认知及上下文进行信息补充,以加深对原文理解。例如如下分词后的文本:

1)“他们不会再囤积中锋了吧?”

2)“周琦下赛季会怎么样?”

对文本1),读到“中锋”时,读者可能补充“足球”“篮球”等近义词;对文本2),读到“周琦”“赛季”时,读者可能搜索对这些词组合的认知信息,进而根据“篮球”“比赛”等近义词判断文本类别。可见,对短文本进行扩展可辅助分类。

Word Embedding又称“Word Representation”,中文称“词向量”或“词嵌入”,本文用“词向量”表示Word Embedding。词向量可通过构建神经网络语言模型[18],结合上下文信息,将词映射成低维实向量而得到。词向量各维的取值取决于词与维度的共现频率,词的语义分布在各维上,其相对位置描述了其语义关系,因此根据词间距离可判断词的语义相似度,进而找出同义词,这是本文的一种文本扩展依据。例如用余弦距离计算下述词语的同义词(本文实验语料训练的Word2Vec):

篮球:排球、垒球、橄榄球;

赛事:比赛、本届、赛站。

可分别将“排球”“比赛”作为“篮球”“赛事”的扩展词。虽然这里的扩展词描述了与原文不同的事件,但由于“篮球赛事”和“排球比赛”都属于“sport”类事件,因此对文本分类任务,仍可辅助类别判断。

另外,由于单个词忽略了上下文语义,因此文本扩展还应考虑组合词,即词向量的组合[13]。对任意词向量u、v,其组合[13]描述为:

NP = f (u, v)

其中:f为组合函数;NP为u、v组合成的新语义。NP的产生依赖于两个假设[13]:1)在相似文本中出现的u、v,其语义也相似;2)u、v向量的相似性可表达其语义相似性。根据词向量特点,u、v符合上述假设。对组合函数f,由于词向量具有analogy性质[16],其语义关系可通过如下线性算子[14-16]描述,如:

vec("Madrid")-vec("Spain")+vec("France")→vec("Paris")

本文以词向量的analogy性质作为其组合依据,用向量加法作为组合函数f,如式(1):

| $ \mathit{\boldsymbol{NP}} = \mathit{\boldsymbol{u}} + \mathit{\boldsymbol{v}} $ | (1) |

通过词向量u、v相加,将词语简单混合,产生新向量NP。NP蕴含了新的语义,可根据其抽取新的特征作为文本扩展词。词向量相加的问题是无法判断相加顺序,因而忽略了词序信息。对该问题,本文用连续滑动的多尺度窗口抽取词组合,使获得的新特征间保持相对词序信息。

2 短文本扩展方法本文根据一般新闻标题的(标题,副标题,主题词)描述格式,将待分类新闻标题T,扩展为标题三元组,形如:

Title = {T, TA, KEYS}

其中:Title为扩展标题;T为待分类标题;TA为副标题;KEYS为主题词集。

2.1 副标题提取副标题TA用于扩展对T的描述,因此与T具有相似词,且应符合一定语法规范。本文提取TA的方法是:对T的任意词语ti,提取与其最相似,且与ti词性相同的词为扩展词;连接扩展词形成TA。其中词性过滤是使TA与T具有相似语法,符合一定语义规范。假设文本T为{t1, t2, …, tn},ti是其任一词。经预训练得到EW为{D, WMDIC},其中D是词语列表,WMDIC是词向量矩阵,分别表示为:

D = [d1, d2, …, dN]

WMDIC = (f1, f2…, fN)

其中:dk是D中任一词;fk是dk的词向量;N为词语总数。提取副标题TA如算法ABSST(ABStract SubTitle)所示。

算法 ABSST。

输入 T, EW;

输出 TA。

1) TA = {∅}

2) foreach ti in T:

if ti in D:

maxDist = -1

foreach fk in WMDIC:

distance = Cosdis(fD.index(ti), fk)

if maxDist < distance and POS(dk) = = POS(ti)

maxDist = distance

pos = k

TA = TA∪{dpos}

其中:D.index (ti)为词ti在D中的索引位置;Cosdis(fD.index(ti), fk)为计算词向量fD.index(ti)、fk的余弦相似度;POS(ti)为ti的词性。将TA的词按选中先后顺序拼接,得到副标题TA。对D中未登录词不予提取,本文实验中用空白符代替。

2.2 主题词集提取参照GB/T3860—2009《文献主题标引规则》描述,主题词能反映文献特征,有利于快速检索。因此本文抽取文本的主题词以增强对文本的描述,用于辅助分类。

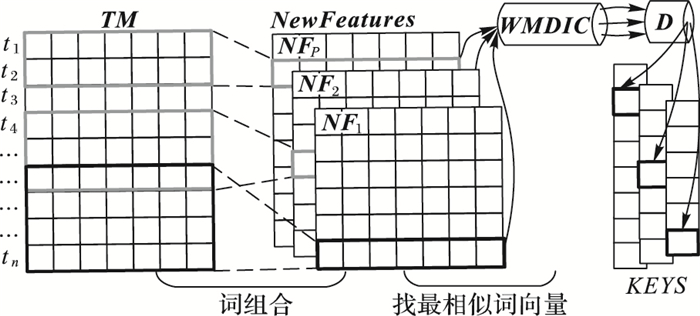

对短文本的词扩展,文献[12]根据文本的词组合,寻找其最相似的类别中心词,再抽取中心词周围一定阈值内的词为扩展词。该方法需进行词聚类,并在词抽取时设置超参数,另外抽取的扩展词间不存在语序关系。因此,本文基于文献[12]方法,首先从文本提取词组合,再将其最相似词作为主题词。主题词提取如图 2所示,提取过程如下:

|

图 2 多尺度词向量组合的主题词抽取 Figure 2 Keywords extraction from composition of multiscale word vectors |

1) 以预训练的词向量矩阵WMDIC∈Rdim×N为查找表,以D为词语列表, 其中dim是词向量维度,N为单词数。对文本T的每个词ti,根据WMDIC填充词向量矩阵TM∈Rdim×N,其中n是T的词数。

2) 设置多尺度大小滑动窗口,根据式(1),分别对窗口内词向量求和,得到NewFeatures,表示为{NF1, NF2, …, NFP}。其中P是窗口数,NFk是第k个新向量矩阵,表示为:

NFk = (nfk1, nfk2, …, nfkq)

其中:nfki是词向量相加而成的新向量;q是新向量数。

3) 对NewFeatures中的每个新向量,查询WMDIC中最相似的词向量,并从D中提取对应词,作为主题词。

由此主题词集KEYS表示为:

KEYS = {Key1, Key2, …, KeyP}

其中Keyk为第k组主题词,表示为:

Keysk = {wk1, wk2, …, wkq}

其中wki是提取的一个主题词。

例如,对“car”类文本T,设窗口数P为3,抽取结果为(本文实验语料训练的Word2Vec):

T:北汽、幻速、车型、勇闯、无人区;

Key1:赵景光、新车、不畏艰难、昆仑山;

Key2:汽车、新车、无人区;

Key3:汽车集团、轿车。

由此T的主题词集KEYS为{Key1, Key2, Key3}。可见通过多尺度窗口的词组合,逐渐聚焦了关键词“车”。虽然KEYS没有反映出“勇闯无人区”这一事件,但仍从一定程度加深了对T的描述,实现了词扩展。与文献[12]方法相比较,本文方法每次从滑动窗口提取一个最相似特征,避免词聚类时进行超参数设置,并使扩展特征数得到一定控制。另外,通过窗口滑动的连续性,扩展特征KEYS中的各主题词间保持了相对词序信息,有利于后续基于卷积计算的特征学习。

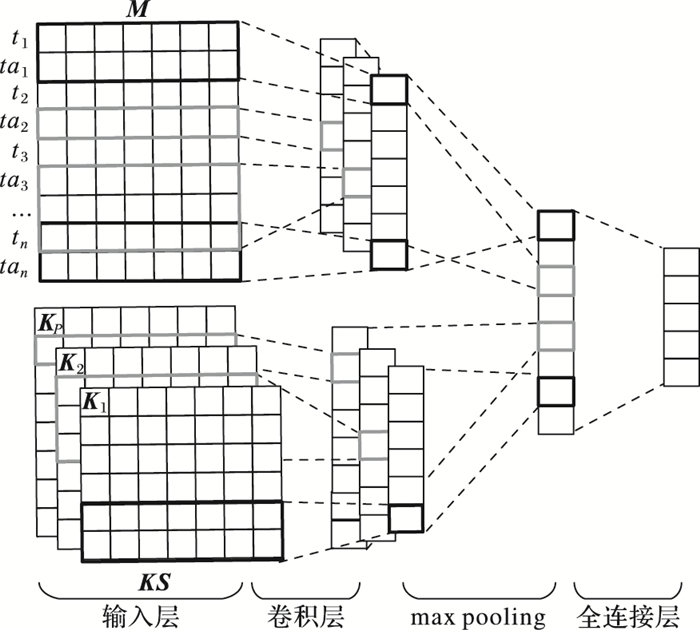

3 CNN分类模型CNN是一种前馈神经网络。文献[11]提出了一种基于CNN的文本分类模型。本文对该模型的输入层进行改进,以适合本文的扩展文本,得到如图 3所示的扩展文本分类模型。对文本T,首先抽取副标题TA、主题词集KEYS,得到三元组Title = {T, TA, KEYS}用于构造网络输入层;再通过卷积运算抽取Title的特征图FM、FKS;对FM、FKS进行max pooling采样,并经全连接层及softmax得到网络输出,即T所属类别。

|

图 3 基于CNN的扩展文本分类模型 Figure 3 Classification model of expanded text based on CNN |

假设文本T为{t1, t2, …, tn}、TA为{ta1, ta2, …, tan},n是文本T的词数。以WMDIC为查找表,分别查找T、TA中每个词的词向量,填充词向量矩阵M∈R2n×dim,表示为:

M = (m1, m2, …,m2n); mi∈Rdim

如图 3所示分类模型的输入层可见,为提高模型泛化能力,本文将T与TA对应位置的词向量拼接得到M,M长度为2n,是一种双词表达形式。本文用这种方式扩展T,用于增加模型的鲁棒性,由此得到的M在一定程度影响但并未完全破坏原文的语序。

对主题词集KEYS = {Key1, Key2, …,KeyP},填充其词向量矩阵集KS,表示为{K1, K2, …, KP}。其中Kd∈Rdm×dim是任一主题词集的词向量矩阵,dm是其包含主题词数,表示为:

Kd = (k1, k2, …, kdm); kj∈Rdim

本文对未登录词的词向量采用随机初始化。

3.2 网络训练过程网络训练过程分3步:

1) 特征抽取。M和KS经卷积层进行特征抽取。由于M包含双词词序信息,KS包含相对词序信息,因此分别用不同卷积核。特征抽取如式(2)所示:

| $ \begin{array}{l} c_r^{\left( i \right)} = {\rm{Relu}}\left( {{\mathit{\boldsymbol{k}}^{\left( i \right)}}{\mathit{\boldsymbol{M}}_{i:i + \mathit{\boldsymbol{k}}_{ra}^{\left( i \right)}- 1}} + {\mathit{\boldsymbol{B}}^{\left( i \right)}}} \right);\\ \;\;\;\;\;\;\;\;\;\;\;r \in \left[{1, 2n-k_{ra}^{\left( i \right)} + 1} \right] \end{array} $ | (2) |

其中:k(i)为第i个卷积核,其行数为kra(i),宽度为dim,与词向量相同;Mi:i+kra(i)-1为卷积核内的词向量矩阵;B(i)为偏置项;卷积结果经激活函数输出,文本用Relu函数为卷积层激活函数;cr(i)为经第i个卷积核抽取的特征;n为输入的原文长度。由式(2)可分别得到M、Kd的第i个、第j个卷积核抽取的特征图:

| $ \begin{array}{l} \mathit{\boldsymbol{feaM}}_{_\mathit{\boldsymbol{M}}}^{\left( i \right)} = \left[{c_1^{\left( i \right)}, c_2^{\left( i \right)}, \cdots, c_{2n-k_{ra}^{\left( i \right)} + 1}^{\left( i \right)}} \right]\\ \mathit{\boldsymbol{feaK}}_{{\mathit{\boldsymbol{K}}_d}}^{\left( j \right)} = \left[{c_1^{\left( j \right)}, c_2^{\left( j \right)}, \cdots, c_{2{w_{kd}}-k_{ra}^{\left( j \right)} + 1}^{\left( j \right)}} \right] \end{array} $ |

其中,wkd为主题词集Kd的词数。由此M经卷积层输出特征图为:

| $ \mathit{\boldsymbol{FM}} = \left( {\mathit{\boldsymbol{feaM}}_{_\mathit{\boldsymbol{M}}}^{\left( 1 \right)}, \mathit{\boldsymbol{feaM}}_{_\mathit{\boldsymbol{M}}}^{\left( 2 \right)}, \cdots, \mathit{\boldsymbol{feaM}}_{_\mathit{\boldsymbol{M}}}^{\left( {M\_size} \right)}} \right) $ |

Kd经卷积抽取特征图为:

| $ \mathit{\boldsymbol{F}}{\mathit{\boldsymbol{K}}_{{\mathit{\boldsymbol{K}}_d}}} = \left( {\mathit{\boldsymbol{feaK}}_{_{{K_d}}}^{\left( 1 \right)}, \mathit{\boldsymbol{feaK}}_{_{{K_d}}}^{\left( 2 \right)}, \cdots, \mathit{\boldsymbol{feaK}}_{_{{K_d}}}^{\left( {{K_d}\_size} \right)}} \right) $ |

KS经卷积层输出特征图集为:

| $ \mathit{\boldsymbol{FKS}} = \left\{ {\mathit{\boldsymbol{F}}{\mathit{\boldsymbol{K}}_{{\mathit{\boldsymbol{K}}_1}}}, \mathit{\boldsymbol{F}}{\mathit{\boldsymbol{K}}_{{\mathit{\boldsymbol{K}}_2}}}, \cdots, \mathit{\boldsymbol{F}}{\mathit{\boldsymbol{K}}_{{\mathit{\boldsymbol{K}}_Q}}}} \right\} $ |

其中:M_size、Kd_size、Q分别为M的卷积核数、Kd的卷积核数、抽取的主题词集数。

2) 采样层及随机dropout。卷积层输出的特征图FM、FKS经采样层过滤以减少参数数量。max pooling通过保留一组样本最大值[19],提取最重要的特征。本文对特征图进行max pooling,再将采样结果拼接成1维实向量X。为避免模型过拟合,在训练阶段对X进行随机dropout[20],使max pooling输出每次随机减少。

3) 全连接层参数训练。将采样层输出X作为一个全连接(Full Connection, FC)层的输入,计算如式(3):

| $ \mathit{\boldsymbol{Y}} = f\left( {\mathit{\boldsymbol{W}} \cdot \mathit{\boldsymbol{X}} + \mathit{\boldsymbol{b}}} \right) $ | (3) |

其中:f是激活函数;W是FC层权重矩阵;b是偏置项。FC层输出Y是一维实向量,表示为[y1, y2, …, yr],yi是输入文本属于某一类别的评分;r是分类类别数。用softmax函数将Y转换为属于类别的概率A,表示为[p(y1), p(y2), …, p(yr)],p(yi)计算如式(4):

| $ p\left( {{y_i}} \right) = {e^{{y_i}}}/\sum\limits_k {{e^{{y_k}}}} $ | (4) |

取MAX(A)作为输入文本所属类别。对网络参数W,根据训练文本的分类标签,用反向传播(Back Propagation, BP)算法进行梯度更新。由于交叉熵函数可加速反向传播[21],因此用交叉熵函数LOSS作损失函数,如式(5):

| $ LOSS\left( {\mathit{\boldsymbol{OUTPUT}}, \mathit{\boldsymbol{A}}} \right) =-\frac{1}{{\left| \mathit{\boldsymbol{A}} \right|}}\sum\limits_{i = 1}^r {outpu{t_i}\ln \left( {p\left( {{y_i}} \right)} \right)} $ | (5) |

其中:OUTPUT是训练文本的类别标签,表示为[output1, output2, …, outputr],是独热编码向量。W的更新以使损失函数最小化为目标,采用梯度下降方法如式(6):

| $ {w_{ji}} \leftarrow {w_{ji}}-\eta \frac{{\partial LOS{S_d}}}{{\partial {w_{ji}}}} $ | (6) |

其中:LOSSd是训练文本d的损失;η是学习速率。

3.3 超参数设置网络超参数包括卷积核大小、卷积核数、词向量宽度等,可通过网格搜索进行寻优。本文实验表明,词向量宽度分别为200、300时,分类性能并无显著提升,本文实验用词向量宽度为200。由于文本重点是特征扩展及分类模型的适用性,故对其他网络参数调优不作详述。为避免扩展特征数多而引入较大噪声,本文分析认为M和KS的卷积核数应满足式(7)条件:

| $ {F_\mathit{\boldsymbol{M}}} \ge F{}_{\mathit{\boldsymbol{KS}}} $ | (7) |

其中,FM、FKS分别是M、KS经采样层输出的特征数。当FM等于FKS时,采样层从M、KS抽取特征数相同。本文实验表明,当FM小于FKS,模型收敛速度显著下降,且分类正确率无提升。分析其原因,由于主题词集均为扩展词,包含较大噪声,当扩展词超过正文特征数,可能因扩展词与正文主题不一致而引起理解歧义。通过减少KS的卷积核数,减少从主题词集抽取特征数,可降低主题词噪声的影响。另外,较少的卷积核数使经KS提取的特征具有随机性,可提高模型泛化能力。根据式(7),本文用式(8)方法设置卷积核数:

| $ M\_size \ge \sum\limits_{d = 1}^P {{K_d}\_size} $ | (8) |

其中:M_size是M的卷积核数;Kd_size是第d个主题词集的卷积核数;P是抽取主题词集时的滑动窗口数。

4 实验结果及分析实验数据来自NLP & CC 2017评测,包含18个类别新闻标题文本,训练集和开发集如表 1所示。

| 表 1 实验数据分布 Table 1 Distribution of experimental data |

实验用Google开源项目Word2Vec的Skip-gram模型训练词向量,维度为200,生成词向量名称及对应语料为:

1) SoGouVec:搜狗新闻语料(SogouCS,一个月新闻数据)。

2) WiKiVec:中文WiKi百科语料。

3) MWiKiVec:中文WiKi百科与训练集混合语料。

以未经文本扩展的CNN分类[11]为Baseline;经本文方法进行副标题扩展、三元组扩展分别为SECNN1、SECNN2。分别在各组词向量上进行实验,模型描述如表 2所示。

| 表 2 实验模型描述 Table 2 Description of experimental models |

实验试图验证文本扩展及分类模型的有效性,因此模型中同种超参数均为统一值。以分类正确率为评价指标,对未登录词的词向量用随机初始化,各模型分类性能如表 3所示。

| 表 3 不同模型分类正确率对比 Table 3 Comparison of classification accuracy of different models |

从Baseline来看,Baseline1正确率最低,为0.7256,Baseline4为0.7424,表明用词向量初始化网络输入对分类性能有一定影响,但并不显著。但本文实验中Baseline2~Baseline4收敛速度较Baseline1快。

如表 3所示,SECNN1_1~SECNN1_3的正确率较各组Baseline均显著提升,SECNN1_3正确率为0.7829,在各词向量中性能最优,比Baseline4提高5.5%,表明本文副标题扩展方法的有效性。经三元组扩展,SECNN2_1~SECNN2_3各组性能略优于SECNN1,其中MWiKiVec性能最优,为0.7942,较Baseline1提高了9.5%。

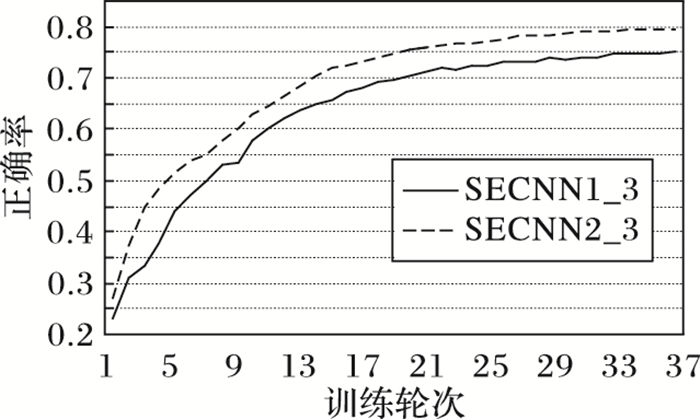

模型SECNN1_3、SECNN2_3的训练过程如图 4。由于SECNN2_3比SECNN1_3输入层特征数多,单轮训练时间较长。本文实验在FM等于FKS时,SECNN2_3有较高的收敛速度和较好的分类性能。如图 4所示,SECNN2_3在训练第37轮时正确率达到0.7942,此时SECNN1_3正确率为0.7499。本文实验中,SECNN1_3在训练第45轮时正确率接近0.78,表明SECNN2_3收敛速度比SECNN1_3更快。

|

图 4 模型SECNN1_3、SECNN2_3训练过程对比 Figure 4 Comparison of training process for models of SECNN1_3 and SECNN2_3 |

从表 3来看,SECNN2的正确率整体高于SECNN1,表明本文所提的主题词扩展方法较好地控制了噪声,对原文形成了有效补充。但SECNN2正确率仅略优于SECNN1,分析其原因如下:经多窗口主题词提取,虽然提取了多主题词集,但主题词集间语义相似度大,且最终都聚焦为文本的局部关键特征,因此对原文语义的扩展仍然不足,限制了分类性能。

总体来看,副标题扩展使分类性能提升最为显著,表明双词结构扩展了文本信息量,使卷积层抽取的特征具有较好的泛化能力。MWiKiVec词向量的分类性能在各组测试中都最优。分析其原因为:由于新闻标题语法结构与普通文本存在差异,用普通文本训练的词向量,不能较好地体现新闻标题的语义。将新闻标题与普通文本混合,可适度改善词向量质量,使其更符合标题的语义特征,由此改善分类性能。另外,本文实验中,WiKi百科语料较搜狗语料的词覆盖率更高,也是基于WiKi百科语料的文本扩展性能更优的原因。

5 结语针对中文新闻标题文本字符数少、特征稀疏,难以提高分类性能的问题,本文提出了基于词向量的短文本扩展方法。首先提取文本副标题、主题词集;再用卷积神经网络学习扩展文本的特征,进而对18个类别的新闻标题分类。结合中文WiKi百科与新闻标题的混合语料生成的词向量,在NLP & CC2017中文标题分类任务的开发集上用本文方法,得到分类正确率为79.42%,比未经扩展的CNN分类模型性能提高9.5%,并通过主题词扩展提高了模型收敛速度。

由于神经网络结构问题,本文方法中存在较多网络超参数。本文仅针对限制扩展特征以控制噪声提出了参数设置策略,但分类性能仍一定程度地依赖于网络超参数。另外,本文的主题词扩展方法聚焦于文本的局部关键特征,这种策略虽较好地控制了词扩展的噪声,也限制了分类性能,后续将针对该问题展开进一步研究。

| [1] | LI H, XU J. Semantic matching in search[J]. Foundations and Trends in Information Retrieval, 2014, 7(5): 343-469. DOI:10.1561/1500000035 |

| [2] | XUE X B, JEON J, CROFT W B. Retrieval models for question and answer archives[C]//Proceedings of the 31st Annual International ACM SIGIR Conference on Research and Development in Information Retrieval. New York:ACM, 2008:475-482. http://dl.acm.org/citation.cfm?id=1390416 |

| [3] | CHEN M G, JIN X M, SHEN D. Short text classification improved by learning multi-granularity topics[C]//Proceedings of the 22nd International Joint Conference on Artificial Intelligence. Menlo Park, CA:AAAI Press, 2011:1776-1781. http://dl.acm.org/citation.cfm?id=2283700&preflayout=flat |

| [4] | PHAN X H, NGUYEN L M, HORIGUCHI S. Learning to classify short and sparse text & Web with hidden topics from large-scale data collections[C]//Proceedings of the 17th International Conference on World Wide Web. New York:ACM, 2008:91-100. http://dl.acm.org/citation.cfm?id=1367510 |

| [5] | 马成龙, 姜亚松, 李艳玲, 等. 基于词矢量相似度的短文本分类[J]. 山东大学学报(理学版), 2014, 49(12): 18-22, 35. (MA C L, JIANG Y S, LI Y L, et al. Short text classification based on word embedding similarity[J]. Journal of Shandong University (Natural Science), 2014, 49(12): 18-22, 35. DOI:10.6040/j.issn.1671-9352.3.2014.295) |

| [6] | 郑诚, 吴文岫, 代宁. 融合BTM主题特征的短文本分类方法[J]. 计算机工程与应用, 2016, 52(13): 95-100. (ZHENG C, WU W X, DAI N. Improved short text classification method based on BTM topic features[J]. Computer Engineering and Applications, 2016, 52(13): 95-100. DOI:10.3778/j.issn.1002-8331.1412-0307) |

| [7] | 张海涛, 王斌君, 王靖亚. 基于背景重构与边缘相关短文本特征选择方法[J]. 武汉大学学报(工学版), 2016, 49(3): 469-475. (ZHANG H T, WANG B J, WANG J Y. A short text feature selection method based on context reconstruction and marginal relevance[J]. Engineering Journal of Wuhan University, 2016, 49(3): 469-475.) |

| [8] | 高元, 刘柏嵩. 基于集成学习的标题分类算法研究[J]. 计算机应用研究, 2017, 34(4): 1004-1007. (GAO Y, LIU B S. Headlines classification method based on ensemble learning[J]. Application Research of Computers, 2017, 34(4): 1004-1007.) |

| [9] | LE Q, MIKOLOV T. Distributed representations of sentences and documents[EB/OL].[2017-04-06]. http://proceedings.mlr.press/v32/le14.pdf. |

| [10] | KALCHBRENNER N, GREFENSTETTE E, BLUNSOM P. A convolutional neural network for modelling sentences[EB/OL].[2017-04-06]. http://www.cs.wayne.edu/~mdong/Kalchbrenner_DCNN_ACL14.pdf. |

| [11] | KIM Y. Convolutional neural networks for sentence classification[C]//Proceedings of the 2014 Conference of Empirical Methods in Natural Language Processing. New York:ACM, 2014:1746-1751. |

| [12] | WANG P, XU B, XU J M, et al. Semantic expansion using word embedding clustering and convolutional neural network for improving short text classification[J]. Neurocomputing, 2016, 174(PB): 806-814. |

| [13] | MITCHELL J, LAPATA M. Composition in distributional models of semantics[J]. Cognitive Science, 2010, 34(8): 1388-1429. DOI:10.1111/cogs.2010.34.issue-8 |

| [14] | MIKOLOV T, CHEN K, CORRADO G, et al. Efficient estimation of word representations in vector space[EB/OL].[2017-04-06]. http://www.surdeanu.info/mihai/teaching/ista555-spring15/readings/mikolov2013.pdf. |

| [15] | MIKOLOV T, YIH W T, ZWEIG G. Linguistic regularities in continuous space word representations[EB/OL].[2017-04-06]. https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/rvecs.pdf. |

| [16] | MIKOLOV T, SUTSKEVER L, CHEN K, et al. Distributed representations of words and phrases and their compositionality[EB/OL].[2017-04-06]. http://www.cs.wayne.edu/~mdong/5021-distributed-representations-of-words-and-phrases-and-their-compositionality.pdf. |

| [17] | QUAN X J, LIU G, LU Z, et al. Short text similarity based on probabilistic topics[J]. Knowledge and Information Systems, 2010, 25(3): 473-491. DOI:10.1007/s10115-009-0250-y |

| [18] | BENGIO Y, SCHWENK H, SENÉCAL J S, et al. Neural probabilistic language models[M]. Berlin: Springer, 2006: 137-186. |

| [19] | LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 |

| [20] | HINTON G E, SRIVASTAVA N, KRIZHEVSKY A, et al. Improving neural networks by preventing co-adaptation of feature detectors[J]. Computer Science, 2012, 3(4): 212-223. |

| [21] | TURIAN J, RATINOV L, BENGIO Y. Word representations:a simple and general method for semi-supervised learning[C]//Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA:ACL, 2010:384-394. |