2. 西北工业大学 航空学院, 西安 710072

2. School of Aeronautics, Northwestern Polytechnical University, Xi'an Shaanxi 710072, China

随着智能时代的到来,场景解析作为计算机视觉研究方向上的重要技术领域,近年来取得了突飞猛进的发展,这对于有效地实现目标检测[1]、姿态估计[2]以及图像检索[3]等智能任务起到至关重要的作用。场景解析作为一项复杂的计算机视觉工作,不仅需要检测并分割出场景中出现的不同物体,而且需要识别出不同物体所属的类别。因此,实现场景解析的核心技术是准确地为图像中每个像素作分类[4-5]。

近年来,基于卷积神经网络(Convolutional Neural Network, CNN)的方法已经在场景解析工作中取得巨大成功[6-12]。这些方法提出的全CNN(Fully CNN, FCNN)以现有成熟的对象分类网络(Visual Geometry Group Network, VGGNet)为基础,首选修改分类网络末端的全连接层为卷积层,然后级联卷积层的特征作为反卷积层的输入,最后采用端到端、像素到像素的训练方式完成面向RGB或RGB-D图像的场景解析。但是,由于CNN的感知域较小,所以单纯CNN的方法仅能学习有限局部区域内的空间结构化信息。如果想要实现更准确的场景解析,就需要网络具有较强的空间结构化学习能力,能够感知图像的全局空间状态,即图像中物体所处空间的物体分布。

为此,具有空间结构化学习能力的条件随机场(Conditional Random Field, CRF)联合CNN的混合网络架构应运而生[13-16]。CRF通过最小化定义在图模型上的能量函数,使得特征相近的相邻像素对或超像素对类别相同,相差较大的类别不同,从而实现场景解析中物体轮廓的一致性和平滑性优化。但是,CRF的能量函数仅能描述图像中物体之间的距离(位置)和相似度(颜色、纹理等),无法较为充分地学习物体所处空间的物体分布,因此,场景解析的效果提升的并不显著。

最近,长短期记忆网络(Long Short-Term Memory, LSTM)联合CNN的混合架构在场景解析中取得了一些突破[12, 17]。LSTM是具有门和存储结构的特殊递归神经网络,它主要通过学习物体间的空间依赖关系实现一定程度的空间结构化信息推理。文献[17]设计了一种基于图模型的LSTM网络,该网络首先对输入图像进行超像素分割,然后按照Confidence-Driven的更新策略遍历图像中每一个超像素,最后利用具有自适应遗忘门的LSTM来学习物体间的空间依赖关系,这样不仅可以提升网络的训练效率,而且能够准确地学习空间结构化信息。在此基础上,文献[12]提出了一种基于LSTM的端到端深度网络,该网络不仅能够有机地融合RGB和深度图像的卷积特征,而且能够通过LSTM进行空间结构化信息的提取,从而完成RGB-D图像的场景解析。但是,现有基于LSTM的方法仅学习RGB图像的平面空间结构化信息,没有充分地利用深度图像提供的深度空间结构化信息,因此无法全面地学习RGB-D图像中物体所处3D空间的物体分布。

为了解决上述问题,本文提出新颖的三维空间结构化编码深度网络(Three-dimensional Spatial Structured Encoding Deep Network, 3D-SSEDN),3D-SSEDN以CNN和CRF的混合架构为基础,能够结合CNN和CRF各自的优点。与现有深度网络不同,本文将CRF作为3D-SSEDN的中间层,并与本文提出的空间结构化编码算法(Spatial Structured Encoding Algorithm, SSEA)有机地结合。这样,3D-SSEDN不仅可以充分地发挥FCNN的特征提取能力,而且能够有机地结合CRF和SSEA学习RGB-D图像中物体的3D空间结构化信息,进而适合利用深度置信网络(Deep Belief Network, DBN)巧妙地挖掘物体各类特征之间的非线性关系,从而能够生成包含丰富RGB-D图像语义信息的混合特征。

本文的主要工作如下:

1) 提出空间结构化编码算法。SSEA通过划分物体所处3D空间,以编码的方式较为准确地学习和描述RGB-D图像中物体所处3D空间的物体分布,从而生成包含3D结构化信息的空间关系特征。这样,3D-SSEDN不仅能够根据物体本身的视觉特征和深度特征(FCNN提取的RGB-D图像特征)作分类,而且能够利用物体的空间关系特征调优分类结果。

2) 运用多模态特征融合方法。本文通过DBN融合视觉特征、深度特征和空间关系特征,从而挖掘各类特征之间的非线性关系,融合生成的混合特征能够更全面地表达物体的语义信息。

本文在NYUDv2[18]和SUNRGBD[19]标准RGB-D数据集上进行了对比实验,结果表明:本文提出的3D-SSEDN较现有先进的场景解析方法能够显著地提升场景解析的结果。

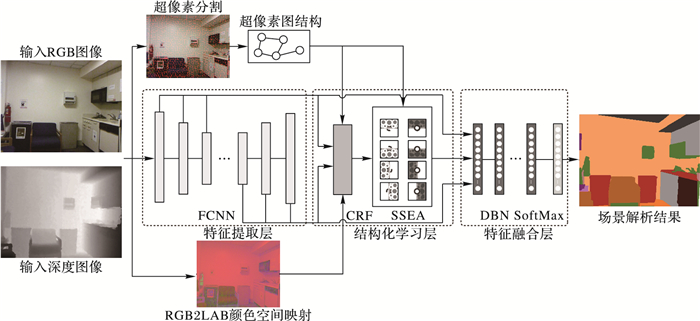

1 三维空间结构化编码深度网络本文提出的三维空间结构化编码深度网络3D-SSEDN包含三个部分:特征提取层、结构化学习层和特征融合层。其中,特征提取层主要由全卷积神经网络FCNN构成,用来分别提取RGB和深度图像中物体的视觉和深度多维特征;结构化学习层有机地结合条件随机场CRF和空间结构化编码算法SSEA,SSEA通过CRF的分类概率推理超像素所处3D空间的物体分布,从而获取超像素的空间关系特征;特征融合层主要包括深度置信网络DBN,用来对上述学习到的超像素视觉特征、深度特征和空间关系特征作融合。整个3D-SSEDN的网络框架如图 1所示。

|

图 1 三维空间结构化编码深度网络 Figure 1 Three-dimensional spatial structured encoding deep network |

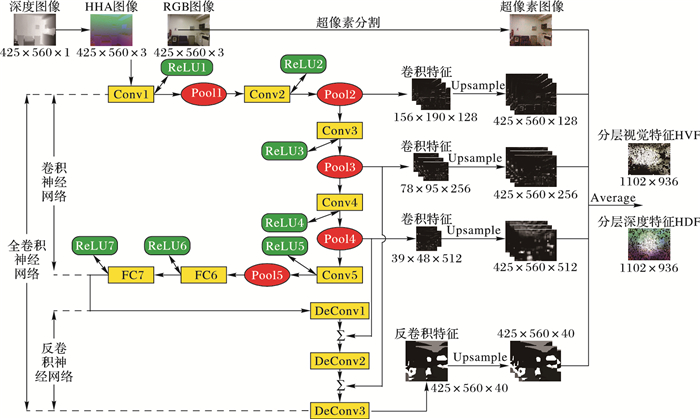

在场景解析研究中,提取的特征将直接影响分类结果。最近的研究表明包含多层物体信息的特征能够提升分类结果。这种特征的结构是分层的,不同层次是对物体不同级别的抽象,这意味着特征提取是逐层进行的,因此,由多个卷积层和反卷积层逐级相连构成的FCNN成为特征提取的有效工具。另外,为了更好地利用FCNN提取深度图像的特征,本文将单通道的深度图像转换为3通道的HHA图像[20]。HHA图像的3个通道分别表示物体的深度、高度以及角度,与RGB图像相似,HHA图像能够通过水平视差、垂直视差和重力方向角显示物体的边界。本文使用FCNN提取特征的原理如图 2所示。

|

图 2 特征提取层 Figure 2 Feature extraction layer |

本文通过FCNN分别提取RGB图像和HHA图像中物体的分层视觉特征(Hierarchical Visual Feature, HVF)和分层深度特征(Hierarchical Depth Feature, HDF),其特征提取过程相同,可统一描述为:

假设FCNN的卷积网络包含Lc层,反卷积网络包含Ld层,输入图像为x(RGB或者HHA图像),第l层的输出特征为Fl,那么,第l层的操作可以表示为:

| $ {\mathit{\boldsymbol{F}}_l} = \left\{ \begin{array}{l} x, \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;l = 0\\ pool(rect(conv({\mathit{\boldsymbol{F}}_{l-1}}))), \;\;1 \le l \le {L_c}\\ deconv({\mathit{\boldsymbol{F}}_{l-1}}), \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{L_c} < l \le {L_c} + {L_d} \end{array} \right. $ | (1) |

式中:初始特征F0为输入图像x;函数conv、rect和pool分别表示卷积网络每层的卷积操作、校正操作和池化操作,函数deconv表示反卷积网络每层的反卷积操作。其中,对于卷积网络的每层操作,conv将卷积核内的多个特征值映射为一个,rect(abs、tanh、sigmoid和ReLU等激活函数)对conv生成的特征作修整,pool则挑选生成特征感知域内最敏感的值作为特征值,新生特征尺寸减小,变得抽象;对于反卷积网络的每层操作,deconv与conv相反,它将特征的一个值映射为多个,一方面将特征尺寸还原,另一方面补偿pool造成的物体细节信息损失,新生特征尺寸增大,变得具体。

为了获取包含多层物体信息的特征,本文分别对FCNN卷积和反卷积网络每层提取的特征进行上采样操作,使新生特征尺寸与输入图像相同,然后级联采样后的特征,从而得到HVF和HDF:

| $ \begin{array}{l} \mathit{\boldsymbol{HVF}}|\mathit{\boldsymbol{HDF}} = \left[{up({\mathit{\boldsymbol{F}}_1}), \cdots, up({\mathit{\boldsymbol{F}}_{{L_c}}}), \cdots, up({\mathit{\boldsymbol{F}}_{{L_c} + {L_d}}})} \right];\\ \mathit{\boldsymbol{HVF}}|\mathit{\boldsymbol{HDF}} \in {{\bf R}^{({N_c} + {N_d}) \times H \times W}}, up({\mathit{\boldsymbol{F}}_l}) \in {{\bf R}^{{N_l} \times H \times W}} \end{array} $ | (2) |

其中:Nc和Nd分别表示卷积和反卷积特征的维数;H和W分别表示特征的高度和宽度;up表示上采样函数;Nl表示FCNN第l层提取特征的维数或者卷积核的个数。

本文的多维特征不仅包含卷积特征,而且还包括反卷积特征。其中反卷积特征中还原的物体信息能够弥补卷积特征中由于池化操作丢失的细节信息,而卷积特征中提取的物体信息能够纠正反卷积特征中还原的错误信息。本文将两者相互级联,得到的多维特征能够包含更多有用的物体信息。与此同时,FCNN提取的HHA图像的特征不仅包含物体的深度信息,而且包括物体的视觉信息,与RGB图像的卷积特征相级联能够更准确地表达物体的视觉外观。

1.1.2 超像素分割由于SLIC(Simple Linear Iterative Clustering)超像素分割算法能够快速而准确地划分图像中物体的边界,满足场景解析的要求。因此,本文使用SLIC算法对输入图像进行超像素分割[21-22],并计算超像素块内所有像素特征(HVF、HDF和LAB颜色特征等)的均值,从而以超像素作为训练预测的基本单位。这样不仅可以避免像素特征中噪声导致的分类预测错误,而且能够提升整个网络的训练和预测速度。

假设输入图像x内像素p,p的特征向量为Fp,那么对于x内超像素S,共包含NS个像素,则S的特征向量FS可以定义为超像素S内所有像素特征的L2-范数:

| $ {\mathit{\boldsymbol{F}}_S} = {\left\| {\sum\limits_{p \in S} {{\mathit{\boldsymbol{F}}_p}/{N_S}} } \right\|_2} \in {{\bf R}^N}, {\mathit{\boldsymbol{F}}_p} \in {{\bf R}^N} $ | (3) |

其中:N表示特征向量的维数,当Fp表示HVF和HDF时,N=Nc+Nd;当Fp表示LAB颜色特征时,N=3。

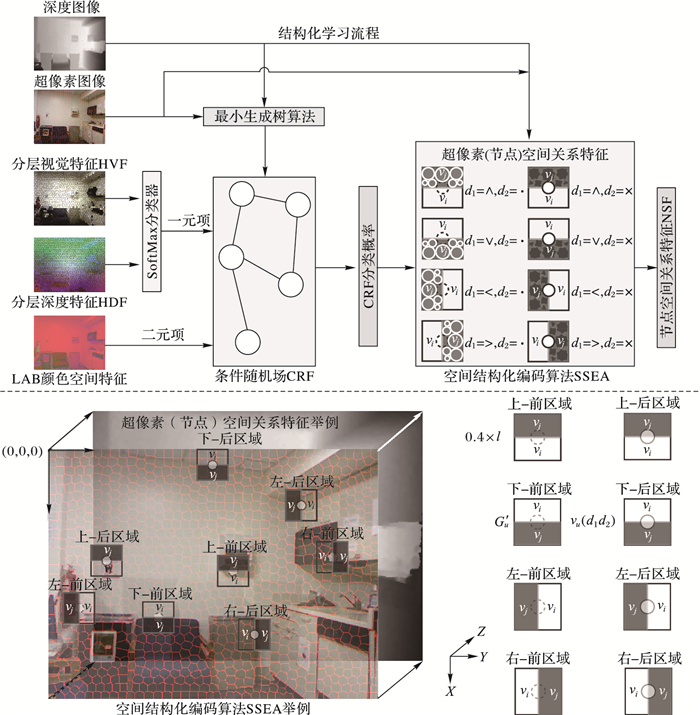

1.2 结构化学习层虽然FCNN能够提取包含多层物体信息的视觉和深度特征,但是这些特征缺少空间结构化信息,可能会出现分类预测错误。为了弥补FCNN的不足,本文在3D-SSEDN中内嵌结构化学习层,该层有机地结合了CRF和空间结构化编码算法SSEA,从而更为全面地学习超像素所处3D空间的物体分布。结构化学习层的原理如图 3所示。

|

图 3 结构化学习层 Figure 3 Structural learning layer |

假设输入图像为x,图像的标签为y,经超像素分割可以得到适合构建x的CRF图模型G=(V, E),其中:V表示超像素节点vi的集合,E表示相邻超像素对(边)eij的集合。由于图G中存在相关性较弱的边,因此本文以相邻超像素对3D质心的2-范数作为图G中边的权值,并通过最小生成树算法生成树型结构G′= (V, E′),从而去除图G中相关性较弱的边[13]。这样,图像x在树型结构G′上的CRF能量函数定义为:

| $ E(y, x;\mathit{\boldsymbol{w}}) = \sum\limits_{i \in V} {{\mathit{\boldsymbol{w}}_N}^{\rm{T}}\mathit{\boldsymbol{U}}({y_i}, {x_i})} + \sum\limits_{(i, j) \in E'} {{\mathit{\boldsymbol{w}}_E}^{\rm{T}}\mathit{\boldsymbol{V}}({y_i}, {y_j}, {x_{ij}})} $ | (4) |

其中:w=[wN, wE]表示CRF的模型参数;U表示一元项,V表示二元项,具体表达式分别如式(5)、(6)。

| $ \mathit{\boldsymbol{U}}({y_i}, {x_i}) = \exp (-{\alpha _u}{\mathit{\boldsymbol{c}}_i}) $ | (5) |

| $ \begin{array}{l} \mathit{\boldsymbol{V}}({y_i}, {y_j}, {x_{ij}}) = \\ \;\;\;\left\{ \begin{array}{l} 1-\exp (-{\alpha _p}\left\| {{\mathit{\boldsymbol{F}}_{{S_i}}}-{\mathit{\boldsymbol{F}}_{{S_j}}}} \right\|_2^2/\beta _v^2)\;, \;\;\;\;{y_i} = {y_j}\\ \exp ( - {\alpha _p}\left\| {{\mathit{\boldsymbol{F}}_{{S_i}}} - {\mathit{\boldsymbol{F}}_{{S_j}}}} \right\|_2^2/\beta _v^2), \;\;\;\;\;\;\;\;{y_i} \ne {y_j} \end{array} \right. \end{array} $ | (6) |

其中:一元项U的参数ci表示利用SoftMax生成的基于HVF和HDF的超像素分类概率;二元项V中的2-范式表示LAB[23]颜色空间内相邻超像素对颜色特征的2-范数,若2-范数的值越接近0,则超像素vi和vj属于同一类别的概率越大,反之,则概率越小。

在CRF的训练阶段,本文使用置信传播算法和L-BFGS(Limited-memory Broyden Fletcher Goldfarb Shanno)优化算法求解CRF的参数w[13]。在CRF的预测阶段,对于一张新的图像x,它的后验概率为:

| $ \mathop {\arg \max }\limits_y p(y|x, {\mathit{\boldsymbol{w}}^ * }) $ | (7) |

那么图像x中超像素vi的分类概率可以表示为bi∈RK,其中K表示类别数。

1.2.2 空间结构化编码算法虽然CRF能够根据相邻超像素对LAB颜色特征的相似度来全局最优化分类概率,但是它仅能实现物体轮廓的一致性和平滑性优化,依然缺乏较强的空间结构化学习能力。为此,本文设计空间结构化编码算法,SSEA通过CRF的分类概率快速地推理超像素所处3D空间的物体分布,从而生成超像素的空间关系特征。

假设超像素vi,以vi为中心的3D邻域空间定义为Gu′=(Vu, Eu′),则vi的节点空间关系特征(Node Spatial structure Feature, NSF), NSFi可以表示为:

| $ \begin{array}{l} \mathit{\boldsymbol{NSF}}{_i} = \left[{\mathit{\boldsymbol{NSF}}{_i}( \wedge \cdot ), } \right.\mathit{\boldsymbol{NSF}}{_i}( \wedge \times ), \mathit{\boldsymbol{NSF}}{_i}( \vee \cdot ), \\ \;\;\;\;\mathit{\boldsymbol{NSF}}{_i}( \vee \times ), \mathit{\boldsymbol{NSF}}{_i}( < \cdot ), \mathit{\boldsymbol{NSF}}{_i}( < \times ), \mathit{\boldsymbol{NSF}}{_i}( > \cdot ), \\ \;\;\;\;\left. {\mathit{\boldsymbol{NSF}}{_i}( > \times )} \right] \in {{\bf R}^{8 \times K}} \end{array} $ | (8) |

其中,NSFi(∧·)、NSFi(∧×)、NSFi(∨·)、NSFi(∨×)、NSFi( < ·)、NSFi( < ×)、NSFi(>·)、NSFi(>×)分别表示超像素vi上-前、上-后、下-前、下-后、左-前、左-后、右-前、右-后8个空间区域内各类别的超像素出现的频率,它们可以统一表示成如下的形式:

| $ \begin{array}{l} \mathit{\boldsymbol{NS}}{\mathit{\boldsymbol{F}}_i}({d_1}{d_2}) = \sum\limits_{{v_j} \in {V_u}({d_1}{d_2})} {{\mathit{\boldsymbol{a}}_j}} \in {{\bf R}^K};\\ \;\;\;\;{d_1} \in \left[{ \wedge, \vee, <, > } \right], {d_2} \in \left[{ \cdot, \times } \right] \end{array} $ | (9) |

其中:Vu(d1d2)表示超像素vi在水平d1和深度d2共同决定方向上的3D空间区域;vj表示区域Vu(d1d2)内的超像素,向量aj表示超像素vj相对于vi的分类概率,其定义如下:

| $ \begin{array}{l} {\mathit{\boldsymbol{a}}_j}(k) = {\mathit{\boldsymbol{b}}_j}(k) \times \exp (-{\alpha _d}d({v_i}, {v_j})/{\sigma _d});\\ \;\;\;\;\;\;\;\;\;\;\;k = 1, 2, \cdots, K \end{array} $ | (10) |

其中:bj表示CRF生成的超像素vj的分类概率; K表示类别数; d(vi, vj)表示超像素vi和vj间的距离; σd表示区域Vu(d1d2)内超像素vj和vi间距离的最大值; αd表示距离衰减率。

这样,NSFi(d1d2)就能够表示超像素vi在水平d1和深度d2共同决定方向上的空间区域内各类别出现的频率,从而近似描述该空间区域的物体分布。若NSFi(d1d2)(k)的值越大,则说明该空间区域内k类别的超像素出现的次数越多,k类别物体所占空间区域面积越大;反之,则说明k类别的超像素出现次数越少,k类别物体所占空间区域面积越小。在此基础上,本文将各空间区域的物体分布级联,从而得到整个空间区域的物体分布。

实际中,假设输入图像x的短边长为l,本文定义vi的空间Gu′为以vi为中心的正方形3D空间邻域,其邻域的边长为0.4 × l。在此基础上,本文定义vi的区域Vu(d1d2)为Gu′空间内超像素vi在水平d1和深度d2共同决定方向上的长方形3D空间区域,如图 3所示。

与单一视觉特征不同,当两个超像素具有相似的视觉特征时,3D-SSEDN就可以根据超像素所处3D空间物体分布的差异区分两个超像素的类别。

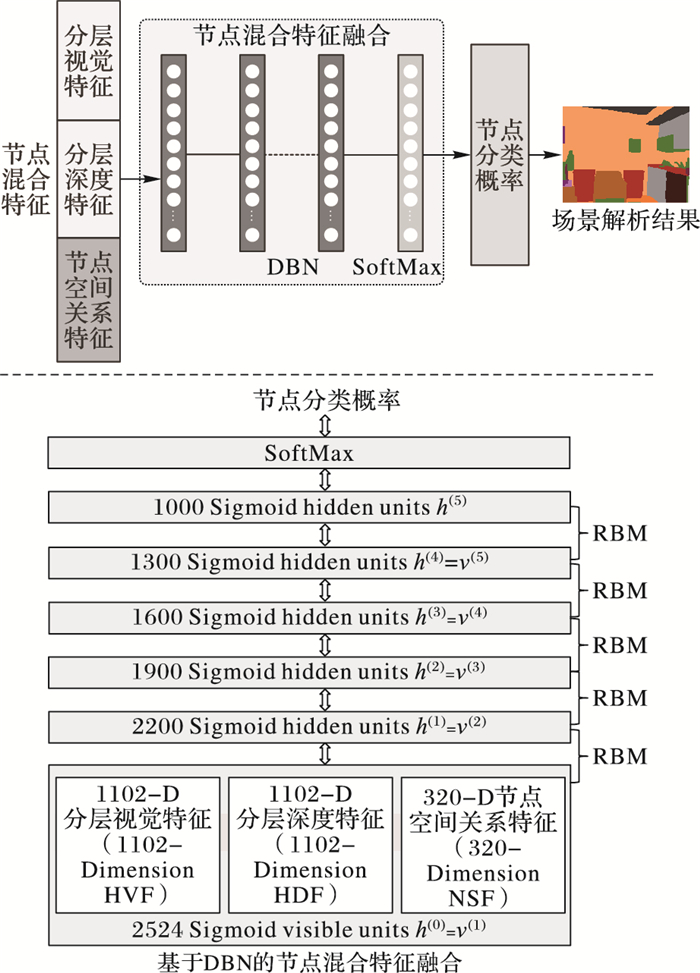

1.3 特征融合层经过特征提取层和结构化学习层的学习,3D-SSEDN可以分别生成超像素的分层视觉特征HVF、分层深度特征HDF以及节点空间关系特征NSF。为了进一步挖掘上述3类特征之间复杂的非线性关系,本文使用DBN对上述特征作融合。同时,特征融合能够对混合特征(级联的HVF、HDF和NSF)进行数据压缩,降低特征的维度,从而去除混合特征中存在的冗余信息,更准确地表达超像素的语义信息。特征融合层的流程如图 4所示。

|

图 4 特征融合层 Figure 4 Feature fusion layer |

研究表明,利用DBN[24]融合不同特征之间的非线性关系来提升物体的分类概率效果显著。DBN由一组受限的波尔兹曼机[25]自下而上堆叠而成,它以级联的多模态特征作为输入,按照低层RBM输出作为高层RBM输入的顺序逐层抽象,最终输出高度抽象的混合特征。

本文采用对比散度算法对RBM作快速训练[26]。在此基础上,训练DBN[27]可以分为预训练和微调两个阶段:在预训练阶段,本文采用无监督的贪心算法自底向上逐层训练DBN中的RBM,得到初始DBN参数;在微调阶段,本文采用无监督的wake-sleep算法对参数调优。为了使得DBN具有分类功能,本文在DBN的顶层添加SoftMax分类器,此时,DBN与标准的前馈神经网络相同,本文采用有监督的反向传播算法进一步调优DBN参数。

1.3.2 特征融合学习本文通过级联超像素的HVF、HDF和NSF得到超像素的节点混合特征(Node Hybrid Feature, NHF)。假设超像素为vi,则vi节点混合特征NHFi可以表示为:

| $ \mathit{\boldsymbol{NH}}{\mathit{\boldsymbol{F}}_i} = \left[{\mathit{\boldsymbol{HV}}{\mathit{\boldsymbol{F}}_i}, \mathit{\boldsymbol{HD}}{\mathit{\boldsymbol{F}}_i}, \mathit{\boldsymbol{NS}}{\mathit{\boldsymbol{F}}_i}} \right] \in {{\bf R}^{2 \times ({N_c} + {N_d}) + 8 \times K}} $ | (11) |

在此基础上,节点混合特征的DBN融合过程可以表示为:

| $ {\mathit{\boldsymbol{\theta }}_i} = fusion\left( {\mathit{\boldsymbol{NH}}{\mathit{\boldsymbol{F}}_i}} \right) \in {{\bf R}^K} $ | (12) |

其中:fusion表示DBN的特征融合操作; θi表示DBN生成的超像素vi的分类概率,即场景解析结果。

2 实验结果与分析为了评价3D-SSEDN网络的场景解析效果,本文使用标准RGB-D数据集NYUDv2[18]和SUNRGBD[19]作训练,并将测试结果与当前的先进方法作比较。另外,本文使用平均准确率(Mean Accuracy)作为场景解析的评价标准[6]。假设nij表示图像中第i类别像素预测为第j类别的数量,nc表示类别数,则图像中第i类别像素的数量ti可以表示为:

| $ {t_i} = \sum\limits_j {{n_{ij}}} $ | (13) |

那么,平均准确率定义为:

| $ meanacc = \left( {\frac{1}{{{n_c}}}} \right)\sum\limits_i {\frac{{{n_{ii}}}}{{{t_i}}}} $ | (14) |

本文提出的3D-SSEDN由3个子网络组成:全卷积神经网络FCNN、条件随机场CRF和深度置信网络DBN。由于各网络间相互独立,可以分别独立训练,因此整个网络框架的训练简单而快速。

在特征提取阶段,首先,将深度图像编码为HHA图像[20]。然后,以BVLC FCN[6]提供的FCN-32s为框架,一方面设置训练参数:mini-batch size=20、learning rate=10-4、momentum=0.99、weight decay=5-4和iterations=105;另一方面通过预训练的VGG_ILSVRC_16_layers模型[6]初始化FCN-32s,并采用随机梯度下降算法对FCN-32s进行训练。在此基础上,分别对RGB和HHA图像进行特征提取,并选取FCN-32s第10、17和24层的卷积特征和第40层的反卷积特征进行上采样操作。最后,通过SLIC算法[21-22]对RGB图像进行超像素分割,并计算超像素的多维特征,本文设置超像素区域尺寸的值为15。

在结构化学习阶段,首先,本文使用UGM工具包[28]构建CRF图模型G,并通过最小生成树算法[13]生成稠密图G对应的树型结构G′,进而采用置信传播算法和L-BFGS优化算法求解CRF的参数w[13],这样CRF就能够通过相邻超像素对在LAB颜色空间[23]的特征相似度来全局最优化分类概率;然后本文应用空间结构化编码算法推理超像素的节点空间关系特征,设置距离衰减率为αd=0.5。

在特征融合阶段,本文使用DBN工具包[29]搭建DBN网络,一方面设置DBN的层数(RBM的个数)以及每层节点的个数(RBM隐藏层节点的个数),如图 4所示;另一方面设置DBN的训练参数:mini-batch size=100、learning rate=0.05、momentum=0.5和maximum epoch=10000。然后,本文通过贪心算法和反向传播算法完成DBN的训练[24-27]。

本研究在2.3 GHz Xeon CPU、8 GB NVIDIA GeForce GTX 1080 GPU、128 GB内存的计算机上进行数据集的训练和测试。

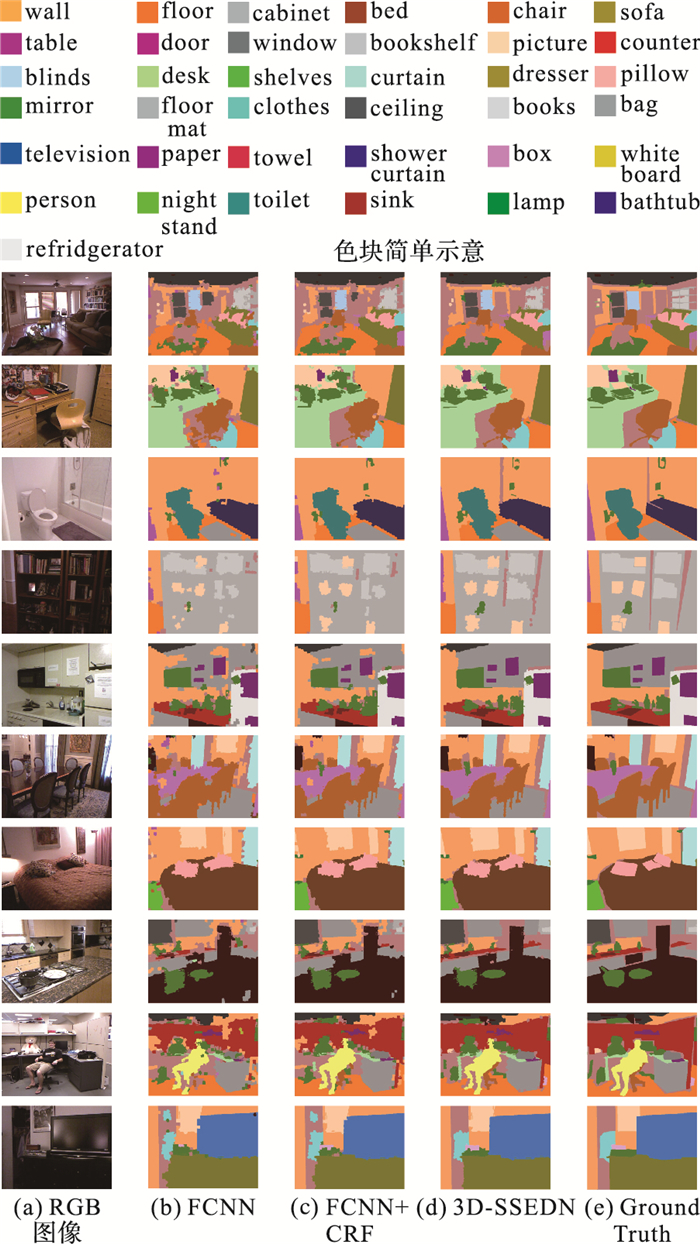

2.2 NYUDv2NYUDv2[18]数据集通过Microsoft Kinect采集深度图像,由795张训练图像和654张测试图像组成,共包含40类室内场景的物体。本文关于该数据集的实验结果如表 1~3所示,其中:表 1表示3D-SSEND训练时间和测试时间(每张图像)的统计结果; 表 2表示3D-SSEND自身对比实验的平均准确率结果; 表 3表示本文方法与现有先进的场景解析方法的平均准确率对比实验结果。场景解析的视觉效果如图 5所示。

| 表 1 NYUDv2数据集上3D-SSEND训练和测试时间 Table 1 Training and testing time of 3D-SSEND on dataset NYUDv2 |

| 表 2 NYUDv2数据集上自身对比实验结果 % Table 2 Self-comparison experimental results on dataset NYUDv2 % |

| 表 3 NYUDv2数据集上本文方法与当前各方法不同物体类别实验结果对比 % Table 3 Experimental result comparison of the proposed method and the current methods for different object categories on NYUDv2 dataset % |

|

图 5 NYUDv2场景解析视觉效果 Figure 5 Scene parsing visual results on dataset NYUDv2 |

表 2中,FCNN-RGB表示利用SoftMax生成的基于分层视觉特征的场景解析结果,FCNN-HHA表示利用SoftMax生成的基于分层深度特征的结果,FCNN表示利用SoftMax生成的基于分层视觉特征和分层深度特征的结果,FCNN+CRF表示CRF调优FCNN后的结果,3D-SSEDN表示本文提出的深度网络的结果。从表 2可以看出:首先,FCNN的结果优于FCNN-RGB和FCNN-HHA,说明分层视觉特征级联分层深度特征能够包含更加丰富的物体形状信息,从而提升场景解析的结果;然后,FCNN+CRF的结果虽然优于FCNN,但是结果提升得并不显著,说明CRF的空间结构化学习能力不强,虽然它能够根据相邻物体间LAB颜色特征的相似度来全局最优化分类概率,但是它仅能实现物体轮廓的一致性和平滑性优化,无法较为充分地学习物体所处空间的物体分布;最后,3D-SSEDN的结果较FCNN+CRF有较为明显的提升,说明本文提出的3D-SSEDN具有较强的空间结构化学习能力,它通过SSEA较为全面地学习RGB-D图像中物体所处3D空间的物体分布,当两个物体具有相似的视觉特征时,3D-SSEDN就可以根据物体所处3D空间物体分布的差异区分两个物体的类别。

表 3为本文方法与文献[7-8, 10-12]的比较结果。3D-SSEDN在场景解析的评价标准中总体上取得较优的结果,其原因归纳如下:1)本文使用FCNN提取RGB-D图像中物体不同抽象级别的视觉和深度特征,级联分层视觉特征和分层深度特征能够包含更加丰富的物体形状信息。2)本文通过空间结构化编码算法生成包含物体所处3D空间物体分布信息的空间关系特征。这样,3D-SSEDN不仅能够根据物体本身的视觉特征和深度特征作分类,而且能够利用物体的空间关系特征调优分类结果。3)本文通过DBN融合视觉特征、深度特征以及空间关系特征,从而能够充分地挖掘3类特征之间的非线性关系,融合生成的混合特征能够更全面地表达物体的语义信息。另外,对于绝大多数物体类别,3D-SSEDN的结果较现有方法有一定程度的提升或基本保持,但是,对于少数物体类别(例如:fridge、shower和nightstand),3D-SSEDN和现有方法的场景解析结果都很不理想,这主要是由于NYUDv2数据集中各类别物体出现的频率不均衡造成的,而与网络结构的设计无关。

不同方法NYUDv2场景解析视觉效果如图 5所示。

从图 5视觉效果图中可以看出:首先,由图 5(b)~(d)可知,3D-SSEDN场景解析后物体的轮廓比FCNN和FCNN+CRF更接近Ground Truth,从而进一步验证了表 2的实验结果;然后,无论物体的轮廓是简单(door、bed、sofa等)还是复杂(person、clothes、chair等),场景解析的结果均与Ground Truth接近,表明3D-SSEDN提取的特征能够比较全面地表达图像的语义信息;最后,对于尺寸小于超像素的物体,3D-SSEDN会出现解析错误,其原因可能是超像素替代像素完成解析任务造成的,这样虽然能够加速整个网络的训练和预测,但是网络却可能丢失尺寸很小物体的细节信息。

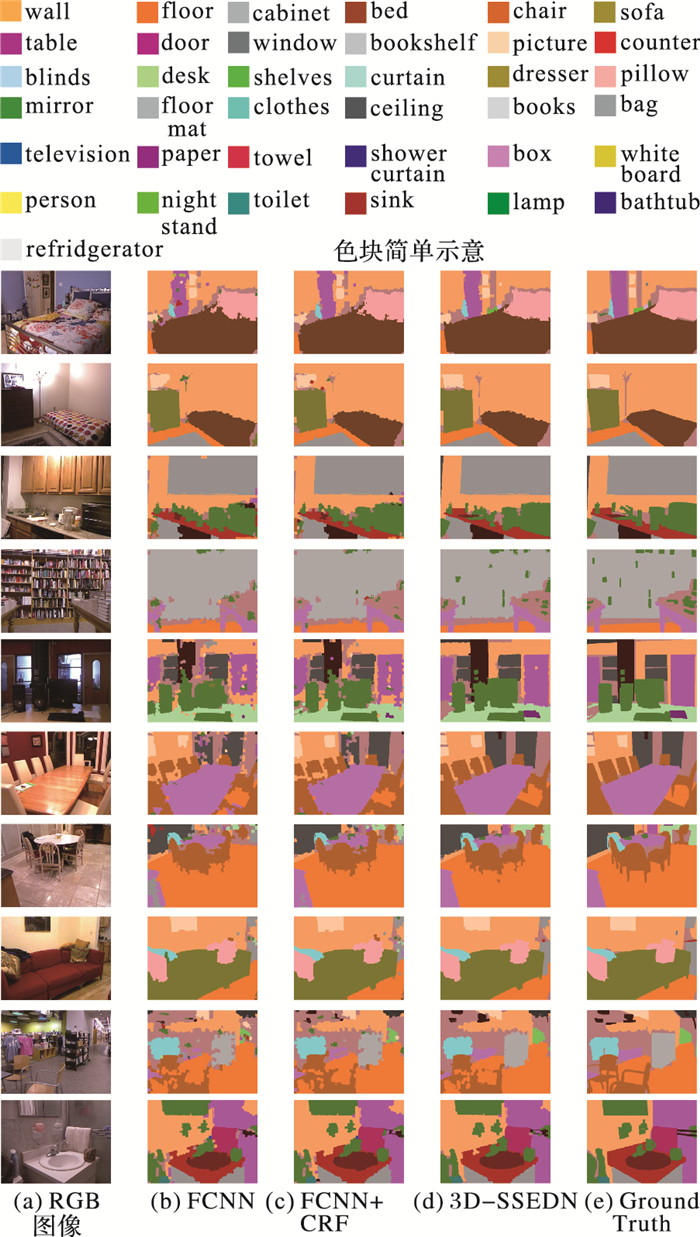

2.3 SUNRGBDSUNRGBD[19]是目前最大的RGB-D图像数据集,由5285张训练图像和5050张测试图像组成,其图像分别来自4个不同的数据集:NYUDv2[18]、Berkeley B3DO[30]、SUN3D[31]和SUNRGBD[19],共包含40类室内场景的物体。本文方法在该数据集上的训练时间和测试时间如表 4所示,关于该数据集的实验结果如表 5~6所示,场景解析视觉效果如图 6所示。

| 表 4 SUNRGBD数据集上3D-SSEND训练和测试时间 Table 4 Training and testing time of 3D-SSEND on dataset SUNRGBD |

| 表 5 SUNRGBD数据集上自身对比实验结果 % Table 5 Self-comparison experimental results on dataset SUNRGBD % |

| 表 6 SUNRGBD数据集上本文方法与当前各方法不同物体类别实验结果对比 % Table 6 Experimental result comparison of the proposed method and the current methods for different object categories on dataset SUNRGBD % |

|

图 6 SUNRGBD场景解析视觉效果 Figure 6 Scene parsing visual results on SUNRGBD dataset |

从表 5中可以看出:3D-SSEDN的场景解析结果明显优于FCNN和FCNN+CRF,进一步证明3D-SSEDN具有较强的空间结构化学习能力。表 6中,将3D-SSEDN与现有先进方法[9-10, 12]作比较,总体上也均取得较优的结果,从而再次验证了本文提出的SSEA算法性能,通过该算法生成的空间关系特征能够更准确地描述物体所处3D空间的物体分布,在此基础上3D-SSEDN将视觉特征、深度特征和空间关系特征相互融合,生成的混合特征能够更准确地表达物体的语义信息,从而弥补了单一视觉特征的不足,显著地提升了场景解析的结果。

3 结语本文针对RGB-D场景解析提出三维空间结构化编码深度网络3D-SSEDN,该网络主要包含3个部分:特征提取层、结构化学习层和特征融合层。与其他方法不同,3D-SSEDN内嵌的结构化学习层有机地结合了CRF和空间结构化编码算法,SSEA能够比较准确地学习物体所处3D空间的物体分布。在此基础上,3D-SSEDN通过DBN对视觉特征、深度特征和空间关系特征进行融合。这样,3D-SSEDN网络不仅能够提取不同抽象级别的视觉特征和深度特征,而且可以生成包含空间结构化信息的空间关系特征,进而得到更为准确表达图像语义信息的混合特征。实验结果表明,在标准数据集上,本文提出的3D-SSEDN的场景解析结果能够达到较高的准确率。因此,该网络可以应用于实际的视觉任务中。

本文设计的3D-SSEDN网络被划分为3个独立的部分,这样虽然能够缩短网络训练和测试时间,但是可能无法充分利用结构化学习层的优势。因此,后续将研究构建网络3个部分的新架构,从而适合利用反向传播算法联合优化整个网络,进一步挖掘结构化学习层的空间结构化学习能力。

| [1] | 徐超, 闫胜业. 改进的卷积神经网络行人检测方法[J]. 计算机应用, 2017, 37(6): 1708-1715. (XU C, YAN S Y. Improved pedestrian detection method based on convolutional neural network[J]. Journal of Computer Applications, 2017, 37(6): 1708-1715. DOI:10.11772/j.issn.1001-9081.2017.06.1708) |

| [2] | HINTERSTOISSER S, LEPETIT V, ILIC S, et al. Model based training, detection and pose estimation of texture-less 3D objects in heavily cluttered scenes[C]//ACCV 2012:Proceedings of the 11th Asian Conference on Computer Vision. Berlin:Springer, 2012:548-562. |

| [3] | SCHUSTER S, KRISHNA R, CHANG A, et al. Generating semantically precise scene graphs from textual descriptions for improved image retrieval[C]//Proceedings of the 2015 Fourth Workshop on Vision and Language. Stroudsburg, PA:ACL, 2015:70-80. http://www.mendeley.com/research/generating-semantically-precise-scene-graphs-textual-descriptions-improved-image-retrieval/ |

| [4] | SHOTTON J, WINN J, ROTHER C, et al. Textonboost for image understanding:multi-class object recognition and segmentation by jointly modeling texture, layout, and context[J]. International Journal of Computer Vision, 2009, 81(1): 2-23. DOI:10.1007/s11263-007-0109-1 |

| [5] | FARABET C, COUPRIE C, NAJMAN L, et al. Learning hierarchical features for scene labeling[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(8): 1915-1929. DOI:10.1109/TPAMI.2012.231 |

| [6] | LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:3431-3440. |

| [7] | KHAN S H, BENNAMOUN M, SOHEL F, et al. Integrating geometrical context for semantic labeling of indoor scenes using RGBD images[J]. International Journal of Computer Vision, 2016, 117(1): 1-20. DOI:10.1007/s11263-015-0843-8 |

| [8] | GUPTA S, ARBELÁEZ P, GIRSHICK R, et al. Indoor scene understanding with RGB-D images:bottom-up segmentation, object detection and semantic segmentation[J]. International Journal of Computer Vision, 2015, 112(2): 133-149. DOI:10.1007/s11263-014-0777-6 |

| [9] | KENDALL A, BADRINARAYANAN V, CIPOLLA R. Bayesian SegNet:model uncertainty in deep convolutional encoder-decoder architectures for scene understanding[EB/OL].[2017-04-10]. http://pdfs.semanticscholar.org/9694/c4d214a59979ee182136e9dfb2975dfebaa2.pdf. |

| [10] | REN X F, BO L F, FOX D. RGB-(D) scene labeling:features and algorithms[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:2759-2766. http://dl.acm.org/citation.cfm?id=2355029 |

| [11] | WANG A, LU J, CAI J, et al. Unsupervised joint feature learning and encoding for RGB-D scene labeling[J]. IEEE Transactions on Image Processing, 2015, 24(11): 4459-4473. DOI:10.1109/TIP.2015.2465133 |

| [12] | LI Z, GAN Y K, LIANG X D, et al. LSTM-CF:unifying context modeling and fusion with LSTMs for RGB-D scene labeling[C]//Proceedings of the 2016 European Conference on Computer Vision, LNCS 9906. Berlin:Springer, 2016:541-557. |

| [13] | CADENA C, KOŠECKÁ J. Semantic segmentation with heterogeneous sensor coverages[C]//Proceedings of the 2014 IEEE Conference on Robotics and Automation, Washington, DC:IEEE Computer Society, 2014:2639-2645. http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=6907237 |

| [14] | ZHENG S, JAYASUMANA S, ROMERA-PAREDES B, et al. Conditional random fields as recurrent neural networks[EB/OL].[2017-04-10]. http://www.robots.ox.ac.uk/~szheng/papers/CRFasRNN.pdf. |

| [15] | LIN G S, SHEN C H, VAN DEN HENGEL A, et al. Efficient piecewise training of deep structured models for semantic segmentation[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2016:3194-3203. https://www.computer.org/csdl/proceedings/cvpr/2016/8851/00/8851d194-abs.html |

| [16] | 李艳丽, 周忠, 吴威. 一种双层条件随机场的场景解析方法[J]. 计算机学报, 2013, 36(9): 1898-1907. (LI Y L, ZHOU Z, WU W. Scene parsing based on a two-level conditional random field[J]. Chinese Journal of Computers, 2013, 36(9): 1898-1907.) |

| [17] | LIANG X D, SHEN X H, FENG J S, et al. Semantic object parsing with graph LSTM[C]//Proceedings of the 2016 European Conference on Computer Vision, LNCS 9905. Berlin:Springer, 2016:125-143. |

| [18] | SILBERMAN N, HOIEM D, KOHLI P, et al. Indoor segmentation and support inference from RGBD images[C]//Proceedings of the 201212th European Conference on Computer Vision, LNCS 7576. Berlin:Springer, 2012:746-760. http://link.springer.com/chapter/10.1007/978-3-642-33715-4_54 |

| [19] | SONG S, LICHTENBERG S P, XIAO J X. SUN RGB-D:a RGB-D scene understanding benchmark suite[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:567-576. http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=7298655 |

| [20] | GUPTA S, GIRSHICK R, ARBELÁEZ P, et al. Learning rich features from RGB-D images for object detection and segmentation[C]//Proceedings of the 2014 European Conference on Computer Vision, LNCS 8695. Berlin:Springer, 2014:345-360. http://rd.springer.com/chapter/10.1007/978-3-319-10584-0_23 |

| [21] | ACHANTA R, SHAJI A, SMITH K, et al. SLIC superpixels compared to state-of-the-art superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2282. DOI:10.1109/TPAMI.2012.120 |

| [22] | 王春波, 董红斌, 印桂生, 等. 基于Hadoop的超像素分割算法[J]. 计算机应用, 2016, 36(11): 2985-2992. (WANG C B, DONG H B, YIN G S, et al. Super pixel segmentation algorithm based on Hadoop[J]. Journal of Computer Applications, 2016, 36(11): 2985-2992. DOI:10.11772/j.issn.1001-9081.2016.11.2985) |

| [23] | SMITH T, GUILD J. The CIE colorimetric standards and their use[J]. Transactions of the Optical Society, 1931, 33(3): 73-134. DOI:10.1088/1475-4878/33/3/301 |

| [24] | HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507. DOI:10.1126/science.1127647 |

| [25] | FREUND Y, HAUSSLER D. Unsupervised learning of distributions on binary vectors using two layer networks, Technical Report UCSC-CRL-94-25[R]. Santa Cruz, CA:University of California at Santa Cruz, 1994. |

| [26] | HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural Computation, 2006, 18(7): 1527-1554. DOI:10.1162/neco.2006.18.7.1527 |

| [27] | HINTON G E. Training products of experts by minimizing contrastive divergence[J]. Neural Computation, 2002, 14(8): 1771-1800. DOI:10.1162/089976602760128018 |

| [28] | SCHMIDT M. UGM:a matlab toolbox for probabilistic undirected graphical models[EB/OL].[2017-04-10]. http://www.cs.ubc.ca/~schmidtm/Software/UGM.html. |

| [29] | PERCEPTRON M. DeepLearning 0.1 documentation[EB/OL].[2017-04-10]. http://deeplearning.net/tutorial/. |

| [30] | JANOCH A, KARAYEV S, JIA Y Q, et al. A category-level 3D object dataset:putting the kinect to work[M]//Consumer Depth Cameras for Computer Vision. London:Springer, 2013:141-165. |

| [31] | XIAO J X, OWENS A, TORRALBA A. SUN3D:a database of big spaces reconstructed using sfm and object labels[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2013:1625-1632. http://doi.ieeecomputersociety.org/10.1109/ICCV.2013.458 |