随着电子商务的普及,越来越多的年轻人倾向于网上购买服装,网上购物平台提供的主要是通过文本关键字进行服装检索的服务(Texture-Based Image Retrieval, TBIR)[1-2]。对于电商而言,TBIR需要耗费大量的人力物力对每日新增入库的商品进行标注;对于购物者而言,TBIR返回的往往是商品品类的大类,比如连衣裙,需要用户在返回的海量结果中根据自己的需求、喜好进一步筛选,这就使得用户体验不佳。

近年来发展的基于内容的图像检索技术(Content-Based Image Retrieval, CBIR)受到广泛关注,尤其是在服装检索领域[3-10]。花卉识别、百度识图、拍立淘等产品,都是“以图搜图”的成功应用。CBIR通过对服装图片抽取颜色、形状、纹理等低层特征,以此建立查询索引库,然后计算与查询图片特征之间的相似度,返回与用户查询最匹配的商品,一定程度上提升了检索的精度。其中比较典型的方法包括:文献[11]提出利用HSV颜色模型提取服装颜色实现服装检索;文献[12]提出将切割颜色直方图、颜色距、前景颜色直方图三种算法得到的欧氏距离线性加权,进一步去除背景干扰;文献[13]提出运用鲁棒性强、速度快的SURF(Speeded-Up Robust Feature)算法来减少光照、尺度、角度引起的误差。通常,单一特征提取的信息较为单一,描述能力较弱,例如方向梯度直方图(Histogram of Oriented Gradient, HOG),而多特征融合包含更丰富的信息,能更好地处理这一问题。文献[14]提出分二次检索,先利用款式缩小检索范围,在此基础上融合颜色直方图进一步排除干扰。文献[15]提出组合颜色、花型、款式三种特征来全方位检索服装。但这些算法大部分都是基于单一的低层视觉特征或者简单的多特征线性融合,对于复杂背景干扰,视角、姿态引起的服装形变无法得到较为满意的检索结果。

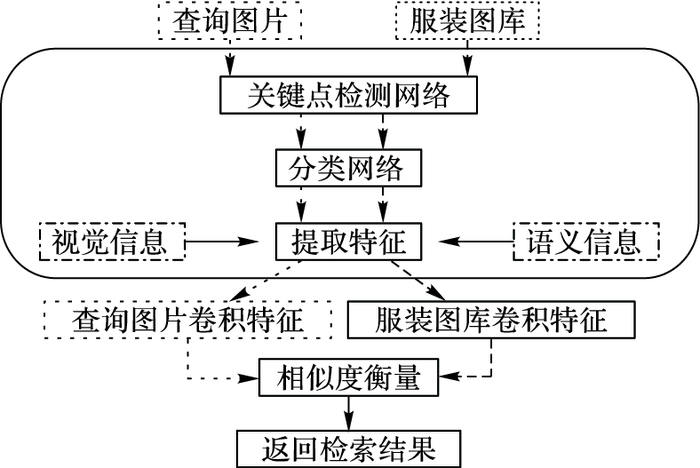

上述传统检索算法是使用低层视觉特征来度量服装图片之间的相似性,缺少了对图片高层语义信息的理解,这正是传统特征对目前检索任务难以胜任的主要原因[16]。近几年流行的深度学习(Deep Learning)在图像分类[17-19]、目标检测[20-22]、物体分割、人脸识别[23-24]等分类、回归视觉任务中取得突破性进展[25-26],揭示了卷积神经网络(Convolutional Neural Network, CNN)对低层视觉特征和高层语义特征的强大表征能力。CNN一般包括卷积层(Convolution Layer)、池化层(Pooling Layer)和全连接层(Fully-Connected Layer)。一般来说,不同的卷积层抽取图像的不同信息,浅层的卷积主要描述图像的形状、颜色、纹理等低层视觉信息,深层的卷积主要描述图像的高层语义信息,融合不同卷积层的特征能更好的表达图像,处理更加复杂的视觉任务。针对传统特征的不足之处,本文利用CNN回归关键点,提出级联多个卷积神经网络,采取由粗到细策略,逐步定位服装关键点:衣领(Collar)、袖子(Sleeve)、边(Hem),检索框架如图 1所示。

|

图 1 基于关键点的服装检索框架 Figure 1 Clothing retrieval framework based on key points |

利用关键点中暗含的空间几何信息,对服装进行对齐、配准, 解决传统形状特征无法应对的服装形变问题。在关键点定位的基础上,利用CNN提取关键点区域低层卷积特征和整幅图像高层卷积特征,充分整合视觉和语义信息,更好地实现了服装检索中的同款和相似款式的检索。实验结果表明,文本算法在大规模服装数据库中能取得较为理想的检索效果。

1 关键点检测当视角不同或姿态变化时,同款服装的形状会发生很大尺度的变化,如图 2所示,基于传统形状特征算法很难处理这种问题。此外,图中地面颜色与上衣的颜色近似,复杂的背景也给基于颜色特征的检索算法带来了严峻的挑战。在人脸识别中,为了有效处理不同姿态(角度、遮挡、夸张表情)问题,一般采用关键点检测,预先进行人脸的配准和对齐。受这一思想启发,对于不同形变服装进行暗含几何约束的关键点检测是有必要的,然后在检测到的关键点周边区域提取卷积特征来进行相似性度量,有效地解决了服装形变和复杂背景干扰等问题,极大地提高了检索精度。

|

图 2 视角、姿态引起的服装形状变化 Figure 2 Shape changes caused by angle and attitude |

深度卷积神经网络在分类、回归诸多领域得到成功应用,主要归因于其强大的特征学习能力。本文设计三个卷积神经网络级联,采取“由粗到细”的策略来回归服装关键点。文中的服装关键点标定为3组6个点:左衣领A、右衣领B;左袖子C、右袖子D;左下侧边E、右下侧边F。

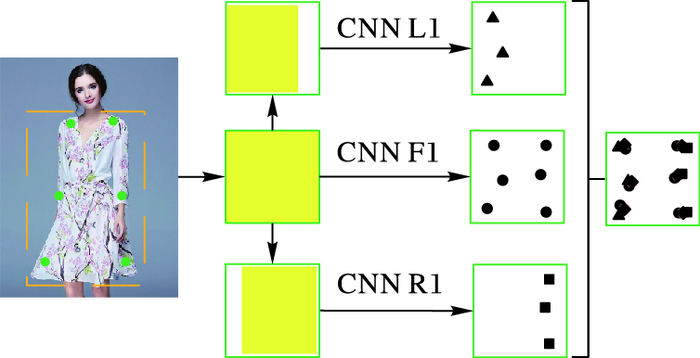

第一级网络主要是对关键点进行粗定位,包含三个深度卷积神经网络,分别是CNN L1、CNN F1、CNN R1,L和R是对服装左右两侧的三个关键点监测,F是对整个服装的检测,相近的网络可以学习出服装的对称结构,如图 3所示。

|

图 3 Level1结构 Figure 3 Level1 structure |

其中,绿色方框表示左侧图片中黄色虚线框标定的服装区域,黄色区域表示各个网络的输入,三角、圆点、正方形表示三个网络各自的预测输出,菱形表示这一级网络的最终位置的预测输出。虚线框内的服装区域检测可由Faster RCNN(Faster Regions with Convloutional Neural Network)、SSD(Single Shot MultiBox Detector)、YOLO(You Only Look Once)等目标检测算法得到,这不是本文的重点,在此不进行深入的探讨。3个深度卷积神经网络的输入是不同的,CNN L1以服装的左侧区域为输入,CNN R1以服装的右侧区域为输入,CNN F1则以整个服装区域作为输入。这样做的原因有两点:首先,能充分利用服装区域的上下文信息,并结合CNN提取的全局特征,避免了回归时出现局部最优值情况,保证了网络训练的可收敛性;其次,由于暗含了关键点的几何约束,使用多个网络同时预测多个值,且每个关键点的位置由多个网络平均得到,使得在单个网络预测出现偏差时也能有效地预测6个位置,尽可能保证第一级网络预测结果的可靠性。

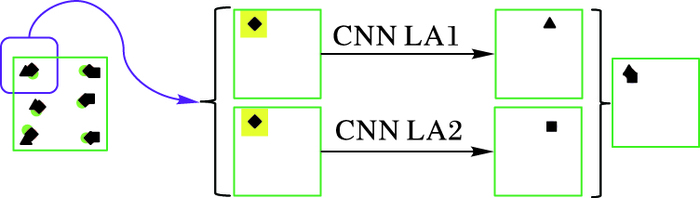

第二级网络主要进行位置的调整,其结构如图 4所示,使用两个同结构的卷积神经网络分别对上一级预测得到的6个关键点进行微调,网络的输入改变成以关键点为中心的n×n的正方形区域,本文中将n设置为15。在前一级网络预测结果的周边局部区域上微调关键点的位置,目的是进一步减小定位误差,实现更加精确定位,最终预测关键点位置同样由多个网络的输出平均得到。第三级网络与第二级网络结构相同。

|

图 4 Level2结构 Figure 4 Level2 structure |

随着级联层数的加深,网络的输入变得越来越小,由于输入的是局部信息,缺少相应的上下文信息,会产生因局部区域表现的不可靠导致网络发散的后果。除此之外,随着级联层数的加深,模型的训练时间也会相应增加。为了压缩模型训练时间和确保关键点定位的可靠性,本文只选择了3级网络级联结构。级联网络最终的预测输出可用式(1)来描述:

| $\left\{ {\begin{array}{*{20}{l}} {x = \frac{{x_1^{(1)} + x_2^{(1)} + \cdots x_{{k_1}}^{(1)}}}{{{k_1}}} + \sum\limits_{i = 2}^3 {\frac{{\Delta x_1^{(i)} + \Delta x_2^{(i)} + \cdots \Delta x_{{k_i}}^{(i)}}}{{{k_i}}}} }\\ {y = \frac{{y_1^{(1)} + y_2^{(1)} + \cdots y_{{k_1}}^{(1)}}}{{{k_1}}} + \sum\limits_{i = 2}^3 {\frac{{\Delta y_1^{(i)} + \Delta y_2^{(i)} + \cdots \Delta y_{{k_i}}^{(i)}}}{{{k_i}}}} } \end{array}} \right.$ | (1) |

其中:(x, y)表示最终的关键点坐标,ki表示第i级网络预测的个数。

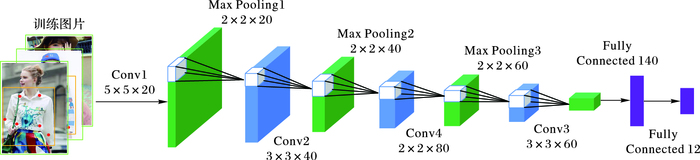

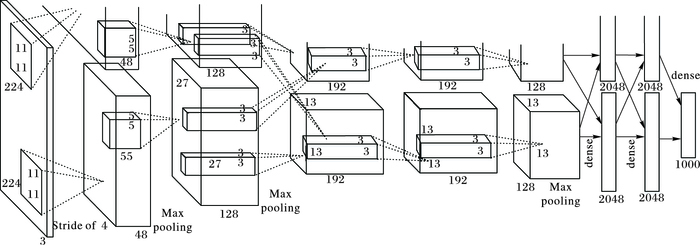

1.2 网络结构本节主要介绍各级网络的具体实现结构。在上节提到,第一级网络结构主要是对关键点的粗定位,但实际上期望实现的是尽可能精准且极小的定位偏差,这样才能为后继网络提供更合理的输入区域,所以这级网络需要相对较深的网络结构。图 5是CNN F1的网络结构,具体包括4层卷积层、3层池化层、2层全连接层。其中,池化层选择最大池化而不是平均池化,主要是其能更好保留纹理信息,便于关键点回归。另外,最后一层全连接含有12个神经元,用于6个关键点的坐标位置回归。

|

图 5 F1网络结构 Figure 5 F1 network structure |

后继两级级联是对前一级预测结果的微调,所以网络相对较浅,同时也能减少级联框架的训练时间。表 1和表 2分别列出了第一级、二三两级网络的具体结构。表中,F1、L1、R1分别代表第一级中的三个网络;S表示二三两级中的网络;Input表示网络的输入;C表示卷积层,两列数字分别表示卷积核的大小和Feature Map数目;P表示池化层,数字表示卷积核大小;FC表示全连接层,数字为该层神经元数目。

| 表 1 第一级子网结构 Table 1 The first subnet structure |

| 表 2 二三两级子网结构 Table 2 The second and third subnet structure |

在卷积神经网络中,深层卷积提取的是语义信息,浅层卷积提取的是视觉信息。相比传统的手工特征具有更好的特征描述能力,这一点在多数视觉任务中得到了充分验证。

大部分购物网站展示的图片中,服装一般是处于居中位置,占据较大空间,且外形没有较大尺度形变,背景简单无干扰,针对这种情况,提取整幅图像的深层卷积特征,进行相似性度量就可以达到相对较好的检索效果。用户自己拍摄的图像中,因为存在拍摄者的视角和被拍摄者的肢体动作等因素,服装外形常常变形,基于传统形状特征的算法很难处理。

本文提出先对服装进行关键点定位,利用暗含的几何关系应对形变问题,然后提取其周边的浅层卷积特征,融合整幅图像的深层卷积特征来进行精确检索。本文特征提取以2012年提出的AlexNet分类模型[17]为基本网络如图 6所示,在其基础上微调训练自己的模型。这个经典模型结构简单,网络较浅,计算量少,较少的样本就能取得较好的分类准确率。整幅图像的高层特征使用第5层卷积特征,关键点周边区域特征使用第2层卷积特征,采取特征串联方式,AlexNet网络对最终的特征进行了降维处理。本文中的训练样本是从BDAT-Clothes服装数据集中每类随机抽取的1000图片组成,验证样本是测试集中每类抽取的100张图片组成。

|

图 6 AlexNet网络 Figure 6 AlexNet network |

为了验证本文算法的有效性,在两个大规模服装图像检索数据库BDTA-Clothes和Fashion Landmark上与常用算法进行了对比实验。实验硬件环境为i7-4790 CPU,NVIDIA 750 Ti GPU,软件环境是ubuntu-14.04 LTS。

3.1 BDAT-Clothes数据集BDATA-Clothes是从互联网上收集的16类总共包括33682张RGB服装图片。查询图片每类400张,剩余作为检索数据库。其中,冲锋衣1652张、卫衣1638张、夹克1587张、女式T恤1544张、女式衬衫1662张、女式西服1662张、女式风衣1598张、旗袍1608张、棉服1635张、男式T恤1754张、男式衬衫1584张、男式西服1583张、男式风衣2200张、羽绒服1685张、连衣裙2017张和针织衫1873张。

3.2 Fashion Landmark数据集Landmark Detection Benchmark[27-28]:是一个公开的大型服装数据集,包括123016张服装图片,每张图片标定6~8个关键点,服装边界框,3种服装类型(上半身、下半身、全身)以及3种形变程度(正常、中等、严重)。为了验证本文关键点检测模型无需大量的训练样本,实验时从Landmark Detection数据集中仅选取了6455张图片作为训练,1626张图片作为测试。原始数据集标注个数不统一,为了适应本文关键点模型,对数据库中的关键点标注信息仅保留下6个:左右衣领、左右袖子以及左右侧边。当作为检索数据库使用时,随机抽取1000张作为查询,剩余样本作为检索图像库。

3.3 关键点检测 3.3.1 评价指标关键点定位的准确性可以用回归出的关键点(x′, y′)与真实标定的关键点(x, y)之间的欧氏距离来判断,如式(2)所示,主要是衡量单幅图像的关键点误差。距离越大说明网络预测的偏差越大,回归的关键点位置越不准确。式(3)表示所有测试样本中各个关键点的预测值ntest与其真值Dis之间的平均距离,能更好地反映网络的定位性能。

| $Dis = \sqrt {{{(x' - x)}^2} + {{(y' - y)}^2}} $ | (2) |

| $Mean\; Error = \sum\limits_{i = 1}^n {\frac{{Dis}}{{{n_{{\rm{test}}}}}}} $ | (3) |

本节简单地说明各级网络的初始参数设置。level1中各个网络的初始学习率设置为0.01,动量设置为0.9,权重衰减因子设置为0.0005。学习策略采用“inv”倒数衰减方式,其中gamma参数设置为0.0001,power参数设置为0.75。level2与level1设置相同。level3中初始学习率设置为0.005,其余设置与level1保持一致。

3.3.3 结果分析第一级网络回归的关键点位置直接影响后续网络的输入区域。通常情况下,随着迭代次数增加,训练的模型会趋向于收敛,定位误差也越来越小。本文做了3组迭代次数对关键点定位误差影响的实验,每组中的误差是5次实验取均值,结果如表 3、表 4所示。从表中可以看出,随着迭代次数的增加,关键点的回归误差越来越小。当迭代次数从100万次增加到120万次时,定位误差基本不变,说明模型已经收敛。级联的各网络经过同样的迭代次数对比实验,发现大约10万次就收敛了。所以本文接下来的实验都是在第一级网络训练100万次,后续网络训练10万次上进行的。

| 表 3 不同迭代次数时的定位误差 Table 3 Location error in different iterations |

| 表 4 L、R、F网络的定位误差 Table 4 Network positioning error of L、R and F |

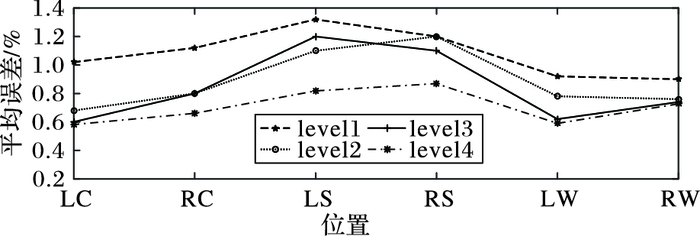

关键点定位误差除了与训练模型的迭代次数有关,还与级联层数有关系。本文将级联层数从1改变到4,分别统计了各级网络的平均定位误差,并分析了各级中6个关键点的定位误差,实验结果如图 7所示。其中,横坐标LC、RC、LS、RS、LW、RW分别表示左衣领、右衣领、左袖子、右袖子、左下侧边、右下侧边,level表示级联的层数。从图 7中不难看出,随着级联层数的增加,关键点的预测值与真实值之间的距离越来越小,说明定位越来越准,验证了本文关键点模型的有效性。但同时也能发现,level4网络的位置调整的力度远比level2和level3要小,且level3已经取得较好的定位准确率。

|

图 7 各关键点平均误差 Figure 7 Average error of key points at all levels |

此外,各个关键点的平均误差也不相同,袖子的定位误差相对较大,原因是选取的训练样本总数较少,仅为6445张服装图片,分摊到无袖、短袖、长袖三类的训练样本数目要远低于另外两组关键点,导致了定位误差要略微偏高。定位误差次之的是衣领,主要是训练数据集中存在部分头发遮挡关键点的情况,给关键点定位带来了难度,降低了相应的定位准确度。但这些定位误差总体较小,都在可接受范围内,如果增加对应的训练样本以及增添服装中心的关键点标定信息,可以进一步降低因类别数目不均以及部分关键点遮挡造成的误差。

增加级联数目可以进一步提高关键点定位的准确性,但同时也会增加模型训练时间以及单张图片的定位时间,表 5是不同级联数目时模型的训练时间和测试速度。

| 表 5 各级模型的训练时间、测试速度 Table 5 Training time, test speed of each level |

由于level1迭代次数最多,所以训练时间最长,级联的level2、level3、level4设置相同,所以每增加一级,就需要增加约为2.3 h的模型训练时间。测试速度方面,第一级网络fps可以达到240+,第四级网络只能达到25左右。综合考虑各级网络的关键点定位准确性、模型训练时间、测试速度,本文选择了三层级联结构。

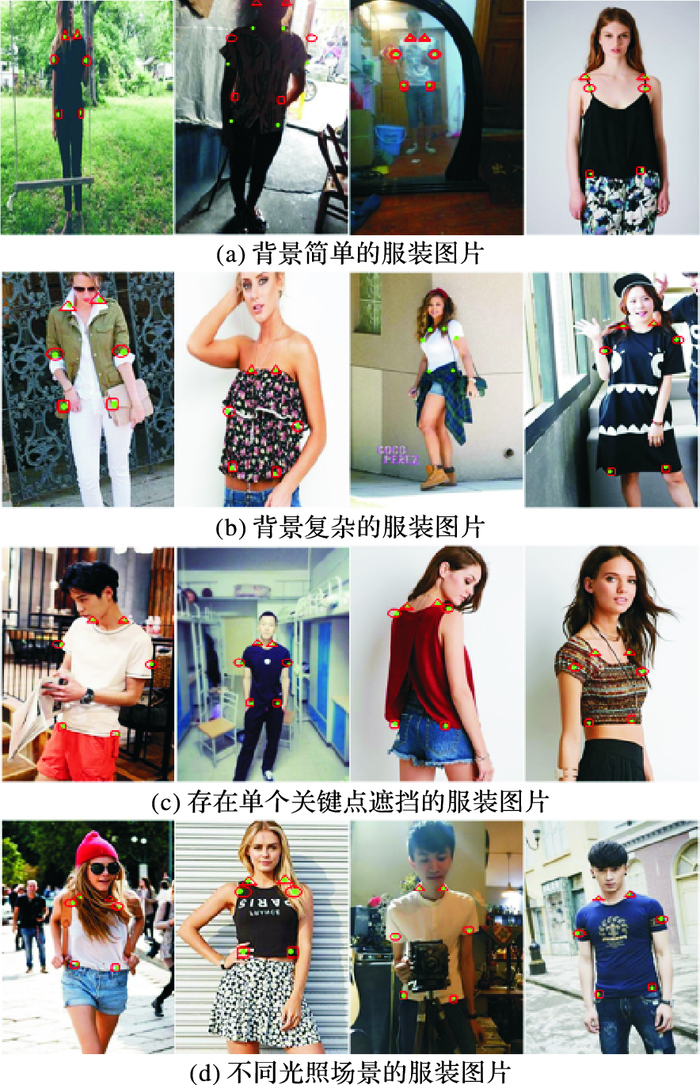

除了对关键点模型进行了定量分析,本文也对其进行了定型分析,从测试集中挑选了具有代表性的服装图片进行了检测结果可视化,如图 8所示。

|

图 8 关键点检测效果 Figure 8 Key point detection results |

图 8中每一行图片中存在视角、姿态引起的服装形变。从(a)、(b)定位结果来看,本文关键点模型对不同背景、姿态下的各种类型服装都能有效地进行定位。针对(c)中关键点被头发、手提包遮挡的情况,本文模型依然能回归出关键点位置,此时关键点区域特征是遮挡物的特征。存在遮挡的图片在数据库很少,且单个关键点的低层视觉信息在最终融合的特征中所占比例很小,所以最终对检索结果影响不是很大。为了进一步减小关键点被遮挡的影响,未来的工作考虑对数据库中的标注信息重新整理,并增加服装中心位置的标注,因为中心位置一般不容易被遮挡,且中心位置图案有时候是同种颜色、款式服装的主要区别,例如白色短袖T恤,区别主要就是中心位置印刷的各种图案。除了形变、背景、遮挡等因素,本文还对不同光照场景进行了实验,从(d)结果来看,本文关键点模型依然能有效地检测出关键点。

3.4 服装检索 3.4.1 评价指标查准率(precision)和查全率(recall)[10]是检索算法中最常用的两个评价指标,具体公式如式(4)、(5)所示。其中,近邻样本在本文中定义为:数据库中与查询样本欧氏距离最近的k服装样本,在两个数据库中k均设定为0.02。

| $查准率 = \frac{{检索出的近邻样本数目}}{{已检索样本数目}}$ | (4) |

| $查全率 = \frac{{检索出的近邻样本数目}}{{库中全部近邻数目}}$ | (5) |

本文选取了目前服装检索中最常用算法与本文进行对比,涉及的特征主要包括颜色特征:HSV(Hue, Saturation, Value)、HIST(Histogram),形状特征:HOG(Histogram of Oriented Gradient)、局部二值模式(Local Binary Pattern, LBP),纹理特征:Color Moments,以及全局特征:GIST(Global Characteristics)[29]。除了单一特征的对比,本文还与多特征融合做了对比,实验中,每种特征维度均为128维。

设定检索返回前10幅图像,定量分析此时每种算法的查准率、查全率, 如表 6所示。

| 表 6 前10张图像的查准率和查全率对比 Table 6 Comparison of precision and recall of the top 10 images |

从表 6中可以看出,在BDAT-Clothes数据库上,HOG+HSV特征融合之后的查准率和查全率要明显好于单一的HOG特征或者HSV特征。相比单一特征,多特征融合由于包含了更加丰富的图像信息,所以能一定程度上提升检索性能。Fashion Landmark数据库背景相对复杂,服装变形明显,传统的基于低层视觉信息的单一特征通常无法有效地处理这些问题,检索结果不是很理想,使用HOG+HSV的传统多特征融合对检索性能提升也很有限,所以低层视觉特征更适用于较为简单的检索任务。表 6中的Landmark表示关键点周边小区域的浅层CNN特征,利用关键点中暗含的几何信息,可以对服装进行对齐,有效地去除复杂背景和服装形变的干扰,所以查准率和查全率均要高于传统算法。CNN + Landmark表示的是将关键点区域浅层卷积特征和全图的高层卷积特征的融合,这样可以有效地将语义信息和视觉信息整合,全局信息和局部信息整合,使得最终的特征具有更好的表征能力,检索性能更加理想。

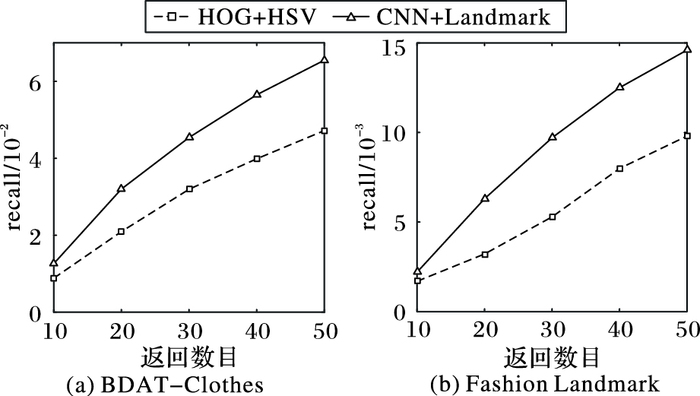

为了更充分地验证本文算法的有效性,选取了传统特征中查全率最高的HOG+HSV多特征与本文算法进行了查全率对比,检索返回服装图片数目设置成5组,实验结果如图 9所示。在两个大规模图像检索数据库上,随着检索返回数目的增加,本文算法的查全率比传统多特征融合方式的优势愈发明显。在设定返回相同数目图片情况时,本文算法查全率要明显高于对比算法,说明检索出的匹配服装数目更多;在设定相同查全率情况时,本文算法需要更少的返回图片数目,意味着查准率更优。本文提出的关键点检索算法相比传统算法在性能上有很大的提升,更适合目前的服装检索任务。

|

图 9 不同检索返回样本数目下的查全率对比 Figure 9 Comparison of recall under different retrieval returns |

针对大规模服装检索问题,提出一种基于关键点定位的检索方法。本文算法的主要思想是使用关键点定位,融合关键点区域的低层视觉信息和整幅服装图像的高层语义信息。相比传统基于颜色、形状、纹理等检索方法,关键点算法能有效地处理视角、姿态引起的服装形变和复杂背景干扰,极大地提升了服装检索可靠性。在Fashion Landmark和BDAT-Clothes两个大规模数据库上的对比实验表明,本文算法可以显著提高检索的查准率和查全率。将来的工作会考虑如何解决头发、肢体等造成的关键点遮挡问题,进一步提高本文算法的检索鲁棒性。

| [1] | 薛培培, 邬延辉. 基于图像内容和支持向量机的服装图像检索方法研究[J]. 移动通信, 2016(2): 79-82. (XUE P P, WU Y H. A clothing image retrieval method based on image content and support vector machine[J]. Mobile Communication, 2016(2): 79-82.) |

| [2] | 兰丽, 耿增民. 服装图像检索研究综述[J]. 电脑知识与技术, 2015, 11(12): 184-187. (LAN L, GENG Z M. The clothing image research review[J]. Computer Knowledge and Technology, 2015, 11(12): 184-187.) |

| [3] | LIU S, SONG Z, LIU G, et al. Street-to-shop:cross-scenario clothing retrieval via parts alignment and auxiliary set[C]//Proceedings of the 20th ACM International Conference on Multimedia. New York:ACM, 2012:1335-1336. |

| [4] | WEI D, WAH C, BHARDWAJ A, et al. Style finder:fine-grained clothing style detection and retrieval[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2013:8-13. |

| [5] | HUANG J, FERIS R S, CHEN Q, et al. Cross-domain image retrieval with a dual attribute-aware ranking network[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2015:1062-1070. |

| [6] | VEIT A, KOVACS B, BELL S, et al. Learning visual clothing style with heterogeneous dyadic co-occurrences[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2015:4642-4650. |

| [7] | LIANG X, LIN L, YANG W, et al. Clothes co-parsing via joint image segmentation and labeling with application to clothing retrieval[J]. IEEE Transactions on Multimedia, 2016, 18(6): 1175-1186. DOI:10.1109/TMM.2016.2542983 |

| [8] | 应玉龙. 基于内容的服装图像检索系统研究[J]. 福建电脑, 2016, 32(3): 25-26. (YING Y L. Research on clothing image retrieval system based on content[J]. Fujian Computer, 2016, 32(3): 25-26.) |

| [9] | KIAPOUR M H, HAN X, LAZEBNIK S, et al. Where to buy it:matching street clothing photos in online shops[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2015:3343-3351. |

| [10] | LI L, LIU G, LIU Q. Advancing iterative quantization hashing using isotropic prior[C]//Proceedings of the 22nd International Conference on Multimedia Modeling. Berlin:Springer, 2016:174-184. |

| [11] | 张腾, 郭清宇. 基于HSV颜色直方图的服装检索[J]. 信息与电脑, 2011(10): 28-29. (ZHANG T, GUO Q Y. Clothing retrieval based on HSV color histogram[J]. China Computer and Communication, 2011(10): 28-29.) |

| [12] | 陈倩, 潘中良. 基于内容的服装检索系统中颜色特征提取算法的研究和改进[J]. 激光杂志, 2016, 37(4): 62-68. (CHEN Q, PAN Z L. Research and improvement of color feature extraction algorithms in the content-based clothing images retrieval system[J]. Laser Journal, 2016, 37(4): 62-68.) |

| [13] | 李克磊, 刘正东. 基于SURF算法的服装视觉图像检索研究[J]. 北京服装学院学报(自然科学版), 2014, 34(3): 57-62. (LI K L, LIU Z D. Visual clothing image retrieval research based on the SURF algorithm[J]. Journal of Beijing Institute of Clothing Technology (Natural Science Edition), 2014, 34(3): 57-62.) |

| [14] | 侯阿临, 赵柳青, 桃敏, 等. 基于多特征的服装图像检索[J]. 现代电子技术, 2010, 33(6): 171-175. (HOU A L, ZHAO L Q, TAO M, et al. Clothing image retrieval based on multi-features[J]. Modern Electronics Technique, 2010, 33(6): 171-175.) |

| [15] | 王海龙, 杜俊俐, 郭清宇. 基于内容的图像检索技术在服装检索中的应用[J]. 计算技术与自动化, 2009, 28(2): 88-91. (WANG H L, DU J L, GUO Q Y. The application of content based image retrieval technology in clothing retrieval system[J]. Computer Technology and Automation, 2009, 28(2): 88-91.) |

| [16] | LIU H, WANG R, SHAN S, et al. Deep supervised hashing for fast image retrieval[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2016:2064-2072. |

| [17] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe:Curran Associates Inc., 2012:1097-1105. |

| [18] | SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:1-9. |

| [19] | HE K, ZHANG X, REN S, et al. Delving deep into rectifiers:surpassing human-level performance on ImageNet classification[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2015:1026-1034. |

| [20] | REN S, HE K, GIRSHICK R, et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(6): 1137-1149. |

| [21] | LIU W, ANGUELOV D, ERHAN D, et al. SSD:single shot multibox detector[C]//Proceedings of the 14th European Conference on Computer Vision. Berlin:Springer, 2015:21-37. |

| [22] | REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once:unified, real-time object detection[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2015:779-788. |

| [23] | SUN Y, WANG X, TANG X. Deep convolutional network cascade for facial point detection[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:3476-3483. |

| [24] | SUN Y, WANG X, TANG X. Deep learning face representation by joint identification-verification[EB/OL].[2016-11-20]. https://core.ac.uk/download/pdf/25035739.pdf. |

| [25] | DENG J, DING N, JIA Y, et al. Large-scale object classification using label relation graphs[M]. Berlin: Springer, 2014: 48-64. |

| [26] | SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 79(10): 1337-1342. |

| [27] | LIU Z, YAN S, LUO P, et al. Fashion landmark detection in the wild[C]//Proceedings of the 14th European Conference on Computer Vision. Berlin:Springer, 2016:229-245. |

| [28] | LIU Z, LUO P, QIU S, et al. DeepFashion:powering robust clothes recognition and retrieval with rich annotations[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2016:1096-1104. |

| [29] | OLIVA A, TORRALBA A. Modeling the shape of the scene:a holistic representation of the spatial envelope[J]. International Journal of Computer Vision, 2001, 42(3): 145-175. DOI:10.1023/A:1011139631724 |