2. 天津大学 管理与经济学部, 天津 300072;

3. 河北大学 管理学院, 河北 保定 071000;

4. 河北大学 数学与信息科学学院, 河北 保定 071000;

5. 中国科学院 微电子研究所, 北京 100029

2. College of Management and Economics, Tianjin University, Tianjin 300072, China;

3. College of Management, Hebei University, Baoding Hebei 071000, China;

4. College of Mathematics and Information Science, Hebei University, Baoding Hebei 071000, China;

5. Institute of Microelectronics, Chinese Academy of Sciences, Beijing 100029, China

词袋模型(Bag-Of-Words, BOW)[1]是对象识别和场景分类领域最成功的方法之一[2-3]。这种方法把图像表示为局部特征的直方图形式。BOW利用局部特征构造字典,然后通过统计图像中出现的视觉词的数量来表示图像,最终用于图像分类。

但是,BOW模型忽略了不同特征之间的空间和位置关系。为了给模型提供空间信息,Berg等[4]通过对于几何对应位置的搜索来给特征表示提供空间信息; 文献[5-6]的方法中用特征向量之间的上下文关系给BOW增加空间位置关系; Li等[7]通过局部图像块之间的关系构造了上下文词袋模型(Contextual BOW, CBOW)方法,用于给图像表示提供空间信息;Feng等[8]用局部出现的相关特征来产生有判别力的直方图表示;Tang等[9]通过发现不同特征之间的模式来进行图像表示。有判别力的模式更能够体现出图像内容的本质特征,Tang等[10]通过多示例学习的方法发现有判别力的模式用于图像分类。

在众多的研究当中,空间金字塔匹配(Spatial Pyramid Matching, SPM)[11]是最经典的方法之一,并且得到了普遍的认可。空间金字塔在场景识别和对象识别领域都取得了良好的效果,空间金字塔将图像划分成不同的层次,并且在不同的层次下把图像划分成不同的细胞单元(cell);然后,分别对每个细胞单元的图像区域进行直方图表示;最后,把不同层次的区域直方图串接起来作为最终的图像表示。空间金字塔存在的一个主要问题是图像的硬划分方式不合理,它在不同层次中把图像不断地细分为大小相等的细胞单元,这种方式的确能够提供一种由粗到细的划分方式,并且能够为相邻的图像块提供空间信息,但是不能保证每个细胞单元有唯一的语义表示。图 1为图像的空间金字塔划分方法,图像被划分成了3个不同的层次,在每个层次中,图像被划分成了大小相同的细胞单元。从图 1中不难发现,每个细胞单元并不能表示成一个有确定语义信息的内容。在第1层当中,每个细胞单元包含了花朵的一部分和背景,在第2层当中,有的细胞单元包含花朵的一部分,有的只包含背景。并且在最终图像表示的时候没有考虑到不同细胞单元间特征的关系即没有考虑到应该把细胞单元表示为对象的某个特定区域。此外,随着层次的深入,图像的向量表示长度会不断增大,例如,一个2层空间金字塔,需要连接1+4+16=21个局部直方图表示,如何控制字典的维度也是一个需要解决的问题。

|

图 1 空间金字塔划分 Figure 1 SPM partition |

本文主要着手解决了两个问题:首先,为了克服空间金字塔硬划分的缺点,从多特征融合的角度出发对图像进行分层。把颜色作为诱导划分的依据;其次,为了缩短字典维度进而提高分类精度,本文采用了分化信息理论的特征聚类(Divisive Information-Theoretic feature Clustering, DITC)[12]聚类方法对字典的维度进行约减。

算法流程如下所示:首先,计算出不同颜色的判别性,并利用不同类别颜色的优化选择对图像进行分层;然后,把不同层次图像划分的表示连接起来作为整幅图像的表示,为了解决图像表示维度过高的问题,算法对特征字典进行了压缩,并利用压缩后的字典进行最终的图像表示。

1 基于颜色判别性的图像层次划分方法 1.1 有判别力的类颜色检测方法BOW框架下的图像块是通过采样得到的,在图像表示时,把图像块特征作为特征的最基本单元进行频率统计。通常情况下,图像块内包含的像素颜色不同,为了便于统计,图像块的颜色通常认为是块内所有像素的平均颜色[13-14]。在训练集中,通过聚类生成颜色字典为

|

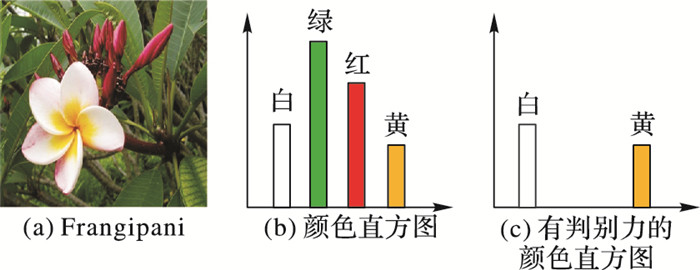

图 2 Frangipani的颜色直方图和有判别力的颜色直方图 Figure 2 Differences between color histogram and discriminative color histogram of Frangipani |

发现对象区域是对象识别的一个重要环节,颜色是一种有效判断对象区域的手段。图像中存在不同的颜色,本文认为每类中有判别力的颜色的区域代表对象或对象上某个部分的某个区域。准确找到有判别力的颜色能够帮助更有针对性地对图像进行表示。

定义

|

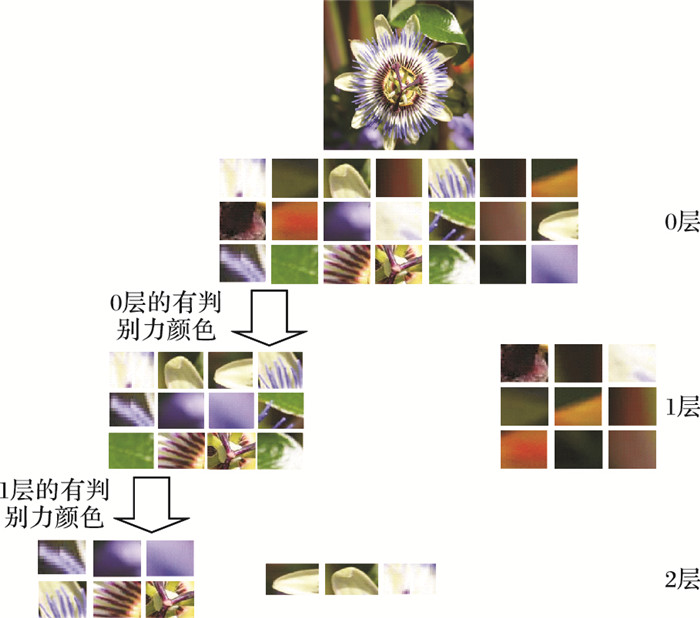

图 3 颜色层次图像划分方法 Figure 3 Color level image partition method |

文中用类与颜色的互信息(Mutual Information, MI)(式(1))来衡量颜色的判别力强弱:

| $ MI\left( {w_n^c, c} \right) = {\rm{lb}}\frac{{p\left( {w_n^c, c} \right)}}{{p\left( {w_n^c} \right) \times p\left( c \right)}} = {\rm{lb}}\frac{{p\left( {w_n^c\left| c \right.} \right)}}{{p\left( {w_n^c} \right)}} $ | (1) |

其中wnc代表颜色视觉词。互信息值越高,当前的视觉词与类的相关性越强。对于每个类别,只需要选择与其最相关,即与这个类别的互信息值最大的几种颜色作为此类的有判别力的颜色。对于任意ci来说,选择mi种最判别力的颜色即互信息值最高的mi种颜色,来构建颜色直方图。

为了选择出对于任一类ci最重要的mi种颜色,构造了如下目标函数

| $ \begin{array}{l} \mathop {\min }\limits_{{m_i}, i = 1, 2, \cdots, k} \sum\limits_{i = 1}^{k-1} {\sum\limits_{j > i}^k {Sim\left( {DH_{i, {m_i}}^c, DH_{j, {m_j}}^c} \right)} }-\\ \;\;\;\;\;\;\;\sum\limits_{i = 1}^k {Sim\left( {H_i^c, DH_{i, {m_i}}^c} \right)}-\sum\limits_{i = 1}^{k - 1} {\sum\limits_{j > i}^k {Sim\left( {DH_{i, {m_i}}^s, DH_{j, {m_j}}^s} \right)} } \\ {\rm{s}}{\rm{.}}\;{\rm{t}}{\rm{.}}\;\;\;{\rm{1}} \le {m_i} \le {V^c} \end{array} $ | (2) |

其中:Hic和DHci, mi分别代表ci类的颜色直方图和有判别力的颜色直方图。DHsi, mi代表ci类中,有判别力颜色的图像块上的形状特征(尺度不变特征变换(Scale-Invariant Feature Transform, SIFT)[20])所组成的形状直方图。V c是颜色字典的维度。Sim(·, ·)用于衡量两个直方图之间的相似度。目标函数的构造是基于以下3个假设的:1)不同类别的有判别力颜色不同,即不同类别的有判别力的颜色直方图不相似。2)有判别力的颜色直方图能够最大限度保持原有图像的颜色信息,即同类别图像的颜色直方图与有判别力的颜色直方图相似。3)有判别力的颜色对应着对象的一些区域,不同种类的对象有着不同的形状特征,每个类别的对象形状特征不相似,即这些有判别力颜色图像块上的形状特征不相似。这三个假设分别对应着目标函数中的三个项。mi是一个离散型的数值,范围在1到颜色字典维度之间,最终式(2)中的优化可以通过坐标下降法求解目标函数得到。

1.2 基于颜色的层次划分方法图像的层次划分能够把图像分成不同的区域,通过分别对这些区域进行表示可以生成更加有判别力的图像表示[15]。本文尝试把颜色作为层次划分的依据。与空间金字塔相似,本算法认为原图像属于图像的第0层。在第1层根据优化得到的有判别力颜色,把原图像中采样得到的图像块分为两部分,即有判别力的图像块集合和无判别力的图像块集合。在第2层中,把有判别力的图像块集合认为是一幅子图像,然后,根据式(2)中的优化方法,得到不同类别在第2层的子图像的有判别力的颜色,并用这些颜色把第2层的图像划分为有判别力的图像块集合和无判别力的图像块集合,把这层中有判别力的图像块作为第3层的图像块。最后用这种方法把图像进行进一步划分层次,这种方法叫作颜色层次(Color Level,CL)图像划分方法。

如图 3所示,图像在0层被表示为图像块的集合,通过优化得到图像的有判别力颜色,这些颜色把图像分为第1层的两部分,可以发现有判别力颜色对应的区域是花朵的或者叶片的某个部分,而无判别力颜色的部分主要对应着背景部分。在第2层中,从第1层的有判别力颜色中优化选取一部分作为此层的有判别力的颜色,把图像块又分为了两部分。

在每一层(层数大于1)分别对有判别力的部分和无判别力的部分进行直方图表示,并把两部分的直方图连接起来作为本层的图像表示。然后把所有层的图像表示连接起来作为最终的图像的表示。

对于任意一幅图像,如果划分为L层,那么图像总共被划分为2L+1个部分。图像表示与文献[13]相似,本文假设图像属于所有k个类别,然后在不同类别下进行图像划分,总共得到k(2L+1)部分。图像划分的每一部分对应着一系列的图像块,假设用于表示这些图像块的特征的维度是h,则最终的图像表示的字典维度为kh(2L+1)。以Flower 102为例,如果字典维度为1000,层次数L为5,则最后生成的图像维度为102×1000×(10+1)=1122000。

2 基于DITC的图像维度约减方法从图像维度的计算方法中可以发现,CL在处理大规模数据集的图像表示的时候,数据维度过高。如何在不影响分类准确率的情况下对数据维度进行约减是这部分的研究重点,DITC聚类方法是一种重要的用于字典聚类[16-17]的方法,在这部分内容中本文把DITC聚类方法用于压缩CL的图像表示。

本文主要考虑的特征为颜色特征和形状特征,定义图像表示的形状颜色字典为

| $ I\left( {C, {W^{{\rm{sc}}}}} \right) = \sum\limits_i {\sum\limits_j {p\left( {{c_i}, w_j^{{\rm{sc}}}} \right){\rm{lb}}\frac{{p\left( {{c_i}, w_j^{{\rm{sc}}}} \right)}}{{p\left( {{c_i}} \right)p\left( {w_j^{{\rm{sc}}}} \right)}}} } $ | (3) |

对字典进行聚类能够降低图像表示维度,同时也有可能降低类别与字典的互信息。为了降低互信息损失,需要使式(4)尽可能小。

| $ I\left( {C, {W^{{\rm{sc}}}}} \right)-I\left( {C, {W^{{\rm{com}}}}} \right) $ | (4) |

其中,Wcom为字典聚类之后的压缩字典, 字典压缩之后的维度用Vcom代表。式(4)展开后可以写成如下形式:

| $ \begin{array}{l} \sum\limits_i {\sum\limits_j {{\pi _j}p\left( {{c_i}\left| {w_j^{{\rm{sc}}}} \right.} \right){\rm{lb}}\frac{{p\left( {{c_i}\left| {w_j^{{\rm{sc}}}} \right.} \right)}}{{p\left( {{c_i}} \right)}}} }-\\ \;\;\;\sum\limits_i {\sum\limits_j {\sum\limits_{w_t^{{\rm{sc}}} \in w_j^{{\rm{com}}}} {{\pi _t}p\left( {{c_i}\left| {w_t^{{\rm{sc}}}} \right.} \right){\rm{lb}}\frac{{p\left( {{c_i}\left| {w_j^{{\rm{com}}}} \right.} \right)}}{{p\left( {{c_i}} \right)}}} } } \end{array} $ | (5) |

其中πj=p(wjsc)。

最终互信息的损失表示为如下形式:

| $ \begin{array}{l} I\left( {C, {W^{{\rm{sc}}}}} \right)-I\left( {C, {W^{{\rm{com}}}}} \right) = \\ \;\;\;\;\;\sum\limits_j {\sum\limits_{w_t^{{\rm{sc}}} \in w_j^{{\rm{com}}}} {{\pi _t}KL\left( {\left( {p\left( {C\left| {w_t^{{\rm{sc}}}} \right.} \right)} \right), \left( {p\left( {C\left| {w_j^{{\rm{sc}}}} \right.} \right)} \right)} \right)} } \end{array} $ | (6) |

其中KL(, )代表KL距离。

聚类的数目l,首先按照

实验通过每隔8个像素进行采样,每个图像块的大小是16×16。CN(Color Name)[18]和HUE[19]是两种非常出色的颜色描述子,本算法把这两种描述子连接起来形成一个新的描述子来描述图像块颜色,然后通过K-means聚类算法生成颜色字典用于图像的层次划分。算法连接SIFT、CN和HUE三种描述子来描述图像块的颜色形状特征,通过K-means聚类生成颜色形状字典。为了对图像进行基于颜色的层次划分,同时又考虑到图像集规模的不同,颜色字典的维度也不同,在Soccer图像集中,颜色字典的维度是300而在Flower 17图像集和Flower 102图像集中,颜色字典的维度是500。在所有图像集中划分的层次数目均为3,3种描述子连接形成的特征聚类生成的特征字典,维度均为1000,Soccer、Flower 17和Flower 102最终的图像表示的维度为49000,119000和714000。DITC聚类用于给字典降维,最终这三个图像集的图像表示维度为1000,2000和800。实验中,本文用标准的非线性支持向量机(Support Vector Machine, SVM)来进行分类,核函数采用交核(Intersection Kernel)。

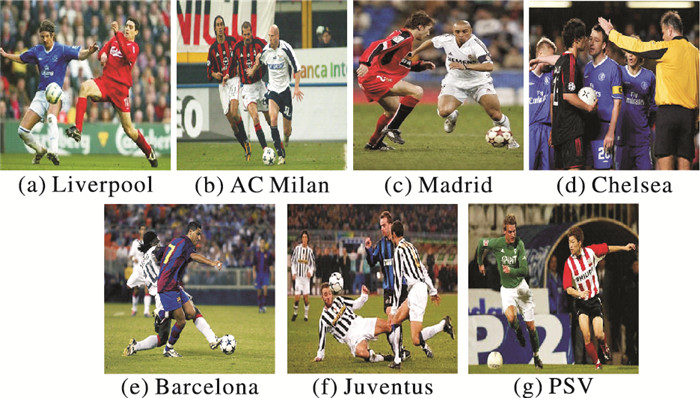

3.1 在Soccer图像集上的结果Soccer图像集[14]中包括了7个球队的280幅图像,每个类别中25幅用于训练,15幅用于测试。在这个图像集中颜色是最主要的特征,可以有效地判断出球员所在的区域。从图 4中可以发现,每一幅图像中可能同时包含属于该类别和不属于该类别的图像。例如:Liverpool球队的队服主要颜色是红色,但是在图像中也存在着穿蓝色球衣的队员。Chelsea队服的颜色为蓝色,但是穿红黑队服的球员和黄色衣服的裁判同样出现在了图像中。利用颜色找到本类别的球员特征进行针对性的表示能够提高对象识别率。

|

图 4 Soccer图像集示例 Figure 4 Images from Soccer |

表 1中为本文算法与一些优秀算法的识别准确率的比较。早融合[13]和晚融合[13]是两种最常见的特征融合方式,其中并没有涉及到图像的层次划分以及字典维度的约减。实验结果中可以发现这两种图像表示方式的准确率在89%左右。空间金字塔的方法对图像进行划分,提供了空间信息,但是细胞单元的内容不能表示一个具体内容。主成分分析(Principal Component Analysis,PCA)可以用于特征降维,CL+PCA能够取得不错的效果,但是识别率仍然比颜色注意力(Color Attention, CA)[13]低。基于逻辑回归的特征融合(Logistic Regression-based Feature Fusion, LRFF)[21]对字典进行了合理的加权,但是并没有尝试去发现对象的位置。CL方法分类准确率为95%左右,而CL+DITC的方法能够得到96%的准确率,因为DITC在对特征进行维度约减的同时合并了相似特征,使得图像的表示有更强的鲁棒性。

| 表 1 在Soccer图像集上的分类结果 Table 1 Classification results on the Soccer dataset |

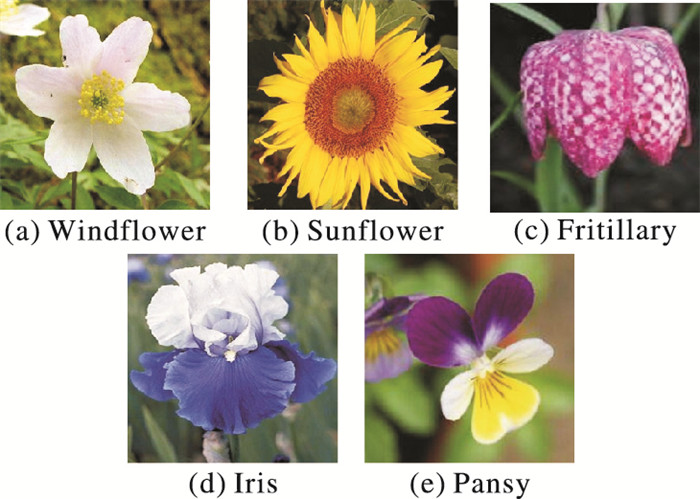

Flower 17图像集[22]中包含了17种花的1360幅图像,其中1020幅图像用于训练,340幅图像用于测试。图 5为Flower 17图像集中的一些图像。在这个图像集中,形状和颜色对于提高识别准确率都有着重要的作用。

|

图 5 Flower 17图像集示例 Figure 5 Images from Flower 17 |

表 2显示了本文算法与一些优秀算法的识别准确率的比较。在这些方法中空间金字塔的识别率仍然不高,这是因为空间金字塔的方法既没有识别出对象区域也没有应用一些其他的方法如注意力图或者特征加权的方法等对图像进行针对性的表示,只是给图像提供了不够准确的空间信息,所以识别率比较低。多核学习(Multiple Kernel Learning, MKL)[23]的方法通过多核学习得到不同特征之间的合理权重,CA[13]用颜色给图像块上的形状特征加权,在图像表示的时候仍然是把采样中得到的所有图像块在同一个直方图中进行表示,即在全局对图像进行表示并没有分层,没有考虑空间关系。通过比对可以发现,CL+DITC比CA算法的分类精度提高了5%左右。全局标识一致性分类器(Global Label Consistent Classifier, GLCC)[32]通过构造不同特征的分类器进行集成学习,但是并没有考虑到不同特征之间的关系,仍然是一种全局图像表示方法。

| 表 2 在Flower 17图像集上的分类结果 Table 2 Classification results on the Flower 17 dataset |

需要说明的是,基于中间层挖掘的方法在Flower 17图像集中取得了不错的效果,在HoPS方法[24]采用了随机映射和数据挖掘的方法进行图像表示,利用频繁项集挖掘的方法可以发现不同特征之间的关系。本文采用了文献[24]中的挖掘(mining)方法对压缩后的字典进行特征挖掘,这种方法利用挖掘到的有效模式代替码字构成字典,从而进行图像表示,能够有效地发现码字之间的内在联系。CL+DITC+mining的方法取得了令人满意的结果。从实验对比中可以发现,CL+DITC的方法在挖掘前后的分类结果产生了明显的变化,利用挖掘到的模式进行图像表示更能够体现出压缩字典内部特征之间的关联关系。此外文献[34]中在采用了卷积神经网络(Convolutional Neural Network, CNN)提取特征之后取得了94.8%的分类准确率,而本文利用中间层特征与此方法获得了相似的结果。

3.3 在Flower 102图像集上的结果Flower102图像集[28]中包含了102种花的8189幅图像,每类中给定了10幅图像用于训练和10幅图用于验证,剩下的用于测试。图 6为Flower 102图像集中的一些图像。在这个图像集中形状是最主要的特征,颜色是辅助特征。

|

图 6 Flower 102图像集示例 Figure 6 Images from Flower 102 |

从表 3中可以发现,本文算法识别率仍然高于空间金字塔、CA和MKL。CLC[29]通过发现局部特征之间的关系和减少噪声特征来提高分类准确率,本文的方法与CLC相比能够把图像不断细分,使得特征之间的关系更加紧密。Flower 102图像库被认为是一个用于细粒度分类的库,找到花朵的区域非常重要,在文献[30]算法中,首先对图像进行分割,通过优化发现分割块中的花朵。这与首先通过颜色来划分对象区域的算法类似,但是,与本文算法相比,这种方法并没有考虑到特征之间的空间关系。Xie等[34]把不同种类有描述性的信息集合起来用于图像分类,本文的算法不但提取出了不同种类最有判别力的特征,还考虑到了空间特征,所以本文算法性能更优。当只采用CL和CL+DITC两种情况时,分类精度分别为73.0%和75.2%,通过挖掘图像块之间的关联关系,可以发现图像块的关联关系,需要注意的是,挖掘出的关联性强的图像块并不一定具有类似的颜色,这在很大程度上弥补了颜色划分的局限性,所以CL+DITC+mining能够取得77.3%的分类准确率。

| 表 3 在Flower 102图像集上的分类结果 Table 3 Experimental results on the Flower 102 dataset |

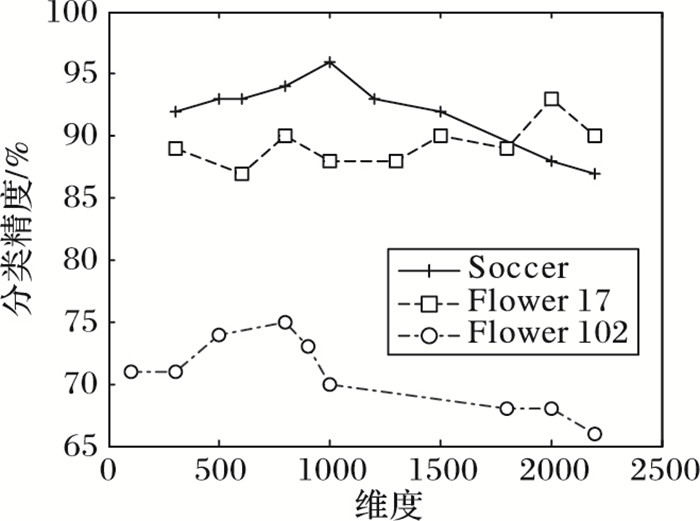

CL+DITC的方法可以有效地提高分类准确率,同时字典的维度对于分类准确率有着重要的影响:如果字典的维度过大,有相似特征的局部特征不能很好的合并;如果字典维度过小,不同特征的图像块会被认为相同。图 7为CL+DITC方法在不同字典维度下的分类准确率,可以发现字典维度过大或者过小都会降低分类准确率。另外,由于DITC在不影响互信息的情况下进行字典聚类,虽然字典维度发生了变化,但是在一定范围内的分类精度变化比较平稳。

|

图 7 字典维度对于分类精度的影响 Figure 7 Influence of dictionary dimension on classification accuracy |

本文提出了一种基于颜色的压缩层次图像表示方法,这种方法首先通过有判别力的颜色对图像进行分层,用以为图像表示提供空间信息,但是这种颜色层次图像表示方法的表示维度会随着层次和类别的数量增加而增加。文章中采用DITC聚类的方法,利用类别和视觉词之间的互信息关系,在不降低分类准确率的情况下对数据维度进行约减,提高了字典的判别性,增强了图像的表示能力。通过算法实验比对,基于颜色的层次压缩表示方法在三个图像集上都能取得比较好的分类效果。此外,颜色特征的提取速度快,在未来的工作中,可以把颜色特征作为发现对象的手段并将其应用于视频监控中。

| [1] | CSURKA G, DANCE C R, FAN L X, et al. Visual categorization with bags of keypoints[C]//Proceedings of the 8th European Conference on Computer Vision. Piscataway, NJ:IEEE, 2004:1-22. http://www.tandfonline.com/doi/ref/10.1080/13875868.2012.700463 |

| [2] | OKAWA M. Offline signature verification based on bag-of-visual words model using KAZE features and weighting schemes[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ:IEEE, 2016:184-190. |

| [3] | 杨浩, 张永. 基于优化视觉词袋模型的图像分类方法[J]. 计算机应用, 2017, 37(8): 2244-2247. (YANG H, ZHANG Y. A image classification method by optimizing bag-of-visual words model[J]. Journal of Computer Applications, 2017, 37(8): 2244-2247. DOI:10.11772/j.issn.1001-9081.2017.08.2244) |

| [4] | BERG A C, BERG T L, MALIK J. Shape matching and object recognition using low distortion correspondences[C]//Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2005:26-33. |

| [5] | 生海迪, 段会川, 孔超. 基于语义短语的空间金字塔词袋模型图像分类方法[J]. 小型微型计算机系统, 2015, 36(4): 877-881. (SHENG H D, DUAN H C, KONG C. Spatial pyramid bag-of-words model for image classification based on semantic phrases[J]. Journal of Chinese Computer Systems, 2015, 36(4): 877-881.) |

| [6] | 陈莹, 高含. 采用空间词袋模型的图像分类方法[J]. 小型微型计算机系统, 2016, 37(9): 2099-2103. (CHEN Y, GAO H. Image classification method based on spatial bag of words model[J]. Journal of Chinese Computer Systems, 2016, 37(9): 2099-2103.) |

| [7] | LI T, MEI T, KWEON I S, et al. Contextual bag-of-words for visual categorization[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2011, 21(4): 381-392. DOI:10.1109/TCSVT.2010.2041828 |

| [8] | FENG J, NI B, XU D, et al. Histogram contextualization[J]. IEEE Transactions on Image Processing, 2012, 21(2): 778-788. DOI:10.1109/TIP.2011.2163521 |

| [9] | TANG P, ZHANG J, WANG X, et al. Learning extremely shared middle-level image representation for scene classification[J]. Knowledge and Information Systems, 2017, 52(2): 509-530. DOI:10.1007/s10115-016-1015-z |

| [10] | TANG P, WANG X, FENG B, et al. Learning multi-instance deep discriminative patterns for image classification[J]. IEEE Transactions on Image Processing, 2016, 26(7): 3385-3396. |

| [11] | LAZEBNIK S, SCHMID C, PONCE J. Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories[C]//Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2006:2169-2178. |

| [12] | DHILLON I S, MALLELA S, KUMAR R, et al. A divisive information-theoretic feature clustering algorithm for text classification[J]. Journal of Machine Learning Research, 2003, 3(3): 1265-1287. |

| [13] | KHAN F S, RAO M A, WEIJER J V D, et al. Coloring action recognition in still images[J]. International Journal of Computer Vision, 2013, 105(3): 205-221. DOI:10.1007/s11263-013-0633-0 |

| [14] | GAVVES E, FERNANDO B, SNOEK C G M, et al. Fine-grained categorization by alignments[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2013:1713-1720. |

| [15] | ZHOU Y, WEI Y. Learning hierarchical spectral-spatial features for hyperspectral image classification[J]. IEEE Transactions on Cybernetics, 2016, 46(7): 1667. DOI:10.1109/TCYB.2015.2453359 |

| [16] | ELFIKY N M, KHAN F S, VAN DE WEIJER J, et al. Discriminative compact pyramids for object and scene recognition[J]. Pattern Recognition, 2012, 45(4): 1627-1636. DOI:10.1016/j.patcog.2011.09.020 |

| [17] | VAN DE WEIJER J, SCHMID C, VERBEEK J, et al. Learning color names for real-world applications[J]. IEEE Transactions on Image Processing, 2009, 18(7): 1512-1523. DOI:10.1109/TIP.2009.2019809 |

| [18] | VAN DE WEIJER J, SCHMID C. Coloring local feature extraction[C]//Proceedings of Computer Vision-ECCV 2006. Berlin:Springer, 2006:334-348. https://link.springer.com/chapter/10.1007/978-3-642-33715-4_23 |

| [19] | LOWE D G. Distinctive image features from scale-invariant points[J]. International Journal of Computer Vision, 2004, 60(2): 91-110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [20] | FERNANDO B, FROMONT E, MUSELET D, et al. Discriminative feature fusion for image classification[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2012:3434-3441. |

| [21] | NILSBACK M E, ZISSERMAN A. A visual vocabulary for flower classification[C]//Proceedings of the 19th IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2006:1447-1454. |

| [22] | GEHLER P, NOWOZIN S. On feature combination for multiclass object classification[C]//Proceedings of the 2009 IEEE 12th International Conference on Computer Vision. Piscataway, NJ:IEEE, 2009:221-228. https://link.springer.com/chapter/10.1007/978-3-319-06755-1_17 |

| [23] | VORAVUTHIKUNCHAI W, CRÉMILLEUX B, JURIE F. Histograms of pattern sets for image classification and object recognition[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2014:224-231. |

| [24] | FERNANDO B, FROMONT E, TUYTELAARS T. Mining mid-level features for image classification[J]. International Journal of Computer Vision, 2014, 108(3): 186-203. DOI:10.1007/s11263-014-0700-1 |

| [25] | YUAN X T, LIU X, YAN S. Visual classification with multitask joint sparse representation[J]. IEEE Transactions on Image Processing, 2012, 21(10): 4349-4360. DOI:10.1109/TIP.2012.2205006 |

| [26] | YE G, LIU D, JHUO I H, et al. Robust late fusion with rank minimization[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2012:3021-3028. https://www.computer.org/web/csdl/index/-/csdl/proceedings/cvpr/2012/1226/00/index.html |

| [27] | NILSBACK M E, ZISSERMAN A. Automated flower classification over a large number of classes[C]//Proceedings of the 6th Indian Conference on Computer Vision, Graphics & Image Processing. Piscataway, NJ:IEEE, 2008:722-729. http://dl.acm.org/citation.cfm?id=1491653 |

| [28] | WANG Z, FENG J, YAN S. Collaborative linear coding for robust image classification[J]. International Journal of Computer Vision, 2015, 114(2/3): 322-333. |

| [29] | ANGELOVA A, ZHU S. Efficient object detection and segmentation for fine-grained recognition[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2013:811-818. https://link.springer.com/chapter/10.1007/978-3-319-29451-3_45/fulltext.html |

| [30] | FU Z, ROBLES-KELLY A, ZHOU J. MILIS:multiple instance learning with instance selection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 958-977. DOI:10.1109/TPAMI.2010.155 |

| [31] | ZHANG L, ZHANG D. Visual understanding via multi-feature shared learning with global consistency[J]. IEEE Transactions on Multimedia, 2016, 18(2): 247-259. DOI:10.1109/TMM.2015.2510509 |

| [32] | MINH H Q, BAZZANI L, MURINO V. A unifying framework in vector-valued reproducing kernel Hilbert spaces for manifold regularization and co-regularized multi-view learning[J]. Journal of Machine Learning Research, 2016, 17(1): 769-840. |

| [33] | XIE G S, ZHANG X Y, SHU X, et al. Task-driven feature pooling for image classification[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2015:1179-1187. |

| [34] | XIE L, WANG J, ZHANG B, et al. Incorporating visual adjectives for image classification[J]. Neurocomputing, 2016, 182(C): 48-55. |