人脸识别在现实社会中的应用,由于其潜在的巨大价值而得到广泛关注;过去四十年间,研究人员在该领域开发出许多优秀项目,取得巨大成就。随着计算机硬件的不断升级,深度学习得到飞速发展,人脸识别技术的精度更是被提升到一个空前的高度。早在20世纪60年代,人脸识别系统的研究就已经开始,具有代表性的是1965年Chan和Bledsoe设计的模型[1]。2012年底,Krizhevsky等[2]采用深度学习算法,在图片分类竞赛ImageNet上一举拿下冠军,从此深度学习开始影响整个计算机视觉(Computer Vision, CV)领域并成功推动人脸识别技术的飞速前进。业内顶尖难度的公共数据集LFW(Labeled Faces in the Wild)[3]的最新结果排名显示,来自大华股份的人脸识别团队通过一个上百层深度网络达到99.78%的识别准确率,取得最优排名。这个数字不仅打败了人类94.27%的识别准确率,甚至触及LFW识别成功率的天花板。而实际应用中,人脸识别技术所表现得却并没有如同其在官方文档数字中描述得那样完美。如目前百度团队公布的最新人脸识别算法,在日常安防使用中测试成功率勉强只能达到80%左右,远低于其LFW上的99.7%。其主要原因是:在实际生活中,传感器设备采集到的图像数据对姿态、光照、遮挡以及分辨率等因素具有高度不可控性,因而使得识别准确率大打折扣。

为了解决上述问题,本文拟对设备采集到的人脸数据进行处理,使用3D重建方法建立二维侧面人脸与3D标准面部模型间像素的对应关系,以便对二维多姿态人脸进行摆正。对于已摆正的图像进行像素点检测,同时计算由于遮挡及侧面不可见等原因产生的像素缺失,利用人脸全局对称性的特点进行像素补全,产生最终的标准正面视图。在摆正过程中,尝试引入图像超分辨率(Super-Resolution, SR)技术提高采集图像数据的精度,得到一张高分辨率正面人脸视图。在SR中,使用一个深度递归卷积神经网络建立低分辨率(Low-Resolution, LR)图像块与高分辨率(High-Resolution, HR)图像块间的对应关系,进行图像超分辨率重建。由于进行SR时的网络很深,为了降低训练难度避免出现梯度消失及梯度爆炸现象,引入递归监督和跳跃连接两种技术进行改进。

1 相关工作对于低质量无约束人脸图像的研究, 由于其潜在的巨大应用价值,一直以来都是人脸处理和识别的重点探索方向。针对姿态不统一而无法进行有效识别的情况,已经开发出了许多优秀的方法。基于形变模型的方法[4-7]主要使用一个三维人脸样本集的线性组合来表示每个人脸。通过使用一个对形变模型进行迭代的方案以逼近输入图像。Blanz等[5-6]首先提出了基于形变模型的3D合成脸方法并成功应用到人脸识别中,之后一些研究人员基于此算法进行调整得到很多不同恢复正面合成人脸图像的方法。Zhu等[8]提出了一种新的深度学习框架用以恢复人脸图像的典型正面视图,并取得很好的效果。不同于之前其他人的工作,他们直接从一组大规模人脸数据集中学习到将多姿态人脸图像变化为标准正面视图的模型。深度学习的方法,由于其可以解决大角度面部倾斜的问题,所以在日常生产生活应用更广[9]。然而,由于深度学习的特点,这种方法需要大量数据训练才能得到最终模型。

本文对传统3D形变模型算法进行改进,使用一个不变的单一三维参考面去匹配所有输入图像,并以此产生标准正面视图。在摆正过程中,对由于姿态、遮挡等原因造成人脸部分区域无法观测的问题,基于人脸全局对称性的特点,进行缺失估计与填充。相较于传统3D形变模型方法,本文模型产生摆正视图更加高效且准确;同时,避免了深度学习方法中需要大规模数据集进行训练的问题。

虽然产生标准面部视图有助于改进实际应用中由于姿态不统一造成的识别率低下的问题。然而,另一个主要问题仍然没有得到有效解决:由于硬件设备等原因采集到的图像质量不高、分辨率不足造成识别困难。近年来,国内外对于这个问题的处理主要集中在两个方向进行,分别为分辨率稳健特征表达方法和图像超分辨率(SR)方法[10]。分辨率稳健特征表达方法,直接从低分辨率人脸图像上提取有鉴别性的特征信息,代表方法有:局部频域描述子(Local Frequency Descriptor,LFD)[11]、耦合局部保持映射(Coupled Locality Preserving Mapping, LPM)[12]、多维标定分析(Multi-Dimensional Scaling, DS)[11]、耦合核嵌入(Coupled Kernel Embedding, KE)[13]等。对于图像超分辨率方法,早期使用大量快速插值,简便但效果不佳。后来,一些方法引入图像的简单特征(如边缘等),利用图像的先验知识进行统计[14-15],显示出其更加强大的性能。近几年,一些更加先进的学习方法被广泛应用于LR-HR块映射模型中。如稀疏编码[16]、卷积神经网络[17]以及随机森林[18]等。本文工作在所提出的深度递归卷积神经网络的基础上,增加网络深度并通过递归监督和跳跃连接简化训练难度,将其应用到图像超分辨率重构中,并从Google爬取100000张人脸图像进行训练以使其更加适用于人脸幻构的应用。

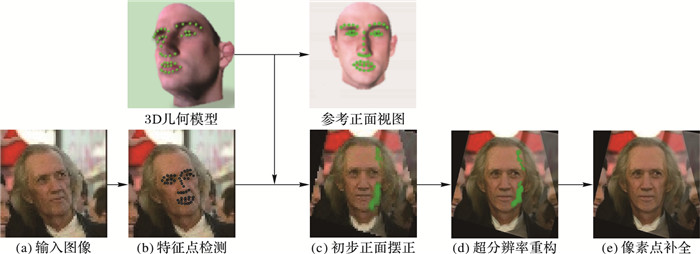

2 算法简介 2.1 基本模型结构本文的目标是对于采集到的低分辨率无约束人脸图像在姿态矫正还原为标准正面视图的同时进行超分辨率重构。本文方法如图 1所示。使用现有的人脸检测器检测到人脸[19],然后裁剪并重新调整到一个标准坐标系;用同样的检测器在参考正面视图上进行特征定位,其中参考正面视图通过对一个三维人脸模型进行纹理渲染得到, 二维坐标系中的坐标对应输入图像在三维人脸模型并计算出一个投影矩阵进行摆正以及后续的遮挡区域估计,在摆正过程中引入一个深度递归卷积神经网络进行人脸的超分辨率重构提高图像精度质量;最后通过人脸对称性的特点对由于姿势光照等原因产生的正面人脸缺损区域进行补全(图 1中,像素缺失的部分显示为绿色),得到输出的超精度正面人脸图像。系统各步骤的具体细节与实现会在后文中进行描述。

|

图 1 人脸超分辨率摆正系统结构 Figure 1 Frame work of image super-resolution and face frontalization system |

这一部分主要介绍产生正面视图的主要过程。给定一个单一的三维模型,它只包含纹理信息而忽略了形状信息,同时已提供三维模型面部特征点的坐标。对于查询图像,可以通过人脸特征点检测的方法得到二维坐标,随后通过查询图像与参考面,以及参考面与三维模型间特征点坐标的对应关系计算出一个3×4的投影矩阵,通过投影矩阵和3D人脸模型对查询图像进行操作,初步获取正面人脸视图。随后对此视图进行姿态估计,补全缺失像素点得到标准正面视图。

人脸特征点检测 最近很多非常有效的方法被提出用于面部特征点的检测[20-22]。出于速度与精度的双重考虑,本文选用SDM(Supervised Descent Method)[20]来对查询图像以及参考面进行特征点定位,SDM使用监督梯度下降的方法来求解非线性最小二乘的问题,并成功地应用于人脸对齐任务上。

与以往SDM算法不同的是,本文仅采用48个面部特征点,排除了下巴上的特征点检测(如图 1绿点所示),这主要是因为本文仅使用一个共同的三维模型进行摆正,排除了其形状信息的作用而仅仅采用其纹理信息,这在以往的实验中被证明对于最终检测精度并无影响[23]。

姿态估计 给定一个3D人脸模型,我们的目标是计算投影矩阵,从而揭示三维人脸模型表面点与查询图像点间的对应关系,如式(1)所示:

| $ \mathit{\boldsymbol{p}} \sim {\mathit{\boldsymbol{C}}_Q}\mathit{\boldsymbol{P}} $ | (1) |

其中p=(x, y)T是查询图像中的面部特征点(如图 1所示)。CQ是3×4的投影矩阵,P=(X, Y, Z)T对应3D模型上的特征点。单一人脸3D模型通过指定一个参考投影矩阵CM=AM[RMtM]合成渲染一个唯一的二维正面人脸参考示意图IR, 其中AM是内部矩阵,外部矩阵由旋转矩阵RM和平移向量tM组成,即式(2):

| $ \mathit{\boldsymbol{p'}} \sim {\mathit{\boldsymbol{C}}_M}\mathit{\boldsymbol{P}} $ | (2) |

其中p′=(x′, y′)T是IR中对应的面部特征点。同理,本文可以由查询图像上点pi=(xi, yi)T和参考面间特征点p′i=(x′i, y′i)T的对应关系得到二者之间对应的矩阵MQ=AQ[RQtQ],从而得到最终查询图像IQ与3D模型间的投影矩阵CQ,并产生初步摆正视图IF。在产生初步摆正视图的基础上,引入超分辨率(SR)技术来避免因平移旋转过程中产生的像素损失的同时提高低质量人脸正面视图IF的精度,具体方法见2.3节。

能见度估计 图像可见性的估计是相当困难的。大多数研究人员对于估计能见度,更喜欢使用两个或多个视图估计出3D几何模型。本文中,使用类似于文献[24-25]的方法,使用一个单一的3D几何模型和其对应的参考正面视图,将所有的3D人脸模型中的点映射到查询图像中。这种情况下,查询图像中的大多数点可以有一个或多个对应的3D模型上的点。计算V(q′)=1-exp(-#q), 其中#q代表查询图像该位置对应3D点的数量,V(q′)为计算得分,设置一个阈值来确定看不见的区域。对于估计出不可见区域的像素强度,本文基于人脸对称性的特点通过加权该点处的平均强度以及另一侧面部对应位置的像素强度覆盖得到。

2.3 图像超分辨率重建上节提到在产生初步摆正视图的过程中,引入超分辨率(SR)技术进行正面人脸图像的超精度重构,这么做的目的主要在于:既补全了由于图像平移旋转过程中所丢失的像素信息,又在一定程度上避免了设备落后等诸多原因造成的实际应用中图像分辨率不高而导致人脸识别算法准确率下降的情况。最近几年,基于深度学习的算法在SR方向上展示了强大的可操作性,在SRCNN(Super-Resolution Convolutional Neural Network)[16]中应用卷积神经网络进行端到端的学习方法在SR上得到了不错的效果。对于提高SRCNN效果的想法之一便是尽可能多地增加神经网络的深度来获得更好的结果;然而这将大幅增加参数个数导致需要更多的数据去学习以避免出现过拟合的情况,并且由于层数增加在学习中存在梯度消失/爆炸的现象而导致训练变得艰难。因此,本文引入递归监督和跳跃链接来简化训练难度,引入递归来避免增加模型的容量。

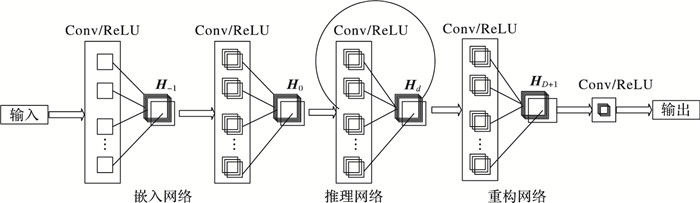

本文进行SR的基本结构如图 2所示,包括三个子网络:嵌入网络、推理网络和重构网络。

|

图 2 图像超分辨率重构网络模型 Figure 2 Image super-resolution reconstruction network model |

嵌入网络用于将给定的低质量正面人脸图像表示为特征图送入推理网络,在推理网络中解决任务后,将最终推理网络中的特征图送入重构网络进行重构产生高分辨率人脸正面图像。本文的目标是学习一个模型:

| $ \mathit{\boldsymbol{\hat y}} = f\left( \mathit{\boldsymbol{x}} \right) = {f_3}\left( {{f_2}\left( {{f_1}} \right)} \right) $ | (3) |

其中

| $ {\mathit{\boldsymbol{H}}_{-1}} = \max \left( {0, {\mathit{\boldsymbol{W}}_{-1}} * \mathit{\boldsymbol{x}} + {\mathit{\boldsymbol{b}}_{-1}}} \right) $ | (4) |

| $ {\mathit{\boldsymbol{H}}_0} = \max \left( {0, {\mathit{\boldsymbol{W}}_0} * {\mathit{\boldsymbol{H}}_{-1}} + {\mathit{\boldsymbol{b}}_0}} \right) $ | (5) |

| $ {f_1}\left( \mathit{\boldsymbol{x}} \right) = {\mathit{\boldsymbol{H}}_0} $ | (6) |

其中:操作符*表示一个卷积(核大小为3×3),而max(0, )则对应一个ReLU(Rectified Linear Unit),权重和偏置矩阵对应W和b,推理网络f2使用输入H0并且计算输出HD。本文对所有的操作使用相同的权重和偏置矩阵W和b。g表示一个单一的递归层的递归模型函数:

| $ g\left( \mathit{\boldsymbol{H}} \right) = \max \left( {0, \mathit{\boldsymbol{W}} * \mathit{\boldsymbol{H}} + \mathit{\boldsymbol{b}}} \right) $ | (7) |

递推关系如下:

| $ {\mathit{\boldsymbol{H}}_d} = g\left( {{\mathit{\boldsymbol{H}}_{d-1}}} \right) = \max \left( {0, \mathit{\boldsymbol{W}} * {\mathit{\boldsymbol{H}}_{d-1}} + \mathit{\boldsymbol{b}}} \right) $ | (8) |

对于d=1, 2, …, D。推理网络f2是由相同的基本函数g组合而成:

| $ {f_2}\left( \mathit{\boldsymbol{H}} \right) = \left( {g \circ g \circ \cdots \circ g} \right)g\left( \mathit{\boldsymbol{H}} \right) = {g^D}\left( \mathit{\boldsymbol{H}} \right) $ | (9) |

其中:º操作符表示函数组合,gd代表了g的d层。重构网络f3使用HD作为输入并输出目标图像。概况地说,重构网络是嵌入网络的逆运算,将重建好的高分辨率块补全到相应位置上。具体推导如下:

| $ {\mathit{\boldsymbol{H}}_{D + 1}} = \max \left( {0, {\mathit{\boldsymbol{W}}_{D + 1}} * {\mathit{\boldsymbol{H}}_D} + {\mathit{\boldsymbol{b}}_{D + 1}}} \right) $ | (10) |

| $ \mathit{\boldsymbol{\hat y}} = \max \left( {0, {\mathit{\boldsymbol{W}}_{D + 2}} * {\mathit{\boldsymbol{H}}_{D + 1}} + {\mathit{\boldsymbol{b}}_{D + 2}}} \right) $ | (11) |

| $ {f_3}\left( \mathit{\boldsymbol{H}} \right) = \mathit{\boldsymbol{\hat y}} $ | (12) |

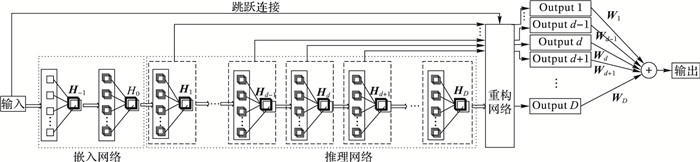

虽然递归模型简单强大且不会引入额外的卷积(新的参数),但训练一个深度递归模型确实很困难的,在以往的成功案例中,也仅仅递归到三层为止,这主要归结于两个重要的原因:梯度消失和梯度爆炸。为了解决以上两个问题,本文引入递归监督和跳跃连接进行模型的改进,使递归层数达到了16层之多。

递归监督 所有递归都被监督,每次递归后,特征映射被用来重构高精度图像,重构方法对于每个递归过程都相同。如图 3所示,每次递归给出一个高精度图像的预测,结合递归的不同层次所带来的不同预测结果来达到更加精准的预测。本文的递归监督很自然地降低了训练递归网络的难度。此外,由于本文是通过监督所有的中间层预测得到最终目标图像的,所以获得递归最有层数的重要性被降低,更快地得到最优的结果。

|

图 3 引入递归监督和跳跃连接的超分辨率重构模型 Figure 3 SR reconstrution model with recursive-supervision and skip-connection |

跳跃连接 在SR中,低分辨率图像(输入)和高分辨率图像(输出)大范围享有共同信息,然而对于输入的精准复制在前向传播中会进行衰减。如图 3所示,本文添加一个跳跃连接直接将输入链接到重建层,简单且有效地保留了预测图像中与输入图像的高度相关性。

3 实验结果与分析本章将在经过分辨率处理的LFW人脸数据集上评估本文方法的有效性。人脸姿态校正模块,本文采用了“calib”函数估计投影矩阵[23]。使用SDM进行人脸特征点检测,其中SDM在作者的主页上是开源的[4]。在超分辨率模块,使用从Google上通过爬虫获取的100000张人脸图像进行训练。需要注意的是,本文算法的主要目的在于验证经过人脸摆正和超分辨率重构对人脸识别性能的影响,因此后续实验并没有使用当前结果最优的人脸识别算法进行验证。

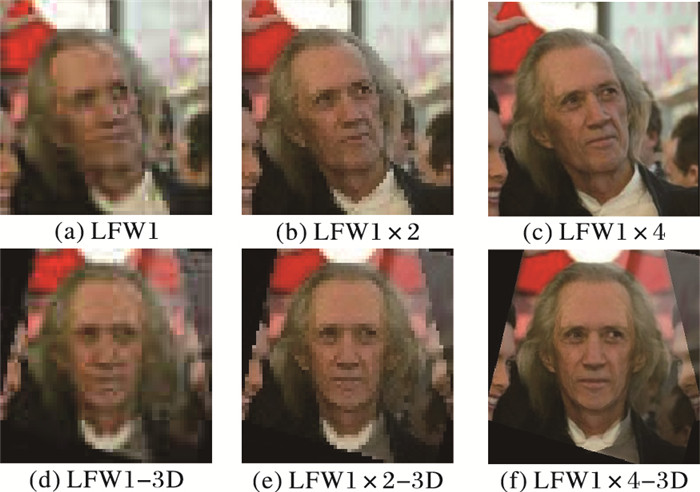

3.1 实验数据集LFW是时下最为热门的无约束人脸图像数据集,其图像采集自Yahoo!News,由5749人组成共13233张,其中1680人有两幅及以上的图像,4069人只有一幅图像。所有图像均产生于现实场景,具备自然的光线、表情、姿态和遮挡。然而与应用场景中监控摄像头采集到的图像相比,LFW具有统一的较高分辨率的特点,因此实验中将LFW数据集图像降采样到统一的50×50(在后面的实验中统一称其为LFW1),在此基础上进行后续的摆正与超分辨率操作,以更好地贴近实际应用中的情况。最终实验用数据如图 4所示,其中横向对应人脸超分辨率重构,纵向表明是否加入人脸摆正处理。

|

图 4 实验用数据示例 Figure 4 Experimental data example |

在超分辨率重构模块,在Google上爬取100000张人脸图像进行训练,目的主要是为了契合其在人脸超分辨率重构上更好的应用。

3.2 人脸验证在这个实验中,本文方法首先对LFW数据集降采样至50×50,然后进行处理并测试结果。LFW官网的view2测试协议提供了10个子集,其中9个用于训练、1个用于测试,交叉验证得到10个不同的分类器,对10次分类结果进行平均得到最终识别准确率[3]。由于本文的目标是查看人脸摆正与超精度重构对于人脸识别算法精度是否有提高,因此使用类似于文献[23]的方法作为评价标准,分别使用LBP(Local Binary Pattern)[26-27]、TPLBP(Three-Patch Local Binary Pattern)[28]特征用于人脸表示以及使用L2范式进行相似性度量。

表 1列出了数据集上的验证准确率。其中LEW1表示对LFW数据集进行降采样后50×50的原始图像,LFW1-3D为对LFW1图像进行人脸摆正而不进行超辨率处理的低质量正面人脸图像。LFW1×2和LFW1×4则分别对应于LFW1进行2倍倍增因子和4倍倍增因子超分辨率重构后的人脸图像,LFW1×2-3D和LFW1×4-3D则对应二者添加人脸摆正步骤后得到的较高清正面人脸图像,LFW则作为超分辨率算法的ground truth进行对比,显示本文超分辨率算法具有很好的还原效果。从表 1中可以看出,随着图像分辨率的提升结果也在大幅度改进,同时当图像分辨率较高时人脸摆正的引入同样会起到较显著的作用,而当图像分辨率较低时人脸摆正的引入可能会起到反效果。

| 表 1 实验数据上的人脸验证准确率 % Table 1 Face verification accuracies on experimental data % |

在本节中,采用上面实验所用到数据集的一个子集进行性别评估实验。通过人脸性别估计,可以满足快速区分人群并进行分类的需求。商家针对客户性别统计,能够更加快速准确地制定符合市场的产品定位等。这里每个数据分类采用同样的2000张图像进行测试,这2000张图像由人工手动进行男、女标签的标记。在实验中,其中500张图像进行训练,而剩余1500张被用于测试。同样LBP、TPLBP特征被用于人脸表示,支持向量机(Support Vector Machine, SVM)被用于进行分类。表 2中可以看到,与上面人脸验证相类似的结果,证明本文方法同样适用于人脸性别估计的应用上。

| 表 2 实验数据上的性别估计准确率 % Table 2 Gender estimation accuracies on experimental data % |

本文针对实际应用中的低质量无约束人脸图像,引入人脸摆正和图像超分辨率重构进行处理,旨在生成高精度正面标准人脸图像。在人脸摆正过程中,算法提议对所有图像采用一个单一的3D形状模型产生正面人脸图像,并根据3D模型以及与之对应的正面参考视图进行补全。同时,通过使用一个很深的递归卷积神经网络引入超分辨率重构模块进行重构。由于递归的存在,网络并未增加多余的参数且保证了较小的体量。为了降低模型训练的难度以及确保低分辨率图像与高质量图像间的高度相关性,采取递归监督和跳跃连接对网络进行改进。

将LFW数据集进行降采样后得到LFW1数据集,并在其上实验的结果表明,本文的方法对于低质量无约束人脸图像在人脸验证以及性别估计的准确率上具有明显的提高作用,表现出该方法在诸如安保、人防等实际应用中巨大的推广价值。

| [1] | 苏楠, 吴冰, 徐伟, 等. 人脸识别综合技术的发展[J]. 信息安全研究, 2016, 2(1): 33-39. (SU N, WU B, XU W, et al. The comprehensive technology development of face recognition[J]. Journal of Information Security Research, 2016, 2(1): 33-39.) |

| [2] | KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe:Curran Associates Inc., 2012:1097-1105. https://dl.acm.org/citation.cfm?id=2999257 |

| [3] | HUANG G B, MATTAR M, BERG T, et al. Labeled faces in the wild:a database for studying face recognition in unconstrained environments[EB/OL].[2016-11-20]. http://cs.umass.edu/~elm/papers/lfw.pdf. http://vis-www.cs.umass.edu/lfw/ |

| [4] | DING C, XU C, TAO D. Multi-task pose-invariant face recognition[J]. IEEE Transactions on Image Processing, 2015, 24(3): 980-993. DOI:10.1109/TIP.2015.2390959 |

| [5] | BLANZ V, VETTER T. Face recognition based on fitting a 3D morphable model[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(9): 1063-1074. DOI:10.1109/TPAMI.2003.1227983 |

| [6] | BLANZ V, VETTER T. A morphable model for the synthesis of 3D faces[C]//Proceedings of the 26th Annual Conference on Computer Graphics and Interactive Techniques. New York:ACM, 1999:187-194. |

| [7] | TAIGMAN Y, YANG M, RANZATO M, et al. DeepFace:closing the gap to human-level performance in face verification[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2014:1701-1708. https://link.springer.com/chapter/10.1007/978-3-319-25958-1_2/fulltext.html |

| [8] | ZHU Z, LUO P, WANG X, et al. Recover canonical-view faces in the wild with deep neural networks[EB/OL].[2016-11-20]. http://arxiv-web.arxiv.org/pdf/1404.3543v1. https://es.scribd.com/document/58788151/Science-June-24th-2011 |

| [9] | 贺飞翔, 赵启军. 基于深度学习的头部姿态估计[J]. 计算机技术与发展, 2016, 26(11): 32-37. (HE F X, ZHAO Q J. Head pose estimation based on deep learning[J]. Computer Technology and Development, 2016, 26(11): 32-37.) |

| [10] | 龙超. 图像超分辨率重建算法综述[J]. 科技视界, 2015(13): 88-89. (LONG C. Survey of super-resolution algorithms[J]. Science and Technology Vision, 2015(13): 88-89. DOI:10.3969/j.issn.2095-2457.2015.13.058) |

| [11] | BISWAS S, BOWYER K W, FLYNN P J. Multidimensional scaling for matching low-resolution face images[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(10): 2019-2030. DOI:10.1109/TPAMI.2011.278 |

| [12] | LI B, CHANG H, SHAN S, et al. Low-resolution face recognition via coupled locality preserving mappings[J]. IEEE Signal Processing Letters, 2010, 17(1): 20-23. DOI:10.1109/LSP.2009.2031705 |

| [13] | REN C X, DAI D Q, YAN H. Coupled kernel embedding for low resolution face image recognition[J]. IEEE Transactions on Image Processing, 2012, 21(8): 3770-3783. DOI:10.1109/TIP.2012.2192285 |

| [14] | SUN J, SUN J, XU Z, et al. Image super-resolution using gradient profile prior[C]//Proceedings of the 2008 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2008:1-8. https://ar.scribd.com/document/317056551/P-R-I |

| [15] | KIM K I, KWON Y. Single-image super-resolution using sparse regression and natural image prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(6): 1127-1133. DOI:10.1109/TPAMI.2010.25 |

| [16] | WANG Z, LIU D, YANG J, et al. Deep networks for image super-resolution with sparse prior[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2015:370-378. http://dl.acm.org/citation.cfm?id=966458 |

| [17] | DONG C, LOY C C, HE K, et al. Image super-resolution using deep convolutional networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307. DOI:10.1109/TPAMI.2015.2439281 |

| [18] | SCHULTER S, LEISTNER C, BISCHOF H. Fast and accurate image upscaling with super-resolution forests[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:3791-3799. http://dl.acm.org/citation.cfm?id=3057821 |

| [19] | VIOLA P, JONES M J. Robust real-time face detection[J]. International Journal of Computer Vision, 2004, 57(2): 137-154. DOI:10.1023/B:VISI.0000013087.49260.fb |

| [20] | XIONG X, TORRE F D L. Supervised descent method and its applications to face alignment[J]. Computer Vision & Pattern Recognition, 2013, 9(4): 532-539. |

| [21] | RAMANAN D, ZHU X. Face detection, pose estimation, and landmark localization in the wild[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:2879-2886. http://dl.acm.org/citation.cfm?id=2805395 |

| [22] | KAZEMI V, SULLIVAN J. One millisecond face alignment with an ensemble of regression trees[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2014:1867-1874. http://www.sciencedirect.com/science/article/pii/S0031320316304459 |

| [23] | HASSNER T, HAREL S, PAZ E, et al. Effective face frontalization in unconstrained images[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2014:4295-4304. https://link.springer.com/article/10.1007/s11265-016-1219-1 |

| [24] | KUTULAKOS K N, SEITZ S M. A theory of shape by space carving[C]//Proceedings of the 7th IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 1999:307-314. https://es.scribd.com/document/269194344/Barcelo-Mathematics-and-Archaeology |

| [25] | ZENG G, PARIS S, QUAN L, et al. Progressive surface reconstruction from images using a local prior[C]//Proceedings of the 10th IEEE International Conference on Computer Vision. Washington, DC:IEEE Computer Society, 2005:1230-1237. http://openaccess.city.ac.uk/view/divisions2/EEENGI.html |

| [26] | OJALA T, PIETIKÄINEN M, MÄENPÄÄ T. A generalized local binary pattern operator for multiresolution gray scale and rotation invariant texture classification[C]//Proceedings of the Second International Conference on Advances in Pattern Recognition. London:Springer-Verlag, 2001:397-406. http://www.academia.edu/10233905/GWAgeER_-_A_GroupWise_Age-Ranking_Approach_for_Age_Estimation_from_Still_Facial_Image |

| [27] | OJALA T, PIETIKÄINEN M, MÄENPÄÄ T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987. DOI:10.1109/TPAMI.2002.1017623 |

| [28] | WOLF L, HASSNER T, TAIGMAN Y. Descriptor based methods in the wild[EB/OL].[2016-11-20]. http://www.openu.ac.il/home/hassner/projects/Patchlbp/WolfHassnerTaigman_ECCVW08.pdf. |