2. 浙江外国语学院 计算机科学与技术学院, 杭州 310024;

3. 杭州易和网络有限公司, 杭州 310012

2. School of Computer Science and Technology, Zhejiang International Studies University, Hangzhou Zhejiang 310024, China;

3. Hangzhou Commnet Company Limited, Hangzhou Zhejiang 310012, China

随着移动互联网和智能手机的快速发展,移动支付已成为支付领域的新宠。自苹果公司于2013年将Touch ID集成到智能手机以来,各大互联网巨头纷纷推出指纹支付方案,例如Apple Pay、Samsung Pay和支付宝钱包等。其中,基于指纹识别的移动终端用户身份认证方式应用得最为广泛。尤其是在互联网新经济、新金融的背景下,指纹识别不再局限于解锁手机这一应用场景,而是被更好地嫁接于安全支付等领域,充分体现其安全、稳定、方便、高效的优点。此外,从便捷性、用户接受度、技术成熟度等方面综合考虑,指纹识别技术相对于人脸、虹膜等其他生物特征技术也具有较大的优势。目前,指纹识别技术已经成为应用于智能手机终端最为成熟的基于生物特征的身份认证与支付交易认证技术。

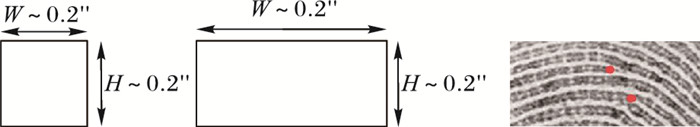

然而,由于应用环境的特殊性,面向智能手机的指纹识别技术依然存在着一些关键问题需要解决。与传统的指纹采集仪不同,嵌入到智能手机的采集仪通常都比较小,例如苹果公司的Touch ID指纹采集仪仅仅6.35 mm×6.35 mm[1]。因此,利用智能手机内嵌的指纹采集仪采集到的指纹图像的面积通常都比较小,普遍都在160×160像素以下,一般只有正常指纹面积的30%~60%,所包含的细节特征点数目也较少[2],如图 1所示。已有研究表明,随着指纹采集仪面积的减小,传统的基于细节点的指纹识别方法由于捕捉到的细节点过少导致性能下降得比较厉害[1-7]。本文的测试结果表明,传统的基于细节点比对的指纹比对算法在小面积指纹(160×160像素)样本库的准确率只有74.34%左右,远达不到实际应用需要。

|

图 1 移动端指纹采集仪尺寸及细节特征点分布 Figure 1 Fingerprint sensor size on mobile device and minutiae overlaid on a small-size fingerprint |

小面积指纹识别是面向智能手机的指纹识别需要解决的一个关键问题。早期的小面积指纹识别研究主要还是借助于细节点信息实现匹配的目的:Jea等[8]利用从细节点导出的辅助特征结合基于流量网络(flow network)的匹配技术来实现小面积指纹匹配;Girgis等[9]提出基于图匹配理论的小面积指纹比对方法,并利用遗传算法来改善脊线形变和弹性形变对指纹匹配所造成的不良影响;Chen等[4]把小面积指纹的面积信息用来进行小面积指纹识别; 此外,pore-valley描述子[10]、重构全局特征[11]的方法也都被用于小面积指纹识别领域。

与上述方法中所关注的小面积指纹相比,智能手机上的指纹采集仪所采集到的指纹面积更小,包含更少的细节点,这使得基于细节点匹配或者重构全局特征的方法的性能受到很大影响。为了解决这一问题,近来科研工作者开始尝试从图像匹配的角度研究面向智能手机的小面积指纹识别问题。该类方法主要包括:

1) 基于相关系数的方法[12]。该类方法主要利用指纹图像本身的信息,逐个像素地计算两幅指纹之间的相关系数。

2) 基于纹理特征的方法[2, 13]。该类方法利用尺度不变特征变换(Scale Invariant Feature Transform, SIFT)或者加速-风(Accelerated-KAZE, A-KAZE)来提取指纹图像的纹理特征,进而通过纹理特征实现指纹匹配。

3) 基于感知哈希算法的方法[14-16]。该类方法主要利用哈希编码和图像块匹配的思想,计算两幅指纹图像的相似程度。

4) 基于相位相关的方法[17]。该类方法利用两幅指纹图像的相位差进行逆傅里叶变换,实现基于相位相关的指纹匹配。

最近,Zhang等[18]提出了一种针对手机端的深度学习方法,其主要思想:在训练阶段采用K最近邻(K-Nearest Neighbor, KNN)方法选取合适的三元组作为训练样本;同时,在网络中融入Triplet Loss和Softmax Loss代替常规的只采用一种Loss进行优化,该算法在其自建库上等错率(Equal Error Rate, EER)达到1.94%。

综上所述,针对智能手机的小面积指纹识别研究才刚刚开始,相关工作还比较少,特别是受限于手机端的硬件环境,基于深度学习理论的指纹匹配算法更加稀少。因此对小面积指纹识别进行深入研究,有助于提高基于指纹识别的智能手机身份认证方案的安全性和可靠性。据此,本文提出了一种基于深度神经网络与注册模板的小面积指纹匹配方法。实验结果表明,本文方法有效提高了小面积指纹匹配的准确率和鲁棒性。

本文的主要贡献:

1) 构建一个基于残差结构的深度网络模型,克服特征描述子设计过程中需要专家先验知识的困难,通过学习自动提取判别特征;

2) 借鉴智能手机指纹“注册-认证”模式,提出一种基于注册模板的小面积指纹匹配方法;

3) 改进与优化现有网络结构,在降低特征复杂度的同时增加特征的有效表达能力,在保证算法性能不下降的前提下,提高匹配速度与效率。

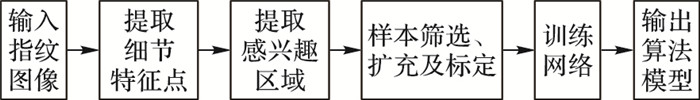

1 构建卷积神经网络模型随着智能移动终端的迅速发展,关于如何构建深度学习网络模型并移植到智能移动终端上的研究也受到了广泛关注,科研工作者提出了一系列的方法,如文献[19-21]。此外,一些深度学习平台,如MXNet,已经支持把训练好的网络移植到手机端。因此,针对现有的大部分指纹匹配方法对小面积指纹匹配的性能无法适应实际使用需求,以及充分模拟移动端指纹注册与识别的流程,本文提出了一种基于深度学习的小面积指纹匹配方法。该方法采用深度残差网络模型结构,有效避免训练误差和测试误差随着网络层数加深而增大的情况,实现对指纹图像进行更高等级特征的描述,网络模型的具体训练过程如图 2所示。

|

图 2 网络模型训练流程 Figure 2 Training procedure of the proposed CNN |

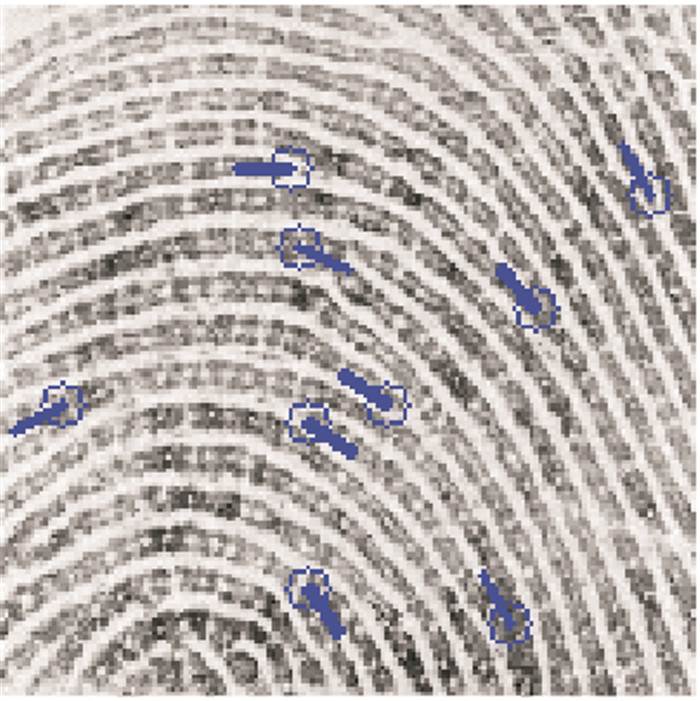

采用传统的细节特征提取算法提取小面积指纹中的细节特征点(端点、分叉点)的坐标、方向、质量等信息,细节特征点如图 3所示。

|

图 3 细节特征点的坐标和方向 Figure 3 Coordinates and directions of minutiae |

在获取一幅图像的细节特征点之后,以细节点为中心,对指纹图像进行旋转归一化,将细节点的方向统一旋转到45°角,然后截取尺寸为64×64的图像块Bi,并记上标签(即在同一个手指的多幅指纹图像中,同一个特征点对应的感兴趣图像块记上相同的标签),并进行以下处理:

1) 感兴趣图像块筛选。

为了削弱低质量样本对算法模型的影响,有必要计算每个Bi的有效指纹面积,方法如下:对于每个Bi,使用sobel算子对其提取边缘信息,然后使用9×9圆形模板对边缘图像进行闭运算,得到作为有效指纹区域判定的Bi′。若Bi′所占面积比重超过64×64的60%,则保留对应的Bi;否则,删去对应的Bi。

2) 感兴趣图像块扩充。

为了增加样本的多样性,增强算法的鲁棒性,防止过拟合现象,对1)中筛选后的训练样本Bi进行45°-6°、45°-3°、45°+3°、45°+6°旋转,如图 4所示。

|

图 4 感兴趣图像块旋转扩充 Figure 4 Augmenting regions of interest with rotation |

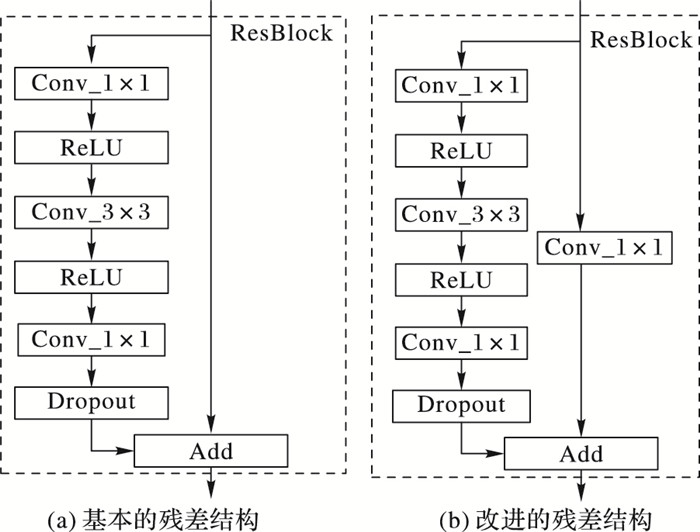

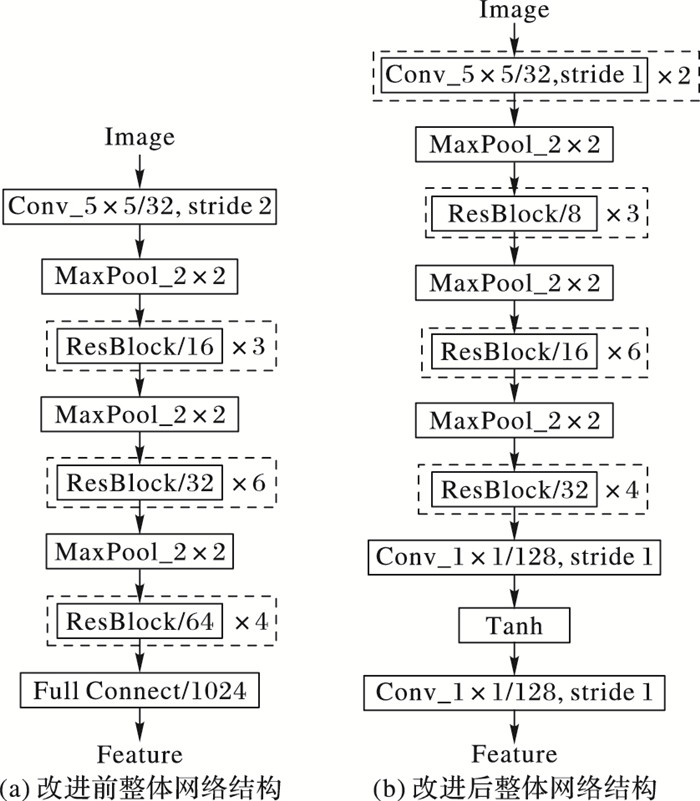

鉴于残差网络在ImageNet2015上的优越表现,本文提出的卷积神经网络由一系列残差结构串联而成,其目的是为了有效提取指纹图像的高阶语义特征。一个基本的残差结构如图 5(a)所示。其中每个卷积层后接一个批归一化层(Batch Normalization, BN),在图中未标出,dropout层的丢弃率为0.2。在每个池化层之后,当特征模板的个数需要改变时,为了保证相加运算的两部分长度相同,需要增加一个映射层,残差结构改为如图 5(b)所示。网络的整体结构如图 6(a)所示,输入图像为64×64,经过一个5×5卷积层,3个池化层和13个残差结构的运算后,得到256个4×4的特征模板,再经过全连接层后得到一个1024维的向量输出。

|

图 5 基础残差结构改进 Figure 5 Improvement original residual module |

|

图 6 整体卷积神经网络结构改进 Figure 6 Improvement overall structure of CNN |

该网络采用Triplet Loss方式进行训练[22]。Triplet Loss方法主要特点在于:训练过程中,样本以一个三元组形式输入。其中三元组的构造方式为:从训练样本中随机选取一个样本,该样本称之为参考样本Ia,然后再随机选取一个与参考样本属于同一手指同一特征点的正样本Ip以及一个与参考样本不同类的负样本In,所选取的三个样本构成了一个三元组。在训练过程中,每个三元组一次性输入到同一个网络中并得到3组特征xia、xip、xin,通过求解以下误差函数并用反向传播方法调节整个网络:

| $ L = \arg \min \sum\limits_i {{{\left( {\left\| {x_i^a-x_i^p} \right\|_2^2-\left\| {x_i^a-x_i^n} \right\|_2^2 + threshold} \right)}_ + }} $ | (1) |

其中:(a)+等效于max(0, a)。该式从本质上定义了同类样本和异类样本之间的距离关系,其目的在于通过训练,使得参考样本与正样本之间的欧氏距离DisP和参考样本与负样本之间的欧氏距离DisN满足同类样本间的距离加上某个给定的阈值threshold要小于异类样本间的距离,即:

| $ \left\| {x_i^a-x_i^p} \right\|_2^2 + threshold < \left\| {x_i^a-x_i^n} \right\|_2^2 $ | (2) |

根据1.3节训练得到算法模型后,就可以对图像的每个细节特征点对应的64×64感兴趣图像块Bi提取特征F={fm}m=1L。其中,L为每个Bi的特征长度,fm为第m维特征。此时,fm为1024维浮点型特征,本节借鉴哈希编码思想对其进行轻量化压缩[23-29],减少存储空间。同时,在保证算法精度的前提下,尽量提高算法匹配速度。其基本思想:从对每一幅指纹图像提取1024维浮点型特征,改为提取8192维整型特征,具体方法如下。

浮点型特征通过使用符号函数sign()可以得到整型表示的二值化特征,那么两组特征之间的相似度可以从余弦距离代替为汉明距离计算[30-31]:

| $ d\left( {x, y} \right) = \sum {x\left[i \right] \oplus y\left[i \right]} $ | (3) |

其中:⊕表示异或运算。但是,由于符号函数无法计算梯度,导致无法直接进行网络优化,因此采用tanh()代替sign()来计算梯度值。

最终网络结构优化如下:在输入端增加一个卷积层;减小中间层的feature map数目;全连接层替换成二个1×1的卷积层;新增一个tanh层进行特征二值化操作。网络最终输出128个8×8尺寸的feature map,即总长度为8192的二值特征,并使用Triplet Loss进行匹配训练,如图 6(b)所示。

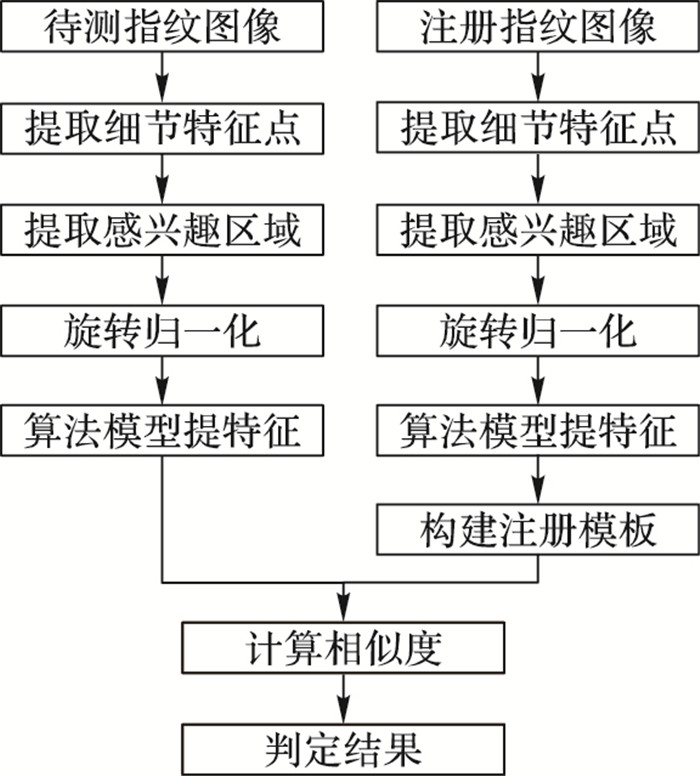

2 基于注册模板的指纹匹配方法针对小面积指纹中包含特征点较少的问题以及结合手机端“注册-认证”的常规模式,本文提出一种注册-匹配相结合的策略,具体流程(如图 7所示)如下:

|

图 7 注册/匹配流程 Figure 7 Procedure of registering and matching |

1) 用训练好的模型对每个注册手指的多幅指纹图像提取特征,并构建注册特征模板;

2) 用训练好的模型对每幅待测指纹图像提取特征;

3) 将待测指纹图像特征与所有注册特征模板进行匹配及计算相似度,并根据设定的相似度阈值判别匹配结果。

2.1 构建注册模板根据训练得到的网络模型,构建注册指纹特征模板。由于指纹采集模块尺寸较小,每次只能采集到完整指纹的部分信息,因此注册过程中需要采集多张指纹图像(与目前手机端指纹注册模式类似),此处设定单枚手指最大采集张数为P,实际有效注册图像数量为S。同时,为了获取注册指纹更多的有效信息,注册过程中需要用户配合指令进行相应的操作,具体操作如下:第一张注册图像要求将手指的中心位置置于采集仪的采集表面;后续在注册过程中手指相对采集仪的位置需要进行一些移动。具体步骤如下:

假设Ii表示第i张注册的指纹图像,MIi表示Ii对应的特征点集,FIi表示Ii对应的特征点集的语义特征集合。

1) 当采集第1张指纹图像时(即N=1时,其中N表示采集指纹图像的张数),判断采集到图像的指纹有效面积Areae,若Areae≥thrarea时,将MI1加入注册模板中,此时注册模板中特征点集为MI1,特征模板为FI1。其中thrarea为采集到指纹图像中指纹有效区域的阈值;若Areae < thrarea,则提示重新采集。

2) 当N=2时,如步骤1)所述方法对采集到的图像进行有效区域判断,若通过,则将I2的细节特征点集MI2对应的特征FI2与注册模板中特征集FI1进行匹配,MI2与当前模板的特征点集MI1进行匹配,求取MI2中与MI1不相同的特征点个数n2,若n2 ≥ thrdif,则将MI2加入注册模板中,此时注册模板特征点集更新为

3) 依此类推,注册模板特征点集为

4) 判断继续/停止条件。若Ndif> Thrdif且Q=S,则提示本手指注册完成,得到最终的

假设

1) 对于M1中每个特征点对应的

2) 对每个Fj1计算

3) 从

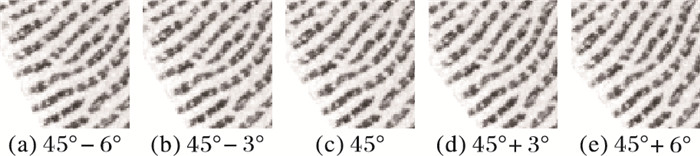

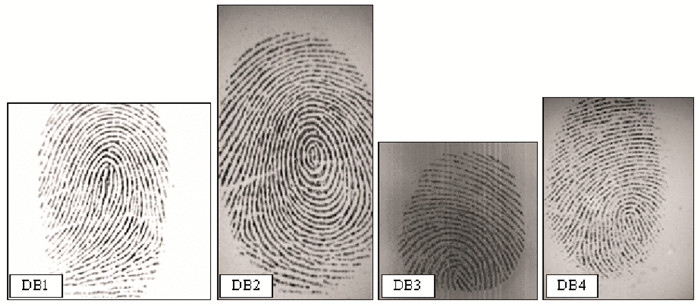

由于目前没有公开的小面积指纹数据库,所以暂时无法与其他最新的算法进行直接公开比较。而FVC2000、FVC2002、FVC2004和FVC2006等公开库都为图像尺寸较大的指纹库(如图 8所示),一般含有较完整的指纹信息,不能有效衡量本文提出的小面积指纹匹配算法的性能,表 1给出了FVC指纹库中各个子库的指纹图像的尺寸等基本信息。因此,为了更好地验证本文算法的有效性,针对算法性能测试的实际需求,构建了两个小面积指纹数据库。

|

图 8 FVC2002指纹图像样例 Figure 8 Sample fingerprint image of FVC2002 |

| 表 1 FVC2002指纹图像信息 Table 1 Fingerprint image information of FVC2002 |

数据库1(DB1)为自建库,采用晟元AS650电容式指纹仪采集了尺寸仅为160×160的13433幅指纹图像(如图 9、10所示)。其中,训练集包括98个手指的1731幅指纹图像;验证集包括80个手指的1600幅指纹图像;注册集包括133个手指的1330幅指纹图像,即每个手指用10幅图像注册成模板;测试集包括133个手指的8772幅指纹图像。训练集、验证集、注册集与测试集三者之间手指两两互斥;注册集、测试集二者之间手指相同,但指纹图像互斥。具体划分如表 2所列。

|

图 9 晟元电容指纹采集仪(AS650型号) Figure 9 Shengyuan capacitive fingerprint sensor (Version AS650) |

|

图 10 晟元数据库指纹图像样例 Figure 10 Fingerprint image samples of Shengyuan database |

| 表 2 晟元自建库指纹图像信息 Table 2 Fingerprint image information of Shengyuan database |

数据库2(DB2)为重构和扩充后的FVC2002DB1(如图 11所示),其中训练集包括DB1_a中50×8×5幅160×160指纹图像(即表示共50个手指,每个手指含8幅原图,从每幅原图中随机截取5个160×160尺寸的图像,依此类推)(DB1_a和DB1_b分别为FVC2002DB1的两个子库);验证集包括DB1_b中10×8×5幅160×160指纹图像;注册集包括DB1_a中50×4×5幅160×160指纹图像;测试集包括DB1_a中50×4×5幅160×160指纹图像。其中,训练集、验证集、注册集与测试集三者之间手指两两互斥;而注册集、测试集二者之间手指相同,但指纹图像互斥。具体划分如表 3所列。

|

图 11 FVC2002DB1重构后的指纹图像样例 Figure 11 Rebuilt fingerprint image samples of FVC2002DB1 |

| 表 3 本文重构FVC2002DB1指纹图像信息 Table 3 Rebuilt fingerprint image information of FVC2002DB1 |

本实验的主要模拟环境为Inter CPU i5-3450 3.1 GHz和4 GB内存,将测试集中每个手指的每幅指纹图像与注册集中的所有模板进行匹配,并采用目前国际上惯用的指纹匹配算法评价指标来衡量本文算法性能,即采用以下指标:

1) 误识率(False Match Rate, FMR)。来自不同手指的两幅指纹图像被错误地判定为来自相同手指的概率。

2) 误拒率(False NonMatch Rate, FNMR)。来自相同手指的两幅指纹图像被错误地判定为来自不同手指概率。

3) 等错率(Equal Error Rate, EER)。当误识率和误拒率相同时,则EER=FMR=FNMR。

4) 万分之一误识率FMR(0.0001)。当误识率FMR为0.0001时,对应的误拒率FMR。

5) 匹配率(Match Rate, MR)。MR1表示Top1的准确率。

6) 平均匹配时间(Average Match Time, AMT)。两幅指纹图像之间匹配运算所需的平均时间。

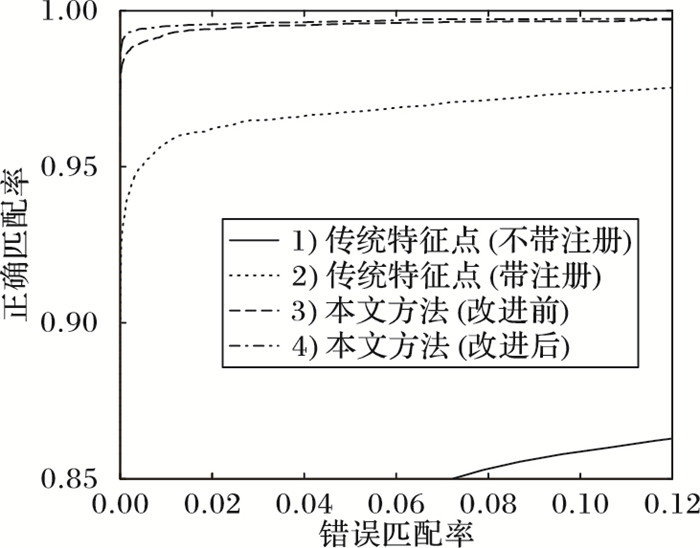

传统的基于细节特征点的指纹匹配方法和是目前比较主流的指纹匹配方法,并在大指纹图像上拥有良好的性能[32]。本项目团队早期研发的一种基于细节特征点的指纹图像匹配算法[32],在2014年第二届中国生物特征识别竞赛指纹识别竞赛中获得一等奖,说明该算法针对大采集面积的指纹具有良好的性能。然而,该算法在小面积的指纹数据库的测试中性能下降较为明显,无法满足智能手机端的应用需求。为了增加实验的说服力,本文在晟元数据库和重构后的FVC2002DB1上分别设计了4种和5种算法进行对比实验,比较上述性能指标。

在晟元自建库上,本文设计的4种算法:

1) 基于传统特征点的方法。即在测试集中任意一张图片与注册集中的任意一张图片进行匹配计算相似度,并按单张图相似度高低排序;

2) 基于传统特征点与注册策略的方法。即在测试集中任意一张图片与注册集中的每个手指10张图片为一组进行匹配计算相似度,取3个最大相似度求均值,并按手指排序;

3) 本文提出的基于深度神经网络和注册策略的方法;

4) 本文提出的基于改进深度神经网络和注册策略的方法。

上述四种方法在晟元测试库上进行对比实验,结果如表 4所列,受试者工作特征曲线(Receiver Operating Characterisitic curve, ROC)如图 12所示。

| 表 4 几种算法在晟元数据库上的实验结果 Table 4 Experimental results on Shengyuan database |

|

图 12 晟元数据库ROC曲线 Figure 12 ROC of Shengyuan database |

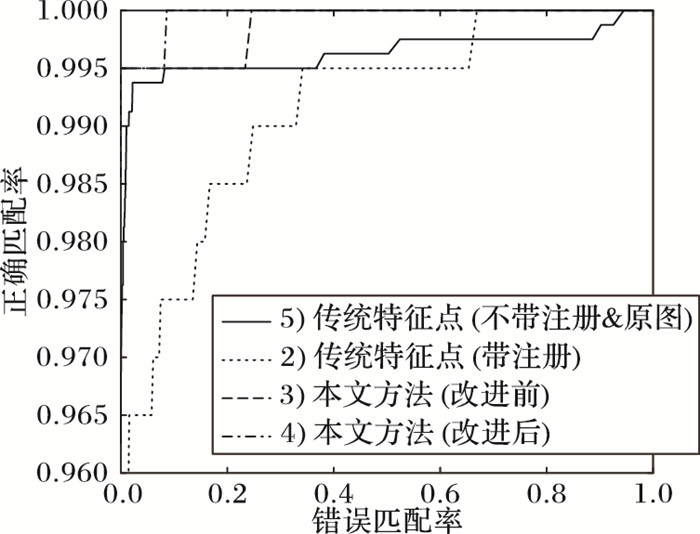

在重构后的FVC2002DB1上,本文新增一种算法:5)基于传统特征点的方法,即在测试集原图(388×374)中任意一张图片与注册集原图(388×374)中的任意一张图片进行匹配计算相似度,并按单张图相似度高低排序。该方法与上述4种方法进行对比实验,结果如表 5所列,ROC曲线如图 13所示(因1)算法的性能明显劣于其他4种算法,比较意义不大,同时为了ROC曲线更好的整体表达效果,故将其排除)。

| 表 5 几种算法在FVC2002DB1数据库上的测试结果 Table 5 Experimental results on FVC2002DB1 |

|

图 13 FVCDB1的ROC曲线 Figure 13 ROC of FVCDB1 |

深入分析实验结果可知:

1) 分别对比表 4和表 5中算法1)与算法2),可以证明本文提出的“注册模式”策略对小面积指纹(160×160)匹配算法的有效性。其中算法1性能严重下降是因为晟元数据库是自建库,指纹图像是用晟元AS650电容式指纹仪采集得到,指纹图像尺寸较小,仅为160×160。FVC2002DB1是公开库,其指纹图像尺寸较大,为388×374,测试样本是从388×374中随机截取160×160得到的,相互之间的重叠区域面积很难保证,而基于传统特征点的匹配方法非常依赖于重叠面积中的细节特征点信息。因此在公开库FVC2002DB1和晟元数据库上,算法1的性能均较差,实验结果是合理的,同时也突出了在小面积指纹匹配方面,“注册模式”的有效性和必要性。

2) 分别对比表 4和表 5中算法1)、2)与算法3)、4),证明本文提出的基于深度神经网络的小面积指纹(160×160)算法比传统基于细节特征点算法,在各项性能指标上具备更为明显的优势。此外,尽管在大面积指纹上(388×374),算法5)也取得了不错的效果,但仍逊于本文算法。

3) 分别对比表 4和表 5中算法3)与算法4),表明改进ResNet网络后算法的平均匹配时间在公开库FVC2002DB1上从49.78 ms降低至26.21 ms,在晟元数据库上从50.12 ms降低至26.53 ms,同时保证其他各项性能指标不下降,部分指标性能还有所提升,证明了改进ResNet的有效性。

实验结果表明,在智能手机端小面积指纹图像上,仅凭借传统特征点的匹配算法在各项指标上性能明显下降,已达不到实用要求;而本文提出的基于改进深度神经网络的算法在性能上有较为显著的提升。其中,在晟元数据库上等错率EER仅为0.58%,万分之一误识率FMR(0.0001)仅为1.39%,Top1准确率MR1达到99.57%,每次平均匹配时间仅为26.53 ms;在FVCDB1数据库上,EER仅为0.50%,FMR(0.0001)仅为0.50%,MR1达到99.50%,每次平均匹配时间仅为26.21 ms。综上所述,本文方法在以上各项重要评价指标上均获得了良好的性能,达到手机端小面积指纹识别的应用要求。

4 结语针对传统基于细节特征点的指纹匹配算法在小面积指纹图像上普遍存在精度低、鲁棒性差等缺点,本文提出一种基于深度学习理论的小面积指纹图像匹配方法。该方法能够显著提高小面积指纹匹配的多项重要性能评价指标,具备较高的准确率、较强的鲁棒性。随着移动互联和智能手机的兴起,基于指纹识别的移动终端用户身份认证方式逐渐被广大用户所接受,而拥有高精度、高鲁棒性的小面积指纹匹配方法必将广泛应用于智能手机端的指纹解锁、指纹安全支付等新领域。

| [1] | FERNANDEZ-SAAVEDRA B, SANCHEZ-REILLO R, ROS-GOMEZ R, et al. Small fingerprint scanners used in mobile devices:the impact on biometric performance[J]. IET Biometrics, 2016, 5(1): 28-36. DOI:10.1049/iet-bmt.2015.0018 |

| [2] | MATHUR S, VJAY A, et al. Methodology for partial fingerprint enrollment and authentication on mobile devices[C]//Proceedings of the 9th IAPR International Conference on Biometric. Piscataway, NJ:IEEE, 2016:1-8. |

| [3] | CHEN F, ZHOU J. On the influence of fingerprint area in partial fingerprint recognition[C]//Proceedings of the 7th Chinese Conference on Biometric Recognition. Berlin:Springer, 2012:104-111. https://link.springer.com/content/pdf/10.1007%2Fs10044-017-0615-x.pdf |

| [4] | CHEN F, LI M, et al. A fusion method for partial fingerprint recognition[J]. International Journal of Pattern Recognition and Artificial Intelligence, 2013, 27(6): 1356009. DOI:10.1142/S0218001413560090 |

| [5] | 毛元, 冯桂, 汤继生. 采用八方向Gabor滤波的指纹识别算法[J]. 华侨大学学报(自然科学版), 2013, 34(2): 151-155. (MAO Y, FENG G, TANG J S. Fingerprint recognition algorithm based on the eight directions Gabor filter[J]. Journal of Huaqiao University (Natural Science), 2013, 34(2): 151-155. DOI:10.11830/ISSN.1000-5013.2013.02.0151) |

| [6] | 贺颖, 蒲晓蓉. 应用Gabor滤波的指纹识别算法的研究和实现[J]. 计算机工程与应用, 2010, 46(12): 172-175. (HE Y, PU X R. Development and implementation of Gabor filterbank-based fingerprint recognition algorithm[J]. Computer Engineering and Applications, 2010, 46(12): 172-175. DOI:10.3778/j.issn.1002-8331.2010.12.051) |

| [7] | 刘映杰, 马义德, 冯晓兰, 等. Gabor滤波器在基于细节点的指纹识别中的应用[J]. 计算机测量与控制, 2007, 15(1): 132-134. (LIU Y J, MA Y D, FENG X L, et al. Fingerprint identification preprocessing algorithms based on Gabor filter[J]. Computer Measurement and Control, 2007, 15(1): 132-134.) |

| [8] | JEA T, GOVINDARAJU V. A minutia-based partial fingerprint recognition system[J]. Pattern Recognition, 2005, 38(10): 1672-1684. DOI:10.1016/j.patcog.2005.03.016 |

| [9] | GIRGIS M R, SEWISY A A, MANSOUR R F. A robust method for partial deformed fingerprints verification using genetic algorithm[J]. Expert Systems with Application, 2009, 36(2): 2008-2016. DOI:10.1016/j.eswa.2007.12.011 |

| [10] | ZHAO Q, ZHANG D, ZHANG L, et al. High resolution partial fingerprint alignment using pore-valley descriptors[J]. Pattern Recognition, 2010, 43(3): 1050-1061. DOI:10.1016/j.patcog.2009.08.004 |

| [11] | WANG Y, HU J. Global ridge orientation modeling for partial fingerprint identification[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(1): 72-87. DOI:10.1109/TPAMI.2010.73 |

| [12] | ZANGANEH O, SRINIVASAN B, BHATTACHARJEE N. Partial fingerprint matching through region-based similarity[C]//Proceedings of the 2014 International Conference on Digital Image Computing:Techniques and Applications. Piscataway, NJ:IEEE, 2014:1-8. http://monash.edu/research/explore/en/persons/nandita-bhattacharjee(a68bc99c-8c24-4087-8a99-b796b7236f70)/publications.html |

| [13] | YAMAZAKI M, LI D, ISSHIKI T, et al. SIFT-based algorithm for fingerprint authentication on smartphone[C]//Proceedings of the 20156th International Conference of Information and Communication Technology for Embedded Systems. Piscataway, NJ:IEEE, 2015:1-5. |

| [14] | ZAGORUYKO S, KOMODAKIS N. Learning to compare image patches via convolutional neural networks[C]//Proceedings of the 2015 Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:4353-4361. |

| [15] | HAN X, LEUNG T, JIA Y, et al. MatchNet:unifying feature and metric learning for patch-based matching[C]//Proceedings of the 2015 Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:3279-3286. |

| [16] | JIANG Y, WANG J, CHANG S F. Lost in binarization:query-adaptive ranking for similar image search with compact codes[C]//Proceedings of the 1st ACM International Conference on Multimedia Retrieval. New York:ACM, 2011:16-23. http://www.tandfonline.com/doi/full/10.1080/02564602.2015.1015631?src=recsys |

| [17] | SHABRINA N, ISSHIKI T, KUNIEDA H. Fingerprint authentication on touch sensor using phase-only correlation method[C]//Proceedings of the 20167th International Conference of Information and Communication Technology for Embedded Systems. Piscataway NJ:IEEE, 2016:85-89. |

| [18] | ZHANG F D, FENG J F. High-resolution mobile fingerprint matching via deep joint KNN-triplet embedding[C]//Proceedings of the 31st AAAI Conference on Artificial Intelligence. Menlo Park, CA:AAAI Press, 2017:5019-5020. |

| [19] | KIM Y D, PARK E, YOO S, et al. Compression of deep convolutional neural networks for fast and low power mobile applications[J]. Computer Science, 2015, 71(2): 576-584. |

| [20] | CHEN W, WILSON J, TYREE S, et al. Compressing convolutional neural networks in the frequency domain[C]//Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, New York:ACM, 2016:1475-1484. https://arxiv.org/pdf/1708.04675 |

| [21] | WANG Y H, XU C, YOU S, et al. CNNpack:packing convolutional neural networks in the frequency domain[EB/OL].[2016-11-20].http://papers.nips.cc/paper/6390-cnnpack-packing-convolutional-neural-networks-in-the-frequency-domain.pdf. |

| [22] | BALNTAS V, JOHNS E, TANG L, et al. PN-Net:conjoined triple deep network for learning local image descriptors[EB/OL].[2017-02-15].http://xueshu.baidu.com/s?wd=paperuri%3A%28ff8216fda10792903f171174e547f13a%29&filter=sc_long_sign&tn=SE_xueshusource_2kduw22v&sc_vurl=http%3A%2F%2Farxiv.org%2Fabs%2F1601.05030&ie=utf-8&sc_us=13359624053645813751. |

| [23] | LAI H, PAN Y, LIU Y, et al. Simultaneous feature learning and hash coding with deep neural networks[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:3270-3278. |

| [24] | LIN G, SHEN C, HENGEL A V D. Supervised hashing using graph cuts and boosted decision trees[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(11): 2317-2331. DOI:10.1109/TPAMI.2015.2404776 |

| [25] | LIONG V E, LU J, WANG G, et al. Deep hashing for compact binary codes learning[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:2475-2483. |

| [26] | LIU W, WANG J, JI R, et al. Supervised hashing with kernels[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2012:2074-2081. https://www.computer.org/web/csdl/index/-/csdl/proceedings/cvpr/2012/1226/00/index.html |

| [27] | STRCHA C, BRONSREIN A M, FUA P. LDAHash:improved matching with smaller descriptors[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 34(1): 66-78. |

| [28] | ZHAO F, HUANG Y, WANG L, et al. Deep semantic ranking based hashing for multi-label image retrieval[C]//Proceedings of the 2015 Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2015:1556-1564. http://dl.acm.org/citation.cfm?id=3080906 |

| [29] | WANG J, KUMAR S, CHANG S F. Semi-supervised hashing for large-scale search[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(12): 2393-2406. DOI:10.1109/TPAMI.2012.48 |

| [30] | ZHANG L, ZHANG Y, TANG J, et al. Binary code ranking with weighted hamming distance[C]//Proceedings of the 2013 Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:1586-1593. |

| [31] | GONG Y, LAZEBNIK S, GORDO A, et al. Iterative quantization:a Procrustean approach to learning binary codes for large-scale image retrieval[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2013:817-824. |

| [32] | ZHANG Y, FANG S, ZHOU B, et al. Fingerprint match based on key minutiae and optimal statistical registration[C]//Proceedings of the 9th Chinese Conference on Biometric Recognition. Berlin:Springer, 2014:208-215. http://portal.acm.org/citation.cfm?id=1083989 |