2. 河南省高校计算智能与数据挖掘工程技术中心, 河南 新乡 453007

2. Engineering Technology Research Center for Computing Intelligence and Data Mining of Henan Province, Xinxiang Henan 453007, China

随着城市经济的快速发展,火灾对于人类的生命、财产以及企业正常运转造成了极大的威胁。火灾具有突发性、危害大等特点[1],对火灾进行检测和早期预警具有明确的现实需求,而如何在火灾发生早期进行烟雾识别具有重大的理论和实际意义。

传统的烟雾识别方法多采用物理信号进行监测。例如: Yamada等[2]提出基于逐层自组装电解质薄膜的烟雾传感器进行烟雾感知识别;Keller等[3]提出利用光声传感器进行火焰烟雾监测;Cheon等[4]提出利用温度传感器和烟雾传感器进行火焰烟雾识别。但是,该类方法对环境的依赖性强,如果周围环境发生改变,识别精度会急剧下降甚至失效; 同时,该类方法识别距离有限,需要安装大量的传感器,对人力和物力都是极大的考验。

近年来,图像处理和模式识别技术的发展与成熟,为烟雾识别提供了新的解决途径,基于图像的识别方法受到了广泛重视: Yu等[5]提出基于光流的视频烟雾识别方法,该方法通过背景估计方法确定视频中的运动像素和区域,使用Lucas-Kanade方法提取光流特征,最后使用反向传播(Back Propagation, BP)神经网络进行模型训练和预测;Wang[6]提出基于机器视觉的烟雾识别,该方法首先采用模糊逻辑进行图像质量增强,然后使用高斯混合模型提取候选烟雾区,进而提取烟雾的动态和静态特征,最后使用支持向量机(Support Vector Machine, SVM)进行模型训练和预测。该类方法相对于传统的基于物理信号的烟雾识别方法,降低了人力物力需求,同时提升了识别精度和稳定性;但是该类方法需要人工提取图像特征,同时大多针对某一特定场景下的烟雾识别,训练模型多针对当前固定场景,一旦场景改变,火焰烟雾状态随之改变,则模型识别效果下降,故不具有通用性。

基于深度学习的烟雾识别能够较好地克服上述不足。深度学习注重模型的深度和自动特征提取,逐层地由高到低进行特征学习,具有较高的特征提取和选择能力,已在自然语言处理、知识图谱、医学和图像等领域得到了广泛应用。然而深度学习是以海量数据为基础条件的,同时要求训练集和测试集符合相同的数据分布。在烟雾识别领域,实际可用数据量通常是较小的,这主要是因为大多数烟雾数据是基于固定场景拍摄的烟雾视频,每帧之间烟雾状态差别较小,造成重复数据较多。如何从已有的相关领域数据中迁移知识到烟雾识别领域是目前急需解决的一个问题。在众多的解决方法中,迁移学习是利用已有的知识对不同但相关领域问题进行求解的一种新的机器学习方法[7]。迁移学习主要可以分为三大类:1) 基于实例的迁移学习;2) 同构空间下基于特征的迁移学习;3) 异构空间下的迁移学习。因此,通过迁移学习,可以将海量数据集中的相关实例或者特征迁移到微量数据集中,从而提高模型的泛化能力。

本文提出一种基于深度迁移学习的烟雾识别方法进行同构空间下的特征迁移。这种迁移方法不需要源数据与目标数据具有相同的数据分布,迁移的是特征提取的能力。相对于烟雾数据集,ImageNet[8]数据集在数据量和种类上非常丰富,ImageNet的图像分类数据集ILSVRC2011中训练集包含1229413张图片,验证集中包含50000张图片,测试集包含100000张图片。尽管ImageNet中没有大量的烟雾图像,但是,由于烟雾图片的识别归根结底是利用边缘、纹理、颜色等特征,因此,特征迁移模型更多的是关注特征学习能力。用ImageNet作为源数据可以提取到丰富多样的图像空间特征信息,即边缘特征、纹理特征和局部细节特征等,进而迁移到烟雾识别问题上。本文从ImageNet上训练好的模型着手,进行特征迁移。具体思路是,将VGG-16网络[9]在ImageNet中学习到的特征层迁移到具有较少数据的烟雾识别问题上,被迁移的特征层中涵盖了复杂多样的特征提取能力(边缘特征、纹理特征和局部抽象特征等)。Simonyan等[9]于2014年提出VGG(Visual Geometry Group)网络,并于2014年在ImageNet大规模数据挑战赛的定位和分类两个问题上分别取得了第一名和第二名。VGG-16是一个具有16层的卷积神经网络,其中卷积层有13层,每个卷积滤波器的大小为3×3。本文将VGG-16网络中的全连接层以上的隐特征层进行迁移,同时加入预先在VGG-16网络使用烟雾数据训练过的全连接层(Fully Connected Layers, FC),进而构建一个新的深度迁移学习网络进行训练预测,训练过程中会冻结由VGG迁移过来的卷积层和池化层参数,对全连接层进行微调。本文实验采用真实场景数据,通过构建深度迁移学习网络,可大幅提高识别精度。

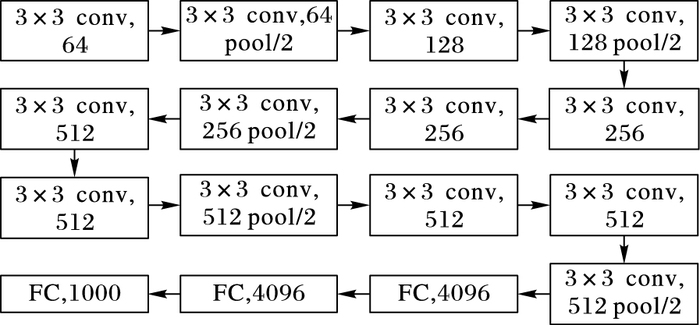

1 研究背景 1.1 VGG-16网络相对于传统的卷积神经网络,VGG-16在深度上作了提升。图 1表示VGG-16网络(pool/2代表 2维下采样, )。网络的输入采用224×224的RGB彩色图像。网络中共有13个卷积层,5个下采样层以及3个全连接层。所有的卷积滤波器的大小为3×3,卷积步长为1。使用Max-pooling进行下采样。网络中共有3个全连接层,对应的神经元节点个数为4096、4096、1000,最后一个全连接层神经元节点对应ImageNet中标签的数量。网络中共有16层含有参数,参数个数为1380000000。

|

图 1 VGG-16网络 Figure 1 VGG-16 convolutional neural network |

VGG-16网络的特点在于使用尺寸较小卷积滤波器(大小为3×3),这样有助于更加细致地提取局部特征,减少了参数个数,同时提升了决策函数的区分性[9]。VGG-16使用多个卷积层进行堆叠,并且卷积滤波器的个数。卷积层中每个神经元的计算公式如式(1) 所示。其中:k表示卷积核权重,x为输入样本,l代表层数,Mj代表上一层中可选输入特征图集合[10],bl代表每层的偏置项。卷积神经网络的权值更新过程与反向传播神经网络类似,对于每个卷积层l,本文假设其后都会连接一个下采样层l+1。根据反向传播神经网络[11-12]可知,反向传播的误差可以看作是每个神经元的基的灵敏度。式(2) 卷积层中每个特征图的计算公式, up(·)代表上采样,ο代表逐项相乘。式(4)、(5) 分别计算基的灵敏度和卷积权值的梯度:

| $X_j^l = f(\sum\limits_{i \in {M_j}} {x_i^{l - 1} * kernel_{ij}^l + b_j^l } )$ | (1) |

| ${{\delta }^{l }}=\beta _{j}^{l +1}({{f}^{'}}(\mu _{j}^{l })\circ \text{up}(\delta _{j}^{l +1}))$ | (2) |

| ${\rm{up}}(x) \equiv x \otimes {1_{n×n}}$ | (3) |

| $\frac{{\partial E}}{{\partial {b_j}}} = \sum\limits_{\mu ,\nu } {{{(\delta _j^l )}_{\mu \nu }}} $ | (4) |

| $\frac{{\partial E}}{{\partial k_{ij}^l }} = \sum\limits_{\mu ,\nu } {{{(\delta _j^l )}_{\mu \nu }}{{(p_i^{l - 1})}_{\mu \nu }}} $ | (5) |

式(4) 中u和v为输出卷积映射的位置坐标。式(6) 表示下采样的过程,down(·)表示下采样函数。下采样层权值更新与卷积层类似,都需要利用式(4) 先计算基的敏感度,再通过式(7)、(8) 得到最后的权值梯度:

| ${x_j} = f(\beta _j^l {\rm{down}}(x_j^{l - 1}) + b_j^l )$ | (6) |

| $d_j^l = {\rm{down}}(x_j^{l - 1})$ | (7) |

| $\frac{{\partial E}}{{\partial {\beta _j}}} = \sum\limits_{\mu ,\nu } {{{(\delta _j^l \circ d_j^l )}_{\mu \nu }}} $ | (8) |

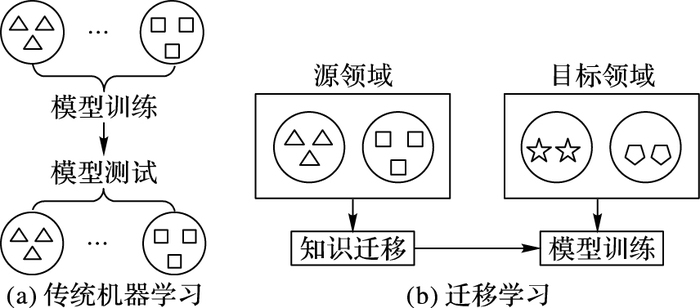

近年来,迁移学习[13]逐渐引起广泛的关注和研究。如图 2所示,传统的机器学习方法要求训练集与测试集必须在相同的特征空间,同时必须有相同的数据分布。然而现实生活中,多数领域的数据是有限的,特征是异构的,迁移学习很好地解决了如何从已有的源领域迁移知识到目标领域,甚至可以解决异类数据之间的知识迁移问题。

|

图 2 传统机器学习和迁移学习对比 Figure 2 Comparison between traditional machine learning and transfer learning |

迁移学习主要分为三大类:1) 同构空间下基于实例的迁移;2) 同构空间下基于特征的迁移;3) 异构空间下的迁移学习。Dai等[17]提出同构空间下基于实例迁移的Tradaboost算法。Yang等[18]提出异类迁移学习,将不同特征空间下的数据进行知识迁移,从而提高了分类效果。目前迁移学习在多个领域内都有发展。Xie等[19]利用迁移学习从卫星拍摄的大量图像中迁移知识,应用到社会经济指标分析中;Sonoyama等[20]将迁移学习应用到内窥镜图像分类问题上,通过从陈旧机器拍摄的内窥镜图像中迁移知识,从而提高新设备拍摄内窥镜图像的识别率。

基于实例的迁移学习大多发生在源数据集与目标数据集有较大相似度的情况下,主要是将源数据集中有助于目标数据集分类的数据尽可能地筛选出来,加入到目标数据集进行模型训练,从而提高模型的泛化能力。基于同构空间下的特征迁移学习,能够很好地克服领域间数据差别较大的情况,在特征层面上寻找一些公共特征,例如纹理特征、边缘特征、高层抽象特征等,然后迁移这种特征提取能力到目标数据集,进而提高在目标数据集上的模型泛化能力。

2 基于迁移学习的烟雾识别 2.1 烟雾识别烟雾识别对于早期预警火灾具有重大的意义。传统的机器学习、深度学习方法对数据量要求较高,无法直接应用于烟雾识别,例如文献[14-16]基于固定场景的烟雾识别中延误数据较为单一,当烟雾场景等环境改变时模型泛化能力较弱。鉴于此,本文使用基于同构空间下的特征迁移,将在同为图像数据的ImageNet数据集上预训练好的VGG-16模型中的特征提取层(卷积和池化层)迁移到目标数据集的分类任务中,其中迁移的是模型的特征提取能力(例如边缘特征提取能力、纹理特征提取能力、形状等高层抽象特征提取能力),从而提高烟雾识别模型的泛化能力。

尽管ImageNet数据与目标烟雾识别数据具有一定的差异性,但是在特征层面上存在一些不变的普适性特征,例如边缘、纹理、形状等高层抽象特征,这些特征无论是对于ImageNet数据集,还是目标烟雾数据集均是存在的共性特征,因此可以进行基于同构空间下的特征迁移。

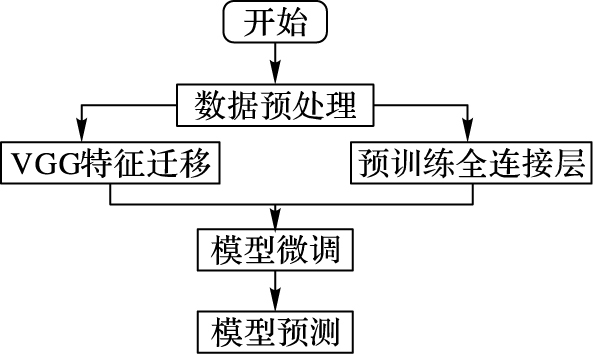

2.2 模型流程图 3表示本文的流程,可分为4个阶段。首先对数据进行预处理,预处理阶段主要将所有的图像数据按照对应的类别进行调整大小(统一成三通道,大小为3×150×150)、随机变换(随机旋转、剪切、翻转等)和归一化;其次,构建基于深度迁移学习的网络。在这个过程中首先在烟雾数据集上利用VGG-16网络预训练一个全连接网络,具体做法是将烟雾数据集作为输入,获取在ImageNet上已训练好的VGG-16网络中的卷积部分输出,从而利用这个输出训练一个全连接网络;然后, 将已在ImageNet上训练好的VGG网络中卷积部分保留参数迁移过来,与之前预训练的全连接网络进行对接,从而得到基于深度迁移学习模型,并进行模型训练和微调参数; 最后, 进行模型预测。

|

图 3 实验流程 Figure 3 Experiment flow chart |

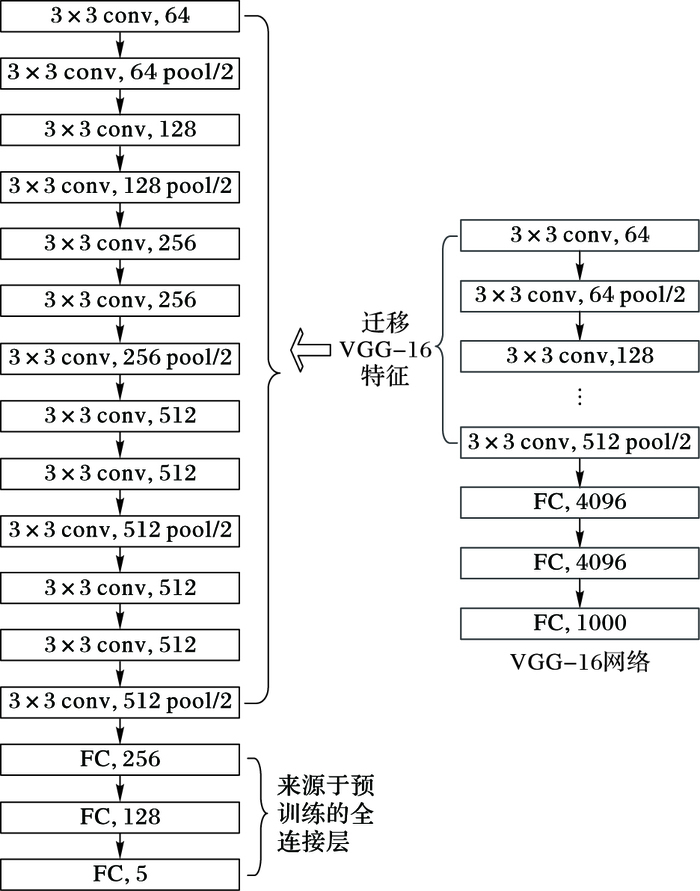

本文将使用基于VGG-16网络的迁移学习模型来进行烟雾识别。图 4是模型的架构,其中,左侧是本文所使用的烟雾识别模型,主要由两部分构成:1) 卷积层和下采样层,该部分是由VGG-16网络迁移过来的,同时加载了对应的VGG-16网络已经训练好的参数;2) 全连接层,该部分的全连接层来自预先训练好的全连接层。

|

图 4 基于VGG-16网络的迁移学习模型 Figure 4 Transfer learning model based on VGG-16 |

为了便于描述,图 4中缺省了输入层和输出层。本文所用模型共包含13个卷积层、5个下采样层,以及3个全连接层。第1~2层中卷积滤波器(大小为3×3) 个数为64;第3~4层中的卷积滤波器(大小为3×3) 个数为128;第5~7层中的卷积滤波器(大小为3×3) 个数为256;第8~13层中的卷积滤波器(大小为3×3) 个数为512;第14~16层为全连接层,对应的神经元个数分别为:256、128、5。

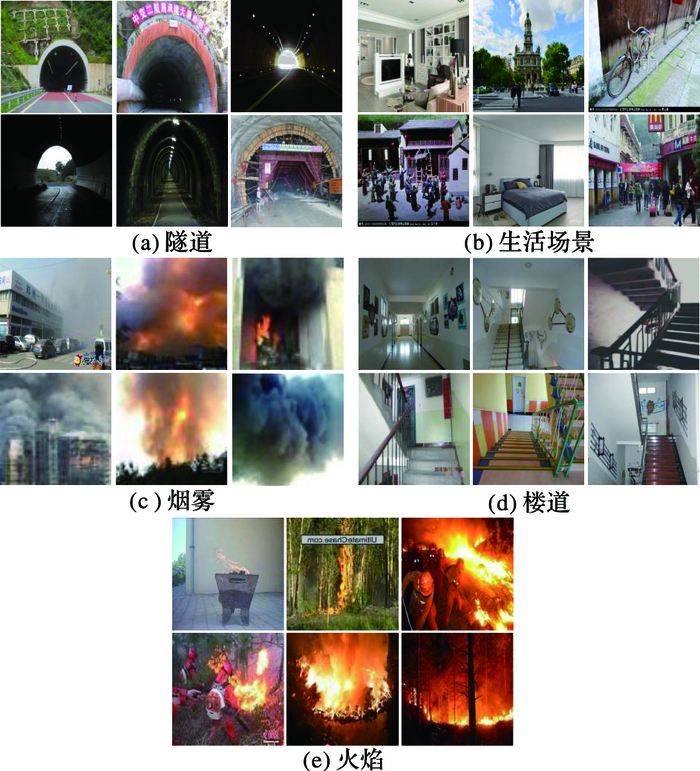

3 实验设计与结果分析 3.1 实验数据集本文采用的实验数据集来自于火焰烟雾公开数据集(http://signal.ee.bilkent.edu.tr/VisiFire/)和网络采集。实验数据集分为训练集和测试集,每个集合均含有5个类别,分别是火焰、烟雾、生活场景、楼道、隧道。表 1给出了具体的实验数据情况。图 5是实验数据实例展示图,其中每个类别中的图像数据均来自不同场景,有利于模型的训练和泛化。综合表 1和图 5,可以看出本文所使用的数据集隶属于小数据集,所以本文采用ImageNet大型数据集作为源数据集进行迁移学习。ImageNet分类数据集共含有1000个类别的图像数据,数据量之大和种类之丰富为基于深度迁移学习的模型构造提供了强大支撑。

| 表 1 实验数据 Table 1 Expermental data |

|

图 5 实验数据实例 Figure 5 Experimental data examples |

本文的对比实验有5个,分别是基于SIFT(Scale-Invariant Feature Transform)特征的支持向量机烟雾识别方法、基于深度神经网络的烟雾识别方法、基于卷积神经网络的烟雾识别方法、基于TrAdaboost的烟雾识别方法和基于Cifar-10数据集的迁移方法,为方便描述本文依次称之为SVM(Support Vector Machine)、DNN(Deep Neural Network)、CNN(Convolutional Neural Network)、TrAdaboost和TLBC(Transfer Learning Based on Cifar)。

SVM方法首先使用SIFT提取图像的特征描述符,在将其转化为特征向量,最后放入支持向量机进行训练和预测,该方法的主要参数采用径向基核函数,正则项C设置为1000。DNN方法将图像预处理归一化后放入神经网络进行训练预测,该方法采用一个4层的神经网络(不包含输入层,神经元个数分别为2048、768、512、5) 进行训练预测。

CNN方法中包含3个卷积层(卷积滤波器大小为5×5和3×3两种),2个下采样层以及两个全连接层,其中卷积层与下采样层交替连接,最后与全连接层连接进行模型训练。

TrAdaboost方法中分为目标数据集和源数据集,源数据集主要包括雾霾(723张图像数据)、烟火混合(929张图像)两大类图像,目标数据集与表 1一致,然后通过TrAdaboost方法进行训练、预测,调整每个样本的权重,TrAdaboost中使用的训练模型为逻辑回归模型。

TLBC方法首先在Cifar-10数据集上采用VGG-16模型进行训练,然后将训练好的模型中的特征隐层(卷积和池化层)迁移到烟雾识别数据上,再增加相应的全连接层进行微调。DNN和CNN方法中模型迭代次数均为100,学习率为0.01。

本文所提深度迁移学习模型简称为DMTL(Deep model based on Transfer learning)。为了增加数据的多样性,同时防止模型过拟合,首先对数据作预处理。将所有的图像数据缩放到统一的大小(3×150×150),同时将所有的数据作随机变换(随机旋转、剪切、翻转等),并进行归一化;然后对已在ImageNet上训练好的VGG-16网络中的全连接层以上部分(主要为卷积层和下采样层)保留参数进行迁移;再次,使用烟雾数据集作为输入,获取在ImageNet上已训练好的VGG-16网络中的卷积部分输出,从而利用这个输出预训练一个全连接网络。如图 4所示,将迁移过来的卷积层与预训练好的全连接层进行对接,开始模型训练,在训练过程中会冻结VGG-16迁移过来的卷积层的参数,只对全连接层参数进行微调。这样可以防止过拟合,同时提高训练效率。DMTL的详细模型配置如图 4所示,模型的学习率为0.0001,迭代次数为100。实验中DNN、CNN以及本文模型均在GPU(Graphics Processing Unit)上进行训练预测,实验所用的GPU为Tesla K40(共三块),实验环境是基于Linux的Keras。

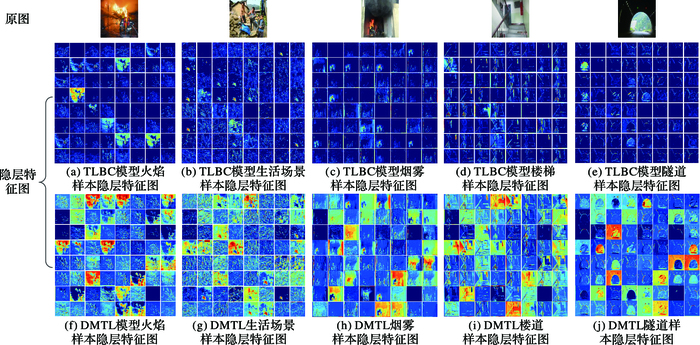

3.3 实验结果与分析图 6是使用本文所提的基于深度迁移学习的烟雾识别模型所提取出来的特征图,其中分别显示了使用VGG-16网络在Cifar-10和ImageNet两个数据集下进行迁移的中间隐层特征图。如图 6所示,为了方便展示,从目标数据集的5个类别中分别抽出一张图像显示出网络第二层的输出特征图。图 6(a)~(e)是在Cifar-10数据集下训练好的VGG-16网络进行迁移后对应样本的隐层特征图,图 6(f)~(j)是在ImageNet数据集下训练好的VGG-16网络进行迁移后对应样本的隐层特征图。可以明显地看出,两种方法均能提取到一些高层抽象特征(纹理、边缘、形状、高层抽象特征),但是与基于Cifar-10数据集的迁移方法相比,结合图 6,可以明显地观察到,基于ImageNet数据集的特征迁移方法要比前者优秀,无论从特征的局部细节展示还是边缘、纹理等高层抽象特征,后者均能很详细地在卷积过滤器中体现出来,这主要是因为ImageNet的大量数据使得训练出来VGG-16网络能够更详尽、精准地学习到样本的抽象特征,总的来说,将已在ImageNet数据集上训练好的VGG-16模型迁移到烟雾识别问题上很好地提取图像的抽象特征,进而提高模型的泛化能力。

|

图 6 TLBC与DMTL模型隐层特征对比 Figure 6 Hidden feature maps based on Cifar-10 and ImageNet |

表 2为各方法在烟雾图像数据集的对比实验结果。

| 表 2 几种方法在烟雾图像数据集的性能对比 Table 2 Performance comparison of several methods on smoke image data sets |

从表 2中可以看出: SVM在训练时间和测试时间上有较大优势,但是训练和测试精度非常低,这是由于传统的图像特征提取方法极大地依赖于先验知识;另一方面,这种传统的机器学习方法对数据依赖性较高,需要有大量的数据来训练模型。DNN、CNN方法相对于SVM方法在训练集精度和测试集精度上有明显提升,这主要是由于深度模型自动提取特征的方法优于传统的人工特征提取方法,但是深度模型对数据本身的依赖性极大,本文实验中的数据集属于小数据,因此DNN、CNN方法的训练、测试精度远远低于本文方法。TrAdaboost方法在训练精度和测试精度上相较于SVM、DNN和CNN方法又有一定的提升,这主要是因为后者对数据的要求较高,需要大量的数据进行学习,才能保证模型的泛化能力,然而TrAdaboost能够从源数据集的实例中根据一定的权重规则来逐步地提高相关样本的训练权重,弱化非相关样本的权重,从而在目标训练集上进行模型训练,提高模型的泛化能力。TLBC方法在训练时间测试时间上和本文方法相差不大,训练和测试精度相对于DNN和CNN,有较大的提升(在测试集上精度提高了超过20%),相对于TrAdaboost提高了近5个百分点,这主要是因为很多情况下源数据集与目标数据集的数据分布差异过大,造成可以进行实例迁移的样本极为稀少,有时可能造成负迁移等问题,然而同构空间下的特征迁移能够找到源数据和目标数据在特征层面上的共同特征来进行迁移。相对于其他四种对比方法,本文方法从VGG-16模型中迁移知识,应用到本文的微量烟雾识别数据集,在训练集精度和测试集精度上占绝对优势,训练集精度达到99.6%,测试集精度达到96.1%。本文方法的训练时间为3500 s,在模型训练时间上略长于其他对比方法,但是这可以通过线下训练模型来解决。总而言之,通过表 2中的TLBC和本文所使用的DMTL与其他对比实验的结果可知,基于同构空间下的特征迁移能够很好地解决烟雾微量数据集的识别问题。

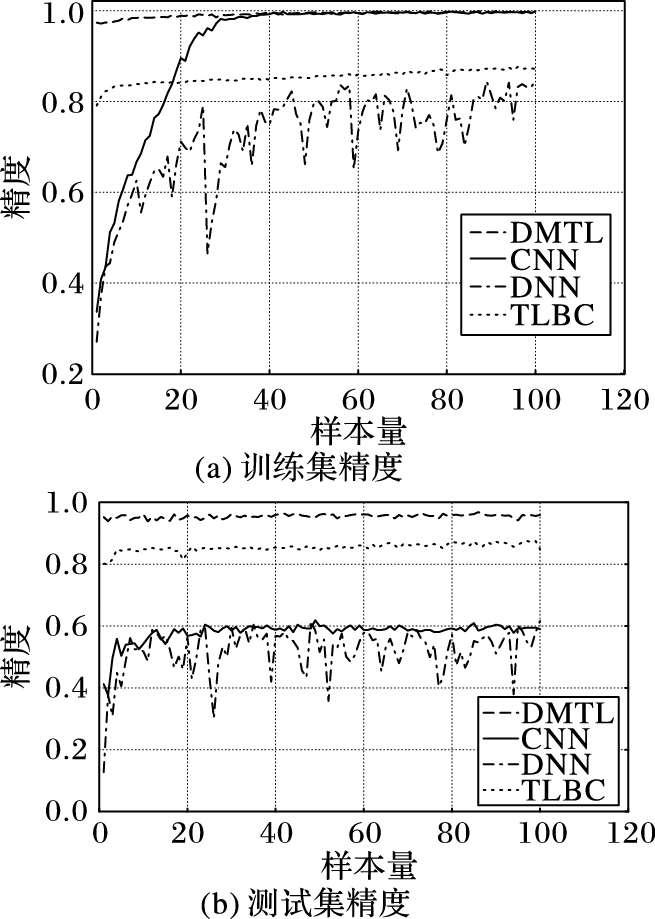

图 7为DNN、CNN、TLBC和本文方法DMTL在训练集和测试集上的精度变化对比。其中,图 7(a)为4种方法在训练集上的精度变化,可以看到,DNN和CNN方法在前30次迭代中精度迅速上升之后逐渐趋于稳定,DNN稳定在70%~80%,CNN稳定在83%~85%,TLBC方法稳定在92%~96%, DMTL方法从迭代开始94%逐渐上升到99%;图 7(b)是4种方法在测试集上的精度变化,其中DNN和CNN方法在前20次迭代中精度迅速上升,之后基本趋于稳定,DNN方法精度稳定在45%~60%,CNN方法稳定在56%~62%,TLBC稳定在82%左右, DMTL方法在迭代过程中基本稳定在96%。

|

图 7 训练集和测试集精度变化对比 Figure 7 Accuracy comparison of training set and test set |

图 7表明DNN、CNN方法在微量烟雾数据集上的学习能力明显弱于本文方法,这主要是由于前者对数据有极大的依赖性,需要大量的数据来进行特征学习。然而本文采用微量火焰烟雾数据集,使用DNN、CNN方法使得模型容易陷入过拟合,从而导致模型的泛化能力降低,导致测试集的精度较低。本文采用基于深度迁移学习的烟雾识别方法DMTL,从已在ImageNet数据集训练好的VGG-16网络中迁移知识,应用到数据量较小的火焰烟雾数据集上,使得模型的学习能力和预测能力相对于前两种方法有大幅提升,测试集精度比DNN、CNN提升了36个百分点左右。综上所述,本文所提的基于迁移学习的烟雾识别方法有较强的学习和泛化能力。

4 结语烟雾识别的核心问题在于提取有效的烟雾特征。然而对于仅有小数据的烟雾识别问题,如何从其他领域进行知识迁移则显得尤为重要。本文成功地将迁移学习引入烟雾识别问题中,从已在ImageNet数据集训练好的VGG-16网络中迁移特征用于烟雾识别,在训练集精度和测试集精度上有较大幅度的提升。本文方法对烟雾识别和其他微量数据领域具有明确的理论和实践意义。同时,针对时序数据的相关性,在下一阶段工作中,拟引入长短期记忆模型针对时间序列的烟雾视频识别深度迁移模型进行研究。

| [1] | YIM H, OH S, KIM W. A study on the verification scheme for electrical circuit analysis of fire hazard analysis in nuclear power plant[J]. Journal of the Korean Society of Safety, 2015, 30(3): 114-122. DOI:10.14346/JKOSOS.2015.30.3.114 |

| [2] | YAMADA M, SHIRATORI S. Smoke sensor using mass controlled layer-by-layer self-assembly of polyelectrolytes films[J]. Sensors and Actuators B:Chemical, 2000, 64(1/2): 124-127. |

| [3] | KELLER A, RüEGG M, FORSTER M, et al. Open photoacoustic sensor as smoke detector[J]. Sensors and Actuators B:Chemical, 2005, 104(1): 1-7. DOI:10.1016/j.snb.2004.03.013 |

| [4] | CHEON J, LEE J, LEE I, et al. A single-chip CMOS smoke and temperature sensor for an intelligent fire detector[J]. IEEE Sensors Journal, 2009, 9(8): 914-921. DOI:10.1109/JSEN.2009.2024703 |

| [5] | YU C, ZHANG Y, FANG J, et al. Video smoke recognition based on optical flow[C]//Proceedings of the 20102nd International Conference on Advanced Computer Control. Piscataway, NJ:IEEE, 2010:16-21. |

| [6] | WANG Y. Smoke recognition based on machine vision[C]//Proceedings of the 2016 International Symposium on Computer, Consumer and Control. Washington, DC:IEEE Computer Society, 2016:668-671. |

| [7] | 庄福振, 罗平, 何清, 等. 迁移学习研究进展[J]. 软件学报, 2015, 26(1): 26-39. (ZHUANG F Z, LUO P, HE Q, et al. Survey on transfer learning research[J]. Journal of Software, 2015, 26(1): 26-39.) |

| [8] | RUSSAKOVSKY O, DENG J, SU H, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y |

| [9] | SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL].[2016-11-20]. http://www.robots.ox.ac.uk:5000/~vgg/publications/2015/Simonyan15/simonyan15.pdf. |

| [10] | LI J, CHENG J H, SHI J Y, et al. Brief Introduction of Back Propagation (BP) Neural Network Algorithm and Its Improvement[M]//Advances in Computer Science and Information Engineering. Berlin:Springer, 2012:553-558. |

| [11] | CUN Y L, JACKEL L D, BOSER B, et al. Handwritten digit recognition:applications of neural network chips and automatic learning[J]. IEEE Communications Magazine, 1989, 27(11): 41-46. DOI:10.1109/35.41400 |

| [12] | BOUVRIE J. Notes on convolutional neural networks[EB/OL].[2016-11-20]. http://cogprints.org/5869/1/cnn_tutorial.pdf. |

| [13] | PAN S J, YANG Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge and Data Engineering, 2010, 22(10): 1345-1359. DOI:10.1109/TKDE.2009.191 |

| [14] | 饶裕平, 柴红玲. 林火视频监控中烟识别方法概述[J]. 林业调查规划, 2009, 34(1): 59-62. (RAO Y P, CHAI H L. A general introduction to a method for smoke recognition in vision monitoring of forest fire[J]. Forest Inventory and Planning, 2009, 34(1): 59-62.) |

| [15] | SAHINER B, CHAN H P, PETRICK N, et al. Classification of mass and normal breast tissue:a convolution neural network classifier with spatial domain and texture images[J]. IEEE Transactions on Medical Imaging, 1996, 15(5): 598-610. DOI:10.1109/42.538937 |

| [16] | HUANG Y, TIAN S, SUN X, et al. Forest fire smoke recognition based on gray bit plane technology[J]. International Journal of Signal Processing, Image Processing and Pattern Recognition, 2013, 6(6): 309-320. DOI:10.14257/ijsip |

| [17] | DAI W, YANG Q, XUE G R, et al. Boosting for transfer learning[C]//Proceedings of the 24th International Conference on Machine Learning. New York:ACM, 2007:193-200. |

| [18] | YANG Q, CHEN Y, XUE G R, et al. Heterogeneous transfer learning for image clustering via the social Web[C]//Proceedings of the 47th Meeting of the Association for Computational Linguistics and the 4th International Joint Conference on Natural Language Processing of the AFNLP. Stroudsburg, PA:Association for Computational Linguistics, 2009:1-9. |

| [19] | XIE M, JEAN N, BURKE M, et al. Transfer learning from deep features for remote sensing and poverty mapping[C]//Proceedings of the 30th AAAI Conference on Artificial Intelligence. Menlo Park, CA:AAAI Press, 2016:3929-3935. |

| [20] | SONOYAMA S, TAMAKI T, HIRAKAWA T, et al. Transfer learning for endoscopic image classification[EB/OL].[2016-11-20]. http://www.researchgate.net/profile/Tetsushi_Koide/publication/306474619_Transfer_Learning_for_Endoscopic_Image_Classification/links/587af87308ae4445c0630cc7.pdf. |