随着移动拍摄技术和网络的高速发展,每天都有海量的视频数据生成和共享,用户难以从如此海量的视频数据中获取到自己感兴趣的内容。如何对视频关键帧进行有效识别、提取,使用户能快速而准确地获取视频中感兴趣的内容成为亟须解决的问题。

传统方法大多基于底层特征对视频关键信息进行提取[1-3],忽略了对用户感兴趣内容的选取。而视频关键帧提取是一个相对主观的工作,当视频内容较为复杂或者持续时间较长时,不同用户对于同一段视频感兴趣的内容区别较大。例如,对于一场篮球比赛视频,用户感兴趣的内容可能是灌篮、三分球等一些精彩片段,也可能集中在球员的控球姿势、球场走位等技术动作,这导致不同用户对于视频关键帧提取的期望有所不同。因此,本文考虑能为不同偏好的用户在同一段视频中提取出不同的关键帧。

近年来,通过使用视频高层语义对关键帧进行提取的研究逐渐引起研究人员的关注:Yao等[4]提出可根据用户在互联网中的搜索和点击事件挖掘视频语义,从而对视频进行标注;El Sayad等[5]指出图像的语义标签和底层特征决定了其是否能被观看者记住并产生兴趣;王晗等[6]提出收集联想关键词构建迁移源域,进一步迁移学习后实现视频标注。然而互联网中的视频,尤其体育赛事和影视作品,通常在复杂的背景下拍摄并包含大量类内变化[7],在这样的训练和学习过程中,直接对视频本身进行语义建模需要标注大量的视频,费时费力,且视频中可能存在的模糊、抖动情况,给语义建模带来极大困难。互联网中包含大量的已标注图像[8],这些图像通常包含丰富信息,且由用户经过挑选上传。通过给定与用户兴趣相关的关键字,并在互联网图像搜索引擎中进行检索即可获得大量与用户兴趣语义相关图像集。因此,本文考虑将从互联网图像集中习得的语义模型作为提取与用户兴趣相关的视频关键帧的依据,从而避免为获得用户兴趣语义模型而标注大量视频作为训练数据的繁重工作[9]。

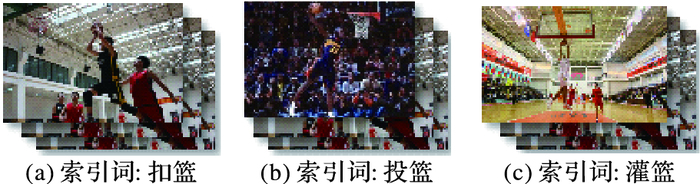

在使用与用户兴趣相关的关键字进行图像检索时,对于同一个内容,不同用户可能会以不同词汇描述。例如,扣篮、灌篮、补扣、大风车等在篮球比赛中都属于同一种语义内容,但这些关键字在互联网中进行检索时,获得的图像集会产生差别[10],如图 1所示。基于近义词检索差异,本文提出一种基于近义词检索的联合权重学习模型,对不同用户提供的兴趣内容进行近似语义建模。通过对含有近似语义模型的兴趣内容进行再加权联合学习,可获得关于一个用户感兴趣内容更全面的视觉信息。另一方面, 为了提高关键帧提取效率,考虑到音频信号中同样蕴含丰富信息[11],且与视频内容有着密切联系,本文使用伴生音频特征对视频进行筛选,使提取结果更加高效、准确。

|

图 1 近义词检索得到不同的图像集 Figure 1 Different image sets got by synonym searching |

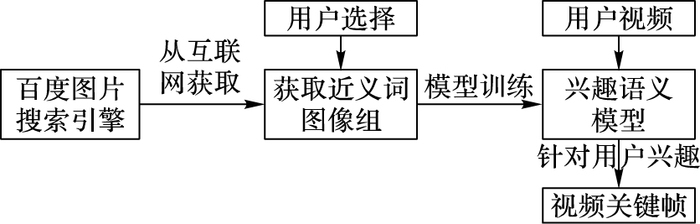

本文提出一种面向用户兴趣的视频关键帧提取算法。首先,根据用户兴趣从互联网图像搜索引擎中检索与该兴趣语义相关的图像集,作为用户兴趣关键帧提取的知识来源;其次,通过对近义词图像组的联合权重学习,将图像中习得的知识迁移到视频中;然后,使用伴生音频特征对视频进行预处理,将视频分割成为时长较短的待提取片段;最后,使用图像集中习得的语义模型对待提取片段进行关键帧提取。本文算法框架如图 2所示。

|

图 2 基于用户兴趣的视频关键帧提取算法框架 Figure 2 Framework of keyframe extraction based on users' interests |

考虑到互联网中视频具有复杂性和多样性等特点,不同用户对视频期望关注的内容有所不同[12],用户对于同一兴趣语义的描述方式也可能存在差异,为搜集尽可能全面的事件知识,本文使用基于近义词检索的联合权重学习模型,围绕同一兴趣语义选取多个含义相近但存在差异的近义词构建互联网索引。例如篮球比赛视频中球员扣篮行为的索引可为“扣篮”“灌篮”“扣球”等,从互联网检索一个近义词可得到与之对应的一组图像,构成近义词图像组,这些图像组内容存在差异(如图 1所示),能从不同方面对语义进行描述,使兴趣语义图像集内容更加全面丰富。对于每一个兴趣语义使用多个近义词进行检索,通过索引构建近义图像组指导近似语义建模,通过对近似语义模型的联合权重学习,进一步提高迁移学习有效性,获取更加完整的语义模型,识别内容能更全面地表征用户对于该视频的关注点,有针对性获取用户所需的精彩内容。

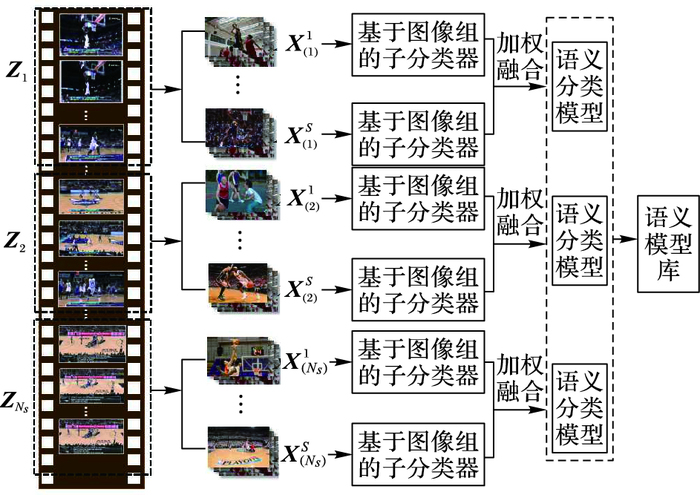

2 针对用户兴趣的视频关键帧提取 2.1 基于用户兴趣语义建模定义Ds={(Zi, Yi)|i=1Ns}为互联网图像集,其中Zi为第i个兴趣语义图像集,Yi为其对应语义标签,Ns为兴趣语义个数;每一个图像集由若干近义词检索得到的图像组Zi={Xi1, Xi2, …, XiS}构成,其中(Xis, yis)={xjs|j=1ns}(s=1, 2,…, S)为第i个兴趣语义的第s个近似语义图像组,xjs∈Rds为图像组Xis的第j张图像,yis为该图像组对应的标签,ds为图像特征维度,ns指图像组内图像数量,S指图像组数量。

兴趣语义由多个近似语义组成,本文将第s个图像组中所含的图像视为正样本,其余所有图像组中的图像视为负样本,针对第i个兴趣语义收集了S个近义词图像组构成训练数据,第s个图像组的近似语义模型f(Xis)的一般形式为:

| $\begin{array}{l} f({\mathit{\boldsymbol{X}}_i}^s) = {({\mathit{\boldsymbol{\omega }}^s})^{\rm{T}}}\mathit{\boldsymbol{\varphi }}({\mathit{\boldsymbol{x}}_j}^s) + {\mathit{\boldsymbol{b}}^s};\\ i = 1,{\rm{ }}2,{\rm{ }} \ldots ,{\rm{ }}{N_s},{\rm{ }}j = 1,{\rm{ }}2,{\rm{ }} \ldots ,{\rm{ }}{n_s} \end{array}$ | (1) |

其中:φ(xjs)为图像特征向量;ωs、bs为模型参数。一个兴趣语义由多个图像组构成,图像组从不同角度去提供该语义的视觉信息,进一步保证图像中语义信息的全面性。使用不同近义词对同一语义信息进行检索所获取的图像集内容会有所差别,若对所有图像集进行平均融合将会忽略图像组之间的差异。本文通过构建联合权重学习模型将第i个兴趣语义模型F(Zi)描述为多个近似语义模型加权融合:

| $F({\mathit{\boldsymbol{Z}}_i}) = \sum\limits_{s = 1}^S {} {\alpha _s}f({\mathit{\boldsymbol{X}}_i}^s) = \mathit{\boldsymbol{\alpha }}{\rm{ }}f({\mathit{\boldsymbol{X}}^s});{\rm{ }}i = 1,{\rm{ }}2,{\rm{ }} \ldots ,{\rm{ }}{N_s}$ | (2) |

其中αs表示第s个近似语义模型的权重。进一步,为求不同近似语义模型的权重,提高知识迁移有效性,本文将第i个图像集中的图像视为正样本,除去第i个图像集以外的所有剩余图像集中的图像视为负样本,构建基于F(Zi)的概率预测函数,将求解语义模型转换为计算逻辑模型参数α*:

| ${\chi _\alpha }({\mathit{\boldsymbol{X}}_i}^s) = \frac{1}{{1 + {{\rm{e}}^{X_i^s}}}}$ | (3) |

| $\mathit{\Omega }\left( \mathit{\boldsymbol{\alpha }} \right) = \sum\limits_{s = 1}^S {} {y_i}^s{\rm{lg }}({\chi _\alpha }({\mathit{\boldsymbol{X}}_i}^s)) + (1 - {y_i}^s){\rm{ lg }}(1 - {\chi _\alpha }({\mathit{\boldsymbol{X}}_i}^s))$ | (4) |

其中:χα(Xis)指概率预测函数,逻辑模型Ω(α)取最小值时参数α为最优语义权重,可得α*=

|

图 3 基于用户兴趣语义的语义模型算法框架 Figure 3 Semantic model framework based on users' interests |

兴趣语义由多个近似语义组成,近似语义间含有相似语义信息,所描述行为基本一致,为使不同描述词得到提取结果差异尽可能小,用户使用不同描述能得到基本一致且较全面的结果。本文使用二次规划对模型系数α*进行优化,根据测试数据的计算结果调整αs的取值,为效果较好的图像组分配较高的权值。优化函数可描述如下:

| $\mathop {\min }\limits_{{\alpha _1},{\rm{ }}{\alpha _2},{\rm{ }} \ldots ,{\rm{ }}{\alpha _s}} \frac{1}{2}\sum\limits_{s = 1}^S {} {\left\| {{\mathit{\boldsymbol{\alpha }}_s}} \right\|^2} + \mu \sum\limits_{s = 1}^S {} {\left\| {f({\mathit{\boldsymbol{X}}_i}^s) - {y_i}^s} \right\|^2}$ | (5) |

其中μ为函数系数。通过多次迭代计算模型系数α,缩小近似语义模型间的差异,用户通过不同近义词描述可得到较为一致且准确的结果。

2.3 视频关键帧提取本文提出一种基于联合权重的语义模型,收集与兴趣语义描述相似的近似语义,构建多个近似图像组,将多个图像组训练所得的近似语义模型通过联合优化学习的方法自动学习各组的权重,构建语义模型。该方法能广泛全面地获取该兴趣语义的数据信息,提供更加全面的视觉信息。

定义Dt={xit|i=1Nt}, xit∈Rdt表示视频帧特征集,xit指特征向量,dt指视频帧特征维度,Nt表示视频总帧数。计算特征距分类平面的距离,距离越小表明越有可能为用于感兴趣内容,提取距离较小的视频帧作为用户感兴趣的关键帧。

3 实验 3.1 实验数据库1) 图像数据集。

本文针对用户兴趣,获取不同用户对视频的不同关注点,将每个兴趣语义用多个近似语义描述,并从互联网中检索与近似语义相关的图像组,通过对近似语义模型的联合权重学习得到最终兴趣语义模型,该模型描述信息全面,符合用户个性。本文使用百度图片搜索引擎,每一兴趣语义构建3~5个近义词索引,索引得图像组由200~300张互联网图像构成,使用的检索关键词在表 1中列出。

| 表 1 用户关注点统计 Table 1 List of user' interest |

2) 视频数据集。

现有的大部分视频数据库普遍存在时长短、特例性强等特点,为充分验证本文方法的合理性与有效性,本文从NBA官网、南非世界杯官网和乐视视频网站获取大量视频数据进行测试。其中包含由普通摄像机拍摄,总时长达300 min的4类体育视频与一类事件视频,每类视频由20段时间在1~3 min的视频片段组成。为了更好地分析提取结果,采用二级计分[13]的方式对目标域视频进行关注点标注:首先将原始视频均匀的分割为时长为4 s的视频片段;然后邀请来自不同研究领域(包括语言学、物理学、经济管理学、计算机和设计美学)的15位测试人员对视频进行关注点标记评级,同时记录测试员对视频中感兴趣行为的描述方式。对于任意一段4 s视频段,测试人员可给出0或1两种分数,其中0代表没有兴趣,1代表产生兴趣。结果统计时,同一视频段的不同描述归为同一类兴趣语义,将15位测试人员的评判结果进行统计,分数高于9分的视频段认为存在用户普遍感兴趣的精彩内容。将5类视频关注点信息统计得表 1,其中表格第一列指测试视频类别,第二列指结果统计得出的该视频中兴趣语义个数,第三列指对兴趣语义的不同描述(大括号内为对同一行为的不同描述)。

3.2 实验设置为降低提取结果重复率,本文提取10帧/秒,即一段4 s视频中将提取40帧进行处理。对视频帧及互联网图像分别提取了以下特征:1) 尺度不变特征转换(Scale-Invariant Feature Transform, SIFT)特征[14]和方向梯度直方图(Histogram of Oriented Gradients, HOG)特征[15],通过量化局部特征比较图像与视频帧间的相似性;2) GIST(Generalized Search Trees)特征[16],由于不同用户兴趣关注点不同,视频常常表现为随意且无重点,这时若通过局部特征去识别图像,计算量巨大,因此本文利用GIST特征忽略图像的局部特点,用一种更加“宏观”的方式去描述图像,降低计算复杂度;3) 颜色直方图特征[17],用来描述不同色彩在图像中所占的比例, 将特征融合为4324维特征向量,构建训练集与测试集数据。

考虑到音频信号蕴含丰富的语义,并与视频联系紧密,能有效反映视频内容变化,本文使用音频短时能量特征对视频进行预处理,筛选出能量值高的视频段以提高算法准确率。根据测试人员评分结果选取E=18为短时能量阈值,用于精彩片段筛选。进一步,为尽可能客观地对比不同方法间的结果差异,本文选用平均正确率(Average Precision,AP)、平均正确率均值(mean Average Precision, mAP)和运行时间(Runtime, RT)对算法性能进行评价。

3.3 实验结果1) 视频预处理结果验证。

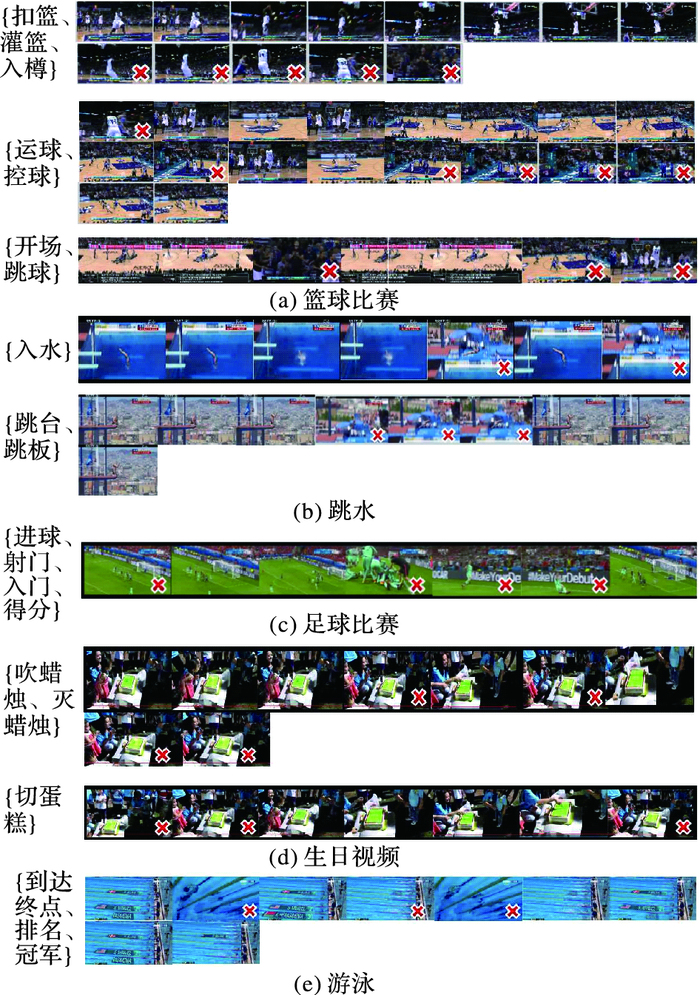

选取视频长度相同的各类视频进行测试,将未使用音频预处理的方法与本文方法(使用音频处理)进行对比。表 2展示了两种方式算法总运行时间(s)和结果mAP(%)对比,其中在计算使用本文方法测试的总运行时间时,将音频处理时间包含在内。图 4给出本文方法的最终提取结果,其中对于每一类视频由上至下依次为该视频不同兴趣语义的提取结果,红叉标记则表示提取错误。由实验结果可看出,采用音频信号指导视频关键信息提取能有效缩减算法运行时间,使用短时能量阈值对视频进行分割能将算法时间缩减76.5%以上,极大程度提高了算法运行效率;同时,使用音频信号指导视频预处理能提高结果准确率,有效排除计算过程中特例干扰,避免在计算过程中由于个别特征点引起分类函数偏移等情况。综上所述,使用音频信号指导视频关键信息提取能有效缩减算法运行时间,同时保证结果准确可靠。

| 表 2 是否对视频使用音频预处理效果对比 Table 2 Comparison results between keyframe extraction with and without audio preprocessing |

|

图 4 使用本文方法提取结果 Figure 4 Results extracted by the proposed method |

2) 近似语义分组训练结果验证。

将对比实验设置为不对兴趣语义进行近似语义的联合权重学习,直接对用户选择的兴趣语义构建索引,从互联网检索获取该语义图像集,根据图像集进行模型训练, 将本文方法与对比实验进行结果mAP对比。由实验结果表 3可以看出,对同一语义进行多个近似语义分组学习将mAP提高了51.5%,多组学习能有效提高结果准确率,适用于不同用户的不同描述。注意到本文方法与对比实验在生日类视频上mAP值相近,仅提高3.1%,这是由于生日类视频对比其他视频可关注信息较少,且用户描述较为统一,近似语义间差异较小,但对比篮球类视频本文方法较对比实验mAP提高了134.6%,这是由于篮球类视频中可关注点较多,且不同用户兴趣差异较大,容易产生不同的兴趣语义描述,进一步说明本文方法针对内容复杂、可关注点较多的视频有较好分类效果。

| 表 3 是否进行近似语义分组学习mAP对比 % Table 3 mAP comparison between keyframe extraction with and without similar semantic group learning % |

3) 与传统关键帧提取方法对比。

本文使用基于关键帧的视频关键信息提取算法框架,下面将本文方法与下列传统关键帧提取法进行对比:

随机选取法 构造随机模拟器,模拟生成多个在[0, 1]服从均匀分布的随机样本点ν,得到随机数rand=ν·(NS·ns),从测试视频中选取对应帧图像作为视频关键信息,该方法不考虑用户需求且不使用图像特征进行训练。

颜色直方图对比法 考虑使用文献[18]提出的基于RGB颜色特征聚类算法,对训练图像和视频帧进行基于颜色特征的聚类,定义4个聚类中心对彩色图像进行迭代聚类,将图像每个像素的R、G和B的值都分成4×4区域,统计直方图颜色信息,并对比测试图像与训练帧间颜色直方图的欧氏距离进行关键信息提取。

特征向量比较法 使用PCA(Principal Component Analysis)算法对本文算法中提取的4324维特征向量(颜色直方图、SIFT、GIST和HOG2x2) 进行降维处理,然后直接计算测试图像与视频帧特征空间的KNN(k-Nearest Neighbor)距离,不采用任何分类函数构建分类器,设定k=4,提取距离较小的视频帧作为视频关键信息。

基于有向无环图的支持向量机分类算法(Directed Acyclic Graph and Support Vector Machine, DAG-SVM)的线性分类法 在获取用户对视频的兴趣语义后,使用Platt等[19]提出的分类算法,针对NS个兴趣语义构造NS(NS-1) 个分类器(节点),所有分类器构成两面有向无环图,当对测试帧进行分类时,从顶部根节点开始逐层细分直到底部叶子节点,每一段视频导入后将根据分类结果对视频帧进行标记提取。

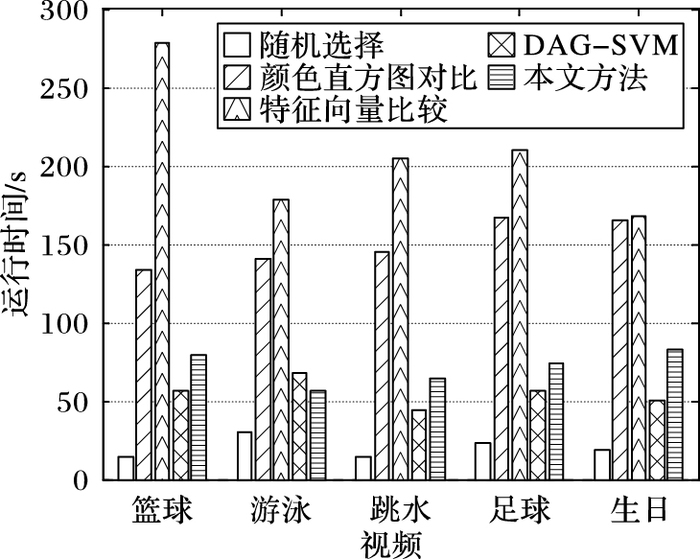

表 4展示了不同关键帧提取方法与本文方法的mAP对比,图 5给出不同算法运行时间。

| 表 4 不同关键帧提取方法的mAP结果对比 % Table 4 Comparison of mAP results by different keyframe extraction methods % |

|

图 5 本文方法与传统关键帧提取方法的运行耗时对比 Figure 5 Comparison of runtime between the proposed method and traditional keyframe extraction methods |

对比DAG-SVM算法和本文方法结果可以看出,同样使用基于支持向量机(Support Vector Machine, SVM)分类的基本思想,本文方法mAP与DAG-SVM相比提高了82.9%,这是由于DAG-SVM仅使用单图像集训练语义模型,没有考虑同一语义有多种近似描述,无法全面获取全部语义信息;颜色直方图对比和特征向量比较法采用蛮力迁移的方式,计算过程中将测试视频帧的每一项特征值与对应训练图像进行对比,耗费大量时间,准确度较差;对于游泳、跳水等内容颜色分布单一、主色调明显的视频,颜色直方图对比算法能有较好表现。

4) 与迁移学习方法对比。

在模型训练阶段本文使用了迁移学习的算法思想,下面将本文方法与下列不同类别的迁移学习算法进行对比:

子空间配准(Domain Adaptation using Subspace Alignment,DA-SA)算法[20] 将测试帧与训练图像看作不同空间上的特征集合,采用构建特征子空间的方式连接两个空间中不同特征,从而对测试帧与训练图像进行相似度比较。

GFK(Geodesic Flow Kernel)核函数法[21] 将源域(训练图像集)和目标域(测试帧集合)的数据在Grassmann流形空间标记并连接,通过核函数最大限度地拟合不同域间的差异,得到与源域数据最相近的目标域视频提取结果。

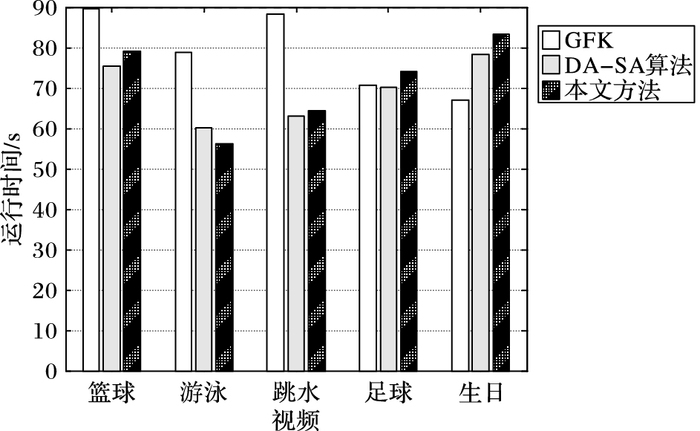

表 5展示了不同种特征迁移方法与本文方法的mAP结果对比,图 6给出不同算法运行时间。由提取结果可看出DA-SA算法和GFK算法在最后结果上表现相似,由于足球视频多采用航拍方式,画面中物体较小,在图像归一化中易将关键信息忽略[22],因此该类视频mAP仅有0.23和0.24。

| 表 5 不同迁移学习算法的mAP结果对比 % Table 5 mAP results of different transfer learning methods % |

|

图 6 本文算法与不同迁移学习方法的运行耗时对比 Figure 6 Comparison of runtime between the proposed method and different transfer learning methods |

本文提出了一种基于用户兴趣的视频关键帧提取框架,根据用户兴趣的不同使用网络图像提供的视觉知识对同一段视频提取相应关键帧。在这个框架下,通过使用同一语义多个近义词在互联网图像搜索引擎中进行检索,将所得到的图像集划分为不同的组。根据不同图像组与视频之间的相关性,通过一种联合优化学习的方法,自动学习各组的权重,从而获得关于用户兴趣语义模型,进一步指导视频关键帧提取。实验结果表明,本文方法不仅能提取高质量的视频关键信息,并且通过用户自主选择能更加合理有效地针对用户兴趣得出结果,提高视频用户对视频浏览的效率。

| [1] | WOLF W H. Key frame selection by motion analysis[C]//Proceedings of the 1996 IEEE Conference on Acoustics, Speech, and Signal Processing. Washington, DC:IEEE Computer Society, 1996:1228-1231. |

| [2] | ZHANG H, WU J, ZHONG D, et al. An integrated system for content-based video retrieval and browsing[J]. Pattern Recognition, 1997, 30(4): 643-658. DOI:10.1016/S0031-3203(96)00109-4 |

| [3] | LU Z, GRAUMAN K. Story-driven summarization for egocentric video[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2013:2714-2721. |

| [4] | YAO T, MEI T, NGO C, et al. Annotation for free:video tagging by mining user search behavior[C]//Proceedings of the 21st ACM International Conference on Multimedia. New York:ACM, 2013:977-986. |

| [5] | EL SAYAD I, MARTINET J, URRUTY T, et al.A semantically significant visual representation for social image retrieval[C]//Proceedings of the 2011 IEEE International Conference on Multimedia and Expo. Washington, DC:IEEE Computer Society, 2011:1-6. |

| [6] | 王晗, 吴心筱, 贾云得. 使用异构互联网图像组的视频标注[J]. 计算机学报, 2013, 36(10): 2062-2069. (WANG H, WU X X, JIA Y D. Video annotation by using heterogeneous multiple image groups on the Web[J]. Chinese Journal of Computers, 2013, 36(10): 2062-2069.) |

| [7] | 王晗. 基于迁移学习的视频标注方法[D]. 北京: 北京理工大学, 2014. (WANG H. Video annotation based on transfer learning[D]. Beijing:Beijing Institute of Technology, 2014.) |

| [8] | WANG H, WU X. Finding event videos via image search engine[C]//Proceedings of the 2015 IEEE International Conference on Data Mining Workshop. Washington, DC:IEEE Computer Society, 2015:1221-1228. |

| [9] | WANG H, WU X, JIA Y. Video Annotation via image groups from the Web[J]. IEEE Transactions on Multimedia, 2014, 16(5): 1282-1291. DOI:10.1109/TMM.2014.2312251 |

| [10] | WANG H, SONG H, WU X, et al. Video annotation by incremental learning from grouped heterogeneous sources[C]//Proceedings of the 12th Asian Conference on Computer Vision. Berlin:Springer, 2014:493-507. |

| [11] | 余春艳, 翁子林. 音频情感感知与视频精彩片段提取[J]. 计算机辅助设计与图形学学报, 2015, 27(10): 1890-1899. (YU C Y, WENG Z L. Audio emotion perception and video highlight extraction[J]. Journal of Computer Aided Design and Computer Graphics, 2015, 27(10): 1890-1899. DOI:10.3969/j.issn.1003-9775.2015.10.011) |

| [12] | ZHANG K, CHAO W, SHA F, et al. Summary transfer:exemplar-based subset selection for video summarization[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2016:1059-1067. |

| [13] | YAO T, MEI T, RUI Y. Highlight detection with pairwise deep ranking for first-person video summarization[C]//Proceedings 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2016:982-990. |

| [14] | LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [15] | HOIEM D, EFROS A, HEBERT M. Recovering surface layout from an image[J]. International Journal of Computer Vision, 2007, 75(1): 151-172. DOI:10.1007/s11263-006-0031-y |

| [16] | OLIVA A, TORRALBA A. Modeling the shape of the scene:a holistic representation of the spatial envelope[J]. International Journal of Computer Vision, 2001, 42(3): 145-175. DOI:10.1023/A:1011139631724 |

| [17] | SWAIN M J, BALLARD D H. Indexing via color histograms[C]//Proceedings of the 3rd International Conference on Computer Vision. Piscataway, NJ:IEEE, 1990:390-393. |

| [18] | MEI T, TANG L, TANG J, et al. Near-lossless semantic video summarization and its applications to video analysis[J]. ACM Transactions on Multimedia Computing, Communications, and Applications, 2013, 9(3): Article No. 16. |

| [19] | PLATT J C, CRISTIANINI N, SHAWE-TAYLOR J. Large margin DAGs for multiclass classification[J]. Advances in Neural Information Processing Systems, 2000, 12(3): 547-553. |

| [20] | FERNANDO B, HABRARD A, SEBBAN M, et al. Unsupervised visual domain adaptation using subspace alignment[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Piscataway, NJ:IEEE, 2013:2960-2967. |

| [21] | GRAUMAN K. Geodesic flow kernel for unsupervised domain adaptation[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2012:2066-2073. |

| [22] | MENG J, WANG H, YUAN J, et al. From keyframes to key objects:video summarization by representative object proposal selection[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ:IEEE, 2016:1039-1048. |