作为公开情报挖掘、大规模人脸数据库建立和跨媒体信息检索等多个领域的支撑技术, 新闻图像中的人脸标注一直是计算机视觉领域中的一个研究热点。其目的是针对有文本描述的新闻图像, 将图像中的人脸用其在文本中的真实姓名作为标签进行标注。

当前, 研究者已提出了一系列人脸标注的方法。FaceBook、Google等互联网公司提出的多种基于深度学习的人脸标注模型[1-3]取得了很好的效果。但是这些模型的训练需要海量的训练数据, 这通常难以获得。为了减少对训练数据的依赖, 主流方法主要通过无监督和弱监督学习的方式进行人脸标注。刘胜宇[4]使用近邻传播(Affinity Propagation, AP)聚类算法[5]对大量待标注人脸进行聚类, 并认为聚类结果中每个类簇中的人脸具有相同的标签, 之后通过分析每个类簇中人脸的候选姓名来确定人脸标签。Luo等[6]2-6将新闻图像中的人脸视为是被多个候选姓名同时标记的数据, 并根据最大边缘准则, 提出了MMS(Maximum Margin Set)算法, 通过最大化人脸被候选姓名标注和被非候选姓名标注时的置信度差异, 来获得人脸标注模型。Zhang等[7]提出基于示例的偏标记学习(Instance-based PArtial Label learning, IPAL)算法, 通过基于人脸间亲密度的标签传播来获得每个人脸的标签。Wang等[8-10]提出了一系列基于检索的人脸标注方法。这些方法将待标注人脸在大规模人脸数据库中进行检索, 并根据返回的最相似的若干张人脸图像的姓名推理出待标注人脸的标签。Chen等[11]1-3采用多信息融合的方式进行人脸标签推理。其首先使用基于检索的方法IM(Image Match)和基于图模型的方法GM(Graph Match)分别得到两种人脸标注结果, 并根据两种结果融合方式的不同, 提出了两种基于信息融合的人脸标注方法:EF-IMGA (Early Fusion of IM and GA method)和LF-IMGA (Later Fusion of IM and GA method)。

可以看出, 现有的方法主要依赖于人脸相似度信息来完成人脸标注。这带来以下两个问题:首先, 在待标注人脸集中常含有大量在文本中不存在真实姓名的噪声人脸[12]7, 这些噪声人脸主要由新闻图像中的背景人物的人脸, 以及被人脸检测器误检为人脸的非人脸物体组成。仅依靠人脸相似度信息很难将噪声人脸和非噪声人脸区分开, 并对噪声人脸和非噪声人脸准确标注。其次, 由于新闻图像中人物的不同表情、光照和姿势等因素带来的视觉空间差异, 人脸相似度可靠性较低[13-14], 即使可以将噪声人脸和非噪声人脸区分开, 仅靠人脸相似度也很难将非噪声人脸标注正确。

然而, 在新闻图像-文本数据集中, 除人脸相似度信息外, 还存在其他一些有助于确定人脸标签的信息。根据Mathialaga等[15]1的研究可知, 在图像中并非所有的人脸都是同等重要的, 通常图像中面积越大的人脸越重要。同样Berg等[16]2-3的研究显示, 当文本中存在多个候选姓名时, 往往越早出现的姓名越重要。受此启发, 本文提出噪声人脸相对于非噪声人脸重要程度较低, 且非噪声人脸和其真实姓名应具有同等重要程度的假设, 并基于该假设提出一种基于多模态信息融合的新闻图像人脸标注(Face Annotation in news images based on Multi-modal Information Fusion, FAMIF)方法, 通过融合多种有助于确定人脸标签的信息来进行人脸标注。FAMIF首先提取出基于人脸相似度的人脸姓名匹配度、人脸重要程度和候选姓名重要程度等多模态信息; 然后训练一个融合上述三种信息的信息融合模型来进行人脸姓名的推理; 最后, 根据同张图像中人脸姓名关系的约束, 提出一种标签修正策略来进一步提高人脸标注效果。实验结果表明, FAMIF相对于仅基于人脸相似度的方法有较好的噪声、非噪声人脸分辨能力, 以及非噪声人脸的标注能力。

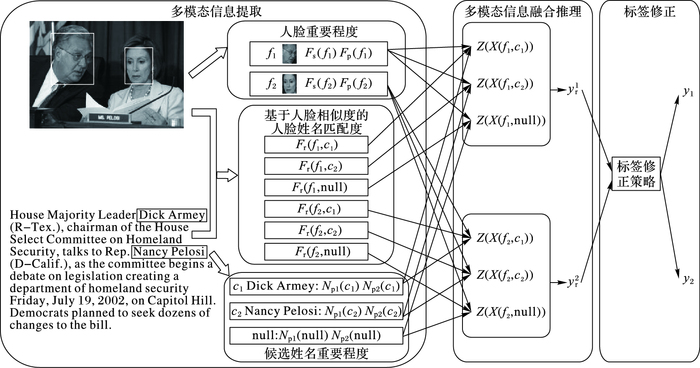

1 基于多模态信息融合的人脸标注方法 1.1 方法框架FAMIF的总体框架如图 1所示。首先在新闻图像中对待标注人脸进行检测和表征, 结果表示为F={f1, f2, …, fi, …, f}, 其中p为图像中待标注人脸总数。同时将从文本中检测出的所有姓名作为F中的每个待标注人脸的候选姓名集, 表示为C={c1, c2, …, c, …, cq, null}, 其中c1, c2, …, cj, …, cq组成了真实候选姓名集Cr, 而null是人为添加的一个标签, 用于标注噪声人脸。其次, 从图像中提取出人脸大小Fs(fi)和人脸位置Fp(fi)用于表征人脸fi的重要程度DF(fi), 并从文本中提取出两种姓名位置信息Np1(cj)和Np2(cj)用于表征候选姓名cj的重要程度DN(cj), 以及基于人脸相似度信息得到fi和cj间的人脸姓名匹配度Fr(fi, cj)。这样待标注人脸-候选姓名对{fi, cj}, 便可以被表征为一个含有多种信息的特征向量X(fi, cj)。之后, 训练一个满足如式(1) 条件的信息融合模型Z:

|

图 1 基于多模态信息融合的新闻图像人脸标注方法框架 Figure 1 Framework of face annotation in news images based on multi-modal information fusion |

| $Z(\mathit{\boldsymbol{X}}({\mathit{\boldsymbol{f}}_i},{n_i})) \ge Z(\mathit{\boldsymbol{X}}({\mathit{\boldsymbol{f}}_i},{c_j}));1 \le i \le p,{c_j} \in C$ | (1) |

其中:ni为fi的真实姓名;Z(X(fi, cj))可以理解为当fi被cj标记时的置信度, 仅当ni=cj时式(1) 等号成立。因此, F的初始标签集Yr={yr1, yr2, …, yri, …, yrp}便可由式(2) 得到:

| $y_{\rm{r}}^i = \arg \mathop {\max }\limits_{{c_j} \in C} (Z(\mathit{\boldsymbol{X}}({\mathit{\boldsymbol{f}}_i},{c_j})));1 \le i \le p$ | (2) |

最后, 根据同张图像上, 除null标签外, 多张人脸不能拥有相同标签这一约束, 提出一个标签修正策略对人脸的初始标签进行修正, 得到最终的人脸标注结果Y={y1, y2, …, yi, …, yp}。

为了表示的方便, 在下文的叙述中当表示某类数据的一般个例时不标注下标, 当有必要表达序号的概念时再标注下标。如“某个待标注人脸”表示为f, “待标注人脸集合中的第i个人脸”表示为fi。

1.2 多模态信息提取 1.2.1 基于人脸相似度的人脸姓名匹配度尽管由于多种因素的影响, 新闻图像中的人脸相似度信息的可靠性较低, 但其仍能为确定人脸标签提供重要的线索。本文利用人脸相似度信息的方式是建立一个基于改进的K近邻(K-Nearest Neighbor, KNN)算法的分类模型来获得人脸姓名匹配度, 并将其作为用于人脸姓名推理的一维信息。

基于KNN的分类方法的传统思路是:假设已知图像中的待标注人脸f和其真实候选姓名集{c1, c2, …, cq}, 以及由其中每个候选姓名的真实人脸样本所组成的训练集T={(f1T, n1T), (f2T, n2T), …, (fT, nT)}(其中,上标T表示训练数据),根据设定的距离度量, 计算训练集中每个样本和f的距离, 并将距离f最近的k个样本点所组成的集合记为Nk(f)。在Nk(f)中根据分类决策规则(如多数表决), 决定f的标签y:

| $y = \arg \mathop {\max }\limits_{{c_j} \in C} \left( {\sum\limits_{\left| i \right|f_i^{\rm{T}} \in {N_k}\left. {\left( \mathit{\boldsymbol{f}} \right)} \right|} {I(n_{_i}^T = {c_j})} } \right)$ | (3) |

其中:I为示性函数, 即当niT=cj时, I=1;否则I=0。

将基于KNN的分类方法用于新闻图像中的人脸标注, 面临的首要问题是如何获得每个真实候选姓名足够的真实人脸样本以组成训练集。为了解决这个问题, 本文基于文献[17]中的一个假设来从输入的数据集中获得训练样本, 该假设的内容为:对于一个由多个新闻图像-文本数据组成的数据集, 在候选姓名集含有c的所有人脸中, 属于c的真实人脸相对于其他候选姓名占有最大的比例。以候选姓名c为例, 获得训练样本的具体过程为首先在数据集中找出候选姓名集中含有c的所有人脸, 并记这些人脸组成的集合为c的相关人脸集。之后在c的相关人脸集中使用AP聚类算法对人脸进行聚类, 将最大的人脸类簇作为c的训练样本。之所以使用AP聚类算法进行人脸聚类, 是因为事先不知道每个候选姓名的相关人脸集中含有多少个候选姓名的人脸, 无法确定应该将相关人脸集聚为几类, 而AP聚类的特点就是不需要预先指定类别数量。

至此, 可以为每个候选姓名获得一定数量的训练样本。但因为每个候选姓名在数据集中出现的次数不同, 不同候选姓名的训练样本数量相差较大, 这会使得人脸被倾向于识别为训练样本较多的候选姓名的人脸。为了克服该困难, 首先对不同候选姓名的训练样本数量进行均衡处理:对于训练样本少于20个的候选姓名, 通过SMOTE(Synthetic Minority Over-sampling TEchnique)算法[18]为每个候选姓名生成若干人工样本数据, 将其训练样本数量补充至20个。之后, 在对人脸f进行识别的过程中, 若在f的真实候选姓名集Cr中cj的训练样本数量最少且为s, 则对Cr={c1, c2, …, cq}中每个候选姓名的样本根据随机采样的方式, 将其训练样本数量降至s。

在对不同的人脸计算其和候选姓名的匹配度时, 用到的训练样本数量也可能不一致。为了根据不同的训练样本数量自适应地调整KNN算法中的参数k的取值, 本文将其定义如式(4) 所示:

| $k = {\rm{round}}(\alpha \cdot s){\kern 1pt} ;\alpha \in [0.05,1]$ | (4) |

其中:round为四舍五入取整函数; s为识别时每个真实候选姓名用到的训练样本数; α为一个取值范围为[0.05, 1]的系数。

确定了训练样本和k的取值后, 在计算f和标签c∈C之间的匹配度Fr(f, c)时, 为了同时涵盖Nk(f)中属于c的样本点的个数和这些样本点距f的距离信息, 本文将Fr(f, c)定义如式(5) :

| $\begin{array}{l} \quad {F_r}(\mathit{\boldsymbol{f}},c) = \\ 2{\pi ^{ - 1}}\arctan (\sum\limits_{\left| i \right|\mathit{\boldsymbol{f}}_i^{\rm{T}} \in {N_k}\left. {\left( \mathit{\boldsymbol{f}} \right)} \right|} {(1 - d(\mathit{\boldsymbol{f}}_i^{\rm{T}}} ,\mathit{\boldsymbol{f}})) \cdot {\omega _i} \cdot I(n_{_i}^T = c)) \end{array}$ | (5) |

其中:ωi为该距离的权重, 距离越小, 权重越大, ωi=1/d(fiT, f); d(fiT, f)为训练集中的样本点fiT到待标注人脸f的距离, 并被归一化至[0, 1]。为了使获得的Fr(f, c)的值域为[0, 1], 使用2π-1 arctan(·)对括号内的数值进行非线性变换。而对于待标注人脸f和标签null的匹配度, 本文采用类似于文献[19]方法, 将其视为一种信息不确定问题。当f和每个真实候选姓名的匹配度之间具有明显差异时, f的标签最有可能是匹配度最高的候选姓名。而当f和每个真实候选姓名的匹配度之间越接近, f的标签也越不确定, 而此时f的标签为null的可能性也在增加, 因此可使用标准化的信息熵的相反数来描述f的标签是null的匹配度:

| ${F_{\rm{r}}}(\mathit{\boldsymbol{f}},{\rm{null}}) = \frac{1}{{1{\rm{b}}\;q}}\sum\limits_{c \in {C_{\rm{r}}}} {{F_{\rm{r}}}(\mathit{\boldsymbol{f}},c)\;1{\rm{b}}\;{F_{\rm{r}}}(\mathit{\boldsymbol{f}},c)} $ | (6) |

其中:q为f真实候选姓名的个数, 而将Fr(f, null)定义为负数的目的是令其和f标签为真实候选姓名的匹配度加以区分。在实验部分, 本文采用欧氏距离作为距离度量, 同时将k取值公式中的系数α根据经验设为0.2。

1.2.2 人脸重要程度在拍摄图像时, 摄影师一般会更加靠近重点人物进行拍摄, 所以在新闻图像中, 面积较大的人脸通常更加重要, 其姓名出现在文本中的可能性也更大。在文献[15]中, 人脸大小信息的表征形式是能框住人脸的最小矩形(Bounding box)面积占图像面积的比例。然而这种表征方式只涵盖了每个人脸相对于所在图像的大小, 却不能涵盖该人脸相对于同一图像中其他人脸在面积上的“突出”程度。为能同时涵盖上述的两方面的信息, 本文将人脸f的人脸大小Fs(f)定义如式(7) 所示:

| ${F_{\rm{s}}}(\mathit{\boldsymbol{f}}) = {F_{\rm{a}}}(\mathit{\boldsymbol{f}}) + \sum\limits_{{\mathit{\boldsymbol{f}}_i} \in F} {\left( {{F_{\rm{a}}}(\mathit{\boldsymbol{f}}) - {F_{\rm{a}}}({\mathit{\boldsymbol{f}}_i})} \right)} $ | (7) |

其中:Fa(fi)和Fa(f)分别为第i张人脸和人脸f的实际面积比上图像中所有人脸面积总和后得到的归一化人脸面积值。

此外, 当摄影师拍摄照片时, 也通常会将重要人物的人脸置于靠近图像中央的位置。因此本文也将人脸在图像中的位置作为度量人脸重要程度的因素之一。为了提取出人脸f的位置信息, 本文首先计算f的Bounding box的中心到图像中心的欧氏距离Frp(f), 之后通过除所有人脸距离之和, 将其归一化为Fnp(f)。类似于人脸大小信息, 为了涵盖f相对于同一图像中其他人脸在位置上的“突出”程度, 将f的人脸位置Fp(f)定义如式(8) 所示:

| ${F_{\rm{p}}}(\mathit{\boldsymbol{f}}) = {F_{{\rm{np}}}}(\mathit{\boldsymbol{f}}) + \sum\limits_{{\mathit{\boldsymbol{f}}_i} \in F} {\left( {{F_{{\rm{np}}}}(\mathit{\boldsymbol{f}}) - {F_{{\rm{np}}}}({\mathit{\boldsymbol{f}}_i})} \right)} $ | (8) |

其中:

在获得人脸大小信息和人脸位置信息后, 人脸f的重要程度DF(f)便可表示为二者的组合, 即DF(f)=(Fs(f), Fp(f))。

1.2.3 姓名重要程度文本中不同的候选姓名通常具有不同的重要程度。Berg等[16]5的研究表明, 姓名出现在文本中的位置对姓名重要性的影响占主要地位。在文献[16]中, 候选姓名c的位置信息Np(c)定义如式(9) :

| ${N_p}(c) = L(c)/L(caption)$ | (9) |

其中:L(c)为从文本开端至c第一次出现位置的文本长度;L(caption)为文本的总长度。虽然这种定义能准确地反映候选姓名在文本中出现的位置, 但却无法反映不同候选姓名出现的先后次序。因此, 本文同时采用两种姓名位置的定义方式。第一种定义方式和式(9) 一致(Np1(c)), 第二种方式为不同候选姓名第一次出现在文本中的次序(Np2(c))。

对于null, 因为其并不出现在文本之中, Np1(null)和Np2(null)是没有意义的。但是为了能够在同一模型下完成对所有人脸的标注, 同时能够和真实候选姓名的位置值区分开, 本文将Np1(null)定义为2, 将Np2(null)定义为20, 均远大于数据集中任一个真实候选姓名的姓名位置值。在获得两种姓名位置信息后, 候选姓名c的重要程度DN(c)便可表示为二者的组合, 即DN(c)=(Np1(c), Np2(c))。

1.3 人脸标签推理及修正 1.3.1 基于多模态信息融合的人脸标签推理在获得人脸姓名匹配度、人脸重要程度和姓名重要程度三种信息之后, 待标注人脸-候选姓名对{f, c}便可表示为X(f, c)=(Fr(f), Fs(f), Fp(f), Np1(c), Np2(c))。接下来, 如何获得信息融合模型Z来融合这些信息以完成人脸标签推理成为关键。鉴于本文所利用的信息种类较多, 很难凭借先验知识和人的主观经验来设计融合方法, 故采用学习的方式来获得模型Z。本文将1.2.1节中获得的候选姓名的训练样本视为已标记数据, 并利用其产生Z的训练数据, 具体过程为:对于姓名n的某个人脸样本f T, 令其和其候选姓名集C中的每个候选姓名组成一个待标注人脸-姓名数据, 进而可得到{X{f T, c}|c∈C}。对于其中的每个数据, 当n=c时将其标记为1, 否则标记为0。这样, 便可以获得一部分有标记数据用于训练模型Z。

在现有的各种学习算法中, 神经网络具有泛化能力强、稳定性高、容错性好、快速高效等优势。因此, 为保证多种信息的合理融合, 本文将多模态信息融合问题转化为回归问题, 通过训练一个5×h×1结构的反向传播(Back Propagation, BP)神经网络来得到模型Z, 其中h为隐藏层节点数。在获得模型Z之后, 待标注人脸的初始标签便可根据式(2) 获得。BP模型的具体训练和测试过程见2.3节。

1.3.2 标注结果修正在由1.3.1节得到的结果中, 会出现这样的情况:部分在同一张图像上出现的不同人脸被相同的标签标注。而现实中, 同一图像上多张人脸属于同一人物的情况在新闻图像中几乎不存在[17]3。因此, 有必要对由1.3.1节得到的结果进行修正, 消除同一张图像上不同人脸被标注相同姓名的情况。本文采用的修正策略如算法1所示。

算法1 标签修正算法。

输入 一张图像上的所有的待标注人脸-候选姓名置信度{Z(X(fi, cj))|1≤i≤p, 1≤j≤q+1}, 初始标注结果Yr={yr1, yr2, …, yrp}。

输出 最终标注结果Y={y1, y2, …, yp}。

for i=1 to p do

Ci={ j|1≤j≤q+1}

end for

for i=1 to p do

for m=1 to p do

if (yri= yrm≠q+1) & & (i≠m) then

if Z(X(fi, yri))>Z(X(fm, yrm)) then

yri= yri

y′=yrm

Cm=Cm\y′

else

yrm= yrm

y′=yri

Ci=Ci\y′

end if

end if

end for

end for

Y=Yr

其中: p为图像中待标注人脸数量;q为文本中真实候选姓名数量;第q+1个候选姓名为null; C*为f*的候选标签集合。

2 实验和结果分析 2.1 实验环境、数据集和评价指标实验在CPU为intel i7-6700, 3.4 GHz, 内存为8 GB的计算机上, 使用Matlab2016a完成。实验所使用的数据集为Label Yahoo! News。其最初是由Berg等[16]6从50万张Yahoo新闻图像中收集得到, 后又被Guillaumin等[12]7进行了进一步的处理。数据集中的人脸含有丰富的光照、表情、姿势等因素的变化。数据集中含有20 071个新闻图像-文本数据, 以及从这些数据中提取出的5 876个候选姓名, 31 147个待标注人脸;同时数据集中还包含了待标注人脸的Bounding box在图像的位置, 以及人脸的4 992维尺度不变特征变换(Scale-Invariant Feature Transform,SIFT)特征向量。在实验过程中, 为了在尽可能在人脸特征信息不过分丢失的情况下降低计算开销, 本文通过使用主成分分析(Principal Component Analysis, PCA)算法, 将人脸特征维度降至300维。

与文献[6]中的预处理方法一致,本文从候选姓名中选择出那些重复超过20次的姓名, 共计214个, 并将其余的候选姓名视为null标签, 同时删除了候选姓名中不包含这214个姓名的图像。处理后的数据集的具体信息如表 1所示。其中, 非噪声人脸比例是数据集中归属于这214个姓名的人脸占所有人脸的比例。可以看出, 数据集中非噪声人脸比例仅为56%, 剩下的44%的人脸均为噪声人脸。

| 表 1 处理后的Label Yahoo!News数据集的详细信息 Table 1 Details of processed Label Yahoo! News dataset |

测试时, FAMIF对数据集中的所有人脸进行标注。为了对标注性能进行评价, 与文献[11]3一致, 本文采用三种评价指标来衡量人脸标注的性能, 即准确率(Accuracy)、精度(Precision), 以及召回率(Recall)。其中, 准确率为数据集中被正确标注的人脸占所有人脸的比例, 反映标注方法的整体性能; 精度为被非null标签标记的人脸中, 被正确标记的人脸所占的比例, 较高的精度说明标注方法对噪声人脸的标注效果较好; 召回率为非噪声人脸中, 被正确标记的人脸所占比例, 反映了标注方法对非噪声人脸的标注效果。当精度和召回率都较高时, 能够说明标注方法区分噪声和非噪声的能力较强。

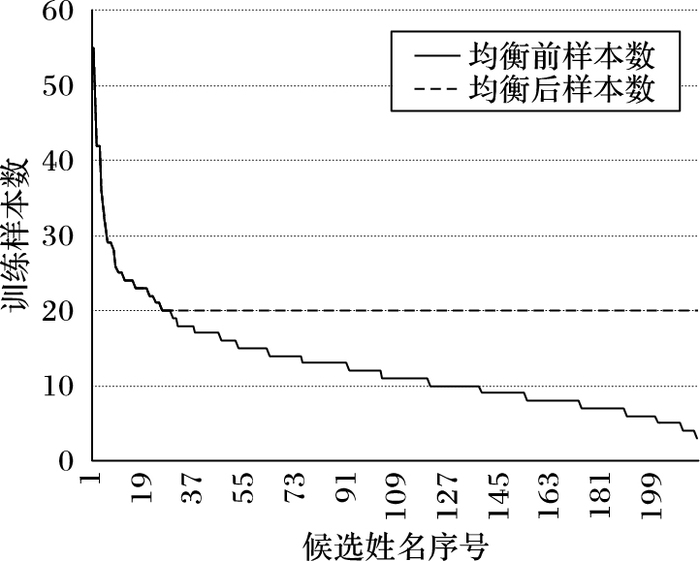

2.2 多模态信息提取结果分析在根据1.2.1节中所提方法获得的训练集中, 每个候选姓名的训练样本数量的分布如图 2所示。可以看出, 在进行样本数量均衡之前, 不同候选姓名的训练样本数量之间差异较大。但在经过均衡处理后, 大部分的候选姓名的训练样本数量都较为平衡。

|

图 2 候选姓名的训练样本数量分布 Figure 2 Distribution of training sample number of candidate names |

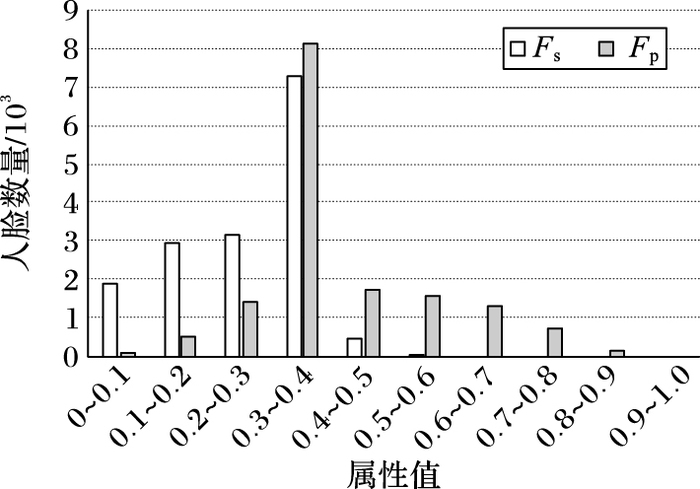

1.2.2节中提取的人脸大小和人脸位置的分布如图 3所示。为了方便绘图和分析, 在图 3中Fs和Fp均被线性缩放至[0, 1]。由图 3可以发现数据集图像中的人脸有很大一部分相对偏小, 而这一点与数据集中含有高达44%的噪声人脸, 即“不重要的”人脸的情况相符, 这间接地反映了用人脸大小来衡量人脸重要性是合理的。然而Fp的分布却没有呈现出大量人脸远离图像中心的情况, 这反映了Fp衡量人脸重要程度的能力较Fs弱。

|

图 3 人脸大小和位置分布情况 Figure 3 Distributions of face size and face position |

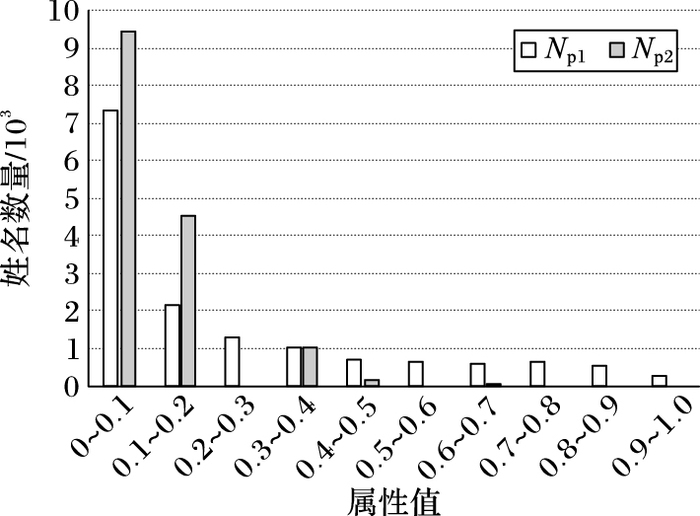

图 4显示了两种候选姓名位置的分布情况。和图 3类似, Np1和Np2均被线性缩放至[0, 1]。可以看出, 尽管Np1和Np2大致分布相同, 但仍具有一定差异, 说明两者的同时使用可以更加详细地描述候选姓名在文本中的位置。此外, 数据集中大部分文本中检测出的候选姓名的数目都在3个以内。而文本中最多出现7个候选姓名, 因此选择将Np2(null)定义为20能够和真实候选姓名的位置区分开。

|

图 4 姓名位置分布情况 Figure 4 Distribution of name position |

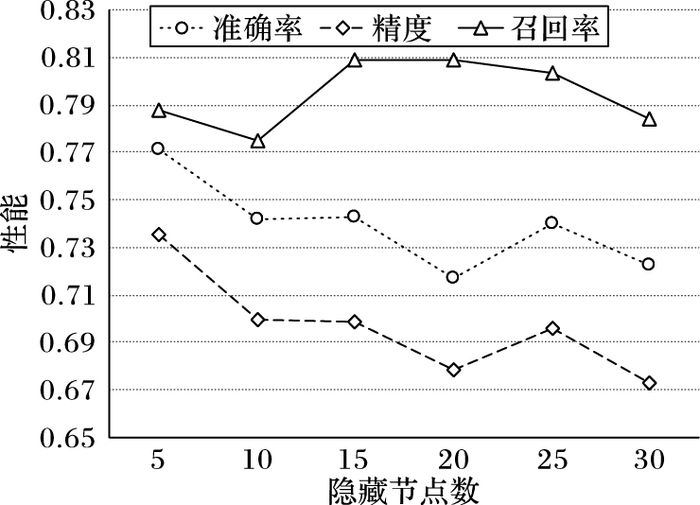

为了对模型Z进行训练, 需根据1.3.1节中的方法, 利用1.2.1节中获得的候选姓名的训练样本来得到模型Z的训练数据。而1.2.1节中, 根据聚类方法获得的每个候选姓名的训练样本里可能含有少量的错误样本。通常情况下, 在数据集中出现次数较多的候选姓名, 其真实人脸数量也通常较多, 因而通过聚类能获得较多的训练样本, 且错误样本所占比例也较低。因此, 为了在能够得到足够的训练数据的同时防止训练数据中含有过多的错误, 本文选择样本数超过30的候选姓名的训练样本共计207个, 将其视为已标记的非噪声人脸样本。此外, 待标注人脸集中含有大量的噪声人脸, 为了使训练数据的分布尽可能接近真实情况, 根据噪声人脸通常具有较小面积的假设, 将数据集中面积最小的207个人脸视为噪声人脸。利用这共计414个人脸样本来生成Z的训练数据, 最终共得到910个训练数据, 其中标记为1的训练数据和标记为0的训练数据各430、480个。在训练神经网络时, 选择Sigmoid函数作为隐藏层和输出层的激活函数, 选择Levenberg-Marquardt算法[20]作为训练算法。为确定隐藏层神经元节点的个数, 在隐藏层设置不同的神经元数量进行训练和测试, 人脸标注的性能随隐藏层神经元个数变化的趋势如图 5所示。可以看出, 当隐藏层神经元的个数为5时达到了最好的效果, 这说明当训练数据较少时, 节点数的增加会导致模型容易出现过拟合, 进而降低其泛化能力。因此将隐藏层节点数设为5, 即h=5。

|

图 5 人脸标注性能随隐藏层神经元个数变化趋势 Figure 5 Tendency of face labeling performances with the number of neurons in hidden layer increasing |

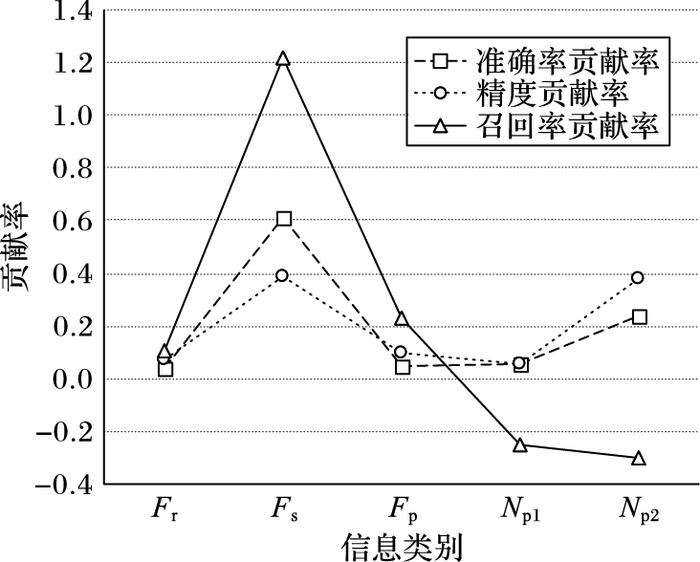

为了分析不同的信息对标注结果的影响, 定义了一个新的评价指标贡献率(Ct):

| ${C_{\rm{t}}}({x_i}) = \frac{{M(\mathit{\boldsymbol{X}} \sim \exp ({x_i}))}}{{\sum\limits_{j = 1}^5 {\left( {M(\mathit{\boldsymbol{X}}) - M(\mathit{\boldsymbol{X}} \sim \exp ({x_j})} \right)} }}$ | (10) |

其中:xi为X(f, c)中第i个信息;X~exp(xi)表示X(f, c)中xi缺省后剩下的数据;M表示准确率、精度或召回率中的某一评价指标,M(X)和M(X~exp(xi))分别表示当输入信息为X(f, c)和X~exp(xi)时在该评价指标上的性能。具体结果如图 6所示。

|

图 6 不同信息的贡献率 Figure 6 Contribution rates of different information |

可以发现, Fr、Fs和Fp对三个指标都有提升作用, 说明这三种信息既有助于噪声人脸和非噪声人脸的区分, 也有助于确定非噪声人脸的标签, 而且Fs的效果尤其明显。而Np1和Np2在提升了人脸标注的准确率和精度的同时降低了召回率, 这反映了这两种信息的引入使得部分非噪声人脸被倾向于判定为噪声人脸, 从而导致召回率下降。但精度和准确率的提升说明这两种信息有助于噪声人脸的标注, 弥补了其对非噪声人脸标注的不良影响, 进而在整体上提高了标注的效果。综上, 可以得出结论, 在采用的多信息融合方法下, 提取的多种信息均有助于人脸标注。

为了进一步分析FAMIF的性能, 将其和近年来提出的几种基于人脸相似度信息的基准算法进行比较, 结果如表 2所示。所有算法的性能均在处理后的Label Yahoo!News数据集上取得。表 2中每个指标的第一名使用粗体进行标识, 可以看出, 相对于基准算法, FAMIF在准确率和召回率上取得了最好的效果。这说明当新闻图像中存在大量噪声人脸时, FAMIF通过利用多种模态信息的融合推理, 综合了各信息对确定人脸标签的有效作用, 可以较好地完成对非噪声人脸的标注, 且整体标注效果优于基准算法。尽管相对于EF-IMGA、LF-IMGA和IPAL, FAMIF的精度指标不够理想, 但从这三种方法的精度和召回率的巨大差异可知, 这三种方法将大量的非噪声人脸标记为null, 区分噪声和非噪声人脸的能力较差。而FAMIF在并未过分牺牲精度的情况下, 准确率和召回率较大幅度地优于基准算法, 说明FAMIF区分噪声和非噪声人脸的能力高于基准算法。

| 表 2 FAMIF和基准方法标注效果比较 % Table 2 Comparison of labeling results between FAMIF and benchmark methods % |

本文提出了一种基于多模态信息的新闻图像中人脸标注方法。通过充分挖掘图像中的人脸大小和位置信息、文本中的姓名位置信息, 建立了人脸和姓名重要程度之间的对应关系, 克服了现有方法过度依赖人脸相似度信息的不足。实验结果表明多模态信息对确定新闻图像中人脸的标签有着极其重要的作用。后续研究中将继续挖掘图像和文本中可能有助于确定人脸标签的信息, 如人脸、图像的聚焦点等, 进一步提高人脸标注准确率。

| [1] | TAIGMAN Y, YANG M, RANZATO M, et al. DeepFace: closing the gap to human-level performance in face verification [C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2014: 1701-1708. |

| [2] | SCHROFF F, KALENICHENKO D, PHILBIN J. FaceNet: a unified embedding for face recognition and clustering [C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015: 815-823. |

| [3] | OUYANG W, LOY C C, TANG X, et al. DeepID-Net: deformable deep convolutional neural networks for object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 46(5): 2403-2412. |

| [4] | 刘胜宇. 网络新闻图像中人脸标注技术研究[D]. 哈尔滨: 哈尔滨工业大学, 2011: 33-40. (LIU S Y. Research on annotation technology of face images in network news [D]. Harbin: Harbin Institute of Technology, 2011: 33-40.) http://cdmd.cnki.com.cn/Article/CDMD-10213-1012000862.htm |

| [5] | FREY B J, DUECK D. Clustering by passing messages between data points[J]. Science, 2007, 315(5814): 972. DOI:10.1126/science.1136800 |

| [6] | LUO J, ORABONA F. Learning from candidate labeling sets [C]//NIPS 2010: Proceedings of the 23rd International Conference on Neural Information Processing Systems. New York: Curran Associates, 2010: 1504-1512. |

| [7] | ZHANG M L, YU F. Solving the partial label learning problem: an instance-based approach [C]//Proceedings of the 2015 International Conference on Artificial Intelligence. Menlo Park: AAAI Press, 2015: 4048-4054. |

| [8] | WANG D, HOI S C H, HE Y. A unified learning framework for auto face annotation by mining Web facial images [C]//Proceedings of the 2012 ACM International Conference on Information and Knowledge Management. New York: ACM, 2012: 1392-1401. |

| [9] | WANG D, HOI S C H, HE Y, et al. Retrieval-based face annotation by weak label regularized local coordinate coding[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(3): 550-63. DOI:10.1109/TPAMI.2013.145 |

| [10] | WANG D, HOI S C H, HE Y, et al. Mining weakly labeled Web facial images for search-based face annotation[J]. IEEE Transactions on Knowledge & Data Engineering, 2012, 26(1): 166-179. |

| [11] | CHEN Z, FENG B, NGO C W, et al. Improving automatic name-face association using celebrity images on the Web [C]//Proceedings of the 2015 International Conference on Multimedia Retrieval. New York: ACM, 2015: 623-626. |

| [12] | GUILLAUMIN M, VERBEEK J, SCHMID C. Multiple instance metric learning from automatically labeled bags of faces [C]//Proceedings of the 2010 European Conference on Computer Vision. Berlin: Springer, 2010: 634-647. |

| [13] | XIAO S, TAN M, XU D. Weighted block-sparse low rank representation for face clustering in videos[C]//Proceedings of the 2014 European Conference on Computer Vision. Berlin: Springer, 2014: 123-138. |

| [14] | XIAO S, XU D, WU J. Automatic face naming by learning discriminative affinity matrices from weakly labeled images[J]. IEEE Transactions on Neural Networks & Learning Systems, 2015, 26(10): 2440-2452. |

| [15] | MATHIALAGAN C S, GALLAGHER A C, BATRA D. VIP: finding important people in images [C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2015: 4858-4866. |

| [16] | BERG T L, BERG A C, EDWARDS J, et al. Names and faces in the news [C]//CVPR 2004: Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2004: 848-854. |

| [17] | GUILLAUMIN M, MENSINK T, VERBEEK J, et al. Face recognition from caption-based supervision[J]. International Journal of Computer Vision, 2012, 96(1): 64. DOI:10.1007/s11263-011-0447-x |

| [18] | CHAWLA N V, BOWYER K W, HALL L O, et al. SMOTE: synthetic minority over-sampling technique[J]. Journal of Artificial Intelligence Research, 2002, 16(1): 321-357. |

| [19] | PANG L, NGO C W. Unsupervised celebrity face naming in Web videos[J]. IEEE Transactions on Multimedia, 2015, 17(6): 854-866. DOI:10.1109/TMM.2015.2419452 |

| [20] | MARQUARDT D W. An algorithm for least-squares estimation of nonlinear parameters[J]. Journal of the Society for Industrial & Applied Mathematics, 2006, 11(2): 431-441. |