ZHANG Gengning, born in 1991, M. S. candidate. His research interests include person re-identification, computer vision

WANG Jiabao, born in 1985, Ph. D., lecturer. His research interests include machine learning, computer vision

LI Yang, born in 1984, Ph. D. candidate, lecturer. His research interests include machine learning, computer vision

MIAO Zhuang, born in 1976, Ph D., associate professor. His research interests include intelligent information processing

ZHANG Yafei, born in 1955, Ph. D., professor. His research interests include artificial intelligence

LI Hang, born in 1983, Ph. D. candidate. His research interests include computer vision

近年来,随着监控设备在公共场所的逐渐增多,行人重识别技术越来越受到人们的关注。行人重识别的定义为从跨摄像机、跨时间段的行人图像数据库中找出与检索行人一致匹配的人物[1]。但是由于光照、摄像机位置、行人姿势变化等问题,同一行人在不同图像之间会出现较大的差异,这给行人重识别研究带来巨大的困难和挑战。

当前,行人重识别研究方法大致可分为两类:基于特征描述的方法和基于度量学习的方法。基于特征描述的方法侧重于通过寻找对视角变化鲁棒的特征来提高行人重识别精度。早期Gray等[2]采用AdaBoost方法从大量颜色、纹理特征中挑选出更具描述力的特征来改进效果,但是该方法无法解决视角变换问题。Kai等[3]放弃使用全局特征描述,改用局部的尺度不变特征变换(Scale-Invariant Feature Transform, SIFT)来表示行人,但是局部特征点经常会落在嘈杂的背景上,导致精度的下降。Farenzena等[4]提出了一种局部特征对称驱动累积(Symmetry-Driven Accumulation of Local Features, SDALF)方法,该方法通过行人对称属性减少背景干扰来提升对视角变换的鲁棒性。此外,Bazzani等[5]对具有相似颜色的像素区域进行聚类,将行人图像划分成最大颜色稳定区域(Maximally Stable Color Regions, MSCR),并使用这些区域的类中心、二阶距矩阵和颜色均值来描述行人。与全局特征描述相比,基于局部区域的特征描述具有更好的视角变化鲁棒性。

基于度量学习的方法侧重于从训练数据中学习出一种鲁棒的度量方法来解决复杂的匹配问题。2008年Zheng等[6]提出概率相对距离比较(Probabilistic Relative Distance Comparison, PRDC)算法,其基本思想是增大正确匹配之间拥有较短距离的可能性,使算法对行人外观变化鲁棒。之后,Pedagadi等[7]采用局部Fisher判别分析(Local Fisher Discriminant Analysis, LFDA)方法进行行人重识别度量学习,但是LFDA需要对高维散列矩阵进行主成分分析(Principal Component Analysis, PCA)降维,降低了特征的表达能力。Xiong等[8]在LFDA的基础上使用了核技巧,提出了核局部Fisher判别分析(kernel Local Fisher Discriminant Analysis, kLDFA)算法,可避免求解高维的散列矩阵,既减少了运算量,又提高了行人重识别的准确率。

针对当前研究进展,本文在行人重识别的特征提取与度量学习上分别作出了改进:在特征提取方面,基于特征融合的思想[9],将颜色标签(Color Name, CN)特征[10]与现有的颜色和纹理特征进行融合,并通过合并区域块直方图来提取行人特征;在度量学习方面,首先对特征进行区域分组处理,然后进行kLDFA求解出各特征组的映射矩阵,最后采用查询自适应得分融合(Query-Adaptive Late Fusion, QALF)方法[11]来兼顾不同查询图像的差异。在VIPeR和iLIDS这两个数据集上,实验结果表明本文改进的特征提取方法和度量学习方法均能有效提升行人重识别的精度。

1 特征提取 1.1 特征选择由于基于局部区域划分的特征描述被验证具有较好的描述能力,故本文在区域划分的基础上,将CN特征与现有的HSV颜色特征,尺度不变局部三元模式(Scale Invariant Local Ternary Pattern, SILTP)纹理特征[12]进行融合,得到更加鲁棒的行人图像特征描述。

CN特征是人们对生活中出现的颜色赋予的一种语义标签,对应于Berlin等[13]在语言研究中总结的11个基本颜色词:黑色、蓝色、棕色、灰色、绿色、橙色、粉红色、紫色、红色、白色和黄色。由于不同光照下的同一颜色会依概率映射到对应的颜色词上,所以CN特征具有一定的光照不变性,且被认为与现实中的颜色具有非常紧密的联系。该特征具备较强的颜色表达能力,在目标分类领域已经得到了较好的应用[10]。

在计算CN特征时,需要对图像像素点完成一个从RGB颜色空间到CN各颜色词的概率映射,映射矩阵M为常数。映射过后,CN特征描述子的定义如下:

| ${O_{{\rm{CN}}}} = \left\{ {p\left( {c{n_1}\left| x \right.} \right),p\left( {c{n_2}\left| x \right.} \right),\cdots ,p\left( {c{n_{11}}\left| x \right.} \right)} \right\}$ | (1) |

其中x为像素点的值,p(cni|x)表示属于第i个颜色词的概率值,且:

| $\sum\limits_{i = 1}^{11} {p\left( {c{n_i}\left| x \right.} \right) = 1} $ | (2) |

传统的矩阵M是由人工标注的一系列颜色片段学习获得的,但是这种学习方法存在着大量的主观因素,因此在文献[14]中使用概率潜在语义分析(Probabilistic Latent Semantic Analysis, PLSA)模型从大量的谷歌图片中自动学习获得映射矩阵,并通过实验比较得出比传统方法学习出来的映射矩阵具有更加良好的性能,所以在本文中使用的映射矩阵M即是文献[14]中学习获得的矩阵。

HSV是一种基于色调(Hue)、饱和度(Saturation)和亮度(Value)的颜色模型,HSV颜色空间的色彩与人的视觉感知基本一致。

SILTP[12]是对局部二值模式(Local Binary Pattern, LBP)特征的改进,LBP计算简单且具有良好的尺度不变性,但是对于图像噪声非常敏感,SILTP通过多次比较的方式对LBP进行改进,使得SILTP既具有LBP的尺度不变性又对图像噪声鲁棒。

1.2 直方图提取特征选择后,即可对行人图像进行区域划分以及块直方图的提取。经过参考文献[8]中的参数及实验验证,本文提取特征的具体步骤如下:

步骤1 区域划分。每张行人图像统一缩放至128×48像素大小,按照区域大小为10×48像素,步长为5像素将图像水平分割成有重叠部分24个区域,其中最后一次步长为8。

步骤2 块划分。对每一个区域使用大小为10×10像素,步长为5像素将每个区域分割成有重叠的8个块,其中最后一次步长为8。

步骤3 直方图提取。对每一个块提取CN、HSV和SILTP特征直方图。CN特征中,每个词分成25bin,11个词通过相加获得275bin,所有像素以每个词的概率投票至对应的bin中,最终获得275维的CN特征直方图;HSV特征中,三个通道每个通道分为8个bin,通过相乘获得512维的颜色直方图;SILTP特征选取SILTP4, 30.3和SILTP4, 40.3两个尺度,获得162维的纹理直方图[12]。

步骤4 直方图合并。各特征提取后,每个块直方图的维度为275+512+162=949维。通过对应维度值相加,把每个区域中的8个949维的直方图合并成1个。至此,每个区域对应一个949维的直方图。

考虑到多尺度下能更好地描述图像,本文将128×48像素的图像进行2×2像素缩放,得到64×24像素和32×12像素两个尺度。依照前述步骤进行了区域划分以及直方图提取,在64×24尺度下可得到11个区域,在32×12尺度下可得到5个区域,每个区域对应一个949维的直方图。

经过上述操作后,提取出来每一幅图像的特征维度为(24+11+5)×949=37 960维。

最后,对特征进行log变换和归一化操作获得最终所需要的图像特征,其中log变换是为了降低某个维度较大的数值特征的影响。

2 度量学习行人重识别时,不同的查询样本都有着各自的特点,如图 1所示:左边行人,其中间部分区分性好,故中间部分提取的特征应该增加权重;中间行人,其黑色上衣是很常见,所以对应部分的特征应该降低权重;右边行人,其头上戴着帽子,相比前两张查询图片,头部部分的特征的权重应该增加。由此可看出,每个查询图像应具有不同的部分权值,以提高查询的精度。

|

图 1 不同的行人图像 |

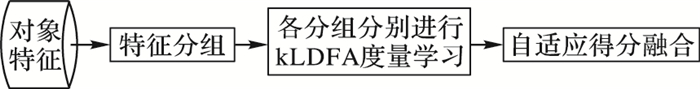

在度量学习中,kLDFA是对于所有查询样本学习出来的映射矩阵,在检索时无法保证前述的特性。因此,本文在kLDFA的基础上,提出了一种查询自适应的度量学习方法,主要过程见图 2。该方法先把提取到的特征按2.1节所示进行分组,然后对每一组特征分别进行kLDFA度量学习得到映射矩阵并存储起来,在相似性度量时再利用QALF对各个特征组的得分进行加权融合,得到相似性度量最终结果。

|

图 2 本文度量学习方法流程 |

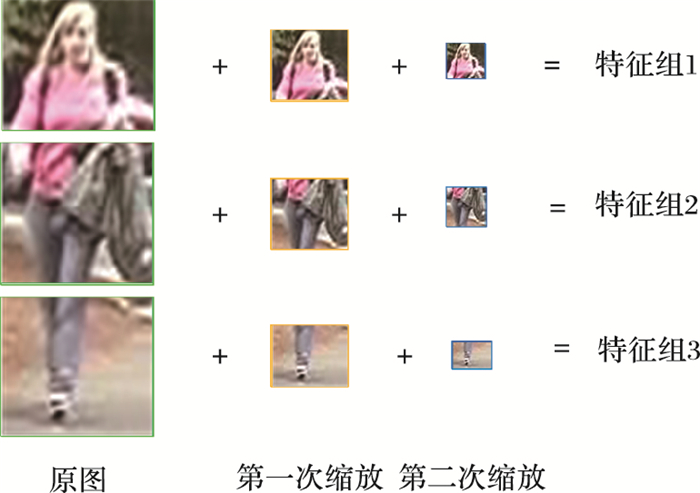

对于从对象图像提取出来的特征,本文将其按图像的上中下等分为3组,如图 3所示,特征组1包含原图、第一次缩放和第二次缩放的前8、4和2个区域,维数为13 286,记为F(1);特征组2包含原图、第一次缩放和第二次缩放的中间8、4和2个区域,维数为13 286,记为F(2);特征组3包含原图、第一次缩放和第二次缩放的最后8、3和1个区域,维数为11 388,记为F(3)。

|

图 3 特征分组 |

kLDFA是LFDA算法的改进,使用核技巧克服了LFDA算法求解困难。其中:LFDA算法主要求解一个映射矩阵P,使得映射之后类内离散度小而类间离散度大。根据著名的Fisher准则函数,P的定义为:

| $\boldsymbol{P} = \mathop {\max {{\left( {{\boldsymbol{P}^{\rm{T}}}{S^{\rm{w}}}\boldsymbol{P}} \right)}^{ - 1}}{\boldsymbol{P}^{\rm{T}}}{S^{\rm{b}}}\boldsymbol{P}}\limits_\boldsymbol{P} $ | (3) |

其中:

| $\left\{ \begin{array}{l} \boldsymbol{\tilde S} = \sum\limits_{i,j = 1}^N {A_{i,j}^{\rm{w}}\left( {{\boldsymbol{e}_i} - {\boldsymbol{e}_j}} \right){{\left( {{\boldsymbol{e}_i} - {\boldsymbol{e}_j}} \right)}^{\rm{T}}}} \\ \boldsymbol{\bar S} = \sum\limits_{i,j = 1}^N {A_{i,j}^{\rm{b}}\left( {{\boldsymbol{e}_i} - {\boldsymbol{e}_j}} \right){{\left( {{\boldsymbol{e}_i} - {\boldsymbol{e}_j}} \right)}^{\rm{T}}}} \end{array} \right.$ | (4) |

其中:e为训练特征; Aw称为类内关系矩阵,而Ab称为类间关系矩阵,定义如下:

| ${A^{\rm{w}}} = \left\{ \begin{array}{l} A_{ij}^{\rm{w}} > 0,\;\;{l_i} = {l_j}\\ A_{ij}^{\rm{w}} = 0,\;\;{l_i} \ne {l_j} \end{array} \right.$ | (5) |

| ${A^{\rm{b}}} = \left\{ \begin{array}{l} A_{ij}^{\rm{b}} > 0,\;\;{l_i} = {l_j}\\ A_{ij}^{\rm{b}} = 0,\;\;{l_i} \ne {l_j} \end{array} \right.$ | (6) |

其中:li和lj为第i和第j个图像实例类标签。

当n>d′时,n为训练特征个数,d′为映射后的特征维数,映射矩阵可表示为P=XQ,Q∈Rn×d′,把上述式子代入式(3),可得:

| $\boldsymbol{Q} = \mathop {\max }\limits_\boldsymbol{Q} {\left( {{\boldsymbol{Q}^{\rm{T}}}{\boldsymbol{X}^{\rm{T}}}\boldsymbol{X\tilde S}{\boldsymbol{X}^{\rm{T}}}\boldsymbol{XQ}} \right)^{ - 1}}{\boldsymbol{Q}^{\rm{T}}}{\boldsymbol{X}^{\rm{T}}}\boldsymbol{X\bar S}{\boldsymbol{X}^{\rm{T}}}\boldsymbol{XQ}$ | (7) |

当使用核技巧,X映射到高维空间ϕ(X),而ϕ(X)Tϕ(X)=K,则式(7)变为:

| $\boldsymbol{Q} = \mathop {\max }\limits_\boldsymbol{Q} {\left( {{\boldsymbol{Q}^{\rm{T}}}\boldsymbol{K\tilde SKQ}} \right)^{ - 1}}{\boldsymbol{Q}^{\rm{T}}}\boldsymbol{K\bar SKQ}$ | (8) |

这样,kLDFA仅对一个n×n的矩阵作特征求解,降低了原有算法的复杂度。本文中,kLDFA使用线性核。

2.3 查询自适应得分融合通过训练数据求得每个特征组的映射矩阵之后,将其存入数据库。当进行相似性度量时,先计算出各个特征组经过映射后的得分,再采用QALF方法对各个特征组得分进行加权。该方法主要通过无标签的训练数据,对每一张查询图像计算得出各个特征组的权重,以达到自适应加权的效果。QALF[11]认为,描述能力强的特征比描述能力弱的特征在得分曲线下的面积要小,QALF方法主要分为离线部分以及在线部分:

离线部分首先,构造一个参考数据集,由不同类别行人的一张图像所构成,用以计算查询图像的参考得分曲线;然后,在参考数据集中随机抽取Q张图像作查询图像,计算每个特征组F(i)(i=1, 2, 3)的得分曲线集合R(i)。

| ${R^{\left( i \right)}} = \left\{ {r_h^{\left( i \right)}} \right\}_{h = 1}^Q$ | (9) |

其中,rh(i)表示第h次查询第i特征组的得分曲线。

在线部分 给定一张查询图像q,首先,在测试数据集上作查询,对于特征组F(i),得分曲线为sq(i);接着,在R(i)中寻找最佳匹配的参考得分曲线。本文中,采用与sq(i)欧氏距离最小的参考得分曲线,即:

| $r_q^{\left( i \right)*} = \mathop {\arg \min }\limits_{r_q^{\left( i \right)} \in {R^{\left( i \right)}}} {\left\| {s_q^{\left( i \right)}\left( {u:v} \right) - r_j^{\left( i \right)}\left( {u,v} \right)} \right\|_2}$ | (10) |

其中:u和v对应曲线相应位置上的点。计算得出最好的匹配曲线后,使用sq(i)与其相减,得到

| $\hat s_q^{\left( i \right)} = s_q^{\left( i \right)} - r_q^{\left( i \right)*}$ | (11) |

对于

| $\bar s_q^{\left( i \right)} = \frac{{\hat s_q^{\left( i \right)} - \min \hat s_q^{\left( i \right)}}}{{\max \hat s_q^{\left( i \right)} - \min \hat s_q^{\left( i \right)}}}$ | (12) |

得到

| $w_q^{\left( i \right)} = \left( {\frac{1}{{{A_i}}}} \right)/\left( {\sum\limits_{k = 1}^K {\frac{1}{{{A_k}}}} } \right)$ | (13) |

其中:Ai为曲线

得到每个特征组的权重后,即可将各个特征组的得分进行融合。本文采用乘积法融合,即对于查询图像q,其与数据库中的图像d的相似性定义为:

| $sim\left( {q,d} \right) = \prod\limits_{i = 1}^K {{{\left( {s_{q,d}^{\left( i \right)}} \right)}^{w_q^{\left( i \right)}}}} $ | (14) |

其中:sq, d(i)表示查询图像q与图像d在特征组F(i)上的得分,且

本文选取VIPeR[2]和iLIDS[15]两个存在视角变化的公开数据集评测所提方法的效果。

VIPeR数据集拥有1 264张行人图像,图像大小为128×48像素,每个行人有2张从不同摄像机拍摄得到的图像,图像都是从水平视角拍摄,但是由于摄像机的视角变换,同一行人在不同摄像机下的图像有较大的姿势变化。

iLIDS数据集由476张行人图像组成,包含119个行人,每个行人拥有2至8张图像,由于数据集在机场拍摄,因此有部分行人图像存在较严重的遮挡问题。

实验中,为了与其他算法比较,本文采用M(r)评价指标,CMC(Cumulative Match Characteristic)评价曲线[8]。其中M(r)为排序后前r位图像中包含正确图像的概率。

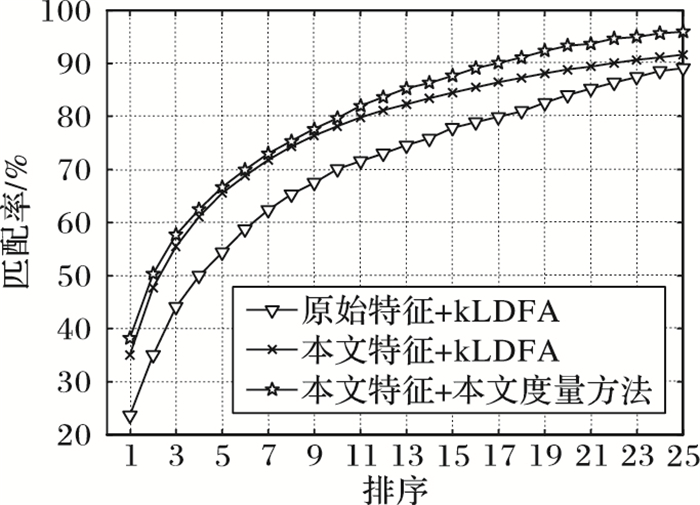

3.2 特征及度量方法对比分析为了评测本文所提特征与度量方法对行人重识别精度的影响,本文在度量学习方法不变的条件下对比了本文特征与文献[8]中的原始特征,同时在使用本文特征的条件下对比了本文度量方法与kLDFA[8]方法。实验结果如图 4所示,其中,测试数据集统一为VIPeR。由图 4可知,当度量学习方法统一为kLDFA时,使用本文特征比原始特征在r=1的精度大约有10个百分点的增加,随着r的增大,虽然提升的程度有所减小,但是依旧比原始特征的精度要高,这验证了本文所提特征比原始特征具有更好的描述能力;当特征统一为本文特征时,使用本文提出的度量学习方法比kLDFA在r=1的精度百分数上大约有3个百分点的增加,并随着r的增大,提升的程度更为明显,这验证了本文的度量学习方法能针对查询图片,对各个区域学习出合适的权重系数,有效地提高行人重识别精度。

|

图 4 三种情况下的CMC曲线 |

本节实验将本文的方法与SVMML方法[16]和KISSME方法[17]进行了对比,以评测本文方法的效果。实验分别在VIPeR和iLIDS数据集上进行了测试,测试结果见表 1。

| 表 1 实验对比结果 |

由表 1可看出,在VIPeR数据集上,当r=1时,本文方法比SVMML在精度上提高约8个百分点,而比KISSME方法提高约13个百分点,随着r的增大,本文方法依然保持良好精度;在iLIDS数据集上,当r=1时,本文方法比KISSME在精度上提升约14个百分点,而在VIPeR上精度较高的SVMML方法,在此数据集上则表现较差,这表明了本文方法具有更好的普适性。

4 结语在行人重识别技术中,特征描述与度量学习一直都是重难点问题,本文针对这两个方面分别作了改进:在特征描述方面,基于特征融合的思想提取出一种更有效的特征;在度量学习方面,在kLDFA的基础上加入自适应得分融合,使得查询图像与数据库图像之间的相似性度量更加精确。实验结果验证了本文方法的有效性。文献[3]中通过人物对称属性减少了背景干扰从而提高了重识别精度,在本文中,由于并未去除行人图像背景的干扰,可能会导致精度有一定程度的下降,在接下来将进一步研究如何去除背景的干扰。

| [1] |

GONG S, CRISTANI M, YAN S, et al.

Person Re-identification[M]. Berlin: Springer, 2014 .

( 0) 0)

|

| [2] |

GRAY D, TAO H. Viewpoint invariant pedestrian recognition with an ensemble of localized features [C]// Proceeding of the 10th European Conference on Computer Vision, LNCS 5302. Berlin:Springer, 2008: 262-275.

( 0) 0)

|

| [3] |

KAI J, BODENSTEINER C, ARENS M. Person re-identification in multi-camera networks [C]// Proceedings of the 2011 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Washington, DC: IEEE Computer Society, 2011: 55-61.

( 0) 0)

|

| [4] |

FARENZENA M, BAZZANI L, PERINA A, et al. Person re-identification by symmetry-driven accumulation of local features [C]// Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2010: 2360-2367.

( 0) 0)

|

| [5] |

BAZZANI L, CRISTANI M, MURINO V. Symmetry-driven accumulation of local features for human characterization and re-identification[J].

Computer Vision and Image Understanding, 2013, 117 (2) : 130-144.

doi: 10.1016/j.cviu.2012.10.008 ( 0) 0)

|

| [6] |

ZHENG W S, GONG S, XIANG T. Person re-identification by probabilistic relative distance comparison [C]// CVPR '11: Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2011: 649-656.

( 0) 0)

|

| [7] |

PEDAGADI S, ORWELL J, VELASTIN S, et al. Local Fisher discriminant analysis for pedestrian re-identification [C]// CVPR '13: Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013: 3318-3325.

( 0) 0)

|

| [8] |

XIONG F, GOU M, CAMPS O, et al. Person re-identification using kernel-based metric learning methods [M]// FLEET D, PAJDLA T, SCHIELE B, et al. Computer Vision—ECCV 2014, LNCS 8695. Berlin: Springer, 2014: 1-16.

( 0) 0)

|

| [9] |

张永库, 李云峰, 孙劲光. 基于多特征融合的图像检索[J].

计算机应用, 2015, 35 (2) : 495-498.

( ZHANG Y K, LI Y F, SUN J G. Image retrieval based on multi-feature fusion[J].

Journal of Computer Applications, 2015, 35 (2) : 495-498.

) ( 0) 0)

|

| [10] |

KHAN F S, VAN DE WEIJER J, VANRELL M. Modulating shape features by color attention for object recognition[J].

International Journal of Computer Vision, 2012, 98 (1) : 49-64.

doi: 10.1007/s11263-011-0495-2 ( 0) 0)

|

| [11] |

ZHENG L, WANG S, TIAN L, et al. Query-adaptive late fusion for image search and person re-identification [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2015: 1741-1750.

( 0) 0)

|

| [12] |

LIAO S, ZHAO G, KELLOKUMPU V, et al. Modeling pixel process with scale invariant local patterns for background subtraction in complex scenes [C]// Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2010: 1301-1306.

( 0) 0)

|

| [13] |

BERLIN B, KAY P.

Basic Color Terms: Their Universality and Evolution[M]. Berkeley, CA: University of California Press, 1991 .

( 0) 0)

|

| [14] |

VAN DE WEIJER J, SCHMID C, VERBEEK J, et al. Learning color names for real-world applications[J].

IEEE Transactions on Image Processing, 2009, 18 (7) : 1512-1523.

doi: 10.1109/TIP.2009.2019809 ( 0) 0)

|

| [15] |

ZHENG W S, GONG S, XIANG T. Associating groups of people [EB/OL]. [2015-12-11]. http://www.bmva.org/bmvc/2009/Papers/Paper167/Abstract167.pdf.

( 0) 0)

|

| [16] |

KOSTINGER M, HIRZER M, WOHLHART P, et al. Large scale metric learning from equivalence constraints [C]// CVPR '12: Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2012: 2288-2295.

( 0) 0)

|

| [17] |

LI Z, CHANG S, LIANG F, et al. Learning locally-adaptive decision functions for person verification [C]// Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013: 3610-3617.

( 0) 0)

|

| [18] |

LI W, ZHAO R, XIAO T, et al. DeepReID: deep filter pairing neural network for person re-identification [C]// Proceedings of the 2014 IEEE Conference on Columbus Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2014: 152-159.

( 0) 0)

|

| [19] |

YI D, LEI Z, LIAO S. Deep metric learning for practical person re-identification [C]// ICPR '14: Proceedings of the 2014 22nd International Conference on Pattern Recognition. Washington, DC: IEEE Computer Society, 2014: 34-39.

( 0) 0)

|

| [20] |

JOBSON D J, RAHMAN Z, WOODELL G A. A multiscale retinex for bridging the gap between color images and the human observation of scenes[J].

IEEE Transactions on Image Processing, 1997, 6 (7) : 965-976.

doi: 10.1109/83.597272 ( 0) 0)

|