2. 软件理论与技术重庆市重点实验室, 重庆 400030

2. Key Laboratory of Software Theory and Technology of Chongqing City, Chongqing 400030, China

ZHU Zhengyu, born in 1959, Ph. D., professor. His research interests include Web intelligent retrieval, data mining, image processing

WANG Mei, born in 1992, M. S. candidate. Her research interests include image processing

近年来,随着计算机和互联网技术的飞速发展,多媒体数据呈现爆炸式的增长,多媒体信息的存储、传输和处理变得越来越重要,尤其是图像处理相关的研究和应用。显著性检测(Saliency Detection)就是图像分析处理前期的一个重要工作,它的任务就是检测出图像中最显著最重要的部分。通过显著性检测可以将有限的计算资源优先分配给图像中的显著区域,大大提高图像分析和处理的效率。

图像的显著性检测,简单来说是指将图片中的显著性区域(前景)从非显著性区域(背景)中分离出来。它作为一种图像预处理技术,可以用于后期的图像分割[1]、物体检测[2]、自适应图像压缩[3]、基于内容的图像检索[4]、视频目标检测[5]等领域。显著性检测算法可以分为两类:眼动点预测模型[6-9]和显著目标检测模型[10-14]。眼动点检测模型主要为了检测出图像中引起人眼注意的显著位置,以此分析和指导人的注意力;而显著目标检测模型则是为了准确地从图像中提取出显著目标区域,以此为基础进行更为复杂的图像处理。显著性检测模型根据实现思路的不同可以分为两种:自上而下[15-17]和自下而上[18-19]。自上而下的方法是由任务驱动的,从高层语义入手,如目标检测等;自下而上的方法是由数据驱动的,从底层特征入手,如颜色、边缘、纹理信息等。本文主要关注自下而上的显著目标检测模型。

1998年,Itti等[6]首次从计算机视觉角度来研究显著性问题,奠定了显著性研究的基本思路:1) 特征提取、归一化;2) 显著值计算;3) 显著区域划分或兴趣点标定。

近几年来,越来越多新颖的算法被应用到显著值计算这个环节中来,并取得了良好的实验效果,为显著性检测的算法研究提供了一些新的角度。最直观的显著性检测方法是基于对比度的算法。Cheng等[10]提出了一种基于全局对比度的显著区域检测算法RC(Region-based Contract)。该算法采用图像各分割区域之间的颜色距离作为全局对比度的衡量方法,取得了很好的实验效果。该文献中还对各区域之间的对比度权值作出了一些假设,如基于center-bias模型提出了越靠近图像中心显著值越大、提出了区域间空间距离越近对显著值影响越大等思想。这些对显著值的假设通过实验验证了其正确性,并对后续的研究有一定的参考价值。

然而,RC算法没有体现区域特征的空间分布对显著性的重要影响,即特征分布越集中显著性越大,并且在处理复杂纹理背景的图像时效果一般。基于此,Krahenbuhl等[11]提出了一种SF(Saliency Filter)算法。该算法使用改进的超像素分割方法来进行图像预处理,并提出了结合颜色独立性和空间颜色分布的显著性计算方法。文中还将显著值的普通计算过程转换为以滤波器的思想进行计算,借助此将算法的时间复杂度降低到了线性时间内。

2013年,Yang等[12]提出了一种基于闭环图和背景先验[20]的显著检测方法——基于图和流形排序的显著性检测(saliency detection algorithm via graph-based Manifold Ranking, MR)算法,将流形排序算法[21]引入到显著性检测的应用中来。文中将图像抽象为一个基于超像素的闭环图模型,然后基于流形排序算法分两个阶段来计算每个节点的显著值。第一阶段以四个边界的节点作为背景先验种子节点,以各节点与背景种子的差异度计算显著值;第二阶段将第一阶段得到的显著图进行二值化的结果作为前景种子节点,以各节点与前景种子的相似度再进行一次显著值计算,以此得到最终的显著图。然而MR算法中的两阶段计算方法都依赖于第一步背景种子的选取。文中使用图像的边界节点作为初始查询节点以求得第一阶段的图像显著值,又使用第一阶段的计算结果作为第二阶段的输入,这样过多依赖了图像的背景特征而忽略了前景特征。对此,本文作出了如下改进:

1) 除了将背景(边界节点)作为查询节点,还加入基于全局对比度的前景特征,将两者结合形成最终的查询节点;

2) 根据前景种子和背景种子,结合亮度、颜色等多种特征,筛选更准确的查询节点。

实验结果表明,本文的改进方法在效果上取得了一定的提升。

1 Manifold Ranking与显著性检测Manifold Ranking的概念最早是由Zhou在文献[21]中提出的。Manifold Ranking算法以图模型来模拟数据集内在的流形结构,所有的数据点通过这个图模型来将它们的排序值传播给邻接点,直到排序值收敛到稳定状态。具体算法描述如下:

给定一个数据集X={x1, …, xi, xi+1, …, xn}∈Rn×n,包括已标记的查询数据以及需要进行排序的未标记数据。令f:X→Rn表示一个排序方程,其中每个值fi表示数据点xi的排序值。f可以看作一个向量f=[f1, f2, …, fn]T。令y=[y1, [y2, …, [yn]T表示一个标签向量,其中当xi为查询节点时[yi=1,否则[yi=0。流形排序算法步骤如下:1) 构建一个图G(V, E),其中节点V为数据集X,边E的权重表示为相似度矩阵W=[wij]n×n。计算图的度矩阵D=diag(d1, d2, …, dn),其中

文献[21]中已经证明,序列最终将收敛到如下闭合解:

| ${\boldsymbol{f}^*} = {\left( {\boldsymbol{I} - \alpha \boldsymbol{S}} \right)^{ - 1}}\boldsymbol{y}$ | (1) |

其中:I为单位矩阵,参数α决定了平滑约束(smoothness constraint)和适应性约束(fitting constraint)的权重比例。其中平滑约束代表相邻节点之间的排序值不应变化太大,适应性约束是指最终得到的排序值结果与初始查询要大致接近。

式(1)的非归一化的解为:

| ${\boldsymbol{f}^*} = {\left( {\boldsymbol{D} - \alpha \boldsymbol{W}} \right)^{ - 1}}\boldsymbol{y}$ | (2) |

文献[12]中的实验证明,应用在显著性检测这一问题中,非归一化的式(2)比归一化的式(1)有更好的实验效果,因此本文也采用式(2)进行流形排序计算。

令A=(D-αW)-1,则:

| ${\boldsymbol{f}^*} = \boldsymbol{Ay}$ | (3) |

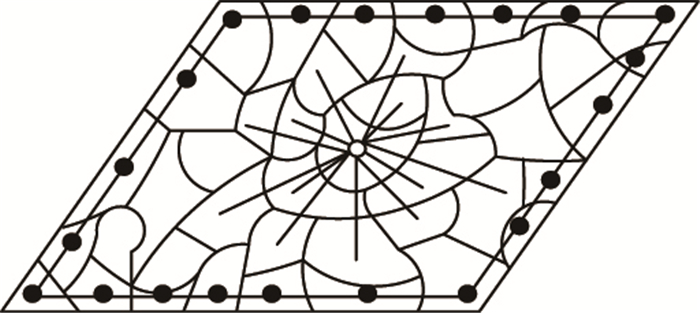

矩阵A可以看作通过排序算法学习到的最优相似度矩阵,它比W能更好地描述节点之间的关联程度。第i个节点的排序值可以看成是矩阵A的第i行与向量y的内积。流形排序算法提出后,被相继应用在文档搜索、图像搜索[22]等领域。在MR算法中,作者将流形排序的思想结合到显著性检测中来。文献中将图像抽象为一个闭环图模型[12],如图 1。

|

图 1 闭环图模型 |

闭环图模型的构建过程为:1) 对一个图像,使用SLIC(Simple Linear Iterative Cluster)超像素方法[23]将图像分割成若干超像素,每个超像素作为图G中的一个“节点”;2) 边界节点之间两两有边,每个节点都与其邻节点、间接邻节点之间有边;3) 边的权重定义为两节点的平均Lab颜色的欧几里得距离,具体计算公式如下:

| ${w_{ij}} = {{\rm{e}}^{ - \frac{{\left\| {{c_i} - {c_j}} \right\|}}{{{\sigma ^2}}}}};i,j \in V$ | (4) |

其中:ci是节点i中包含所有像素点的Lab平均颜色。

基于以上闭环图模型,选取初始显著节点作为查询节点,可以通过Manifold Ranking算法中的式(2)得到每个节点的排序值。这个排序值即作为该节点所包含像素的显著值,以此得到图像的显著图。

2 基于Manifold Ranking和结合前景背景特征的显著性检测 2.1 前景和背景特征的流形排序MR算法提出的两阶段显著性检测方法是以背景特征为查询节点的流形排序,其背景特征从四个方向的边界节点获取。在式(2)中令[yi=1,i是上边界的节点,得到以上边界节点为查询种子的排序结果ft。那么以上边界节点为背景特征的图像显著值St可通过式(5)计算得到:

| ${S_{\rm{t}}} = 1 - {{\bar f}_t}$ | (5) |

其中

| ${\boldsymbol{S}_{{\rm{bg}}}} = {\boldsymbol{S}_{\rm{t}}} \times {\boldsymbol{S}_{\rm{b}}} \times {\boldsymbol{S}_{\rm{r}}}$ | (6) |

然而由于MR算法只考虑了背景特征而没有考虑全局前景特征,本文方法基于MR算法中的闭环图模型,将所有节点设为查询节点,即在式(2)中令y=[1, 1, …, 1]T,相当于直接利用闭环图本身的最优相似度矩阵A计算每个节点与其他节点的差异和。以此进行流形排序得到一个显著图Sfg,该显著图即为考虑全局特征得到各个节点的显著值,计算公式如式(7)。将显著图Sfg二值化,得到前景特征种子节点(后文简称“前景种子”)。

| ${S_{{\rm{fg}}}} = A \times {\left[{1,1,,\cdots ,1} \right]^{\rm{T}}}$ | (7) |

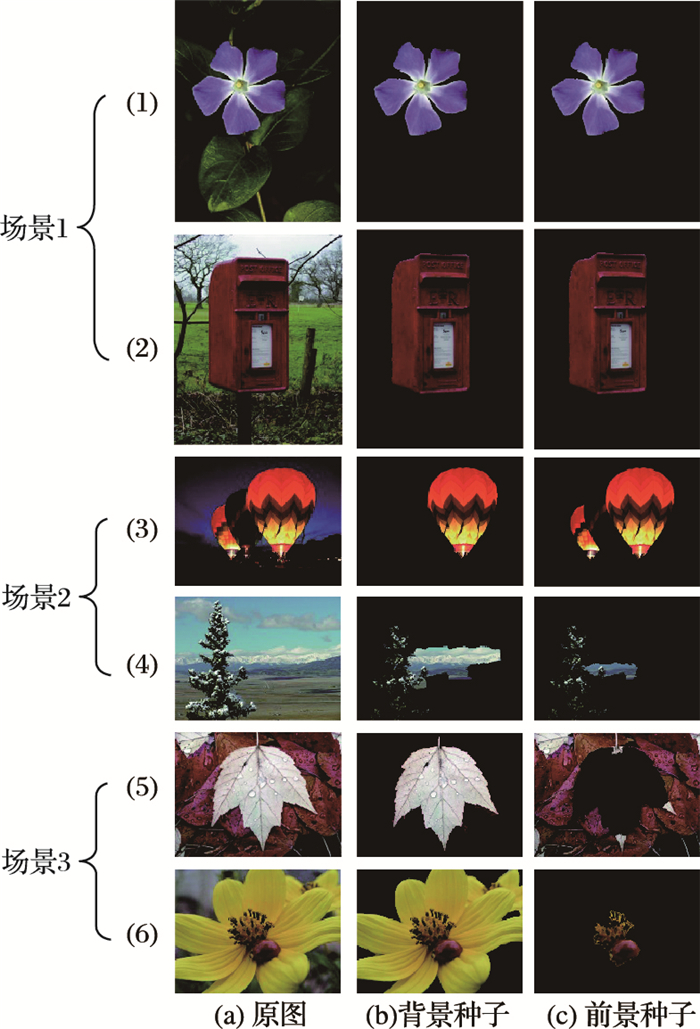

实验发现,部分图片的前景种子与背景种子有着很大的相似性(场景1),如图 2中的(1)、(2)组图片:此类图片的显著区域既与背景特征区别显著,也在全局范围内有着排序靠前的特征显著性,因此使用前景或者背景种子作为查询节点,都可以得到良好的实验结果。

|

图 2 图像的背景种子和前景种子 |

然而,大部分的前景种子与特征种子存在部分差异(场景2),如图 2中的(3)、(4)组图片:有时前景种子作为查询节点更准确,有时背景种子表现更佳,因此不能单纯使用前景或背景种子进行计算,需根据一定规则将两者进行有机结合。3.2节将详细阐述如何进行结合。

特别地,还存在个别图片的前景种子与背景种子存在显著差异(场景3),如图 2中的(5)、(6)组图片:此类图片的前景种子与背景种子的交集非常有限,即以边界节点特征作为先验与计算全局对比度得到的显著区域几乎完全相反。通过实验发现,背景特征种子往往更贴近理想的查询节点,因此对于这类图片,直接采取背景特征种子作为最终查询节点。

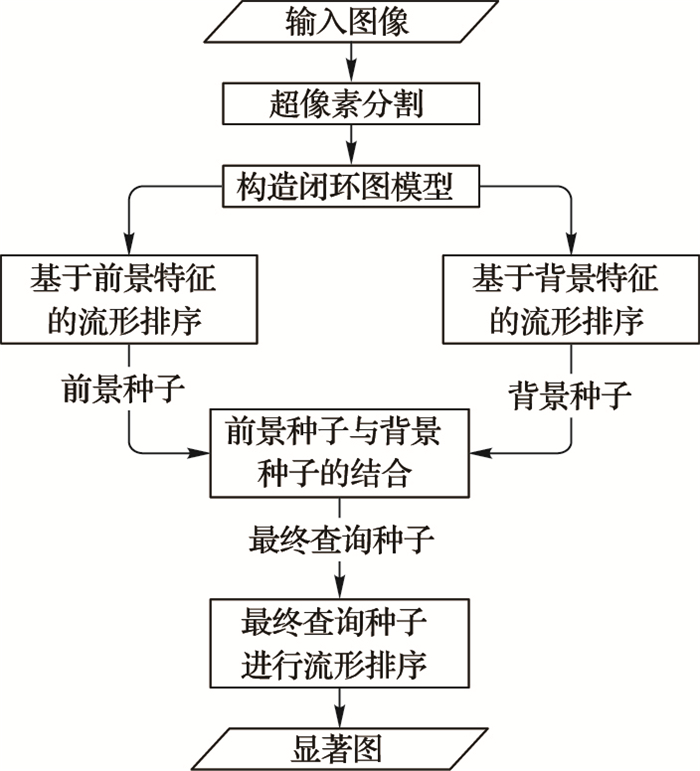

2.2 结合前景和背景特征的显著性检测针对上文描述的前景特征与背景特征的不同表现,本文提出了一种结合背景和前景特征的显著性检测方法。通过MR算法得到背景特征显著图,再以式(2)设全1的查询节点y得到前景特征显著图。对前景特征显著图和背景特征显著图分别进行二值化,得到前景种子和背景种子。结合这两类种子节点作为最终查询节点进行流形排序,即可得到更准确的显著值。算法流程如图 3所示。

|

图 3 算法流程 |

得到前景种子和背景种子的前提下,关于如何计算选取最终查询节点,本文提出了一种结合亮度和颜色特征的种子选取规则。

定义初始前景fgQuery=[q1, q2, …, qn]T,其中qi=0或1。fgQuery为两次被标记为显著区域的节点,用于计算图像前景特征,也作为初始查询节点。同理初始背景bgQuery为两次被标记为非显著区域的节点,用于计算图像背景特征。候选查询节点candidate为待判定为前景或背景的节点。计算公式如式(8):

| $\left\{ \begin{array}{l} \boldsymbol{fgQuery} = \boldsymbol{Query1} \cap \boldsymbol{Query2}\\ \boldsymbol{fgQuery} = \neg \left( {\boldsymbol{Query1} \cup \boldsymbol{Query2}} \right)\\ \boldsymbol{candidate} = \boldsymbol{Query1} \cup \boldsymbol{Query2} - \boldsymbol{Query1} \cap \boldsymbol{Query2} \end{array} \right.$ | (8) |

其中Query1是背景种子,Query2是前景种子。

首先判断图像的前景种子是否符合3.1节中描述的场景1或场景3。若符合,则最终查询节点y即为背景种子Query1;否则将y初始化为初始前景fgQuery,然后判断候选查询节点是否被选为最终查询节点。式(9)如下:

| $\begin{array}{l} \boldsymbol{y} = \left\{ \begin{array}{l} \boldsymbol{Query1},\;场景1或3\;\\ \boldsymbol{fgQuery},\;\;场景2 \end{array} \right.\\ 场景1:\boldsymbol{Query1} = Query2\\ 场景2:\boldsymbol{Query1} \ne Query2\;{\rm{and}}\;num\left( {\boldsymbol{fgQuery}} \right) \ge \mu \times \\ num\left( {\boldsymbol{Query1}} \right)\\ 33:num\left( {\boldsymbol{fgQuery}} \right) < \mu \times num\left( {\boldsymbol{Query1}} \right) \end{array}$ |

其中:num(Query)表示Query种子节点的个数;μ表示初始前景至少占背景种子的比例,实验中取50%。即当初始前景的节点个数小于背景种子个数的一半时,则认为前景种子与背景种子的差异过大,初始前景的特征不足以用来作为判断是否显著的参考。因此,当前景种子与背景种子完全相同,或者初始前景节点数明显不足的情况下,直接采用背景种子作为最终查询节点。

对于候选查询节点,根据亮度和颜色两种特征来判定其属于前景还是背景,即是否被选为最终查询节点。之所以将亮度参数和颜色参数分开考虑,是针对MR算法中两种表现不佳的情况:

1)显著区域因亮度存在差异,部分亮度较低的区域被判断为非显著区域;

2)显著区域因颜色存在差异,部分与背景颜色更接近的区域被判定为非显著区域。

针对以上两种情况,候选节点满足以下两个要求之一的节点,也设为查询节点:

1)亮度参数(L分量)更接近初始前景;

2)颜色参数(a、b分量)更接近初始前景。

具体判断公式如式(10):

| $\begin{array}{l} {y_{i \in candidate}} = \left\{ {1,\;D_{{\rm{fg}}}^l < } \right.D_{{\rm{dg}}}^l|D_{{\rm{fg}}}^{ab} < D_{{\rm{bg}}}^{ab}\\ D_{{\rm{fg}}}^l = {L_{candidate}} - {\rm{mean}}\left( {{L_{fgQuery}}} \right)\\ D_{{\rm{bg}}}^l = {L_{candidate}} - {\rm{mean}}\left( {{L_{bgQuery}}} \right)\\ D_{{\rm{fg}}}^{ab} = {L_{candidate}} - {\rm{mean}}\left( {{L_{fgQuery}}} \right)\\ D_{{\rm{bg}}}^l = {L_{candidate}} - {\rm{mean}}\left( {{L_{bgQuery}}} \right) \end{array}$ | (10) |

其中:L代表Lab颜色空间中的L分量,AB表示Lab颜色空间中的a、b两个分量; Dil表示当前节点与初始前景或初始背景之间L分量的欧氏距离,Diab表示当前节点与初始前景或初始背景之间a、b分量的欧氏距离。

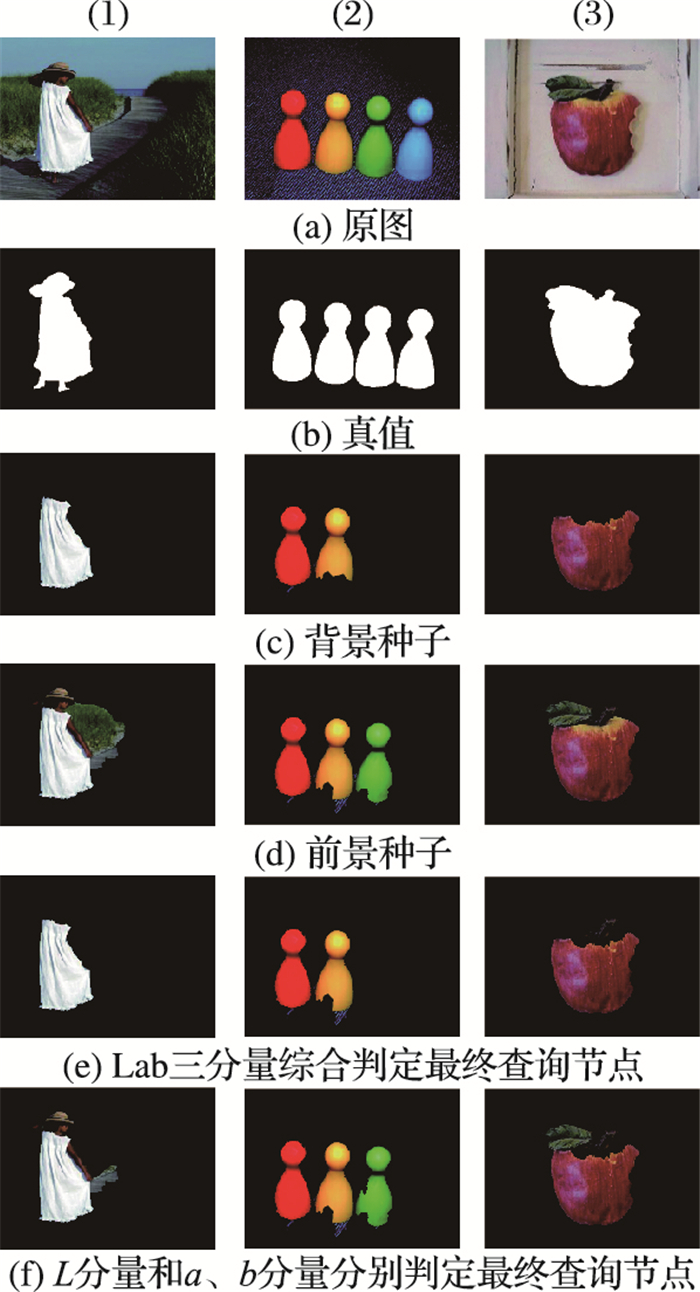

图 4展示了两种判定方式得到的查询种子,可以看出,将亮度和颜色分量分开判定比Lab三个分量综合判定,使得更多原本应该加入显著区域的节点加入进来,得到的最终查询节点更准确。

|

图 4 Lab分量综合判定和分开判定 |

综上分析,本文提出算法的形式化描述如下:

输入:图像Image;

输出:图像的各个超像素部分的显著值,即得到一个图像的显著图saliencymap。

1) 将图像分割为n个超像素区域,以每个超像素为节点建立闭环图G,计算度矩阵D和权重矩阵W。

2) 计算A=(D-αW)-1并将其对角元素设置为0。

3) 基于背景特征的流形排序:以四个方向的边界节点作为查询节点进行流形排序计算,由式(5)、(6)得到背景特征显著图,以自适应阈值二值化后得到背景种子Query1。

4) 基于前景特征的流形排序:根据式(7),将所有节点作为查询节点进行流形排序计算,得到前景特征显著图,以自适应阈值二值化后得到前景种子Query2。

5) 计算查询节点y:①根据式(8)计算初始前景fgQuery、初始背景bgQuery,候选查询节点candidate;②根据式(9)判断是否符合场景1或场景3,若符合,令y=Query1,直接跳到第6)步;否则,继续下列步骤。③y初始化为初始前景y=fgQuery,对于每个候选节点candidate,根据式(10)判断其是否为查询节点。

6) 利用式(3)计算各个节点的排序值,得到的排序值即为各个超像素的显著值,并以此求得图像的显著图。

3 实验结果与分析本文实验的硬件环境为CPU 3 GHz、内存4 GB的计算机。实验在Windows 7操作系统下进行,使用Matlab语言在Matlab 2014a平台上仿真。

本文实验数据集采用的是由文献[24]提供的MSRA-1000,是MSRA数据集的子集,由人工标记了显著区域GroundTruth(GT)。以下实验中,本文方法(简写为Ours)与近几年的其他三种state-of-art类算法:MR算法[12]、SF算法[11]、RC算法[10](RC算法有两个版本,分别来自文献[4]和文献[10],本文使用的是文献[10]中给出的实验数据)进行了对比分析。

实验中涉及到几个参数,它们分别是:超像素个数(闭环图节点个数)n,式(2)中的调节参数α。本文实验中,参考MR算法[12]中参数的设定,取n=200, α=0.99。

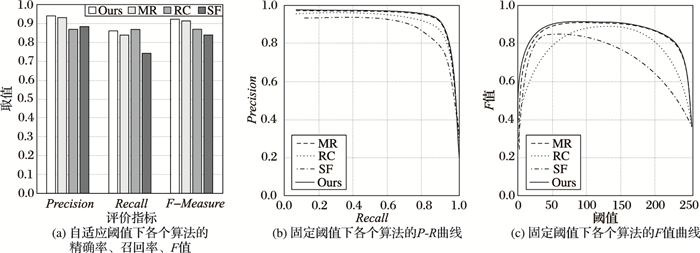

实验中,使用了三种常用的评价指标:精确率(Precision)、召回率(Recall)和F值(F-measure)。其中:精确率表示算法得出的显著区域中真实显著区域的比例,召回率表示GT中的显著区域被正确标记的比例,F值则是对精确率和召回率进行整合的一个综合指标。本文参照以往文献[10-12]中的参数设定,设β2=0.3以强调精确率的重要性。

| ${F_\beta } = \frac{{\left( {1 + {\beta ^2}} \right)\Pr ecision \times {\mathop{\rm Re}\nolimits} call}}{{{\beta ^2}\Pr ecision + {\mathop{\rm Re}\nolimits} call}}$ | (11) |

显著图的二值化使用下面两种方式:自适应阈值方式和固定阈值方式。自适应阈值是指对每个图片都根据其显著图计算一个阈值进行分割,实验结果直接使用平均精确率、召回率和F值的方式来表示。固定阈值是指对所有数据集中的图片,固定阈值为0~255,以此获得在不同阈值下的精确率和召回率,一般使用P-R曲线和F值曲线来表示。可以认为,自适应阈值方式是该算法的最佳表现结果,固定阈值方式体现了算法的平均表现结果。图 5分别是本文算法(Ours)、MR算法、SF算法、RC算法在自适应阈值和固定阈值下的实验对比结果。可以看出,自适应阈值情况下,本文算法较MR是算法在精确率、召回率、F值上均有提升;固定阈值情况下,本文算法始终略好于MR算法。

|

图 5 MSRA-1000数据集上四种算法对比 |

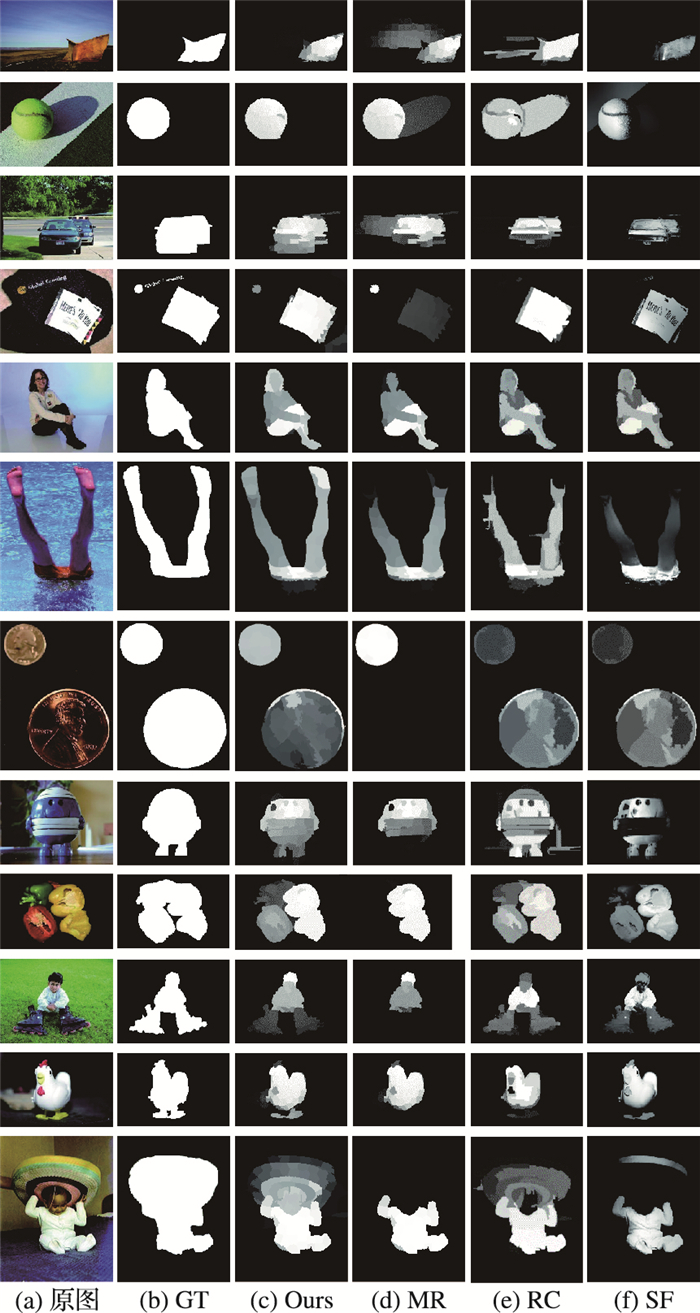

为了更直观地分析本文算法在实验效果上的改进,图 6展示了12组本文算法得到的显著图与其他三种算法:MR算法、SF算法、RC算法的对比结果,其中GT是人工标记的显著区域。可以看出,以GT为参照,本文算法的效果普遍好于其他三种算法。

|

图 6 各个算法显著图对比结果 |

通过前6组图片,可以看出本文算法更能够均匀地突出前景,即显著区域的显著值更大而非显著区域的显著值减小。这是由于本文结合了前景和背景特征得到的查询节点,采取了比MR算法(仅由背景特征得到的)更准确的查询节点,使得噪声数据减少,显著与非显著区域的排序值区分更大。

通过后6组图片,可以看出本文算法可以检测到MR算法“丢失”的显著区域,这是由于本文方法结合了全局对比度

的前景特征。MR算法由于依赖于边界背景特征,容易在以下两种情况下表现不佳:一是显著区域与边界区域特征近似时,难以区分是否显著;二是当显著区域由几个特征差异较大的部分组成时,难以区分是否显著。而这两个问题在使用前景特征进行流形排序时可以得到很好的解决。SF算法和RC算法是基于全局对比度的算法,这两种算法在后6幅图片中表现比MR好,也可以间接证明这一点。

综合来说,使用背景特征先验可以更均匀地突出显著区域,使用前景特征先验可以检测到更完整的显著区域。本文方法采取结合前景和背景特征的方式,有效结合了以上两个优点。

4 结语图像显著性检测越来越得到广泛的研究和关注,然而仍然存在许多问题尚待改进。本文在文献[12]的基础上,针对其依赖背景特征的不足,基于Manifold Ranking算法提出了一种结合前景背景特征的显著性检测方法。该方法融合全局对比度和以边界信息为参考的背景特征,并结合多次流形排序算法为计算显著值提供了更准确的查询节点。然而,本文算法仍有改进的空间,如在处理背景较为复杂的图片时对显著区域的检测不够准确;算法仅仅使用了颜色特征进行描述,在以后的工作中可以融合纹理、形状等多种图像特征。

| [1] |

GOFERMAN S, ZELNIK-MANOR L, TAL A. Context-aware saliency detection[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 34 (10) : 1915-1926.

( 0) 0)

|

| [2] |

RUTISHAUSER U, WALTHER D, KOCH C, et al. Is bottom-up attention useful for object recognition? [C]// CVPR '04: Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2004: 37-44.

( 0) 0)

|

| [3] |

ITTI L. Automatic foveation for video compression using a neurobiological model of visual attention[J].

IEEE Transactions on Image Processing, 2004, 13 (10) : 1304-1318.

doi: 10.1109/TIP.2004.834657 ( 0) 0)

|

| [4] |

CHENG M M, ZHANG G X, MITRA N J, et al. Global contrast based salient region detection [C]// CVPR '11: Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2011: 409-416.

( 0) 0)

|

| [5] |

LIU Z, ZHANG X, LUO S, et al. Superpixel-based spatiotemporal saliency detection[J].

IEEE Transactions on Circuits and Systems for Video Technology, 2014, 24 (9) : 1522-1540.

doi: 10.1109/TCSVT.2014.2308642 ( 0) 0)

|

| [6] |

ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20 (11) : 1254-1259.

doi: 10.1109/34.730558 ( 0) 0)

|

| [7] |

HOU X, ZHANG L. Saliency detection: a spectral residual approach [C]// Proceedings of the 2007 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2007:1-8.

( 0) 0)

|

| [8] |

JUDD T, EHINGER K, DURAND F, et al. Learning to predict where humans look [C]// Proceedings of the IEEE 12th International Conference on Computer Vision. Piscataway, NJ: IEEE, 2009: 2106-2113.

( 0) 0)

|

| [9] |

KIM J S, SIM J Y, KIM C S. Multiscale saliency detection using random walk with restart[J].

IEEE Transactions on Circuits and Systems for Video Technology, 2014, 24 (2) : 198-210.

doi: 10.1109/TCSVT.2013.2270366 ( 0) 0)

|

| [10] |

CHENG M M, ZHANG G X, MITRA N J, et al. Global contrast based salient region detection[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37 (3) : 569-582.

doi: 10.1109/TPAMI.2014.2345401 ( 0) 0)

|

| [11] |

KRAHENBUHL P. Saliency filters: contrast based filtering for salient region detection [C]// CVPR '12: Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2012: 733-740.

( 0) 0)

|

| [12] |

YANG C, ZHANG L, LU H, et al. Saliency detection via graph-based manifold ranking [C]// CVPR '13: Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2013: 3166-3173.

( 0) 0)

|

| [13] |

LIANG Z, WANG M, ZHOU X, et al. Salient object detection based on regions[J].

Multimedia Tools and Applications, 2014, 68 (3) : 517-544.

doi: 10.1007/s11042-012-1040-1 ( 0) 0)

|

| [14] |

SHI J, YAN Q, XU L, et al. Hierarchical image saliency detection on extended CSSD[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38 (4) : 717-729.

doi: 10.1109/TPAMI.2015.2465960 ( 0) 0)

|

| [15] |

LIU T, YUAN Z, SUN J, et al. Learning to detect a salient object[J].

IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33 (2) : 353-367.

doi: 10.1109/TPAMI.2010.70 ( 0) 0)

|

| [16] |

ZHAO R, OUYANG W, LI H, et al. Saliency detection by multi-context deep learning [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2015: 1265-1274.

( 0) 0)

|

| [17] |

TONG N, LU H, RUAN X, et al. salient object detection via bootstrap learning [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2015: 1884-1892.

( 0) 0)

|

| [18] |

LI C, YUAN Y, CAI W, et al. Robust saliency detection via regularized random walks ranking [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2015: 2710-2717.

( 0) 0)

|

| [19] |

QIN Y, LU H, XU Y, et al. Saliency detection via cellular automata [C]// Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2015: 110-119.

( 0) 0)

|

| [20] |

WEI Y, WEN F, ZHU W, et al. Geodesic saliency using background priors [C]// Proceedings of the 2012 12th European Conference on Computer Vision, LNCS 7574. Berlin: Springer, 2012: 29-42.

( 0) 0)

|

| [21] |

ZHOU D, WESTON J, GRETTON A, et al. Ranking on data manifolds [EB/OL]. [2015-11-08]. http://www.kyb.mpg.de/fileadmin/user_upload/files/publications/pdfs/pdf2334.pdf.

( 0) 0)

|

| [22] |

WANG B, PAN F, HU K M, et al. Manifold-ranking based retrieval using k-regular nearest neighbor graph[J].

Pattern Recognition, 2012, 45 (4) : 1569-1577.

doi: 10.1016/j.patcog.2011.09.006 ( 0) 0)

|

| [23] |

ACHANTA R, SHAJI A, SMITH K, et al. SLIC superpixels [EB/OL]. [2015-12-11]. http://islab.ulsan.ac.kr/files/announcement/531/SLIC_Superpixels.pdf.

( 0) 0)

|

| [24] |

ACHANTA R, HEMAMI S, ESTRADA F, et al. Frequency-tuned salient region detection [C]// CVPR 2009: Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2009: 1597-1604.

( 0) 0)

|