人类活动的运动数据能够表征人类日常健康状况[1]。过去,捕捉运动数据需要昂贵的设备、复杂的算法和特定的场景,提取运动数据具有一定的困难。随着高新科技发展,可捕捉运动数据的智能手环等设备成为热点,利用计算机自动捕获、分析视频中的人体运动数据引起关注,大规模海量人体运动数据库逐渐被建立[2]。

相比之下,猪只运动数据的重要性与猪只运动数据的采集和提取却鲜有关注和研究。

运动数据的异常同样能反映猪只健康状况。例如,Zhu等[3]利用猪的步态角度数据检测猪的跛行;Oczak等[4]分析猪只攻击行为的时间数据,识别出会导致相互撕咬的前期行为,以预测和防止猪只之间的攻击行为;Viazzi等[5]通过平均强度和占领指数两个运动信息研究猪只攻击行为。

上述工作只针对特殊病症或状态提出单一的或具有针对性的运动参量。而自然条件下猪只日常运动时间、距离、速度、加速度等构成的运动数据,更能表征猪只日常健康。对实时监控视频中的猪只进行跟踪并提取出反映猪只行为的参量信息,能够为识别各种采食、排泄、站立、趴窝、慢走和跑动等行为的研究提供重要的数据基础[6]。例如,高云[7]利用三轴加速度传感器得到的速度和加速度数据对猪的走、跑、跳、静止行为进行分类与识别;刘龙申等[8]利用无线加速度传感器采集母猪产前的加速度,检测出母猪躺卧、站立、吃料、筑窝等行为;尹令等[9]通过各种传感器获取奶牛的体温、呼吸频率和运动加速度等参量,区分奶牛静止、慢走、爬跨等行为。

上述方法虽然能够采集猪只的运动参量,但是在动物身上安装多种传感器会给动物带来不舒适感,会导致应激行为,影响动物的健康生长。

本文工作主要如下:

1) 将视频监控技术、数字图像处理技术引入生猪养殖领域,实现计算机视觉技术与畜牧养殖业不同学科交叉。

2) 提出一套能够应用于自然条件下的猪只识别与跟踪方法。

3) 提出一套不需要接触动物身体的运动参量提取方法。立足猪只日常基础行为,所提取的运动参量简单、实用、通用。将猪场现场提取到的猪只运动参量存储形成数据库,对未来更多更一般化的猪只日常行为研究有利。

1 猪只运动参量提取算法原理本文课题组前期开发了基于物联网的猪场远程实时监控系统,此系统通过网络能对猪场进行实时视频访问。本文在该系统的基础上,先对实时视频进行基于颜色特征和轮廓特征结合的猪只识别,再基于最短距离匹配法提取状态参量和运动速度、运动位移、运动加速度和运动角速度4个基础运动参量。

1.1 基于颜色特征和轮廓特征结合的猪只识别提取运动参量前需要对视频图像进行猪只识别。猪只常长时间躺着,基于运动分析的方法会失效;猪只是非刚性目标,其活动的随意性决定了其形状的不规则性,因此固定的模板匹配法也会失效;变形的模板匹配法和基于主动轮廓的方法的计算分析复杂,运算速度慢,无法满足实时性要求[10]。颜色特征具有对目标形状变化不敏感和计算量简单等优点,适合猪只检测。常用的颜色通道有RGB、YUV、HSV和YCbCr。RGB将红、绿、蓝三个色彩空间分离为3个通道;YUV将亮度、色度信号分离为不同的通道,颜色特征不受亮度变化影响;HSV将颜色分成了色调(H)、饱和度(S)、明度(V)三个通道;YCbCr是YUV经过缩放和偏移的模型。

对猪场远程监控系统的多个猪场多个养猪室进行观察,发现不同场地环境、光照、拍摄视角等对不同颜色通道中目标的聚类情况不一样,例如中山白石猪场配种猪舍对Cr通道聚类效果一般,但阳东宝骏猪场保育室对Cr通道的聚类效果却非常好,广州市力智猪场种猪室对Cr通道聚类效果一般却对R通道聚类效果非常好。

假设某颜色通道c下的一幅图像被阈值T分割成了C0和C1两类[11-12],则C0和C1出现概率可以表示为:

| $\left\{ \begin{matrix} {{W}_{0}}=\sum\limits_{i=0}^{T}{{{P}_{i}}}=w(T) \\ {{W}_{1}}=\sum\limits_{i=T+1}^{L-1}{{{P}_{i}}}=1-w(T) \\ \end{matrix} \right.$ | (1) |

其中:Pi是每一个灰度值出现的概率;i是灰度值。

C0与C1的标准方差可以表示为:

| $\left\{ \begin{matrix} {{u}_{0}}=\sum\limits_{i=0}^{T}{i{{P}_{i}}/{{W}_{0}}=u(T)/w(T)} \\ {{u}_{1}}=\sum\limits_{i=T+1}^{L-1}{i{{P}_{i}}/{{W}_{1}}=\frac{u-u(T)}{1-w(T)}} \\ \end{matrix} \right.$ | (2) |

其中:

| $\left\{ \begin{matrix} {{\sigma }_{0}}^{2}=\sum\limits_{i=0}^{T}{{{(i-{{u}_{0}})}^{2}}{{P}_{i}}/{{W}_{0}}} \\ {{\sigma }_{1}}^{2}=\sum\limits_{i=T+1}^{L-1}{{{(i-{{u}_{1}})}^{2}}{{P}_{i}}/{{W}_{1}}} \\ \end{matrix} \right.$ | (3) |

类内方差和类间方差可以分别定义为式(4)~(5):

| ${{\sigma }_{W}}^{2}={{W}_{0}}{{\sigma }_{0}}^{2}+{{W}_{1}}{{\sigma }_{1}}^{2}$ | (4) |

| ${{\sigma }_{B}}^{2}={{W}_{0}}{{W}_{1}}({{u}_{1}}-{{u}_{0}})$ | (5) |

式(6)表示总体方差,它是类内差和类间差的总和:

| ${{\sigma }^{2}}={{\sigma }_{B}}^{2}+{{\sigma }_{W}}^{2}={{\sum\limits_{i=0}^{L-1}{(i-u)}}^{2}}{{P}_{i}}$ | (6) |

从式(6)中可知,总体方差与阈值无关,只取决于图像的灰度直方图。最优的分割方法是不断迭代找到一个阈值T使得“类间方差最大,类内方差最小”,如式(7)所示,即“η最大”:

| $\text{max }\eta \text{(T)}=\frac{{{\sigma }_{B}}^{\text{2}}}{{{\sigma }^{2}}}$ | (7) |

将此颜色通道c下最大的η记作δ。

根据经验,对猪只颜色最敏感的颜色通道为R、H、Cr。在程序初始化时对视频的第一帧计算这3个颜色通道的δ值,选择最大δ值的颜色通道作为此场景下最优的颜色通道,此δ值所对应的阈值T即为最优聚类阈值。

图像聚类分割后,猪场环境噪声较大。借鉴Kashiha等[13]思想,初始化时手工设定将猪栏食槽、水槽以及猪栏门等固定环境噪声排除,再利用连通区域消除、形态学腐蚀与膨胀等方法将环境中相对猪只个体来说面积小得多的错误目标去除。

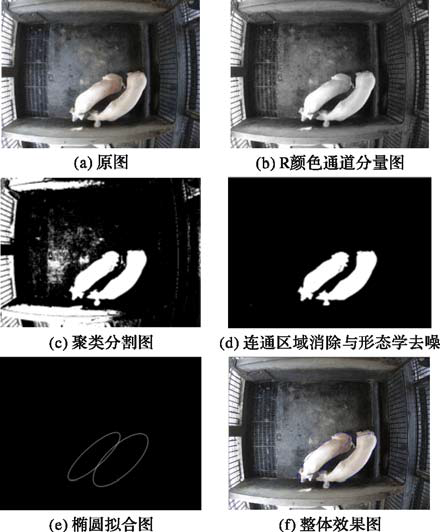

猪的体型特征与椭圆类似,椭圆受猪只体重或非刚体变换的影响较小,所以选用椭圆对猪只轮廓进行拟合[13]。采用最小二乘法拟合椭圆,所拟合椭圆的长轴为猪只身长L。整个处理过程如图 1所示。

|

图 1 目标识别过程 |

从图 1可看出基于颜色特征的识别工作完成后,图像已经能够识别猪只目标,但是基于颜色特征的检测并不能处理猪只粘连情况。

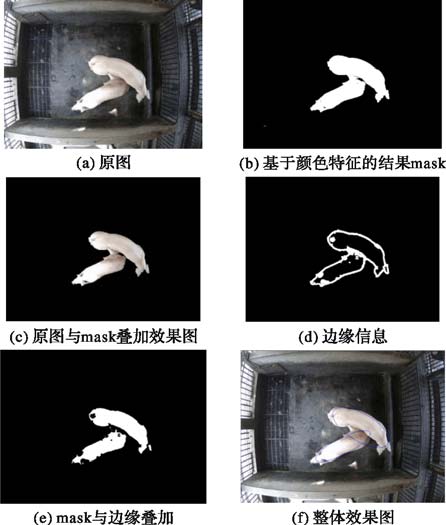

本文提出应用基于颜色特征与轮廓特征结合的方法分割轻度粘连的猪只。先将基于颜色特征检测结果作为mask和原图叠加,既去除了环境干扰又保留了原图猪只的细节。然后对此进行5*5的高斯模糊和Prewitty边缘检测提取猪只的轮廓信息。为了强调边缘信息,将边缘图像作膨胀处理,再将基于颜色特征的mask叠加边缘信息,至此,颜色特征和轮廓特征结合在一起,粘连猪只由轮廓信息分割开来。处理过程如图 2所示。

|

图 2 粘连目标分割过程 |

每帧图像中的猪只目标识别之后,猪只i在t时刻的运动状态变量可以用以下三元组表示:

| ${{p}_{i}}^{t}=({{x}_{i}}^{t},{{y}_{i}}^{t},{{\theta }_{i}}^{t})$ |

其中: i表示每个猪只个体; t表示当前所记录的系统时间; xit和yit表示猪只椭圆中心坐标像素点的值; θ表示当前猪只椭圆长轴的角度。

|

图 3 猪只状态参量示意图 |

绘制猪只视频的运动历史图(Motion History Image,MHI),如图 4所示,摄像机拍摄帧率为25 frame/s,如此短的时间内猪只个体的位置变化非常微小,因此算法中每只猪只始终能在下一帧中找到唯一最小欧氏距离的猪只与它匹配。由于猪只有自身宽度,对于不同采样频率,只要上下两采样帧之内运动的位置变化小于1/8身长(约等于1/2身宽)都不会导致此位置的猪只与旁边位置的猪只混淆。

|

图 4 运动历史图(MHI) |

为了增强跟踪算法对识别出错帧的适应性,跳过识别出错帧,后续帧只要猪只运动在附近1/8身长的范围内,算法仍然能够找回目标。对猪只运动历史图进行统计,找出运动位移小于1/8身长的最大帧数作为重初始化阈值σ,即只有连续大于σ帧检测出错,算法才认为目标丢失。

猪只身长采用自适应方法获取,根据所拟合的椭圆pit获得每只猪身长Lit,因此算法也适用于同一个场景中存在尺寸大小差异比较大的不同猪只。

实际应用中,猪场会面临瞬间光照突变等噪声,虽然1.1节所采用的颜色通道选择、环境消噪等目标识别技术能够在一定程度上避免光照影响,但偶尔午后大块的光照色斑仍然会引起算法误判,如图 5所示,算法将大块的光照色斑误认为猪只目标。由于猪场猪只圈养、栏内数量固定,且隔帧之内猪只运动不会突变,本文利用上下两帧的运动关联将光斑噪声去除。

|

图 5 光斑影响算法误判 |

具体算法过程如下:

输入 视频当前帧。

输出 视频状态变量序列。

Step1 系统初始化猪只运动状态变量pit、结构体容器P与每帧存放猪只信息的临时变量ptemp,获取所有猪只身长Lit,设定重初始化阈值σ。读入第一帧时,根据检测算法得到的猪只椭圆的个数n随机派号 p1t,p2t,…,pnt,每个猪只个体的信息都放入容器P中。

Step2 读入下一帧,若检测算法再次得到相同的猪只椭圆个数n,用临时变量ptemp存放每个猪只个体的信息。容器P中每个pit=(xit,yit,θit)都与此帧的每个临时变量ptempt+1=(xtempt+1,ytempt+1,θtempt+1)计算欧氏距离,式为:

| $\Delta =\sqrt{{{({{x}_{temp}}^{^{t+1}}-{{x}_{i}}^{t})}^{2}}+{{({{y}_{temp}}^{t+1}-{{y}_{i}}^{t})}^{2}}}$ |

若Δ满足Δ< Lit/8,则猪只跟踪匹配成功,用pit的标号i替换ptempt+1的标号temp,并用已完成匹配标号的ptempt+1替换pit更新容器P,以便再下一帧的匹配;匹配不成功,则容器P依旧保留旧值pit。

若检测算法在此帧得到的猪只椭圆个数为m(m>n),则上下两帧的每个pit与ptempt+1匹配成功后会有多余的(m-n)个ptempt+1目标剩余,则此剩余的ptempt+1为噪声点,不作匹配,不放入容器P中,此帧匹配成功。

若检测算法在此帧得到的猪只椭圆个数为z(z<n),则上下两帧的每个pit与ptempt+1匹配成功后会有多余的(n-z)个pit目标剩余,则此剩余的pit为此帧未能检测到的上一帧的猪只目标,pit不作匹配保留旧值,且它在容器P中的值维持不变,此帧匹配成功。

Step3 重复Step2中的过程,不断利用上一帧的pit得到当前帧的Pit+1,直到用户退出系统。

Step4 如果Step2中出现连续匹配不成功的pit次数大于σ帧,则等待(2*σ)帧后返回Step1重初始化,记录重初始化的时间点与重初始化的次数。

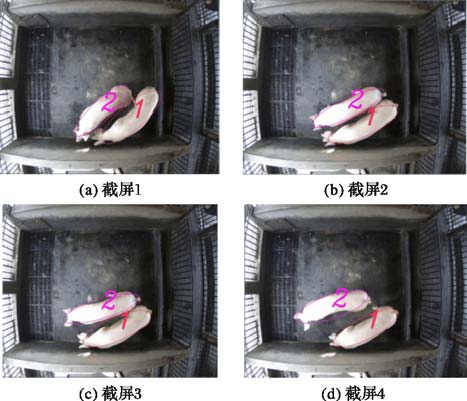

跟踪效果如图 6所示(为某个时刻每隔40帧的效果截图)。

|

图 6 跟踪算法效果 |

跟踪猪只的同时,根据猪只状态参量Pit提取每只猪的运动位移s、速度v、加速度a和角速度ω作为猪只运动特征数据,运动参量V可用以下四元组表示。

V=(s,v,a,ω)

采集运动参量V的意义如下:

1) 4个参量不同的数据组合可识别猪只各种采食、排泄、站立、趴窝、慢走和跑动等行为[7-9]。

2) 4个参量也分别对应不同的应用价值:某段时间的运动位移累加量可反映猪只此段时间的日常运动量;运动速度可反映猪只打架[4]、侵略、病变等行为;运动加速度模仿三轴加速度传感器的效果,对猪只日常行为[7]、特殊阶段行为(如母猪产前各行为的加速度明显不同于平常时刻[11])、步态分析(猪只病变跛行[3])、计步[12]等具有重要的应用价值;运动角速度可协助判断猪只咬尾旋转等。

3) 通过长时间的采集、存储可形成记录猪只运动的运动数据库,此数据库可作为进一步猪只日常行为分析的基础。应用时可根据不同的应用需求多次直接调用数据库内的结果,而不需要重新从视频采集和避免多次重复计算。

四个运动参量的具体算法如下:

位移表示猪只由初位置到末位置的位置变化。t时刻猪只的位置为(xit,yit),t+1时刻猪只的位置为(xit+1,yit+1),则t时刻的状态到t+1时刻的状态的猪只位移可以表示为式(8):

| $s=\sqrt{{{({{x}_{i}}^{t+1}-{{x}_{i}}^{t})}^{2}}+{{({{y}_{i}}^{t+1}-{{y}_{i}}^{t})}^{2}}}$ | (8) |

本实验所用的摄像机帧率为25 frame/s,t与t+1的时间差非常小,位移s可以等同于路程。

速度表示猪只运动的快慢,数值上等于单位时间内通过的路程。t时刻猪只的位置为(xi,yi),t+1时刻猪只的位置为(xit+1,yit+1),Δt表示t与t+1的时间差,则t时刻状态到t+1时刻状态的猪只运动速度v可以表示为式(9):

| $v=\frac{1}{\Delta t}\sqrt{{{({{x}_{i}}^{t+1}-{{x}_{i}}^{t})}^{2}}+{{({{y}_{i}}^{t+1}-{{y}_{i}}^{t})}^{2}}}$ | (9) |

加速度表示单位时间内猪只速度改变的快慢。t时刻猪只的速度为vit,t+1时刻猪只的速度为vit+1,Δt表示t与t+1的时间差,则此时猪只的运动加速度a可以表示为式(10):

| $a=\frac{1}{\Delta t}|{{v}_{i}}^{t+1}-{{v}_{i}}^{t}|$ | (10) |

角速度表示猪只运动角位移的时间变化率,用于描述猪只转动速度变化的快慢。t时刻的角度为θit,t+1时刻的角度为θit+1,Δt表示t与t+1的时间差,则t时刻的状态到t+1时刻的状态的角速度ω可以表示为式(11):

| $\omega =\frac{1}{\Delta t}|{{\theta }_{i}}^{t+1}-{{\theta }_{i}}^{t}|$ | (11) |

在广州市力智猪场种猪室做了7次实验:实验①~⑥为不同日期、不同时间段的猪场情景;实验⑦为暴雨天气清晨没有光照时的猪场情景。实验分别对猪只检测、状态参量和运动参量提取进行了测试。系统在7次实验的时候都在后台对算法每个处理过程的中间结果以单帧图像的形式保存以便数据的统计和分析。

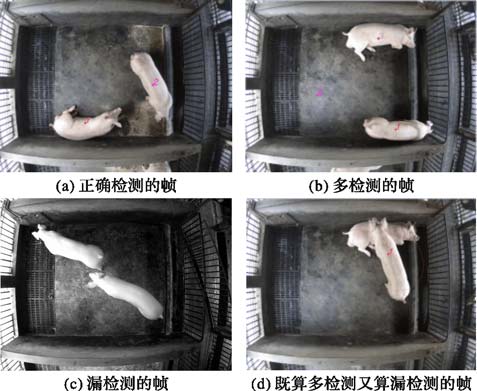

2.1 猪只识别测试应用猪只椭圆拟合后的效果图对猪只检测结果进行统计。人工统计实验①~⑦中所有检测结果。如图 7所示,只有拟合的椭圆正确圈住猪只且猪只标号正确时此帧才被认为是正确检测的帧;错误圈住其他非猪只物的帧体被认为是多检测的帧;有猪只未被椭圆圈住的帧被认为是漏检测的帧; 一个椭圆同时圈住多头猪只的帧既被认为是多检测的帧也被认为是漏检测的帧。7次实验的统计结果见表 1。

|

图 7 正确识别的帧和错误识别的帧 |

| 表 1 实验统计结果 |

用信息检索(Information Retrieval,IR)的评价指标对实验结果作评价,如图 8所示,A表示猪只被算法检测出来了,D表示非猪只未被算法认为是猪只,所以A和D都被认识是正确检测,B为多检测,C为漏检测。召回率、精确率和正确率的公式为(12)~(14)。7次实验的召回率、精确率和正确率见表 1。

|

图 8 信息检索(IR)的评价指标 |

| $\text{召回率}\left( \operatorname{Re}call \right)=\frac{A}{A+C}=\frac{\text{正确检测到猪只的帧}}{\text{总帧数}}$ | (12) |

| $\text{精确率}\left( \Pr ecision \right)=\frac{A}{A+B}=\frac{\text{正确检测到猪只的帧}}{\text{算法检测到猪只的帧}}$ | (13) |

| $\text{正确率}\left( Accuracy \right)=\frac{A+D}{A+B+C+D}=\frac{\text{正确的帧}}{\text{总帧数}}$ | (14) |

统计发现,算法由于采用了颜色通道选择、环境消噪、上下两帧的运动关联等技术手段,对光照变化适应性较强,一天内不同时间段的光照变化未对算法造成影响,实验①~⑥中未发现因光照而出错的帧;实验⑦中全段视频未能正确检测到猪只(如图 6(c)所示),原因是此时段外界几乎没有光源,摄像机内置红外功能,所以视频呈现的是黑白影像,本文算法采用颜色特征作猪只检测,缺少光源会使猪只颜色特征失效;实验①~⑥中多检和漏检的帧数一样多,因此召回率、精确率和正确率相等,出错原因都是猪只出现了严重的遮挡(如图 6(d)所示),算法还无法解决遮挡难题,遮挡也是计算机视觉研究中的难题之一。

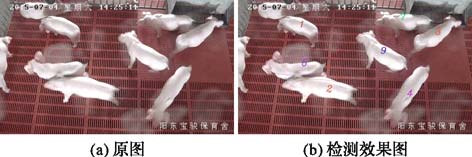

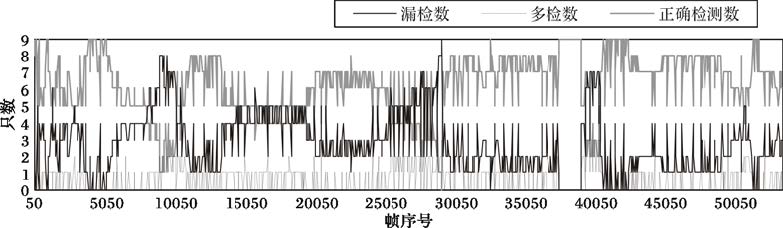

根据对保育猪长达1周的考察,保育猪比成年种猪更为活跃,14:30—15:30为保育猪最活跃的时段,也是一天中阳光最猛烈的时刻。为了检验算法对多猪只与在强烈阳光下的检测效果,于2015年07月04日14:24—15:08对广东省阳江市阳东宝骏猪场保育室的9只保育猪进行了约40 min共53 246帧视频的测试。如图 9所示,9只猪只活跃奔跑,强烈的阳光在地面形成多处大块光斑。人工对约54 000帧中每隔50帧的检测结果进行每帧的漏检测和多检测只数统计,统计结果如图 10所示。

|

图 9 多猪只检测结果 |

|

图 10 每帧识别结果统计 |

统计发现,算法能正确检测大部分猪只;未发现由于大块的阳光光斑而造成多检的猪只;算法漏检和多检主要原因如下:

1) 猪只跑到边角位置时漏检。由于阳东宝骏猪场保育室房顶较矮(5 m×5 m×3 m),摄像机非广角镜头,边角位置拍摄不全,猪只处于边角位置时由于出镜面积过小,会被算法当作噪声过滤掉;

2) 保育猪只非常活跃,多只猪只拥挤成团、遮挡频繁时,出现漏检又多检。

2.2 状态参量测试通过系统后台记录的重初始化次数能够检验基于最短距离匹配法的跟踪情况,7次实验跟踪过程中的重初始化次数见表 1。

重初始化次数越多表明跟踪算法失败次数越多。实验⑦识别算法全程未成功识别到猪只,所以跟踪算法全程失效,9 min内不断重初始化;实验②、③、⑥中,识别算法全程都能正确识别猪只,所以未重初始化;实验①、④、⑤中重初始化都发生在识别算法出错的帧中。由此可知,识别算法直接影响跟踪算法。需要注意的是,并不是所有识别错误的帧都会导致跟踪算法失效,本文的跟踪算法采用了短时间自纠正技术,σ值取30,在连续识别出错30帧以上才会失效,连续检测出错的帧在30帧内算法依旧能够跟踪猪只。

实验对完全成功进行猪只识别的实验②中3 001帧图像进行手工标注,在Matlab中编写测试代码,手工用鼠标对准猪只画椭圆和从猪只的头部到猪只的尾巴画直线,然后程序后台通过实验人员的操作获取鼠标所画椭圆的圆心坐标和所画直线的角度信息,最后比对实验人员手工标记的pit与本文系统所测得的pit。以相对误差作为误差计算标准,相对误差的计算如式(15)所示:

| $\sigma =\frac{|H-S|}{H}*100%$ | (15) |

其中:H表示手工测量值;S表示系统测量值。误差统计结果见表 2。本文认为误差率小于5%的帧都算是正确的帧。

| 表 2 误差统计 |

实验显示状态参量pit的正确率为99.2%;正确识别目标的前提下,x和y坐标的误差率非常低,为正确提取猪只运动参量的位移s、速度v和加速度a提供了保证;θ的误差率相对较高,而θ只对角速度ω的计算带来误差。猪只状态参量pit的误差主要来源于以下两个方面:

1) 目标检测模块环境去噪时的腐蚀阈值是根据实验过程中对大量视频观察所得的经验值进行设定的,对猪只目标进行腐蚀时由于不同的环境噪声使得腐蚀结果与真实猪只的图像有偏差,从而造成目标位置与角度的误差。

2) 实验人员手工标注数据时存在误差。

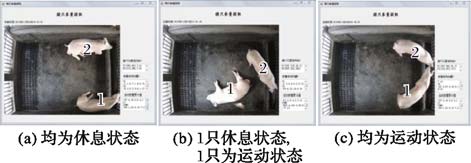

2.3 运动参量测试在实验①~④中抽取18个小片段(每段时长约20 s)进行运动参量提取算法的测试,这些小片段如图 11所示,主要分为三组:(a)2只猪都处于休息状态;(b)1只猪处于休息状态另1只处于运动状态;(c)2只猪都处于运动状态。实验分别比较了4种数据:各时刻运动位移的累加量、运动速度、运动加速度、运动角速度。

|

图 11 不同状态猪只的视频片 |

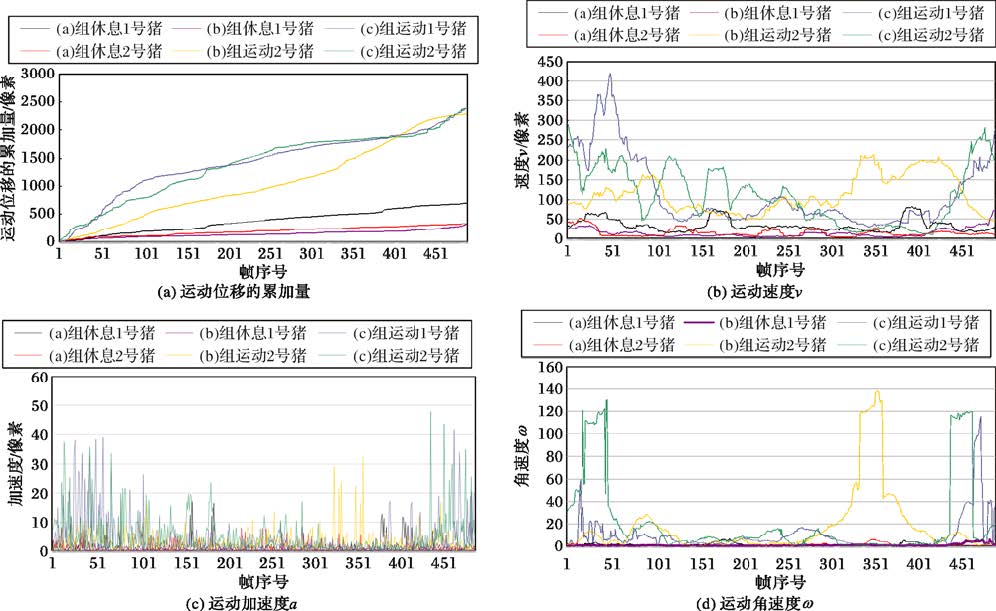

图 12展示的是4个参量的统计图,不同的猪只运动状况会得出不同的具体数值,所以不关注各帧的具体数值,重点关注运动猪只与休息猪只的总体趋势。

|

图 12 各个运动参量统计 |

图 12(a)中是运动位移的累加量,可以看出一段时间内运动的猪只的位移量明显高于休息的猪只;图 12(b)中是每只猪每帧的运动速度v,运动状态猪只比休息状态猪只的数值大,运动状态猪只的参量跟随猪只不同的运动状态呈现不同的波动,休息状态猪只的参量数值小、波动性较平缓;图 12(c)中是每只猪每帧的运动加速度a,运动状态猪只数值大,猪只从静止到开始运动的瞬间和步行时步间的加速度非常大(计步器原理[14]),因此呈现出尖锐的曲线,休息状态的猪的数值几乎接近0;图 12(d)中是每只猪每帧的运动角速度ω, 休息状态猪只的角速度接近0表明猪只没有发生转动,猪只在做转动运动时角速度值明显增大。

总体来看:(a)组处于休息状态猪只的运动参量V的各个数值都很低接近于0;(c)组处于运动运动状态猪只的运动参量V的各个数值都比较高;(b)组运动状态猪只的运动参量V的各个数值明显比另一只休息状态下猪只的运动参量V的各个数值高很多。

3 结语利用课题组前期的猪场远程监控系统实时捕获视频进行分析,成功读取视频后进行了猪只识别和状态参量及运动位移、运动速度、运动加速度和运动角速度4个运动参量的提取。对自然条件下的猪场现场进行了8次实验,结果表明,所提出的猪只识别与跟踪方法对大部分猪只运动场景中的轻度粘连、光照变化等都有较好的处理效果,但无外界光源时算法会失效,本文下一阶段将通过红外等相关手段尝试解决。参量提取算法所提取的运动参量能够有效地反映猪只运动,能够为本课题组接下来的猪只行为识别研究提供数据基础。检测算法的正确率决定了跟踪算法、状态参量与运动参量提取的准确率,而本文未能解决遮挡难题,使算法能够抵抗遮挡实现长时间无间断的猪只运动参量提取将是下一阶段的工作重点。

| [1] |

林英禄. 运动数据的实时监测与健康评价模型的研究[D]. 上海:华东师范大学, 2015:1-85.

( LIN Y L. Real-time sports data monitoring and research of fitness evaluation model[D]. Shanghai: East China Normal University, 2015:1-85.

) ( 0) 0)

|

| [2] |

蔡美玲. 三维人体运动分析与动作识别方法[D]. 长沙:中南大学, 2013:1-137.

( CAI M L. 3D human motion analysis and action recognition[D]. Changsha: Central South University, 2013:1-137.

) ( 0) 0)

|

| [3] |

ZHU W X, ZHOU J J, WU Y. Gait abnormality detected of pigs based on machine vision[J].

Applied Mechanics and Materials, 2014, 614 : 432-435.

doi: 10.4028/www.scientific.net/AMM.614 ( 0) 0)

|

| [4] |

OCZAK M, ISMAYILOVA G, VIAZZI S. Analysis of aggressive behaviours of pigs by automatic video recordings[J].

Computers and Electronics in Agriculture, 2013, 99 : 209-217.

doi: 10.1016/j.compag.2013.09.015 ( 0) 0)

|

| [5] |

VIAZZI S, ISMAYILOVA G, OCZAK M. Image feature extraction for classification of aggressive interactions among pigs[J].

Computers and Electronics in Agriculture, 2014, 104 : 57-62.

doi: 10.1016/j.compag.2014.03.010 ( 0) 0)

|

| [6] |

杨威, 俞守华. 视频监控技术在生猪规模化养殖中的应用[J].

现代农业装备, 2014 (4) : 37-41.

( YANG W, YU S H. Video surveillance technology in large-scale pig farming[J].

Modern Agricultural Equipments, 2014 (4) : 37-41.

) ( 0) 0)

|

| [7] |

高云.基于无线传感器网络的猪运动行为监测系统研究[D]. 武汉:华中农业大学, 2014:1-174.

( GAO Y. Study of pig behavior monitoring system based on WSN[D]. Wuhan: Huazhong Agricultural University, 2014:1-174.

) ( 0) 0)

|

| [8] |

刘龙申, 沈明霞, 姚文, 等. 基于加速度传感器的母猪产前行为特征采集与分析[J].

农业机械学报, 2013, 44 (3) : 192-196.

( LIU L S, SHEN M X, YAO W, et al. Acquisition and analysis of sows' behavior before farrowing based on acceleration sensor[J].

Transactions of the Chinese Society of Agricultural Machinery, 2013, 44 (3) : 192-196.

) ( 0) 0)

|

| [9] |

尹令, 刘财兴, 洪添胜, 等. 基于无线传感器网络的奶牛行为特征监测系统设计[J].

农业工程学报, 2010, 26 (3) : 203-208.

( YIN L, LIU C X, HONG T S, et al. Design of system for monitoring dairy cattle's behavioral features based on wireless sensor networks[J].

Transactions of the Chinese Society of Agricultural Engineering, 2010, 26 (3) : 203-208.

) ( 0) 0)

|

| [10] |

YU S H, CHEN J H, OU J Y, et al. Multi-target tracking based on regional correlation and color histogram match[J].

Advanced Materials Research, 2014, 998/999 : 631-637.

doi: 10.4028/www.scientific.net/AMR.998-999 ( 0) 0)

|

| [11] |

WEI X Q, JIA K, LAN J H. Automatic method of fruit object extraction under complex agricultural background for vision system of fruit picking robot[J].

Optik — International Journal for Light and Electron Optics, 2014, 125 (19) : 5684-5689.

doi: 10.1016/j.ijleo.2014.07.001 ( 0) 0)

|

| [12] |

周丽萍, 陈志, 陈达, 等. 基于改进Otsu算法的生猪热红外图像耳根特征区域检测[J].

农业机械学报, 2016, 47 (4) : 228-232.

( ZHOU L P, CHEN Z, CHEN D, et al. Pig ear root detection based on adapted Otsu[J].

Transactions of the Chinese Society for Agricultural Machinery, 2016, 47 (4) : 228-232.

) ( 0) 0)

|

| [13] |

KASHIHA M A, BAHR C, OTT S. Automatic monitoring of pig locomotion using image analysis[J].

Livestock Science, 2014, 159 : 141-148.

doi: 10.1016/j.livsci.2013.11.007 ( 0) 0)

|

| [14] |

宋浩然, 廖文帅, 赵一鸣. 基于加速度传感器ADXL330的高精度计步器[J].

传感技术学报, 2006, 19 (4) : 1005-1008.

( SONG H R, LIAO W S, ZHAO Y M. Using 3-axis accelerometer ADXL330 to high accuracy pedometer[J].

Chinese Journal of Sensors and Actuators, 2006, 19 (4) : 1005-1008.

) ( 0) 0)

|