2. 智能信息处理与实时工业系统湖北省重点实验室(武汉科技大学), 武汉 430065

2. Hubei Province Key Laboratory of Intelligent Information Processing and Real-time Industrial Systems (Wuhan University of Science and Technology), Wuhan Hubei 430065, China

基于内容的图像检索一直是图像处理领域的研究热点,图像检索中至关重要的步骤取决于图像特征的提取和相似性算法。基于内容的图像检索主要通过分析视觉内容来查询图像,因此图像的特征表示是图像检索的重点。在过去的十几年中,提出了各种低层特征的表示,有颜色特征,边缘特征,纹理特征,文本特征等基于图像全局的特征,还有SIFT(Scale-Invariant Feature Transform)[1],SURF(Speeded Up Robust Feature)等基于图像局部的特征。传统的图像检索通常选择严格的距离函数作为相似性算法,在底层特征上用做相似性的检索,然而严格的距离函数在复杂的视觉图像检索任务中并不总是最优的[2]。尽管各种各样的技术被提出来,但是图像的底层视觉特征和图像的高层语义仍然存在着“语义鸿沟“的问题。最近受到深度学习的影响,通过探索先进的深度网络学习特征表示和相似的技术,希望利用深度学习技术在图像检索上缩小图像底层和高层之间的语义鸿沟[3]。本文前期工作主要研究了多模态图像特征的综合分析和语义理解[4, 5],并且在图像聚类和检索应用中取得了较好的效果;然而,其局限性在于很大程度上依赖于人工选择的初始特征,而忽略了特征的自动选择和优化。针对上述问题,本文提出了基于深度特征分析的双线性图像相似度匹配算法,不仅可以通过深度神经网络的方法自动地优化特征选择,而且还通过双线性相似度算法更好的表示了图像之间的相似度。本文从深度网络中提取图像的特征,采用双线性的相似性度量方法进行图像检索。实验结果表明,本文方法明显的提高了图像检索的精度。

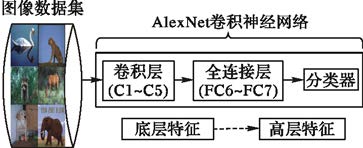

1 基于卷积神经网络的特征提取深度网络广泛应用在图像检索,模式识别,自然语言处理等各个领域,并取得了巨大的成功[6]。深度网络成功的原因主要是一方面增加了深度网络的复杂性,使得网络变得更有能力拟合训练数据,另一方面则是设计了有效的策略去解决过拟合等问题。深度网络具有强大的学习能力和高效的特征表达能力,更重要的优点是从像素级原始数据到抽象的语义概念逐层提取信息,这使得它在提取图像的全局特征和上下文信息方面具有突出的优势[7]。本文采用的是深度网络中的卷积神经网络,其中卷积层(Convolution,C),池化层以及全连接层(Full Connection,FC)是卷积神经网络的重要组成部分。

卷积层的特征提取利用了自然图像的统计平稳性,上一层的特征被一个可学习的卷积核进行卷积,然后通过一个激活函数,就可以得到输出特征图[8-9]。每一个输出特征图可能是组合卷积多个输入特征图的值。若输入的图像样本为$\left( {{x_1},{x_2}, \cdots ,{x_i}} \right)$,卷积层提取特征的过程如式(1)所示:

| $x_j^l = f\left( {\sum\limits_{i \in {M_j}} {x_j^{l - 1}} *k_{ij}^l + b_j^l} \right)$ | (1) |

其中:l表示层数,k表示由l层到l+1层要产生的特征的数量,表示“卷积核“,b表示偏置,Mj表示选择的输入特征图的集合,f是激活函数,通常采用非线性激活函数Relu(Recitified linear Unit),Relu定义如式(2)所示:

| $f({x_i}) = \max \left( {0,{x_i}} \right)$ | (2) |

池化层是在卷积特征提取的基础上,对每个卷积得到的特征进行取平均,减小卷积层输出特征向量的维数,同时改善结果防止过拟合。

本文采用的卷积神经网络模型来自ILSVRC-2012竞赛中赢得第一名的网络模型 AlexNet,此模型针对图像增强采用了两种策略:第一种形式是人为的扩大数据集,通过对图像数据集进行变换和水平反射;第二种形式是对数据进行增强,改变训练图像中RGB(Red-Green-Blue)通道的强度[10]。另外针对模型过拟合,提出了一种叫做“Dropout”的技术,它做的就是以0.5的概率将每个隐层神经元的输出设置为零,每次提出一个输入,该神经网络就尝试一个不同的结构,但是所有这些结构之间共享权重。因为神经元不能依赖于其他特定神经元而存在,所以这种技术降低了神经元复杂的互适应关系,学习更为鲁棒的特征。

如图 1所示,AlexNet卷积神经网络共有8层,其中C1~C5分别代表 5个卷积层,FC6和FC7分别代表2个全连接层,和1个分类器。为了更好的适应新的数据集,本文使用微调[11](fine-tuning)的方法,即在原有的网络上,修改最后一层分类器的输出,调整为本文实验中图像数据集的类别个数,然后使用原模型的网络参数进行初始化,再用本文的图像数据集在原模型上进行重新训练。

|

图 1 基于卷积神经网络的特征提取 |

由于AlexNet模型所要求输入图像的尺寸是固定的,所以在输入训练数据前,需要将图像数据集中图像的尺寸调整为模型所要求的输入尺寸,本文中模型的输入尺寸是227×227。卷积神经网络可以从图像中提取较好的语义信息,并且在图像检索,图像识别中得到不错的效果。根据文献[12]中的结论,卷积神网络层数越深,提取的图像特征的语义表示更好,由于最后一层是分类器,本文实验中提取第七层全连接层的特征,其特征维数是4096,作为图像检索的特征。

2 双线性相似性度量传统的图像检索中的相似性度量方法,如欧氏距离,马氏距离[12]等距离度量方法,其需要满足距离度量的很多条件,如非负性、对称性、三角不等式等。为了满足这些特征,需要付出很多代价,如固定距离,就不能适应特征的特性。而传统的距离度量方法因为要满足距离的条件,所以会在原来的模型上加以另外的限制条件,增加了模型的复杂度。同时对于很多传统的距离度量方法,因为有距离的概念,在样本扰动一点,其距离相差不大,难以区分不同类的图像[13]。

本文采用双线性相似性度量(Bilinear Similary Measure,BSM),该方法被成功用于图像检索领域[14],相对传统的距离度量方法,抛弃了距离度量的限制条件。双线性相似性度量算法通过学习到一个成对的相似性函数S,输入Pi,Pj是两个样本图片的特征向量,输出是两个样本的相似度,S函数表示如式(3)所示:

| ${S_W}({p_i},{p_j}) = p_i^{\rm{T}}W{p_j},W \in {R^{dxd}}$ | (3) |

其中:W就是本文要学习的矩阵,此算法旨在学习利用双线性相似性度量表示稀疏特征。P假设三个样本为一组,分别是$({p_i},p_i^ + ,p_i^ - )$,其中${p^ + }$,${p^ - }$是同一类样本,而$p$,${p^ - }$是不同类的样本。该模型定义了一个间隔,目的是为了使同类的相似度大于异类的相似度,如式(4)所示:

| ${S_W}({p_i},p_i^ + ) > {S_W}({p_i},p_i^ - ) + 1$ | (4) |

由于一般情况下很难满足上述条件,此时增加一个损失函数,该损失函数为铰链损失(hinge loss),如式(5)所示:

| ${l_W}({p_i},p_i^ + ,p_i^ - ) = \max \left\{ {0,1 - {S_W}\left( {{p_i},p_i^ + } \right) + {S_W}\left( {{p_i},p_i^ - } \right)} \right\}$ | (5) |

对于大量的样本,铰链损失函数如下式(6)所示:

| ${L_W} = \sum\limits_{\left( {{p_i},p_i^ + ,p_i^ - } \right) \in P} {{l_W}\left( {{p_i},p_i^ + ,p_i^ - } \right)} $ | (6) |

为了是损失函数最小,BSM 算法采用PA(Passive Aggressive) [15]算法去迭代训练W,W最初赋值为${W^0}$,对于每次迭代,本文随机选择三个样本$({p_i},p_i^ + ,p_i^ - )$,解决下面的凸模型:

| ${W^i} = \arg \min \frac{1}{2}||W - {W^{i - 1}}||_{Fro}^2 + c\xi $ | (7) |

| ${l_W}({p_i},p_i^ + ,p_i^ - ) \le \xi and \xi \ge 0$ | (8) |

其中:$||.|{|_{Fro}}$是Frobenius范数,也称为L2范数。因此,在第$i$次迭代中,${W^i}$是权衡两部分的效果,一部分是与前一次的${W^{i - 1}}$要尽量靠近,另一部分是损失函数要小,利用参数c来控制两部分的权衡效果,式(8)是式(7)中的约束条件,本文所提出的BSM算法如算法1所示:

算法1 双线性相似性算法.初始化$W = {W^0}$,设置迭代次数n:重复下面迭代过程:

1) 随机挑选三张图片P,P+,P-满足${S_W}({p_i},p_i^ + ) > {S_W}({p_i},p_i^ - )$. 2) 更新${W^i} = {W^{i - 1}} + {\lambda _i}{V^i}$

其中: ${\lambda _i} = \min \left\{ {C,\frac{{{l_{{W_{i - 1}}}}\left( {{p_i},p_i^ + ,p_i^ - } \right)}}{{||{V^i}|{|^2}}}} \right\}$

${V^i} = {\left[ {p_i^l(p_k^ + - p_k^ - ),...,p_i^d(p_k^ + - p_k^ - )} \right]^{\rm{T}}}$

3) 直到达到迭代次数n为止,得到W矩阵。

得到W后,通过式(3)计算图像间的相似度值,值的大小表示图像的相似度,值越大,图像间的相关性越大,反之相关性越小。

3 实验与分析本文实验采用的数据集源自加州理工大学Greg Griffin等人收集并公开Caltech101数据集[16]和Caltech256数据集[17]。其中Caltech101数据集总共9145幅图像,共有102个类别,包含的类别有飞机,熊猫,袋鼠等。Caltech256数据集总共有30607张图片,共有257个类别,包含有汽车,手表,马等。本文实验中图像检索性能的评价指标有查准率(Precesion),平均查准率(mean Average Precison,mAP),以及查全率(Recall)[18]。

3.1 实验结果和性能对比在Caltech101上,每类抽取30张作为训练集,用来在AlexNet模型上进行微调训练,剩下则作为测试集。本文方式采用卷积神经网络提取的特征和BSM相似度算法来进行检索,其中CNN表示提取网络第七层的特征,BSM表示双线性相似性度量方法,E表示欧氏距离的度量方法。对所有类别进行测试后,平均查准率如表 1所示.

| 表 1 Caltech101中平均查准率对比(%) |

表 1中的结果表明,基于卷积神网络提取的特征,使用BSM相似性算法的平均查准率要比欧氏距离高18.04%,这说明本文采用BSM相似性算法在图像检索的平均查准率上要明显好于传统的距离度量算法。

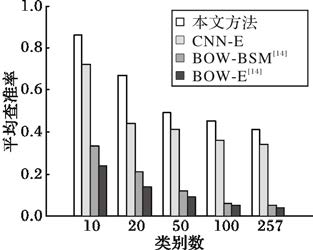

在Caltech256数据集上,每类取70%的样本作为训练集,30%的样本作为测试集。本文分别选取了10类,20类,50类,100类,以及257类进行实验,其中BOW(Bag-of-Words)算法是基于SIFT特征然后构建字典表示[19-20],如图 2所示,Caltech256图像数据集上类别总数不同的平均查准率.

|

图 2 不同类别总数下的平均查准率对比 |

从图 2中可以看出随着测试类别总数的增加,图像检索返回不相关的图像会增加,图像检索的平均查准率有所下降。本文提出的BSM算法在基于卷积神经网络提取的特征或者传统方法提取的特征上的平均查准率都要明显高于传统的欧氏距离,表明BSM算法能够有效的区别图像间的相关性。同时基于卷积神经网络提取的特征要明显好于传统的SIFT特征,因为卷积神经网络从像素级原始数据到抽象的语义概念逐层提取信息,这使得它在提取图像的全局特征和上下文信息方面相比传统的特征提取方法具有突出的优势,在一定程度上缩小了图像的底层视觉特征和图像的高层之间的“语义鸿沟“。

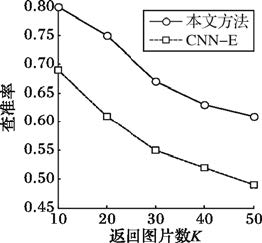

查准率一般采用TopK来作为评价指标,即返回K张图片,返回的结果中有多少和查询实例是一类的。在Caltech101整个数据集上,分别选取返回10张,20张,30张,40张,50张时进行查准率的比较,如图 3所示.

|

图 3 Caltech101中TopK查准率对比 |

从图 3可以看出,随着返回的图像增多,图像检索返回的不相关的图像概率也变大,所以图像检索的查准率会有所下降。同时可以看出,在基于卷积神经网络提取的图像特征上,本文提出的BSM算法的查准率明显高于传统的欧氏距离。

在Caltech256数据集上,本文实验分别选取了20个类别,50个类别进行实验,并且分别测试TopK=1,TopK=10,TopK=50的时候检索结果,其中BOW模型的实验结果来自文献[14],如表 2所示.

| 表 2 Caltech256中TopK查准率对比(%) |

从表 2可以看出随着类别的总数增多,TopK查准率有所下降,同时随着TopK返回的图像越多,TopK的查准率也会有所下降,表明查准率和返回的图像数目,以及查询的图像总类相关。从表中的数据可以看出,基于卷积神经网络提取的特征在图像检索的查准率上远远高于传统提取特征方法,同时BSM算法在相同的特征提取方法下也明显好于传统的欧氏距离。

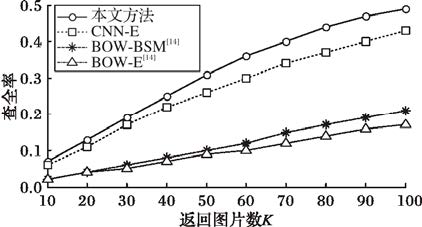

在Caltech256数据集上,对所有类别进行检索。从图 4可以看出,随着返回图片的总数增加,查全率逐渐升高。从图中的数据可以看出,基于卷积神经网络的提取的图像特征要明显好于传统的特征提取方法,同时本文提出的BSM算法的查全率也优于传统的欧氏距离相似度算法。

|

图 4 Caltech256中查全率的对比 |

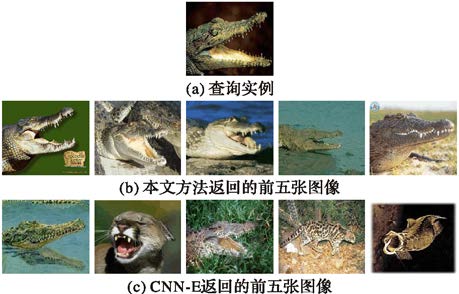

分别在Caltech256和Caltech101图像数据集上根据查询实例列出前五的检索结果如图 5~图 6,从左到右为返回次序。

|

图 5 Caltech256图像数据集返回的前五张图像对比 |

|

图 6 Caltech101 图像数据集返回的前五张图像对比 |

从图 5~图 6中检索实例的结果可以看出,BSM相似性算法返回的结果全是正确的,检索精度很高,而欧氏距离返回的结果中,大部分都不是和查询图片一个类别,检索精度很低。Caltech256上欧氏距离返回的只有两个正确,其他三个都是错误类别,而在Caltech101上,欧氏距离返回的有三个正确,其他两个是错误的类别,表明随着图像数据集类别总数的增多,返回不相关的图像几率也会增大。

4 结语本文采用了深度神经网络来对图像进行特征的提取,利用双线性相似度算法对图像数据集进行图像检索。实验结果表明,在相同相似性度量算法的条件下,基于微调的深度网络的图像特征相比传统的特征提取方法有很大的提升,表明基于深度网络提取的特征有着更好的表示,深度网络的图像特征能够明显的提升检索效果。本文采用的双线性相似度算法,相比传统的欧氏距离,在深度图像特征上有着更好的检索效果。本文下一步的工作是在更深的网络模型上进行图像的特征提取,以及使用更好的相似性算法等方向探索,进一步获得更好的图像检索效果。

| [1] |

LOWE D G. Distinctive image features from scale-invariant key-points[J].

International Journal of Computer Vision, 2004, 60 (2) : 91-110.

doi: 10.1023/B:VISI.0000029664.99615.94 ( 0) 0)

|

| [2] |

何云峰, 周玲, 于俊清, 等. 基于局部特征聚合的图像检索方法[J].

计算机学报, 2011, 34 (11) : 2224-2233.

( HE Y F, ZHOU L, YU J Q, et al. Image retrieval based on locally features aggregating[J].

Chinese Journal of Computers, 2011, 34 (11) : 2224-2233.

) ( 0) 0)

|

| [3] |

BENGIO Y, COURVILLE A, VINCENT P. Representation learning: a review and new perspectives[J].

IEEE Transactions on Pattern Analysis & Machine Intelligence, 2013, 35 (8) : 1798-828.

( 0) 0)

|

| [4] |

张鸿, 吴飞, 张晓龙. 基于关系矩阵融合的多媒体数据聚类[J].

计算机学报, 2011, 34 (9) : 1705-1711.

( ZHANG H, WU F, ZHANG X L. Multimedia data clustering based on correlation matrix fusion[J].

Chinese Journal of Computers, 2011, 34 (9) : 1705-1711.

) ( 0) 0)

|

| [5] |

ZHANG H, GAO X, WU P, et al. A cross-media distance metric learning framework based on multi-view correlation mining and matching[J].

World Wide Web, 2016, 19 (2) : 181-197.

doi: 10.1007/s11280-015-0342-4 ( 0) 0)

|

| [6] |

BECKER B C, ORTIZ E G. Evaluating open-universe face identification on the Web[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Washington, DC: IEEE Computer Society, 2013:904-911.

( 0) 0)

|

| [7] |

DENTON E, ZAREMBA W, BRUNA J, et al. Exploiting linear structure within convolutional networks for efficient evaluation[EB/OL].[2015-10-10]. machinelearning.wustl.edu/mlpapers/paper_files/NIPS2014_5544.pdf.

( 0) 0)

|

| [8] |

HINTON G, DENG L, YU D, et al. Deep neural networks for acoustic modeling in speech recognition: the shared views of four research groups[J].

IEEE Signal Processing Magazine, 2012, 29 (6) : 82-97.

doi: 10.1109/MSP.2012.2205597 ( 0) 0)

|

| [9] |

SIMARD P Y, STEINKRAUS D, PLATT J C. Best practices for convolutional neural networks applied to visual document analysis[C]//Proceedings of the 2003 International Conference on Document Analysis and Recognition. Washington, DC: IEEE Computer Society, 2003:958.

( 0) 0)

|

| [10] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[J].

Advances in Neural Information Processing Systems, 2012, 25 (2) : 2012.

( 0) 0)

|

| [11] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2014:580-587.

( 0) 0)

|

| [12] |

SIMON M, RODNER E, DENZLER J. Part detector discovery in deep convolutional neural networks[C]//Proceedings of the 12th Asian Conference on Computer Vision, LNCS 9004. Piscataway, NJ: IEEE, 2014:162-177.

( 0) 0)

|

| [13] |

WEINBERGER K Q, SAUL L K. Fast solvers and efficient implementations for distance metric learning[C]//Proceedings of the 25th International Conference on Machine Learning. New York: ACM, 2008: 1160-1167.

( 0) 0)

|

| [14] |

CHECHIK G, SHARMA V, SHALIT U, et al. Large scale online learning of image similarity through ranking[J].

The Journal of Machine Learning Research, 2010, 11 : 1109-1135.

( 0) 0)

|

| [15] |

CRAMMER K, DEKEL O, KESHET J, et al. Online passive-aggressive algorithms[J].

The Journal of Machine Learning Research, 2006, 7 : 551-585.

( 0) 0)

|

| [16] |

LI F F, FERGUS R, PERONA P. Learning generative visual models from few training examples: an incremental Bayesian approach tested on 101 object categories[J].

Computer Vision & Image Understanding, 2007, 106 (1) : 59-70.

( 0) 0)

|

| [17] |

ZHENG W S, GONG S, XIANG T. Unsupervised selective transfer learning for object recognition[C]//Proceedings of the 2010 Asian Conference on Computer Vision. Piscataway, NJ: IEEE, 2010:527-541.

( 0) 0)

|

| [18] |

DUVENAUD D, RIPPEL O, ADAMS R P, et al. Avoiding pathologies in very deep networks[EB/OL]. [2015-01-01]. http://arxiv.org/abs/1402.5836.

( 0) 0)

|

| [19] |

LI F F, PERONA P. A Bayesian hierarchical model for learning natural scene categories[C]//Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision & Pattern Recognition. Washington, DC: IEEE Computer Society, 2005:524-531.

( 0) 0)

|

| [20] |

顾昕, 张兴亮, 王超, 等. 基于文本和内容的图像检索算法[J].

计算机应用, 2014, 34 (S2) : 280-282.

( GU X, ZHANG X L, WANG C, et al. Image retrieval algorithm based on text and content[J].

Journal of Computer Applications, 2014, 34 (S2) : 280-282.

) ( 0) 0)

|