人脸识别问题,作为计算机视觉领域一个极为重要且基础的问题,近年来一直受到广大研究机构和公司的广泛关注。对于现代人脸识别方法来说,取得高人脸识别率的前提是获得高判别性和鲁棒性的重构系数[1-2]。

受人类视觉系统的稀疏性编码的启发[3],稀疏表示方法的核心思想是将某一图像向量表示成为对应训练字典中所有样本的稀疏线性组合的形式。近来,稀疏表示技术在人脸识别、手写字识别和自然环境图像分类等模式识别领域取得了令人欣喜的成绩[4]。基于稀疏理论的分类方法成功的关键在于,高维信号可以用位于低维流形的对应类内特征样本进行稀疏表示[5],与此同时,l0和l1范数最小化模型的提出和改进也极大地降低了稀疏表示方法在求解大规模高维度问题时的复杂度[6]。尽管如此,稀疏表示分类(Sparse Representation Classification, SRC)的运行时间成本高仍是其主要缺陷之一。

针对SRC高额的运行时间成本,Zhang等 [7]提出了一种协从表示(Collaborative Representation Classification, CRC)人脸分类方法。CRC与SRC相似,区别在于SRC中基于l1范数的稀疏诱导约束,CRC中使用了l2正则化最小约束,使得CRC在可以取得与SRC相近的人脸识别率的情况下极大地降低了算法运行的时间成本。潘禹岐等[8]提出一种局部加权CRC算法,将高维中的局部人脸特征信息用于人脸识别。

最近,低秩恢复理论(Low-rank Recovery Theory, LRT)获得了相关领域学者的极大关注[9]。LRT作为一种有效的工具在诸如背景消减(background subtraction)、追踪(tracking)以及网络数据挖掘等方面,取得了令人欣喜的成绩。Liu等 [10-11]中提出来一种低秩表示(Low-Rank Representation, LRR)的新方法,LRR可以同时处理好噪声抑制和子空间分类问题。简言之,LRR的核心思想是通过求解核范数最小化(nuclear norm minimization)问题的最低秩解,即:在所有的用训练样本线性重构的向量可能性解中找到其对应的最低秩的表示方式。LRR的思想得到了相关科研人员的关注,Chen等[12]通过使用LRR技术抑制训练样本中的噪声;Zhang等[13]通过用同等权值的低秩矩阵和稀疏矩阵对测试图像进行线性重构;杜海顺等[14]提出了基于Gabor低秩恢复稀疏表示分类的人脸图像识别方法。以上提到的方法,同样没有对类内特征信息进行充分的探索。

鉴于以上算法的不足,本文提出一种基于特征化字典的低秩表示人脸识别(Characterized Dictionary-based Low-Rank Representation classification for face recognition, LRR-CD)算法,构建人脸特征化字典后,通过运用LRR技术,在核范数的约束框架内,寻找各测试样本对应的训练样本的最优低秩解(低秩向量)用于对测试样本进行重构,同时最小化基于训练样本的低秩重构特征系数以及与之相对应的类内特征差异,最后通过最小残差分类器对测试样本进行分类。LRR-CD通过缜密的探索类内人脸中存在的细微差异,构建出具有高效且高判别度的重构系数矩阵,为人脸识别率的提高奠定了坚实的基础。同时,在实验中也引入了遮挡、光照变化等噪声用以验证我们算法的鲁棒性,通过实验数据对比,LRR-CD对以上噪声具有良好的鲁棒性。

1 低秩理论描述最近,基于低秩理论的相关技术发展迅速,如低秩矩阵恢复、低秩矩阵求全(low-rank matrix completion)以及低秩表示。低秩技术可以有效地呈现出样本数据信息中的特征低秩结构。LRR的核心是对于特定的样本词典中所有样本个体(atom),寻求能够通过线性组合重构测试数据向量的最小的低秩解。

假设矩阵A是原始的数据样本集,A中的每一列表示一份个体数据样本,考虑到数据中存在的噪声,规则化的低秩最小问题可以如下表示:

| $\begin{array}{l} \mathop {\min }\limits_Z {\kern 1pt} {\kern 1pt} {\kern 1pt} {\left\| Z \right\|_*} + \lambda {\left\| E \right\|_{2,1}}\\ s.t.{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} A = AZ + E \end{array}$ | (1) |

其中:Z对应于字典A的最低秩表示数据;E是噪声数据;‖·‖*是核范数;‖E‖2, 1用于特征化表示某一具体样本由噪声影响所带来的误差,通常‖E‖F2用于模拟弱高斯噪声(‖·‖F为F范数),‖E‖1用于模拟某一随机遮挡。引进系数λ用于调节这两种特征化项的权重。

随着低秩技术的发展,相关科研人员提出了一大批算法用于求解低秩最小约束问题,例如增强型拉格朗日乘子法(Augmented Lagrange Multiplier, ALM)[15]、可迭代阀值法(Iterative Thresholding Method, ITM)[16]和快速最陡梯度法(Accelerated Proximal Gradient, APG)[17]。在这些方法中,考虑到运行时间成本和准确性,ALM是一个较好的选择。本文中也将采用ALM用于求解人脸识别方面的低秩最小约束问题。

2 LRR-CD算法描述为了充分利用人脸图像中的类内信息,更准确、高效、有判别度地去表示光照和表情变化、遮挡等条件下人脸特征信息,本文提出了一种新的基于特征化字典的低秩表示人脸识别(LRR-CD)算法。

对于一个测试样本图像y,首先将它分割成N块,每一块可以用对应的特征列向量Yi(i=1, 2, …, N)表示。那么,Y=[Y1, Y2, …, YN]可以表示对应的测试样本图像y。按照相同的方式,也将训练样本集中的每个训练样本分成N个特征块并用特征列向量的方式保存,称之为训练块集。对于每一个块Yi,用Ai表示重构它所需的训练块集合,用Di表示其对应的类内差异字典。这里认为,所有图像都已经统一排列,即由同一坐标系相机拍摄而成。因此,重构训练块集合Ai是由来自同一坐标系中所有训练样本的特征列向量Yi组成的。这样,特征列向量Yi可以用重构训练块集Ai和对应类内差异字典Di表示:

| ${Y_i} = {A_i}{X_i} + {D_i}{S_i} + {E_i}{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \forall i,{\kern 1pt} {\kern 1pt} 1 \le i \le N.$ | (2) |

首先,在理想的情况下,每一个图像特征块都应该由来自测试样本所属的训练样本集的训练块构成。然而,有一些面部图像的面部特征块并不是很明显,不具有足够的判别度。如果直接在对应训练块重构系数集Xi上使用低秩约束,这样会使得此识别块由训练样本集中别的个体样本的某部分重构。进而,误导此人的面部识别,最终使得识别率下降。用X=[X1, X2, …, XN]表示相应训练块重构系数。显而易见的是,所有的非零系数将会出现在对应的人脸特征块位置上,即X中存在整齐排列的低秩结构。为了不错分这些具有低判别度的特征块,在X上采取一种类内低秩约束。其次,我们认为测试样本与训练样本之间存在的特征块差异是由有限数量的误差引起的。例如,对于脸颊特征块来说,可见误差可能由穿戴口罩引起的;对于嘴部特征块来说,误差可能由表情变化或是光照变化引起的。因此,对于每个特征块,相应类内差异字典的系数应该是稀疏的,互不相关的。再次,希望在一定程度内,重构误差越小越好。基于以上论述,可以建立如下最优化模型:

| $\begin{array}{l} \mathop {{\rm{min}}}\limits_{X,S,E} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\left\| X \right\|_*} + {\left\| S \right\|_*} + \lambda {\left\| E \right\|_{2,1}}\\ s.t.{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {Y_i} = {A_i}{X_i} + {D_i}{S_i} + {E_i}{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \forall i \end{array}$ | (3) |

其中,E=‖E1, E2, …, EN‖对应各个特征块的重构误差。对X的类内低秩约束保留了全局性图像表示的优点。与此同时,通过限制某些低识别度的特征块仅由类内训练块重构而成,从而大大降低了大面积严重噪声对于识别度的影响。在得到每一特征块的重构系数后,就可以使用基于最小重构误差准则的分类器对测试样本进行分类了。

为了求解问题(3) ,采用目前广泛使用的ALM方法。具体来说,首先将问题(3) 变换成如下形式:

| $\begin{array}{l} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \mathop {min}\limits_{X,S,E,G,Z} = \left\| G \right\|_*^{} + {\left\| Z \right\|_*} + \lambda {\left\| E \right\|_{2,1}}\\ {\kern 1pt} s.t.{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {Y_i} = {A_i}{X_i} + {D_i}{S_i} + {E_i}{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \forall i\\ {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} G = X,{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} Z = S \end{array}$ | (4) |

基于ALM方法,问题(4) 可以进一步地变换成如下的非约束问题形式:

| $\eqalign{ & L = {\left\| G \right\|_*} + {\left\| Z \right\|_*} + \lambda {\left\| E \right\|_{2,1}} + tr\left( {H_1^T\left( {G - X} \right)} \right) + \cr & tr\left( {H_2^T\left( {Z - S} \right)} \right) \cr & + \sum\limits_i {tr\left( {J_i^T\left( {{Y_i} - {A_i}{X_i} - {D_i}{S_i} - {E_i}} \right)} \right)} \cr & + {\mu \over 2}\left( \matrix{ \left\| {G - X} \right\|_F^2 + \left\| {Z - S} \right\|_F^2 \hfill \cr + \sum\limits_i {\left\| {{Y_i} - {A_i}{X_i} - {D_i}{S_i} - {E_i}} \right\|_F^2} \hfill \cr} \right) \cr} $ | (5) |

其中:tr(·)代表某个矩阵的迹;惩罚参数μ>0。然后,可以有选择地在固定某些变量的情况下对某单一未知量进行更新优化。在算法1中详细注明了如何求解式(5) 。通过算法1中的1) ~5) 步,可以求解出式(5) 的近似解。具体来说,第一步中的目标函数来源于以下公式:

| $\mathop {\mathop {min}\limits_v }\nolimits_{} \frac{1}{2}\left\| {X - V} \right\|_*^2 + \mu {\left\| V \right\|_{2,1}}$ | (6) |

式(6) 的解为:

| $V\left( {i,:} \right) = \left\{ \begin{array}{l} \frac{{\left\| {X\left( {i,:} \right) - \mu } \right\|}}{{X\left( {i,:} \right)}}X\left( {i,:} \right),{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\left\| {X\left( {i,:} \right)} \right\|_2} > \mu \\ 0,{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} 其他 \end{array} \right.$ | (7) |

对于第二步,其目标函数来源于:

| $\mathop {\mathop {min}\limits_V }\nolimits_{} \frac{1}{2}\left\| {X - V} \right\|_*^2 + \mu {\left\| V \right\|_1}$ | (8) |

问题(8) 可以通过奇异值阈值(Singular Value Thresholding, SVT)算子[18]解决。为了在第3) ~5) 步中进行求解,将优化函数各对应变量的导数设置为0,这样便于得到问题的近似解。由于可以求解出各个特征块重构系数的高度近似解,使得本文的算法有足够的可靠性,进而说明算法1的优化求解是行之有效的。

算法1 ALM法求解式(5) 。

输入 局部特征块Yi,训练块Ai,类内差异字典Di,参数λ;

输出 重构系数X和S。

初始化:设置X和S初始解为单位阵,G=X,Z=S,E=H1=

H2=Ji=0,μ=0.1≤108,ε≤10-5 while 未收敛 do

1) 更新G,固定其余变量:

| $G = \arg \min \frac{1}{\mu }{\left\| G \right\|_{2,1}} + \frac{1}{2}\left\| {G - \left( {X - {H_1}{{\rm{ }}_1}\mu } \right)} \right\|_F^2$ | (9) |

2) 更新Z,固定其余变量:

| $Z=\arg \min \frac{\lambda }{\mu }{{\left\| Z \right\|}_{1}}+\frac{1}{2}\left\| Z-\left( S-{{{H}_{2}}}/{\mu }\; \right) \right\|_{F}^{2}$ | (10) |

3) 更新X,固定其余变量:

| $\begin{align} & X=\arg \min tr\left( H_{1}^{T}\left( G-X \right) \right)+ \\ & \sum\limits_{i}{tr\left( J_{i}^{T}\left( {{Y}_{i}}-{{A}_{i}}{{X}_{i}}-{{D}_{i}}{{S}_{i}}-{{E}_{i}} \right) \right)} \\ & +\frac{\mu }{2}\left( \left\| G-X \right\|_{F}^{2}+\sum\limits_{i}{\left\| {{Y}_{i}}-{{A}_{i}}{{X}_{i}}-{{D}_{i}}{{S}_{i}}-{{E}_{i}} \right\|_{F}^{2}} \right) \\ \end{align}$ | (11) |

4) 固定其余变量,更新S:

| $\begin{align} & S=\arg \min tr\left( H_{2}^{T}\left( Z-S \right) \right)+ \\ & \sum\limits_{i}{tr\left( J_{i}^{T}\left( {{Y}_{i}}-{{A}_{i}}{{X}_{i}}-{{D}_{i}}{{S}_{i}}-{{E}_{i}} \right) \right)} \\ & +\frac{\mu }{2}\left( \left\| Z-S \right\|_{F}^{2}+\sum\limits_{i}{\left\| {{Y}_{i}}-{{A}_{i}}{{X}_{i}}-{{D}_{i}}{{S}_{i}}-{{E}_{i}} \right\|_{F}^{2}} \right) \\ \end{align}$ | (12) |

5) 固定其余变量,更新E:

| $\begin{align} & E=\arg \min \lambda {{\left\| E \right\|}_{2,1}}+ \\ & \sum\limits_{i}{tr\left( J_{i}^{T}\left( {{Y}_{i}}-{{A}_{i}}{{X}_{i}}-{{D}_{i}}{{S}_{i}}-{{E}_{i}} \right) \right)} \\ & +\frac{\mu }{2}\left( \sum\limits_{i}{\left\| {{Y}_{i}}-{{A}_{i}}{{X}_{i}}-{{D}_{i}}{{S}_{i}}-{{E}_{i}} \right\|_{F}^{2}} \right) \\ \end{align}$ | (13) |

6) 更新乘子:

| $\begin{array}{l} {H_1} = {H_1} + \mu \left( {G - X} \right)\\ {H_2} = {H_2} + \mu \left( {Z - S} \right)\\ {J_i} = {J_i} + \mu \left( {{Y_i} - {A_i}{X_i} - {D_i}{S_i} - {E_i}} \right),{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \forall i \end{array}$ |

7) 更新参数μ:

8) 检查收敛条件:

‖Yi-AiXi-DiSi-Ei‖2<ε(∀i),

‖Z-S‖∞<ε以及‖G-X‖∞<ε

end while

3 实验结果及分析在本章中,将本文所提出的LRR-CD与4种具有较高代表性的重构性人脸识别算法SRC[6]、CRC[7]、低秩表示正则切(LRR with Normalized CUT, LRR-NCUT) [10]和低秩递归最小二乘(LRR with Recursive Least Square, LRR-RLS)[11]算法进行详细全面的对比。SRC、CRC算法是具有较好识别效果的重构性算法,也是低秩识别算法的有力竞争对手。LRR-NCUT和LRR-RLS算法是低秩表示算法中具有较高代表性的两种算法,两者在构建重构系数的过程中均以低秩理论为依据,区别在于最终的分类决策,前者采用的NCUT(Normalized CUT)[19], 后者则采用经典的递归最小二乘分类器。为了验证本文算法的有效性,验证实验在三个具有较高认知度的人脸数据库(AR,CMU-PIE,Extended Yale B)中进行。其中,在SRC中,使用Matlab优化工具箱中的linprog函数,利用l1范数求解SRC的最优化问题。两种对比方法的相关参数按照如下设置:SRC中的ε设为10-4;在CRC中,设置参数λ=0.01。在每个数据库中,分别选择一定数量的训练样本和测试样本。

本文实验环境如下所示:软件版本,Matlab R2014a 64位;操作系统,Windows 7;硬件配置,Intel Core i7-2630QM CPU @2.00 GHz and 4 GB (1600 MHz) RAM。

3.1 AR人脸库AR人脸数据库由126个人的不同正面角度、表情、光照和遮挡的超过4000张照片组成。每个人包含26个图像样本,分为两组,每组13张。随机地从AR人脸库中选出一个分别包含50名男性和50名女性的子集库。在子集库中,每个样本个体都包含14张不同光照、表情、遮挡、正面角度的图像。这些图像被裁切至60×60的尺寸。图 1显示了部分在实验中使用的人脸图像。

本文实验中,随机选取子集中前7幅图像作为训练样本集,剩余的与训练样本没有交集的图像作为测试样本集。这样就分别有了700份训练样本和测试样本。在AR人脸库中,将式(3) 中参数λ设置为0.001。

|

图 1 实验中使用的部分AR库中人脸图像 |

关于测试样本集的平均识别率如表 1所示。显而易见的是,LRR-CD的识别率远高于与其对比算法,相比SRC识别率提高17.16个百分点,相比CRC提升12.6个百分点。特征子空间维数为20、40、60、80、100、120、140、160、180、200时,五种方法的识别率如表 2所示。从表 2中,以看出当维度低于100时,LRR-CD表现出较大的优势,识别率领先幅度在20%左右。即使特征子空间的维度上升,LRR-CD的识别率依然大幅领先相比较的两种算法。我们认为这得益于LRR-CD算法中对于类内差异字典的学习,通过发掘类内中存在差异,使得原本LRR中就存在的全局特征信息中加入了类内差异特征信息,该信息对于测试样本的局部重构起到了至关重要的作用。同时也观察到LRR-CD算法在子空间维度增加到40时,识别率就达到了97%以上,并且一直很稳定。这充分表明了特征块字典的作用,即使在很低的维度下,通过充分探索类内差异信息并结合LRR中本身就包含的全局特征信息,获得了高效、高判别度的重构系数。

| 表 1 AR库中不同算法平均识别率比较 |

| 表 2 AR库中不同算法不同特征子空间维度下识别率比较 |

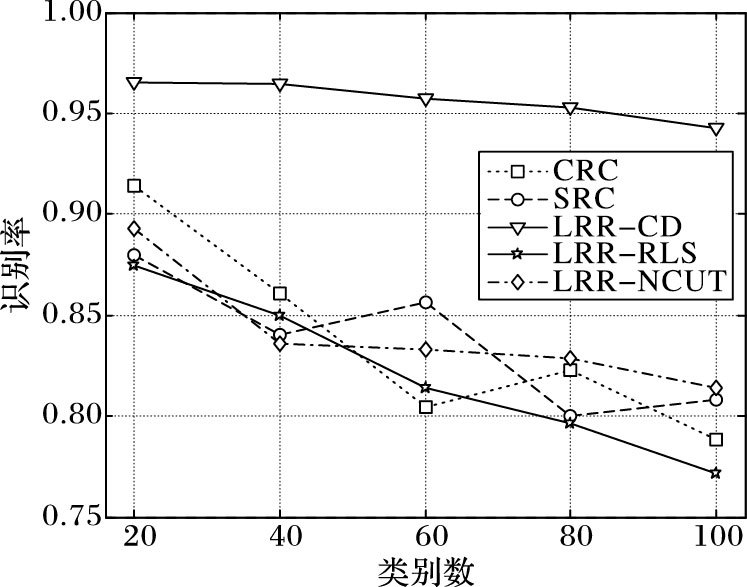

此外,还进行了不同类别数下识别率的对比实验。分别选取了人脸类别数为20、40、60、80、100五种类别数进行实验。从图 2中可以看出,随着人脸类别数量的增加所有五种人脸识别算法识别率呈现一个下降的趋势。但是,也可以观察到LRR-CD相比其余四种算法下降的幅度并不明显,这得益于特征块化之后LRR-CD同时寻求类间和类内最优的低秩重构系数,对于类别数量的增加具有很好的鲁棒性,进而使得LRR-CD所获得的识别率相较于其他四种算法具有很大的优势。

|

图 2 AR库中不同类别数下识别率对比 |

PIE来源于姿态(pose)、光照(illumination)和表情(expression)三个词的首字母。PIE人脸库,俗称CMU-PIE,该数据库中包含了68个子集共计41368张人脸照片。每个子集的照片都是在13个不同姿态、4种不同的光照条件下拍摄完成的。随机地从该库中选择100个不同样本个体(男性和女性各50) ,每个个体样本中包含14张不同光照、姿态和表情的图片。将各图像的尺寸调整为50×50。相关实验中用到的样本如图 3所示。在CMU-PIE人脸库的实验中,将式(3) 中的参数λ设置为1E-5。

|

图 3 实验中使用的部分CMU-PIE库中人脸图像 |

不同方法在此数据库的平均实验结果如表 3所示。从表 3中,可以看出LRR-CD再次展现出优于其他算法的性能,平均识别准确率领先幅度在2.58~11.19个百分点。

| 表 3 CMU-PIE库中不同算法平均识别率比较 |

从表 4的从20到200的特征子空间维度的识别率详细对比中,可以发现在维度20时,LRR-NCUT微弱地领先LRR-CD,但是在维度上升到40之后,LRR-CD的识别率大幅提升,远超其他算法。我们认为,在维度过低的情况下特征信息的提取以及学习仍有相当的难度,局部特征化信息被大量压缩无法得到有效的提取,同时,特征信息的包含量极其微小,导致全局和局部特征信息的学习不够充分,进而影响重构系数的判别性,最终影响识别率。得益于NCUT在聚类过程中的优势,使得LRR-NCUT在20的维度上微弱地领先LRR-CD,但当特征信息含量提升的时候,LRR-CD展现出其良好的全局和局部信息的融合性,识别率明显高于与之比较的算法。

| 表 4 CMU-PIE库中不同特征子空间维度下识别率比较 |

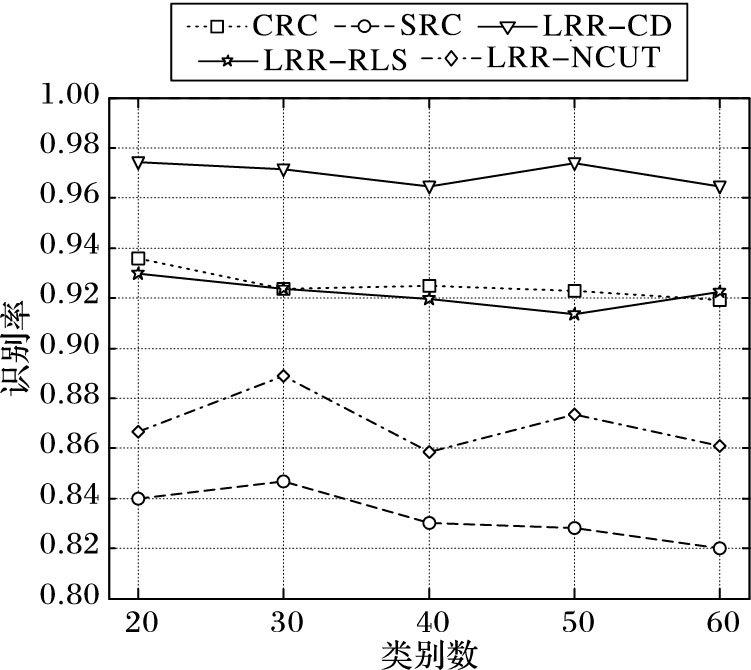

图 4展示了CMU-PIE库中不同人脸类别数下各算法的识别率对比情况。分别选取了人脸类别数为20、30、40、50、60五种情况。从图 4可以看出:LRR-CD的识别率高于其他算法;LRR-RLS和CRC算法的识别率不相上下;LRR-NCUT算法受限于NCUT方法,其稳定性较差,识别率的波动是五种算法中最大的。

|

图 4 CMU-PIE库中不同类别数下识别率对比 |

EYB(Extended Yale B)人脸数据库由38个不同个体在64种不同光照条件下拍摄的2414张正面面部照片组成,所有的面部图像都被调整为实际的人脸区域,EYB库中所存储的人脸图像的尺寸为192×168。在本文实验中,将图像尺寸调整为64×56,并将式(3) 提到的参数λ设置为0.001。实验中用到的部分人脸图像如图 5所示。

|

图 5 实验中使用的部分EYB库中人脸图像 |

本文实验中的训练样本与测试样本的建立方法与在AR库中的建立方法相似。不同在于,每个个体样本中包含32个图像。相关实验数据如表 5~6所示,表 5为不同维度下平均识别率对比表,表 6为特征子维度从20到200时的详细识别率对比。

| 表 5 EYB库中平均识别率比较 |

| 表 6 EYB库中不同特征子空间维度下识别率比较 |

表 5~6体现了LRR-CD较好的性能。从表 6中可以明显地看出:所有算法在40维的时候识别率都大幅提升,但是LRR-CD的提升幅度远远大于与之比较的两种算法;SRC最高的几个识别率一直维持在87%左右,CRC的最高识别率在90%左右徘徊,与此同时,LRR-RLS和LRR-NCUT得益于低秩恢复理论的良好全局重构性,识别率高于SRC和CRC。然而,注意到LRR-CD的多个识别率在96%以上,而LRR-RLS和LRR-NCUT的最高识别率分别仅为95.14%和94.56%。同样,我们认为LRR-CD之所以能取得比较好的性能在于其优秀的全局和类内特征信息的融合能力:通过核范数约束,充分探索类内人脸图像中存在的差异,并结合全局特征信息,构建高效、高判别度的重构系数,用以低误差、高特征度地重构测试样本,最终获得较好的识别率。

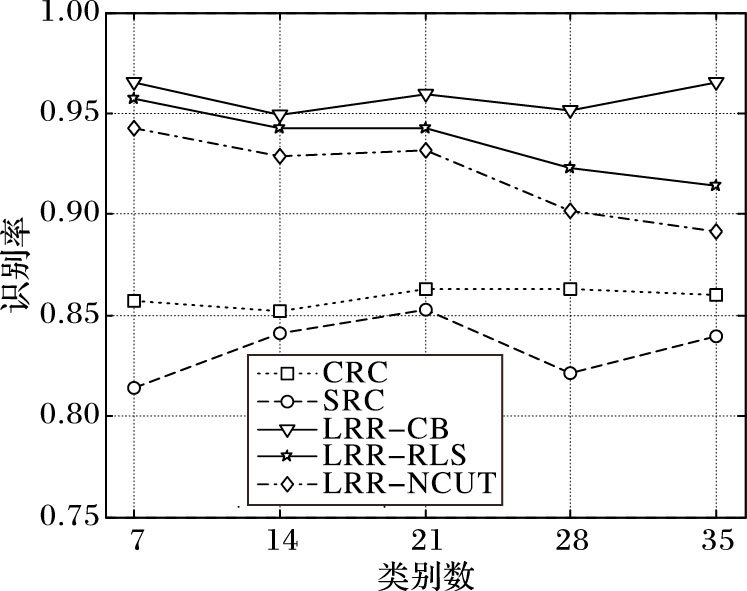

图 6展示了EYB库中不同人脸类别数下各算法识别率的对比,可以明显地发现LRR-CD的识别率高于其他算法。同时,从图 6可以看出LRR-RLS和LRR-NCUT算法随着人脸类别数的增加识别率有不同程度的下滑,而LRR-CD却相对稳定,并且在类别数为35时识别率不降反升。我们认为,随着类别数的增加,全局信息和局部信息更加丰富,此时LRR-CD可以充分发挥高效提取这两种特征信息的优势,进而取得较高的识别率。

|

图 6 EYB库中不同类别数下识别率对比 |

在本文中,提出了一种新的人脸识别的算法--基于特征化字典的低秩表示。通过建立新的类内差异字典,同时对全局特征块集和类内差异字典进行最小低秩优化,运用ALM算法求解所对应的核范数最优化问题,构建具有高判别度和高效性的重构系数。通过运用所获得的低秩重构系数,对测试样本进行基于训练样本的重构,即,高效低误差地利用训练样本表示测试样本。最后,使用最小残差分类器进行分类。通过在AR,CMU-PIE和Extended Yale B人脸数据中进行的实验,实验结果充分说明了LRR-CD算法的可行性和有效性,并且对于一般的光照,姿态,表情和遮挡变化等噪声影响具有较好的鲁棒性。下一阶段工作将主要集中于融合参数学习(parameter learning)的方法自适应地求解算法在不同人脸库下最优参数以及更好地进行人脸特征块的提取工作。

| [1] | WANG J J,YANG J C,YU K,et al.Locality-constrained linear coding for image classification[C]//Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE,2010:3360-3367. |

| [2] | YANG J C,YU K,GONG Y H,et al.Linear spatial pyramid matching using sparse coding for image classification[C]//CVPR 2009:Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE,2009:1794-1801. |

| [3] | OLSHANUSEN B A, FIELD D J. Emergence of simple-cell receptive field properties by learning a sparse code for natural images[J]. Nature, 1996, 381 (6583) : 607-609. doi: 10.1038/381607a0 |

| [4] | WRIGHT J, YANG A Y, GANESH A, et al. Robust face recognition via sparse representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31 (2) : 210-227. doi: 10.1109/TPAMI.2008.79 |

| [5] | WRIGHT J S, NOWAK R D, FIGUEIREDO M A T. Sparse reconstruction by separable approximation[J]. IEEE Transactions on Signal Processing, 2009, 57 (7) : 2479-2493. doi: 10.1109/TSP.2009.2016892 |

| [6] | TROPP J A, WRIGHT S J. Computational methods for sparse solution of linear inverse problems[J]. Proceedings of the IEEE, 2010, 98 (6) : 948-958. doi: 10.1109/JPROC.2010.2044010 |

| [7] | ZHANG L,YANG M,FENG X C,et al.Collaborative representation based classification for face recognition[EB/OL].[2016-03-06].https://arxiv.org/ftp/arxiv/papers/1204/1204.2358.pdf.ComputerScience,2012(23):103-108. |

| [8] | 潘禹岐, 江铭炎, 张振月. 基于流形的局部加权协从表示人脸识别[J]. 计算机应用研究, 2016, 33 (7) : 2206-2209. ( PAN Y Q, JIANG M Y, ZHANG Z Y. Face recognition based on locality weighted CRC of manifold[J]. Application Research of Computers, 2016, 33 (7) : 2206-2209. ) |

| [9] | CUI X Y,HUANG J Z,ZHANG S T,et al.Background subtraction using low rank and group sparsity constraints computer vision[C]//ECCV 2012:Proceedings of the 12th European Conference on Computer Vision,LNCS 7572.Springer:Berlin,2012:612-625. |

| [10] | LIU G C,LIN Z C,YU Y.Robust subspace segmentation by low-rank representation[C]//ICML 2010:Proceedings of the 27th International Conference on Machine Learning.Piscataway,NJ:IEEE,2010:663-670. |

| [11] | LIU G C, LIN Z C, YAN S C, et al. Robust recovery of subspace structures by low-rank representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35 (1) : 171-184. doi: 10.1109/TPAMI.2012.88 |

| [12] | CHEN J, YI Z. Sparse representation for face recognition by discriminative low-rank matrix recovery[J]. Journal of Visual Communication and Image Representation, 2014, 25 (5) : 763-773. doi: 10.1016/j.jvcir.2014.01.015 |

| [13] | ZHANG C J,LIU J,TIAN Q,et al.Image classification by non-negative sparse coding,low-rank and sparse decomposition[C]//CVPR 2011:Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE,2011:1673-1680. |

| [14] | 杜海顺, 张旭东, 金勇, 等. 基于Gabor低秩恢复稀疏表示分类的人脸图像识别方法[J]. 电子学报, 2014, 42 (12) : 2386-2393. ( DU H S, ZHANG X D, JIN Y, et al. Face image recognition method via Gabor low-rank recovery sparse representation-based classification[J]. Acta Electronica Sinica, 2014, 42 (12) : 2386-2393. ) |

| [15] | BERTSEKAS D P. Constrained Optimization and Lagrange Multiplier Methods,Computer Science And Applied Mathematics[M]. Cambridge,Massachusetts: Academic Press, 1982 : 231 -256. |

| [16] | DAUBECHIES I, DEFRISE M, DE MOL C. An iterative thresholding algorithm for linear inverse problems with a sparsity constraint[J]. Communications on Pure and Applied Mathematics, 2004, 57 (11) : 1413-1457. doi: 10.1002/(ISSN)1097-0312 |

| [17] | BECK A, TEBOULLE M. A fast iterative shrinkage-thresholding algorithm for linear inverse problems[J]. SIAMJ Journal of Image Sciences, 2009, 2 (1) : 183-202. doi: 10.1137/080716542 |

| [18] | CAI J F, CANDES E J, SHEN Z. A singular value Thresholding algorithm for matrix completion[J]. SIAM Journal on Optimization, 2008, 20 (4) : 1956-1982. |

| [19] | SHI J B, MALIK J. Normalized cuts and image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22 (8) : 888-905. doi: 10.1109/34.868688 |