2. "智慧商务与物联网技术"河南省工程实验室(河南师范大学), 河南 新乡 453007

2. Henan Engineering Laboratory of Intelligence Business and Internet of Things(Henan Normal University), Xinxiang Henan 453007, China

LIU Shangwang, born in 1973, Ph. D., associate professor. His research interests include biologic image processing, computer vision

GAO Liuyang, born in 1991, M. S. candidate. His research interests include biologic image processing, computer vision

目标跟踪的实质是估计目标对象在图像序列中的状态[1-3],是识别、分析、决策等后续高级处理的基础,其在安全监控、交通监测、人机交互、军事领域、医学应用等领域[4],有着广泛应用。

目标跟踪模型可分为判别模型(Discriminant Model, DM)和生成模型(Generative Model, GM)两种。判别模型将跟踪问题看成是分类问题,即跟踪的目的是将图片中的前景(目标)和背景分开,该类模型跟踪效率比较理想。Adam等[5]通过局部信息对图像分块进行目标跟踪(Frag Tracker, Frag);Babenko等[6]提出了基于在线多示例学习的目标跟踪方法(Multiple Instance Learning, MIL)。

生成模型主要是寻找与跟踪目标最相似的区域,即最优化估计目标的状态,能够较好地描述目标外观变化。Kalal等[7]改进的在线学习机制能不断更新跟踪模块(Tracking Learning Detection, TLD)。

为在复杂情况下,特别是目标发生剧烈表观变化时,设计出一个在动态场景下有效的目标跟踪算法或模型。受图像稀疏表示的影响,在判别模型中:Wright等[8]把识别转化为分类与匹配问题,提出基于稀疏表示的人脸识别;Mei等[9]首次将稀疏表示理论引入粒子滤波框架中通过最小投影误差跟踪目标;Zhang等[10]将所有候选目标的线性组合通过目标模板线性表示并由稀疏系数确定目标位置;Zhang等[11]又在此基础上优化微小模板,降低计算复杂度;潘晴等[12]构造背景字典从而筛选区分目标及其相邻背景的特征,提高在复杂场景中目标识别的鲁棒性。基于生成模型:Liu等[13]在稀疏表示的基础上利用在线特征选择来减小目标的重建误差;Bao等[14]改进稀疏模型,主要对琐碎模板对应的系数进行条件约束;Wang等[15-16]提出使用最小二乘法来对目标跟字典之间的距离进行优化,随后提出一种基于稀疏原型的目标跟踪算法提高跟踪效率。

目前方法中,判别模型严重依赖于训练样本的选择,对目标外观的描述度不高,跟踪精度欠缺[17];生成模型计算复杂、时效性低[18]。实际应用中,兼顾准确性、鲁棒性和实时性仍一个挑战性课题[13, 19]。鉴于以上分析,本文在粒子滤波的框架下提出一种稀疏协同模型,集合两种模型的优势,对目标进行跟踪。

1 粒子滤波目标跟踪框架粒子滤波(particle filtering)是求解序列贝叶斯滤波的一种实用算法,它往往代表着目标状态中的点状态[18]。即在目标跟踪过程中通过当前和以前的结果来预计当前目标状态,以对目标进行定位跟踪。

1.1 运动模型在视频帧序列中,可用一个矩形跟踪框表示目标,而目标的位置可通过运动参数来表示[20-21]。即:

| ${X_t} = \left\{ {{x_t}, {y_t}, {\theta _t}, {a_t}, {\varphi _t}} \right\}$ | (1) |

其中:xt, yt表示运动方向上的位移;θt表示目标旋转角度;st表示目标尺度变化;αt表示宽高比;φt表示斜切度。Xt中的每个运动参数之间相互独立,对应上一帧Xt-1呈高斯分布。

相邻帧之间的运动模型,可由式(2)表示:

| $p\left( {{X_t}\left| {{x_{t-1}}} \right. = {\rm{N}}\left( {{X_t}, {X_{t-1}}, {\boldsymbol{\psi }}} \right)} \right)$ | (2) |

其中ψ表示相应运动参数对角方差矩阵,即ψ=diag(σx2, σy2, σθ2, σs2, σα2, σφ2)。

理论上,运动参数越多,目标跟踪准确率越高[9]。通过大量实验验证,本文选取运动参数的数目为36时,可以计算出目标的运动状态。

1.2 目标模型粒子滤波技术是利用连续时间的贝叶斯重复采样,来估计一个动态系统状态变量的概率分布[22-23]。若在帧t的样品中具有其前一帧的目标状态信息,就可以进行粒子取样来表示当前目标状态,如式(3)所示:

| $p\left( {x_t^i|{x_{t - 1}}} \right) = G\left( {{x_{t - 1}}, {\sigma ^2}} \right)$ | (3) |

其中,xti表示当前帧选取第i个粒子状态;xt-1表示前一帧粒子状态;σ2为高斯分布函数随机取样时的方差。

引入权重,则其运动模型为:

| $p\left( {x_t^i|{x_{t - 1}}} \right) = \omega _t^iG\left( {{x_{t - 1}}, {\sigma ^2}} \right)$ | (4) |

其中ωti是在t帧中第i个样本集中通过相应的稀疏表示计算获得的权重。t时刻的样本集X={xti}i=1, 2, …, N,可由式(3)得到。

模板集T={t j}j=1, 2, …, m是由在最后的m-1帧和第一帧模板中m-1的跟踪结果组成。给定样本集合X,每个元素tj的稀疏系数γj,通过式(5)计算得到:

| $\begin{array}{l} \;\;\;\;\;\;\;\mathop {\min }\limits_{{\gamma _j}} \left\| {{t^j}-{X_{{\gamma _j}}}} \right\|_2^2 + {\lambda _1}{\left\| {{\gamma _j}} \right\|_1}, \\ {\rm{s}}{\rm{.t}}.{\gamma _j} \ge 0, j = 1, ..., m \end{array}$ | (5) |

其中λ1是权重参数。样本集X形成一个完整的字典,通过稀疏选择与模板高度相关的样本。也就是说,利用模板匹配来进行目标跟踪[24]。

此外,跟踪质量还取决于目标特征提取。一个跟踪目标对象可以用不同的特征来表示,如灰度强度、颜色、纹理、超像素和Hear-like特征等[19]。其中,灰度强度特征提取简单、高效,能够满足本文要求。故本文采用灰度强度值(灰度值)表示目标对象,在粒子滤波框架下进行基于稀疏表示的目标跟踪。

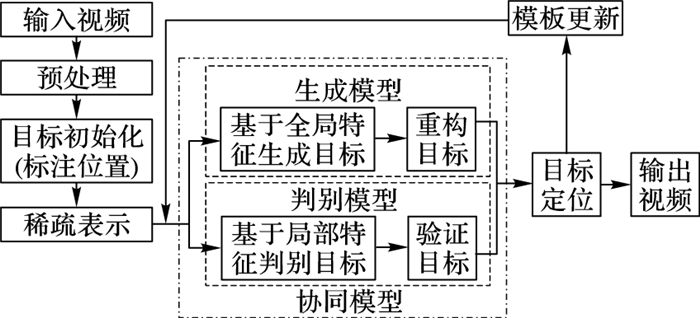

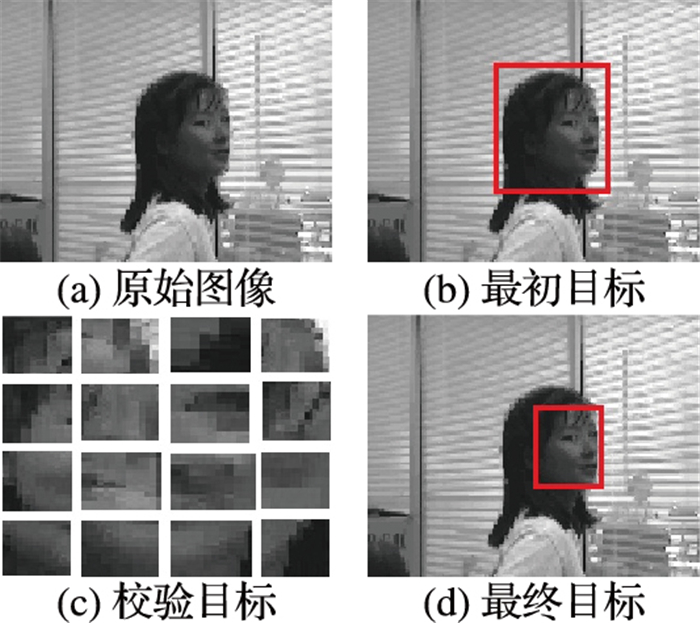

2 稀疏表示目标跟踪本文将稀疏表示理论引入到粒子滤波框架进行目标跟踪,其工作框架,如图 1所示。

|

图 1 本文框架 |

从图 1中可以看出,本文采用判别模型来进行凌乱复杂场景中目标跟踪;采用生成模型来缓解目标外观的变化,以更好地描述目标;通过将两种模型集成在本文协同模型中,达到鲁棒目标跟踪效果。其中,重点是在判别模型中通过局部训练提高区分目标和背景的效率;在生成模型中通过全局加权直方图有效定位目标;同时,通过回归机制建立协同模型。

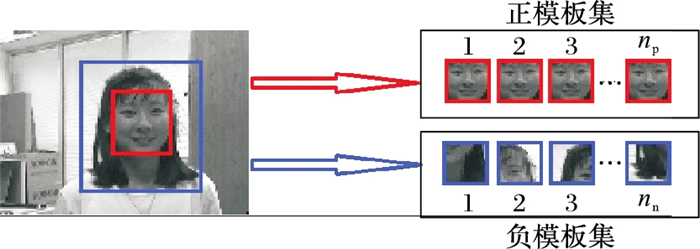

2.1 稀疏目标判别模型目标跟踪中,判别模型寻找不同类别之间的最优分类面,旨在区分出目标[19]。为提高其效率,在模型训练过程中,训练图像集由np正模板和nn负模板组成。np是在目标周围(即图 2小方框内),利用双线性插值滤波器得到合适分辨率(32×32)的局部图像,由这些局部图像归一化后按行堆放形成向量作为正模板集A+(如图 2所示)。同样,负模板nn由图像中远离目标位置的像素即大方框和小方框的中间回形部分形成。因此,负模板集A-包含有背景和部分目标对象。

|

图 2 训练图像集 |

为了从背景中分割出前景目标对象,通过式(6)提取满足条件的特征。

| $\mathop {\min }\limits_s \left\| {{\boldsymbol{A^{\rm T}}s - p}} \right\|_2^2 + {\lambda _2}{\left\| \boldsymbol{s} \right\|_1}$ | (6) |

其中:模板A∈RK×(np+nn)由正模板集A+和负模板集A-组成;K为特征维数;λ2是权重;p∈R(np+nn)×1代表p在训练集A中每个数据的属性,即+1为正模板,-1为负模板;s为稀疏向量集。

稀疏向量Si,第i个候选粒子向量,经式(7)投影到一个子空间,即对角元矩阵s′ii。

| $\boldsymbol{s}_{ii}' = \left\{ {_{1, 其他}^{0, {s_i} = 0}} \right.$ | (7) |

其中:s′ii的行数和列数与S一致,当Si为0时对角元s′ii也为0,反之为1。

简言之,通过稀疏向量选择K维特征空间中对应其值为非零元素的特征。这些特征通常用来有效区分目标和背景。

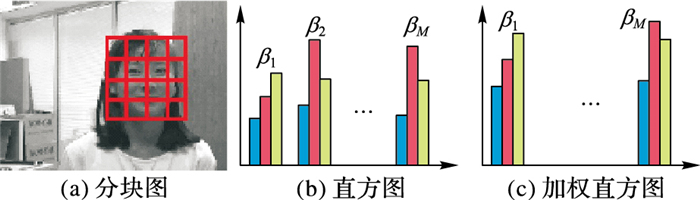

2.2 稀疏目标生成模型通过重叠滑动窗口的归一化图像把目标区域(全局信息)分成M块(本文中,M取值32)补丁[20](如图 3(a)所示)。K-means算法[20]可以使这些补丁形成J个聚类中心,再通过聚类中心建立字典D。这样,每个补丁范围便转换为矢量yi∈RG×1,这里G表示补丁的大小。每个补丁的稀疏向量系数β的计算,如式(8)所示:

| $\begin{array}{l} \mathop {\min }\limits_{{\beta _i}} \left\| {{y_i}-D{\beta _i}} \right\|_2^2 + {\lambda _4}{\left\| {{\beta _i}} \right\|_1}, \\ {\rm{s}}{\rm{.t}}.{\beta _i} \ge 0 \end{array}$ | (8) |

其中:这些聚类中心用K-means算法对补丁M从第1帧开始(包括目标对象的最有代表性的模式)生成字典D,D∈RG×J;λ4是权重参数。每个补丁稀疏系数向量βi∈RJ×1通过归一化形成一个直方图(图 3(b)),其中βi∈R(J×M)×1是目标的直方图。为排除遮挡补丁的干扰,更好地描述目标对象,对目标直方图由式(9)进行加权(图 3(c))。

|

图 3 加权改进过程 |

遮挡部分的重构误差较大,将其相应的稀疏向量系数为0。

| $\phi = \rho \odot o$ | (9) |

其中:ρ代表候选直方图;⊙代表点乘表示元素之间的乘法,即对应元素相乘;o中的每个元素可以通过式(10)计算得到,并作为在相应修补程序中的一个指标。

| ${o_i} = \left\{ {_{0, 其他}^{1, {\varepsilon _i} < {\varepsilon _0}}} \right.$ | (10) |

其中:εi=‖yi-Dβi‖22为候选目标yi的重构误差;ε0代表目标是否被遮挡的判别阈值(本文取0.04)。

当遮挡时要对每个候选目标的稀疏直方图ϕ要进行加权,需要通过局部补丁和遮挡空间信息来进行修补。为了有效确定生成目标和模板的匹配关系,可通过置信值的大小来解决,如式(11)所示:

| ${L_c} = \sum\limits_{j = 1}^{J \times M} {\min \left( {\varphi _c^j, {\psi ^j}} \right)} $ | (11) |

其中:LC是第c个候选粒子直方图,ψ是目标模板直方图。在作直方图相似性比较之前,需先将两个直方图进行归一化,归一化空间为(0, 1]。从而,Lc越大,生成的目标越接近真实值。

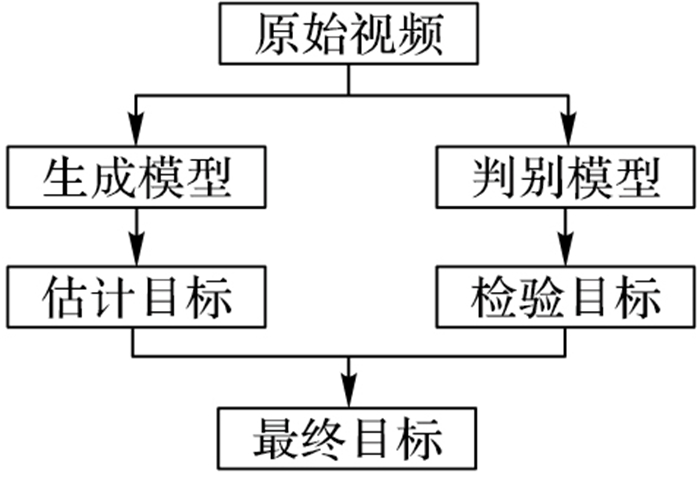

2.3 协同模型生成模型数据分布假设若不符合真实情况,则其跟踪效果、鲁棒性会变得较差。而判别模型对数据分布的假设要求不甚严格,在模型不符合数据假设的情况下,效果仍然较好;但数据样本对目标描述不够或在数据分布接近生成模型假设的情况下,目标跟踪效果则没有生成模型好[12]。

本文协同模型集成了生成与判别模型,如图 4所示。

|

图 4 协同模型集成图 |

从图 4可以看出,本文协同模型的生成过程为:首先,通过目标生成模型,在生成模型中获取大量的背景图像块,进而建立背景字典;其次,基于学习的字典对所有图像块进行稀疏重构,来获取稀疏残差;然后,归一化作为模型的显著映射图,为排除遮挡等干扰对图进行加权,通过置信值从而对输入图像显著性即目标进行初步估计(图 5(b));与此同时,在稀疏判别模型中,通过建立回归机制,引入流形排序求解优化问题,将生成模型获得的显著值代入判别模型中,对目标进行检验(图 5(c)),得到新候选目标;最后,利用最小重构误差对目标进行重定位(图 5(d))。

|

图 5 协同模型跟踪目标过程 |

在重定位时,候选区域的似然函数为:

| $p\left( {{z_t}|x_t^c} \right) = {H_c}{L_c} = \frac{{\left( {\sum\limits_{j = 1}^{J \times M} {min\left( {\phi _c^j, {\psi ^j}} \right)} } \right)}}{{\left( {1 + exp\left( {-\left( {{\varepsilon _b}-{\varepsilon _f}} \right)/\sigma } \right)} \right)}}$ | (12) |

则在目标模板T={t1, t2, …, tk}∈Rd×k中,跟踪目标为:

| $y = T\alpha = {a_1}{t_1} + {a_2}{t_2} + \cdots + {a_k}{t_k}$ | (13) |

其中a=(a1, a2, …, ak)T∈Rk×1为目标系数。

此时,引入琐碎模板,如式(14)所示:

| $\boldsymbol{y} = {\boldsymbol{T}_a} + \boldsymbol{s} + n = \left[{\boldsymbol{T}\;\boldsymbol{I}} \right]\left[{_\boldsymbol{s^a}} \right] + n$ | (14) |

其中:I=[i1, i2, …, id]∈Rd×d, ii∈Rd×1为琐碎模板;s=[s1, s2, …, sd]T∈Rd×1为琐碎系数。

通过式(12)构造目标函数,可得到候选目标的稀疏表示模型:

| $\left[{{\boldsymbol{{\hat a}}_i}, {\boldsymbol{{\hat s}}_i}} \right] = \arg \mathop {\min }\limits_{a, s} \frac{1}{2}\left\| {{\boldsymbol{y}_i} -{\boldsymbol{T}_a} -\boldsymbol{s}} \right\|_2^2 + \boldsymbol{\lambda} {\left\| \boldsymbol{s} \right\|_1}$ | (15) |

再通过迭代求解算法,可得候选区域的重构误差:

| $error = {\left\| {{\boldsymbol{y}_i}-\boldsymbol{T}{{\hat a}_i}} \right\|^2}$ | (16) |

当前帧中,重构误差最小的粒子或者观测值最大的粒子即当前帧的跟踪结果。

2.4 模板更新由于实际场景复杂多变,跟踪过程中目标的外观往往会发生明显变化。为了提高目标跟踪效果,合适的模板更新策略至关重要[21]。本文协同模型集成判别模型和生成模型:前者用来寻找最佳分类特征,后者用来有效地描述目标外观,二者分工明确。因此,在整个协同模型更新过程中,目标判别模型和生成模型两个模块独立更新。

跟踪过程中,由于目标判别模型旨在区分前景和背景,所以在跟踪过程中训练图像集中正模板保持不变;对于负模板从图像区域的跟踪结果只能够每隔几帧更新一次(本文实验取为5帧)。

对于生成模型中模块,字典D为了捕捉目标外观变化和修复遮挡对象,可通过式(17)更新模板:

| ${\psi _n} = \mu {\psi _f} + \left( {1 - \mu } \right){\psi _l}\;, \;{O_n} < {O_0}$ | (17) |

其中:ψf代表手动设置跟踪结果在第一帧的直方图;ψl是模板更新前最后保存的直方图;μ是权重系数;On表示在新的帧中跟踪结果的遮挡程度,可由式(18)计算得出。

| ${O_n} = \frac{1}{{J \times M}}\sum\limits_{i = 1}^{J \times M} {\left( {1-o_n^i} \right)} $ | (18) |

在该框架下,遮挡部分On小于预定义常数O0,才更新跟踪结果,以保证目标跟踪的正确性。

3 实验结果与分析实验平台:操作系统为Windows 7;CPU为Intel i7-3770;32 GB RAM;软件环境为Matlab2014a。选取公开视频序列[18, 20-22]中,包含姿态变化、局部遮挡、光照变化、背景复杂、平面内外旋转、尺度变化等挑战性视频序列进行实验。重点选择了MIL、TLD、Frag、本文中融合前单个目标判别模型(Discriminant Model, DM)和目标生成模型(Generative Model, GM)5种相关方法法与本文方法进行对比实验。

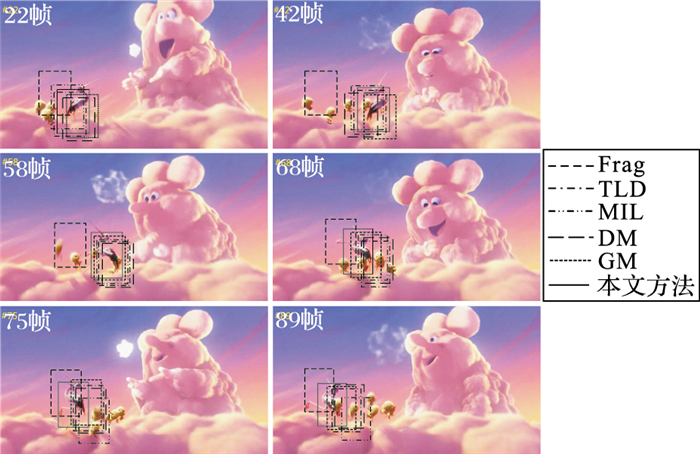

3.1 定性结果与分析姿态变化、局部遮挡实验选取Bird视频序列,共100帧,目标跟踪对象为飞翔小鸟。相关算法的目标跟踪结果,如图 6所示。

|

图 6 Bird视频序列部分跟踪结果 |

从图 6可以看出:从#22帧开始Frag跟踪发生了漂移,从而无法准确跟踪,原因在于其跟踪依据的是局部信息而不是全局信息导致最终跟踪失败。MIL和TLD追踪器在小鸟转身前只是有少量的漂移;但在#58帧小鸟外观发生了较大变化并伴随着旁边还有干扰产生局部遮挡时,MIL和TLD漂移量逐渐增大,无法对目标准确定位,导致在#89时TLD丢失了目标。DM在跟踪过程中随着小鸟运动引起姿态变化和局部遮挡的干扰,捕捉到目标的准确度逐渐下降;GM因为遮挡程度更新不及时,导致目标有所偏差;而本文协同模型可以通过目标判别优势,在小鸟被遮挡的情况下准确定位;又能利用目标生成模型缓解因运动带来外观变换,从而在整个过程中能准确地跟踪到目标。

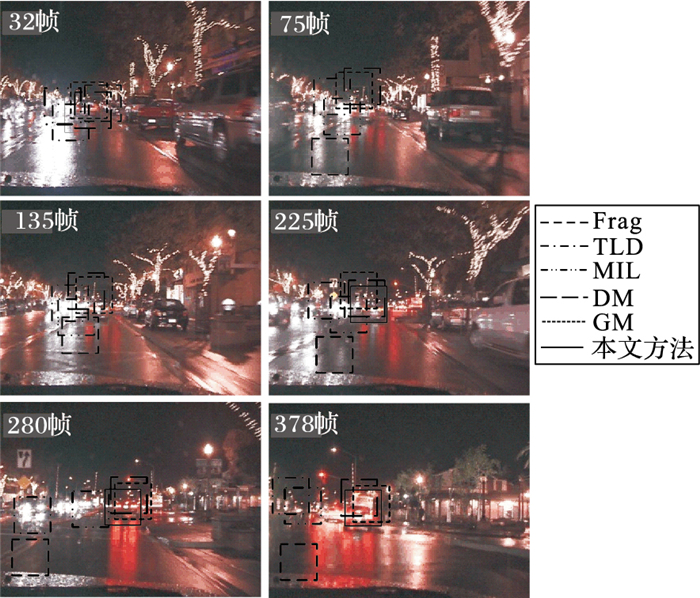

光照变化、背景混乱、对比度低实验选取CarDark视频序列,共400帧,目标跟踪对象为运动小车。相关算法的目标跟踪结果,如图 7所示。

|

图 7 CarDark视频序列部分跟踪结果 |

由图 7可见:Frag在#32帧有一些漂移,在#75、#135和#225帧又因光照变化使得Frag漂移目标丢失。MIL不能处理光照信息,所以从#75帧开始有少量漂移,随着小车的运动加上光照影响,到#225帧时丢失跟踪目标,错误跟踪到其他车辆上。TLD在#75是有少许漂移,慢慢的也无法准确跟踪;在#280和#378帧由于路灯不断闪烁的影响,Frag丢失目标,MIL也慢慢远离目标,而TLD也丢失了目标。DM因光照影响对目标的分类匹配,GM在背景混乱的情况不如判别好;由于本文的方法是把背景图像块和偏移目标的图像块都作为负样本处理,在生成模型中把光照处理为遮挡,模型更新及时,从而这些图像块的置信值都比较小;因此跟踪器能够很好地跟踪到准确的目标,不会存在太大的偏移,在整个汽车行驶过程中跟踪得都很好。

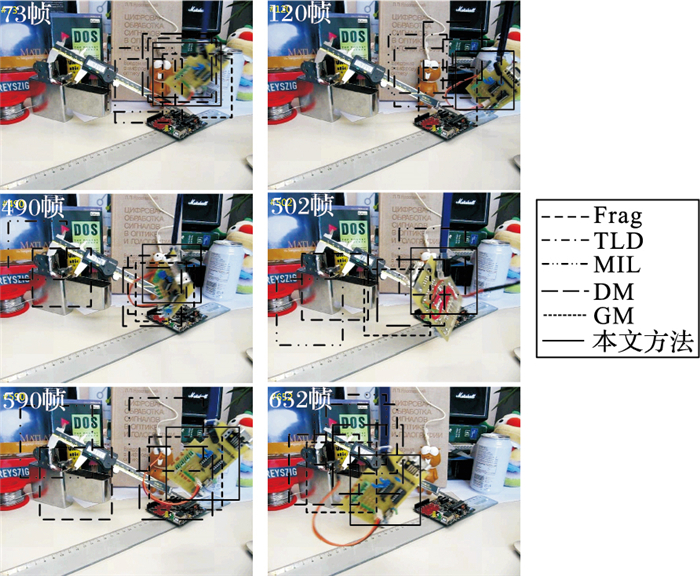

背景混乱、平面内旋转、尺度变化实验 选取board视频序列,共700帧,目标跟踪对象为板。相关算法的目标跟踪结果,如图 8所示。

|

图 8 board视频序列部分跟踪结果 |

图 8中,由#73和#120帧可见,Frag只要目标本身没有剧烈的外观变化几乎能够准确地跟踪目标,但是当目标快速移动和旋转时(从#490和#502可以看出),Frag跟踪器不能完成跟踪任务。而TLD和MIL仅使用当前样本(目标区域),而缺少对样本的好坏估计,所以在目标经过背景凌乱的情况下就不能准确跟踪目标,当目标发生旋转时,MIL跟踪器能够跟上目标(#490和#502),但是到后来还是发生了漂移,到最后丢失了目标(#652)。

DM由于旋转对目标定位精度有所下降,GM在复杂背景下影响对构造字典的质量,引起目标定位不准确;而本文方法中判别模型可以很好地区分前景和背景,利用最新获取的负样本更新负模板集合,更加有利于在变化着的、凌乱的场景中区分前景和背景,对于板的运动,生成模型可以捕捉细微变化具有较好的优势,所以能在整段视频序列中进行有效跟踪。

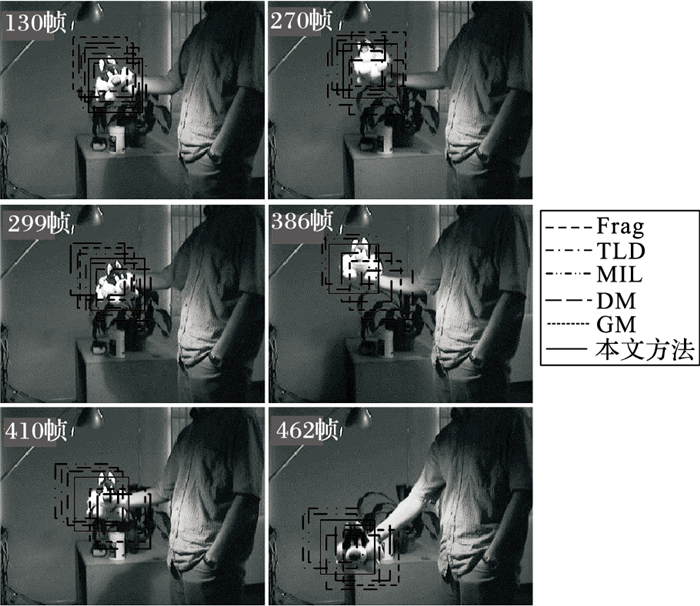

光照变化、平面外旋转、姿态变化实验 选取Sylvester视频序列,共500帧,跟踪对象为人物手中的玩偶。相关算法的目标跟踪结果,如图 9所示。

|

图 9 Sylvester视频序列部分跟踪结果 |

由图 9可以看出,#130帧之前,各相关算法都能准确跟踪目标。随着玩偶不停地、长时间地移动变化姿态,MIL出现了漂移,直到#462跟踪不准确。Frag在前300帧的跟踪效果较好;但从#386帧开始,随着玩偶的来回移动,致使跟踪失败。TLD和MIL在#386帧出现了漂移现象,在#462帧没有准确跟踪到目标,原因在于二者不能适应目标外观变化而偏离了跟踪目标。DM在对目标分类中会因玩偶旋转姿态变化增加对目标定位的难度,GM可以适应玩偶的运动变化但更新字典次数增多,降低生成的目标与字典相似程度;本文方法由于各模块独立更新,使得模板字典具有较好的实时性和稳定性,判别模型会保留最佳区分目标的特证,结合生成目标的特征点匹配,能准确对目标定位,在整段视频中,无论是光照条件下跟踪目标长时间来回移动,还是平面外旋转的变化情况下,均能准确跟踪到目标。

简言之,MIL针对的是外观模型,当目标外观变化较大,更新不及时,就会导致目标跟踪失败。TLD对训练样本没有选择,当运动出现飘移后,便难以确定区分目标和背景的特征。Frag基于分块的非特定目标跟踪,主要依据局部信息,目标局部被遮挡,将丢失目标。而本文方法能够同时利用局部信息和全局信息。其中,DM可以很好地区分目标与背景;GM能够在目标运动过程中较好地描述目标外观变化;综合两种模型的优势,和其他方法相比,本文的方法具有判别和生成模型的优势,能够准确跟踪目标。

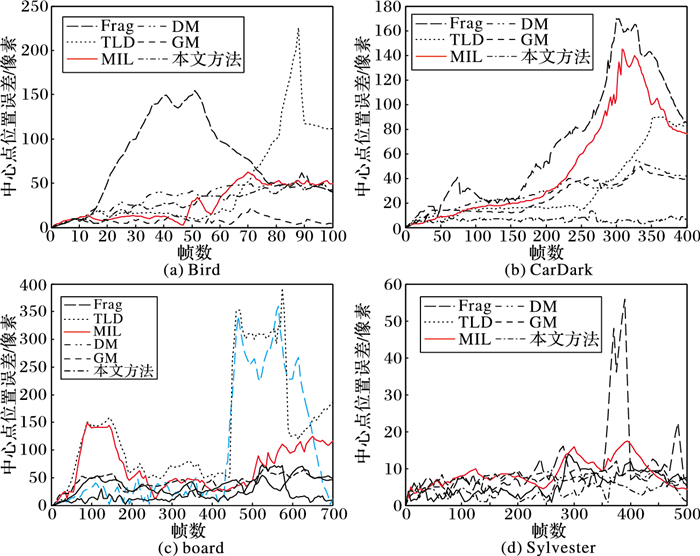

3.2 定量结果与分析为进一步客观准确评估本文目标跟踪方法,采用中心点位置误差指标作为衡量准则[19],进行定量评价分析。中心点位置误差(error),是指跟踪结果与真值之间的x和y方向的坐标值之间差距的平方误差,如式(19)所示: error=(xg-xi)2+(yg-yi)2 (19)式中:xg和yg分别代表跟踪目标真实的x方向和y方向的坐标值;xi和yi分别代表跟踪不准确时跟踪结果的x方向和y方向的坐标值。该误差愈小,目标跟踪的准确度愈高,反之亦然。相关方法的中心点位置误差示意图,如图 10所示。

|

图 10 4种视频图像的跟踪误差曲线 |

从图 10可以看出,在4种具有不同跟踪挑战的视频序列中,本文的跟踪方法产生的误差都比另外几种方法的小,在不同场景中目标跟踪表现得也较稳定,从而说明本文方法比Frag、TLD和MIL方法目标追踪得更准确。

下面,从公共视频库中随机抽取6组,加上前述4组,共10组视频进行测试。每组测试10次后取平均值,所得各视频序列平均中心点位置误差,如表 1所示。

| 表 1 各视频序列平均中心点位置误差 |

由表 1可见,本文方法在目标跟踪过程中的平均中心点误差为7.5像素,远小于其他方法。即使与融合前单个目标判别模型(DM)和目标生成模型(GM)相比,分别降低了0.6%和1.1%。

为更客观、更全面、多角度地对四种跟踪算法在噪声污染下进行定量分析,引入两个评价指标[25]:跟踪精确率(Tracking Rate, TR)和跟踪虚警率(False Alarm Rate, FAR),它们通过以下3个参数进行定义:

1) 真阳率(True Positive Area, TPA),为跟踪结果中属于目标的区域;

2) 假阳率(False Positive Area, FPA),为跟踪结果中属于背景的区域;

3) 假阴率(False negative Area, FNA),为未跟踪到的目标区域。则:

| $TR{\rm{ = }}TPA{\rm{/(}}TPA{\rm{ + }}FNA{\rm{)}} \times {\rm{100\% }}$ | (20) |

| $FAR = FPA{\rm{/(}}TPA + FPA{\rm{)}} \times {\rm{100\% }}$ | (21) |

通过式(20)和(21)可以看出精确率越大、虚警率越小,跟踪的精度越高,反之亦然。

重复运行10次目标跟踪实验后,上述指标平均值,如表 2所示。

| 表 2 量化分析表 |

从表 2中可以看出,本文方法的目标跟踪平均精确率为89.89%,平均虚警率为11.03%。

究其原因:DM跟踪器主要负责区分前景和背景,而对于遮挡的问题不能很好处理;GM跟踪器旨在处理遮挡问题,而容易受到凌乱背景的影响;而本文对DM与GM进行优劣互补,而且各模板独立更新,从而保证目标跟踪的准确率。

3.3 鲁棒性分析对测试视频序列,加入高斯噪声或椒盐噪声,进行鲁棒性分析实验。

3.3.1 定性分析对Bird视频序列加入噪声密度为0.25的椒盐噪声后,相关算法的目标跟踪结果,如图 11所示。

|

图 11 噪声污染下Bird视频序列部分跟踪结果 |

从图 11可以看出,从#8帧开始,Frag跟踪由于噪声污染了局部信息,无法准确捕捉小鸟运动,而失去跟踪目标。MIL和TLD追踪器在最初还可以捕捉到小鸟;但在#57帧因噪声加剧了小鸟外观变化和局部遮挡现象,二者的漂移量逐渐增大;又由于无法及时更新模板,对目标定位出现偏差,二者逐渐丢失了跟踪目标。DM和GM开始捕捉到目标,由于噪声降低了背景与目标的对比度,引起跟踪误差渐渐增大;本文方法可以通过目标判别优势能较好地区分目标和背景,利用生成模型处理局部遮挡,因此仍能捕捉到跟踪目标,但由于噪声污染致使定位的精确度有所降低。

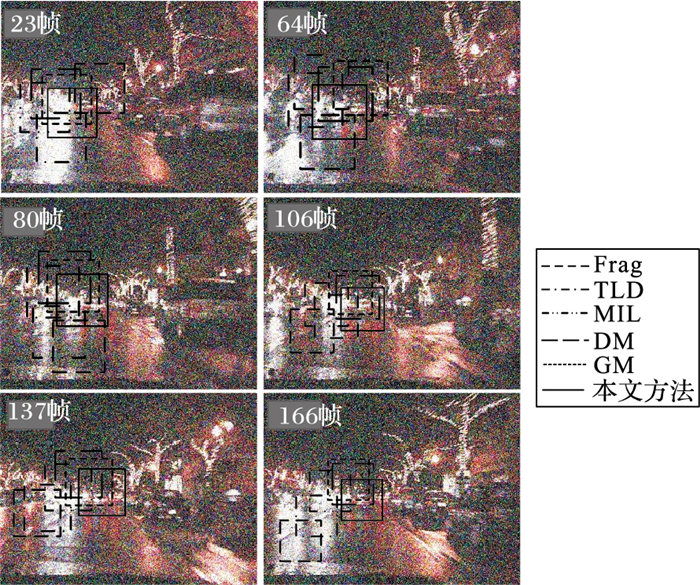

添加均值为0.03、方差为0.05的高斯噪声后,在CarDark视频序列上,相关算法的目标跟踪结果,如图 12所示。

|

图 12 噪声污染下CarDark视频序列部分跟踪结果 |

由图 12可见,Frag在#23帧有一些漂移,噪声使光照发生变化致使Frag愈加敏感,漂移逐渐增大,最终跟踪目标丢失。MIL刚开始可以捕捉到部分目标,加入的噪声让车对运动和光照影响较大,到#106帧时,彻底丢失跟踪目标,而错误跟踪其他车辆上。噪声使TLD的训练样本质量下降,在#23帧仅跟踪到局部小车,慢慢地也丢失了跟踪目标(从#137帧开始)。DM对光照比较敏感,小车的运动增加提取最佳特征的难度。GM由于噪声污染使生成目标的置信度变大从而定位不准。本文模块的独立更新策略,判别模型和生成模型相互合作,保证定位的准确率,使得本文方法在噪声污染情况下,仍能跟踪目标,只是噪声一开始就降低了模板的质量,从而偏移量稍大。

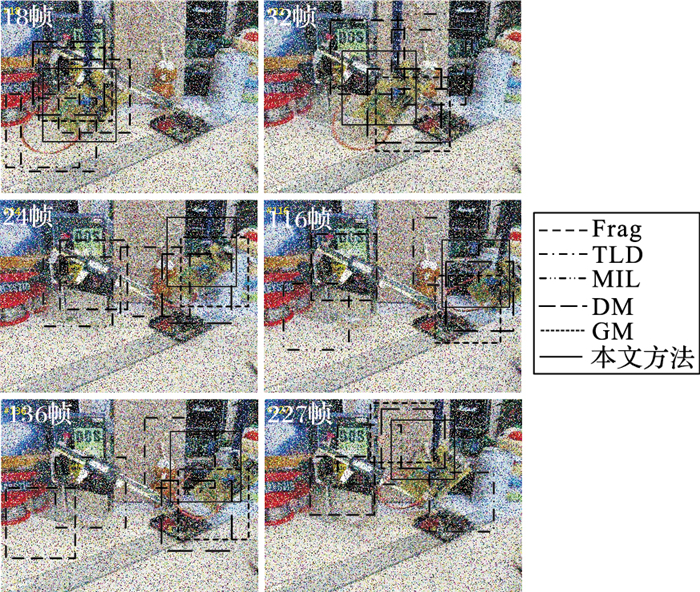

在board视频序列中,加入噪声密度为0.25的椒盐噪声,相关算法的目标跟踪结果,如图 13所示。

|

图 13 噪声污染下board视频序列部分跟踪结果 |

从图 13可以看出,Frag在#24帧后失去跟踪目标,原因是板的快速运动对Frag跟踪器的干扰较大,并且椒盐噪声加大了目标判断的难度,导致跟踪任务失败。TLD和MIL在凌乱的背景下跟踪目标效率较低,椒盐噪声使目标运动飘移逐渐增大,致使二者在#24帧后逐渐失去跟踪目标。DM由于噪声污染,难以区分目标和背景,GM因噪声加大在复杂背景下对目标定位的难度;本文方法总体上能够跟踪到目标,只是噪声污染增加了判别和生成目标的难度,目标跟踪准确度有所下降。

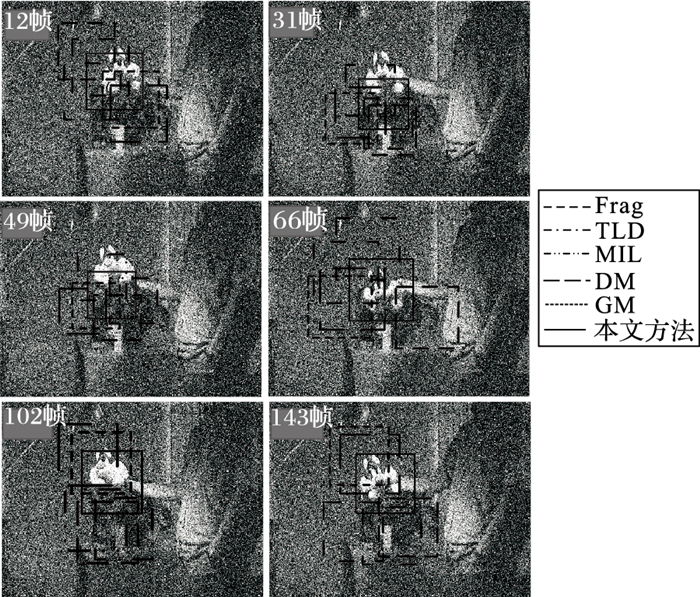

在Sylvester测试视频中,加入均值为0.03、方差为0.05的高斯噪声,相关算法的目标跟踪结果,如图 14所示。

|

图 14 噪声污染下Sylvester视频序列部分跟踪结果 |

由图 14可见,Frag刚开始只能跟踪到玩偶的局部,随着玩偶不停变化姿态和噪声的干扰,从#66帧后完全失去跟踪目标。MIL在#12帧以前还可以跟踪到目标,从#31帧后开始目标定位逐渐失准,在#56帧后便无法准确跟踪;虽然TLD和MIL一样,在#31到#49帧效果稍好一点,但它们由于噪声干扰和无法适应玩偶的变化,在#102帧后就完全失去了跟踪目标。本文方法通过判别模型和生成模型协同处理,使得整个跟踪过程中都能捕捉到目标,但随着噪声污染对区分目标和背景影响的加大,目标跟踪误差也越来越大。

总而言之,加入噪声后,使得目标与背景的对比度降低,MIL由于不能很好描述目标外观的变化,加之更新不及时,逐渐丢失跟踪目标。因噪声降低了训练样本的质量,TLD难以提取有效的区分目标和背景的特征,而难以准确进行目标跟踪。Frag依据的局部信息非常易受噪声影响,使得目标与背景混淆,从而致使目标跟踪失败。噪声污染,使DM无法提取出区分背景与目标的最佳特征,让GM生成的目标与字典对比的相似度变大,故定位偏差主键变大;本文方法中,判别模型依靠局部信息区分目标与背景,而生成模型通过全局信息描述目标外观变化,再加上模块的独立更新策略,有效保证了目标跟踪的精度;但噪声污染无疑使得目标与背景更加混淆,大幅增加了目标定位难度,致使本文方法跟踪精度会有所下降。

3.3.2 定量分析在高斯噪声和椒盐噪声污染的情况下,对10组视频测试10次取平均值,各方法所得各视频序列平均中心点位置误差(像素),如表 3和表 4所示。

| 表 3 高斯噪声下各视频序列平均中心点位置误差 |

| 表 4 椒盐噪声下各视频序列平均中心点位置误差 |

表 3中高斯噪声下本文的平均中心位置误差(像素)为13.1,比其他方法的要小;表 4中能看到椒盐噪声污染下本文的平均中心位置误差(像素)是9.9,小于其他方法,整体上在噪声污染的情况下跟踪准确率有所下降,但相比其他方法,均有一定的抗噪性。

对测试视频序列分别加入高斯噪声(均值为0.03、方差为0.05)和椒盐噪声(密度为0.25),重复运行10次,目标跟踪实验后,TR和FAR如表 5和表 6所示。

| 表 5 高斯噪声下量化分析表 |

| 表 6 椒盐噪声下量化分析表 |

从表 5可以看出,在高斯噪声污染下,本文方法的目标跟踪平均精确率为79.83%,平均虚警率为20.46%;由表 6可见,在椒盐噪声污染下,本文方法的目标跟踪平均精确率为87.36%,平均虚警率为13.08%。总体上,本文的精确率比其他五种方法要高,而虚警率则较低;表明在噪声污染情况下,本文方法仍能跟踪到目标。

通过分析具体原因发现,由于噪声污染,使MIL外观模型更新不及时,降低了TLD训练样本的质量, 从而影响对显著区域的检测,影响了Frag所依据的局部信息,减弱了DM对前景和背景的区分,加大GM估计目标的难度,从而削弱了对跟踪目标的准确判别。在噪声污染的情况下,本文方法则通过局部信息区分目标与背景,利用全局信息描述目标外观变化,由于噪声使得目标与背景的对比度降低,刚开始难以捕捉到最佳特征,致使跟踪过程中精确率出现少许下降。

3.4 运行时间将各方法在10组视频序列上测试10次后取平均值,运行的平均帧率(f/s),如表 7所示。

| 表 7 平均帧率 |

从表 7中可以看出本文方法的目标跟踪平均帧率为10.21 f/s,运行速率和单个目标判别模型相比稍低,但要高于其他方法,能够满足一定的实时性。

测试视频序列大部分的分辨率为720×400,通过分析,GM比DM复杂,故运行速率不如后者。Frag主要依据局部信息基于分块对目标进行匹配,来计算两幅图像的相似度,融入了直方图对应位置的信息,因此运行慢。MIL和TLD虽然公认运行速度快,但由于每个视频序列中目标受到外界环境干扰和实验环境的影响,导致运行速度有所差异;本实验中,MIL在跟踪过程中依赖上一帧的结果,由于场景对目标影响较大要不断对样本进行学习更新,因此降低了运算速度;而TLD为保证每一帧正常检测到目标,跟踪模块对整幅图像进行全屏扫描,由于跟踪结果不精准,需要不断更新显著特征点和检测模型来跟踪目标,因此耗时较大。而本文中的判别模型几乎只对负模板更新,生成模型根据遮挡程度进行更新,具有更好的灵活性,而协同模型需要两者共同完成,所以目标跟踪平均帧率和单个判别模型相比稍低, 但差距不大,综合考虑目标跟踪的准确率和鲁棒性,本文的方法优于其他方法。

4 结语本文将稀疏表示引入粒子滤波的框架中,提出了协同目标跟踪模型。首先,在原有的稀疏判别模型的训练上进行正负模板训练。其次,在表示生成模型中归一加权目标直方图集成了一个伪分类器,通过置信值确定生成目标,可以有效地处理复杂的背景以及遮挡问题。最后,判别分类和生成模块集成在同模型中,且各模块独立更新,从而减少漂移,提高了目标跟踪的准确率。实验结果表明,在目标复杂的场景下因外观变化,本文仍能较好地跟踪动态复杂背景视频序列中的运动目标,其平均中心位置误差相对较小,且具有较好的鲁棒性。加入噪声后,本文目标跟踪精度有所下降,后续研究中拟通过寻求更好的区分特征或类似SVM强分类器的方法来解决。

| [1] | 匡金骏, 柴毅, 熊庆宇. 基于时空约束和稀疏表示分类的目标跟踪算法[J]. 控制与决策, 2013, 28 (9) : 1355-1360. ( KUANG J J, CHAI Y, XIONG Q Y. Visual object tracking via time-space constraints and sparse representation classification[J]. Control and Decision, 2013, 28 (9) : 1355-1360. ) |

| [2] | 周治平, 周明珠, 李文慧. 基于混合粒子滤波和稀疏表示的目标跟踪算法[J]. 模式识别与人工智能, 2016, 29 (1) : 23-30. ( ZHOU Z P, ZHOU M Z, LI W H. Object tracking algorithm based on hybrid particle filter and sparse representation[J]. Pattern Recognition and Artificial Intelligence, 2016, 29 (1) : 23-30. ) |

| [3] | 王保宪, 赵保军, 唐林波, 等. 基于双向稀疏表示的鲁棒目标跟踪算法[J]. 物理学报, 2014, 63 (23) : 166-176. ( WANG B X, ZHAO B J, TANG L B, et al. Robust visual tracking algorithm based on bidirectional sparse representation[J]. Chinese Journal of Physics, 2014, 63 (23) : 166-176. ) |

| [4] | LI M, MA L F, NIAN F Z. Robust visual tracking via appearance modeling and sparse representation[J]. Journal of Computers, 2014, 9 (7) : 1612-1619. |

| [5] | ADAM A, RIVLIN E, SHIMSHONI I. Robust fragments-based tracking using the integral histogram[C]//Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2006:798-805. |

| [6] | BABENKO B, YANG M, BELONGIE S. Robust object tracking with online multiple instance learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33 (8) : 1619-1632. doi: 10.1109/TPAMI.2010.226 |

| [7] | KALAL Z, MIKOLAJEZYK K, MATAS J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34 (7) : 1409-1422. doi: 10.1109/TPAMI.2011.239 |

| [8] | WRIGHT J, YANG A Y, GANESH A, et al. Robust face recognition via sparse representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31 (2) : 210-227. doi: 10.1109/TPAMI.2008.79 |

| [9] | MEI X, LING H. Robust visual tracking and vehicle classification via sparse representation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33 (11) : 2259-2272. doi: 10.1109/TPAMI.2011.66 |

| [10] | ZHANG S, YAO H, SUN X, et al. Robust object tracking based on sparse representation[C]//Proceedings of SPIE International Conference on Visual Communications and Image Processing. Bellingham:SPIE, 2010:77441N-1. |

| [11] | ZHANG S, YAO H X, ZHOU H Y, et al. Robust visual tracking based on online learning sparse representation[J]. Neurocomputing, 2013, 100 (1) : 31-40. |

| [12] | 潘晴, 曾仲杰. 基于稀疏表示和特征选择的LK目标跟踪[J]. 计算机应用研究, 2014, 31 (2) : 623-628. ( PAN Q, ZENG Z J. LK tracking based on sparse representation and features selection[J]. Application Research of Computers, 2014, 31 (2) : 623-628. ) |

| [13] | LIU B Y, YANG L, HUANG J Z, et al. Robust and fast collaborative tracking with two stage sparse optimization[C]//Proceedings of the 11th European Conference on Computer Vision. Heidelberg:Springer-Verlag, 2010:624-637. |

| [14] | BAO C, WU Y, LING H, et al. Real time robust l1 tracker using accelerated proximal gradient approach[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2012:1830-1837. |

| [15] | WANG D, LU H C, YANG M H. Least soft-threshold squares tracking[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:2371-2378. |

| [16] | WANG D, LU H C, YANG M H. Online object tracking with sparse prototypes[J]. IEEE Transactions on Image Processing, 2013, 22 (1) : 314-325. doi: 10.1109/TIP.2012.2202677 |

| [17] | SHI Z, WEI C, FU P, et al. A parallel search strategy based on sparse representation for infrared target tracking[J]. Algorithms, 2015, 8 (3) : 529-540. doi: 10.3390/a8030529 |

| [18] | ZHANG T, LIU S, AHUJA N, et al. Robust visual tracking via consistent low-rank sparse learning[J]. International Journal of Computer Vision, 2015, 111 (2) : 171-190. doi: 10.1007/s11263-014-0738-0 |

| [19] | 杨彪, 林国余, 张为公, 等. 融合残差Unscented粒子滤波和区别性稀疏表示的鲁棒目标跟踪[J]. 中国图象图形学报, 2014, 19 (5) : 730-738. ( YANG B, LIN G Y, ZHANG W G, et al. Robust object tracking incorporating residual unscented particle filter and discriminative sparse representation[J]. Journal of Image and Graphics, 2014, 19 (5) : 730-738. ) |

| [20] | YANG C. Saliency detection via graph-based manifold ranking[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:3166-3173. |

| [21] | YAN Q. Hierarchial saliency detection[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC:IEEE Computer Society, 2013:1155-1162. |

| [22] | 杨存强, 韩晓军, 张南. 基于图像块迭代和稀疏表示的超分辨率图像重建算法[J]. 计算机应用, 2016, 36 (2) : 521-525. ( YANG C Q, HAN X J, ZHANG N. Super-resolution image reconstruction algorithm based on image patche iteration and sparse representation[J]. Journal of Computer Applications, 2016, 36 (2) : 521-525. ) |

| [23] | 胡昭华, 徐玉伟, 赵孝磊, 等. 多特征联合的稀疏跟踪方法[J]. 计算机应用, 2014, 4 (8) : 2380-2384, 2389. ( HU Z H, XU Y W, ZHAO X L, et al. Sparse tracking algorithm based on multi-feature fusion[J]. Journal of Computer Applications, 2014, 4 (8) : 2380-2384, 2389. ) |

| [24] | GUO Q, WU C. Fast visual tracking using memory gradient pursuit algorithm[J]. Journal of Information Science & Engineering, 2016, 32 (1) : 213-228. |

| [25] | POLAT E, YEASIN M, SHARMA R. A 2D/3D model-based object tracking framework[J]. Pattern Recognition, 2003, 36 (9) : 2127-2141. doi: 10.1016/S0031-3203(03)00041-4 |