| 基于深度学习的遥感影像地物目标检测和轮廓提取一体化模型 |

遥感影像地物目标检测和轮廓提取,对于资源调查、农村规划、城市规划、自然灾害的监测以及资源勘测等具有重要的意义[1]。遥感影像目标识别流程一般为:设计特征,提取特征,利用特征进行识别。传统方法多采用人工设计的特征,如张艳宁等[2]提出一种基于矩不变量和支持向量机的遥感图像目标识别方法,在二值化飞机和舰船的识别上达到了90%以上的验证精度;孙艳霞[3]提出一种基于纹理特征的遥感图像目标自动识别方法,在遥感地物目标的识别上取得了一定的效果,Lin等[4]利用边缘检测算法得到图像中的边缘,处理得到建筑物的位置和轮廓;张煜等[5]采用几何约束与影像分割相结合的方法,用矩形框定位建筑物的大概位置,该方法在遮蔽较少、房屋比较独立且形状比较简单的情况下效果尚可,但是阈值的选取难以适应不同图像、不同目标的提取,所以在使用上受到限制[6]。目标检测和轮廓提取方法需要人为进行设计和调整,智能化程度不高。

深度学习的本质是复杂的非线性模型,利用海量的训练数据(可为无标签数据),通过构建多隐层的模型,学习更加有用的特征数据,从而提高数据分类效果, 提升预测结果的准确性[7]。根据深度学习训练数据是否有标签可以分为监督学习和无监督学习。监督学习有较为成熟的理论及硬件技术的支持,特别是反向传播算法[8]的提出,使利用监督学习的神经网络训练成为可能。因此,利用监督学习的深度学习技术在图像识别[9-11]、目标检测[12-15]、语音识别[16]等领域得到了广泛的应用,并取得了成功。

在图像处理方面,一般选用利用卷积神经网络(convolotional neural network, CNN)的模型进行图像的处理。在图像处理方法中,卷积神经网络是深度学习中最为出色的一个模型,它是为了识别二维图像而设计的特殊多层感知器,卷积核的本质是特征提取器。CNN具有局部感知区域、权值共享和池化的结构特点。局部感知区域、权值共享使CNN的参数数量明显减少,提升网络性能;空间下采样让CNN有一定的缩放平移不变性,具有更强的泛化能力。卷积神经网络将特征提取纳入模型学习中,将特征学习和分类学习有机地结合在一起,更有效地实现对图像的解译。

本文利用深度学习的方法实现遥感影像中的遥感地物自动化、智能化的目标检测和轮廓提取。

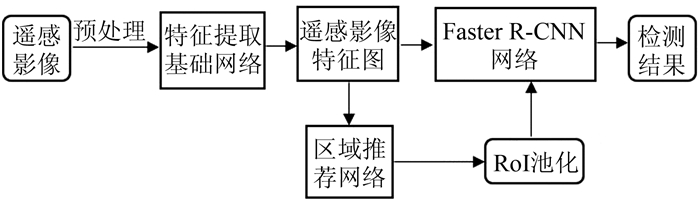

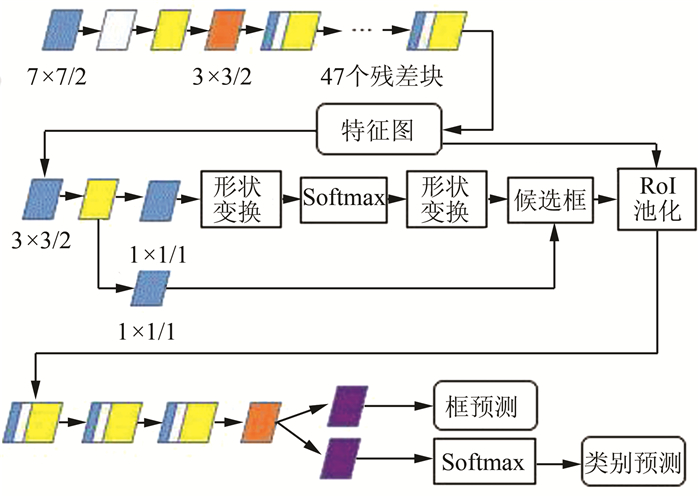

1 目标检测和轮廓提取一体化模型 1.1 利用Faster R-CNN的遥感影像地物目标检测Simonyan等[10]提出一种基于区域卷积神经网络和区域推荐网络的两阶段目标检测网络Faster R-CNN。其基本技术路线是:①输入待检测图片,利用基础网络提取图片的相应特征;②在基础网络提取的特征图上,利用区域候选框网络(region proposal Network, RPN)产生一系列的候选框;③在候选框对应的特征图区域进行兴趣区域(regine of interese, RoI)池化处理,得到相同尺度的特征。将得到的特征输入到Faster R-CNN检测模块,实现候选框的坐标回归和类别的检测。针对遥感影像,利用Faster R-CNN进行目标检测的流程如图 1所示。

|

| 图 1 基于Faster R-CNN的遥感影像目标检测流程图 Fig.1 Flow Chart of Remote Sensing Image Object Detection Based on Faster R-CNN |

1.2 基于FCN的遥感影像目标轮廓提取

为了解决图像逐像素分类的问题,Long等[17]提出了全卷积网络(full convolutional network, FCN)模型,克服了CNN模型中因池化结构而造成的特征图空间分辨率过低的问题。由于FCN中采用的均是卷积层,没有全连接层,因此, 被称为全卷积神经网络。

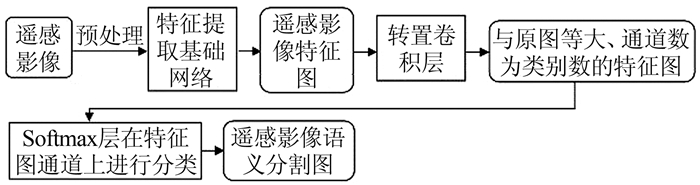

FCN的基本技术路线为:①将输入的图像进行卷积操作,提取相应的特征;②利用反卷积操作将特征图与输入的原图相等大小;③对原图相等大小的特征图的通道上进行像素级别的分类,获得最终的语义分割图。针对遥感影像,利用FCN进行像素级分类和地物轮廓提取的流程,如图 2所示。

|

| 图 2 基于FCN的遥感影像语义分割流程图 Fig.2 Flow Chart of Remote Sensing Image Semantic Segmentation Based on FCN |

1.3 遥感影像目标检测和轮廓提取一体化

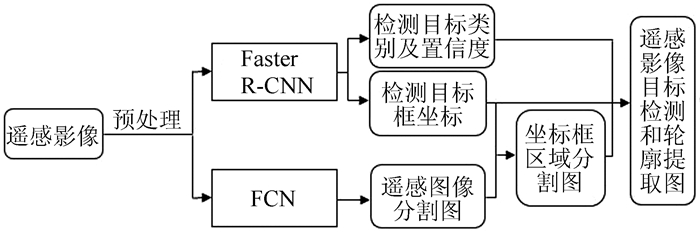

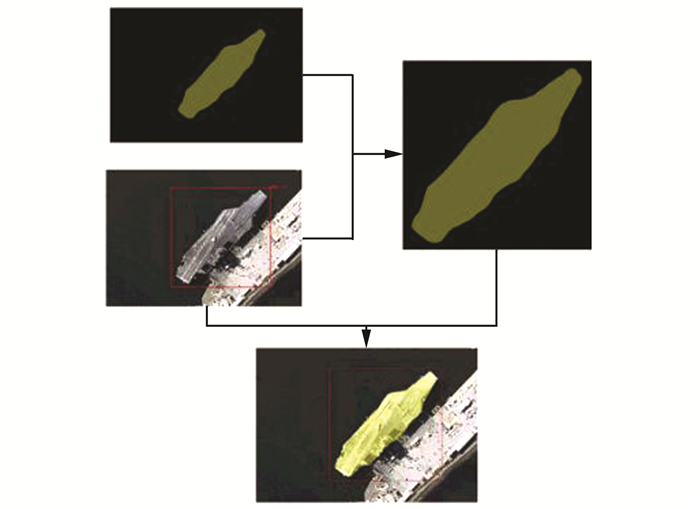

以目标检测和轮廓提取结果为基础,提出一种遥感影像的目标检测和轮廓提取一体化流程:①根据Faster R-CNN的检测结果,主要是目标框的坐标信息,在经过FCN处理后的分割图中获得对应区域的分割图;②将获得的对应区域的分割图与目标检测结果图的对应区域进行融合,得到最终的目标检测和轮廓提取结果,如图 3所示。

|

| 图 3 目标检测和轮廓提取一体化流程图 Fig.3 Flow Chart of Integrated Processing for Target Detection and Contour Extraction |

2 目标检测和轮廓提取模型实验

本文采用的数据集是HRSC2016数据集[18]。数据集中的遥感影像来源于谷歌地球,为高分可见光影像,具有较为单一的背景, 一般为海面或海港,其空间分辨率为0.4~2 m,图像大小300像素×300像素~1 500像素×900像素,总共包含1 680张影像。HRSC2016数据集主要包含海面和近岸两个场景,如图 4所示。

|

| 图 4 HRSC2016数据集示例图 Fig.4 Examples of HRSC2016 Data Set |

2.1 基于Faster R-CNN的船舶检测

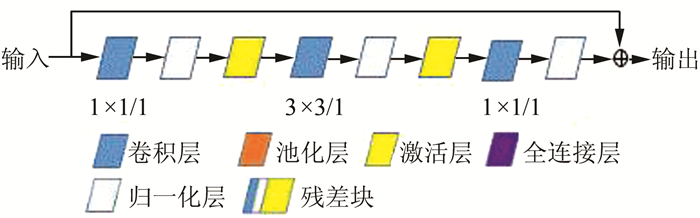

网络中用的基本单元如图 5所示,包括卷积层、池化层、激活层、全连接层、归一化层以及残差网络中的残差块的结构。

|

| 图 5 网络基本单元图示 Fig.5 Network Basic Unit |

在HRSC2016数据集上的实验,Faster R-CNN采用的基础网络为ResNet-152 v1[11],网络结构如图 6所示。

|

| 图 6 Faster R-CNN网络结构图 Fig.6 Faster R-CNN Network Architecture |

网络训练主要对矩形框的左上角点和右下角点的坐标进行回归,并对框内的目标进行分类,其优化的损失函数为:

| $ \begin{array}{*{20}{l}} {L\left( {\left\{ {{p_i}} \right\},\left\{ {{\mathit{\boldsymbol{t}}_i}} \right\}} \right) = \frac{1}{{{N_{{\rm{cls}}}}}}\sum\limits_i {{L_{{\rm{cls}}}}} \left( {{p_i},p_i^*} \right) + }\\ {\;\;\;\;\;\;\;\;\;\gamma \frac{1}{{{N_{{\rm{reg}}}}}}\sum\limits_i {p_i^*} {L_{{\rm{reg}}}}\left( {{\mathit{\boldsymbol{t}}_i},t_i^*} \right)} \end{array} $ | (1) |

式中,i表示图中锚框的索引;pi表示锚框预测为目标的概率;ti为表示预测的包围框的4个参数化坐标的向量;pi*表示锚框真实目标的概率;ti*表示真实的参数化包围框坐标;Ncls为分类样本的个数;Nreg为回归样本的个数;γ为权重值。

实验中,会对输入的遥感影像进行灰度值的归一化处理,同时,会以最短边缩放至600像素为基准,对整张影像进行缩放处理。训练时,采用图像翻转、旋转进行数据增强。

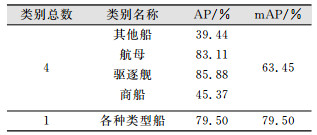

目标检测中用来评定检测精度的指标为平均精度(average precision, AP)和均值平均精度(mean average precision, mAP)。在单类舰船目标检测和4类舰船目标检测两个级别上, 对检测的结果进行了精度评定,结果如表 1所示。

| 表 1 一级和二级类别检测结果精度评定 Tab.1 Accuracy Assesment of Object Detection for the First and the Second Class |

|

网络训练完成后,部分检测结果如图 7所示。

|

| 图 7 Faster R-CNN船舶检测结果示例图 Fig.7 A Result of Ship Detection Based on Faster R-CNN |

图 7中绿色的框为真实的矩形包围框,红色的框为网络检测出来的矩形框。

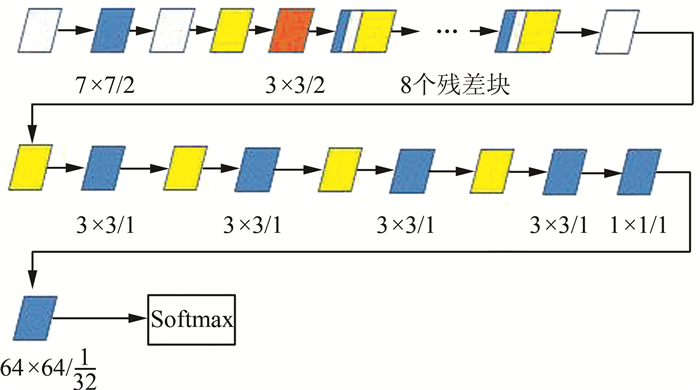

2.2 利用FCN的船舶轮廓提取FCN采用的基础网络为ResNet-18 v2[11],网络结构如图 8所示。

|

| 图 8 FCN网络结构图 Fig.8 FCN Network Architecture |

网络训练主要对待分割图像进行像素级别的分类,优化的损失函数为:

| $ L = - \mathop \sum \limits_{i = 0}^{w - 1} \mathop \sum \limits_{j = 0}^{h - 1} \mathit{\boldsymbol{p}}_{i, j}^* \times {\rm{ln}}\mathit{\boldsymbol{p}}{_{i, j}} $ | (2) |

式中,w, h分别表示预测图的宽、高分辨率;pi, j*为点(i, j)处真实的类别通道上的概率分布向量;其中只有一个通道上概率为1,其他通道上的概率均为0;pi, j表示点(i, j)处预测的各分类通道的概率分布向量,各分类通道的概率之和为1。

实验中,对输入遥感图像的灰度值进行归一化处理;训练时,采用图像随机裁剪的数据增强方法。

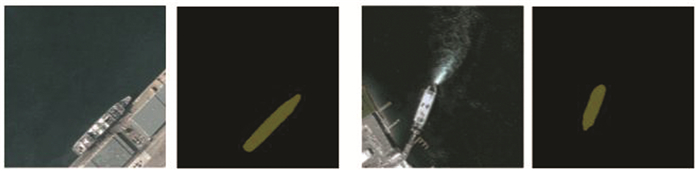

首先,FCN在公开遥感数据集Vaihingen上进行预训练,精度为92.53%;接着,在目标数据集HRSC2016上进行微调训练;最终,获得验证精度97.40%的模型。训练后,模型的分割效果如图 9所示。

|

| 图 9 FCN船舶分割示例图 Fig.9 Results of Ship Segmentation Based on FCN |

2.3 遥感影像船舶检测和轮廓提取一体化

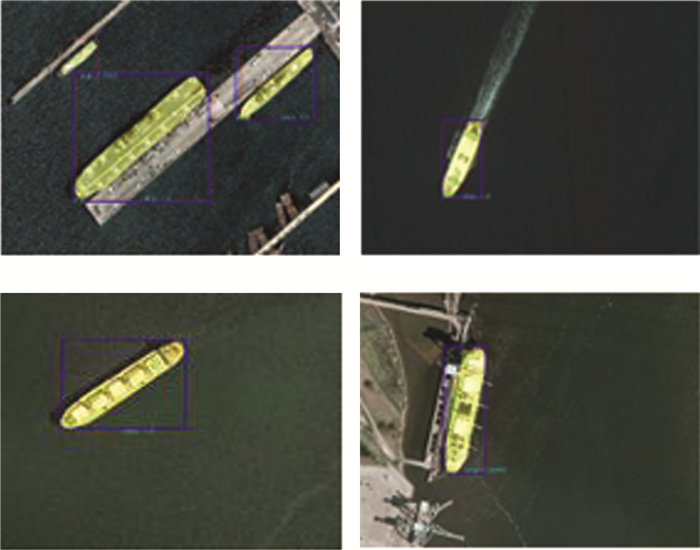

船舶检测和轮廓提取一体化处理模型由目标检测和语义分割中的两个子模型组成,处理流程为:①通过Faster R-CNN对包含船舶的遥感图像进行船舶目标检测,得到船舶外包矩形框的坐标以及框内船舶具体类别和相应置信度;②将图像送入FCN网络,对船舶进行逐像素分类;③将检测到的矩形框叠加到船舶语义分割结果图上的相应区域,从而获得船舶检测和轮廓提取的结果。处理流程如图 10所示,效果如图 11所示。

|

| 图 10 船舶检测和轮廓提取一体化模型处理示意图 Fig.10 Integrated Model Processing for Ship Detection and Contour Extraction |

|

| 图 11 船舶检测和轮廓提取一体化处理结果图 Fig.11 Integrated Processing Results of Ship Detection and Contour Extraction |

3 结束语

本文探讨了利用深度学习方法实现遥感影像中地物目标检测、轮廓提取以及目标检测和轮廓提取一体化处理的流程。以船舶检测和轮廓提取为例进行了实验,实验结果表明, 与需要大量人工设计的传统方法相比,本文提出的框架实现了船舶检测和轮廓提取的一体化、自动化以及智能化。下一步的研究会将此方法应用到其他遥感数据集上,检测和提取其他遥感影像中的地物,以此检验此方法的鲁棒性。

| [1] |

赵波.遥感图像目标识别算法研究[D].长沙: 湖南国防科学技术大学, 2004 http://cdmd.cnki.com.cn/Article/CDMD-90002-2005143818.htm

|

| [2] |

张艳宁, 郑江滨, 王晓红, 等. 一种有效的遥感图像目标识别方法[J]. 信号处理, 2002, 18(1): 1-4. DOI:10.3969/j.issn.1003-0530.2002.01.001 |

| [3] |

孙艳霞.纹理分析在遥感图像识别中的应用[D].乌鲁木齐: 新疆大学, 2005

|

| [4] |

Lin C, Nevatia R. Building Detection and Description from a Single Intensity Image[J]. Computer Vision and Image Understanding, 1998, 72(2): 101-121. |

| [5] |

张煜, 张祖勋, 张剑清. 几何约束与影像分割相结合的快速半自动房屋提取[J]. 武汉测绘科技大学学报, 2000, 25(3): 238-242. |

| [6] |

沈伟.高分辨率遥感影像分割及地物轮廓提取方法研究[D].北京: 北京交通大学, 2008 http://cdmd.cnki.com.cn/Article/CDMD-10004-2009147389.htm

|

| [7] |

韩小虎, 徐鹏, 韩森森. 深度学习理论综述[J]. 计算机时代, 2016(6): 107-110. |

| [8] |

Rumelhart D E. Learning Representations by Back-Propagating Errors[J]. Nature, 1986, 323: 533-536. DOI:10.1038/323533a0 |

| [9] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[C]. International Conference on Neural Information Processing Systems, Nevada, USA, 2012 https: //www.researchgate.net/publication/267960550_ImageNet_Classification_with_Deep_Convolutional_Neural_Networks

|

| [10] |

Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[C]. ICLR2015, San Diego, CA, USA, 2015

|

| [11] |

He K, Zhang X, Ren S, et al. Deep Residual Learning for Image Recognition[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Los Vegas, NV, USA, 2015 https: //ieeexplore.ieee.org/document/7780459

|

| [12] |

Girshick R, Donahue J, Darrell T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]. IEEE Conference on Computer Vision and Pattern Recognition, IEEE Computer Society, Columbus, OH, USA, 2014

|

| [13] |

Girshick R. Fast R-CNN[J]. Computer Science, 2015. DOI:10.1109/ICCV.2015.169 |

| [14] |

Ren S, He K, Girshick R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[C]. International Conference on Neural Information Processing Systems, Montreal, Quebec, Canada, 2015

|

| [15] |

Redmon J, Divvala S, Girshick R, et al. You only Look Once: Unified, Real-Time Object Detection[C]. IEEE Conference on Computer Vision and Pattern Re-cognition, IEEE Computer Society, Los Vegas, NV, USA, 2016

|

| [16] |

Yu D, Deng L. Automatic Speech Recognition: A Deep Learning Approach[M]. New York: Springer, 2014.

|

| [17] |

Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Tran-sactions on Pattern Analysis and Machine Intelligence, 2014, 39(4): 640-651. |

| [18] |

Liu Z, Liu Y, Weng L, et al. A High Resolution Optical Satellite Image Dataset for Ship Recognition and Some New Baselines[C]. International Conference on Pattern Recognition Applications and Methods, Porto, Portugal, 2017

|

2019, Vol. 44

2019, Vol. 44